エージェンティックAIは、単なる返答生成を超え、ビジネスプロセスの「実行」まで担うシステムを実現します。最大の課題は、現状多くの自律エージェントがメールやPDF、スキャン文書など非構造化データを前提としており、それらを安定して扱える仕組みが不足している点です。本記事では、なぜ構造化データがエージェンティックAIに決定的なレイヤーなのか、そして専用のパースレイヤー(解析レイヤー)が、AI導入の期待を実際に“使える”システムへ変える仕組みを解説します。

主なポイント

- エージェンティックAIは、AIの役割をコンテンツ生成からビジネス遂行へと拡張し、データエラーが与える影響コストも増大します。

- 自律エージェントには、クリーンかつ構造化され検証済みの入力データが不可欠です。LLM単体ではこの要件を満たせません。

- Parseurは、現実の書類を信頼性の高い構造化データへと変換する解析レイヤーを提供し、エージェントが推測に頼らず確信を持って行動できる基盤を作ります。

「チャット」から「実行」への大転換

過去数年でAIは急速に進化しました。2023年~2024年の主役は生成AIで、メール文作成や要約、自然言語での質疑応答など対話型の価値提供が中心でした。しかし多くの場合、やりとりは「会話」にとどまり、本格的な業務の自動執行には至っていませんでした。

2026年には状況が大きく転換し、Gartner によれば 企業アプリの40%がタスク特化型AIエージェントを導入見込みです。次なる革新の主役は「エージェンティックAI」。それは単なる応答ではなく、「実行」までを自律的に担う設計だと言えます。AIがメール下書きや次アクションの提案に留まらず、送信・実行・意思決定まで一連のワークフローを一手に担います。

この価値は非常に大きく、Kong INC の調査では企業の90%がAIエージェントを導入準備中、うち79%が3年以内の本格稼働を見込むとされます。AIがサプライチェーン管理や請求/支払い全自動化、CRM情報の自動更新など、本当に“人手なし”の手続きまで現実味を帯びてきました。

しかし課題も見逃せません。GPT-5やClaudeといった大規模言語モデル(LLM)は驚異的な知能を持ちながら、その根幹を支える「データ」はしばしば不安定。 Rubrik 調査によれば企業データの80%は非構造化(メール、PDF、スキャン文書など)。この雑多なデータで自律エージェントが動けば、エラーや誤認が一気に拡大してしまいます。

こうしたデータ信頼性の課題こそ、多くのエージェンティックAI導入が現場運用に至らない最大の要因です。課題はAIの推論性能だけでなく、「入力データ」をいかに正確に扱えるかにあります。

エージェンティックAIがデモ止まりから本格的なビジネス基盤へと進化するには、データ信頼性を支える専用レイヤー——つまり、人が読む文書を自律行動前にクリーンで構造化された信頼できるデータへと変換する層——が不可欠なのです。

エージェンティックAIとは?

エージェンティックAIとは、明確な目標を設定し、自律的に実世界のタスクを判断・遂行できるシステム技術群です。従来のチャットボットは受け身でテキスト返答するだけですが、エージェンティックAIは環境を認識し、推論し、人手不要で状況に即した判断・実行を繰り返します。

従来のAIが「次に何をすべき?」と尋ねるだけだったのに対し、エージェンティックAIは「何を実行するか決めて、実際に手続きまでする」ことができます。

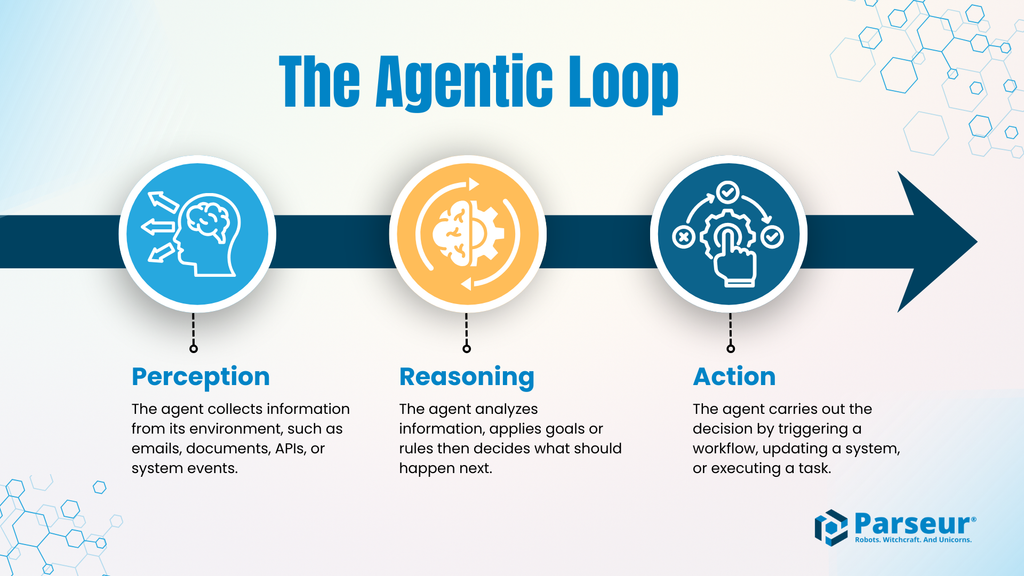

エージェンティック・ループ:知覚 → 推論 → 行動

多くのエージェンティックAIは次の基本ループで作動します:

- 知覚(Perception): 環境(メール、文書、API応答、システムイベントなど)から情報を受信。

- 推論(Reasoning): 情報を解釈し、既定ルールや目標に照らして次の行動を判断。

- 行動(Action): データベース更新、ワークフロー開始、支払処理、外部システム通知などを実行。

このループを繰り返し、エージェントはごくわずかな監督で自己完結します。新たな知覚がある限り、どんどん実行できるのです。

なぜリスクはより大きいのか?

AIが「内容生成」から「タスク実行」へ主役をシフトすると、エラーへの許容度が劇的に下がります。チャットボットの誤字程度なら問題ありませんが、自律エージェントが金額・顧客情報・数量を誤認し、そのままアクションすれば重大な業務トラブルにつながります。

具体的な失敗例:

- 誤った金額で請求書を処理

- 不正確な数量で発注

- 他顧客の情報を誤って書き換え

- 間違った仮定でワークフロー実行

エージェンティックAIにおいて、エラーは「見た目」だけでなく、事業の根幹そのものを揺るがすリスクとなります。

生成AI vs. エージェンティックAI

| 比較項目 | 生成AI | エージェンティックAI |

|---|---|---|

| 主な役割 | テキスト/画像/要約生成 | タスク実行とワークフロー進行 |

| 対話モデル | 都度ユーザー指示で反応 | 小規模な人手で自律運用 |

| 典型的な出力 | 提案文、説明、下書きなど | システム記録更新や実業務処理 |

| 意思決定フォーカス | 一貫した返答の生成 | 行動選択および実行 |

| エラー許容度 | 比較的高い(修正容易) | 低い(エラー発生=業務・財務に直結) |

| データ要件 | 曖昧や抜けのあるデータでも利用可能 | 正確・検証済み構造化データが必要 |

| リスク | 表面的なエラー・軽微な損失 | 業務全体・財務直結の重大なリスク |

「グラウンドトゥルース」問題

エージェンティックAIは、論理・API・フォーマットの明確な世界で動作します(JSONやXML、明確なフィールド名・型を要求)。一方、実際のビジネス環境はメールやPDF、スプレッドシート、人間が作成した添付ファイルなど非構造化データが大半です。

この「構造のギャップ」こそが自律エージェントの拡大・導入を阻害する最大の壁です。

エージェントが高精度な推論・アクションを実現するには、「グラウンドトゥルース」、すなわち信頼できる機械可読な事実ベースの入力が不可欠。しかしそれがない限り、どんなに知能が高いAIも推測の連鎖から脱せません。

なぜLLMだけでは限界があるのか

「LLM(大規模言語モデル)が全ての文書を単独で読んで処理できるのでは?」と思われがちですが、実運用の拡大とともにその脆弱性が表面化します。

幻覚(ハルシネーション)の発生

LLMは不確実な入力や情報が曖昧な箇所を、確率的に“推測”で埋めます。対話では問題なくとも、エージェンティックAIの現場でその推測がアクションに直結すると、重大な誤判断が現実に波及します。特にノイズ混在・長文の文書からのデータ抽出では幻覚率が高まることが研究でも指摘されています。

コストと遅延の問題

長いPDFやメール、画像化ドキュメントをLLMが処理するには大量のトークン消費が発生し、計算コストも大幅増、応答速度の遅延やレスポンス一貫性の低下も顕著です。大量処理やリアルタイム性が重視される現場では、深刻な技術的・コスト的障害になります。

一貫性の課題

堅牢な自動ワークフローには、毎回同じフィールド名・データ形式・スキーマでの出力が求められますが、LLMの結果は微妙な揺らぎがあり、ほんのわずかなズレでも後続の処理・自動化の障害となります。

失敗がどのように顕在化するか

信頼性に課題のある文書データでエージェントが動くと、エラーは直ちに現場で可視化されます。

たとえば請求書AIがPDFから異なるベンダー名を読み間違えて別口座に送金、購買エージェントが数字を誤認し在庫切れを見逃し、契約管理AIが更新条件を誤解して誤価格を複数顧客に適用――

こうした抽出エラーは決してレアな例外ではなく、ほぼ確実に関連する全システムに波及し誤動作の連鎖と信頼失墜を招きます。

これこそ“グラウンドトゥルース問題”です:エージェントは行動準備ができていても、正しい構造化データが無ければ「視界不良で自動運転」しているような危うさなのです。

欠けているレイヤー:インテリジェントドキュメントプロセッシング(IDP)

エージェンティックAIの現場失敗例は、推論能力が不十分なのではなく、「入力情報を構造化データとして安定して扱う手段がない」点に尽きます。その空白を埋めるのが インテリジェントドキュメントプロセッシング(IDP) です。

IDPは「人が作成した不規則な文書」と「自律エージェント」の間に、 解析(パース)レイヤー を導入します。AI・エージェントに非構造化データを直接読ませるのではなく、先に「構造化かつ精度確認済みデータ」に変換することで信頼性を大きく高められます。

このパースレイヤーこそがエージェンティックAIの安定稼働・拡張性の要です。AIが“推測”ではなく“根拠ある事実”のみで動く道筋を作ります。

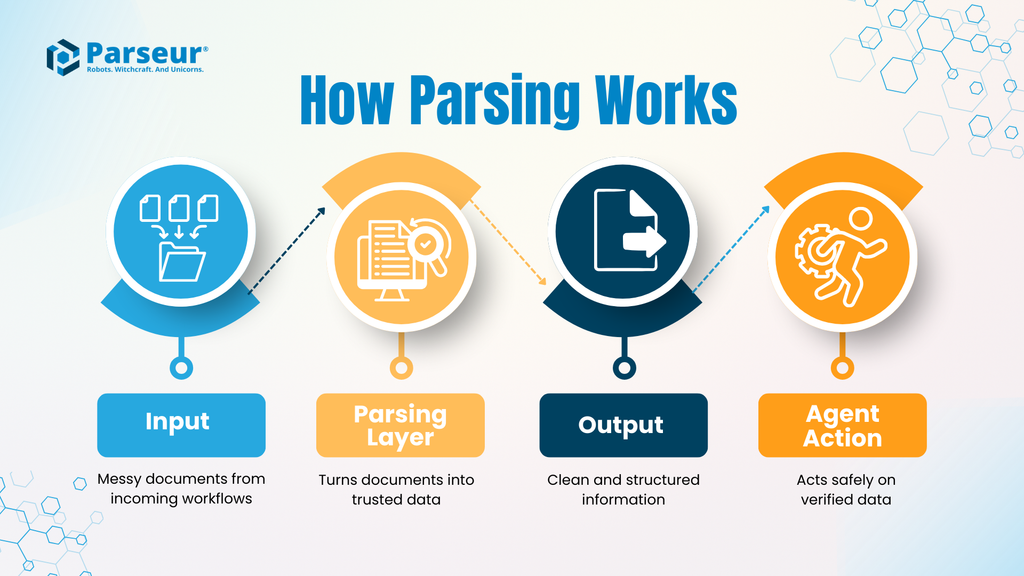

ドキュメントパースの流れ

代表的なIDPワークフローは以下のとおりです:

- 入力: 請求書、船荷証券、契約文書、メールなど、多様な型やレイアウト。

- パースレイヤー: IDPが所定フィールドを正確に抽出、日付や金額、識別子などを標準化と検証を実施(目的は精度と一貫性)。

- 出力: 一貫したスキーマによるクリーンな構造化データ(多くはJSON)。

- エージェントアクション: エージェントはこの検証済みデータを材料に業務実行に集中。

このように「文書理解」と「意思決定」の機能を切り分けることでリスクを抑え、プロセス全体の透明性が高まります。=AIが文書を“読む”必要はなく、検証済みの事実で直接“行動”できるのです。

なぜパースレイヤーがリスクプロファイルを変えるのか

解析レイヤーがなければ、エージェントは現実の雑多な非構造化文書から直接情報を得るため、小さな不一致が大規模な障害につながります。IDPを中間に挟むことで、曖昧さやばらつきは自動化前に吸収・調整可能です。

この差は大規模展開時ほど顕著です。例として、

Parseurの2026年調査 では、企業の88%が書類データ抽出エラーを経験。このまま自律エージェントを入れれば、リスクが膨大になります。

IDPの目的は「AIの知能を高める」のではなく、「自動化全体の安全性・信頼性を高める」こと。幻覚率を下げ、ワークフローの安定性や24時間自動化を支え、人的介入不要な運用を実現します。

多くの方がAIの知能面に目を向けがちですが、本当に“使える”AIには「データ信頼性」こそ最重要。そのためのパースレイヤーこそ、エージェンティックAIを夢物語からビジネスの日常ツール化へ導くカギなのです。

実務での活用例:Parseurが活かされる代表シナリオ

エージェンティックAIが実ビジネス現場で最大の価値を発揮するのは、「いつ」「正確な」「構造化データ」を安定的に受け取れるかにかかっています。以下では、パースレイヤーの有無が「安定した自動化」と「失敗する自動化」を分ける典型的なシナリオを紹介します。

例A:自律サプライチェーンのアップデート自動化

シナリオ:

物流会社からの遅延通知メールに、予定日・コンテナID・港スケジュール変更が本文やPDFで自由な書式で届く。

パースレイヤー未導入:

自律エージェントはメール本文を直接スキャンして日付やIDを特定しようとしますが、毎回フォーマットが異なり、抽出失敗や誤認識が頻発。稀な事例ではなく、情報見落としによる現場混乱・誤出荷など重大な業務停止につながります。

Parseur利用時:

メールや添付文書をまずパースレイヤー(Parseur)が受け、重要フィールド(コンテナID、新着予定日、港)を安定抽出・標準化。エージェントはクリーンなデータを即座に参照し、物流の再ルーティングやERP自動更新、予定調整まで正確に実行します。

例B:完全自動化された経理処理(AP)

シナリオ:

企業は請求書の受取~発注書照合~支払い承認までを自動化したい。請求書は形式も明細も様々。

課題:

自律エージェントがAP業務全体を担うには、全明細・単価・数量・合計額などが100%正確に読み取れるのが絶対条件。些細な誤認も照合失敗や誤った支払いに波及します。

信頼性のない抽出:

AIが金額や説明文で誤解・誤判定し、発注書とマッチングできず誤った承認をしてしまう。結果的に人手での訂正が急増し、自動化への信頼が薄れる。

Parseur利用:

請求書が1ピクセル単位で正確にパースされ、明細や合計額が一貫抽出と検証済みでエージェントの元へ。迷いなく照合・支払い・例外検出が実現します。

ヒューマン・イン・ザ・ループ(HITL)が最後の砦として不可欠な理由

エージェンティックAIの最大課題は、技術よりも「信頼性」です。業務や財務に直結する自動判断には、企業側の本能的な慎重さがあります。「暴走するエージェント」による連鎖エラー・損失リスクを避けるには、設計時点で「ヒューマン・イン・ザ・ループ(HITL)」の思想が不可欠です。

HITLは自動化の足かせではなく、「業務現場で安心して使える自動化」を可能にする仕組みです。

HITLがエージェンティックアーキテクチャに与える価値

優れたシステムほど、全自動化でなく「曖昧さ」や「例外発生時」のみ人が介入できる設計になっています。Parseurは「データがエージェントに届く前の検問所」として最適です。

規定通りの明確な文書なら構造化データをそのまま流し、曖昧・不一致・不明値の場合のみ人間にフラグを立てて確認や修正を促します。これにより:

- エージェントは定型・反復タスクを完全自動化

- 人は説明や判断が必要な場面のみ介入

これにより、自動化のスケールと精度・責任のバランスが両立します。

なぜHITLが信頼と導入を支えるのか

「人が確認する=自動化失敗」と思われがちですが、実際にはHITLによって高リスク環境下でもエージェンティックAIが運用可能となります。

HITLの無い自動化は「全自動だけど高リスク」か「人手頼みで効率悪化」かの二択。HITL設計は“ガードレール付き自動化”という最適解を提供します。

大企業・金融・監査分野では、以下の問いが常に重要になります:

- 曖昧データ発生時は誰が承認・修正するか

- 例外処理の管理責任はどこにあるか

- システムレベルでエラーの伝播はどう防ぐか

HITL対応パースレイヤーは、こうした経営課題をクリアにします。

まとめ

ヒューマン・イン・ザ・ループ(HITL)は“保険”ではなく、エージェンティックAIが現実の業務環境で本領を発揮するための不可欠な安全網です。曖昧なデータを自律エージェントが処理する前にキャッチし、HITLはAIを実験段階から“インフラ的な信頼ツール”へと進化させます。

2026年に向けた基盤づくり

今、私たちは「デジタル同僚」時代に突入しつつあります。単なる提案・応答にとどまらず、「本格的なビジネス遂行」を担う自律エージェントが現実のものとなっています。業務の迅速化やミス削減、人材の価値活動集中――すべての可能性が開けています。

ただし決定的な要件があります。「エージェントが行動するデータが信頼できること」が自律AI活用の絶対条件です。非構造化や混在データへの強引な自動化は、業務リスクと信頼崩壊しか招きません。大規模な自律型ビジネスに踏み出す前に、データパイプラインを厳密かつ監査可能、正確な構造化データに整備すべきです。

Parseurは、この「データ基盤作り」に最適な選択肢。エージェンティックAIの心臓部として、メール・PDF・各種文書を厳密に機械可読な信頼データへ変換します。クリーンな入力・ヒューマンチェック・構造化出力によって、自信あるオートメーションと日常使い可能なAIワークフロー、そして需要拡大にも耐える成長性を企業にもたらします。

よくある質問

エージェンティックAIが実験段階から実運用へと進化する中で、信頼性、データ品質、システム設計に関する疑問が高まっています。ここでは多くの方が混乱しやすいポイントにお答えします。

-

シンプルに言うと、エージェンティックAIとは何ですか?

-

エージェンティックAIは、情報を認識し、推論し、目標の達成のために自律的に行動するシステムを指します。チャットボットと違い、会話するだけでなく、最小限の人手で業務ワークフロー全体を完遂します。

-

なぜ非構造化データは自律エージェントにとって問題なのですか?

-

多くのビジネスデータは人間向けに作成されており、メールやPDF、スキャン文書など形式がバラバラです。このようなデータを確認せずに扱うとシステム全体にエラーが拡大するリスクがあります。

-

大規模言語モデル(LLM)は書類理解を単独でこなせますか?

-

LLMは文書を読むことができますが、高精度な構造化データの大量抽出には不安定さや一貫性の欠如が課題です。エージェンティックなワークフローでは、こうしたばらつきが誤動作やコスト増、業務トラブルに直結します。

-

インテリジェントドキュメントプロセッシング(IDP)はどんな役割ですか?

-

IDPは、非構造化文書を自律エージェントが利用できるクリーンな構造化データへ変換する専用レイヤーです。この工程を挟むことで業務信頼性が高まり、現実のビジネスへのAI導入が可能となります。

最終更新日