La IA agéntica promete sistemas capaces de generar resultados reales en los negocios, no solo respuestas. Sin embargo, la mayoría de los agentes autónomos están construidos sobre datos no estructurados como correos electrónicos, PDFs y documentos escaneados, fuentes sobre las que no pueden actuar con confianza. En este artículo analizamos por qué los datos estructurados son la capa esencial que falta en la IA agéntica y cómo una capa de análisis dedicada convierte agentes prometedores en sistemas verdaderamente confiables.

Puntos Clave:

- La IA agéntica marca una evolución de la generación de contenido a la ejecución de acciones empresariales, haciendo que los errores de datos tengan consecuencias mucho mayores.

- Los agentes autónomos requieren entradas limpias, estructuradas y validadas para operar con seguridad y a escala. Los LLM, por sí solos, no bastan.

- Parseur ofrece la capa fundamental de análisis que convierte documentos empresariales en datos estructurados y confiables, permitiendo a los agentes actuar de manera precisa y segura.

De la "Conversación" a la "Acción"

Los últimos años han sido testigos de un rápido avance en IA. En 2023 y 2024, el foco estuvo en la IA generativa: sistemas capaces de redactar correos, resumir documentos y responder a preguntas con flidez. Estas herramientas han transformado la interacción con el software, pero la mayoría se limitaba al intercambio conversacional.

Para 2026, la narrativa ha cambiado según Gartner: el 40% de las aplicaciones empresariales incluirán agentes de IA específicos para tareas. La siguiente ola es la IA agéntica: sistemas que no solo responden, sino que toman acción. Por ejemplo, un agente de IA puede enviar correos en tu nombre o ejecutar completamente un flujo de trabajo.

Es una promesa potente. Según Kong INC, el 90% de las empresas está adoptando agentes de IA activamente, y un 79% planea implementarlos a escala en los próximos tres años. Imagina una IA que gestione partes de la cadena de suministro, procese y pague facturas, o actualice el CRM automáticamente conforme llega nueva información. Sin tableros manuales, sin intervención repetitiva; solo resultados.

No obstante, bajo la superficie de entusiasmo, hay una realidad ineludible. Aunque los modelos de lenguaje como GPT-5 o Claude son cada vez más sofisticados, el "combustible" que consumen suele ser deficiente. Según Rubrik, el 80% de los datos empresariales sigue estando no estructurado, incluyendo correos electrónicos, PDFs, documentos escaneados y archivos adjuntos mal formateados. Cuando se fuerza a los agentes a actuar a partir de estos datos caóticos, los errores se disparan.

Por ello, muchos proyectos de ia agéntica se estancan o no pasan de la fase experimental. El cuello de botella no está en el razonamiento ni en la planificación, sino en la confianza en los datos de entrada.

Para que la ia agéntica evolucione de una demo asombrosa a infraestructura fiable, necesita una capa dedicada a la fiabilidad de los datos, capaz de transformar información legible solo por humanos en hechos claros y estructurados antes de cualquier acción autónoma.

¿Qué Es la IA Agéntica?

La IA agéntica describe sistemas que operan de forma autónoma para alcanzar objetivos definidos. A diferencia de los chatbots tradicionales, que esperan instrucciones y devuelven texto, estos sistemas perciben información, razonan y actúan sin intervención humana constante.

En la práctica, un agente agéntico no solo responde a una pregunta como "¿Qué debería hacer ahora?". Decide y ejecuta la acción de manera autónoma.

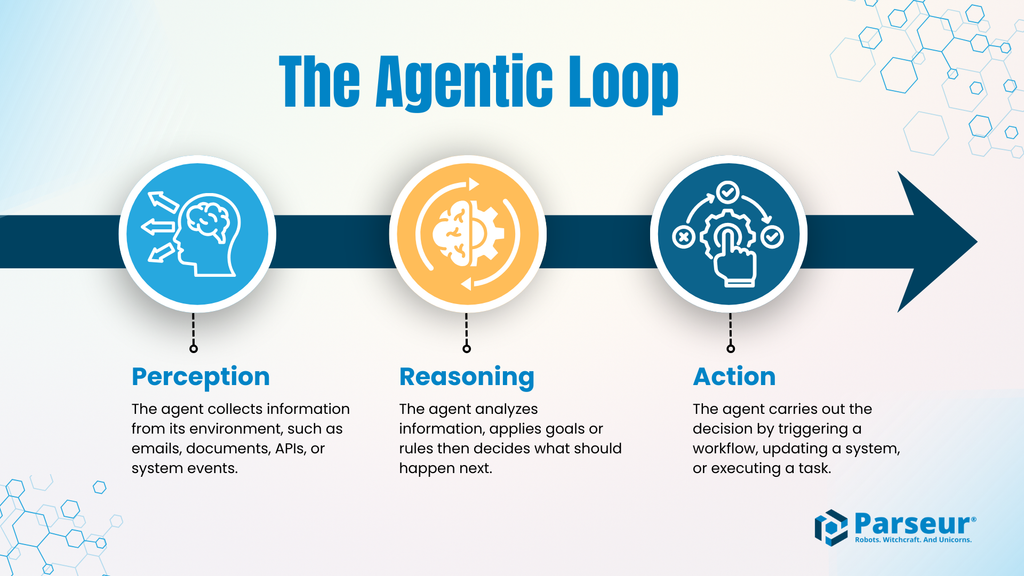

El Bucle Agéntico: Percepción → Razonamiento → Acción

Casi todos los sistemas de la ia agéntica siguen este ciclo central:

- Percepción: El agente recibe información de su entorno, ya sea correos electrónicos, documentos, respuestas de APIs o eventos de sistema.

- Razonamiento: Interpreta esa información aplicando reglas y objetivos, y determina qué hacer a continuación.

- Acción: Ejecuta una tarea, como actualizar un registro, iniciar un flujo de trabajo, enviar un pago o avisar a otro sistema.

Este bucle se repite y permite que el agente actúe de manera continua y autónoma mientras reciba nuevos datos.

¿Por qué las consecuencias son más graves?

El salto de la generación de texto a la ejecución de acciones supone que los errores tienen un impacto mucho mayor. Un chatbot que se equivoca en una respuesta genera solo una molestia. Por el contrario, un agente autónomo que recoge mal un dato, identifica a un cliente incorrecto o actúa sobre información incompleta puede causar verdaderos incidentes operativos.

Ejemplos típicos:

- Pagar una factura errónea o por la cantidad incorrecta

- Solicitar volúmenes de inventario equivocados

- Actualizar información del cliente equivocado

- Activar procesos basados en suposiciones incorrectas

En la ia agéntica, los errores no solo dañan la imagen de la empresa: interrumpen procesos críticos.

IA Generativa vs. IA Agéntica

| Aspecto | IA Generativa | IA Agéntica |

|---|---|---|

| Propósito principal | Genera contenido como textos, imágenes o resúmenes | Ejecuta tareas y flujos de trabajo para lograr un objetivo |

| Modelo de interacción | Responde a indicaciones del usuario a demanda | Opera de forma autónoma con mínima intervención humana |

| Salidas típicas | Borradores, explicaciones, sugerencias | Actualizaciones de sistemas, transacciones, acciones disparadas |

| Toma de decisiones | Enfocada en producir respuestas coherentes | Enfocada en elegir y ejecutar las siguientes acciones |

| Tolerancia al error | Relativamente alta; los errores son visibles y fáciles de corregir | Muy baja; los errores pueden afectar operaciones o finanzas |

| Requisitos de datos | Puede trabajar con información ambigua o incompleta | Requiere datos precisos, estructurados y validados |

| Perfil de riesgo | Los errores suelen ser cosméticos o informativos | Los errores pueden causar fallos operativos o financieros |

El Problema del “Ground Truth”

Los sistemas de ia agéntica dependen de lógica, APIs y datos estructurados (JSON, XML, etc.) con campos, formatos y estructuras definidos y predecibles. Sin embargo, en la realidad de las empresas la información llega en correos electrónicos, PDFs, hojas de cálculo, documentos escaneados o archivos adjuntos escritos por humanos.

Este desajuste es el gran cuello de botella para los agentes autónomos.

Antes de razonar o actuar, un agente necesita "ground truth": datos comprobables y legibles por máquina en los que pueda confiar. Sin esta base, incluso el mejor agente estará obligado a improvisar.

¿Por Qué No Basta con los LLM?

Puede parecer que los modelos de lenguaje grande (LLM) pueden simplemente leer cualquier documento y comprenderlo. Pero este planteamiento conlleva varias desventajas, más visibles cuanto más se automatiza el proceso.

Alucinaciones

Los LLM son modelos probabilísticos: si falta información, es confusa o está mal formateada, no dejan de actuar, sino que rellenan los huecos con suposiciones. En un entorno conversacional, esto puede no ser grave. Pero en un flujo de trabajo agéntico, una suposición se convierte en una acción real. Los estudios demuestran que los errores ("alucinaciones") aumentan al pedir a los modelos que extraigan datos estructurados de documentos ruidosos, especialmente cuando la entrada es amplia o compleja.

Costo y latencia

Procesar PDF completos, hilos de correo largos o documentos escaneados con un LLM implica un alto coste computacional. Cada documento consume recursos y tiempo, lo que ralentiza el proceso y puede hacer inviable la tarea cuando se maneja alto volumen o se requiere respuesta en tiempo real.

Inconsistencia

Los flujos agénticos necesitan constancia: el mismo nombre de campo, tipo de dato y formato en cada ronda para poder automatizar procesos fiables. Pero la salida de los LLM a menudo varía entre ejecuciones, incluso con entradas similares. Esa leve inconsistenciapuede interrumpir la automatización.

¿Cómo se manifiestan estos fallos?

Los errores de interpretación de datos por parte de agentes autónomos afectan pronto y de modo visible.

Ejemplo: un agente que procesa facturas lee mal el proveedor de un PDF y paga a la cuenta equivocada. Otro rellena erróneamente la cantidad en una orden de compra, causando escasez de inventario. Un agente de contratos interpreta incorrectamente una cláusula y cambia términos de precios para varias cuentas.

No son incidentes aislados. En la ia agéntica, un fallo puede propagarse rápidamente a través de sistemas conectados, generando más errores por arrastre y requiriendo intervención manual para contener el daño.

Este es el problema del ground truth: los agentes están listos para actuar, pero sin datos estructurados y fiables, trabajan con información borrosa.

La Capa Faltante: Procesamiento Inteligente de Documentos (IDP)

La ia agéntica falla en la práctica no porque le falte capacidad de decisión, sino por la falta de una interpretación estructurada y confiable de los datos de entrada. Aquí es donde entra el Procesamiento Inteligente de Documentos (IDP).

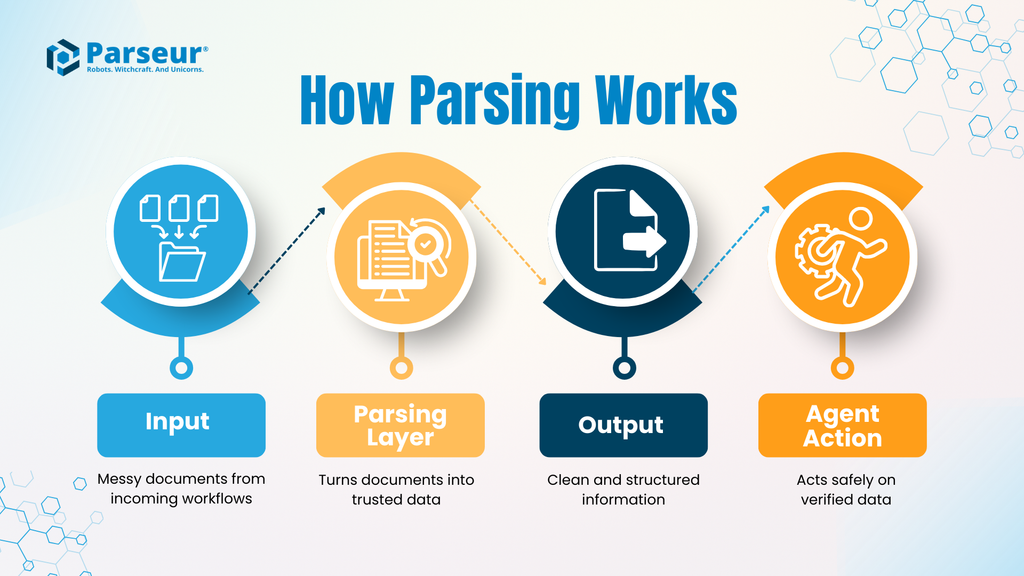

El IDP incorpora una capa de análisis entre los documentos desordenados y los agentes de IA autónomos. En vez de obligar al agente a analizar datos en bruto, esta capa transforma documentos en datos limpios y estructurados antes de cualquier acción automatizada.

En una arquitectura agéntica, esta capa estabilizadora garantiza que los agentes operen sobre hechos, no sobre suposiciones.

¿Cómo funciona el análisis de documentos?

Típicamente, un flujo IDP implica:

- Entrada: Un documento real (factura, conocimiento de embarque, contrato, correo). Estas entradas presentan formatos, diseños y estructuras muy variados.

- Capa de análisis: El IDP extrae campos relevantes, estandariza formatos (fechas, monedas, identificadores) y valida los datos según reglas aplicables. El objetivo es asegurar precisión y consistencia, no interpretación.

- Salida: Datos limpios y estructurados (normalmente en JSON) que siguen un esquema predecible.

- Acción del agente: El agente toma esta información y ejecuta la tarea sabiendo que la entrada es precisa y fiable.

Al separar el análisis documental de la toma de decisiones, las organizaciones mitigan riesgos y ganan transparencia. El agente no necesita "leer" documentos; actúa con datos verificados.

¿Por qué esta capa reduce enormemente el riesgo?

Sin una capa de análisis, el agente enfrenta directamente toda la ambigüedad de los documentos reales. Cada inconsistencia es un posible punto de fallo. Con IDP, esa incertidumbre se resuelve aguas arriba, antes de que se active la automatización.

Esta diferencia resulta crítica a gran escala. Por ejemplo:

Según la encuesta de Parseur de 2026, el 88% de las empresas identifican errores en datos extraídos de documentos. Un agente autónomo con esta tasa de error es un riesgo, no una solución.

El IDP no vuelve al agente más inteligente, sino más seguro. Disminuye el riesgo de errores y alucinaciones, mejora la confianza en el flujo de trabajo y permite a las empresas automatizar sin depender de supervisión humana constante.

En la ia agéntica, la inteligencia suele acaparar la atención, pero la fiabilidad es lo que la hace viable. La capa de análisis es el eslabón perdido que convierte prototipos en sistemas verdaderamente operativos.

Casos de Uso Reales: Dónde los Agentes Necesitan Parseur

La ia agéntica se muestra valiosa cuando opera dentro de flujos de trabajo reales. El éxito depende menos de la sofisticación del razonamiento y más de que el agente reciba datos precisos y estructurados cuando debe actuar. Veamos dos casos típicos en los que una capa de análisis determina si la automatización será confiable o fallará.

Caso de Uso A: Cadena de suministro autónoma

Escenario:

Llega una notificación de retraso de envío por correo electrónico de un proveedor logístico. El mensaje contiene una nueva fecha de llegada, un ID de contenedor y un horario de puerto actualizado, todo incluido en texto libre o como adjunto en PDF.

Sin capa de análisis:

El agente intenta deducir la nueva fecha de entrega a partir del correo directamente. El formato difiere del estándar previo y el ID de contenedor aparece inesperadamente. El agente omite la actualización o interpreta mal un campo, fallando al actualizar el ERP, la planificación no se ajusta y la fábrica se prepara para inventario que no llegará a tiempo. La producción se retrasa o para: solo se detecta cuando ya hay consecuencias.

Con Parseur:

Tanto el correo como el adjunto pasan por la capa de análisis. Parseur extrae el ID del contenedor, la nueva fecha y ubicación con su motor de IA, entregando una actualización limpia y estructurada. El agente recibe los datos en tiempo real, ajusta la logística, actualiza el ERP y reprograma la producción automáticamente. Un posible fallo operativo se resuelve como una reacción controlada y automatizada.

Caso de Uso B: Función de cuentas por pagar “autónoma”

Escenario:

Una empresa desea automatizar la conciliación de facturas. Las facturas entrantes deben cotejarse con órdenes de compra, validarse y aprobarse sin intervención manual.

El reto:

Los agentes de cuentas por pagar solo pueden automatizar este flujo si cada línea, cantidad, precio, impuestos y total se extraen correctamente. Incluso errores menores pueden romper la lógica o causar pagos incorrectos.

Sin extracción confiable:

El agente interpreta mal el total de una línea o confunde productos similares. Fallan los cruces con la orden de compra, las facturas se rechazan incorrectamente o, peor aún, se aprueban con importes incorrectos. La revisión manual aumenta y cae la confianza en la automatización.

Con Parseur:

Las facturas se analizan con precisión, capturando todas las líneas de manera consistente, estandarizando formatos y validando totales antes de que el agente vea los datos. Así, el agente puede conciliar y aprobar pagos con confianza, involucrando humanos solo ante verdaderas excepciones.

Por Qué el Humano en el Bucle (HITL) Es la Red de Seguridad

Uno de los mayores frenos para adoptar la ia agéntica no es la tecnología, es la confianza. Es lógico que las empresas sean precavidas frente a sistemas autónomos que pueden tomar decisiones que afectan dinero, operaciones o clientes. El temor a que un "agente descontrolado" actúe con datos defectuosos es real, especialmente en sistemas conectados.

Aquí es fundamental el diseño “humano en el bucle” (HITL).

HITL no enlentece la automatización: la hace viable en el mundo real.

Cómo encaja HITL en una arquitectura agéntica

En sistemas bien diseñados, los humanos no revisan cada acción; solo intervienen ante incertidumbre. Parseur cumple un papel clave al ser punto de control antes de que los datos se entreguen al agente.

Cuando el documento es claro y la extracción fiable, los datos estructurados fluyen sin intervención. Si el documento es ambiguo, falta información o los valores son inesperados, Parseur puede marcarlo para revisión humana. Solo una vez verificados o corregidos los datos, el flujo continúa.

Así, el sistema queda bajo control:

- Los agentes gestionan las tareas repetitivas y predecibles.

- Los humanos solo intervienen donde se requiere juicio o contexto adicional.

El resultado: escalabilidad sin sacrificar precisión ni trazabilidad.

Por qué HITL aumenta la confianza, no la reduce

Existe el mito de que requerir validación humana significa fracaso en la automatización. Al contrario: HITL hace posible ejecutar la ia agéntica de forma segura en contextos complejos.

Sin HITL, las empresas se ven forzadas a elegir entre automatización total y riesgo inaceptable, o revisión manual exhaustiva (perdiendo eficiencia). HITL ofrece un punto intermedio seguro.

Esto es esencial para la adopción en grandes empresas. Auditores, compliance y directivos necesitan respuestas claras:

- ¿Qué pasa con los datos ambiguos?

- ¿Quién revisa excepciones?

- ¿Cómo se evita que los errores se propaguen?

Una capa de análisis con HITL lo soluciona.

En resumen

El humano en el bucle no es un fracaso. Es la red de seguridad que permite que la ia agéntica sea escalable y confiable. Al detectar ambigüedad antes de accionar, HITL transforma agentes experimentales en infraestructura empresarial en la que realmente se puede confiar.

Creando la Infraestructura para 2026

Entramos en la era de los Coworkers Digitales: agentes autónomos que no solo sugieren acciones, sino que ejecutan flujos completos de trabajo empresarial. El potencial es enorme: más velocidad, menos errores y la oportunidad de centrar el talento humano en decisiones estratégicas.

Pero esta promesa exige una condición: los agentes solo serán tan confiables como los datos que reciben. Automatizar acciones sobre datos desordenados o no estructurados equivale a asumir riesgos operativos y perder rápidamente la confianza. Antes de automatizar, las organizaciones deben asegurarse de que los datos sean precisos, estructurados y auditables.

Aquí destaca el papel de Parseur. Como el “motor” de la ia agéntica, Parseur transforma correos electrónicos, PDFs y documentos en datos verificables y legibles por máquina. Con entradas limpias, revisiones humanas en el bucle y salidas estructuradas, los agentes pueden generar operaciones confiables y preparadas para escalar con éxito.

Preguntas Frecuentes

A medida que la IA agéntica pasa de la experimentación a la implementación en el mundo real, surgen preguntas inevitables sobre confiabilidad, calidad de datos y diseño de sistemas. Las siguientes preguntas frecuentes abordan algunos de los puntos más comunes de confusión.

-

¿Qué es la IA agéntica, en términos simples?

-

IA agéntica se refiere a sistemas que perciben información, razonan sobre ella y actúan de forma autónoma para alcanzar un objetivo. A diferencia de los chatbots, los sistemas agénticos no solo responden; ejecutan tareas a lo largo de flujos de trabajo con mínima intervención humana.

-

¿Por qué los datos no estructurados son un problema para los agentes autónomos?

-

La mayoría de los datos empresariales llegan en formatos diseñados para humanos, no para máquinas. Correos electrónicos, PDFs y documentos escaneados carecen de una estructura consistente, lo que hace difícil que los agentes los interpreten con fiabilidad. Actuar sobre estos datos sin validación aumenta el riesgo de errores que pueden propagarse a través de los sistemas.

-

¿Pueden los modelos de lenguaje grande entender documentos por sí solos?

-

Los LLM pueden leer documentos, pero son probabilísticos e inconsistentes al extraer datos precisos y estructurados a gran escala. En flujos de trabajo agénticos, esta variabilidad puede llevar a acciones incorrectas, mayores costos y fallos operativos.

-

¿Qué papel juega el Procesamiento Inteligente de Documentos (IDP)?

-

El IDP actúa como una capa dedicada que transforma documentos no estructurados en datos limpios, estructurados y legibles por máquina antes de que lleguen al agente autónomo. Esta separación mejora la confiabilidad, reduce el riesgo y hace que los sistemas agénticos sean viables en entornos empresariales reales.

Última actualización el