L’agentic AI promette sistemi in grado non solo di generare risposte, ma di compiere azioni operative concrete per il business. Tuttavia, la maggior parte degli agenti autonomi si basa ancora su dati non strutturati, come email, PDF e documenti scansionati, che non consentono di agire in modo affidabile. In questo articolo analizziamo perché i dati strutturati siano il livello mancante nell’agentic AI e come uno strato di parsing dedicato possa trasformare agenti promettenti in sistemi affidabili.

Punti Chiave:

- L’agentic AI sposta l’intelligenza artificiale dalla semplice generazione di contenuti all’esecuzione di azioni di business reali, con un conseguente drastico aumento dei costi legati a eventuali errori sui dati.

- Gli agenti autonomi necessitano di input puliti, strutturati e verificati per operare in sicurezza su larga scala. I soli LLM non sono sufficienti.

- Parseur fornisce lo strato critico di parsing che trasforma documenti reali in dati affidabili e strutturati, permettendo agli agenti di agire con sicurezza anziché affidarsi a supposizioni.

Il passaggio dal “chattare” al “fare”

Negli ultimi anni, l’intelligenza artificiale ha compiuto grandi progressi. Nel 2023 e 2024, l’attenzione è stata rivolta in particolare alla generative AI: sistemi capaci di scrivere email, riassumere documenti e rispondere a domande in modo naturale. Questi strumenti hanno rivoluzionato l’interazione con il software, ma si sono limitati quasi sempre alla conversazione.

Nel 2026, però, il paradigma cambia, con Gartner che prevede il 40% delle applicazioni enterprise dotate di agenti AI specifici per task. La nuova ondata si chiama agentic AI: sistemi progettati non solo per rispondere, ma per agire realmente. Invece di scrivere la bozza di un’email, un agente AI può inviarla direttamente per conto tuo. Invece di suggerire i prossimi passi, può eseguire l’intero flusso di lavoro.

La promessa è notevole. Secondo Kong INC, il 90% delle aziende sta adottando agenti AI e il 79% prevede una diffusione su larga scala entro tre anni. Immagina un’IA che gestisce parti della supply chain, elabora e paga fatture o aggiorna il CRM appena arrivano nuove informazioni. Niente più dashboard, niente più task manuali ripetitivi: solo risultati tangibili.

Sotto la superficie dell’entusiasmo, però, si nasconde una criticità. Anche se i “cervelli” di questi sistemi – i modelli linguistici come GPT-5 o Claude – diventano più potenti, il “carburante” disponibile resta spesso inaffidabile. In base a Rubrik, l’80% dei dati aziendali è non strutturato: email, PDF, documenti scansionati e allegati senza un formato coerente. Se gli agenti devono agire su questo caos di dati, gli errori si moltiplicano.

Molti progetti di agentic AI restano bloccati allo stadio pilota proprio per questo. Il problema non è tanto la logica o la pianificazione, quanto la fiducia negli input.

Per trasformare l’agentic AI da demo entusiasmante a infrastruttura aziendale concreta, è necessario uno strato intermedio dedicato a garantire la qualità dei dati: serve convertire informazioni leggibili dagli umani in fatti puliti e strutturati, prima di ogni azione autonoma.

Cos’è l’Agentic AI?

L’Agentic AI descrive sistemi progettati per funzionare in autonomia verso obiettivi specifici. A differenza dei chatbot tradizionali – limitati a rispondere a prompt testuali – gli agenti seguono un ciclo completo: percepiscono informazioni, ragionano e agiscono, senza necessità di continuo intervento umano.

In concreto, un agente non si limita a rispondere a “Cosa dovrei fare ora?”: decide ed esegue la prossima azione in autonomia.

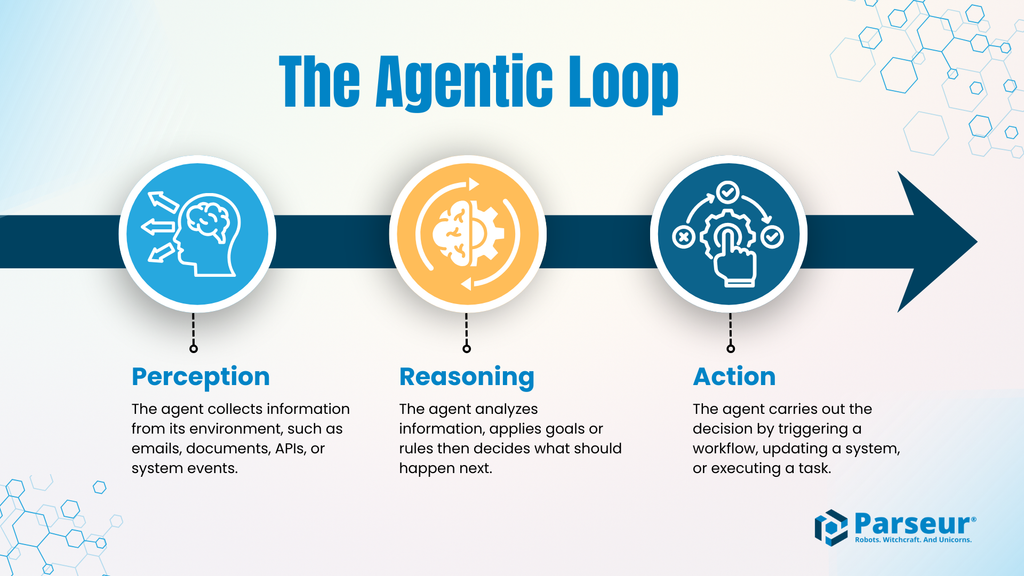

Il ciclo agentico: Percezione → Ragionamento → Azione

La maggior parte dei sistemi agentici segue questo ciclo fondamentale:

- Percezione: l’agente acquisisce dati dal suo contesto – siano essi email, documenti, API o eventi di sistema.

- Ragionamento: interpreta e valuta le informazioni, applica regole o obiettivi e decide i passi successivi.

- Azione: l’agente compie l’attività assegnata, dalla modifica di una scheda all’attivazione di un workflow, fino all’esecuzione di pagamenti o notifiche a sistemi esterni.

Il ciclo si ripete: basta fornire nuovi dati e l’agente prosegue autonomamente.

Perché le responsabilità sono aumentate?

Quando l’AI passa dal generare contenuti all’eseguire vere azioni, il costo degli errori aumenta drasticamente. Un chatbot che commette un refuso è inoffensivo, ma un agente autonomo che interpreta male un importo o riconosce il cliente sbagliato rischia di bloccare processi e generare problemi operativi concreti.

Esempi di errori tipici:

- Pagamento errato di una fattura

- Ordinazione di scorte in quantità sbagliata

- Modifica di dati del cliente sbagliato

- Attivazione di automazioni su informazioni errate

Nell’agentic AI, l’errore non è decorativo: è operativo.

Agentic AI vs Generative AI

| Aspetto | Generative AI | Agentic AI |

|---|---|---|

| Obiettivo | Creazione di contenuti (testi, immagini, riepiloghi) | Esecuzione di compiti/processi per raggiungere obiettivi |

| Interazione | Risponde a richieste dell’utente | Opera autonomamente, con intervento umano minimo |

| Output | Bozze, spiegazioni, suggerimenti | Transazioni, aggiornamenti, azioni operative |

| Decision Making | Punta a risposte coerenti | Sceglie e compie autonomamente la prossima azione |

| Tolleranza errore | Piuttosto elevata; errori evidenti e facili da individuare | Bassissima; errori con impatti finanziari/operativi |

| Requisiti dati | Può lavorare su input incompleto o ambiguo | Richiede dati strutturati, precisi e validati |

| Rischiosità | Gli errori spesso sono estetici o informativi | Gli errori si traducono in danni operativi reali |

Il problema del “ground truth”

Gli agenti agentici si aspettano input strutturati: JSON, XML, dati con campi chiari, formati precisi e strutture prevedibili. Ma il business reale usa tutt’altro: le informazioni vitali circolano via email, PDF, spreadsheet, documenti scansionati o allegati informali generati da persone.

Questo disallineamento è la vera barriera all’automazione su larga scala.

Prima che un agente possa ragionare o agire, serve quindi il “ground truth”: fatti affidabili, macchine leggibili e verificabili. Senza queste fondamenta, anche i sistemi agentici più raffinati devono improvvisare.

Perché gli LLM non bastano da soli?

Un errore diffuso è pensare che i large language model (LLM) possano semplicemente “capire” qualsiasi documento grezzo. Nella pratica, questo approccio moltiplica i rischi man mano che l’automazione si estende.

Allucinazioni e inaffidabilità

Gli LLM sono per loro natura probabilistici: in assenza di dati certi o in presenza di formati ambigui, non si bloccano, ma “indovinano”. In chat questo può far sorridere; in automazione, un’ipotesi errata può produrre un’azione sbagliata. Studi recenti mostrano che le allucinazioni aumentano quando gli LLM devono estrarre dati strutturati da documenti complessi e lunghi.

Costi e latenze operative

Elaborare PDF corposi, lunghe email o documenti scansionati con un LLM implica costi computazionali elevati: più token da processare, tempi più lunghi, performance meno stabili. Per un agente che deve operare su dati in tempo reale o in grandi volumi, questo è un collo di bottiglia concreto.

Incoerenza nei dati

L’automazione agentica fa affidamento sulla coerenza: campi, formati e strutture invariabili per ogni azione. Gli output dei LLM invece variano spesso in minimi dettagli, anche con input apparentemente identici. Questo basta per rompere i workflow automatici.

Quando gli errori si traducono in conseguenze reali

Se gli agenti agiscono su dati documentali non affidabili, il fallimento non tarda ad arrivare:

- L’agente di contabilità interpreta male il nome del fornitore nel PDF, autorizzando il pagamento sbagliato.

- L’agente acquisti inserisce una quantità errata nell’ordine, provocando una crisi di stock imprevedibile.

- L’agente contratti fraintende una clausola, applicando termini errati a decine di account.

E non si tratta di eccezioni: in ambienti agentici, l’errore si propaga, generando una reazione a catena di fallimenti, rectifiche manuali e diffidenza verso l’automazione.

Questo è il cuore del problema “ground truth”: i sistemi agentici possono agire, ma senza dati strutturati e affidabili rischiano di farlo a tentoni, aumentando l’esposizione al rischio.

Il livello mancante: Intelligent Document Processing (IDP)

Se l’agentic AI fatica ad affermarsi nel business reale, il motivo non è l’intelligenza dei modelli ma la mancanza di interpretazione affidabile degli input documentali. Qui entra in gioco l’Intelligent Document Processing (IDP).

L’IDP crea uno strato di parsing tra il caos dei documenti prodotti dagli umani e i sistemi agentici autonomi. Invece di forzare agenti o LLM a interpretare input disordinati, questo livello converte i documenti in dati strutturati e certi, prima che venga intrapresa qualsiasi azione.

Nell’architettura agentica, questo strato stabilizza il sistema: gli agenti lavorano sui fatti, non sulle supposizioni.

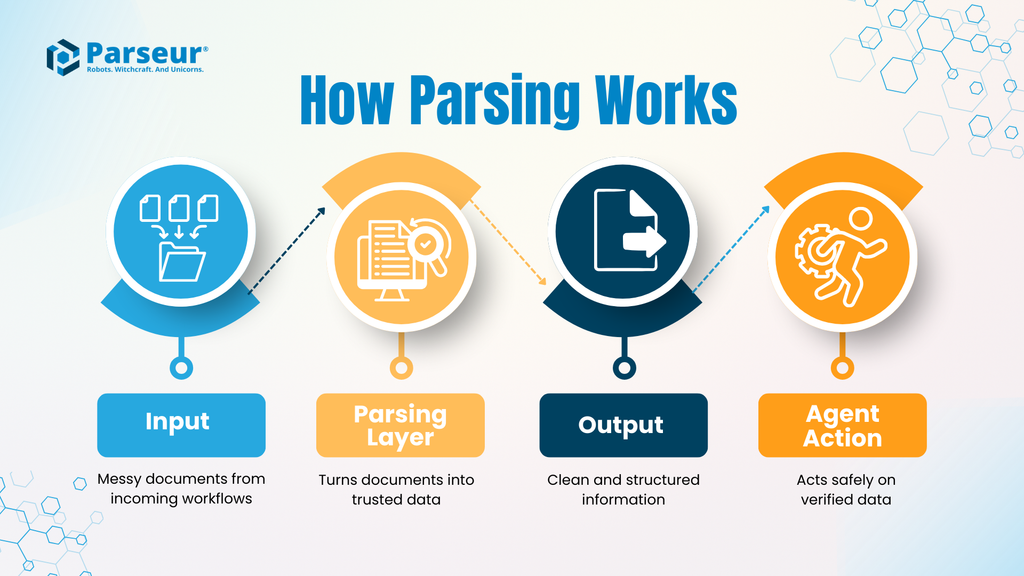

Come funziona il parsing documentale?

Un workflow IDP tipico comprende:

- Input: un documento reale come una fattura, polizza di carico, contratto o email – ognuno con formato, layout e struttura differenti.

- Parsing: la soluzione IDP estrae i campi target, uniforma i formati (date, valute, ID), convalida i dati secondo regole prestabilite. Non interpreta in senso lato, ma punta a precisione e coerenza.

- Output: dati puliti e strutturati, solitamente in JSON, conformi a un formato previsto.

- Azioni agentiche: l’agente usa questi dati strutturati per agire in sicurezza, certo che gli input siano affidabili.

Con questa separazione tra comprensione documentale e automazione, il rischio diminuisce e la trasparenza aumenta: l’agente non “legge”, ma opera solo su dati verificati.

Perché questo livello riduce davvero il rischio?

Senza parsing dedicato, gli agenti espongono l’intero sistema all’ambiguità dei documenti. Ogni incoerenza rappresenta un potenziale punto di rottura. L’IDP intercetta le incertezze prima dell’automazione, proteggendo il workflow dagli errori più insidiosi.

Questo diventa decisivo nella fase di scala: secondo il sondaggio Parseur 2026, l’88% delle imprese segnala errori nei dati documentali. Un agente con l’88% di tasso d’errore non aggiunge valore, ma costituisce un rischio.

L’IDP non aumenta l’intelligenza degli agenti, ma li rende affidabili: riduce le allucinazioni, migliora la stabilità dei processi e consente alle aziende di automatizzare in tranquillità, senza supervisione continua.

Nel mondo agentic AI, l’intelligenza fa notizia, ma è l’affidabilità che rende un sistema usabile. Lo strato di parsing è ciò che trasforma esperimenti in operation concrete.

Casi d’uso reali: dove gli agenti hanno bisogno di Parseur

L’agentic AI dispiega il suo potenziale nei workflow aziendali reali. Qui la differenza tra successo e blocco dipende meno dal modello AI in sé, e più dal fatto che riceva al momento giusto dati strutturati e affidabili. Vediamo due scenari (tra i tanti) dove uno strato di parsing è la chiave per passare dall’automazione teorica a quella realmente funzionante.

Caso d’uso A: La gestione autonoma della supply chain

Scenario:

Una email dal fornitore logistico notifica un ritardo consegna. Dentro il messaggio (o in un PDF allegato) ci sono nuova data di arrivo, ID del container e programma rivisto, spesso in formati liberi o non standardizzati.

Senza parsing dedicato:

L’agente tenta di estrarre informazioni direttamente dall’email. Ma la posizione dell’ID container è diversa dal solito, la data di arrivo ha formato inconsueto. L’agente sbaglia campo, non aggiorna l’ERP, la pianificazione resta invariata e la produzione si ferma o rallenta. Il danno si scopre a ritardo già avvenuto.

Con Parseur:

Email e allegato sono prima processati dal livello di parsing. Parseur estrae ID, date, posizioni con alta precisione e restituisce dati puliti e strutturati in output. L’agente può aggiornare ERP, ridefinire la logistica e modificare il planning in tempo reale: l’imprevisto viene gestito automaticamente, assicurando continuità operativa.

Caso d’uso B: La contabilità fornitori “self-driving”

Scenario:

Un’azienda vuole automatizzare la riconciliazione delle fatture: ogni fattura va abbinata al relativo ordine, verificata e approvata senza intervento manuale.

La sfida:

Gli agenti AP possono operare solo se righe, quantità, prezzi, tasse e totali sono estratti con precisione. Minimi errori fanno saltare i match o peggio, autorizzano pagamenti errati.

Senza estrazione affidabile:

L’agente può confondere i totali, invertire prodotti simili o mancare una riga. Gli ordini non vengono abbinati correttamente, le fatture sono segnalate come fallite o processate in modo scorretto, aumentando il carico sul personale.

Con Parseur:

Le fatture vengono elaborate con parsing accurato, le righe sono estratte a livello granulare, i totali verificati e i dati formattati in modo coerente. L’agente gestisce il workflow in tranquillità, intervenendo sulle eccezioni solo quando le vere discrepanze sono rilevate.

Perché il Human-in-the-Loop (HITL) è la rete di sicurezza

Un ostacolo decisivo all’adozione dell’agentic AI è la fiducia. Le aziende sono prudenti a delegare compiti critici, come decisioni finanziarie o operative, ad agenti automatici. Il rischio di “azioni fuori controllo” dovute a dati errati è tangibile e cresce quanto più i sistemi sono interconnessi.

Ecco perché la progettazione human-in-the-loop (HITL) è fondamentale.

L’HITL non limita l’automazione: la rende davvero praticabile nelle aziende.

Come HITL si integra nell’architettura agentica

In un buon sistema, il personale non verifica ogni output: interviene solo se emerge incertezza. Parseur funge da checkpoint: i dati strutturati validi passano direttamente al workflow, mentre quelli ambigui o con campi incoerenti vengono segnalati per revisione umana. L’operatore valida o corregge, poi si procede con l’automazione.

Questo crea un sistema scalabile ma protetto:

- Gli agenti eseguono task ripetibili e affidabili

- L’operatore umano interviene solo per giudizio o contesto non codificabile

Il risultato: automazione che cresce senza sacrificare accuratezza né responsabilità.

HITL aumenta la fiducia senza ostacolare la velocità

È falso credere che la revisione umana sia il fallimento dell’automazione: l’HITL è ciò che rende l’agentic AI sostenibile in ambiti complessi.

Senza HITL, le aziende devono scegliere tra automazione totale rischiosa o manualità inefficiente. L’HITL offre una terza via: automazione con reti di sicurezza integrate.

Per il business, questo è cruciale. Compliance, audit e management vogliono risposte chiare su:

- Cosa accade se i dati sono incerti?

- Chi approva l’eccezione?

- Come si blocca la propagazione degli errori?

Uno strato parsing + HITL offre garanzie solide per ciascun punto.

Il takeaway

L’human-in-the-loop non è un compromesso, ma la condizione abilitante perché l’agentic AI sia realmente utilizzabile. Gestendo l’incertezza prima che l’azione parta, trasforma l’AI agentica da esercizio di stile a infrastruttura affidabile, pronta per il business.

Costruire l'infrastruttura per il 2026

Sta nascendo un’era di “colleghi digitali”: agenti autonomi capaci non solo di suggerire o rispondere, ma di eseguire workflow critici su larga scala. Il vantaggio potenziale è enorme: operazioni più snelle, meno errori, persone focalizzate su decisioni strategiche invece che su compiti ripetitivi.

Ma questa promessa si basa su un presupposto chiave: l’affidabilità dell’agente dipende dalla qualità dei dati su cui agisce. Affidare a un’agentic AI dati incompleti o disordinati significa accettare gravi rischi operativi. Prima di automatizzare le azioni, bisogna assicurare che la pipeline dati sia precisa, strutturata e verificabile.

Qui entra in gioco Parseur: come motore dell'agentic AI, trasforma email, PDF, documenti vari in dati perfetti, pronti per l'automazione. Grazie a input puliti, sicurezza human-in-the-loop e output strutturati, gli agenti possono agire con fiducia, convertendo le ambizioni AI in operazioni reali, sicure e scalabili.

Domande Frequenti

Con il passaggio dell'agentic AI dalla sperimentazione all'implementazione reale, diventano inevitabili le domande su affidabilità, qualità dei dati e progettazione dei sistemi. Le seguenti FAQ affrontano alcuni dei dubbi più comuni che emergono.

-

Cos'è l'agentic AI, in termini semplici?

-

L'agentic AI si riferisce a sistemi che percepiscono informazioni, le elaborano e agiscono autonomamente per raggiungere un obiettivo. A differenza dei chatbot, i sistemi agentici non si limitano a rispondere: eseguono compiti attraverso workflow con un intervento umano minimo.

-

Perché i dati non strutturati sono un problema per gli agenti autonomi?

-

La maggior parte dei dati aziendali è presentata in formati pensati per gli esseri umani, non per le macchine. E-mail, PDF e documenti scansionati non seguono una struttura coerente, rendendo difficile per gli agenti interpretarli in modo affidabile. Agire su questi dati senza validazione aumenta il rischio di errori che possono propagarsi nei sistemi.

-

I grandi modelli linguistici possono occuparsi della comprensione dei documenti da soli?

-

Gli LLM possono "leggere" i documenti, ma sono probabilistici e incoerenti nell'estrazione di dati precisi e strutturati su larga scala. Nei workflow agentici, questa variabilità può portare ad azioni sbagliate, costi più elevati e fallimenti operativi.

-

Che ruolo svolge l'Intelligent Document Processing (IDP)?

-

L'IDP funziona come un livello dedicato che trasforma i documenti non strutturati in dati puliti, strutturati e leggibili dalle macchine prima che raggiungano un agente autonomo. Questa separazione migliora l'affidabilità, riduce il rischio e rende i sistemi agentici utilizzabili in contesti reali di business.

Ultimo aggiornamento il