L’agentic AI promet des systèmes qui ne se contentent plus de générer des réponses, mais prennent de vraies décisions et agissent pour l’entreprise. Problème : la plupart des agents autonomes s’appuient sur des données non structurées, comme les emails, fichiers PDF ou documents scannés, sur lesquels ils ne peuvent pas agir de manière fiable. Cet article analyse pourquoi les données structurées représentent la couche manquante de l’agentic AI et comment une couche de parsing dédiée transforme les agents prometteurs en systèmes solides et utilisables en production.

À retenir :

- L’agentic AI fait passer l’IA de la génération de contenu à l’exécution d’actions métier, ce qui augmente de manière significative le coût des erreurs de données.

- Les agents autonomes ont besoin d’entrées structurées, validées et propres pour fonctionner en toute sécurité à grande échelle. Les LLMs seuls montrent leurs limites.

- Parseur fournit la couche essentielle de parsing qui convertit les documents bruts en données fiables et structurées, permettant aux agents d’agir avec certitude plutôt que sur des approximations.

Du “bavardage” à l’action

L’IA a beaucoup progressé ces dernières années. En 2023 et 2024, l’attention portait sur l’IA générative : des systèmes capables de rédiger des emails, résumer des documents et répondre avec aisance. Ces outils ont transformé notre interaction avec les logiciels mais se limitaient le plus souvent à la conversation.

En 2026, le débat a évolué : selon Gartner, 40 % des applications d’entreprise intégreront des agents IA dédiés. La nouvelle vague d’innovation, c’est l’agentic AI : des systèmes conçus non seulement pour dialoguer, mais pour agir. Plutôt que de rédiger un email, un agent IA l’envoie à votre place. Plutôt que de simplement conseiller les prochaines étapes, il exécute lui-même l’ensemble du workflow.

La promesse est considérable. Selon Kong INC, 90 % des entreprises déploient activement des agents IA et 79 % envisagent une adoption généralisée sous trois ans. Imaginez une IA qui gère votre chaîne logistique, traite et règle les factures, ou met à jour votre CRM automatiquement à l’arrivée de nouvelles données. Fini les tableaux de bord à surveiller, les transferts manuels… place aux résultats.

Mais au-delà de l’effet d’annonce, la réalité s’impose. Si le “cerveau” de ces systèmes – des modèles comme GPT-5 ou Claude – se perfectionne, le “carburant” qui les alimente souffre souvent d’un manque de fiabilité. Selon Rubrik, 80 % des données d’entreprise sont toujours non structurées : emails, PDF, documents scannés, pièces jointes. Quand les agents doivent agir sur ces données brutes et disparates, les erreurs se multiplient rapidement.

C’est pour cette raison que beaucoup de projets agentic AI restent bloqués en expérimentation. Le problème n’est pas la planification ni le raisonnement. Tout dépend de la qualité des données d’entrée.

Pour que l’agentic AI passe de démos impressionnantes à une infrastructure digitale fiable, il faut lui ajouter une couche dédiée à la structuration et l’assurance qualité des données : transformer l’information lisible par l’humain en données propres, structurées, avant toute initiative autonome.

Qu’est-ce que l’Agentic AI ?

L’agentic AI désigne des systèmes qui fonctionnent de façon autonome pour atteindre un objectif. Contrairement aux chatbots, qui attendent une question avant de répondre par du texte, les systèmes agentiques perçoivent, raisonnent et agissent sans supervision humaine continue.

Concrètement, un agent ne se contente pas de répondre “Que dois-je faire ?” : il choisit et exécute la tâche.

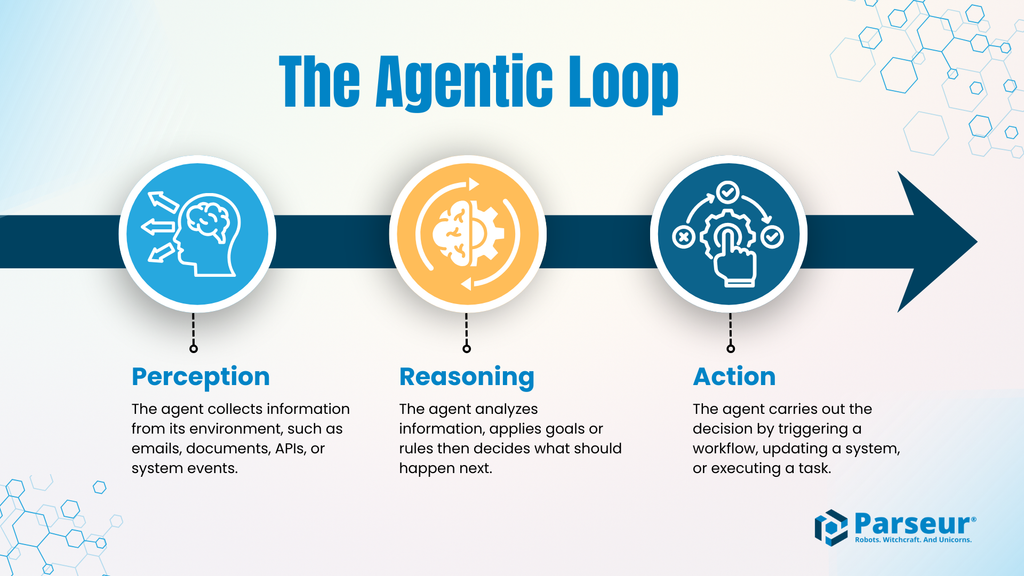

La boucle agentique : Perception → Raisonnement → Action

Un système agentic AI suit généralement ce cycle :

- Perception : L’agent reçoit des informations de son environnement : emails, documents, réponses d’API, événements système, etc.

- Raisonnement : L’agent analyse, applique ses règles ou ses objectifs, puis décide de la prochaine action.

- Action : L’agent réalise une opération : mise à jour système, lancement de workflow, paiement, notification, etc.

Cette boucle se répète en continu, permettant à l’agent d’opérer quasiment sans surveillance. Tant que des informations arrivent, il agit en conséquence.

Pourquoi les enjeux sont-ils plus élevés ?

Quand l’IA passe de la simple génération de contenus à la gestion d’actions, le coût de l’erreur devient critique. Une faute de frappe générée par un chatbot n’a que peu de conséquences. Mais un agent autonome qui lit mal un montant, confond un client, ou agit sur une donnée bancale peut provoquer des dysfonctionnements graves.

Exemples :

- Paiement d’un mauvais montant de facture

- Commande d’une quantité inappropriée de stock

- Mise à jour d’une fiche client erronée

- Workflow déclenché sur de fausses informations

Dans l’agentic AI, l’erreur n’est plus théorique : elle compromet réellement les opérations.

IA générative vs. Agentic AI

| Aspect | IA générative | Agentic AI |

|---|---|---|

| But principal | Générer des contenus (textes, images, résumés, etc.) | Exécuter des tâches et workflows pour un objectif |

| Mode d’interaction | Répond à la demande de l’utilisateur | Fonctionne de manière autonome, peu d’intrants |

| Types de sortie | Réponses, explications, suggestions | Mises à jour de système, transactions, actions |

| Prise de décision | Vise la cohérence dans la réponse | Priorise le choix et l’exécution d’actions |

| Tolérance à l’erreur | Plutôt élevée : erreurs visibles, faciles à corriger | Très faible : erreurs impactantes |

| Exigences de données | Peut composer avec l’ambiguïté | Nécessite des données structurées, validées |

| Profil de risque | Erreurs à faible impact, souvent informatives | Erreurs potentiellement coûteuses opérationnellement |

Le problème du “ground truth”

L’agentic AI a besoin d’un univers de logique, d’APIs et de données structurées : JSON, XML, formats cohérents, champs clairs. Mais dans la réalité, l’information critique provient d’emails, de PDFs, de tableurs, de scans et de pièces jointes.

Ce décalage bloque l’automatisation par agents autonomes.

Avant de raisonner et agir, un agent a besoin d’une “vérité de base” : des faits fiables et exploitables par la machine. Sans base solide, même les agents les plus avancés improvisent.

Pourquoi les LLMs seuls ne suffisent-ils pas ?

On aimerait croire que les LLMs savent lire et comprendre les documents bruts. En réalité, cela engendre des risques majeurs pour les workflows automatisés.

Hallucinations

Les LLMs fonctionnent de façon probabiliste. S’ils rencontrent des données manquantes ou ambiguës, ils inventent. En conversation, ce n’est souvent pas gênant. En workflow agentique, une approximation, aussi mineure soit-elle, devient une action risquée. Les études sur les agents autonomes montrent que le taux d’hallucination grimpe dès que le modèle doit extraire des informations précises de documents désordonnés, surtout sur des sources longues ou complexes.

Coûts et latence

Traiter des PDFs ou des fils d’emails entiers via un LLM consomme énormément de ressources. Chaque document absorbe des tokens, augmente la latence et génère une variabilité de délai. Pour des agents opérant en temps réel ou sur des volumes importants, cela devient rapidement un obstacle technique et financier.

Manque de cohérence

Les workflows automatisés exigent des formats reproductibles. Un agent doit recevoir les bons champs au bon format, à chaque fois, pour pouvoir agir en confiance. Or, même sur des documents similaires, les sorties des LLMs varient : cette incohérence brise les automatisations.

Conséquences concrètes des échecs

Quand des agents traitent des données non fiables, l’échec est immédiat :

Un agent de facturation lit mal le nom du fournisseur dans un PDF : paiement vers un mauvais destinataire. Un agent logistique mal interprète une quantité : rupture de stock imprévue, chaîne de production arrêtée. Un agent gérant les contrats applique la mauvaise tarification à plusieurs clients suite à une mauvaise lecture de clause.

Ces erreurs ne sont pas isolées : elles se répandent, chaque mauvaise extraction entraînant d’autres actions erronées. Résultat : une réaction en chaîne, qui annule tout le bénéfice de l’automatisation.

C’est là tout l’enjeu du “ground truth” : même prêts à agir, les agents pilotent à l’aveugle tant que les données structurées et fiables font défaut.

La couche manquante : Intelligent Document Processing (IDP)

Si l’agentic AI patine dans les cas d’usage réels, ce n’est pas à cause du manque d’intelligence ou de capacité d’action. C’est parce que les agents disposent rarement de données d’entrée fiables. L’Intelligent Document Processing (IDP) fournit la couche essentielle.

L’IDP introduit une couche de parsing entre les documents désordonnés générés par l’humain et les agents IA autonomes. Plutôt que d’exposer directement les LLMs aux documents bruts, cette couche les transforme en données structurées, sûres, avant toute prise de décision.

Cette couche stabilise l’architecture agentique. Grâce à elle, les agents agissent sur des faits, pas sur des hypothèses.

Comment fonctionne le parsing de documents ?

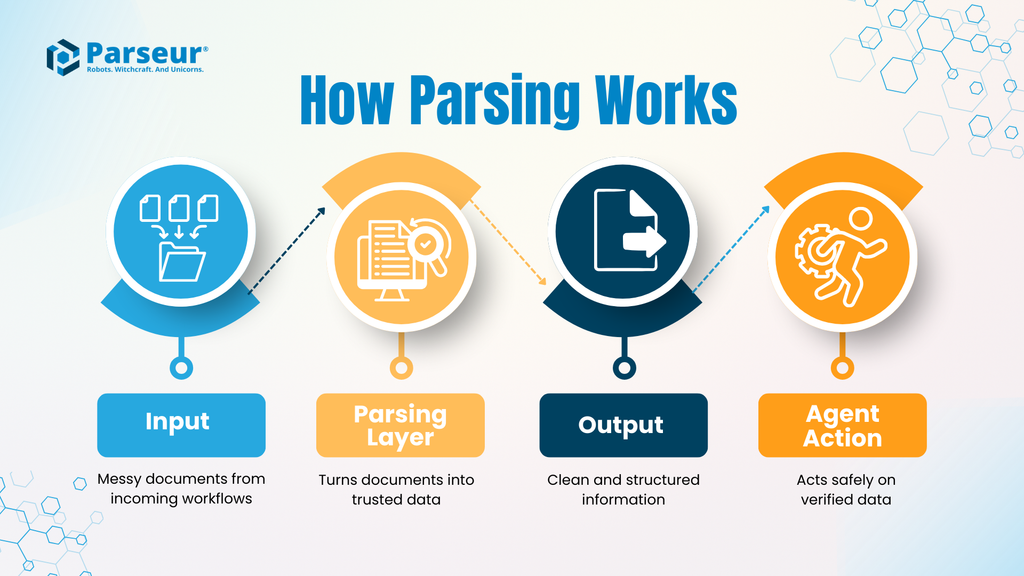

Un workflow IDP typique suit ces étapes :

- Entrée : Un document métier (facture, BL, contrat, email, etc.), avec des formats et structures variables.

- La couche de parsing : Un outil IDP extrait les champs ciblés, standardise les formats (dates, montants...), valide la donnée selon des règles métiers. L’exactitude prime sur l’interprétation.

- Sortie : Une donnée structurée, généralement en JSON, respectant un schéma prédéfini.

- Action de l’agent : L’agent autonome peut alors consommer ces données propres et adopter la bonne décision sans ambiguïté.

En séparant la compréhension documentaire de l’action, le risque diminue. L’agent n’a plus à “lire” le document : il exécute une action sur la base de données structurées, fiables.

En quoi cette couche change-t-elle le niveau de risque ?

Sans couche de parsing, les agents font face à toute l’ambiguïté des documents métiers : chaque doute devient une possible erreur. Grâce à l’IDP, l’incertitude est traitée en amont, avant que l’automatisation ne démarre.

C’est vital à grande échelle :

Selon l’étude 2026 de Parseur, 88 % des entreprises estiment que des erreurs se glissent dans leurs données documentaires. Un agent autonome qui fonctionnerait sur 88 % de données erronées représenterait un vrai danger, pas un atout.

L’IDP ne rend pas les agents plus complexes, mais il rend leur automatisation possible et fiable : réduction des hallucinations, workflows robustes, automatisation à grande échelle sans supervision humaine continue.

Face à ces enjeux, la fiabilité est indispensable. La couche de parsing est ce chaînon manquant qui fait passer l’agentic AI du laboratoire à l’entreprise.

Cas d’usage : quand les agents ont besoin d’une extraction fiable

L’agentic AI prend tout son sens dans les workflows métier, où l’efficacité dépend essentiellement de la qualité, de la structure et du bon acheminement de la donnée jusqu’à l’agent. Voici deux cas courants : une bonne couche de parsing fait la différence entre automatisation réussie et échec.

Cas A : la chaîne logistique autonome

Exemple :

Un e-mail de retard logistique arrive d’un transporteur. Il contient la nouvelle date d’arrivée, un numéro de conteneur, un planning mis à jour, souvent dissimulés dans le texte ou une pièce jointe PDF.

Sans couche de parsing :

L’agent analyse directement l’email : la date n’est pas là où il l’attend, le numéro de conteneur est atypique. Il rate la mise à jour ou lit mal un champ ; l’ERP reste inchangé, le stock se fait attendre, la production ralentit après coup.

Avec Parseur :

L’email et sa pièce jointe passent par une couche de parsing : Parseur détecte le numéro et la nouvelle date, formate la donnée en temps réel et la rend exploitable. L’agent logistique ajuste automatiquement la planification et met à jour l’ERP : l’incident devient une adaptation fluide.

Cas B : la comptabilité fournisseurs “autonome”

Exemple :

L’organisation veut automatiser la réconciliation des factures : chaque facture doit être rapprochée au bon de commande, validée et payée sans contrôle manuel.

Problème :

Les agents peuvent suivre ce workflow… si et seulement si chaque ligne, quantité, prix unitaire, taxe et total sont extraits sans erreur. La moindre imprécision casse l’automatisation ou provoque une erreur de paiement.

Sans parsing fiable :

L’agent rate un total, confond deux produits similaires : l’appariement échoue, l’humain doit reprendre la main, la fiabilité du process s’effrite.

Avec Parseur :

Les factures sont analysées en détail, toutes les lignes capturées uniformément, les totaux validés avant arrivées à l’agent. Celui-ci peut alors rapprocher les factures, valider le paiement et ne solliciter l’humain qu’en cas de vraie anomalie.

Human-in-the-Loop (HITL) : le filet de sécurité indispensable

Le plus grand frein à l’agentic AI n’est pas la technologie, mais la confiance. Les entreprises hésitent à autonomiser finances, opérations, relation client, de peur qu’un agent commette une erreur propagée à l’échelle de l’information.

C’est là que la conception Human-in-the-Loop (HITL) devient essentielle.

Le HITL ne freine pas l’automatisation : il la fiabilise pour la déployer en conditions réelles.

Comment le HITL s’insère-t-il dans une architecture agentique ?

Un système bien pensé n’impose pas de contrôle humain sur chaque action. En général, l’intervention humaine est sollicitée uniquement en cas de doute. Parseur joue le rôle de checkpoint : si un document est conforme : il passe, sinon, il est soumis à validation manuelle.

Lorsque tout est clair, la donnée structurée intègre le workflow automatiquement. Si le document est douteux, incomplet, ou inattendu, Parseur alerte une personne pour vérification ou correction avant transfert à l’automatisation.

Le workflow reste simple :

- Les agents gèrent les tâches répétitives et prédictibles

- Les humains interviennent sur les dossiers complexes ou incertains

C’est ainsi que l’automatisation se généralise sans rogner sur la qualité ou la conformité.

Pourquoi le HITL renforce-t-il la confiance ?

À tort, on croit que l’automatisation a échoué dès qu’il y a intervention humaine. En réalité, le HITL est la clé de fiabilité de l’agentic AI.

Sans filet, le choix est binaire : tout automatique avec interdiction de faillir, ou tout manuel et donc retour en arrière. Avec le HITL, on automatise avec garde-fous : la performance sans sacrifier la sécurité.

En entreprise, cela pose les vraies questions :

- Que se passe-t-il si la donnée est incertaine ou incomplète ?

- Qui décide en cas d’exception ?

- Comment éviter que l’erreur se propage ?

Grâce à une couche de parsing avec HITL, voici des réponses concrètes.

Ce qu’il faut retenir

Le HITL n’est pas un compromis médiocre, c’est le filet de sécurité qui permet le passage à l’échelle en agentic AI. Il filtre les ambiguïtés avant qu’un agent n’agisse, offrant ainsi la confiance et la robustesse attendues.

Construire l’infrastructure agentic AI pour 2026

Nous sommes à l’aube de l’ère des collaborateurs numériques : des agents autonomes qui n’assistent plus, mais exécutent des workflows métiers essentiels à grande échelle. Le potentiel est immense : opérations accélérées, réduction des erreurs, collaborateurs humains recentrés sur la décision.

Cependant, tout cela n’a de valeur qu’à une condition : un agent n’est fiable que si la donnée qu’il traite l'est également. Automatiser avec de la donnée non structurée, c’est multiplier les risques, les erreurs en cascade et perdre la confiance. Avant d’autonomiser l’action, il faut une data pipeline précise, structurée, auditable.

C’est là que Parseur intervient : véritable “salle des machines” de l’agentic AI, il convertit emails, PDF et documents en données prêtes à l’emploi pour vos agents. Avec des entrées structurées, un contrôle HITL intelligent et des sorties prévisibles, l’autonomie opérationnelle devient sûre, évolutive, et au service de votre entreprise.

Foire Aux Questions

À mesure que l’agentic AI passe de l’expérimentation au déploiement réel, les questions autour de la fiabilité, la qualité des données et la conception des systèmes deviennent inévitables. Les FAQ ci-dessous répondent aux points les plus fréquemment sources de confusion.

-

Qu’est-ce que l’agentic AI, en termes simples ?

-

L’agentic AI désigne des systèmes capables de percevoir des informations, de raisonner dessus et d’agir de manière autonome pour atteindre un objectif. Contrairement aux chatbots, les systèmes agentiques ne font pas que répondre : ils exécutent des tâches à travers des workflows avec une intervention humaine minimale.

-

Pourquoi les données non structurées posent-elles problème aux agents autonomes ?

-

La plupart des données professionnelles arrivent dans des formats pensés pour les humains, pas pour les machines. Les emails, PDF et documents scannés manquent d’une structure cohérente, ce qui rend leur interprétation difficile pour les agents. Agir sur ces données sans validation augmente le risque d’erreurs qui peuvent se propager dans les systèmes.

-

Les grands modèles de langage peuvent-ils gérer seuls la compréhension documentaire ?

-

Les LLMs peuvent lire des documents, mais ils sont probabilistes et incohérents lorsqu’il s’agit d’extraire des données précises et structurées à grande échelle. Dans des workflows agentiques, cette variabilité peut mener à de mauvaises décisions, des coûts accrus et des échecs opérationnels.

-

Quel est le rôle du Intelligent Document Processing (IDP) ?

-

L’IDP joue le rôle d’une couche dédiée qui transforme les documents non structurés en données propres, structurées et lisibles par machine avant qu’elles n’atteignent un agent autonome. Cette séparation améliore la fiabilité, réduit les risques et rend les systèmes agentiques viables en environnement professionnel réel.

Dernière mise à jour le