Agentische KI verspricht nicht nur Systeme, die Antworten formulieren, sondern auch eigenständig geschäftliche Entscheidungen treffen und Maßnahmen initiieren. Das grundlegende Problem: Die meisten autonomen Agenten reagieren auf unstrukturierte Daten wie E-Mails, PDFs oder gescannte Dokumente, die sie nicht zuverlässig auswerten können. In diesem Beitrag zeigen wir, warum strukturierte Daten die entscheidende Schicht in der agentischen KI sind, und wie eine spezialisierte Parsing-Ebene vielversprechende Agenten in belastbare Unternehmenssysteme verwandelt.

Wichtigste Erkenntnisse:

- Agentische KI verschiebt den Fokus von Content-Generierung hin zur Ausführung realer Geschäftsprozesse – und macht Fehler in den Daten deutlich teurer.

- Autonome Agenten benötigen präzise, strukturierte und validierte Daten, um skalierbar und verlässlich zu funktionieren. LLMs sind alleine dafür nicht ausreichend.

- Parseur stellt die unverzichtbare Parsing-Schicht bereit, die reale Dokumente in korrekte, strukturierte Daten umwandelt und Agenten ermöglicht, sicher und fundiert zu agieren statt zu raten.

Vom „Plaudern“ zum „Handeln“: Der Paradigmenwechsel

KI hat sich in den vergangenen Jahren rasant weiterentwickelt. 2023 und 2024 standen generative KI-Lösungen im Mittelpunkt – etwa Systeme, die E-Mails formulieren, Dokumente zusammenfassen oder Fragen in beeindruckend natürlicher Sprache beantworten. Diese Tools haben zwar die Mensch-Maschine-Interaktion revolutioniert, aber oft beim Austausch von Informationen geendet.

Der Sprung kommt spätestens 2026: Gartner prognostiziert, dass 40 % aller Unternehmensanwendungen Aufgaben-spezifische KI-Agenten enthalten werden. Die nächste große Innovationswelle heißt agentische KI – Systeme, die nicht nur reagieren, sondern eigenständig Entscheidungen treffen und Prozesse durchführen. Ein Agent schreibt nicht nur einen E-Mail-Entwurf, sondern verschickt die E-Mail direkt, schlägt nicht nur Maßnahmen vor, sondern steuert ganze Workflows.

Dieses Versprechen ist stark: Laut Kong INC setzen bereits 90 % der Unternehmen KI-Agenten aktiv ein, und 79 % planen dies innerhalb von drei Jahren unternehmensweit zu tun. Denken Sie an eine KI, die Teile der Lieferkette steuert, Rechnungen verarbeitet und bezahlt oder das CRM automatisch aktualisiert, sobald neue Daten eintreffen – ganz ohne Dashboards oder manuelle Übergaben.

Doch hier folgt die harte Realität: Das „Gehirn“ dieser Systeme – große Sprachmodelle wie GPT-5 oder Claude – wird immer leistungsfähiger, aber der „Treibstoff“ ist oft unzuverlässig. Laut Rubrik sind rund 80 % der Unternehmensdaten unstrukturiert – E-Mails, PDFs, gescannte Dokumente, unterschiedlich formatierte Anhänge. Agenten, die auf solch chaotischen Daten arbeiten, verursachen Fehler, die sich schnell multiplizieren.

Deshalb scheitern viele KI-Projekte oder verharren im Pilotstatus. Das Problem ist seltener die Agentenlogik – meist ist es das fehlende Vertrauen in die Daten.

Damit agentische KI von der bestechenden Demo zum unternehmensweiten Rückgrat werden kann, benötigen Systeme eine spezialisierte Schicht zur Datenzuverlässigkeit, die menschenlesbare Dokumente in klar strukturierte, maschinenverständliche Fakten verwandelt – noch bevor eine autonome Aktion erfolgt.

Was ist agentische KI überhaupt?

Agentische KI beschreibt Systeme, die selbstständig Aufgaben durchführen und Ziele erreichen. Im Gegensatz zu klassischen Chatbots, die auf Anfragen reagieren, nehmen agentische Systeme eigenständig Informationen auf, ziehen Schlussfolgerungen und initiieren Handlungen, ohne kontinuierliche menschliche Führung.

Praktisch heißt das: Ein Agent beantwortet nicht nur die Frage „Was soll ich als nächstes tun?“, sondern entscheidet eigenständig und setzt die Aufgabe direkt um.

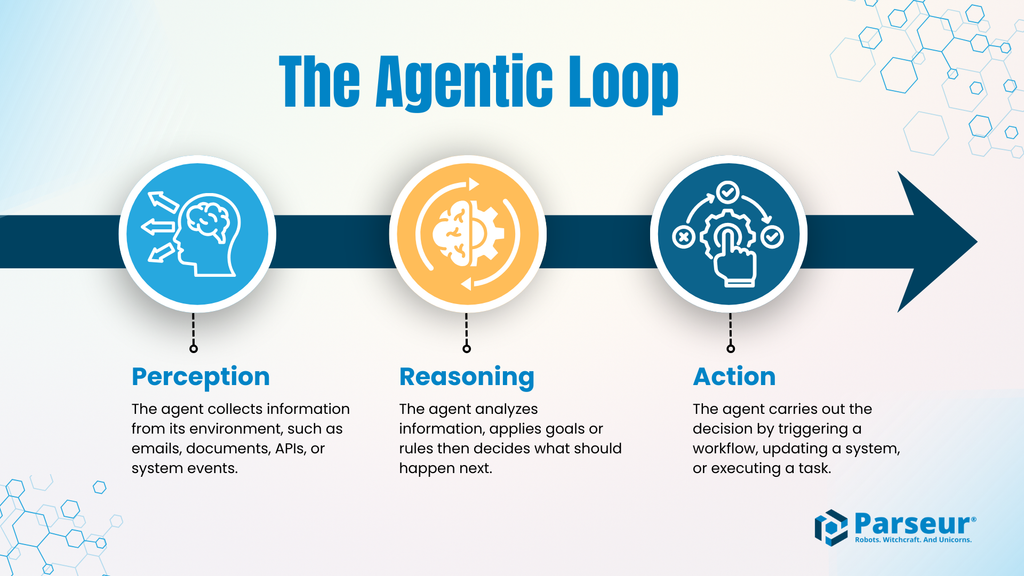

Agentic Loop: Wahrnehmung → Schlussfolgerung → Handlung

Agentische KI folgt oft einem klaren Zyklus:

- Wahrnehmung: Der Agent nimmt Informationen aus verschiedenen Quellen auf – E-Mails, Dokumente, APIs oder Systemereignisse.

- Schlussfolgerung: Er analysiert diese Daten, prüft Regeln oder Zielvorgaben und entscheidet über den nächsten Schritt.

- Handlung: Der Agent führt gezielt Aktionen aus, etwa das Aktualisieren von Datensätzen, das Starten von Prozessen, das Auslösen von Zahlungen oder das Anstoßen weiterer Systeme.

Dieser Zyklus wiederholt sich kontinuierlich und ermöglicht Agenten das Agieren bei minimaler Überwachung. Mit jedem neuen Input beginnt der Kreislauf erneut.

Warum sind Fehler hier gravierender?

Sobald KI-Systeme nicht nur Inhalte generieren, sondern Handlungen ausführen, steigen die Fehlerkosten dramatisch. Während ein Tippfehler im Chatbot meist harmlos bleibt, können fehlerhafte Aktionen eines autonomen Agenten – etwa falsche Rechnungsbeträge, Bestellungen an die falsche Adresse oder unpassende Kontenänderungen – schwerwiegende betriebliche Folgen haben.

Konkrete Beispiele:

- Zahlung eines falschen Rechnungsbetrags

- Falsche Mengenbestellungen, die Nachschubketten stören

- Aktualisierung falscher Kundendatensätze

- Automatisierte Workflows, ausgelöst durch fehlerhafte Informationen

Hier können sich Fehler nicht nur summieren, sondern ganze Prozesse beeinträchtigen oder blockieren.

Generative KI vs. agentische KI

| Aspekt | Generative KI | Agentische KI |

|---|---|---|

| Hauptzweck | Generiert Inhalte wie Texte, Bilder oder Zusammenfassungen | Führt zielgerichtete Aufgaben und Workflows aus |

| Interaktionsmodell | Reagiert auf Nutzereingaben | Agiert eigenständig mit minimalem Eingriff |

| Typische Ergebnisse | Entwürfe, Vorschläge, Erklärungen | Systemänderungen, Transaktionen, proaktive Aktionen |

| Entscheidungsfindung | Fokus auf sprachliche Kohärenz | Fokus auf Aktionsauswahl und Umsetzung |

| Fehlertoleranz | Hohes Maß, Fehler leicht korrigierbar | Gering, Fehler können Betrieb und Finanzen gefährden |

| Datenanforderungen | Arbeitet mit auch unvollständigen Daten | Benötigt strukturierte, geprüfte Eingaben |

| Risikoprofil | Fehler meist informativ/kosmetisch | Fehler mit betrieblichem/finanziellem Risiko |

Das “Ground Truth”-Problem

Agentische Systeme verlassen sich auf Logik, APIs und strukturierte Datenformate wie JSON oder XML – mit klar definierten Feldern und konsistenten Formaten. Die Realität in Unternehmen: Entscheidende Informationen lagern oftmals in E-Mails, PDFs, Exceltabellen, Scans oder als unstrukturierte Anhänge.

Dieser Widerspruch schafft das größte Hindernis für den zuverlässigen Einsatz agentischer KI: Bevor ein Agent Entscheidungen trifft oder handelt, braucht er eine „Ground Truth“ – gesicherte, maschinenlesbare und präzise Daten. Sonst bleibt jeder Agent gezwungen, auf Basis ungeprüfter Informationen zu improvisieren.

Warum LLMs alleine nicht ausreichen

Es erscheint naheliegend, große Sprachmodelle einfach unstrukturierte Dokumente verarbeiten zu lassen. Doch dieser Ansatz führt mit wachsendem Automatisierungsgrad zu großen Risiken.

Halluzinationen

LLMs arbeiten probabilistisch. Wo Informationen fehlen, unscharf oder schlecht formatiert sind, raten sie – selbst in kritischen Anwendungen. Im Dialog harmlos, entstehen im agentischen Workflow jedoch durch Vermutungen schnell schädliche Handlungen. Untersuchungen zeigen, dass die Fehlerquote steigt, wenn Modelle strukturierte Daten aus komplexen, realen Dokumenten extrahieren sollen.

Kosten und Latenz

Die Verarbeitung ganzer PDFs, langer E-Mail-Verläufe oder Bildscans durch LLMs ist teuer und ineffizient. Jeder Input verbraucht viele Tokens, erhöht die Latenz und beeinträchtigt die Planbarkeit. Gerade automatisierte Agenten, die schnell und skalierbar reagieren müssen, stoßen damit an praktische Grenzen.

Inkonsistenz

Autonome Workflows benötigen absolut konsistente Strukturen, Feldnamen und Datentypen, damit Folgeprozesse fehlerfrei laufen. Ergebnisse aus LLMs können aber – selbst bei ähnlichen Dokumenten – unterschiedlich strukturiert sein. Das reicht aus, um automatische Prozesse zum Stillstand zu bringen.

Fehlerbilder aus der Praxis

Wenn Agenten auf ungenau extrahierte Dokumentendaten angewiesen sind, führen Fehler direkt zu sichtbaren Betriebsstörungen.

Beispiele: Ein Rechnungs-Agent liest einen fehlerhaften Lieferantennamen und überweist versehentlich an das falsche Konto. Ein Bestell-Agent extrahiert die falsche Menge, bestellt zu spät nach – mit Lieferengpässen als Folge. Ein Vertrags-Agent interpretiert Verlängerungsklauseln falsch, wodurch für mehrere Kunden die Bedingungen falsch angewendet werden.

Solche Fehler bleiben nicht lokal: In einem agentischen System kann eine fehlerhafte Extraktion eine Kettenreaktion verursachen, die sich durch alle verbundenen Systeme zieht. Das Resultat sind aufwändige Nacharbeiten, Prozessunterbrechungen und Vertrauensverlust in die Automatisierung.

Das ist das Kernproblem der Ground Truth: Agenten agieren nur dann effektiv, wenn sie auf verlässliche, strukturierte Daten zugreifen können. Fehlen diese, agieren sie „im Nebel“.

Die fehlende Schicht: Intelligent Document Processing (IDP)

Das Scheitern agentischer KI in der Praxis liegt selten an Logik oder Planung, sondern daran, dass Agenten keinen festen Zugang zu verlässlichen Unternehmensdaten haben. Hier wird Intelligent Document Processing (IDP) zur unverzichtbaren Zwischenschicht.

IDP bringt eine dedizierte Parsing-Schicht zwischen heterogene, menschlich verfasste Dokumente und KI-Agenten. Anstatt Agenten oder Sprachmodelle direkt mit Rohdaten zu überfordern, werden Dokumente zuvor in konsistente, strukturierte Daten übersetzt – erst danach erfolgt die weitere Automatisierung.

In agentischen Architekturen fungiert diese Schicht als Stabilitätsanker und stellt sicher, dass Agenten mit konkreten Fakten, nicht mit Annahmen agieren.

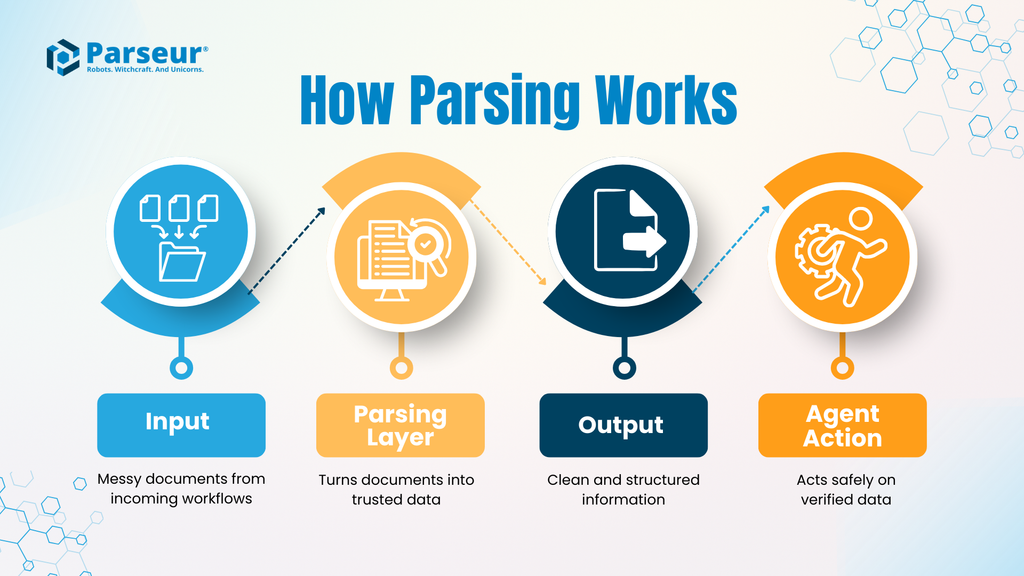

Wie funktioniert Dokumenten-Parsing?

Ein typischer IDP-Workflow umfasst folgende Schritte:

- Input: Echte Geschäftsdokumente wie Rechnungen, Frachtbriefe, Verträge oder E-Mails – mit variablen Layouts und Formaten.

- Parsing-Schicht: Ein spezialisiertes Tool extrahiert gezielte Felder, vereinheitlicht Daten (z. B. Datumsformate, Beträge, IDs) und prüft sie auf Regelkonformität. Im Fokus steht nicht Interpretation, sondern messbare Genauigkeit.

- Output: Saubere, strukturierte Daten, typischerweise als JSON – exakt passend zu vordefinierten Schemas.

- Agentenaktion: Der Agent erhält ausschließlich geprüfte, strukturierte Daten und führt auf dieser Basis seine Aufgabe aus.

Durch diese klare Arbeitsteilung sinkt das Fehler- und Haftungsrisiko, und der Agent kann sich ganz auf seine Entscheidungslogik konzentrieren.

Warum reduziert diese Schicht das Risiko?

Fehlt die Parsing-Schicht, sind Agenten der chaotischen Realität in E-Mails und Anhängen schutzlos ausgeliefert. Mit IDP werden Inkonsistenzen und Datenmängel bereits vor der Automatisierung aussortiert.

Besonders bei Skalierung ist das entscheidend:

Eine Parseur-Umfrage 2026 zeigt, 88 % der Unternehmen erleben Fehler bei der Dokumentendaten-Extraktion. Ein Agentensystem, das mit solch unsicheren Daten agiert, wird zum Risiko.

IDP macht Agenten nicht „klüger“, sondern gibt ihnen ein verlässliches Fundament. Das senkt Fehlerquoten, erhöht die Transparenz und verschafft Unternehmen die notwendige Sicherheit, um Verantwortung an KI abzugeben.

In agentischen Systemen ist Intelligenz wichtig – aber erst zuverlässige Datenintegration schafft praxisreife Autonomie.

Praxisbeispiele: Wo Agenten Parseur benötigen

Agentische KI entfaltet erst im realen Geschäftsprozess ihren Wert. Entscheidend ist, ob ein Agent rechtzeitig auf präzise, strukturierte Daten zugreifen kann – weniger seine Fähigkeit zur Interpretation. Zwei typische Szenarien zeigen, warum die Parsing-Schicht über Erfolg und Misserfolg einer Automatisierung entscheidet.

Use Case A: Die autonome Lieferkette

Szenario:

Eine E-Mail des Logistikers meldet eine Versandverzögerung. Darin enthalten: neues Ankunftsdatum, Container-ID und aktualisierter Hafenplan – oft als Freitext oder PDF-Anhang.

Ohne Parsing-Schicht:

Der Agent sucht direkt im Mailtext nach dem neuen Datum – doch das Format unterscheidet sich, die Container-ID ist schwer auffindbar. Möglicherweise wird das Update nicht erkannt oder falsch interpretiert. Das ERP bleibt unaktualisiert, die Planung läuft in die Irre, Produktion wird ausgebremst oder gestoppt. Der Fehler fällt erst auf, wenn der Schaden verursacht ist.

Mit Parseur:

E-Mail und Anhänge werden durch die Parsing-Schicht geschickt. Parseur extrahiert die Schlüsselwerte wie Container-ID, Ankunftsdatum und Standort sicher und überführt sie in eine strukturierte Form. Der Agent nutzt diese geprüften Daten, aktualisiert das ERP und passt die Disposition an – reibungslos und in Echtzeit.

Use Case B: Die vollautomatisierte Buchhaltung

Szenario:

Das Unternehmen will die Verarbeitung von Eingangsrechnungen voll automatisieren. Rechnungen müssen automatisch geprüft, Bestellungen abgeglichen, validiert und ohne manuelle Prüfung freigegeben werden.

Die Herausforderung:

Autonome Buchhaltungsagenten sind nur dann sinnvoll einsetzbar, wenn alle Rechnungsdetails – Positionen, Stückzahlen, Preise, Steuern, Summen – sicher und strukturiert ausgelesen werden.

Bei ungenauer Extraktion:

Der Agent liest fehlerhafte Beträge, verwechselt Produktnamen oder ordnet Zeilen falsch zu. Die Rechnungsprüfung scheitert, Beträge werden falsch überwiesen oder falsch markiert. Die Zahl der manuellen Rückfragen steigt, das Vertrauen in die Automatisierung sinkt.

Mit Parseur:

Rechnungen werden hochpräzise verarbeitet. Zeilen werden sauber erkannt, Beträge und Summen validiert. Der Agent erhält ausschließlich geprüfte, einheitlich strukturierte Daten, gleicht diese konsistent ab, gibt Zahlungen frei und ruft menschliche Hilfe nur bei echten Abweichungen.

Warum Human-in-the-Loop (HITL) das Sicherheitsnetz bleibt

Ein Haupthemmnis für agentische KI ist weniger die Technologie als das nötige Vertrauen in die Systeme. Unternehmen sind zurecht skeptisch, wenn autonome Prozesse über Finanzen, Betrieb oder Kundenbeziehungen entscheiden. Die Sorge vor Fehlerketten auf Basis unzuverlässiger Daten ist berechtigt – gerade in vernetzten Systemen.

Deswegen ist das Human-in-the-Loop-(HITL)-Prinzip so entscheidend.

HITL verzögert Automatisierung nicht – es schafft erst die nötige Sicherheit.

So integriert sich HITL in agentische Architekturen

In einer robusten Lösung überwachen Menschen nicht jede einzelne Aktion, sondern greifen nur bei Unsicherheiten ein. Parseur übernimmt die Kontrolle vor dem Agenten: Ist ein Dokument eindeutig und entspricht der Regelkonfiguration, gelangen die strukturierten Daten direkt an den Workflow. Bei Unstimmigkeiten, fehlenden Feldern oder unerwartetem Layout wird das Dokument automatisch zur menschlichen Prüfung vorgelegt. Erst nach Freigabe werden die Daten weitergeleitet.

Das Ergebnis:

- Agenten automatisieren planbare, sichere Aufgaben

- Menschen bringen Kontextwissen ein, wenn Maschinenerkenntnisse nicht reichen

So entsteht ein System, das Skalierung und Verlässlichkeit vereint.

Wie HITL vertrauensbildend wirkt

Manchmal heißt es, menschliche Kontrolle sei ein Zeichen für gescheiterte Automatisierung. In Wirklichkeit macht erst HITL agentische KI reif für hochkritische Anwendungen. Ohne diesen Rückkanal droht Entweder-oder-Denken: vollständige Automatisierung mit volatilem Risiko oder aufwendige manuelle Prozesse, die Produktivität verhindern. HITL schafft den Ausgleich und bietet Klarheit bei Fragen wie:

- Was geschieht bei Datenunsicherheiten?

- Wer genehmigt Ausnahmen?

- Wie werden Fehlerketten zuverlässig gestoppt?

Erst eine Parsing-Schicht in Kombination mit HITL macht agentische Architekturen sicher und unternehmensreif.

Fazit

Human-in-the-Loop ist kein Hindernis, sondern das Sprungtuch, das Automatisierung auch bei komplexer agentischer KI sicher und skalierbar macht. Unsicherheiten werden frühzeitig abgefangen und autonome Workflows können mit echtem Vertrauen laufen.

Die Infrastruktur für 2026 aufbauen

Wir stehen am Anfang des Zeitalters der digitalen Kollegen: Autonome Agenten, die nicht nur reagieren oder Vorschläge machen, sondern zentrale Geschäftsprozesse eigenständig, flexibel und reproduzierbar steuern. Das Potenzial: Schnellere Abläufe, weniger Fehler, mehr Freiräume für wertschöpfende Aufgaben jenseits von Routine.

All das gilt nur, wenn Agenten auf solide Daten bauen können. Wer KI mit unstrukturierten, unsauberen Informationen füttert, riskiert Produktionsfehler, Prozessstörungen und Vertrauensverlust. Vor jeder Automatisierung müssen daher Datenpipelines stringent strukturiert und prüfbar aufgesetzt werden.

Hier setzt Parseur an – als Rückgrat der agentischen KI. Parseur verwandelt E-Mails, PDFs und Dokumente in strukturierte, maschinenlesbare Informationen. Mit geprüften Eingaben, Human-in-the-Loop-Sicherung und skalierbarer Datenqualität können Agenten zuverlässig agieren – und visionäre KI-Workflows werden zur tragfähigen Unternehmensrealität.

Häufig gestellte Fragen

Während sich agentische KI von der Experimentierphase zu realen Anwendungsfällen weiterentwickelt, werden Fragen zur Zuverlässigkeit, Datenqualität und Systemarchitektur unvermeidlich. Die folgenden FAQs beantworten einige der häufigsten Missverständnisse.

-

Was ist agentische KI einfach erklärt?

-

Agentische KI beschreibt Systeme, die Informationen wahrnehmen, darüber schlussfolgern und eigenständig Maßnahmen ergreifen, um ein Ziel zu erreichen. Im Gegensatz zu Chatbots reagieren agentische Systeme nicht nur, sondern führen Aufgaben in Workflows mit minimaler menschlicher Beteiligung aus.

-

Warum sind unstrukturierte Daten ein Problem für autonome Agenten?

-

Die meisten Geschäftsdaten liegen in Formaten vor, die für Menschen und nicht für Maschinen gemacht sind. E-Mails, PDFs und gescannte Dokumente haben keine konsistente Struktur und sind daher für Agenten schwer zuverlässig interpretierbar. Ein Handeln auf Basis solcher Daten ohne Validierung erhöht das Fehlerrisiko, das sich über Systeme hinweg potenziert.

-

Können große Sprachmodelle das Verstehen von Dokumenten alleine übernehmen?

-

Sprachmodelle (LLMs) können Dokumente lesen, sind aber probabilistisch und inkonsistent, wenn es um die präzise Extraktion strukturierter Daten in großem Umfang geht. In agentischen Workflows kann diese Variabilität zu falschen Aktionen, höheren Kosten und betrieblichen Ausfällen führen.

-

Welche Rolle spielt Intelligent Document Processing (IDP)?

-

IDP ist eine spezialisierte Schicht, die unstrukturierte Dokumente in saubere, strukturierte, maschinenlesbare Daten verwandelt, bevor sie einen autonomen Agenten erreichen. Diese Trennung verbessert die Zuverlässigkeit, verringert Risiken und macht agentische Systeme im echten Unternehmensumfeld einsatzfähig.

Zuletzt aktualisiert am