Agentowe AI to obietnica systemów, które nie tylko udzielają odpowiedzi, ale realnie wykonują czynności w imieniu firmy. Problem polega na tym, że większość autonomicznych agentów napotyka dane niestrukturalne, takie jak e-maile, PDF-y czy skany dokumentów, które utrudniają niezawodne działanie na produkcji. W tym artykule dowiesz się, dlaczego brakującym elementem agentowego AI jest warstwa danych strukturalnych oraz jak dedykowana warstwa przetwarzania (parsowania) czyni agentów rozwiązaniami godnymi zaufania.

Najważniejsze wnioski:

- Agentowe AI zmienia rolę AI z samych odpowiedzi na wykonywanie faktycznych operacji biznesowych — co sprawia, że prawidłowość danych staje się krytyczna (koszt błędu wzrasta drastycznie).

- Autonomiczne agenty potrzebują czystych, uporządkowanych i zweryfikowanych danych, aby móc bezpiecznie działać na szeroką skalę. Sam LLM nie wystarczy.

- Parseur to kluczowa warstwa zapewniająca, że dokumenty ze świata rzeczywistego są transformowane w niezawodne dane strukturalne, co umożliwia agentom działanie w oparciu o pewność, a nie domysły.

Zmiana z “rozmowy” na “działanie”

Ostatnie lata to dynamiczny rozwój AI. W latach 2023–2024 główny nacisk padł na AI generatywną: narzędzia, które pisały e-maile, podsumowywały dokumenty i odpowiadały na pytania. To diametralnie odmieniło sposób pracy z oprogramowaniem, ale ograniczało się głównie do konwersacji.

Do 2026 roku sytuacja uległa zmianie — Gartner prognozuje, że 40% aplikacji biznesowych będzie wyposażonych w specjalistycznych agentów AI. Nowa fala to agentowe AI: systemy, które nie tylko komunikują się, ale rzeczywiście wykonują operacje. AI już nie tylko napisze e-mail — wyśle go za ciebie. Nie doradzi kolejnych kroków, tylko je wykona.

To ogromna szansa. Według Kong INC, 90% firm wdraża już agentów AI, a 79% zakłada pełne wdrożenie w ciągu 3 lat. Wyobraź sobie AI kontrolujące cały fragment łańcucha dostaw, zautomatyzowane rozliczanie faktur czy aktualizacje CRM w miarę pojawiania się nowych danych — bez paneli i ręcznych przekazań, liczą się tylko efekty.

Pod powierzchnią tych możliwości kryje się jednak istotny problem. O ile „mózgiem” tych systemów są coraz potężniejsze modele językowe (jak GPT-5 czy Claude), to ich „paliwo” pozostaje niepewne. Rubrik szacuje, że aż 80% firmowych danych to materiały niestrukturalne: e-maile, PDF-y, skany i niejednolite załączniki. Gdy agent podejmuje działania na podstawie nieuporządkowanych danych — błędy mogą rosnąć lawinowo.

Dlatego dziś wiele wdrożeń agentowego AI utknęło w fazie eksperymentów. Problemem nie jest rozumowanie agentów ani ich planowanie. To kwestia zaufania do jakości danych wejściowych.

Aby agentowe AI mogło wyjść poza fazę pilotów i stać się niezawodną infrastrukturą biznesową, potrzebuje warstwy zapewniającej pewność danych — elementu, który zamienia surowe, „ludzkie” informacje w czyste dane strukturalne, zanim agenci podejmą działania.

Czym jest agentowe AI?

Agentowe AI to systemy autonomiczne, które realizują zadania w celu osiągnięcia określonych celów. Różnica względem klasycznych chatbotów polega na tym, że nie czekają na polecenia, lecz same interpretują informacje napływające z otoczenia i podejmują działania.

W praktyce agent nie prosi o wskazówkę — tylko sam rozstrzyga, co i jak należy zrobić, a następnie to wykonuje.

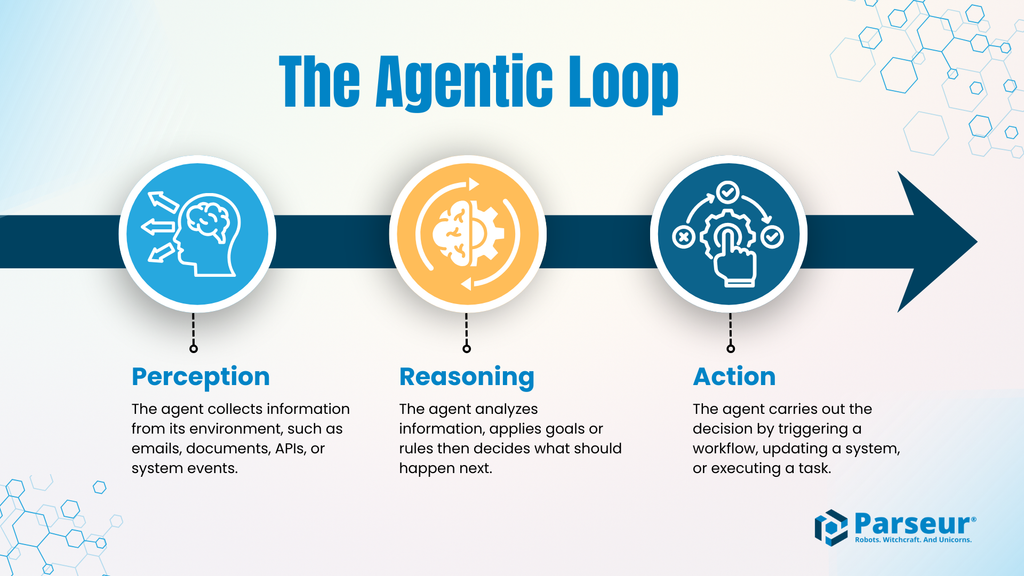

Pętla agenta: Percepcja → Rozumowanie → Działanie

Większość systemów agentowego AI pracuje według prostej pętli:

- Percepcja: Odbieranie informacji z otoczenia: e-maile, dokumenty, wyjścia API, zdarzenia systemowe.

- Rozumowanie: Analiza tych danych, nałożenie reguł lub celów, wybór dalszych kroków.

- Działanie: Realizacja operacji: aktualizacja rekordu, inicjacja procesu, płatność, wysłanie komunikatu do innego systemu.

Ten cykl agent powtarza tak długo, jak tylko ma dostęp do nowych danych, wykazując się pełną autonomią.

Wyższe ryzyko — dlaczego?

Gdy AI zaczyna faktycznie działać, każdy błąd staje się kosztowny. Chatbot, który popełni literówkę, nie zaszkodzi firmie. Agent podejmujący błędną decyzję — np. myląc numer klienta czy kwotę — może powodować realne operacyjne straty, opóźnienia i chaos.

Przykłady to m.in.:

- Realizacja płatności na błędną kwotę

- Zamówienie złej liczby produktów

- Nadpisanie nie tego rekordu klienta

- Uruchomienie błędnego procesowania zamówienia

W środowisku agentowym jeden błąd może unieruchomić cały proces.

AI generatywna vs. Agentowe AI

| Aspekt | AI generatywna | Agentowe AI |

|---|---|---|

| Główny cel | Generowanie treści: teksty, obrazy, podsumowania | Wykonywanie operacji biznesowych, realizacja celów |

| Model interakcji | Reakcja na zapytania użytkownika | Działanie autonomiczne; minimalny nadzór człowieka |

| Typowe wyniki | Szkice, porady, wyjaśnienia | Transakcje, zmiany w systemie, automatyczne akcje |

| Decyzyjność | Skoncentrowana na odpowiedziach | Skoncentrowana na wyborze i realizacji działań |

| Tolerancja na błąd | Stosunkowo wysoka; błędy widoczne łatwe do poprawy | Bardzo niska; wręcz nieakceptowalna |

| Wymagania danych | Może działać na niepełnych/niestrukturalnych danych | Wymaga danych uporządkowanych, spójnych i zweryfikowanych |

| Ryzyko operacyjne | Zwykle ogranicza się do wad treści | Może wywołać realne szkody i przerwy w działaniu firmy |

Problem „prawdy podstawowej” — dlaczego dane są barierą?

Agentowe AI żyje w świecie logiki biznesowej, API i schematów danych — oczekuje wejść typu JSON lub XML, z jasno zdefiniowanymi polami i przewidywalną strukturą. Tymczasem w rzeczywistości najważniejsze dane, np. dotyczące klientów czy zamówień, dostarczane są jako e-maile, PDF-y, arkusze czy skany. To właśnie tutaj pojawia się największa bariera.

Zanim agent podejmie jakiekolwiek działanie, potrzebuje rzetelnego, maszynowo czytelnego „ground truth” — źródła prawdy. Jeśli nie może mu zaufać, nawet najlepszy agent jest zdany na zgadywanie.

Dlaczego same LLM-y nie wystarczają?

Łatwo założyć, że duży model językowy (LLM) może po prostu "przeczytać" dokument i zrozumieć go. Praktyka pokazuje, że takie podejście wiąże się z szeregiem ryzyk, które przy wdrożeniu na produkcję kończą się katastrofą.

Halucynacje

LLM-y są probabilistyczne. Gdy napotkają brakujące, niejednoznaczne lub źle sformatowane dane, nie zatrzymują się – zgadują. W konwersacji nie jest to groźne, ale w sytuacji gdy agent podejmuje rzeczywiste działania, zgadywanie przeradza się w błąd operacyjny. W szczególności przy próbie wydobycia danych z chaotycznych dokumentów, częstotliwość halucynacji istotnie rośnie.

Koszty i opóźnienia

Analiza przez LLM-y całych PDF-ów, wątków mailowych lub skanów generuje duże i niestabilne koszty, a czas reakcji potrafi być nieprzewidywalny. Dla agentów działających na żywo to poważne ograniczenie.

Niespójność zwracanych danych

Agentowe przepływy wymagają konsekwencji — te same nazwy pól, typy, formaty bez wyjątków. LLM-y często generują różne formaty nawet dla bardzo podobnych dokumentów — wystarczy minimalna różnica, by automatyzacja zawiodła.

Praktyczne skutki awarii

Agenty działające na nieprzetworzonych danych popełniają szybkie i kosztowne błędy: źle zidentyfikowana nazwa dostawcy na fakturze powoduje płatność na nieprawidłowe konto; błędne pole ilości powoduje niedostarczoną dostawę; zła interpretacja kontraktu skutkuje nieprawidłową odnową/płatnością.

W środowisku agentowym błędy nie zatrzymują się na jednym kroku – rozprzestrzeniają się na kolejne etapy, generując lawinę poprawek ręcznych i utratę zaufania do całej automatyzacji.

To właśnie kwintesencja problemu: bez strukturalnych, pewnych danych, agentowe AI podejmuje działania „po omacku”.

Brakująca warstwa: Intelligent Document Processing (IDP)

Agentowe AI nie zawodzi dlatego, że agenty nie potrafią rozumować albo działać, tylko dlatego, że brakuje warstwy niezawodnego czytania dokumentów biznesowych. Tutaj właśnie znaczenie zyskuje Intelligent Document Processing (IDP).

IDP wprowadza dedykowaną warstwę parsowania, która separuje chaotyczne, tekstowe dokumenty i zamienia je na uporządkowane dane dla agentów AI. Zamiast wymuszać coraz to większą złożoność modeli, dokładna transformacja dokumentów do strukturalnej postaci odbywa się przed podejmowaniem jakichkolwiek działań.

W tej roli IDP działa jak stabilizator — agent wie, że operuje na pewnych danych, a nie na domysłach.

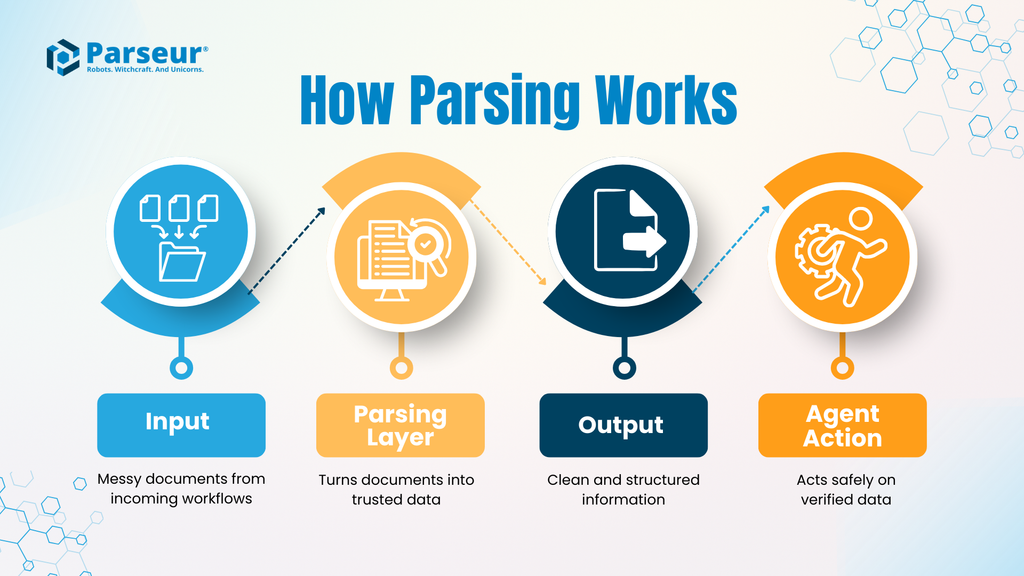

Jak działa warstwa parsowania dokumentów?

Typowa architektura IDP obejmuje:

- Wejście: Surowy dokument (faktura, list przewozowy, kontrakt, e-mail), często w wielu różnych wariantach.

- Warstwa parsowania: Narzędzie IDP takie jak Parseur wyodrębnia kluczowe pola, standaryzuje formaty (daty, liczby, identyfikatory) i weryfikuje dane z ustalonymi regułami. Skupia się nie na interpretacji sensu, ale na rzetelności i konsekwencji.

- Wyjście: Czyste dane w strukturze (zwykle JSON), gotowe do przetworzenia przez systemy agentowe.

- Działania agenta: Agent operuje wyłącznie na tych zweryfikowanych danych, mając gwarancję, że polega na kompletnej, sprawdzonej informacji.

Oddzielenie etapu „czytania” dokumentów od etapu decyzyjnego radykalnie zmniejsza ryzyko i upraszcza kontrolę jakości. Agent już nie „czyta PDF-ów” — działa na pewnych danych.

Dlaczego to obniża ryzyko operacyjne?

Bez warstwy parsowania agenty są narażone na niejednoznaczność i chaos dokumentów „po ludzku”. Każda różnica formatowania to potencjalne źródło awarii. IDP przejmuje całą niepewność, a agent końcowy dostaje wyłącznie to, na czym może polegać.

Efekt skali jest nie do przecenienia — według badania Parseur z 2026 roku 88% firm zgłasza błędy w danych dokumentowych. Agent z 88% błędnych danych to poważne ryzyko — nie wsparcie.

IDP nie sprawia, że agenty „myślą”. Sprawia, że są przewidywalne i bezpieczne. Ogranicza halucynacje, stabilizuje jakość danych i umożliwia skalowanie automatyzacji bez ryzyka lawinowych błędów.

W środowisku agentowym to nie inteligencja, ale niezawodność czyni autonomię realną. Warstwa parsowania to brakujące ogniwo zamieniające eksperymenty w zaufane systemy.

Przykłady zastosowania: kiedy agenty faktycznie potrzebują Parseur

Prawdziwa wartość agentowego AI ujawnia się dopiero w rzeczywistych procesach biznesowych — a tam liczy się nie „inteligencja”, lecz dostępność i pewność danych. Zobaczmy to na dwóch scenariuszach, gdzie warstwa parsowania umożliwia automatyzację:

Przypadek A: Autonomiczny łańcuch dostaw

Scenariusz:

E-mail o opóźnieniu dostawy od przewoźnika zawiera nową datę, identyfikator kontenera i zmieniony harmonogram portowy — wszystko w luźnym tekście lub PDF-ie.

Bez parsowania:

Agent analizuje maila „na żywo”, format jest inny niż wcześniej, numer kontenera w nieoczekiwanym miejscu. Skutkuje to błędnie wyłapaną datą i nieaktualizacją ERP, produkcja czeka na nieistniejącą dostawę — proces się blokuje, koszty narastają.

Z Parseur:

Mail i załączniki trafiają do warstwy IDP. Parseur identyfikuje pola, standaryzuje, sprawdza i przekazuje agentowi kompletną aktualizację — ERP oraz plan produkcji automatycznie zostają zsynchronizowane. Możliwe przestoje zamienione zostają w sprawną reakcję systemu.

Przypadek B: “Samobieżna” automatyzacja księgowości

Scenariusz:

Firmowa automatyzacja rozliczania faktur — dopasowywanie do zleceń, walidacja i zatwierdzanie całkowicie bez udziału człowieka.

Wyzwanie:

Agenty księgowe mogą zautomatyzować proces tylko, jeśli każde pole (wartości, ilości, SUMA) jest wydobyte bezbłędnie. Drobna pomyłka w polu lub opisie eliminuje automatyczne dopasowanie i generuje ryzyko np. błędnej płatności.

Bez precyzyjnego wydobycia:

Błąd w wyciągnięciu sumy lub produktu powoduje odrzucenie faktury przez system lub, co gorsza, realizację płatności o nieprawidłowej wartości. Ręczna kontrola staje się koniecznością.

Z Parseur:

Faktury są analizowane z precyzją na poziomie szczegółów. Każde pole to pewny rekord, formaty ujednolicone i sumy przeliczone – agent bezpiecznie wykonuje proces, a interwencja człowieka potrzebna jest tylko w prawdziwych wyjątkach.

Dlaczego Human-in-the-Loop (HITL) to niezbędna warstwa bezpieczeństwa

Jedną z kluczowych barier dla agentowego AI jest brak zaufania: firmy boją się, że autonomiczny system podejmie złą decyzję w ważnej sprawie. Obawy są uzasadnione — błędnie przetworzone dane mogą lawinowo wywołać kaskadę kosztownych następstw.

W tej sytuacji nieoceniony staje się model „human-in-the-loop” (HITL).

HITL nie zatrzymuje automatyzacji — pozwala jej rozwijać się bezpiecznie.

Jak wygląda HITL w architekturze agentowej?

W praktyce ludzie nie muszą ręcznie przeglądać każdej operacji. Reagują wyłącznie, gdy pojawia się niepewność. Tu Parseur jest bramką — jeżeli dokument daje się zinterpretować jednoznacznie, dane trafiają automatycznie do agenta. Gdy są niejasności (brak pól, nietypowy układ), Parseur kieruje sprawę do weryfikacji człowieka, który potwierdza lub koryguje dane.

Ta kontrola funkcjonuje jak filtr:

- Agenty wykonują rutynowe zadania, gdy ryzyko jest niskie

- Człowiek interweniuje tylko w nietypowych lub krytycznych sytuacjach

Efekt? Automatyzacja o wysokiej skali, bez kompromisów w kwestii kontroli i odpowiedzialności.

Dlaczego HITL buduje zaufanie do agentowego AI

Wbrew błędnym przekonaniom, konieczność weryfikacji przez człowieka nie znaczy automatyzacyjnej porażki. Wręcz przeciwnie — to dopiero dzięki HITL agentowe AI staje się wdrażalne na szeroką skalę, nawet tam, gdzie ryzyko jest wysokie.

Bez tej warstwy firmy wybierają między pełną automatyzacją i nieakceptowalnym ryzykiem, a 100% ręczną kontrolą i brakiem zysków. HITL daje złoty środek: automatyzację z wbudowaną siatką bezpieczeństwa.

To kluczowe dla spełnienia wymogów compliance, audytorów i zarządów, którzy pytają:

- Co jeśli dane są niejasne?

- Kto i jak zatwierdza wyjątki?

- Jak blokuje się eskalację drobnych błędów?

Mechanizm HITL, obsługiwany przez warstwę parsującą, dostarcza tych odpowiedzi.

Podsumowanie

Human-in-the-loop to nie „awaryjny hamulec” automatyzacji — to jej gwarancja bezpieczeństwa i skalowalności. Pozwala wyłapywać niepewności zanim staną się błędami, zamieniając agentowe AI z technologicznej ciekawostki w zaufaną infrastrukturę biznesową.

Jak zbudować skuteczne agentowe AI na rok 2026?

Wkraczamy w erę cyfrowych współpracowników — autonomicznych agentów realizujących kluczowe procesy na dużą skalę, odciążając ludzi od monotonnych zadań i radykalnie przyspieszając firmowe operacje.

Jest jednak kluczowy warunek: agenty są tak niezawodne, jak dane, na których działają. Jeśli pozwolisz AI działać na niestrukturalnych, niezweryfikowanych wejściach, ryzykujesz łańcuchowe błędy, przestoje i utratę zaufania. Pełna automatyzacja procesów wymaga pipeline’u danych, który jest rzetelny, spójny i poddaje się audytowi.

Tu kluczową rolę pełni Parseur. Działa jako „maszynownia” agentowego AI — zamienia e-maile, PDF-y i dokumenty na precyzyjne, maszynowo czytelne dane. Dzięki warstwie wejściowej, wsparciu human-in-the-loop i strukturze odporniejszej na błędy, agentowe AI zyskuje pewność działania, a automatyzacja staje się naprawdę skalowalna, bezpieczna i efektywna.

Najczęściej Zadawane Pytania

W miarę jak agentowe AI przechodzi z fazy eksperymentów do wdrożeń w rzeczywistych środowiskach, pytania dotyczące niezawodności, jakości danych i projektowania systemów stają się nieuniknione. Poniższe odpowiedzi rozwiewają najczęstsze wątpliwości.

-

Czym jest agentowe AI, w prostych słowach?

-

Agentowe AI to systemy, które odbierają informacje, rozumują je i podejmują autonomiczne działania w celu osiągnięcia celu. W przeciwieństwie do chatbotów, systemy agentowe nie tylko odpowiadają; realizują zadania w całych przepływach pracy przy minimalnej ingerencji człowieka.

-

Dlaczego dane niestrukturalne są problemem dla autonomicznych agentów?

-

Większość danych biznesowych trafia w formatach przeznaczonych dla ludzi, nie dla maszyn. E-maile, pliki PDF i zeskanowane dokumenty nie mają spójnej struktury, więc agenty nie potrafią ich niezawodnie interpretować. Podejmowanie działań na takich danych bez walidacji zwiększa ryzyko błędów, które mogą się rozprzestrzeniać po innych systemach.

-

Czy duże modele językowe mogą samodzielnie rozumieć dokumenty?

-

Modele LLM potrafią czytać dokumenty, lecz są probabilistyczne i niespójne, jeśli chodzi o wydobywanie precyzyjnych, strukturalnych danych na dużą skalę. W agentowych przepływach pracy taka zmienność prowadzi do błędnych działań, wyższych kosztów i awarii operacji.

-

Jaką rolę pełni Intelligent Document Processing (IDP)?

-

IDP pełni rolę dedykowanej warstwy, która przekształca niestrukturalne dokumenty w czyste, strukturalne, maszynowo odczytywalne dane zanim trafią one do agenta autonomicznego. To rozdzielenie zwiększa niezawodność, zmniejsza ryzyko i umożliwia wdrażanie agentowych systemów w realnym biznesie.

Ostatnia aktualizacja