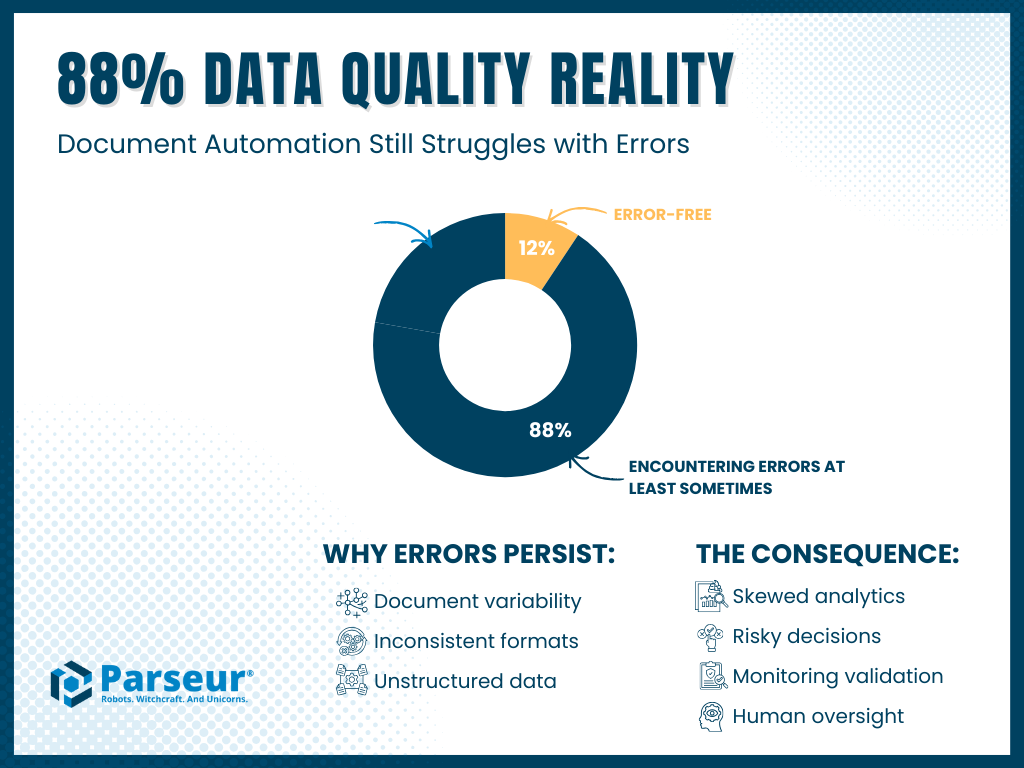

Parseur依頼による調査によると、書類処理業務に関わる米国の500名のビジネスリーダーのうち、88%が自社の分析やAIシステムに供給するデータの正確性に大きな自信を示す一方、同じく88%が書類由来のデータで少なくとも時おりエラーを発見していることが明らかになりました。この「自信の錯覚」は、日常的なデータ品質のリスクが広範に存在し、分析やAIによる成果を継続的に損なう「データ信頼性ギャップ」があることを示しています。

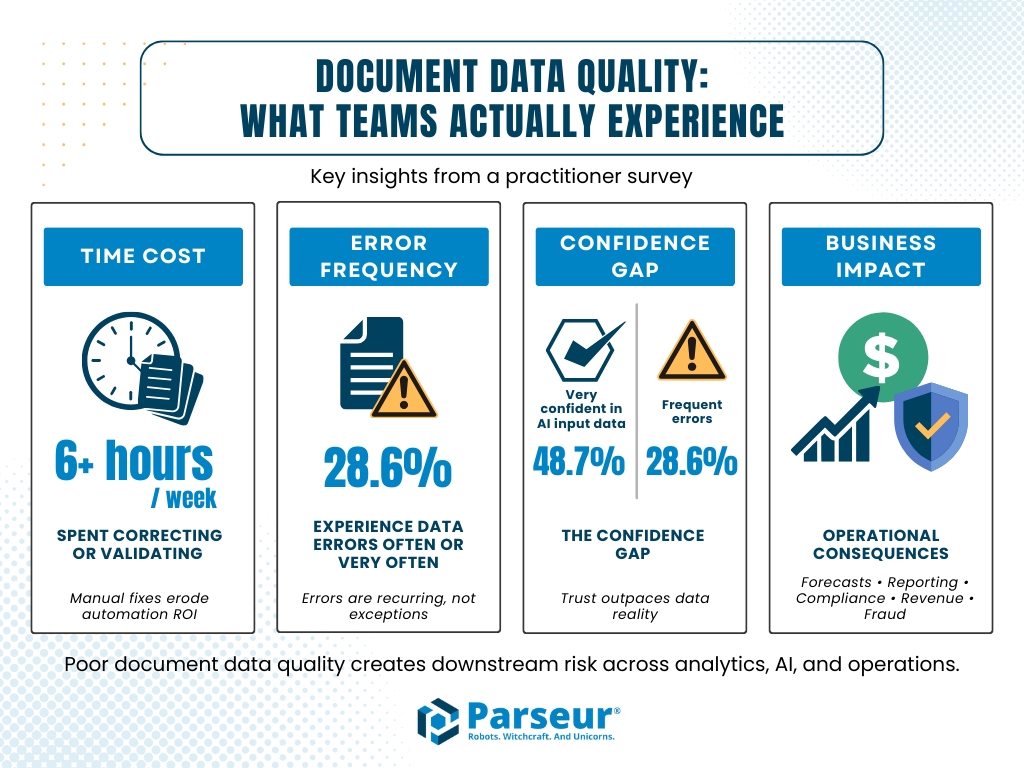

主な調査結果:

- 自信と現実: 88%が自社データに自信を持つと回答する一方、同じく88%が書類データにエラーを少なくとも時々発見

- エラー頻度: **約69%**が、時々・しばしば・または非常に頻繁にエラーを経験

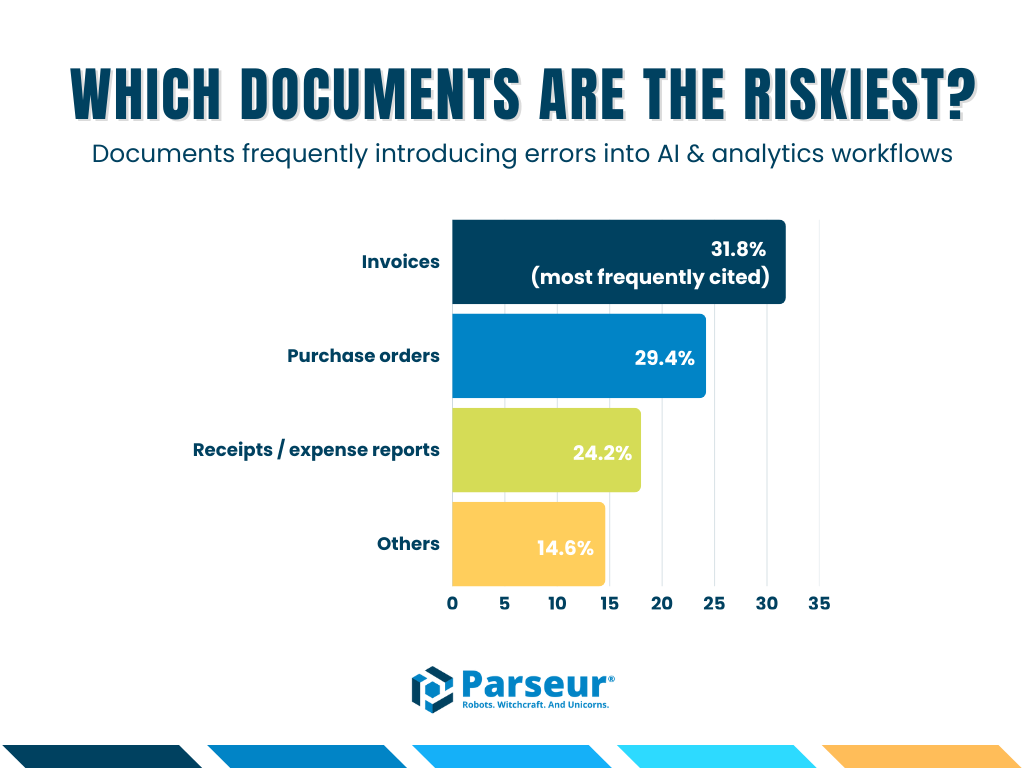

- 主なエラー発生源: 請求書(31.8%)、発注書(29.4%)、領収書や経費報告書(24.2%)

- 調査対象: 米国のオペレーション、財務、IT、カスタマーサポートの現場(マネージャー、ディレクター、C-スイートを中心)

数字の背後にあるもの:AIデータパラドックス

2026年現在、AI導入が急速に進む中で議論の焦点は「AIを導入すべきか」から「AI出力の信頼度」へと変わっています。多くの企業がLLM(大規模言語モデル)のトレーニングやRAG(Retrieval-Augmented Generation)、各種分析パイプラインのデータソースとして、日常的に書類データを利用しています。

とはいえ、この急拡大の裏には、大きなジレンマが隠れています。

本調査では、米国の書類処理を担当するプロフェッショナル500名に対しデータ信頼性を調査。その結果、大半の組織が自社データに自信を見せる一方で、定期的にエラーが発生している現実が明らかになりました。

これこそが書類データ信頼性ギャップ―データへの自信と実際の品質との間に広がる溝です。

何が明らかになったのか?88%のプロフェッショナルが、AIや自動化ワークフローに投入した書類データでエラーを経験すると報告しています。

本記事では、2026年調査の主要知見から、書類データ信頼性ギャップの実態、ビジネスに生じる損失、先進的な企業がAI基盤の精度と信頼性をどのように確保しているかを詳しく解説します。

なぜ重要なのか:ビジネスインパクトと規模

不正確なデータは単なる手間ではなく、財務・運用・戦略面で重大な損失を引き起こします。たった一つの小さな書類データのミスでも、システム全体に波及し、不正確なレポートや誤った経営判断に直結します。

金銭的損失だけでなく、書類データエラーは業務の摩擦も生み出します。サプライチェーンの遅延、コンプライアンスリスク、顧客不満足や無駄な手戻り作業も、すべて不完全なデータ入力が原因です。

2026年Parseur調査は、こうした課題の重大さを裏付けています。業界を問わず多くのプロフェッショナルが、**請求書(31.8%)、発注書(29.4%)、領収書や経費報告書(24.2%)**にエラーリスクが集中していると回答。これらのエラーは例外ではなく、各種分析やAIモデル、ビジネスワークフローに波及し、コストを増大させています。

主要な定量分析(調査より)

- 週6時間以上: 多くのチームがデータ修正・検証に週6時間以上を費やし、自動化のROIを損なう

- 28.6%が頻繁または非常に頻繁なデータエラーを経験

- **48.7%**がエラー多発にもかかわらず「非常に自信あり」と回答―危険な信頼性ギャップを浮き彫りに

- エラーが招いた問題として、不正確な予測、財務報告のミス、顧客や取引先とのトラブル、コンプライアンス違反、収益損失、詐欺リスク増加などが報告

未検証の書類は組織のリスク温床になりえます。影響や規模を理解し、「ソースでの精度重視」、検証ワークフローの導入、Human-in-the-loopプロセスの活用によって、AI出力と重要なビジネス成果の両立が可能です。

Parseurが調査を実施した理由

Parseurは、財務・オペレーション・IT・顧客サポート分野で書類業務の自動化を支援してきました。AIの進化でデータ抽出精度は向上しても、分析やレポートでのエラー発覚は依然として不安材料です。

本調査は、こうした課題を定量化し、エラー発生源の可視化と企業の対策状況を把握するために行いました。AI時代でも見過ごされがちなリスク=悪い書類データに焦点を当て、具体的なアクションを促すインサイトをビジネスリーダーへ届けます。

88%という現実:エラーは“例外”ではなく“日常”

実態把握のため、回答者にこう尋ねました。

「書類からデータを抽出・検証・レビューする際、エラーを経験していますか?」

結果は鮮明です。

- 88%が少なくとも時々エラーを発見

- 12%のみが完全にエラーフリーなパイプラインを報告

OCRやAIパーサーなどの自動化が進んでも、多様な書類仕様や不規則な入力の影響で精度低下リスクが依然として高い現状です。レイアウト・書式や手書き要素、用語の不統一、記述欄のばらつきが、AIモデルや業務意思決定の精度に大きな影響を与えています。

自動化技術だけでは限界があり、十分な監視や検証、人によるレビューが行われなければ、AI活用はむしろエラー拡大のリスクを孕みます。調査結果は、企業自らエラーを予測し、未然防止に努める必要性を示しています。

最もリスクの高い書類は?

書類種別ごとにエラーリスクが異なり、2026年調査にて「AI/分析ワークフローでエラーを招きやすい文書」について質問しました。

主な結果は以下のとおりです:

- 請求書:31.8%(最多)

- 発注書:29.4%

- 領収書・経費報告書:24.2%

これらの書類が特にリスクが高い理由:

- 取扱量が膨大:大手企業は年間数千~数百万単位の請求書や発注書を処理。低エラー率でも大きな損失に直結

- 構造が複雑:構造化要素と自由記述が混在し、抽出ミスが生じやすい

- 経営判断への影響大:財務、売上認識、サプライチェーン、顧客対応などに直結。小さなミスでも過払い、納期遅延、コンプライアンス不備、評判毀損といった甚大な結果に

何より、これらの書類でのエラー多発はAIワークフロー上で特に重大で、該当段階での正確性確保がなければ、下流の分析やAI意思決定でミスが増幅し運用コストも増加します。

報告された運用インパクト(定性的)

書類データエラーがもたらすのは予測ミス、財務報告エラー、取引先トラブル、監査・コンプライアンス違反、運用遅延、収益損失、詐欺リスク増加。大多数が中度~重度のインパクトを指摘。

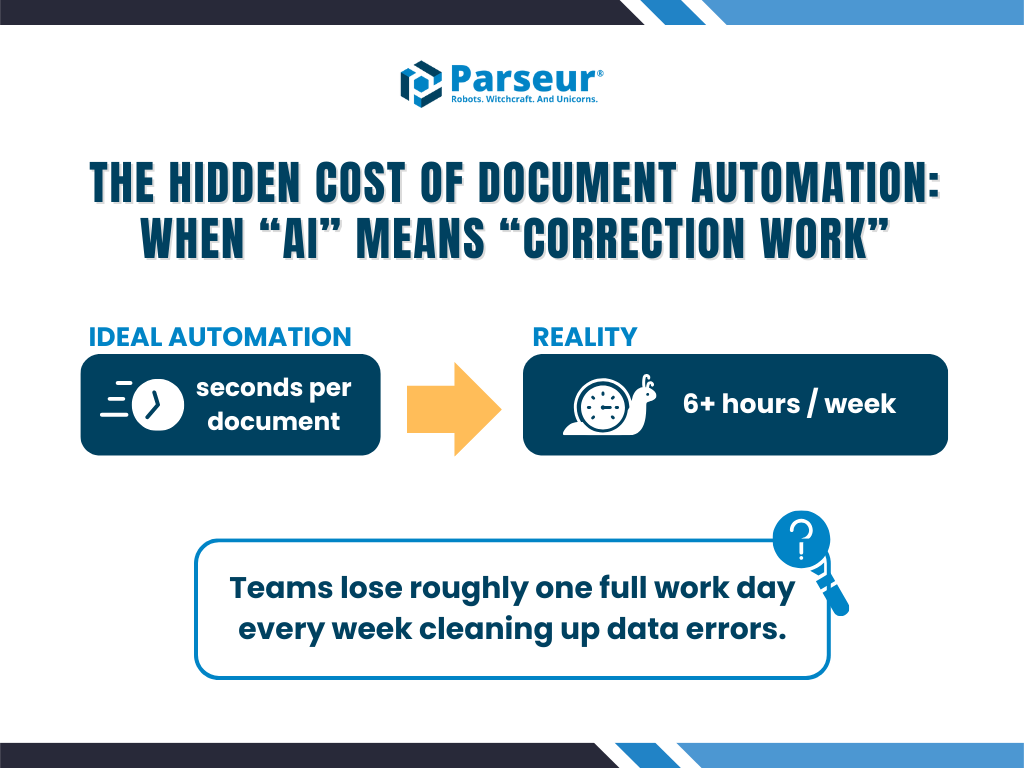

隠れたコスト:“修正業務”に浪費される膨大な時間

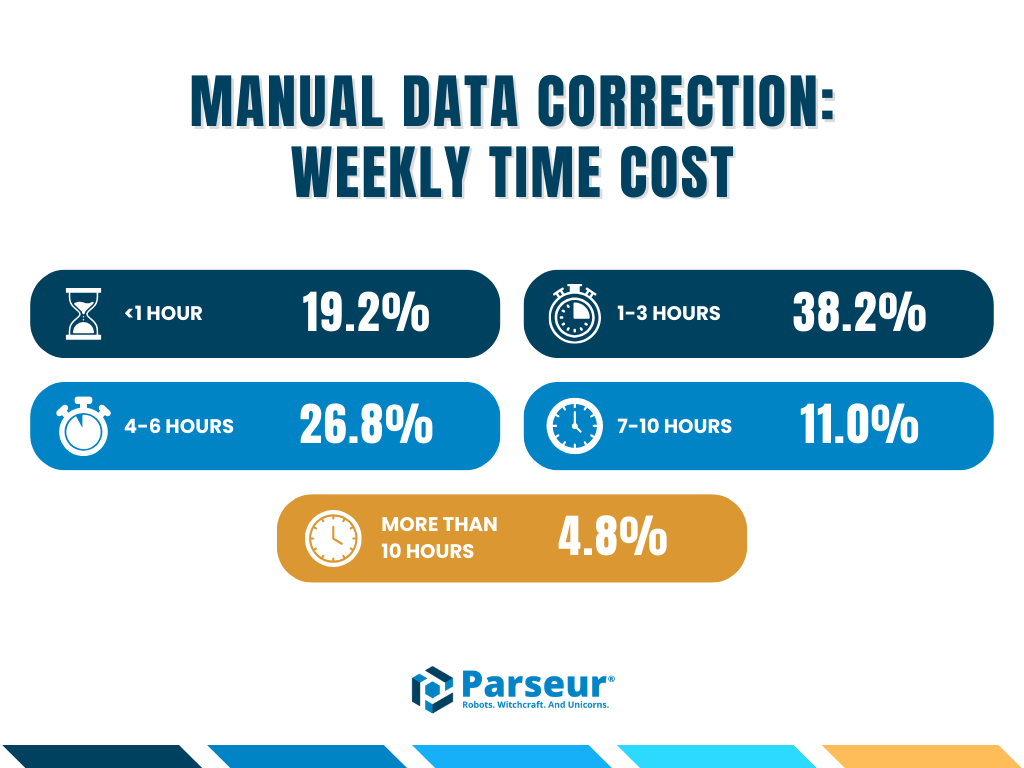

特に目立つのが、こうしたエラーによる人的コスト。各チームに「週何時間データ修正・レビューに費やしていますか?」と質問しました。

実際、多くのチームが週6時間以上も本来不要な修正作業に費やしており、自動化によって単純作業は減ったものの、その分「修正」へと役割が移行し、業務効率が低下しています。

- 調査結果: 多くのチームが週6時間以上データ修正を強いられている

- 業務インパクト: この「修正コスト」が自動化ROIを毀損し、高度な人材が本来戦略的価値を発揮できない状況に

隠れたコスト:自動化が「修正作業」に置き換わる現実

自動化で効率化が期待される一方、実際には修正・レビュー作業が増えています。

- 38.1%が週1〜3時間

- 26.8%が週4〜6時間

- かなりの割合が週6時間超を修正作業に費やすと回答

これは「修正コスト」ともいえ、リーダーやIT・財務部門が高い品質維持のためチェック業務に時間とリソースを割いている実態を表します。

結果、本来の意思決定や戦略立案の機会を削り、自動化のROIが損なわれるケースが多発しています。

問題発生源:リスクの高い書類の特徴

全ての書類が同じリスクを持つわけではありません。エラー多発書類には以下の共通点があります:

- 取扱量が非常に多い

- 構造化情報と自由記述欄が複雑に混在

- 直接的な金銭、運用、コンプライアンスへの影響

これらの書類は、過払い・紛争・収益漏れ・規制違反・遅延など多様なリスクを生みます。

なぜ信頼性ギャップが生じるのか

「書類由来データの正確性にどれほど自信がありますか?」との問いに、エラー頻発にも関わらず**48.7%**が「非常に自信がある」と回答。これがデータ信頼性ギャップの典型例です。

背景要因は複数あります。

1. 統計的精度とビジネス的精度の違い

どんなに99%の精度があっても、クリティカル業務では残り1%のエラーが深刻な損害を生む場合があります。AI精度は単なる指標でなく、ビジネスインパクトで評価する必要があります。

2. 汎用AI・抽出ツールへの過信

LLM抽出ツールは複雑・非標準書類に弱く、幻覚や誤抽出が多発。検証ルールなしでは運用で重大エラーを見逃すことに。

3. “ブラックボックス化”の問題

どこでなぜエラーが出たのかが不明になることで、結果そのものへの信頼性が失われます。

4. 要職ほど精度懸念が強い

IT・データ担当者や経営層ほど、書類精度リスクを強く認識。現場よりも経営視点での影響を重視しています。

明らかになった戦略的インパクト

こうしたエラーは想定外ではなく、財務やコンプライアンス、運用遅延など実際的なリスクの引き金となります。

- 金銭的損失:過払い、売上チャンス損失

- コンプライアンスリスク:業界規制違反による罰則・指摘

- 運用遅延:サプライチェーン停止や業務中断

この理解をもとに、ワークフロー設計・検証ルール・ヒューマン・イン・ザ・ループプロセスの導入こそが、信頼性ギャップの解消と「本当に使えるAIアウトプット」につながります。

ビジネス影響:単なる不便ではない実害

書類データエラーは以下のような具体的な問題を引き起こしています:

- 金銭的損失(過払い含む)

- 誤った予測や報告

- コンプライアンス・監査違反

- 顧客・パートナーとのトラブル

- 運用遅延や収益損失

- 詐欺リスク拡大

これらは理論上の懸念ではなく、AI活用が進む現場で現実の課題として表面化しています。

ギャップ縮小に効果的な「ヒューマン・イン・ザ・ループ」

調査は、AI単独では十分な信頼性を確保できないことを明確に示しています。

信頼性ギャップを埋める企業は、**Human-in-the-Loop(HITL)**ワークフローを採用し、AIの高速処理と人間による検証やコントロールを組み合わせています。

- 高精度抽出: Parseurのような専用AIによるリファレンスデータベース準拠の抽出で、汎用LLMのリスクを低減

- 厳格な検証ルール: 例:「合計=明細合計」など業務ルールに基づいた自動チェックの徹底

- スムーズなレビュー: 信頼性が低い場合は自動的に人間が確認・修正を行えるワークフローを構築

これにより人間の関与はボトルネックではなく、AI精度の「ガードレール」となり、組織全体のデータ信頼性向上と実用的AI活用が可能になります。

調査手法

Parseur 2026 書類データ調査は2025年末、QuestionProを活用し実施。米国の書類関連業務従事プロフェッショナル500名(マネージャー~C-スイート層)が対象。

IT、金融、小売、ヘルスケア、物流各業界の参加者が、書類データの正確性、自信度、AI導入状況、エラーによる運用影響に回答しました。

今後へ:AIに悪いデータを供給しないために

AIの信頼性は、供給するデータの信頼性で決まります。普及が加速する今こそ、書類データ品質管理を徹底しなければ、エラー拡大のリスクが増大します。

正しいアプローチはAIの利用停止ではなく、パイプライン自体に信頼性を組み込むこと。そのためにParseurは、インテリジェントな書類処理、検証、透明性、人的精度を組み合わせ、AIが「仮定」ではなく「確信」に基づいて動作できる環境を提供します。

今こそデータの信頼を取り戻しませんか?

AIへ不正確なデータを供給する時代を終わらせ、本当に信頼できる自動書類処理を導入しましょう。

2026年調査からの追加インサイト

- エラー経験は一般的: 39.4%が書類由来データに時々誤りを発見(500人中197人)、さらに**28.6%*が頻繁または非常に頻繁*にエラーを経験。データの不正確性が日常的な課題になっている。

- IT・金融が主な調査対象: **43.4%**がIT、**23.2%**が金融部門所属。いずれも意思決定・コンプライアンス・AI活用でデータ信頼性が特に重要な領域。

- AI導入はすでに広範: **37.9%**が多くのワークフローでAIを本格導入済み、**31.4%**が一部で利用。高採用率下、書類データエラーの下流への影響が大きくなっている。

最終更新日