Key Takeaways

- データ抽出は設計がしっかりしていない場合、検証や後処理なしでは乱雑な出力となることが多い。

- 信頼できるパイプラインを構築するには、スキーマ検証、正規化、テキストクリーンアップ、テーブル修正、重複排除、継続的な品質チェックが必要。

- JSON Schema、Pydantic、Pandas、Great Expectationsのようなツールが後処理を強力かつ自動化してくれる。

- Parseur APIはデータの迅速なキャプチャと構造化を支援し、チームが品質や分析に集中できる環境を提供。

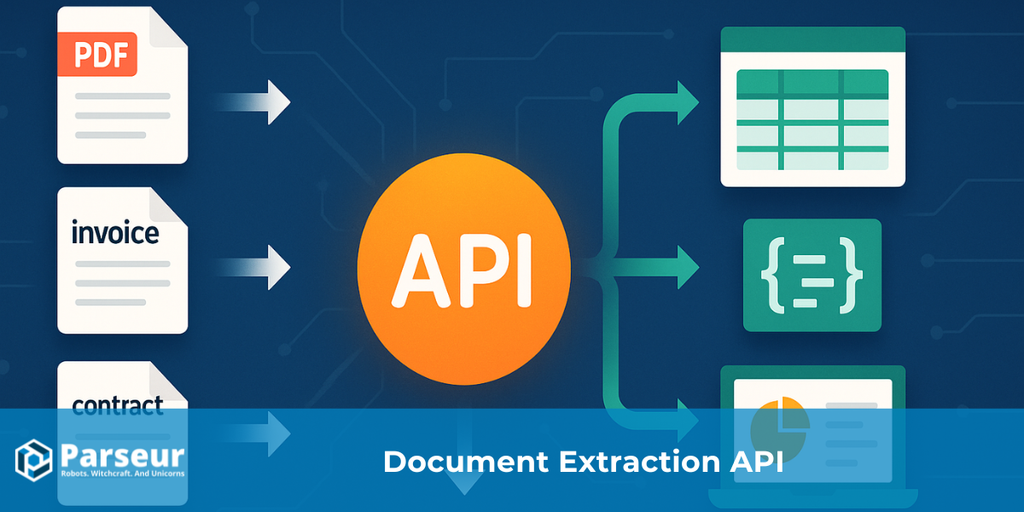

データクレンジング技術とは、APIが返した生データを修正・標準化・検証するプロセスを指します。抽出ツールはPDFや画像、メールなどの非構造化ファイルをJSONやCSVのような構造化フォーマットに変換しますが、結果にはしばしば不一致、NULL値、不正な型、重複、書式エラーなどが含まれます。クレンジングによってデータセットが期待するスキーマに準拠し、レポートや分析、後続のワークフローに信頼して使える状態となります。

DataXcel の最近のケーススタディでは、抽出された電話記録のうち14.45%が無効または非アクティブであることが判明し、強力なデータクレンジング実践がこうしたエラーを防ぎ、抽出データの品質確保に不可欠であることが示されています。

PDF、画像、メールからデータを抽出するAPIは通常、JSONやCSVなどの構造化フォーマットを返します。これで生データは扱いやすくなりますが、完璧な状態にはほとんどなりません。欠損値や不一致ヘッダー、混在型、重複、不正な日付などがよく発生し、これらをクレンジングしなければレポートや分析、財務判断に悪影響が及びます。

本ガイドでは、乱雑な抽出データを信頼できるデータセットに変えるための実践的な手順(検証・標準化・エンリッチメント・テスト・ログ記録)を解説します。メールやPDF添付ファイルを扱うチーム向けには、Parseurのようなツールがデータキャプチャを簡単にしてくれるため、クレンジングや品質管理に集中できます。

データ抽出APIのしくみを最初から最後まで詳しく知りたい方は、What Is a Data Extraction API for Documents?(ドキュメント向けデータ抽出APIとは)完全ガイドを参照してください。

Types Of Data Cleaning Techniques

データ抽出APIを利用してデータを取得した後、その生データにはしばしば不一致、欠損値、書式エラー、重複が含まれます。たとえAPIがPDFや画像、メールなどの非構造化ファイルをJSONやCSVのような構造化フォーマットに変換したとしても、信頼できる状態にするには丁寧なクレンジングが欠かせません。

Harvard Business Review の調査によると、企業データのうち3%しか基本的な品質基準を満たしておらず、新規データの47%に重大なエラーが含まれるそうです。これらのエラーは実際の損失につながっており、Gartner によればデータ品質の問題は平均で企業に年間1,500万ドルの損失を与えているとのことです。

効果的なデータクレンジング技術の導入は、データの正確性・一貫性・分析への備えを整えるうえで不可欠です。代表的な技術例は以下の通りです。

Validation and Error Checking

抽出データが日付・数値・メールアドレスなど想定フォーマットと合致しているか確認します。これにより分析やレポート時のミスやAPI出力の信頼性低下を防ぎます。

Standardization

電話番号・住所・日付などを一貫したフォーマットで正規化します。これによりデータセットの統合が容易になり利便性が高まります。

Handling Missing Values

データセットの用途に応じてNULLや欠損値を埋めたり補間する、もしくは不完全なレコードを削除する対応を行います。

Deduplication

APIの多重呼び出しや複数データソースの影響で発生した重複エントリを削除し、データセットの正確性を確保します。

Data Enrichment

抽出データに地理的情報や分類など付加価値のある情報を加えて、データをさらに活用しやすくします。

Format and Type Correction

不正値や誤った書式、文字列から数値への変換、スペル訂正、通貨表記統一などでデータの一貫性を徹底します。

Logging and Auditing

全てのクレンジング操作を記録し、API抽出の品質把握やデータの可追跡性・保全性を高めます。

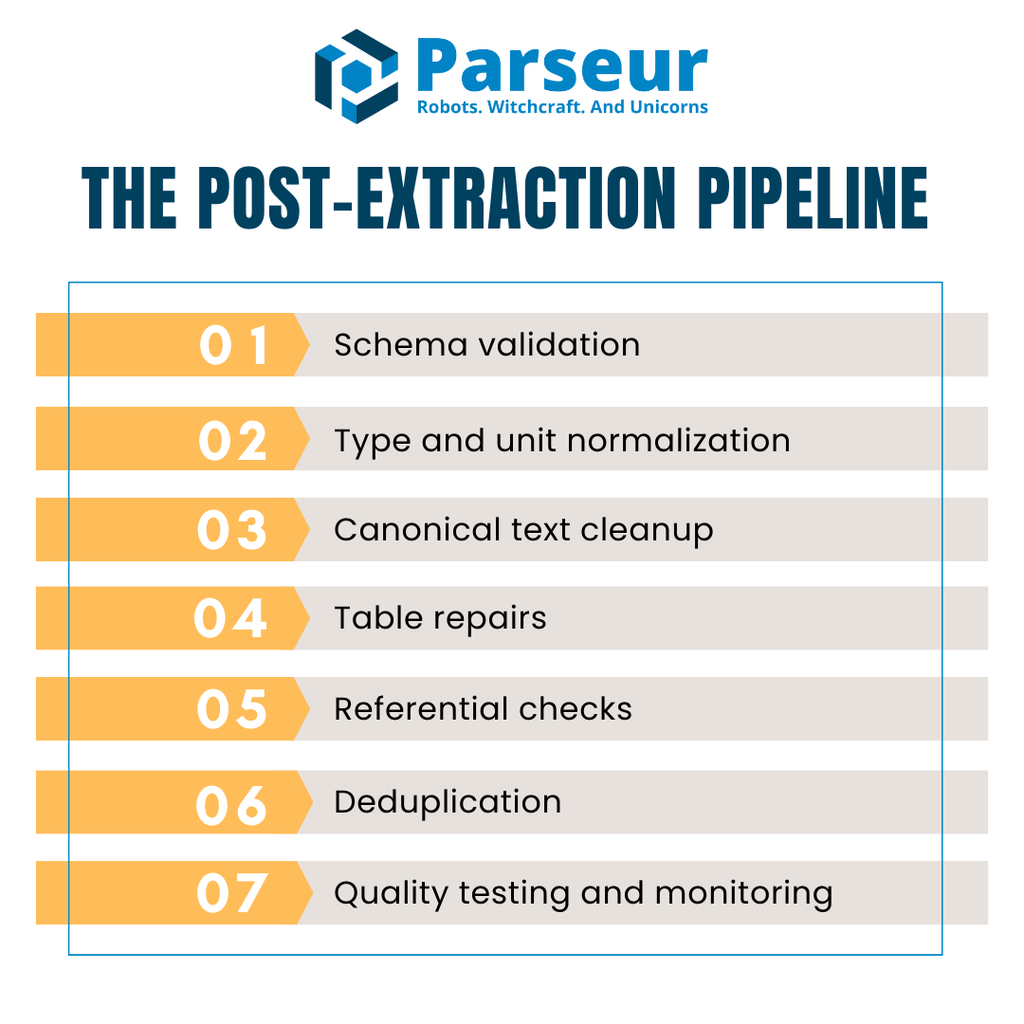

The Post-Extraction Pipeline (Overview)

APIからデータを取得しても、そのまま分析やレポートに使えることはほとんどありません。生データはよく、欠損フィールド・型不一致・テーブル不整合・重複値などを含みます。こうした問題が下流に渡らないよう、すべての抽出データバッチに対して繰り返し適用できる構造的パイプラインが必要です。

実用的な抽出後クレンジングパイプラインは、通常次の主な5ステージで構成されます。

- スキーマ検証 — 受信したJSONまたはCSVが期待通りの構造か確認し、最初に不正データを弾く。

- 型・単位の正規化 — データ型の修正、欠損値への対応、単位やフォーマットを揃える。

- テキスト標準化 — 文字列正規化、大小文字整形、Unicode不一致の解消。

- テーブル修正 — ヘッダー統一、明細整列、複合明細の合計再計算など。

- リファレンスチェック — サプライヤや通貨、税ルールといった他データとの整合性チェック。

- 重複排除 — 重複レコードを削除するが、本来の繰り返しデータは残す。

- 品質テスト・監視 — 自動チェックでバグやエラーを早期検知し、本番データの破損を防ぐ。

パフォーマンス面では、多くのチームがカラム型ストレージ(Apache ArrowやParquetなど)でデータを保持しつつクレンジングを実行します。これにより特に大規模な請求書や取引データの処理効率が向上します。

フロー全体は「API→検証→クレンジング→QA→ウェアハウス」のスイムレーンのようなもので、一貫したデータ品質・コスト削減・不意の品質問題予防につながります。

Step 1: Validate Against A Schema (Stop Garbage Early)

API抽出後のデータクレンジングで最初に行うべきはスキーマ検証です。機械で読み取り可能か、期待される構造と合致するかを確実にします。このプロセスなしでは、破損データがシステムに紛れ込み、後工程で障害を引き起こします。

代表的なのは JSON Schema(Draft 2020-12)で、移植性が高くエコシステムも充実しています。JSON Schemaでは有効データがどのような構造か(フィールド型・必須属性・フォーマットルール等)を定義でき、例えばinvoiceDateはISO 8601形式、totalは必ず非負数、といった指定が可能です。

Pythonプロジェクトなら Pydantic v2 がランタイムでの妥当性検証と自動JSON Schema生成に優れています。請求書や明細アイテムをモデル化することで、構造の厳密な担保や不正データの即時検知が行えます。vendorNameは必ず文字列、invoiceNumberは正規表現、currencyは限定通貨(USD, EUR, GBP)なども実装可能です。

検証ルールは型チェックだけでなく、許容値リスト(enum)・書式正規表現・数値範囲なども加えて設計しましょう。こうしたガードレールで微妙なエラーも早期ブロックできます。

また、不正レコードの取り扱い方針(すぐにリジェクトか、デッドレターキューに隔離して後でレビューか)も事前に決めておきましょう。この「失敗は早めに発覚させる」方式で信頼できるデータのみ後工程へ通過できます。

Step 2: Fix Types, Nulls, And Units

スキーマ検証を通過したら、次はデータ型の修正・欠損値への対応・単位正規化が重要です。APIがJSONやCSVで出力しても、数値が文字列で格納されていたり、日付形式がまちまちだったり、各行でNULL値がバラバラに現れるのはよくあります。こうしたままでは分析やレポートの信頼性が確保できません。

Parseur API を使えば、請求書・領収書・メールの抽出データを、最小限のセットアップでクリーンなJSONへと自動変換できます。リアルタイムWebhookで構造化済みデータをERPやCRM、DBに直接送るため、手動クレンジングの負担が減り、バリデーションルール適用も楽になります。これによりパイプラインの高速化と一般的なエラーの未然防止が実現します。

まず正しいデータ型への変換を行います。数量や単価などは数値型へ、invoiceDateやdueDateは標準ISO日付へ、paidやapprovedなどの真偽値も「True/False」型へ統一します。

次に欠損値の取扱い方針を決めます。主な3つは、

- Drop: 重要でない場合は不完全な行を削除

- Fill: デフォルト・平均値・プレースホルダー等で補完

- Flag: 未入力フィールドは「要確認」扱いにして置換せずラベル付与

どのフィールドでどの戦略を採るかのルールも残しておきましょう。

Pythonなら Pandas がこの処理をシンプルにします。to_numeric(errors="coerce"), to_datetime(), fillna(), dropna() などの関数で型変換やNULL処理が自在です。これによりどの列も期待通りの型に揃い、NULLの挙動も一貫化できます。

この「型・欠損値・単位」の早期修正が、その後のテキスト正規化、テーブル補正、リファレンスチェックの確かな土台となります。

Step 3: Canonicalize Text (Names, Casing, Unicode)

数値・日付フィールドの修正が終われば、次はテキストデータのクレンジングです。テキストは大抵バラバラな大文字小文字、空白、エンコーディングで混乱し、グルーピングや突合に失敗しやすいです。同じベンダーでも名称が微妙に異なると集計が分断され分析も台無しになります。

まずは空白と句読点のクリーンアップ。前後空白や重複スペース削除、余計な記号の除去など。次に一貫した大文字小文字ルールの適用。「会社名はタイトルケース」「請求書ステータスはすべて大文字」などで比較容易にします。

さらに重要なのがUnicode正規化です。異なるエンコーディングだと見た目が同じでも「別もの」と認識されます。NFKC正規化でアクセントや記号、句読点を統一保管します。世界的なデータセットでは、例えば「Café」「Cafe」の重複回避のため、照合時はアクセントを剥ぐ対応も有効です。

最後にサプライヤ名・ベンダー名など「重要テキスト項目」の**標準化リスト(カノニカルリスト)**を用意しましょう。「Inc.」→「Incorporated」等の略称統一から始め、エンティティリゾリューション用に機械学習的なアプローチも段階的に拡張可能です。

テキスト標準化は、異なるソース間の照合性を保ち、下流処理での重複や分断リスクを大きく減らします。

Step 4: Repair Tables (Line Items That Add Up)

API抽出後、最も修正が必要になるのは明細テーブルです。ヘッダーが複数行に分割されていたり、PDFからセルが回転して出力されたり、値が合体していて分析しにくい場合もしばしば。まず「たった1行の明確なヘッダー行」を用意し、自分のスキーマにマッピングするのが第一歩です。

構造が整ったら、単位も揃えて計算時の差異を解消します。例えばkgとlbsを共通単位に変換したり、通貨を統一して合計比較できる状態に。各行のamount = quantity × unitPrice も再計算して明細の整合性を検証しましょう。重要なのは、「明細合計と請求書合計が少しの誤差範囲内で一致するか」を常にチェックすることです。不一致なら見逃さず、直ちにフラグ。

CSVへのエクスポートは一層ややこしくなります。隠れた区切り文字、余分なクォート、エンコーディング不一致などで列ズレ発生も。柔軟な DuckDB などで明示的な区切り文字・クォート・エンコーディングを指定し、all_varchar等でローディング後に型変換するパターンが安全です。

これらの対策によって、乱雑だった抽出テーブルも分析・財務部門が信頼できる構造化データへと変貌します。重要なのは「数字が合致しているか」だけでなく、「レポートに見えないエラーが絶対紛れ込まない保証」を取ることです。

Step 5: Referential And Business Rules

単体レコードが正しいように見えても、テーブル間を比較すると問題が発覚する場合があります。リファレンスチェックはデータが相互に整合しているか、ビジネスルールに準拠しているかを検証する重要な段階です。

例えばinvoicesテーブルのvendorIdは全てマスターテーブルのvendorsに存在しているべきです。通貨コードは自社で許可されたコードのみ、税率も適用国・地域に正しく合致している必要があります。こうした整合性の不備を早期に発見しないと、ジョイン失敗、不正レポート、コンプライアンス違反等のリスクに直結します。

近年はこの種のルールをトランスフォーメーション層で直接コーディングするケースが増加。DBT tests を用いれば、

- unique(請求書番号重複なし)

- not_null(vendorIdなど重要項目はNULL禁止)

- accepted_values(通貨はUSD, EURなど指定値のみ)

- relationships(vendorIdは必ずvendorsテーブルに存在)

のように制約を明示可能です。

リファレンス整合性を自動テストに組み込むことで、問題は即座に発覚し、週単位の監査でやっと見つかる…といった事態を防げます。手作業レビューをスケーラブル・再現可能なプロセスへ昇華し、報告・コンプライアンスの信頼性も高まります。

Step 6: Deduplication And Record Linkage

重複レコードは静かにデータへの信頼を損ねます。合計金額を水増ししたり、二重支払いを招いたり、監査時に混乱を引き起こしかねません。API抽出後のクレンジングでは、正規エントリを誤って消さずに重複判定できる戦略が必要です。

まず**決定的な照合キー(キーセット)**を定義します。請求書の場合は supplierName + invoiceNumber + invoiceDate + amount + currency の組み合わせが「ほぼ確実に重複である」と特定できます。

厄介なのは、完全一致でなく微妙に異なる「擬似重複」。ファジーマッチングウィンドウ――例えば同一サプライヤ・7日以内・金額が1%以内――でレビュー対象をピックアップできます。バケット化によって意図しない正規データの削除リスクを減らし、不正エントリだけをカバーします。

さらに**シンタクティックマッチ(文字列直接比較)とセマンティックマッチ(意味的類似判定:「Acme Corp.」と「ACME Corporation」は同一会社、と理解する)**も区別すると有効です。OpenRefine などを使えばクラスタリングによる類似グルーピングで、重複候補を自動抽出しやすくなります。

決定論的ルールとファジー・セマンティック照合の組み合わせが、「正確性を最大化しつつ正常データの誤消去を最小限に留める」最良のアプローチです。

Step 7: Automate Data Quality Checks

データ品質は一度きりの作業ではありません。丁寧にクレンジングしても、新着データでいつエラーが入り込むかわかりません。品質チェック自動化によって、問題を常に一貫して検知できるようになります。

信頼性の高い選択肢の一つがGreat Expectations (GX)です。GXで定義するExpectationルールで、たとえば請求書番号が正規表現と合うか、数量が有効レンジにあるか、行数がある範囲内か等を検証可能。CI/CDパイプラインで自動実施し、抽出品質低下がすぐ分かります。

Python主体のパイプラインでは、Pandera を使いPandasデータフレーム上で型・範囲・NULL制約を手軽に適用。数行のコードで不正行のリジェクトや、異常パターンの警告が出せます。

自動化の結果は可視化してこそ効果的です。ダッシュボードやモニタリングツールに失敗率・通過率・エラー内容を出力し、関係者がタイムリーに問題を把握できる仕組みにしましょう。

データ品質を「継続的かつモニタリング可能」にすることで、常に信頼性の高いデータセットを保てます。

Performance And Storage Tips (So Data Cleaning Does Not Become the Bottleneck)

抽出後のデータクレンジングは必須ですが、パイプラインのボトルネックになってはいけません。大量の請求書・レシート・取引ログ等の処理では、最適化されていないプロセスがレイテンシ増・コスト増・後続チームのストレス要因になります。目指すべきは「品質を守りながら高速性も維持する」ことです。

MDPI の研究によれば、「データクレンジングがデータ処理全体の最大80%の時間を占める場合がある」とされ、パイプライン効率への影響は非常に大きいです。これは、データクレンジング処理を最適化してパイプライン全体のパフォーマンスと効率を維持することの重要性を示しています。

パフォーマンス維持のための実践アイデア例:

- カラム型ストレージ形式の利用 — Apache ArrowやParquet形式を活用すれば、ベクトル演算によるメモリ効率や処理速度の向上、分析エンジンとの連携がしやすくなります。

- バッチ&並列処理 — レコードを都度処理せず、バッチまたは非同期タスクで複数ファイルを同時に処理、全体の待ち時間を最小化。

- ウェアハウスネイティブな処理 — 巨大CSVや複雑なジョインなどはDuckDB やDWHへ直接パース処理を移譲、パイプラインの負荷を減らし処理高速化。

- 中間結果キャッシュ — 再クレンジングが発生しやすい工程では同じデータ処理を繰り返さずに済むようキャッシュ利用。

- システムリソース監視 — CPU・メモリ・IO状況をモニタリングし、サービスへの影響が生じる前にボトルネック検出。

精度と拡張性の両立には、カラム型フォーマット、バッチ処理、計算資源の最適活用がカギ。こうしてバリデーションからクリーンアップまで、リアルタイム分析やレポーティングに必要なスピードを維持しましょう。

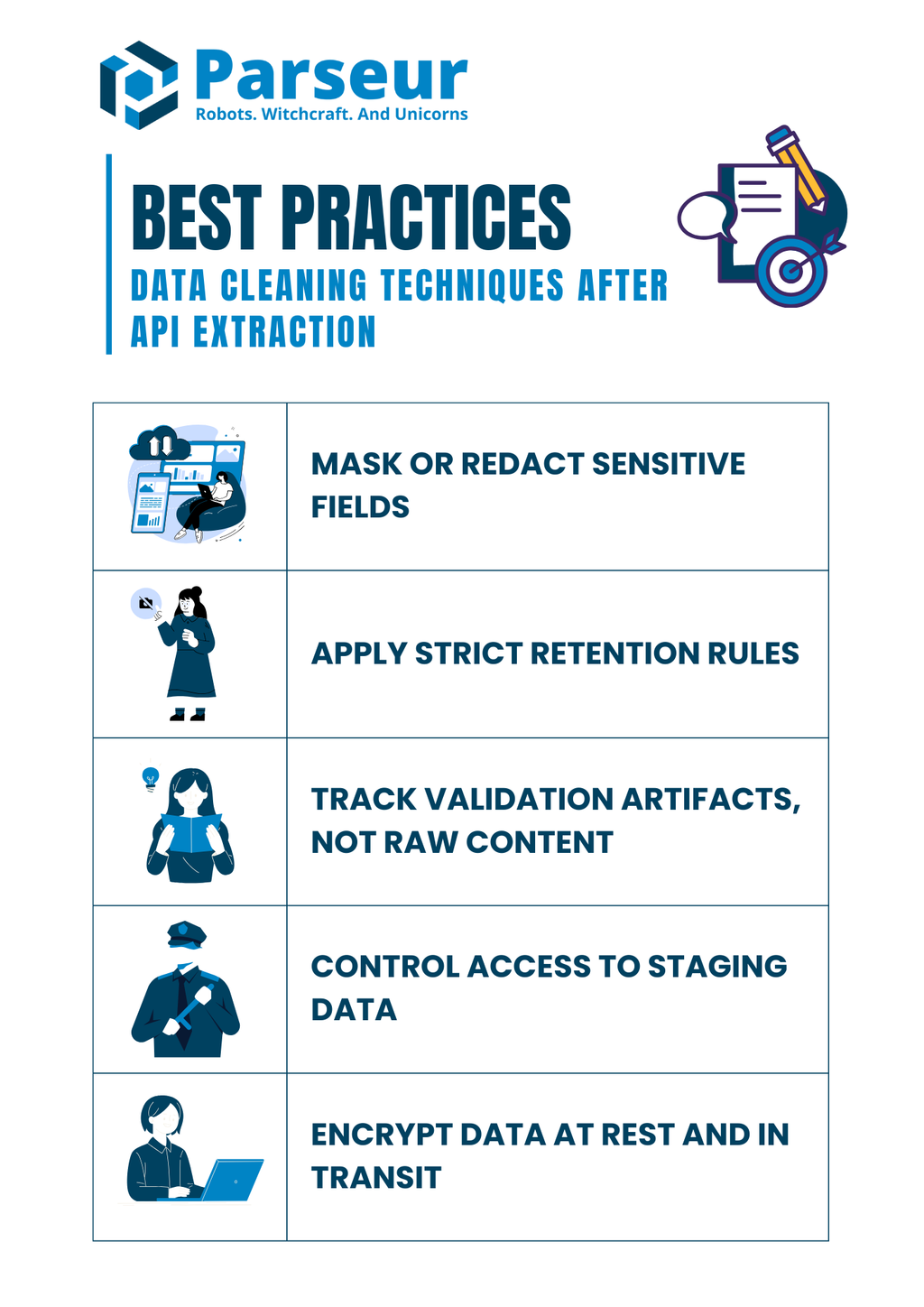

Security And Compliance Notes (Do Not Clean Away Controls)

データクレンジングはミス修正目的だけでなく、コンプライアンス面でも重要です。多くの抽出文書には口座情報・税番号・従業員情報など機微な情報が含まれており、後処理段階でこれを適切に扱わないとリスクが発生します。

Mitratech の調査では、「データガバナンス不全から全体の61%の組織が流出・非効率・コンプライアンス違反等に悩まされている」とされ、強力なデータクレンジング技術の実践が品質と規制対応の両方で不可欠であることが裏付けられています。

クレンジング時にコンプライアンスを損なわないためのベストプラクティス:

- 機微フィールドのマスキング/ハッシュ化 — 社会保障番号、クレジットカード番号、口座番号等の生データログを防ぎ、記録時は必ずマスキングやハッシュを施す。

- 厳格な保存期間ルール適用 — 抽出元ファイルは最低限の期間のみ保存し、法令で定められた保存期間内だけ保管する。

- 検証結果のみ記録、生データは保存しない — 欠損や日付不正の内容記録は行っても、元文書自体の恒久保存は避ける。

- ステージング領域への厳格なアクセス制御 — 権限ベースでのアクセス管理により、機微レコードの閲覧や修正は認可ユーザーのみに限定。

- データ暗号化(保存時・転送時) — ステージングDB、ファイル、ログは全て暗号化し情報漏洩リスクを抑える。

技術的クレンジングと同時にコンプライアンス管理も徹底し、規制違反や顧客信頼損失リスクを低減しましょう。

Worked Example (Pulling The Pieces Together)

理解を深めるため、検証・正規化・リコンサイル・テストを一つのパイプラインで行うシンプルな例を挙げてみましょう。Parseur API を使ってPDFやメールから請求書データを抽出した場面を想定してください。Parseurは非構造文書から直接構造化済みJSONを配信し、クレンジングパイプラインの良い出発点になります。

サンプル抽出JSON(入力例):

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

ステップ1: Pydanticでスキーマ検証

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# Define line item model

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Define invoice model

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# Example raw JSON string

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# Parse JSON into Invoice model

invoice = Invoice.model_validate_json(raw_json)

# Normalize line items into Pandas DataFrame

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# 合計値チェック

if round(df["amount"].sum(), 2) != invoice.total:

print("明細合計が請求書合計と一致しません")

else:

print("合計値一致 ✅")

print(df)

ステップ3: Great Expectationsで品質テスト

import great_expectations as gx

# Initialize Great Expectations context

context = gx.get_context()

# Load the Pandas DataFrame into a batch

batch = context.sources.pandas_default.read_dataframe(df)

# Get a validator to run expectations

validator = batch.get_validator()

# Set expectations

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# Run validation and capture results

results = validator.validate()

print(results)

出力(クレンジング結果):

- スキーマに沿って請求書データを検証

- 日付・数値型を正規化

- 合計値のリコンサイル(許容誤差チェック付)

- 品質テストで値の範囲や構造を検証

このように、乱雑なAPI出力も早期にバリデートし、決定的にクレンジングした上で本番システムに投入できます。

データクレンジングは信頼できるパイプライン構築の一工程にすぎません。その起点は「文書から正確かつ構造化されたデータを取得する」ことです。ここでParseurの力が活躍します。Parseurの直感的なプラットフォームと柔軟なParseur APIで、PDF・メール・スプレッドシート・添付ファイルからのデータ抽出を自動化し、チームの手間を軽減。抽出後は本ガイドで解説したクレンジング手法を適用し、信頼性ある分析可能なデータに仕上げましょう。

将来を見据えて、Gartnerは2026年までに新規クラウド導入の70%が、個別ツール統合ではなく「連携可能なクラウドデータエコシステム」を活用すると予測。つまり構造化データ・API抽出ワークフローの価値は今後もさらに高まります。

APIがドキュメント処理をどのように変革するか、ツール選定やワークフロー最適化などをまとめた包括的リソースもご覧ください。Data Extraction APIs for Documents(ドキュメント向けデータ抽出API完全ガイド)もぜひ参照し、乱雑な生ファイルから実用的なデータへと自信を持って進めましょう。

よくある質問

まとめに入る前に、API抽出後のデータクレンジングに関するよくある質問を紹介します。これらの簡単な回答は、チームがよく直面する一般的な落とし穴や実務的な懸念事項に対応しています。

-

合計値が欠損した行は削除すべきですか?

-

私は、即座に削除するのではなく隔離して調査することを推奨します。合計は重要な財務項目です。何も言わずに削除してしまうとレポートに歪みが生じます。レビュー用バケットに保持することで透明性が保たれ、適切な解決につながります。

-

クレンジング前にJSONの妥当性を保証するには?

-

JSON SchemaやPydanticを使って、受信データが機械で読み取れて、期待値のフィールドとマッチしているか検証しましょう。不正なJSONを早期に検知すれば、後工程での手戻りを防げます。

-

ウェアハウスがなくても品質テストはできますか?

-

はい。Great ExpectationsやPanderaのようなツールを使えば、PythonのパイプラインやCI/CDワークフロー内でルールを直接適用できます。ウェアハウスに取り込む前から品質維持が可能です。

-

テーブルの合計が請求書合計と合わなかった場合は?

-

明細合計と請求書合計を許容範囲内で照合するリコンサイルルールを設定しましょう。不一致は上書きせずフラグを立て、即レビューへ回しましょう。

-

上流でテストしているならDBTテストは不要ですか?

-

いいえ。DBTテストはモデル層で制約をコード化する追加のセーフティネットです。上流でのチェックがあっても、この多重防御アプローチにより不十分なデータがプロダクション分析に流入するのを防げます。

-

CSVエクスポート時のエンコーディング問題はどう対処する?

-

パース時には必ず区切り文字・エンコーディング・クォート文字を明示的に指定しましょう。DuckDB等のツールを使うとファイル診断や、複数ソースからのデータ正規化時にも一貫性が保てます。

最終更新日