Principais Aprendizados

- A extração de dados pode gerar resultados desorganizados, exigindo validação e pós-processamento se não for cuidadosamente projetada.

- Um pipeline confiável deve incluir validação de esquema, normalização, limpeza de texto, ajustes em tabelas, deduplicação e verificações contínuas de QA.

- Ferramentas como JSON Schema, Pydantic, Pandas e Great Expectations fortalecem e automatizam o pós-processamento.

- A Parseur API ajuda a capturar e estruturar dados rapidamente, permitindo que as equipes foquem em qualidade e análise.

Técnicas de limpeza de dados referem-se à correção, padronização e validação dos dados brutos retornados por APIs. Mesmo que ferramentas de extração convertam arquivos não estruturados como PDFs, imagens ou e-mails em formatos estruturados como JSON ou CSV, os resultados geralmente incluem inconsistências, valores nulos, tipos incorretos, duplicatas ou erros de formatação. A limpeza garante que o conjunto de dados atenda ao esquema planejado e seja confiável para relatórios, análises e fluxos de trabalho posteriores.

Um estudo recente da DataXcel revelou que 14,45% dos registros telefônicos extraídos estavam inválidos ou inativos, ressaltando a importância de práticas robustas de limpeza para mitigar esses erros e garantir a qualidade dos dados extraídos.

APIs que extraem dados de PDFs, imagens ou e-mails geralmente retornam formatos estruturados como JSON ou CSV. Embora isso torne a informação bruta mais utilizável, o resultado raramente é perfeito. Equipes frequentemente encontram valores ausentes, cabeçalhos inconsistentes, tipos de dados mistos, duplicatas ou datas malformadas. Esses erros podem comprometer relatórios, análises e decisões financeiras sem limpeza.

Este guia percorre um playbook prático para transformar extrações desorganizadas em conjuntos de dados confiáveis: validar, padronizar, enriquecer, testar e registrar. Para equipes que lidam com anexos de e-mail e PDF, ferramentas como o Parseur simplificam a captura para que você possa focar na limpeza e na qualidade.

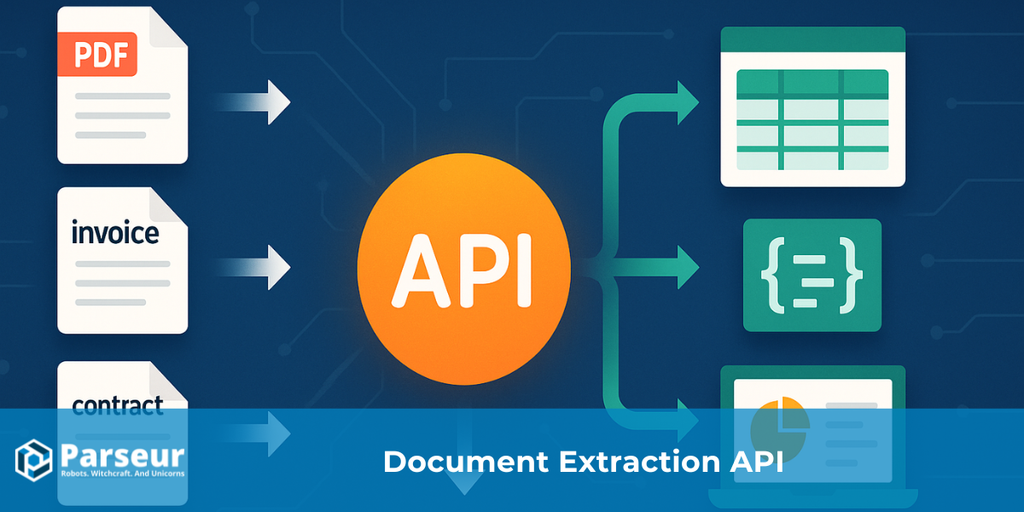

Se quiser aprofundar seu conhecimento sobre como APIs de extração de dados funcionam de ponta a ponta, confira nosso guia completo: O Que é uma API de Extração de Dados para Documentos?

Tipos de Técnicas de Limpeza de Dados

Após extrair dados usando uma API de extração, os resultados brutos frequentemente contêm inconsistências, valores ausentes, erros de formatação ou duplicatas. Embora as APIs ajudem a converter arquivos não estruturados como PDFs, imagens ou e-mails em formatos estruturados como JSON ou CSV, os dados ainda necessitam de limpeza cuidadosa para serem confiáveis.

Um estudo feito pela Harvard Business Review mostrou que apenas 3% dos dados das empresas atendem a padrões básicos de qualidade, e 47% dos registros recém-criados têm pelo menos um erro crítico. Esses problemas têm impacto real, pois a Gartner projeta que questões de qualidade de dados custam, em média, US$15 milhões anuais às empresas.

Implementar técnicas eficazes de limpeza de dados é essencial para garantir que seus dados sejam corretos, consistentes e prontos para análise. Veja algumas das principais técnicas:

Validação e Verificação de Erros

Confirme que os dados extraídos estão nos formatos esperados, como datas, números ou e-mails. Isso impede erros em análises ou relatórios e garante precisão nos resultados da sua API de extração.

Padronização

Converta dados para formatos consistentes, como normalizar números de telefone, endereços ou datas, facilitando a integração e uso dos dados.

Tratamento de Valores Ausentes

Dependendo do objetivo do conjunto de dados, trate nulos ou ausências preenchendo lacunas, interpolando ou removendo registros incompletos.

Deduplicação

Elimine entradas duplicadas que podem vir de chamadas repetidas de API ou fontes sobrepostas, aumentando a precisão e confiabilidade.

Enriquecimento de Dados

Para aumentar a utilidade dos dados extraídos, você pode adicionar contexto ou informações suplementares, como detalhes geográficos ou categorias.

Correção de Formato e Tipo

Para garantir consistência em todo o seu dataset, corrija valores mal formatados, converta strings em números, corrija erros de digitação ou padronize moedas.

Registro e Auditoria

Acompanhe todas as operações de limpeza para monitorar a qualidade das extrações da API e preservar a integridade dos dados ao longo do tempo.

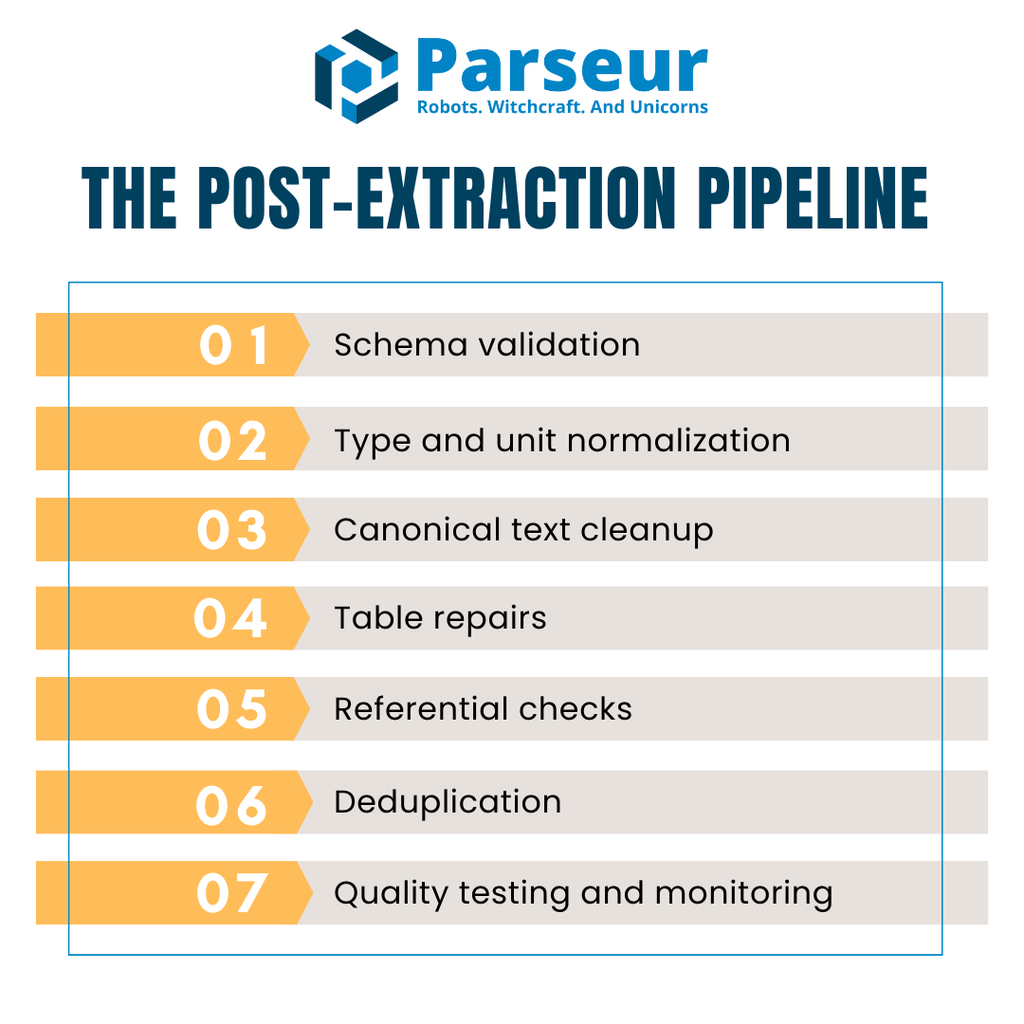

O Pipeline Pós-Extração (Visão Geral)

Após a extração de dados via API, eles raramente estão prontos para uso imediato em análises ou relatórios. Os outputs brutos frequentemente contêm campos ausentes, tipos discordantes, tabelas inconsistentes ou valores duplicados. Para evitar propagar esses problemas ao longo do pipeline, equipes precisam de um fluxo bem estruturado e repetível para cada lote extraído.

Um pipeline prático de pós-extração geralmente inclui cinco estágios principais:

- Validação de esquema – Confirme que o JSON ou CSV recebido corresponde à estrutura prevista antes de processar qualquer coisa.

- Normalização de tipo e unidade – Corrija tipos de dados, trate valores ausentes e aplique unidades ou formatos padrão.

- Limpeza canônica de texto – Padronize strings, normalize capitalização e resolva inconsistências de Unicode.

- Reparo de tabelas – Unifique cabeçalhos, alinhe itens e reconcilie totais em faturas ou recibos multilinhas.

- Verificações referenciais – Valide relações entre datasets, como fornecedores, moedas ou regras fiscais.

- Deduplicação – Identifique e remova registros duplicados sem descartar repetições legítimas.

- Testes e monitoramento de qualidade – Execute checagens automáticas para que erros sejam detectados cedo e não corrompam dados da produção.

Quanto à performance, muitas equipes mantêm dados em formato colunar como Apache Arrow ou Parquet durante a limpeza. Isso melhora o uso de memória e o processamento, especialmente em grandes conjuntos de faturas ou transações.

Pense no fluxo como uma raia—API → Validação → Limpeza → QA → Data warehouse, para reforçar a consistência, reduzir custos e evitar surpresas na qualidade dos dados.

Passo 1: Valide Contra um Esquema (Interrompa o Lixo no Início)

O ponto de partida na limpeza de dados extraídos por API é a validação contra um esquema. Isso certifica que as informações recebidas são legíveis por máquina e correspondem à estrutura prevista. Sem esse passo, dados malformados podem infiltrar-se no sistema e causar falhas depois.

O padrão mais usado para isso é o JSON Schema (Draft 2020-12), por ser portável, agnóstico e sustentado por um ecossistema robusto. O JSON Schema permite definir como o dado válido deve ser: tipos de campos, obrigatoriedade, regras de formato. Por exemplo: invoiceDate precisa seguir ISO 8601, total sempre ser um número não negativo.

Em projetos Python, o Pydantic v2 valida dados em tempo real e gera definições de JSON Schema automaticamente. Modelos de faturas ou itens de linha reforçam a estrutura e capturam dados inválidos instantaneamente — como vendorName sendo string, invoiceNumber se encaixando num padrão regex, ou currency devendo pertencer ao conjunto (USD, EUR, GBP).

Regras de validação devem ir além de tipos. Use enumerações para valores permitidos, regex para formatos como CNPJ/ID fiscal, ou faixas numéricas para totais e quantidades. Esse tipo de restrição bloqueia erros mais sutis.

Defina também como tratar registros inválidos. Equipes costumam rejeitá-los imediatamente ou isolá-los em uma dead-letter queue para revisão posterior. Essa abordagem fail-fast garante que só dados confiáveis avancem no pipeline.

Passo 2: Corrija Tipos, Nulos e Unidades

Após a validação do esquema, o próximo passo é corrigir tipos, tratar valores ausentes e normalizar unidades. Mesmo que a API gere JSON/CSV estruturado, é comum haver números como strings, datas em vários formatos e nulos espalhados. Sem ajustar esses pontos, a análise posterior será prejudicada.

Com a Parseur API, é possível extrair dados de faturas, recibos e e-mails para JSON limpo quase sem configuração. Os webhooks em tempo real enviam o dado já estruturado para ERPs, CRMs ou bancos de dados, reduzindo a limpeza manual antes da aplicação das regras de validação. Isso não só acelera o fluxo de limpeza como também previne muitos erros comuns do início.

O primeiro passo é forçar os valores ao tipo correto. Converta campos como quantidade ou unitPrice em tipos numéricos, e datas como invoiceDate e dueDate para formatos ISO. Valores booleanos como pago ou aprovado também devem ser normalizados para true/false.

Depois, escolha como lidar com valores ausentes. Três estratégias principais:

- Excluir: remova linhas incompletas se não forem essenciais.

- Preencher: aplique valores padrão, médias ou placeholders.

- Sinalizar: marque os campos ausentes para revisão, em vez de preencher automaticamente.

A regra escolhida deve ser documentada campo a campo, para garantir consistência.

No Python, Pandas facilita: funções como to_numeric(errors="coerce"), to_datetime(), fillna() e dropna() ajudam a padronizar rapidamente. Assim todo campo tem o formato esperado e os nulos são tratados sem ambiguidades.

Corrigir tipos, ausências e unidades desde cedo cria a base para as próximas etapas como normalização textual, reparo de tabelas e checagens referenciais.

Passo 3: Canonize Textos (Nomes, Capitalização, Unicode)

Após corrigir campos numéricos e datas, o foco passa para a limpeza dos valores textuais. Dados de texto frequentemente são bagunçados, com variações de caixa, espaços ou codificação que atrapalham agrupamento e comparação. O mesmo fornecedor pode aparecer sob diversos nomes se não for padronizado, fragmentando suas análises.

O primeiro passo é a limpeza de espaços e pontuação. Remova espaços e caracteres sobrando, colapse múltiplos espaços e trate caracteres extras. Em seguida, aplique regras consistentes de capitalização. Por exemplo, nomes de empresas podem ser formatados em title case, enquanto campos de status podem ser padronizados em caixa alta para facilitar comparação.

Trate também a normalização Unicode: codificações diferentes podem fazer duas strings visualmente iguais serem consideradas distintas. Ao normalizar texto em forma NFKC, acentos, símbolos e pontuação ficam armazenados de modo padronizado. Em bases globais, pode ser útil tirar acentos de nomes para evitar duplicatas tipo “Café” e “Cafe”.

Por fim, construa uma lista canônica para campos críticos como nomes de fornecedor. Comece com regras leves de abreviações (“Inc.” vs “Incorporated”) e expanda até modelos de machine learning para resolução de entidades.

Canonizar texto garante comparabilidade entre fontes e reduz risco de registros duplicados ou fragmentados no downstream.

Passo 4: Repare Tabelas (Itens de Linha que Somam Corretamente)

Após a extração via API, as tabelas de itens normalmente exigem mais reparo. Cabeçalhos podem estar divididos em várias linhas, células giradas de PDFs escaneados, ou valores mesclados dificultando a análise. A limpeza começa por garantir um cabeçalho único e consistente por tabela, compatível com seu esquema.

Com a estrutura ajustada, normalize as unidades para manter os cálculos consistentes em todas as faturas. Por exemplo, converta kg/lb para uma única unidade e reconcilie moedas antes de comparar totais. Recalcule amount = quantity × unitPrice em cada linha — etapa simples e crítica para garantir integridade. Sempre cheque se a soma dos itens confere com o total da fatura dentro de uma margem de tolerância. Assim, flagra-se rapidamente casos de item faltando ou duplicado.

Exportar para CSV adiciona complexidade. Delimitadores escondidos, aspas e encoding diferente podem prejudicar colunas. Use ferramentas como DuckDB para carregar arquivos com delimitador, aspas e codificação definida. Opções como all_varchar facilitam importar arquivos problemáticos para depois fazer cast para os tipos certos.

Esses passos transformam tabelas extraídas desorganizadas em linhas confiáveis para análise e times financeiros. O objetivo não é apenas fazer os números baterem, mas evitar que erros silenciosos entrem nos relatórios.

Passo 5: Regras Referenciais e de Negócio

Muitos problemas só aparecem ao comparar dados entre tabelas, mesmo que registros individuais estejam corretos. Checagens referenciais asseguram consistência dos valores e respeito às regras de negócio antes de chegar ao warehouse.

Por exemplo, cada vendorId em invoices precisa existir na tabela de fornecedores. Códigos de moeda devem limitar-se às operações da empresa, e taxas de imposto precisam condizer com a jurisdição. Detectando cedo, equipes evitam erros em joins, relatórios ou compliance.

Times modernos codificam essas regras nas transformações. Testes DBT facilitam definir restrições como:

- unique (sem invoiceNumbers duplicadas);

- not_null (campos obrigatórios como vendorId sempre preenchidos);

- accepted_values (moeda limitada a USD, EUR etc.);

- relationships (vendorId deve existir na tabela de fornecedores).

Automatizar a integridade referencial oferece defesa em profundidade: problemas aparecem na hora, não semanas depois numa revisão fiscal. Essa abordagem transforma checagens manuais em processos escaláveis e repetíveis, aumentando a confiança nos relatórios e compliance.

Passo 6: Deduplicação e Vinculação de Registros

Registros duplicados podem corroer silenciosamente a confiança nos dados. Eles inflacionam totais, geram pagamentos em dobro ou confundem auditorias. A limpeza pós-extração exige estratégia para eliminar duplicatas sem descartar repetições legítimas.

Comece definindo chaves determinísticas: em faturas, supplierName, invoiceNumber, invoiceDate, amount e currency juntos costumam indicar duplicidade verdadeira.

Além dos matches exatos, duplicatas frequentemente se escondem em registros quase idênticos. Um janela de fuzzy matching pode ajudar — ex.: faturas do mesmo fornecedor em 7 dias e diferença de até 1% no valor devem ser revisadas. Esse agrupamento evita apagar registros válidos mas identifica entradas suspeitas.

É importante diferenciar entre matching sintático (comparação direta de strings) e matching semântico (entender que “Acme Corp.” e “ACME Corporation” são a mesma entidade). Ferramentas como OpenRefine usam métodos de clusterização para sugerir duplicatas para revisão humana.

Unir regras determinísticas com fuzzy ou semântica gera um processo equilibrado de deduplicação, maximizando a precisão e minimizando o risco de apagar dados legítimos.

Passo 7: Automatize Checagens de Qualidade dos Dados

A qualidade dos dados não é tarefa única. Mesmo limpando bem, novas extrações podem gerar erros a qualquer momento. Automatizar checagens garante que problemas sejam captados sempre antes de impactar relatórios ou decisões.

Uma opção confiável é o Great Expectations (GX). O GX permite declarar regras (Expectations) no dataset. Por exemplo, exige que invoiceNumber siga um regex, quantidades em uma faixa válida ou totals dentro dos limites esperados. Esses testes podem rodar em CI/CD, fornecendo retorno instantâneo se a qualidade da extração cair.

Para pipelines nativos em Python, Pandera traz uma forma leve de impor tipos, faixas e obrigatoriedade direto em dataframes Pandas — e rejeitar ou avisar sobre linhas inválidas com poucas linhas de código.

A automação só é eficaz se os resultados forem visíveis. Envie outcomes para dashboards ou alertas, mostrando percentual de linhas inválidas, números de aprovação/reprovação e detalhes do erro. Isso fecha o ciclo e ajuda as equipes a priorizar correções rapidamente.

Medir e monitorar qualidade continuamente faz com que todo dataset limpo permaneça sempre correto, consistente e pronto para produção.

Dicas de Desempenho e Armazenamento (Para a Limpeza não Virar Gargalo)

A limpeza pós-extração é fundamental, mas não pode travar o pipeline. Ao lidar com grandes volumes de faturas, recibos ou logs de transação, processos mal otimizados criam atrasos, aumentam custos e frustram equipes. O objetivo é alinhar qualidade com velocidade.

Estudos da MDPI mostram que a limpeza de dados pode consumir até 80% do tempo dos profissionais de dados, destacando seu grande impacto na eficiência geral do processamento. Isso ressalta a importância de otimizar os processos de limpeza para manter a performance e eficiência do pipeline.

Veja maneiras práticas de manter a performance sob controle:

- Use formatos colunares — Apache Arrow e Parquet aceleram a limpeza com operações vetorizadas e poupança de memória. Integram bem com engines analíticos e bibliotecas Python.

- Loteie e paralelize cargas — Prefira jobs em lote ou tarefas assíncronas à análise record a record. Assim, processa múltiplos arquivos ao mesmo tempo e minimiza espera.

- Aproveite ferramentas nativas do warehouse — Para CSVs gigantes ou joins complexos, jogue parsing pesado para DuckDB ou direto no warehouse. Isso alivia o pipeline local e acelera as transformações.

- Faça cache de intermediários — Se algumas checagens/normaizações puderem ser reusadas, cache para não reprocessar registros redundantes.

- Monitore uso do sistema — Acompanhe CPU, memória e I/O para enxergar gargalos antes que afetem níveis de serviço.

Pipelines bem otimizados equilibram precisão e escala. Adotar formatos colunares, batching e uso inteligente de recursos mantém validação e limpeza rápidas para sustentar analytics e reporting em tempo real.

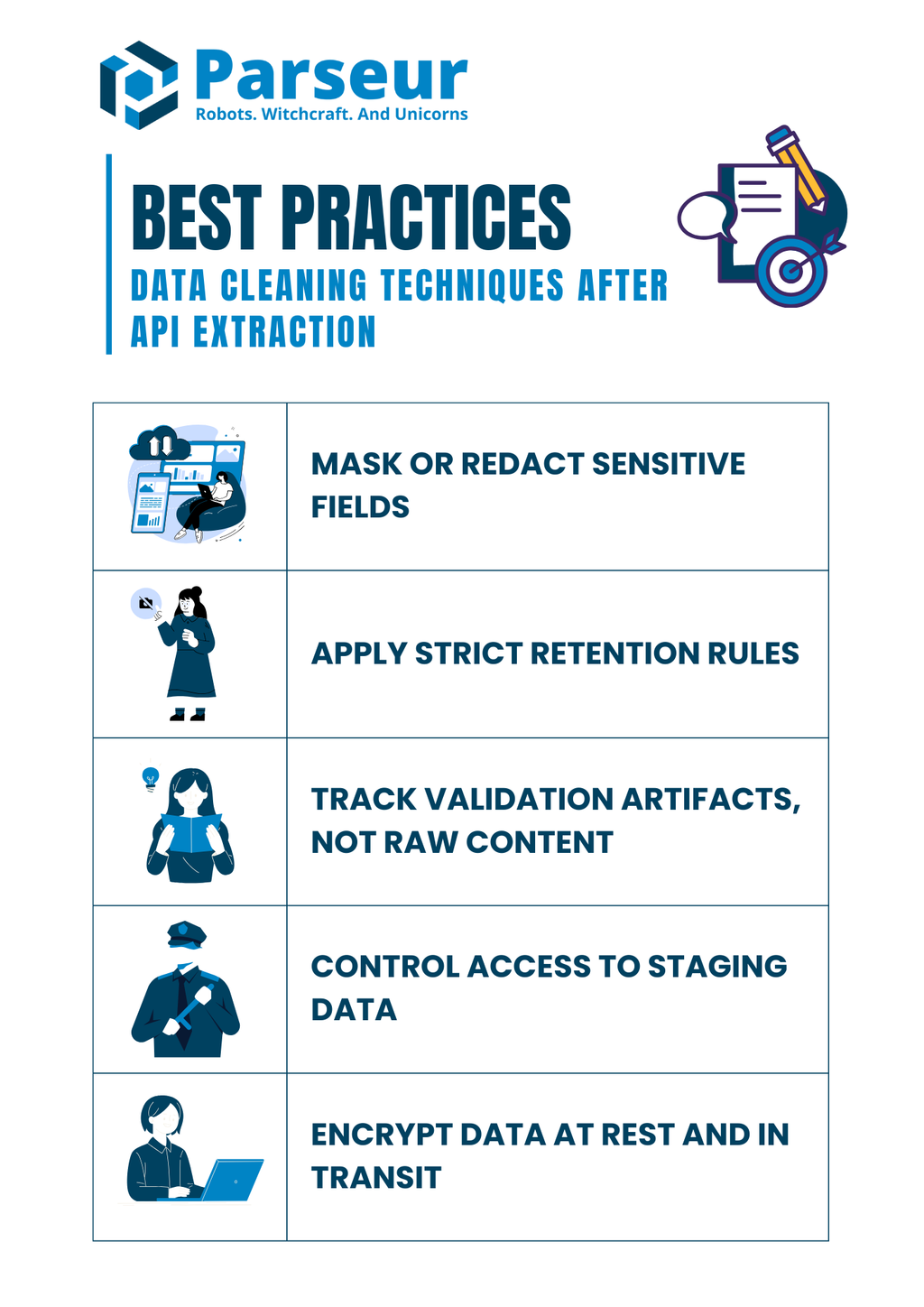

Notas de Segurança e Compliance (Não Limpe a Governança Fora)

A limpeza de dados não se resume a corrigir erros; envolve também compliance. Muitos documentos extraídos contêm dados sensíveis como bancários, identificadores fiscais ou registros de funcionários. Manipular esses campos de forma inadequada pode criar riscos ainda antes do dado chegar ao warehouse.

Pesquisas da Mitratech mostram que 61% das organizações já experimentaram violações de dados, ineficiências e problemas de compliance devido à má governança de dados. Isso evidencia a importância crítica de práticas robustas de limpeza para garantir qualidade e compliance regulatório.

Veja melhores práticas de compliance na limpeza:

- Oculte ou masque campos sensíveis — Não registre identificadores puros como CPF, cartão ou conta em logs. Sempre substitua por formatos mascarados ou hash ao armazenar em logs.

- Aplique regras estritas de retenção — Não mantenha arquivos extraídos além do necessário. Defina períodos alinhados às normas.

- Registre apenas artefatos de validação, não o conteúdo bruto — Salve o que falhou e por quê (ex: campos ausentes, datas inválidas) sem armazenar o documento sensível.

- Controle acesso a dados de staging — Permissões por perfil; só usuários autorizados podem ver ou alterar registros sensíveis em áreas de staging.

- Criptografe dados em trânsito e em repouso — Temporários ou definitivos, bancos, arquivos e logs devem ser criptografados para reduzir exposição.

Práticas de compliance devem correr em paralelo às técnicas — garantindo o time livre de multas regulatórias e protegendo a confiança do cliente.

Exemplo Prático (Amarrando Tudo Junto)

Para ilustrar o processo de modo mais concreto, veja um exemplo simples que une validação, normalização, reconciliação e teste em um único pipeline. Suponha que você usou a Parseur API para extrair dados de uma fatura, seja PDF ou e-mail. O Parseur entrega JSON estruturado direto do não estruturado, fornecendo ponto de partida confiável para a sua limpeza.

JSON extraído (input):

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

Passo 1: Valide o esquema com Pydantic:

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# Modelo para item de linha

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Modelo para fatura

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# Exemplo de string JSON bruto

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# Parse do JSON para modelo Invoice

invoice = Invoice.model_validate_json(raw_json)

# Normalizando itens de linha em um DataFrame do Pandas

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# Checagem dos totais

if round(df["amount"].sum(), 2) != invoice.total:

print("Inconsistência: total dos itens não confere com o total da fatura")

else:

print("Totais conferem ✅")

print(df)

Passo 3: Faça testes de qualidade dos dados com Great Expectations:

import great_expectations as gx

# Inicialize o contexto do Great Expectations

context = gx.get_context()

# Carregue o DataFrame Pandas como batch

batch = context.sources.pandas_default.read_dataframe(df)

# Pegue o validador para rodar as expectativas

validator = batch.get_validator()

# Defina as expectativas

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# Rode validação e capture resultados

results = validator.validate()

print(results)

Resultados (após limpeza):

- Dados da fatura são validados conforme o esquema.

- Datas e números com tipo correto.

- Totais conferidos com checagem de tolerância.

- Testes de qualidade confirmam faixas e estrutura.

Esse processo ponta a ponta mostra como equipes podem pegar outputs desordenados de API, validar desde o início e aplicar regras determinísticas antes de carregar no sistema de produção.

A limpeza de dados é apenas uma das partes para construir um pipeline confiável — tudo começa com dados precisos e estruturados dos seus documentos. É aí que o Parseur se destaca. Com uma plataforma intuitiva e a flexível Parseur API, extraia automaticamente dados de PDFs, e-mails, planilhas e anexos, cortando o trabalho manual que costuma atrasar as equipes. Uma vez capturados, aplique as técnicas deste guia para garantir que estejam corretos, consistentes e prontos para análise.

Olhando para frente, a Gartner projeta que até 2026, 70% das novas implantações em nuvem utilizarão ecossistemas de dados em nuvem coesos em vez de soluções pontuais integradas manualmente. Essa tendência reforça a necessidade crescente de dados limpos, estruturados e workflows de extração via API.

Para quem quer entender o quadro completo, reunimos um guia abrangente sobre como APIs transformam o processamento de documentos — inclusive como escolher a ferramenta certa e otimizar seus fluxos de trabalho. Explore o nosso guia completo sobre APIs de Extração de Dados para Documentos e veja como você pode avançar de vez dos arquivos crus para dados acionáveis e limpos.

Perguntas Frequentes

Antes de finalizar, confira algumas perguntas frequentes sobre limpeza de dados após extração por API. Estas respostas rápidas abordam armadilhas comuns e preocupações práticas que equipes geralmente enfrentam.

-

Devo descartar linhas com totais ausentes?

-

Eu prefiro quarentenar e investigar em vez de descartar de imediato. Totais são campos financeiros críticos e, ao removê-los silenciosamente, relatórios podem ser distorcidos. Mantê-los em um bucket de revisão garante transparência e resolução adequada.

-

Como posso garantir JSON válido antes da limpeza?

-

Valide com JSON Schema ou Pydantic para garantir que os dados recebidos sejam legíveis por máquina e correspondam aos campos esperados. Detectar JSON malformado no início evita desperdício de tempo com correções posteriores.

-

Consigo testar a qualidade sem um warehouse?

-

Sim. Ferramentas como Great Expectations ou Pandera permitem impor regras diretamente em pipelines Python ou workflows CI/CD. Isso mantém a qualidade mesmo antes dos dados chegarem ao seu warehouse.

-

E se as tabelas não fecham com o total da fatura?

-

Defina uma regra de reconciliação para comparar as somas dos itens com o total da fatura dentro de uma margem de tolerância. Qualquer divergência deve ser sinalizada e enviada para revisão, não sobrescrita.

-

Testes DBT são necessários se já testo antes?

-

Sim. Testes DBT fornecem uma camada extra de segurança ao codificar restrições na camada de modelo. Mesmo com checagens upstream, essa abordagem “defense-in-depth” impede que dados insuficientes cheguem à análise de produção.

-

Como resolver problemas de codificação em exportação CSV?

-

Sempre defina delimitador, codificação e caracteres de citação explicitamente durante o parsing. DuckDB e ferramentas similares ajudam a diagnosticar arquivos difíceis e garantem consistência ao normalizar dados de múltiplas fontes.

Última atualização em