Punti Chiave

- L’estrazione dei dati può generare output disordinati che richiedono validazione e post processing, se la pipeline non è adeguatamente progettata.

- Una pipeline affidabile deve includere: validazione dello schema, normalizzazione, pulizia testuale, correzione delle tabelle, deduplicazione e controlli di qualità continui.

- Strumenti come JSON Schema, Pydantic, Pandas e Great Expectations rendono il post-processing più robusto e automatizzato.

- Parseur API facilita l’acquisizione e la strutturazione rapida dei dati, così i team possono concentrarsi su qualità e analisi.

Le tecniche di data cleaning rappresentano le procedure per correggere, standardizzare e validare i dati grezzi ottenuti da API di estrazione. Anche se gli strumenti convertono PDF, immagini o email non strutturati in formati come JSON o CSV, spesso l’output contiene ancora errori: incoerenze, valori nulli, tipi sbagliati, duplicati o difformità di formattazione. Il cleaning garantisce che il dataset rispetti lo schema desiderato e sia affidabile per reportistica, analisi e automazione dei workflow.

Un recente caso di studio di DataXcel ha mostrato che il 14,45% dei record telefonici estratti erano non validi o inattivi, sottolineando quanto sia fondamentale adottare solide pratiche di data cleaning per mitigare questi errori e assicurare la qualità dei dati estratti.

Le API che estraggono dati da PDF, immagini o email restituiscono solitamente formati strutturati come JSON o CSV. Ciò rende i dati grezzi più utilizzabili, ma di rado senza errori: valori mancanti, intestazioni errate, tipi dati misti, duplicati o date non uniformi sono frequenti. Se non corrette, queste anomalie possono compromettere report, analisi e decisioni.

Questa guida propone un playbook pratico per trasformare extract disordinati in dataset affidabili: validare, standardizzare, arricchire, testare e tracciare. Per chi gestisce allegati email e PDF, strumenti come Parseur velocizzano la raccolta, lasciando più tempo alla qualità dei dati.

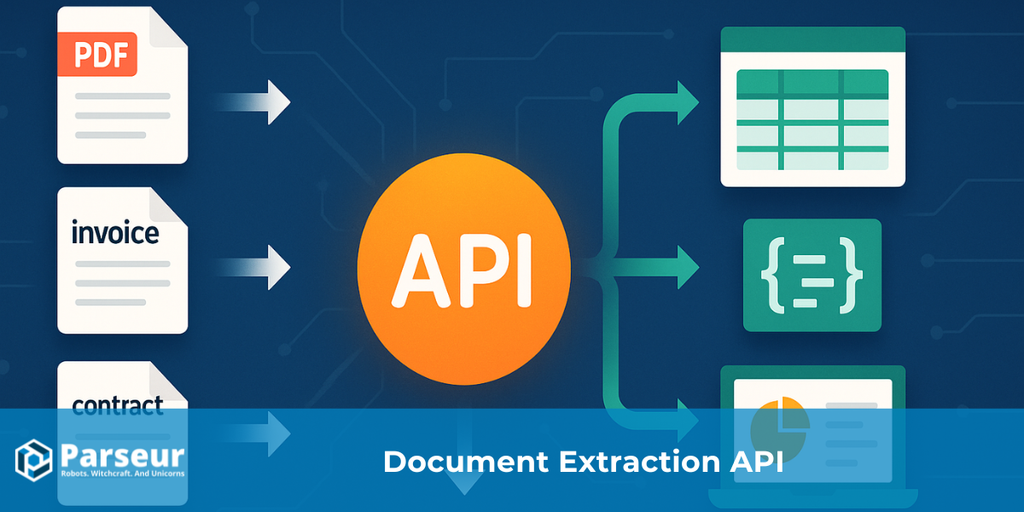

Se vuoi approfondire come funzionano davvero, dall’inizio alla fine, le API di estrazione dati, consulta la nostra guida completa: Cos’è una API di Estrazione Dati da Documenti?

Tipi di Tecniche di Data Cleaning

Dopo l’estrazione dei dati tramite API, i risultati grezzi possono presentare incoerenze, valori mancanti, errori di formattazione o duplicati. Sebbene le API convertano file non strutturati come PDF, immagini o email in strutture JSON o CSV, la validazione e la pulizia restano essenziali per l’attendibilità.

Secondo uno studio di Harvard Business Review, solo il 3% dei dati aziendali soddisfa i requisiti minimi di qualità e il 47% dei nuovi record contiene almeno un errore critico. Le conseguenze sono concrete: Gartner stima che problemi di qualità costano alla media delle aziende 15 milioni di dollari l’anno.

Adottare buone tecniche di data cleaning è fondamentale per assicurare dati precisi, coerenti e pronti all’uso decisionale. Le principali tecniche includono:

Validazione e Controllo degli Errori

Verifica che i dati estratti rispettino i formati richiesti (date, numeri, email) prevenendo errori nei report e garantendo precisione all’output della tua API di estrazione.

Standardizzazione

Porta dati come numeri di telefono, indirizzi o date in formati uniformi per facilitare l’integrazione e rendere i dataset interoperabili.

Gestione dei Valori Mancanti

A seconda delle esigenze, tratta i valori nulli tramite riempimento, interpolazione o rimozione dei record incompleti.

Deduplicazione

Elimina i duplicati causati da chiamate API ripetute o fonti sovrapposte, migliorando accuratezza e affidabilità.

Arricchimento Dati

Aggiungi contesto ai dati estratti, come dettagli geografici o categorie, per aumentare la loro utilità.

Correzione di Formato e Tipo

Rendi i dati coerenti correggendo valori mal formattati, convertendo stringhe in numeri, gestendo errori di digitazione o uniformando le valute.

Logging e Audit

Traccia tutte le operazioni di cleaning per monitorare la qualità delle estrazioni API e garantire integrità permanente.

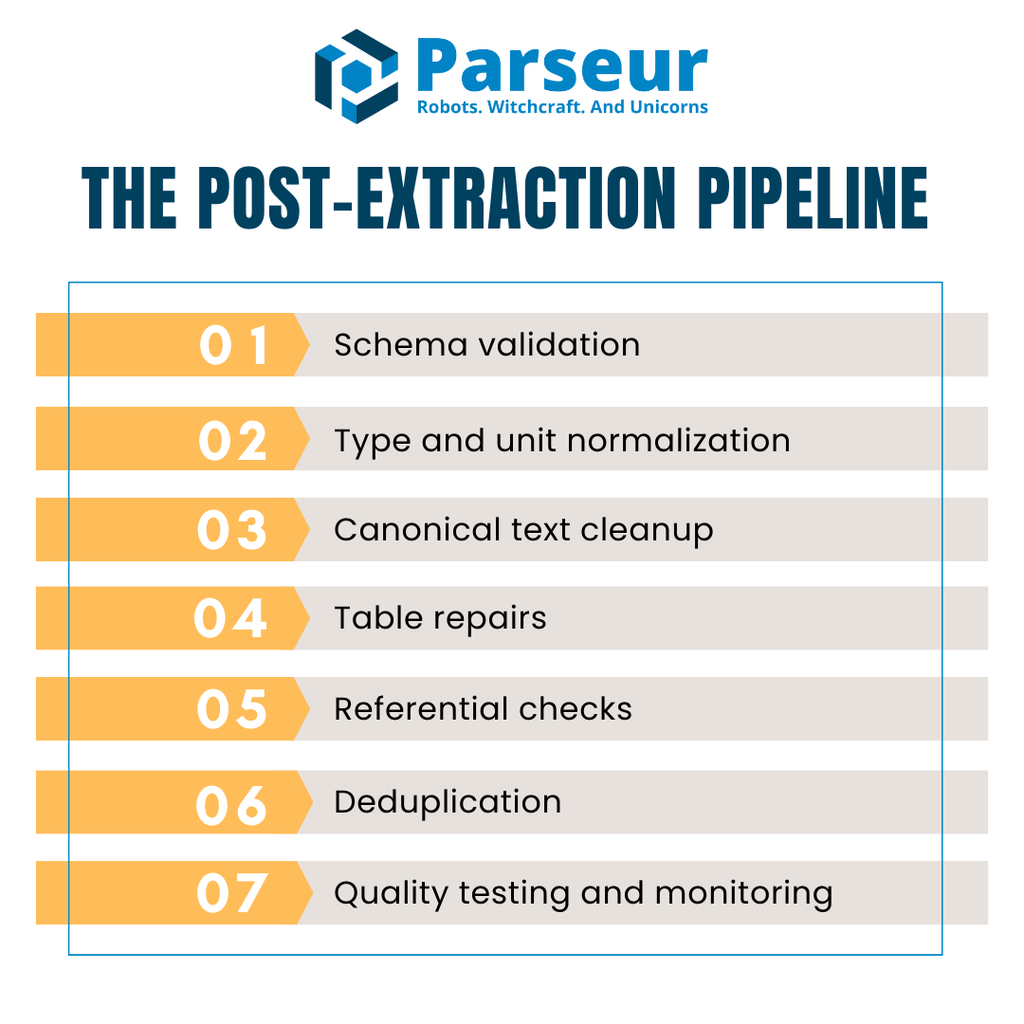

La Pipeline Post-Estrattiva (Panoramica)

Dopo l’estrazione API, i dati raramente sono subito adatti ad analisi o reporting. Gli output grezzi mostrano spesso campi mancanti, tipi errati, tabelle sbagliate o duplicati. Serve una pipeline strutturata, ripetibile e automatica per ogni batch.

Una pipeline post-estrattiva funzionale segue in genere queste fasi principali:

- Validazione dello schema – Conferma che JSON o CSV rispetti la struttura attesa.

- Normalizzazione di tipi e unità – Allinea tipi dati, gestisce i nulli e uniforma formati o unità.

- Pulizia testuale canonica – Uniforma stringhe, regola maiuscole/minuscole e corregge le inconsistenze Unicode.

- Riparazione delle tabelle – Allinea intestazioni, ricostruisce righe di dettaglio e riconcilia i totali.

- Controlli referenziali – Verifica la coerenza tra dataset (es. fornitori, valute, regole fiscali).

- Deduplicazione – Individua e rimuove i record duplicati, preservando le ripetizioni lecite.

- Test e monitoraggio di qualità – Esegui controlli automatici per evitare che gli errori si propaghino in produzione.

Per prestazioni, molti team lavorano su rappresentazioni colonnari come Apache Arrow o Parquet, che ottimizzano memoria e velocità per grandi volumi di dati di fatture o transazioni.

La pipeline è come una swimlane: API → Validazione → Cleaning → QA → Warehouse. Questo garantisce coerenza, contenimento dei costi e assenza di sorprese sulla qualità dei dati.

Step 1: Validazione Contro Uno Schema (Blocca la Spazzatura Subito)

Il primo passo nelle tecniche di data cleaning post-API è la validazione dello schema. Serve ad assicurarsi che i dati siano leggibili dalla macchina e aderenti alla struttura attesa. Saltare questo controllo permette a dati malformati di entrare, causando guai futuri.

Uno dei più diffusi standard per questo compito è JSON Schema (Draft 2020-12). È portabile, indipendente dagli strumenti e con un ampio ecosistema di librerie. JSON Schema ti permette di definire cosa può considerarsi un dato valido: tipo di campo, obbligatorietà e regole di formato. Ad esempio, puoi richiedere che invoiceDate sia in formato ISO 8601 o che total sia sempre un numero non negativo.

In Python, Pydantic v2 permette di validare dati a runtime generando automaticamente lo schema JSON. Creare modelli per fatture o righe consente agli sviluppatori di imporre la struttura e bloccare dati non validi istantaneamente. Un modello semplice, per esempio, può verificare che vendorName sia una stringa, invoiceNumber rispetti un pattern regex e currency appartenga a un insieme predefinito (USD, EUR, GBP).

Le regole di validazione dovrebbero andare oltre la semplice tipizzazione: aggiungi vincoli come enumerazioni per i valori accettati, regex per formati specifici (es. ID fiscali) e intervalli numerici per totali o quantità. Queste barriere prevengono che errori sottili si propaghino.

Prevedi sempre come gestire i record invalidi. Alcuni team preferiscono rifiutarli immediatamente, altri li inseriscono in una dead-letter queue per una revisione successiva. Questo approccio fail-fast garantisce che solo dati affidabili entrino nel resto della pipeline di cleaning.

Step 2: Correggi Tipi, Nulli e Unità

Dopo la validazione dello schema, si passa a sistemare i tipi dei dati, gestire i mancanti e normalizzare le unità. Anche dopo la conversione API in JSON o CSV, capitano spesso numeri come stringhe, date in mille formati e nulli inconsistenti. Senza questa pulizia, report e analisi saranno meno affidabili.

Con la Parseur API, puoi estrarre dati da fatture, scontrini ed email già in JSON con pochissima configurazione. Grazie ai webhooks in tempo reale, i dati arrivano pronti a ERPs, CRMs o database, riducendo la necessità di cleaning manuale a monte e prevenendo errori.

Il primo passo è coercizzare tutti i valori al tipo corretto. Converti campi come quantity o unitPrice in tipi numerici e trasforma le date come invoiceDate e dueDate nei formati ISO standard. Anche i booleani come paid o approved vanno normalizzati a true o false.

Poi decidi come gestire i valori mancanti. Esistono tre strategie principali:

- Drop: elimina i record incompleti se non sono critici.

- Fill: sostituisci i mancanti con valori di default, medie o placeholder.

- Flag: marca i campi nulli da revisionare invece di cambiarli in modo silente.

Ogni regola adottata va documentata per campo, per mantenere coerenza tra tutti i batch.

Con Pandas la pulizia è agevole: funzioni come to_numeric(errors="coerce"), to_datetime(), fillna() e dropna() aiutano a standardizzare i dati. Ogni colonna avrà così il formato atteso e i nulli saranno trattati in modo deterministico.

Pulire tipi, nulli e unità fin da subito significa costruire le fondamenta solide per i passaggi seguenti: normalizzazione del testo, correzione tabelle e controlli referenziali.

Step 3: Canonicalizzazione del Testo (Nomi, Maiuscole, Unicode)

Una volta sistemati numeri e date, è il turno dei dati testuali, spesso inconsistenti tra maiuscole, spazi o encoding. Lo stesso fornitore può avere nomi diversi, frammentando le analisi se non si interviene.

Primo passo: pulisci spazi e punteggiatura. Elimina spazi multipli, sistemali o rimuovi caratteri errati. Poi uniforma le maiuscole: nomi aziendali in title case, status tutti maiuscoli per confronti rapidi.

La normalizzazione Unicode è altrettanto importante. Encoding diversi possono far sì che due stringhe visivamente identiche vengano considerate differenti. Portare tutto alla forma NFKC garantisce che accenti, simboli e punteggiatura siano trattati in modo uniforme. Nei dataset globali, puoi anche rimuovere gli accenti durante i confronti dei nomi vendor, così da evitare doppioni tipo “Café” e “Cafe”.

Infine, crea una lista di canonicalizzazione dei campi più importanti (es. fornitori). Parti da regole leggere (incorporare abbreviazioni) fino a modelli ML per risolvere entità ambigue.

Testo canonicalizzato = dati confrontabili tra fonti diverse e meno rischio di frammentazione o duplicati a valle.

Step 4: Ripara le Tabelle (Linee che Tornano)

Le tabelle di dettaglio articolo estratte tramite API richiedono spesso la maggior parte della riparazione. Le intestazioni possono essere divise su più righe, celle ruotate dai PDF scansionati, o valori uniti in modi che rendono difficile l’analisi. La pulizia inizia assicurando che ogni tabella abbia una singola riga header coerente con lo schema.

Quando la struttura è a posto, normalizza le unità di misura affinché i calcoli restino consistenti tra tutte le fatture. Per esempio, converti kg e lbs nella stessa unità, oppure riconcilia le valute prima dei confronti sui totali. Ricalcolare ogni “amount” = “quantity” × “unitPrice” è un controllo critico per l’integrità. A maggior tutela, verifica sempre che la somma delle linee torni con il totale della fattura entro una piccola tolleranza, così intercetti in tempo errori come righe perse o duplicazioni.

Exportare le tabelle in CSV aggiunge un ulteriore livello di complessità. Delimitatori nascosti, caratteri di quote errati o encoding sbagliati possono rompere le colonne. Un pattern sicuro è caricare i file con strumenti flessibili come DuckDB, dove si possono settare delimitatori, quote e encoding. Con all_varchar carichi tutto in modo sicuro, poi casti i tipi corretti dopo.

Questi passaggi trasformano tabelle estratte disordinate in righe strutturate e affidabili su cui analytics e finance possano lavorare. L’obiettivo non è solo far quadrare i conti, ma evitare che errori silenziosi finiscano nei report.

Step 5: Regole Referenziali e di Business

Anomalie emergono spesso nei dati confrontati tra tabelle distinte, anche se il record isolato sembra valido. I controlli referenziali assicurano che i valori siano coerenti e che le regole di business siano rispettate prima che i dati arrivino nel data warehouse.

Ad esempio, ogni vendorId nella tabella fatture dovrebbe esistere anche nella tabella fornitori master. I codici valuta devono appartenere solo a quelli abilitati per le operazioni aziendali, e le aliquote fiscali vanno verificate in base alla giurisdizione. Individuare subito queste violazioni evita errori successivi come join falliti, report scorretti o violazioni di compliance.

Nei workflow moderni, queste regole sono codificate nei layer di trasformazione. I test DBT tests si usano per:

- unique: nessun duplicato di invoiceNumber,

- not_null: campi chiave come vendorId sempre valorizzati,

- accepted_values: currency tra USD, EUR, ecc.,

- relationships: vendorId sempre presente in vendors.

Codificare l’integrità referenziale nei test automatici offre una difesa a più livelli: i problemi emergono subito, non settimane dopo nelle revisioni finanziarie. Questo trasforma controlli manuali in processi scalabili, automatizzando affidabilità e compliance.

Step 6: Deduplicazione e Record Linkage

Duplicati nei dati sono insidiosi: generano totali gonfiati, errori nei pagamenti, confusione negli audit. Serve una strategia che distingua tra doppioni reali e ripetizioni lecite.

Si parte da chiavi deterministiche: una fattura è quasi sempre duplicata se condivide supplierName, invoiceNumber, invoiceDate, amount e currency. Se due righe condividono tutti questi valori, sono quasi certamente duplicati.

I duplicati possono annidarsi anche in record quasi identici, ma non uguali. Una finestra di matching fuzzy aiuta: ad esempio, fatture dallo stesso fornitore entro 7 giorni e l’1% dello stesso importo vengono messe in revisione. Questo approccio a bucket evita rimozioni errate ma intercetta casi sospetti.

Fondamentale è distinguere tra matching sintattico (confronto stringa puro) e matching semantico (es. “Acme Corp.” e “ACME Corporation” sono lo stesso soggetto). Strumenti come OpenRefine consentono il clustering per suggerire duplicati da verificare.

Unendo regole deterministiche a controlli fuzzy o semantici ottieni un cleaning equilibrato che massimizza la precisione senza rischiare la cancellazione di record leciti.

Step 7: Automatizza i Controlli di Qualità Dati

La qualità dati deve essere un processo continuo. Anche la pipeline meglio progettata può essere contaminata da nuove estrazioni. Automatizzare le verifiche fa emergere subito i problemi, evitando che influenzino report o decisioni.

Una soluzione affidabile è Great Expectations (GX). GX permette di dichiarare regole (Expectations) su ogni dataset: puoi verificare che i numeri fattura rispettino regex, le quantità siano nei range o il conteggio delle righe nei limiti attesi. Integrando i test nel CI/CD hai feedback immediato se l’estrazione degrada.

Se lavori in Python, Pandera permette di impostare tipi, range e nullabilità direttamente sui dataframe Pandas. Con poche righe di codice puoi rifiutare righe non valide o generare alert quando i dati si discostano dagli standard attesi.

L’automazione funziona solo se visibile: esporta gli esiti dei test su dashboard o alert per stakeholder, così vedono la percentuale di righe errate, i pass/fail e i dettagli di errore. Il ciclo si chiude e le priorità sono subito chiare.

Rendere la qualità dati misurabile e continua è ciò che permette alle aziende di mantenere dataset puliti, consistenti e pronti per la produzione.

Performance e Storage (Perché il Data Cleaning Non Sia un Collo di Bottiglia)

La pulizia dati dopo l’estrazione è fondamentale, ma non deve bloccare le pipeline. Su ingenti batch di fatture, scontrini o log di transazioni, una pipeline poco scalabile causa latenza, costi e insoddisfazione a valle. L’obiettivo è garantire qualità senza sacrificare la velocità.

Studi di MDPI hanno mostrato che il data cleaning può occupare fino all’80% del tempo di un professionista dati, influendo moltissimo sull’efficienza complessiva della pipeline. Questo sottolinea quanto sia essenziale ottimizzare il cleaning dati per mantenere alte prestazioni.

Ecco alcuni accorgimenti pratici per ottimizzare performance e scalabilità:

- Storage colonnare — formati come Apache Arrow e Parquet consentono operazioni vettoriali e riducono l'uso di memoria. Si integrano bene con i motori analytics e le librerie Python.

- Batch e parallelizzazione — elabora a batch o tramite task asincroni; processi multipli parallelizzano più file e riducono le attese.

- Sfrutta warehouse e tool analitici — parsing pesanti delegati a DuckDB o direttamente al warehouse alleggeriscono la pipeline locale e velocizzano le trasformazioni.

- Cache intermedia — se certi check o normalizzazioni vanno ripetuti, la cache evita di rieseguire le stesse operazioni più volte.

- Monitoraggio risorse — osserva CPU, RAM e IO per anticipare i colli di bottiglia e rispettare livelli di servizio attesi.

Pipeline di cleaning efficienti bilanciano accuratezza e scalabilità. L’adozione di formati colonnari, il batch processing e un uso intelligente delle risorse mantengono la validazione e il cleaning abbastanza veloci da supportare analytics e reportistica real-time.

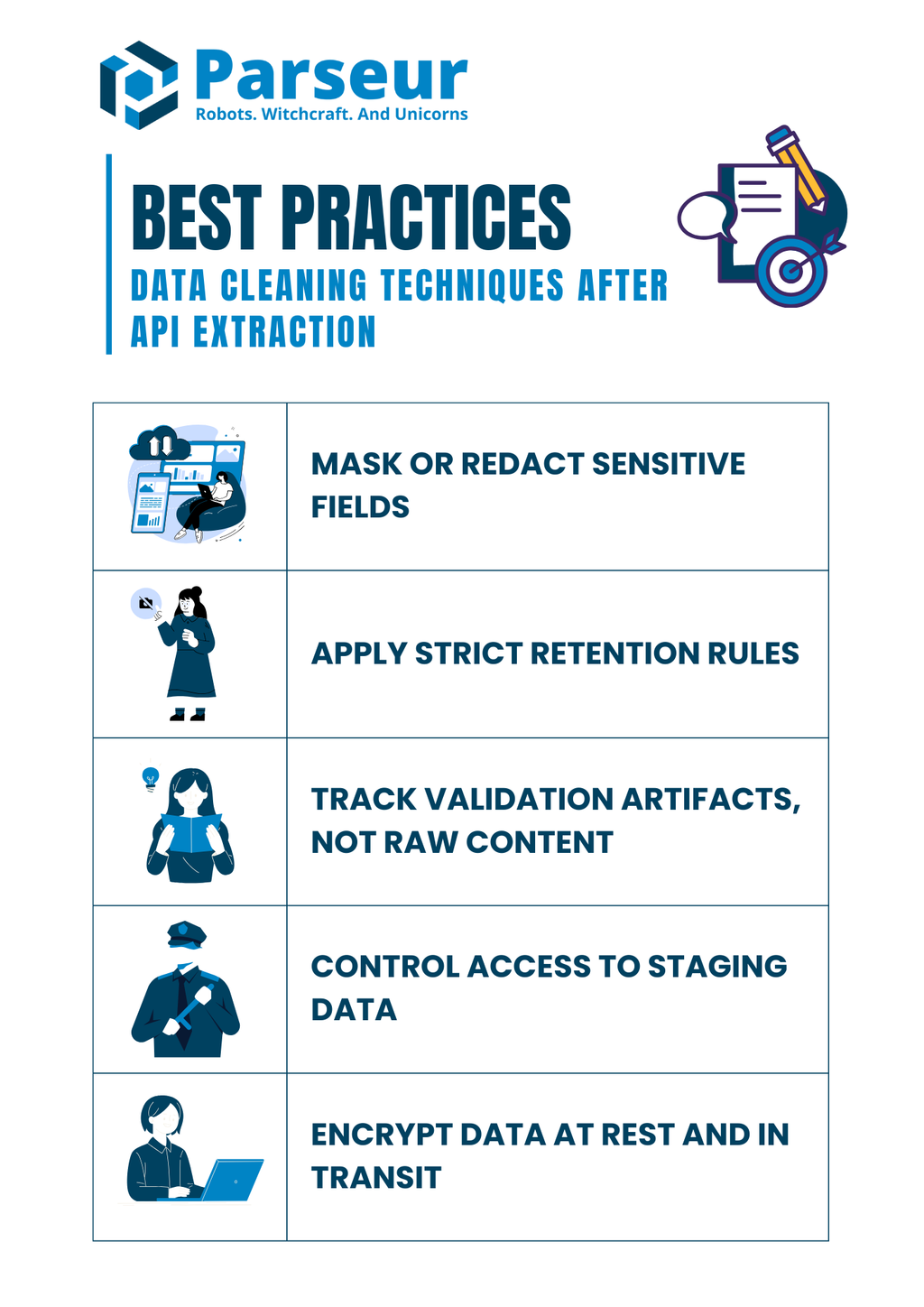

Sicurezza e Compliance (Non Cancellare i Controlli Durante il Cleaning)

La pulizia dati non è solo tecnica, ma anche un tema di compliance. Molti documenti estratti sono sensibili: dati bancari, fiscalità, persone. Una gestione superficiale nel post-processing apre falle di rischio.

Secondo una ricerca di Mitratech, il 61% delle aziende sperimenta violazioni, inefficienze e problemi di compliance dovuti a scarsa governance dei dati. Questo sottolinea quanto pratiche solide di data cleaning siano cruciali sia per la qualità che per la conformità normativa.

Ecco le best practice per tenere la compliance in ogni fase:

- Maschera/redigi i campi sensibili — niente dati raw (CF, carte, conti) nei log—usa hash o versioni mascherate.

- Retention rigorosa — non mantenere i file raw più a lungo del necessario; imposta un ciclo di retention conforme alle regole.

- Traccia solo gli esiti delle validazioni — logga solo i motivi degli scarti, mai il documento completo e sensibile.

- Controllo accessi — solo chi autorizzato può vedere o modificare dati riservati in area staging.

- Cripta sempre, sia at rest che in transit — staging, file temporanei e log devono essere criptati.

Le buone regole di compliance devono camminare insieme alle soluzioni tecniche: controlli in pipeline proteggono dai rischi normativi e rafforzano la fiducia dei clienti.

Esempio Pratico (Integrare Tutto Insieme)

Vediamo ora un esempio pratico che combina validazione, normalizzazione, riconciliazione e testing in una pipeline end-to-end. Supponiamo che Parseur API abbia estratto una fattura da un PDF o email, restituendoci un JSON strutturato.

Esempio di JSON estratto (input):

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

Step 1: Validazione dello schema con Pydantic:

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# Definizione modello riga

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Definizione modello fattura

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# Esempio di stringa JSON raw

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# Parsing JSON in modello Invoice

invoice = Invoice.model_validate_json(raw_json)

# Normalizzazione righe in DataFrame Pandas

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# Controllo dei totali

if round(df["amount"].sum(), 2) != invoice.total:

print("Non corrisponde: la somma delle linee non torna con il totale fattura")

else:

print("Totali corrispondenti ✅")

print(df)

Step 3: Test di qualità con Great Expectations:

import great_expectations as gx

# Inizializzazione del contesto Great Expectations

context = gx.get_context()

# Caricamento DataFrame Pandas in un batch

batch = context.sources.pandas_default.read_dataframe(df)

# Ottieni un validator per le expectations

validator = batch.get_validator()

# Definisci le expectations

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# Esecuzione validazione e print risultati

results = validator.validate()

print(results)

Output (pulito):

- Dati fattura validati su schema.

- Date e numeri coerenti e tipizzati.

- Totali riconciliati e verificati con controllo di tolleranza.

- Test di qualità superati su range e struttura.

Questo processo end-to-end dimostra come partire da output API disordinati, validarli a monte e applicare cleaning deterministico prima di caricarli nei sistemi produttivi.

Il data cleaning è solo una parte della pipeline: il primo passo resta ottenere dati strutturati e affidabili dai documenti. Qui interviene Parseur. Grazie a una piattaforma intuitiva e flessibile come Parseur API, puoi estrarre automaticamente dati da PDF, email, fogli elettronici e allegati, abbattendo il carico manuale che appesantisce i team. Una volta estratti, puoi applicare tutte le tecniche illustrate per ottimizzare precisione, coerenza e prontezza all’analisi.

Guardando al futuro, Gartner prevede che entro il 2026 il 70% delle nuove implementazioni cloud utilizzerà ecosistemi dati cloud coesi invece di soluzioni puntuali integrate manualmente. Questo trend rafforza l’urgenza di avere dati puliti e strutturati e workflow estrattivi basati su API.

Per i team che vogliono una visione completa, abbiamo preparato una risorsa approfondita su come le API stanno rivoluzionando il document processing, incluso come scegliere lo strumento giusto e ottimizzare i tuoi workflow. Consulta la nostra guida definitiva alle API di Estrazione Dati da Documenti e scopri come trasformare file raw in dati affidabili, strutturati e pronti per ogni analisi.

Domande Frequenti

Prima di concludere, ecco alcune domande frequenti sulla pulizia dei dati dopo l’estrazione via API. Queste risposte rapide affrontano errori comuni e questioni pratiche con cui spesso si scontrano i team.

-

Devo eliminare le righe con totali mancanti?

-

Preferisco mettere in quarantena e indagare queste righe piuttosto che eliminarle subito. I totali sono campi finanziari critici, e rimuoverli senza controllo può falsare i report. Tenerli in un bucket di revisione garantisce trasparenza e risoluzione adeguata.

-

Come faccio a garantire JSON valido prima del cleaning?

-

Valida con JSON Schema o Pydantic per assicurarti che i dati in ingresso siano leggibili dalla macchina e corrispondano ai campi attesi. Intercettare JSON malformato precocemente evita sprechi di tempo nella correzione a valle.

-

Posso testare la qualità senza un data warehouse?

-

Sì. Strumenti come Great Expectations o Pandera permettono di imporre regole direttamente nelle pipeline Python o nei flussi di lavoro CI/CD. Questo permette di mantenere la qualità anche prima che i dati arrivino nel data warehouse.

-

Cosa fare se le tabelle non corrispondono al totale della fattura?

-

Imposta una regola di riconciliazione che confronta la somma degli articoli con il totale della fattura, entro un intervallo di tolleranza. Ogni discrepanza deve essere segnalata e revisionata, non sovrascritta.

-

I test DBT sono necessari se testo già a monte?

-

Sì. I test DBT forniscono un’ulteriore rete di sicurezza codificando i vincoli a livello di modello. Anche se esistono controlli a monte, questo approccio defense-in-depth previene che dati insufficienti entrino in produzione.

-

Come gestisco problemi di encoding da esportazioni CSV?

-

Definisci sempre esplicitamente delimitatore, encoding e caratteri di quote durante il parsing. DuckDB e strumenti simili aiutano a diagnosticare file complessi e garantire coerenza nella normalizzazione dei dati provenienti da più fonti.

Ultimo aggiornamento il