Puntos Clave

- La extracción de datos puede producir resultados desordenados que requieren validación y procesamiento posterior si no están cuidadosamente diseñados.

- Un pipeline confiable debe incluir validación de esquemas, normalización, limpieza de texto, corrección de tablas, deduplicación y controles continuos de QA.

- Herramientas como JSON Schema, Pydantic, Pandas y Great Expectations automatizan y robustecen el post-procesamiento.

- Parseur API ayuda a capturar y estructurar datos rápidamente, permitiendo a los equipos enfocarse en calidad y analítica.

Las técnicas de limpieza de datos abarcan la corrección, estandarización y validación de los datos brutos que entregan las APIs. Aunque las herramientas de extracción convierten archivos no estructurados como PDFs, imágenes o emails en formatos estructurados como JSON o CSV, los resultados suelen presentar inconsistencias, valores nulos, tipos incorrectos, duplicados o errores de formato. Una limpieza adecuada asegura que el conjunto resultante cumpla el esquema propuesto y sea confiable para reportes, análisis y procesos posteriores.

Un caso reciente documentado por DataXcel demostró que el 14,45% de los registros telefónicos extraídos eran inválidos o inactivos, evidenciando la importancia de implementar prácticas sólidas de limpieza para mitigar estos errores y asegurar la calidad de los datos extraídos.

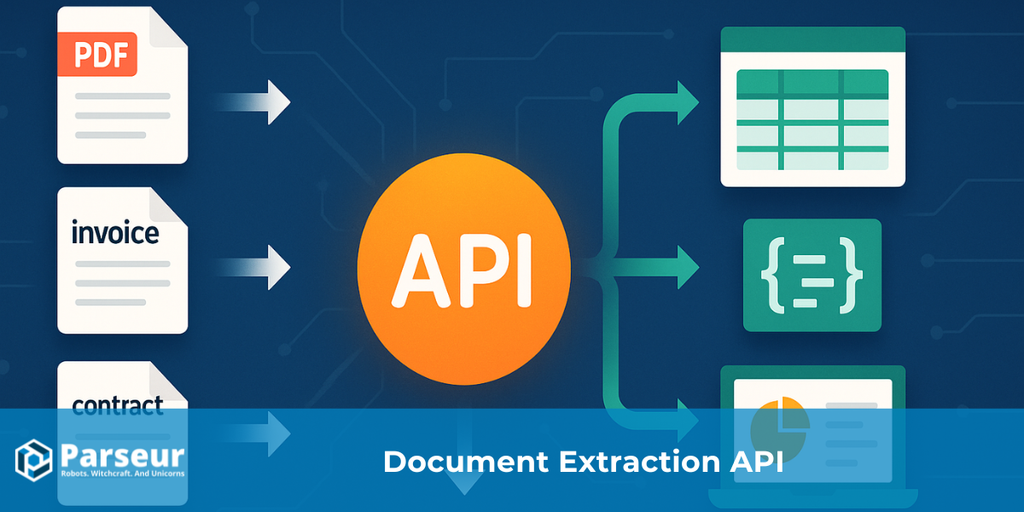

Las APIs que extraen datos desde PDFs, imágenes o emails generalmente devuelven formatos estructurados tipo JSON o CSV. Esto hace la información más utilizable, pero rara vez el resultado es perfecto. Los equipos suelen enfrentarse a valores faltantes, encabezados inconsistentes, tipos de datos mezclados, duplicados o fechas mal formateadas. No limpiar estos errores puede comprometer informes, análisis y decisiones financieras.

Esta guía ofrece un playbook práctico para transformar extracciones desordenadas en conjuntos de datos fiables: valida, estandariza, enriquece, verifica y registra. Si gestionas adjuntos de email y PDF, herramientas como Parseur facilitan la captura para que puedas centrarte en limpieza y calidad.

¿Quieres descubrir en profundidad cómo funcionan las APIs de extracción de datos de principio a fin? Explora nuestra guía completa: ¿Qué es una API de extracción de datos para documentos?

Tipos de Técnicas de Limpieza de Datos

Una vez extraídos los datos mediante una API especializada, los resultados crudos frecuentemente presentan inconsistencias, valores faltantes, errores de formato o duplicados. Incluso cuando las APIs transforman archivos no estructurados como PDFs, imágenes o emails en JSON o CSV, los datos aún requieren un proceso minucioso de limpieza para ser plenamente fiables.

Según un estudio de la Harvard Business Review, solo el 3% de los datos empresariales cumplen los estándares mínimos de calidad, y el 47% de los datos recién creados tienen, al menos, un error crítico. Estos fallos se traducen en impactos reales: Gartner calcula que los problemas de calidad de datos cuestan a la empresa promedio 15 millones de dólares anuales.

Aplicar técnicas eficaces de limpieza es esencial para asegurar que tus datos sean fiables, consistentes y aptos para el análisis. Aquí algunas de las más utilizadas:

Validación y Verificación de Errores

Revisa que los datos extraídos encajen con los formatos requeridos—fechas, números, correos—para evitar errores en reportes y garantizar la precisión de los resultados obtenidos con la API.

Estandarización

Asegúrate de convertir los datos a esquemas uniformes; por ejemplo, normalizando números telefónicos, direcciones o fechas. Esto facilita la integración y uso posterior de los datos.

Gestión de Valores Faltantes

Dependiendo del objetivo del conjunto de datos, gestiona valores nulos rellenando, interpolando o eliminando registros incompletos.

Deduplicación

Elimina registros repetidos que puedan surgir de llamadas repetidas a la API o fuentes redundantes, mejorando calidad y precisión.

Enriquecimiento de Datos

Agrega contexto o información adicional (detalles geográficos, categorías, etc.) para aumentar la utilidad de los datos extraídos.

Corrección de Formato y Tipo

Consigue homogeneidad: convierte cadenas a números, corrige fechas, normaliza monedas y repara errores ortográficos.

Registro y Auditoría

Registra todas las operaciones realizadas durante la limpieza para garantizar trazabilidad y control de calidad a lo largo del tiempo en tus extracciones.

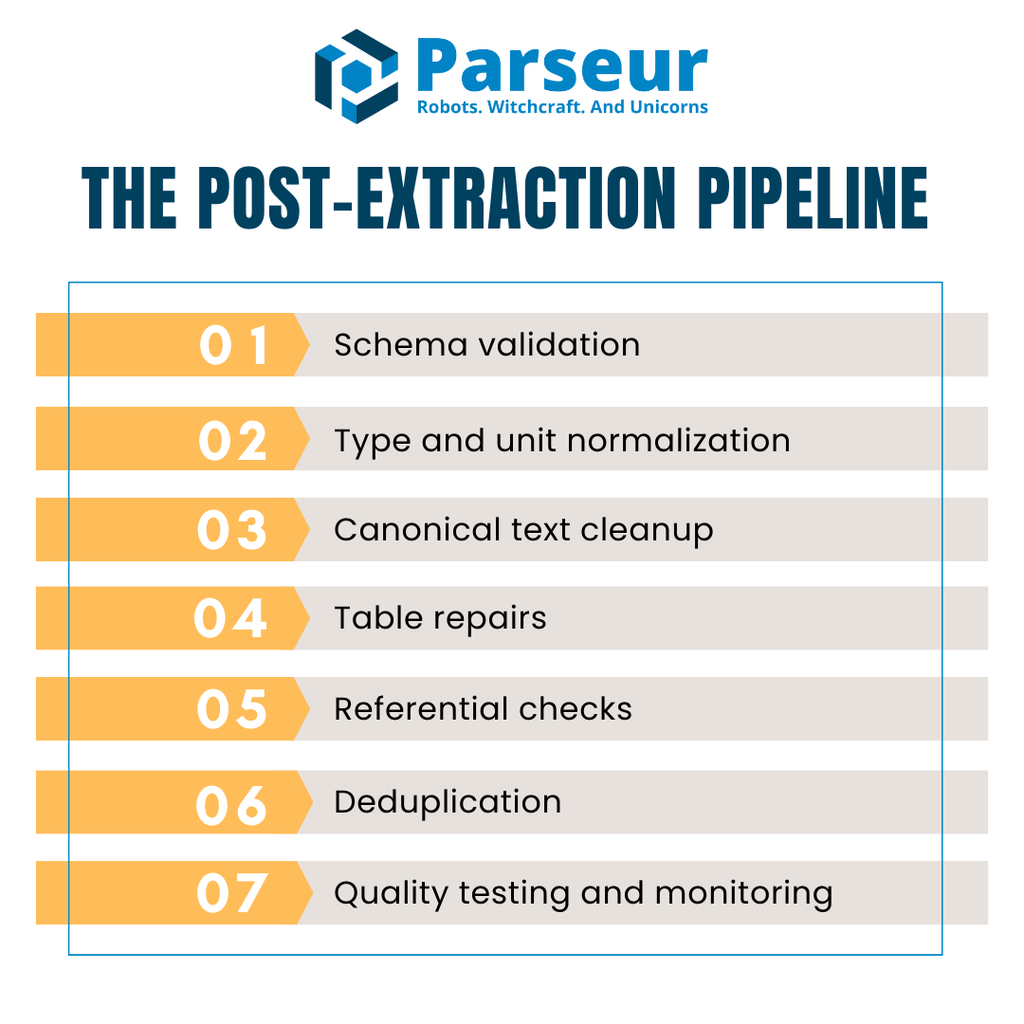

El Pipeline Posterior a la Extracción (Resumen)

Una vez que obtienes los datos de una API, es raro que estén listos para análisis o reportes de inmediato. Los resultados suelen traer campos faltantes, tipos inconsistentes, tablas desordenadas o duplicados. Para evitar que estos errores lleguen aguas abajo, es necesario implantar un pipeline estructurado, repetible para cada lote de datos.

Un pipeline post-extracción efectivo suele tener estas etapas principales:

- Validación de esquema — Confirma que el JSON o CSV se ajusta a la estructura esperada antes de avanzar.

- Normalización de tipos y unidades — Ajusta tipos de datos, gestiona faltantes y estandariza formatos o unidades.

- Limpieza canónica de texto — Estandariza strings, gestiona mayúsculas/minúsculas y normaliza codificación.

- Reparación de tablas — Uniformiza encabezados, alinea ítems y revisa totales para documentos multilínea.

- Comprobaciones referenciales — Valida relaciones entre entidades clave como proveedores, monedas o reglas fiscales.

- Deduplicación — Elimina duplicados sin borrar repeticiones legítimas.

- Pruebas y monitoreo de calidad — Lanza verificaciones automáticas para identificar errores antes de que pasen al entorno productivo.

Para mayor eficiencia, muchos equipos usan formatos columnar como Apache Arrow o Parquet durante la limpieza, acelerando tiempos y reduciendo uso de memoria, clave al manejar grandes volúmenes de facturas o transacciones.

Visualiza el flujo como un relevo: API → Validación → Limpieza → QA → Almacén de datos, garantizando consistencia, reducción de costes y menor riesgo de sorpresas de calidad.

Paso 1: Validar Contra un Esquema (Evita la Basura desde el Inicio)

El primer paso para limpiar datos extraídos por API es validar el esquema. Así te aseguras de que la información recibida es legible por máquina y respeta la estructura esperada. Sin esta comprobación, los datos mal formateados pueden infiltrar el pipeline y provocar fallos en procesos posteriores.

Uno de los estándares más usados para esta tarea es **JSON Schema (Draft 2020-12)**. Es portable, independiente de la herramienta utilizada y cuenta con un gran ecosistema de librerías. JSON Schema te permite definir cómo deben ser los datos válidos: tipos de campos, atributos requeridos y reglas de formato. Por ejemplo, puedes requerir que invoiceDate siga el formato ISO 8601 o que total sea siempre un número no negativo.

En proyectos Python, Pydantic v2 valida estructuras en tiempo real y genera automáticamente definiciones de JSON Schema. Crear modelos concretos para facturas o ítems obliga a cumplir la estructura y detecta datos no válidos al instante. Por ejemplo, puedes comprobar que vendorName sea string, invoiceNumber cumpla un patrón regex y currency esté dentro de un set específico (USD, EUR, GBP).

Las reglas de validación deben ir más allá del tipo. Añade restricciones como enumeraciones de valores permitidos, reglas regex para formatos como identificadores fiscales y rangos numéricos para totales o cantidades. Estos controles frenan errores sutiles antes de que avancen.

Por último, planifica cómo tratar registros inválidos. Algunos equipos prefieren rechazarlos de inmediato, otros los ponen en dead-letter queue para revisión posterior. Este enfoque fail-fast garantiza que solo datos confiables sigan en el proceso de limpieza.

Paso 2: Corrige Tipos, Nulos y Unidades

Superada la validación de esquema, el siguiente objetivo es corregir tipos, manejar valores faltantes y normalizar unidades. Aunque una API produzca JSON o CSV estructurado, los datos suelen venir como strings en vez de números, fechas en distintos formatos o campos nulos dispersos. Ignorar esto propicia análisis poco confiables.

Con la Parseur API, los usuarios pueden extraer automáticamente datos de facturas, recibos y correos a JSON limpio con una configuración mínima. Sus webhooks en tiempo real envían los datos estructurados directamente a ERPs, CRMs o bases de datos, reduciendo la limpieza manual previa a la validación. Esto no solo acelera el pipeline sino que también previene muchos errores habituales desde el principio.

El primer paso es convertir los datos al tipo correcto: por ejemplo, convierte campos como quantity o unitPrice a tipos numéricos y convierte fechas como invoiceDate y dueDate a ISO estándar. Valores booleanos como paid o approved también deben normalizarse a true o false.

Después, debes decidir cómo tratar faltantes. Hay tres estrategias principales:

- Eliminar: borra filas incompletas no críticas.

- Rellenar: sustituye por valores por defecto, promedios o placeholders.

- Marcar: deja faltantes señalizados para revisión (sin sobreescribir sin registro).

Esta lógica debe documentarse por campo para mantener la coherencia a lo largo del pipeline.

Pandas simplifica esta tarea en Python: to_numeric(errors="coerce"), to_datetime(), fillna() y dropna() hacen fácil estandarizar valores y gestionar nulos. Estas transformaciones aseguran que cada columna tenga el formato esperado y que los nulos se traten de forma determinista.

Corregir tipos, nulos y unidades desde el principio establece la base para limpiar texto, reparar tablas y controles referenciales después.

Paso 3: Canonicaliza Texto (Nombres, Formato, Unicode)

Tras ajustar numéricos y fechas, es el turno de limpiar campos textuales. Los valores de texto suelen tener diferentes mayúsculas/minúsculas, espacios de más o problemas de codificación, lo que complica agrupaciones y comparaciones. Un mismo proveedor puede figurar con varios nombres sin estandarizar, fragmentando los análisis.

El primer paso es limpiar espacios y signos innecesarios: recorta espacios iniciales o finales, agrupa espacios múltiples, elimina caracteres extraños. Luego aplica reglas de mayúsculas/minúsculas consistentes; por ejemplo, nombres de empresa en formato title(), estados de factura en mayúsculas.

La normalización Unicode también es esencial. Distintas codificaciones pueden hacer que dos cadenas idénticas visualmente sean distintas. Normaliza el texto a la forma NFKC para estandarizar acentos, símbolos y puntuaciones. En bases globales, puede ser útil quitar acentos para evitar duplicados (ej. “Café” vs. “Cafe”).

Por último, crea una lista de canonización para campos clave como proveedor. Comienza con reglas simples (abrev. como “Inc.” vs “Incorporated”) y amplía hacia modelos automáticos para resolución de entidades.

Canonizar texto permite comparar distintas fuentes y reduce riesgos de duplicados y registros dispersos.

Paso 4: Repara Tablas (Ítems que Sumán Bien)

Las tablas extraídas por API suelen necesitar ajustes adicionales. Encabezados fragmentados o celdas rotadas en PDFs complican el análisis. La limpieza comienza asegurando que cada tabla tenga una única fila de encabezado congruente con tu esquema.

Una vez la estructura esté lista, normaliza unidades para mantener la consistencia en los cálculos entre facturas. Por ejemplo, convierte kg y lbs a la misma unidad estándar, o unifica monedas antes de comparar totales. Recomputa amount = quantity × unitPrice en cada fila—esto es clave para garantizar la integridad. Como protección extra, siempre revisa que la suma de los ítems cuadre con el total de la factura (permitiendo solo una mínima diferencia), así podrás detectar errores como filas duplicadas o ítems omitidos.

Exportar a CSV añade otra capa de complejidad. Delimitadores ocultos, comillas o codificaciones erróneas pueden romper columnas. Una estrategia recomendada es cargar los archivos con herramientas flexibles como DuckDB que permite definir delimitadores, comillas y codificaciones explícitamente. El modo all_varchar permite cargar archivos conflictivos y luego castear cada columna.

Estos pasos convierten tablas caóticas en registros estructurados y fiables para equipos de análisis y finanzas. El objetivo es no solo cuadrar totales sino también evitar errores silenciosos.

Paso 5: Reglas Referenciales y de Negocio

Los problemas reales suelen aparecer al comparar datos entre tablas incluso si cada campo se ve correcto. Los chequeos referenciales aseguran que los valores sean coherentes y que las reglas de negocio se respeten antes de llegar al almacén.

Por ejemplo, todo vendorId de la tabla de facturas debe existir en la tabla maestra de vendors. Los códigos de moneda deben limitarse a los permitidos en la empresa y los impuestos a sus jurisdicciones. Identificar estos problemas pronto evita errores aguas abajo como joins rotos, reportes mal calculados o incumplimiento legal.

Los equipos modernos suelen implementar estas reglas en la capa de transformación. Pruebas DBT permiten codificar restricciones como:

- unique (sin facturas duplicadas),

- not_null (campos críticos como vendorId completos),

- accepted_values (validación de moneda),

- relationships (vendorId debe existir como clave foránea).

Plasmar la integridad referencial en pruebas automáticas asegura defensa en profundidad: los problemas surgen al instante y no semanas después de un cierre financiero.

Paso 6: Deduplicación y Vinculación de Registros

Los duplicados minan la confianza; inflan totales, causan pagos duplicados y dificultan auditorías. Limpiar tras la extracción por API requiere una estrategia que elimine duplicados sin borrar repeticiones legítimas.

El primer paso es definir claves determinísticas. En facturas puede ser una combinación de supplierName, invoiceNumber, invoiceDate, amount y currency. Si dos filas tienen todos estos valores, casi seguro son duplicados.

Más allá de coincidencias exactas, los duplicados suelen esconderse entre datos casi idénticos. El matching difuso ayuda; por ejemplo, facturas del mismo proveedor dentro de siete días y el mismo importe (±1%) pueden marcarse para revisión. Este enfoque en “bucket” evita borrados accidentales pero detecta entradas sospechosas.

También es clave diferenciar entre coincidencia sintáctica (texto exacto) y semántica (“Acme Corp.” y “ACME Corporation” son lo mismo). Herramientas como OpenRefine permiten agrupar registros similares para revisión humana.

Al combinar reglas estrictas con matching difuso y semántico se logra una deduplicación eficaz sin sacrificar registros legítimos.

Paso 7: Automatiza los Chequeos de Calidad de Datos

La calidad requiere vigilancia continua: aunque hayas limpiado hoy, una nueva extracción puede introducir errores mañana. Automatizar verificaciones garantiza que los problemas se detecten antes de impactar decisiones o informes.

Una opción confiable es Great Expectations (GX). GX permite declarar reglas (Expectations) para datasets: desde patrones en invoiceNumber, rangos de cantidad o límites en el número de filas. Ejecuta los tests en pipelines CI/CD y recibe feedback inmediato si cae la calidad.

Para pipelines nativas en Python, Pandera permite definir y validar tipos, rangos y nulos directamente en dataframes Pandas. Con unas pocas líneas de código, puedes rechazar filas inválidas o lanzar alertas automáticas ante desviaciones.

La automatización es útil sólo si los resultados son visibles. Envía los resultados a dashboards o sistemas de alertas, para que todos sepan el porcentaje de filas inválidas, cantidad de errores y detalles. Así los equipos pueden priorizar los fixes rápidamente.

Medir la calidad y hacerla continua mantiene los datos limpios, robustos y listos para producción.

Rendimiento y Almacenamiento (Para que la Limpieza No Sea el Cuello de Botella)

Limpiar datos tras la extracción es esencial, pero no debe enlentecer los pipelines. Tratando grandes volúmenes (facturas, recibos, logs), la baja optimización puede causar latencia y frustraciones aguas abajo. El objetivo es asegurar la calidad sin sacrificar la velocidad.

Estudios de MDPI muestran que la limpieza de datos puede consumir hasta el 80% del tiempo de un profesional de datos, lo que destaca su gran impacto en la eficiencia global del procesamiento. Esto subraya la importancia de optimizar los procesos de limpieza para mantener el rendimiento y la eficiencia de los pipelines.

Aquí tienes claves prácticas para mantener el rendimiento bajo control:

- Usa formatos columnar — Apache Arrow y Parquet aceleran la limpieza y reducen la memoria, habilitando operaciones vectorizadas. También se integran fácilmente con motores de análisis y librerías Python.

- Agrupa y paraleliza — En lugar de procesar fila a fila, lanza trabajos por lotes o tareas asíncronas desde el extractor. Así procesas múltiples archivos en simultáneo y minimizas los tiempos de espera.

- Aprovecha herramientas warehouse-native — Para CSVs muy grandes o joins complejos, realiza parseo en DuckDB o en tu data warehouse directamente. Esto libera al pipeline local y agiliza las transformaciones.

- Cachea resultados intermedios — Si ciertos chequeos o normalizaciones se repiten, cachear evita retrabajo innecesario.

- Monitorea recursos del sistema — Vigila uso de CPU, memoria e IO para identificar cuellos de botella antes de que afecten los niveles de servicio.

Un pipeline eficiente equilibra precisión y escalabilidad. Adoptar formatos columnar, procesamiento por lotes y recursos inteligentes mantendrá toda la validación y limpieza veloz y lista para analítica en tiempo real.

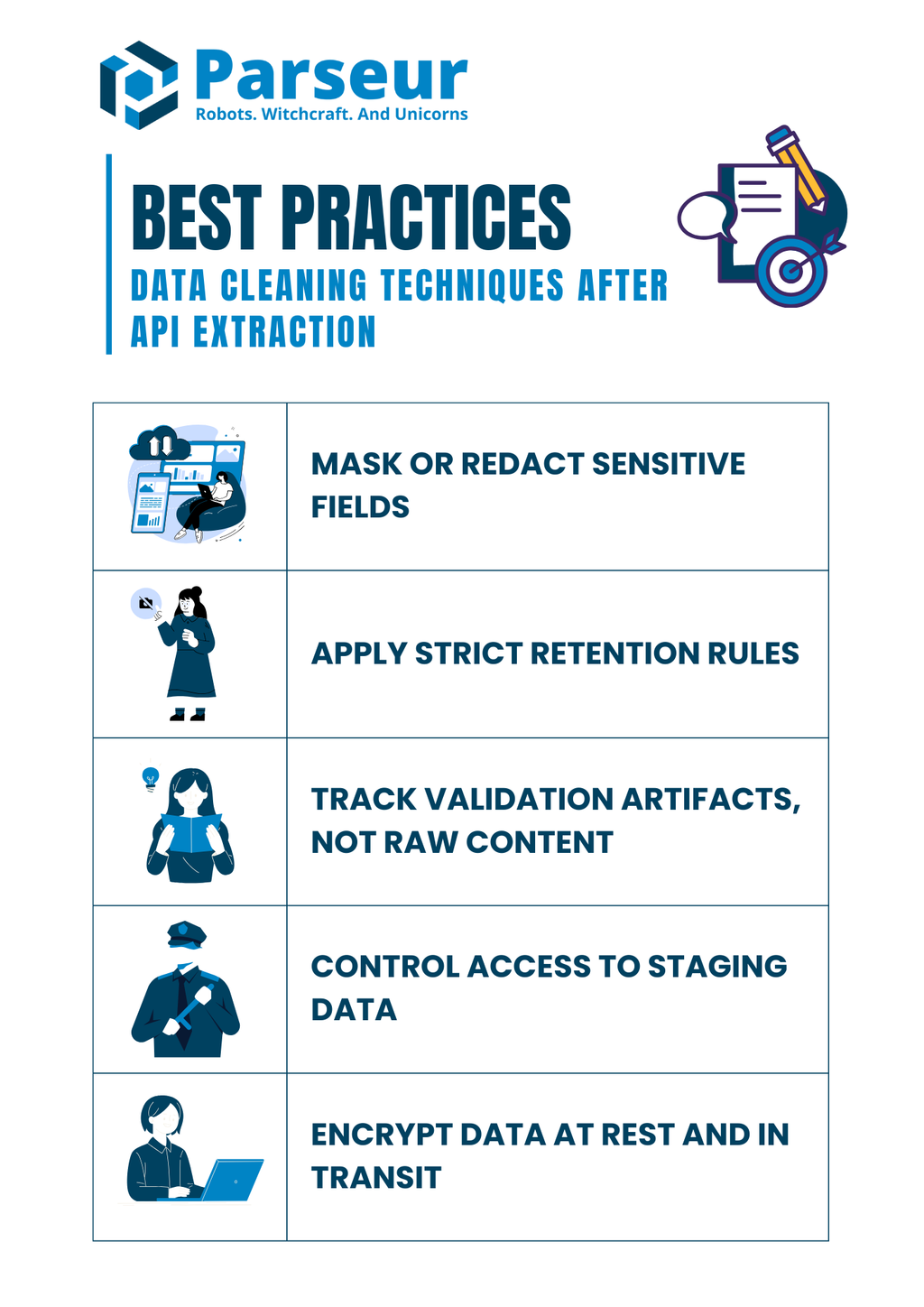

Seguridad y Cumplimiento (No Limpies los Controles)

La limpieza de datos no solo trata de arreglar errores, también impacta la normativa. Muchos documentos extraídos contienen información confidencial: datos bancarios, identificadores fiscales o empleados. Un mal trato en el post-procesado puede generar riesgos antes de llegar al almacén.

Investigaciones de Mitratech indican que el 61% de las organizaciones sufre brechas de datos, ineficiencias o problemas de cumplimiento por mala gobernanza. Esto evidencia la importancia crítica de aplicar prácticas sólidas de limpieza para lograr calidad y normativa.

Buenas prácticas para mantener el cumplimiento durante la limpieza:

- Enmascara o redacta campos sensibles — No registres identificadores como SSN, tarjetas de crédito o cuentas en logs. Sustitúyelos por máscaras o versiones hash al almacenar.

- Aplica reglas estrictas de retención — No guardes archivos brutos más tiempo del necesario. Define ventanas de retención alineadas a la normativa.

- Guarda artefactos de validación, no el contenido completo — Registra qué falló y por qué (campos faltantes, fechas inválidas), sin guardar el documento sensible.

- Controla accesos a datos temporales — Permisos basados en roles: solo usuarios autorizados pueden ver o modificar datos sensibles en staging.

- Cifra los datos en reposo y en tránsito — Tanto en temporales como definitivos, asegúrate de que bases de datos, archivos y logs estén cifrados para reducir riesgos.

El cumplimiento debe avanzar en paralelo con la limpieza técnica. Mantener controles a lo largo del pipeline protege de multas regulatorias y refuerza la confianza de los clientes.

Ejemplo Práctico (Juntando Todas las Piezas)

Veamos un ejemplo sencillo que une validación, normalización, conciliación y testing de calidad en un único pipeline. Imagina que usaste la Parseur API para extraer datos de una factura desde PDF o email. Parseur entrega JSON estructurado directamente desde esos documentos desordenados, dándote el punto de partida ideal para tu proceso de limpieza.

JSON extraído de ejemplo (input):

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

Paso 1: Valida el esquema con Pydantic:

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# Define el modelo de línea de ítem

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Define el modelo de factura

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# Cadena JSON de ejemplo

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# Parsear JSON en el modelo de factura

invoice = Invoice.model_validate_json(raw_json)

# Normaliza las líneas en un DataFrame de Pandas

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# Chequea los totales

if round(df["amount"].sum(), 2) != invoice.total:

print("Diferencia: los ítems no suman el total de la factura")

else:

print("Totales coinciden ✅")

print(df)

Paso 3: Ejecuta pruebas de calidad con Great Expectations:

import great_expectations as gx

# Inicializa el contexto de Great Expectations

context = gx.get_context()

# Carga el DataFrame de Pandas en un batch

batch = context.sources.pandas_default.read_dataframe(df)

# Obtén un validador para correr las expectativas

validator = batch.get_validator()

# Define expectativas

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# Ejecuta la validación y captura resultados

results = validator.validate()

print(results)

Salida (limpio):

- Los datos de la factura se validan contra un esquema.

- Fechas y números tipados correctamente.

- Totales conciliados con chequeo de tolerancia.

- Pruebas de calidad confirman rangos y estructura.

Este proceso de punta a punta demuestra cómo los equipos pueden transformar extracciones desordenadas de API validando pronto y aplicando limpieza determinista antes de cargar en sistemas productivos.

La limpieza es solo una parte de un pipeline fiable; el primer paso es extraer datos precisos y estructurados de tus documentos. Aquí es donde Parseur marca la diferencia. Con su plataforma intuitiva y la flexible Parseur API, podrás extraer automáticamente datos de PDFs, emails, hojas de cálculo y adjuntos, reduciendo el esfuerzo manual que retrasa a los equipos. Una vez tus datos estén capturados, puedes aplicar las técnicas de limpieza que cubrimos para asegurar que sean precisos, consistentes y listos para análisis.

Mirando hacia adelante, Gartner predice que para 2026 el 70% de los nuevos despliegues cloud harán uso de ecosistemas cloud de datos cohesivos en vez de integraciones manuales. Esta tendencia refuerza la necesidad de contar con datos limpios, estructurados y flujos de extracción API totalmente integrados.

Si quieres comprender el panorama completo, hemos creado un recurso integral sobre cómo las APIs transforman el procesamiento documental, incluyendo cómo elegir la herramienta adecuada y optimizar tus flujos. Explora nuestra guía completa sobre APIs de extracción de datos para documentos para aprender cómo ir de archivos desordenados a datos limpios y listos para accionar.

Preguntas Frecuentes

Antes de finalizar, aquí tienes algunas preguntas frecuentes sobre la limpieza de datos tras la extracción por API. Estas respuestas rápidas abordan problemas comunes y preocupaciones prácticas que los equipos suelen enfrentar.

-

¿Debo eliminar filas con totales faltantes?

-

Prefiero ponerlos en cuarentena e investigarlos en lugar de eliminarlos directamente. Los totales son campos financieros críticos, y eliminarlos en silencio puede sesgar los reportes. Mantenerlos en un bucket de revisión garantiza transparencia y una resolución adecuada.

-

¿Cómo garantizo JSON válido antes de limpiar?

-

Valida con JSON Schema o Pydantic para confirmar que los datos recibidos sean legibles por máquina y que coincidan con los campos esperados. Detectar JSON malformado desde el principio previene perder tiempo en corregir pasos posteriores.

-

¿Puedo probar la calidad sin un data warehouse?

-

Sí. Herramientas como Great Expectations o Pandera te permiten aplicar reglas directamente en pipelines de Python o flujos de CI/CD. Así puedes mantener la calidad incluso antes de que los datos lleguen al warehouse.

-

¿Qué hago si las sumas de las tablas no igualan el total de la factura?

-

Establece una regla de conciliación para comparar la suma de los ítems con el total de la factura dentro de un rango de tolerancia. Cualquier discrepancia debe ser marcada y enviada a revisión en lugar de sobrescrita.

-

¿Son necesarias las pruebas DBT si ya pruebo aguas arriba?

-

Sí. Las pruebas en DBT ofrecen una red adicional al codificar restricciones en la capa del modelo. Incluso si hay validaciones aguas arriba, este enfoque de defensa en profundidad evita que datos insuficientes lleguen a la analítica de producción.

-

¿Cómo manejo problemas de codificación en exportaciones CSV?

-

Siempre define el delimitador, la codificación y los caracteres de comillas explícitamente durante el parseo. DuckDB y herramientas similares ayudan a diagnosticar archivos problemáticos y garantizan consistencia al normalizar datos de múltiples fuentes.

Última actualización el