要点まとめ

- ドキュメントパーシングAPIは、PDF・画像・メールなど所有するファイルから構造化データを抽出します。

- ウェブスクレイピングAPIは、HTMLやレンダリングされたウェブページから情報を自動収集します。

- 適切な選択肢は、あなたのデータソース(受信ファイル/監視したいウェブサイト)によって決まります。

- 多くのチームがハイブリッドワークフローとして、スクレイピングでドキュメントを取得しパーシングで確実なJSON化を実現しています。

ドキュメントパーシングAPI vs ウェブスクレイピングAPI

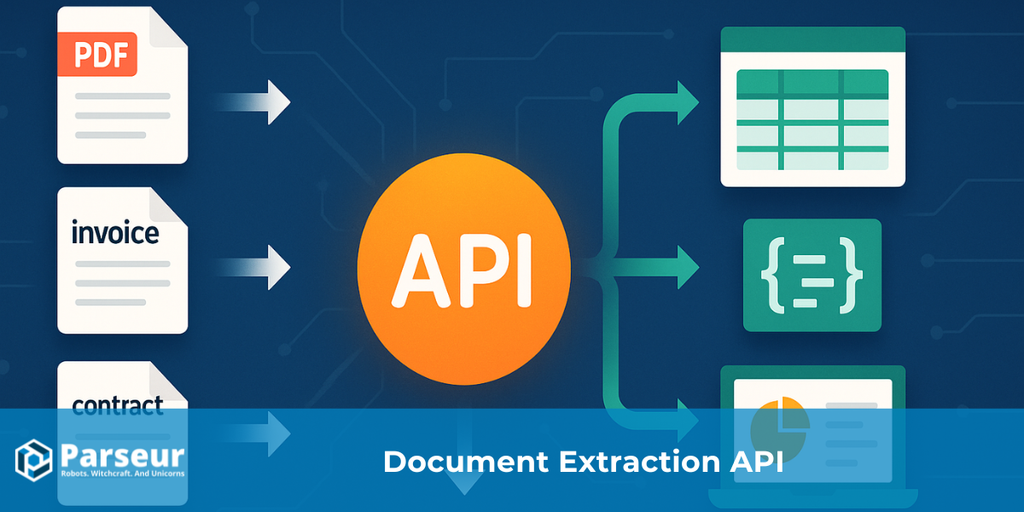

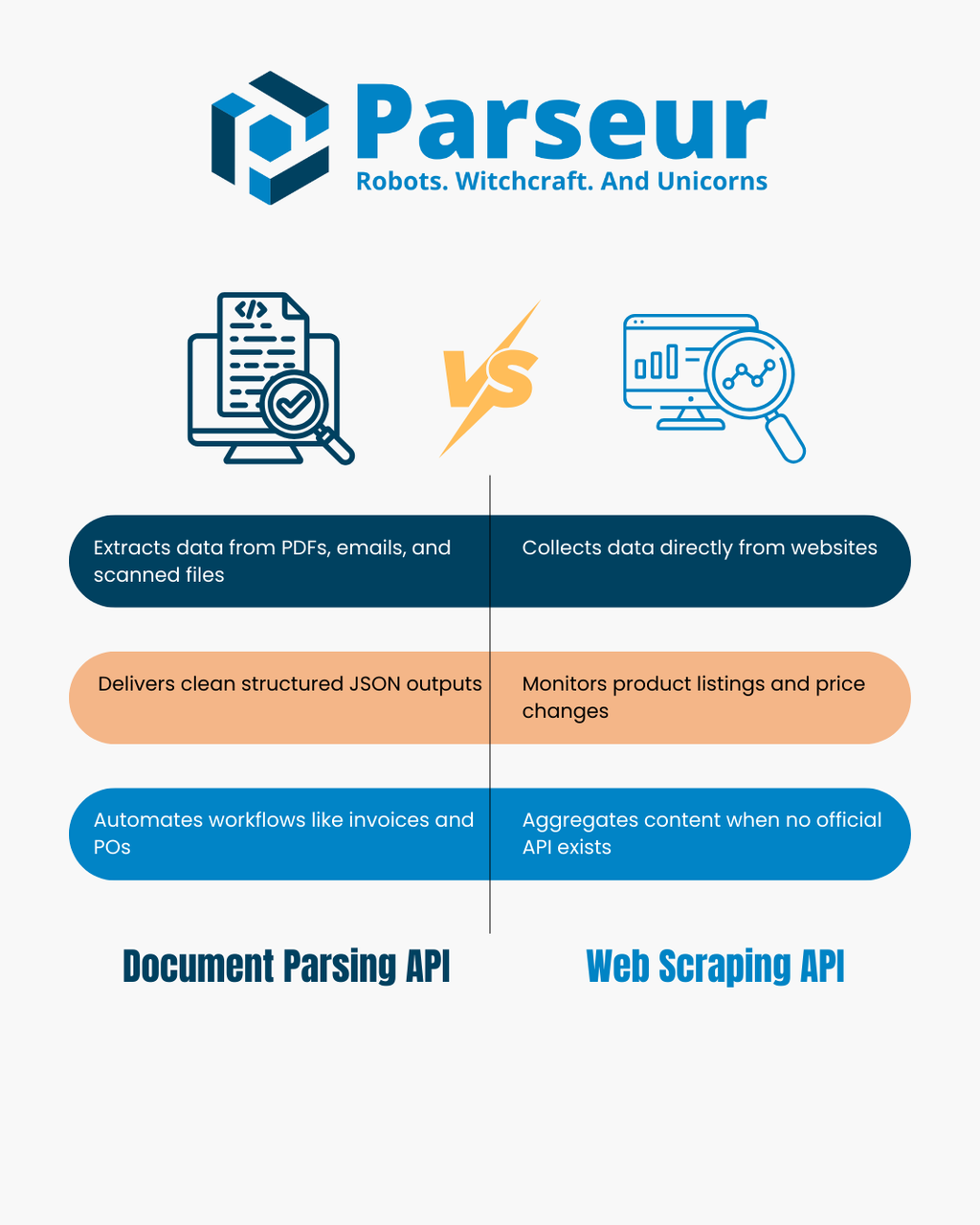

ドキュメントパーシングAPIは、PDFやスキャン画像、メールなどのファイルを構造化されたJSONに変換します。ファイルのレイアウトやテキスト内容を解析し、キーバリューの組み合わせやテーブル情報を抽出。これにより、請求書管理、発注トラッキング、メールからデータベースへの自動登録などの業務自動化が実現します。

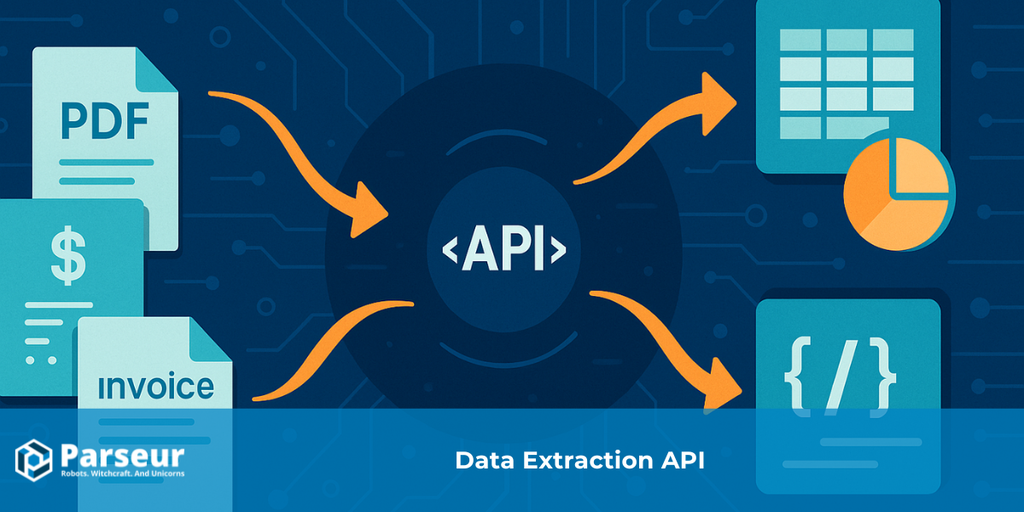

ウェブスクレイピングAPIは、ウェブサイト上のデータを直接取得し、HTMLやレンダリングされたDOMを解析します。公式APIがない場合、商品リスト監視や価格変動追跡、ニュース記事の集約、大規模データセットの構築などに使用されます。

どちらもデータ抽出手法ですが、パーシングAPIは所有ファイルを対象にし、スクレイピングAPIはウェブページを対象にするという点が大きな違いです。この記事ではそれぞれの強みと制約、意思決定フロー、比較表、そして実際のユースケースを解説します。より広い自動化の文脈はデータ抽出APIガイドもご参照ください。

ドキュメントパーシングAPIとウェブスクレイピングAPIの仕組み

両者はデータ抽出のための技術ですが、運用形態も抱える課題も大きく異なります。それぞれの動作イメージを把握すると、自社の業務にどちらが向いているか明確になります。

Scrapingdog の調査によれば、開発者の34.8%がウェブスクレイピングAPIを利用しており、カスタムスクレイピングスクリプト保守より構造化された即利用できるデータワークフローへ移行が進んでいます。

ドキュメントパーシングAPI

ドキュメントパーシングAPIは、すでに手元または適法に受領したファイルから構造化情報を抽出する機能に特化しています。PDF・スキャン画像・添付メール、場合によってはオフィスドキュメントも対象です。手入力なしでレイアウト解析とテキスト検出がなされ、意味を持つデータポイントが抽出されます。

- インプット例:PDF、スキャン、画像、メール、オフィスファイル

- アウトプット例:キーバリュー・テーブル・指定フィールドを含むクリーンなJSON

- 仕組み:OCRとパーシングルールでテキスト・数値・テーブルを検出し、CRMs、ERPs、各種DBなど下流システムで利用しやすい形式に変換

- 典型ユースケース:請求書・領収書の自動処理、発注書明細の抽出、財務諸表・大量顧客フォーム管理など。さらにメールを構造化データへ変換し、Zapier・Make・n8nと連携した業務の自動化も実現されます。

ウェブスクレイピングAPI

一方ウェブスクレイピングAPIは、オープンウェブ上から直接情報を抽出する用途です。ファイルではなくウェブサイト情報をフェッチし、HTML抽出、ヘッドレスブラウザによるレンダリングも可能、セレクタやJavaScript評価により特定フィールドのみ取り出せます。

- インプット例:ウェブサイトのURL、HTML、JSONエンドポイント

- アウトプット例:解析済みJSONやCSVなど分析・連携用の形式

- 仕組み:ウェブページを読み込み、DOM(ドキュメントオブジェクトモデル)を解析、CSSセレクタやXPathルールで商品名・価格・記事タイトルなどを抽出。一部ツールはプロキシ管理・アンチボット対策も可能。

- 典型ユースケース:EC価格監視・商品カタログ取得・ニュース集約・求人情報トラッキング・公式APIが無い分野の独自データセット作成等

設計として「自社所有または受信ファイルならパーシングAPI」、「公開ウェブ情報が対象ならスクレイピングAPI」が適しています。

意思決定ツリー:どちらが最適か?

ドキュメントパーシングAPIとウェブスクレイピングAPI選択のカギは、データソースと実現したいゴールです。判断を助けるために、以下の意思決定フローを用意しました。

!

正当に所有するファイル(PDF・画像・メール添付)ですか?

→ ドキュメントパーシングAPIを。ファイルを綺麗なJSON化し、主要項目もテーブル明細も自動で抽出できます。

公開ウェブページやオンラインデータセットがソースですか?

→ ウェブスクレイピングAPIを。HTMLやレンダリングされたページを取得し、必要なデータポイント(商品リスト・ニュース記事など)へと抽出できます。

文書もウェブも両方扱いますか?

→ この場合はハイブリッド型。例えばベンダーポータルからPDFをダウンロードするのにスクレイピング、そのPDFをパーシングAPIへ渡し構造データ化…など。

構造化テーブルや明細情報(請求書/領収書/発注書等)が必要ですか?

→ これはドキュメントパーシングAPIが得意分野。精度・スキーマ一貫性が求められる財務データ等も信頼して使えます。

リアルタイム更新情報(価格変動・速報ニュース等)が欲しいですか?

→ ウェブスクレイピングAPIが最適。頻繁にウェブサイトを確認し最新データ収集ができます。

これで自社ニーズにマッチしたAPI/ワークフローをすばやく選択できます。

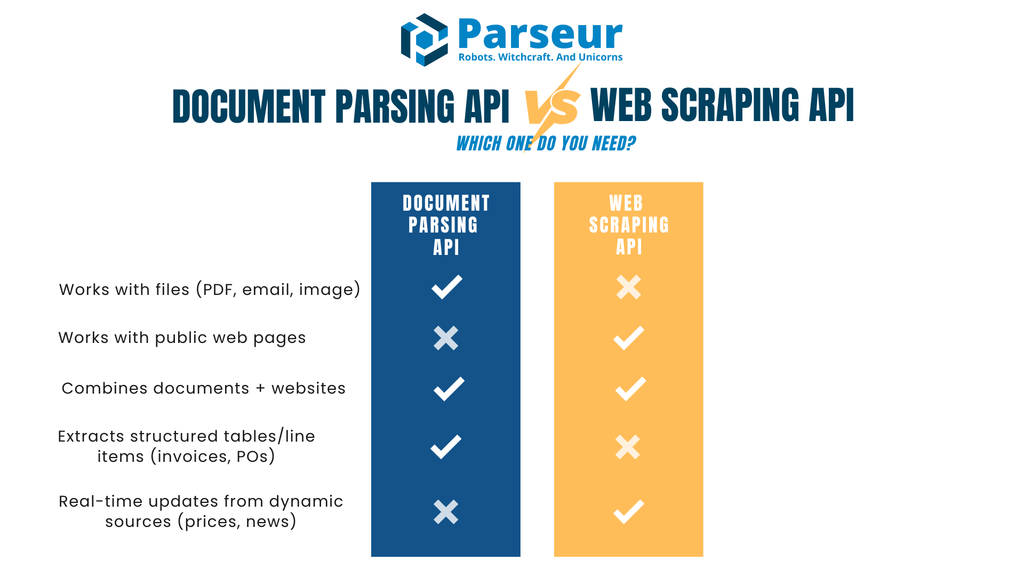

ドキュメントパーシングAPI vs ウェブスクレイピングAPI 比較表

各APIの強みや制約を並べて比較できます。

| 基準 | ドキュメントパーシングAPI | ウェブスクレイピングAPI |

|---|---|---|

| 主な入力 | PDF・スキャン画像・添付メールなどのファイル | ウェブページ(HTML/JSON)、レンダリングDOM |

| 代表的な出力 | キーバリューや明細テーブル・構造化フィールドを含むJSON | セレクタ抽出によるJSONやCSV |

| 環境変化耐性 | 安定:テンプレート設定後は精度が持続 | サイトレイアウトやDOM構造変更で抽出ロジックが壊れやすい |

| 主要用途 | 請求書、発注書、契約書、フォーム、財務諸表、業務メール等 | 商品カタログ、価格更新、求人ボード、ニュース集約 |

| 取得方法 | ドキュメントは自社や取引先が提供 | 他社ウェブサイトからデータ取得 |

| 法的観点 | プライバシーとコンプライアンス(管理者・処理者区分や保持ルール) | 利用規約・robots.txt・アンチボット制御に準拠 |

| レイテンシ・規模 | バッチ処理・非同期処理・Webhook通知に優れる | クローリング速度やアンチボット対策・同時処理数の制約 |

| 保守性 | テンプレートやスキーマの微調整が必要になる場合がある | 頻繁なセレクタ更新やアンチボット対応が不可欠 |

| データ品質 | 構造化出力・検証ルール・正規化で高品質 | サイト品質・HTML整形に大きく左右されやすい |

| セキュリティ | 伝送・保存時暗号化、署名Webhook、権限制御 | IPローテーション、セキュアプロキシ、ネットワーク衛生など必須 |

| LLM連携適性 | 下流AI/MLへの構造化JSONインプットに最適 | 非構造テキストの要約・分類・エンリッチ等に好適 |

| 適用タイミング | ドキュメント(請求書・領収書・契約書等)をすでに受け取っている場合 | ウェブ上のライブデータ(価格・在庫・ニュースヘッドライン等)が対象の場合 |

ウェブスクレイピングAPIが最適な場面と責任あるスクレイピングのコツ

情報がファイルではなくウェブサイトのみにある場合、ウェブスクレイピングAPIは強力な選択肢です。パートナーやベンダーから書類を「受け取る」のを待たず、大規模なデータ収集を自動化できます。市場調査・価格監視・知識集約等、頻繁なデータ更新が発生するプロジェクトにも最適です。

Browsercatの業界データでは、ウェブスクレイピング市場は2024年に約10.1億ドル、2032年までに24.9億ドルへ拡大し、年率11.9%成長とされています。

スクレイピングが役立つ代表的なシーン:

- 複数ECでの価格や商品在庫監視

- ニュース記事や公式発表の自動集約

- 公開APIの無い求人、イベント、ディレクトリ情報のデータセット化

ウェブスクレイピングは「自分が所有していない」情報取得であるため、責任ある運用が不可欠です。推奨される運用例:

- 事前にrobots.txtや利用規約の確認

- サーバー負荷を避けるためのレート制限設定

- 繰り返し取得を防ぐキャッシュ活用

- スクレーパーの明示的識別(偽装しない)

- 公式APIがある場合は優先利用

ウェブは頻繁に変更される現実があるため、HTMLや構造が少し修正されただけでスクレイパーが動かなくなることも。監視やアラート導入で即時対応できるようにしましょう。

また、スクレイピングは単独利用だけでなく、たとえばベンダーポータルでPDFをダウンロード→パーシングAPIでJSON化…など、ハイブリッドな業務に組み込まれることも多いです。

ウェブスクレイピングAPIの主な課題

ウェブスクレイピングAPIはリアルタイムなデータ収集には便利ですが、多くのビジネス上のハードルも存在します。これらの課題を把握し、現実的な期待値を持つことが重要です。

Octoparseの分析では、全ウェブサイトのうち約50%のみがスクレイピング容易、30%が中難度、20%は構造複雑や対策強化で特に難易度高いという結果です。

頻繁なウェブ構造変更

ウェブサイトはスクレイピングを想定していません。HTML構造やCSSクラス名の変更・レイアウトシフトだけでもスクレイピングスクリプトは壊れやすく、小さな修正が保守コスト・監視負荷の増大につながります。

アンチボット対策

CAPTCHA・IP制限・セッション検証・ボット検知などのプロテクションが普及。対策としてプロキシローテーション・User-Agent管理・リクエスト間隔調整などの技術負荷も高まっています。

法的・倫理的懸念

ウェブスクレイピングは法的にグレーゾーンです。公開データ対象でも、利用規約やrobots.txt違反、ペイウォール回避等は重大なリスクとなります。社内で明確な倫理基準を設け、規模の大きい運用前には必ず法務で確認しましょう。

データ品質・一貫性

ウェブは人間向けに設計されているため、スクレイピングしたデータは追加のクレンジングや検証が不可欠な場合も。HTML構造の不統一や動的JavaScript・重複データは、下流処理の手間を増やします。

スケーラビリティの課題

スクレイピング規模拡大=単純なリクエスト増加にはなりません。高負荷時のインフラ・並列実行・リトライ・分散・監視まで設計が必要で、プロキシやサーバーのコストも膨らみやすくなります。

長期的な持続性課題

業務インフラとして過信しづらい面も。公式APIや構造化文書との差異で、パイプラインは継続的な調整・保守(リソース確保)が不可欠です。

ドキュメントパーシングAPIが適している場面

既に必要な情報がウェブサイトではなく書類(PDFやスキャン、メール添付など)で届く場合、パーシングAPIによる自動構造化が最適です。手動転記の手間なく、非構造ファイルの内容を即時・正確なJSONへ転換できます。

Spherecoの調査によると、**企業データの80%が非構造(メール・PDF・スキャン等)**で、これが自動化の大きなボトルネックになっています。

代表的な活用例:

- 請求書・領収書処理:サプライヤー名・日付・合計金額・テーブル明細の抽出(支払管理ワークフロー最適化)

- 発注書や明細書:注文番号・金額・支払い条件などの自動抽出、照合の迅速化

- フォーム・契約書:顧客情報や署名日付など標準フィールドの引き出し

- 業務メール:注文確認・発送連絡をJSON化し下流システムと統合

パーシングAPIは制度・一貫性に優れ、テキスト抽出後の正規化・バリデーション・Webhook連携まで自動化。追加のクレンジング不要で、業務即応できる構造データを保証します。

また、ファイル構造はウェブより変動が少なく、一度解析設定すれば数千件でも安定して処理可能です。

ベンダー書類や顧客明細、業務メールの大量処理に依存する現場では、パーシングAPIがほぼ唯一の持続可能な最適解といえるでしょう。

ハイブリッドパターン:現場の複合運用例

実務では、パーシングとスクレイピングは競合ではなく相互補完的です。現実のビジネスデータはファイルとウェブの両方から生まれるため、双方を組み合わせることで自動化の完成度が高まります。

実践的なハイブリッド例:

- スクレイプ→PDFダウンロード→パース:ベンダーポータルの請求書や明細書PDFをスクレイピングAPIで取得し、パーシングAPIで金額・明細やキー項目を抽出

- パース+スクレイピングで付加情報取得:パースした請求書に、仕入先カテゴリや業界ベンチマークなど外部情報をスクレイピングで補強

- メールパース+ウェブ検証:注文確認や発送メールから詳細をパース、その後サプライヤーサイトの在庫や価格をスクレイピングで検証

- 知能層追加:ドキュメント由来JSON+ニュースサイトのデータを組み合わせ、BI分析や異常検知、他ソースとの商品名マッピングなども可能

両手法の強みを尊重することで、手作業を減らしつつ業務全体への自動化と拡張性を高められます。

ParseurはドキュメントパーシングAPIかウェブスクレイピングAPIか?

Parseurはパワフルなドキュメント&メールパーシングAPIで、非構造化ドキュメントを構造化JSONへ変換します。ウェブスクレイピングAPIのようにウェブから直接データを抽出せず、あなた自身やユーザーが所有する書類・メールだけを扱います。そのため、ウェブ構造の変化やスクレイピング制限、レンダリング問題のリスクがありません。Parseurなら請求書・領収書・発注書・顧客フォームなどの業務自動化が、確実かつ拡張可能に実現できます。

実際の運用イメージ

- Parseurの役割:メール・PDF・画像・オフィスファイルを取り込み、主要項目やテーブル明細で構造化されたJSONを返却。Webhook連携やAPI経由で取得可能。

- データ取扱アプローチ:Parseurは利用者の明示的な指示下でのみ情報を処理。DPAサポート・サブプロセッサ情報公開・カスタム保持/削除・静止/転送時の暗号化・署名Webhook等、堅牢なセキュリティ対策を実践。

- ベストフィット:主にメールやPDFで文書を受領し、迅速かつ安定して構造化データを抽出したいチームに最適。ほぼノーコードで業務活用が可能です。

Parseur APIの決定的な強み

Parseur APIの最大の特長は、API+ウェブアプリの両対応です。開発者はAPIでシームレスにシステムへ組み込み、オペレーションやサポート担当者はウェブ画面からパース結果の確認や修正ができます。

自前で監視や管理UIを開発・維持せずとも、ウェブアプリでJSONスキーマや抽出項目を直感的に作成、リアルタイム調整・確認も簡単。技術者・非技術者が協力しながら、最小の手間で本格業務連携が可能です。

ウェブ構造に依存せず「所有ファイルへのパース」に特化しているため、長期間安定した業務自動化の基盤としても信頼できます。

Parseurのデータ管理方針

ParseurはウェブスクレイピングAPIではありませんが、メールや書類を効率的かつ安全に処理できるよう特化設計されています。PDF・スキャン画像・メール添付に依存する現場でも、拡張性の高いJSON自動変換を実現します。

Parseurのデータセキュリティ・プライバシー・コンプライアンス重視は特筆点です。安心して利用でき、厳格なグローバル規格への準拠も実施済です。

Parseurのデータマネジメント主要ポイント

ドキュメントとメール専用の用途に設計

ParseurはPDF・画像・メール本文を取り込んでWebhookもしくはAPI経由で構造化JSONとして届けます。これにより請求書管理・発注トラッキング・メール→DB連携まで重いカスタム開発なしに自動化できます。

データ主権は常に利用者側に

Parseurに送信したデータの所有・利用権限は常にあなた側。明示的な指示下でのみ処理し、保有期間は最短1日までカスタマイズ可能。パース→即時削除(Process then Delete)機能も搭載済み。

保存場所について

Parseurの全データはEU(オランダ)、Google Cloud Platformの高セキュリティデータセンターに保存。GCP自体はISO 27001認証取得済。詳細はこちら

暗号化・セキュリティ方針

全データはAES-256で保存時暗号化、TLS v1.2以上で転送。古い通信規格(SSLv2, SSLv3, TLS 1.0/1.1)は完全無効化。Let’s Encrypt証明書でParseurサーバー・外部アプリ・ブラウザ間通信すべてを保護。

インフラ監視とペンテスト

Parseurは常時インフラ監視・依存パッチ適用を継続し、外部サービスによる定期ペネトレーションテストも実施。2025年にはAstraペンテスト証明書も取得、OWASP Top 10やSANS 25ベースの高レベル検証を通過済みです。

パスワード安全・アカウント保護

Parseurは生パスワードを保存せず、PBKDF2+SHA-256ハッシュ+512bitソルト+600,000回反復というNIST推奨以上の組み合わせで厳格管理。

稼働信頼性・SLA体制

稼働率99.9%以上を目標に、リトライ・バックオフ機構で障害発生時もデータ消失ゼロを維持。メール取り込みは24時間リトライ+二重送信、エンタープライズ向けに99.99%稼働保証あり。稼働履歴はこちら

GDPR+プライバシーファーストアプローチ

ParseurはGDPR完全準拠。利用者がデータコントローラーとして管理し、Parseurは販売・外部共有なし。サポート時を除き閲覧不可で、全従業員への継続的GDPR教育を実施。ParseurとGDPRはこちら

インシデント対応・違反通知方針

万一のデータ侵害時は48時間以内に顧客へ通知。完全な透明性を確保し法律順守を貫徹。Parseur公式のセキュリティ・プライバシー概要

法的観点・コンプライアンス早見表

ドキュメント抽出/ウェブスクレイピングAPI選択時には法的根拠や順守責任が不可欠です。両方式ともデータ取扱いは要注意ですが、適用義務や責任範囲はソース・用途によって異なります。

ドキュメント取り扱いには、利用者とデータ保有者・提供者の間の適法な契約が必要。管理者・処理者区分、データ処理契約(DPA)、明確な保存・削除ルール策定も欠かせません。また、通知・データ最小化義務も考慮要素です。

ウェブスクレイピングの法的な位置付けはさらに複雑です。公開情報でも、利用規約やrobots.txt等で明示的に禁止されたデータへのアクセスや、ペイウォール・アクセス制御回避などは法的リスクが高まります。必ず法務部と協議して規則・契約義務との整合を確認しましょう。

さらにクロスボーダーデータ転送が絡む場合、EUほか規制地域から個人情報を取り扱う際は適切な移転メカニズムも確実に整備してください。

まとめ:最適なデータAPIの選び方

ドキュメントパーシングAPIとウェブスクレイピングAPIはいずれも業務の自動データ収集に大きな価値がありますが、目的や現場により使い分けが必要です。パーシングAPIは、請求書や明細・メールなど「所有する文書タイプ」の処理に最適です。

Experlogixによれば、ドキュメント自動化で処理時間を最大80%短縮できるとされており、パーシングAPI導入による効率化の効果は絶大です。

逆に、必要なデータがウェブサイト(商品カタログや価格リスト等)にしかない場合は、スクレイピングAPIが有効です。多くのワークフローではファイル取得をスクレイピングで、構造化をパーシングで行うハイブリッド利用が定着しつつあります。

最も重要なのはデータソースに沿ったAPI選択。PDF・スキャン・メールで受領したデータにはパーシングAPIを、ウェブ上のデータにはスクレイピングAPIを。複数ソースを扱うチームは両手法組合せで広範な自動化を実現しましょう。

よくある質問

多くの読者の方が、ドキュメントパーシングとウェブスクレイピングの違いについて共通の疑問を持っています。下記に、それぞれの違いや実際のユースケースに役立つFAQを掲載します。

-

ドキュメントパーシングとウェブスクレイピングは同じものですか?

-

いいえ。ドキュメントパーシングは、すでに所有している、または受信したPDF、スキャン画像、メールなどのファイルを扱います。一方、ウェブスクレイピングは、HTMLやレンダリングされたコンテンツを解析してウェブサイトからデータを抽出します。

-

ParseurはウェブスクレイピングAPIツールですか?

-

いいえ。ParseurはドキュメントとメールパーシングAPIであり、ウェブスクレイピングツールではありません。ウェブページのクロールや取得は行いません。代わりに、所有するメール、PDF、画像、オフィスファイルなどのドキュメントをクリーンで構造化されたJSONへと変換します。これにより、請求書や領収書、発注書の処理など、複雑な社内ツールを構築せずとも業務自動化が可能です。

-

ウェブスクレイピングは合法ですか?

-

ケースバイケースです。公開データのスクレイピングは一部許可されている場合もありますが、多くのウェブサイトは利用規約やrobots.txtで制限を設けています。必ずこれらを確認し、法的助言を受けてから行いましょう。

-

スクレイピングを避けるべき場合は?

-

データがペイウォールの裏にある場合や、厳格なアクセス制御下にある場合、またはサイト利用規約で明確に禁止されている場合はスクレイピングを避けましょう。これらの制限を回避しようとする試みはコンプライアンスや法的リスクにつながります。

最終更新日