Belangrijkste Inzichten

- Data-extractie kan rommelige outputs opleveren die validatie en nabewerking vereisen als die niet zorgvuldig zijn opgezet.

- Een robuuste pijplijn bevat schema-validatie, normalisatie, tekstopschoning, tabelreparatie, deduplicatie en doorlopende kwaliteitscontroles.

- Tools als JSON Schema, Pydantic, Pandas en Great Expectations maken het schoonmaakproces krachtiger en automatiseren veel werkzaamheden.

- Parseur API helpt je snel data te vangen en te structureren, zodat teams zich kunnen focussen op kwaliteit en analyse.

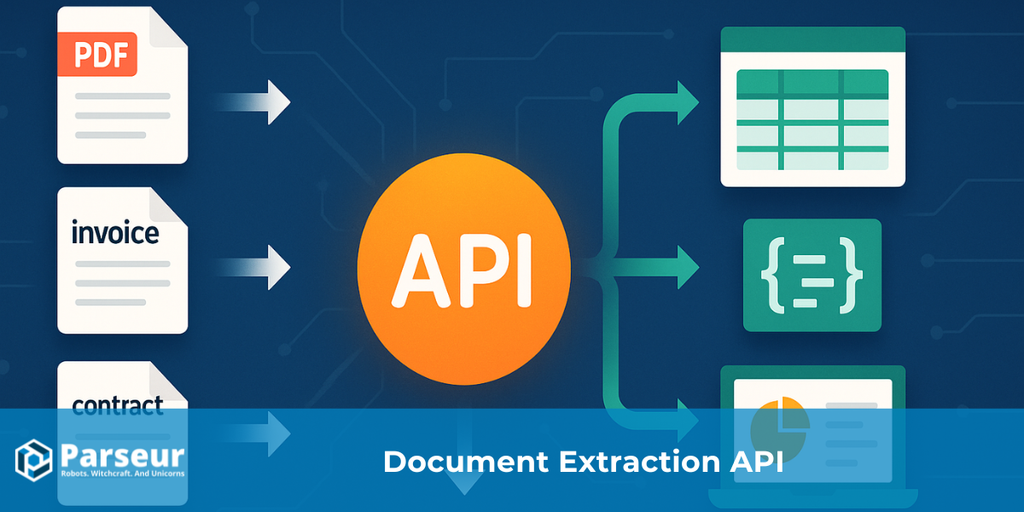

Data cleaning technieken slaan op het corrigeren, standaardiseren en valideren van ruwe data die via API's is verkregen. Zelfs wanneer extractietools ongestructureerde bestanden zoals PDF’s, afbeeldingen of e-mails omzetten naar gestructureerde formaten zoals JSON of CSV, bevatten de resultaten vaak inconsistenties, nullwaarden, verkeerde types, duplicaten of opmaakfouten. Schoonmaken zorgt dat de dataset aansluit op het beoogde schema en betrouwbaar is voor rapportages, analytics en je vervolgprocessen.

Een recente case study van DataXcel liet zien dat 14,45% van alle geëxtraheerde telefoongegevens ongeldig of inactief was, wat het belang aantoont van sterke data cleaning praktijken om deze fouten te beperken en de kwaliteit van extracties te waarborgen.

API's die data halen uit PDF’s, afbeeldingen of e-mails leveren meestal gestructureerde formaten als JSON of CSV. Dit maakt ruwe info direct bruikbaar, maar zelden perfect. Teams komen vaak ontbrekende waarden, inconsistente headers, gemengde datatypes, duplicaten of foutieve datums tegen. Zonder opschonen kunnen deze fouten rapportages, analytics en financiële beslissingen ondermijnen.

In deze gids vind je een praktische handleiding om rommelige extracties om te zetten naar betrouwbare datasets: valideren, standaardiseren, verrijken, testen en loggen. Voor teams die e-mail- en PDF-bijlagen verwerken, maakt een tool zoals Parseur het vastleggen makkelijk zodat jij kunt focussen op kwaliteit en cleaning.

Wil je diepgaandere kennis over hoe data extractie API's werken van begin tot eind? Bekijk dan onze complete gids: Wat is een Data Extraction API voor Documenten?

Soorten Data Cleaning Technieken

Na data extractie via een API bevat de ruwe output vaak inconsistenties, lege waarden, foutieve opmaak of duplicaten. Ook al zetten API's ongestructureerde bestanden als PDF’s, afbeeldingen of e-mails om naar gestructureerde formaten zoals JSON of CSV, de data moet nog steeds zorgvuldig opgeschoond worden om betrouwbaar te zijn.

Volgens een studie van Harvard Business Review voldoet slechts 3% van alle bedrijfsdata aan minimale kwaliteitsstandaarden en bevat 47% van nieuw aangemaakte datarecords minstens één kritieke fout. Deze fouten hebben echte impact, want Gartner becijfert de kosten voor slechte datakwaliteit op gemiddeld $15 miljoen per jaar per bedrijf.

Effectieve data cleaning technieken zijn essentieel om je data accuraat, consistent en analyse-klaar te maken. Veelgebruikte technieken zijn onder andere:

Validatie en Foutcontrole

Controleer of geëxtraheerde data de juiste formaten volgt zoals voor datums, getallen of e-mails. Zo voorkom je fouten in analyses of rapportages en waarborg je de nauwkeurigheid van je data extractie API.

Standaardisatie

Zorg dat data in consistente formaten staat, bijvoorbeeld telefoonnummers, adressen of datums normaliseren zodat datasets eenvoudiger te combineren en te gebruiken zijn.

Omgaan met Ontbrekende Waarden

Afhankelijk van je doel kun je nullen aanvullen, interpoleren of onvolledige records verwijderen.

Deduplicatie

Verwijder dubbele gegevens die ontstaan door herhaalde API-calls of overlappende bronnen, zodat je dataset accurater wordt en betrouwbaarder is.

Data Verrijking

Maak je data bruikbaarder door extra context of aanvullende info toe te voegen zoals geografische details of categorieën.

Format- en Typecorrectie

Zorg voor consistentie door verkeerde opmaak te verbeteren, strings naar getallen te zetten, spelfouten te corrigeren of valuta te standaardiseren.

Logging en Auditing

Leg alle schoonmaak-bewerkingen vast om de kwaliteit van je API-extracties te monitoren en dataintegriteit op termijn te bewaken.

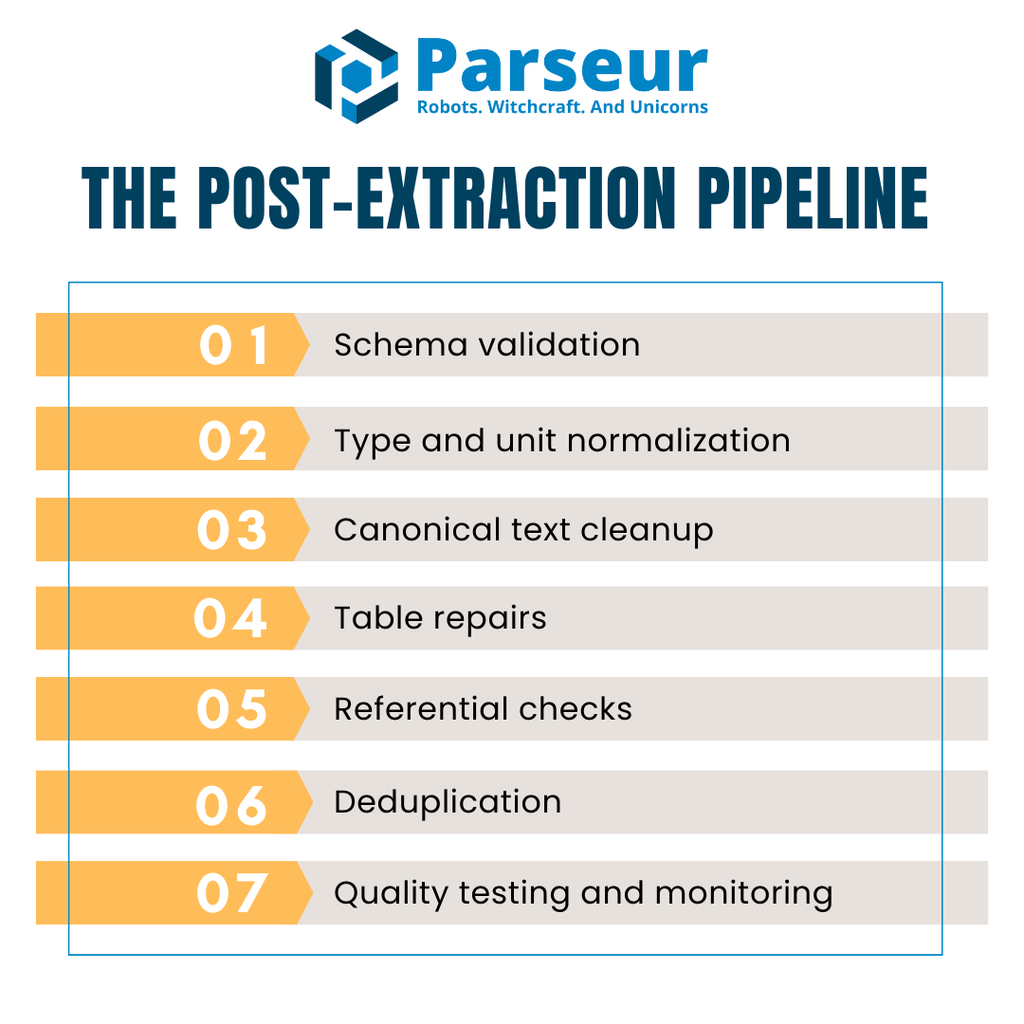

Het Post-Extractie Stappenplan (Overzicht)

Na extractie via een API is data zelden direct bruikbaar voor analyse of rapportages. De ruwe output bevat vaak ontbrekende velden, verkeerde datatypes, inconsistente tabellen of dubbele waarden. Om te voorkomen dat deze problemen doorsijpelen naar je systemen, heb je een gestructureerde, herhaalbare pijplijn nodig voor elke batch.

Een praktische post-extractie pijplijn heeft meestal deze zeven fases:

- Schema-validatie – Controleer of inkomende JSON of CSV de verwachte structuur heeft, voordat je verder gaat.

- Type- en eenheidsnormalisatie – Zet datatypes goed, corrigeer missende waarden en pas consistente eenheden of formaten toe.

- Canonical tekstopschoning – Standaardiseer strings, maak gebruik van gelijke hoofdletters, los Unicode-issues op.

- Tabelreparatie – Unificeer headers, lijn regels uit en check totalen in meerregelige facturen of bonnen.

- Referentiële checks – Valideer relaties tussen datasets, zoals leveranciers, valuta of belastingregels.

- Deduplicatie – Vind en verwijder duplicaten zonder legitieme herhalingen kwijt te raken.

- Kwaliteitstesten en monitoring – Automatiseer kwaliteitscontroles zodat fouten vroeg gesignaleerd worden en geen productie data corrumperen.

Voor performance slaan veel teams data tijdelijk kolom-georiënteerd op, bijvoorbeeld in Apache Arrow of Parquet, tijdens het schoonmaken. Dat is beter voor geheugen en snelheid, zeker bij grote factuur- of transactiedatasets.

Zie het als een estafettebaan: API → Validatie → Schoonmaken → QA → Warehouse. Zo forceer je consistentie, verlaag je kosten en verras je nooit met datakwaliteit.

Stap 1: Valideer Tegen een Schema (Rommel Vroeg Stoppen)

De eerste stap in het schoonmaken van data na API-extractie is schema-validatie. Zo zorg je dat alles machineleesbaar is en je verwachte structuur volgt. Zonder deze stap kan rommel je systeem insluipen en later voor fouten zorgen.

**JSON Schema (Draft 2020-12)** is hiervoor een van de krachtigste standaarden. Portabel, tool-onafhankelijk en ondersteund door een groot ecosysteem. Hiermee definieer je precies hoe geldige data eruitziet, inclusief type, verplichte attributen en opmaakregels. Bijvoorbeeld: invoiceDate moet ISO 8601 zijn, total mag niet negatief.

In Python-projecten valideert Pydantic v2 data razendsnel tijdens runtime en genereert automatisch JSON Schema-definities. Maak modellen voor facturen of regels, en je dwingt zo structuur én directe foutmelding af. Bijvoorbeeld: vendorName als string, invoiceNumber een regex, currency moet een van de geldige codes (USD, EUR, GBP) zijn.

Ga in je validatie verder dan losse types. Voeg keuzelijsten, regexregels (bijv. voor btw-ids), of numerieke grenzen toe. Zo voorkom je subtiele fouten.

Bedenk ook hoe je met ongeldige records omgaat: direct afwijzen of in een dead-letter queue plaatsen voor latere check. Zo laat je alleen betrouwbare data door in je schoonmaak-pijplijn.

Stap 2: Corrigeer Typen, Nullen en Eenheden

Als data door de schema-check heen komt, is het volgende het fixen van types, nullen, en eenheden. Zelfs als je parsing API JSON of CSV levert, zie je vaak nog getallen als string, inconsistente datumformaten of losse nullen in rijen. Zonder correctie krijg je onbetrouwbare analyses en rapportages.

Met de Parseur API, haal je automatisch data uit facturen, bonnen en e-mails als schoon JSON met minimale setup. Realtime webhooks sturen de data direct naar ERP, CRM of database zodat je minder handmatig hoeft schoon te maken vóór validatie. Dat versnelt je pijplijn en voorkomt veelvoorkomende fouten nog voor ze ontstaan.

Begin met alles in het juiste datatype krijgen. Zet velden als quantity en unitPrice naar numeriek, parse datums zoals invoiceDate en dueDate naar standaard ISO-formaat, en normaliseer boolean waarden als betaald of goedgekeurd naar true/false.

Vervolgens: hoe ga je om met missende waarden? Je hebt drie mogelijkheden:

- Droppen: verwijder incomplete rijen als ze niet belangrijk zijn.

- Invullen: vul aan met defaults, gemiddelden, of placeholders.

- Markeren: zet lege velden op een lijstje voor review in plaats van blind over te schrijven.

Leg voor elk veld vast hoe je het doet voor consistentie.

In Python is dit met libraries zoals Pandas eenvoudig. Met functies als to_numeric(errors="coerce"), to_datetime(), fillna() en dropna() kun je data snel standaardiseren. Hiermee zorg je dat elke kolom het juiste formaat heeft en nullen gedetermineerd worden afgehandeld.

Door direct types, nullen en eenheden te normaliseren leg je de solide basis voor latere stappen als tekstopschoning, tabellen repareren en referentiële checks.

Stap 3: Canoniseer Tekst (Namen, Hoofdletters, Unicode)

Zijn de numerieke en datumvelden op orde, dan ga je tekstwaarden schoonmaken. Tekstdata is vaak rommelig, met variërende hoofdletters, spaties of karakters waardoor groeperen of matchen lastig wordt. Dezelfde leverancier komt onder verschillende schrijfwijzen binnen als je niet canoniseert en je inzichten versnipperen.

Eerst stap: spaties en leestekens opschonen. Haal spaties voor/achter weg, klap dubbelspaties samen, verwijder overbodige tekens. Pas daarna consistente hoofdletters toe. Bedrijfsnamen bijvoorbeeld in title case, statusvelden juist in hoofdletters voor makkelijke vergelijking.

Unicode normalisatie is even belangrijk. Verschillende encoderingen kunnen visueel gelijke teksten alsnog als ongelijk registeren. Normaliseer tekst tot NFKC, zodat accenten, symbolen en leestekens telkens gelijk zijn opgeslagen. Voor internationale datasets kun je accenten strippen bij het vergelijken van leveranciersnamen, zodat je geen dubbele records als “Café” en “Cafe” krijgt.

Maak verder een canonieke lijst van je belangrijkste (leveranciers)velden. Begin simpel met regels als “Inc.” → “Incorporated” en breid eventueel uit naar entity resolution met machine learning.

Door tekst te canoniseren worden velden vergelijkbaar en heb je minder kans op fragmentatie of dubbelingen in je dataset.

Stap 4: Repareer Tabellen (Regels die Optellen)

Na API-extractie zijn regeltabellen vaak het meest rommelig. Headers verspreid over meerdere rijen, cellen verwisseld uit gescande PDF’s, of waarden samengevoegd zodat analyse lastig wordt. Schoonmaken begint met één heldere headerrij die klopt met je schema.

Is de structuur gezet, normaliseer de eenheden zodat berekeningen kloppen: converteer kg/lbs naar éénheden, reken valuta om voordat je vergelijkingen maakt. Herbereken per regel het bedrag: aantal × eenheidsprijs. Dit is een simpele maar essentiële stap voor integriteit. Controleer altijd of de som van de regels overeenkomt met het factuurtotaal, binnen een kleine marge. Zo vang je direct fouten als missende of dubbele regels af.

Kies je voor CSV-export? Ook daar schuilt gevaar: foute delimiters, losse aanhalingstekens of encoding-verschillen laten kolommen breken. Het veiligste is werken met flexibele tools zoals DuckDB: hiermee stel je delimiters, quotes en encoding expliciet in. Met bijvoorbeeld all_varchar laad je eigenwijze bestanden veilig, en zet je kolommen achteraf om naar het juiste type.

Deze stappen maken van rommelige extracted tabellen gestructureerde, betrouwbare rijen waar analytics en finance iets mee kunnen. Zo tel je niet alleen netjes op, maar weet je ook zeker dat er geen stille fouten in je rapporten sluipen.

Stap 5: Referentiële en Businessregels

Problemen duiken vaak op als je data vergelijkt tussen tabellen, zelfs als elke rij individueel lijkt te kloppen. Referentiële checks zorgen dat waarden écht consistent zijn en businessregels worden nageleefd voordat data je warehouse bereikt.

Bijvoorbeeld: elke vendorId in facturen moet ook bestaan in de grote leverancierslijst. Valutacodes mogen alleen zijn toegestaan binnen jouw bedrijfsvoering. Btw-tarieven moeten passen bij het rechtsgebied. Door fouten vroeg te vangen voorkom je downstream issues als mislukte joins, verkeerde rapporten of compliance-problemen.

Moderne datateams bouwen deze checks in bij hun transformatielaag. DBT tests maken het makkelijk om constraints als volgt vast te leggen:

- unique (geen dubbele factuurnummers),

- not_null (essentiële velden niet leeg),

- accepted_values (valuta enkel USD, EUR, etc.),

- relationships (foreign keys als vendorId moeten voorkomen in vendors).

Referentiële integriteit coderen in automatische tests geeft je defense-in-depth: fouten komen direct boven en niet pas weken later in een review. Zo maak je van handmatige controles een schaalbaar, herhaalbaar proces dat rapportages en compliance betrouwbaarder maakt.

Stap 6: Deduplicatie & Record Linkage

Dubbele records ondermijnen het vertrouwen in je data. Ze blazen sommen op, zorgen voor dubbele betaling of veroorzaken verwarring tijdens audits. Na API-extractie moet je dus duplicates verwijderen zonder legitieme herhalingen kwijt te raken.

Stap één: definieer deterministische sleutels. Voor facturen is een veilige combinatie vaak supplierName, invoiceNumber, invoiceDate, bedrag en valuta. Twee rijen met al deze waarden zijn vrijwel zeker duplicaten.

Maar duplicaten zijn er vaak ook in bijna-gelijke records. Een fuzzy matching window helpt — bijv. facturen van dezelfde leverancier binnen zeven dagen en met een bedrag binnen 1% verschil, flag je voor review. Zo vermijd je per ongeluk verwijderen maar bespeur je toch verdachte entries.

Maak onderscheid tussen syntactisch matchen (tekst direct vergelijken) en semantisch matchen (“Acme Corp.” = “ACME Corporation”). Met tools als OpenRefine kun je clusteren op gelijkenis en zo batches naar mensen voorleggen om te checken.

Combineer deterministische regels met fuzzy of semantische checks voor een gebalanceerd deduplicatieproces dat accuraat is zonder legitieme records te schappen.

Stap 7: Automatiseer Data Kwaliteitscontroles

Data kwaliteit is nooit een eenmalige actie. Zelfs na grondig schoonmaken kunnen nieuwe extracties altijd fouten introduceren. Door kwaliteitschecks te automatiseren vang je consistent problemen voordat ze impact hebben op rapportages.

Een betrouwbare keuze is Great Expectations (GX). Hiermee leg je regels, “Expectations” genoemd, vast voor je datasets. Je controleert bijvoorbeeld of factuurnummers aan een regex voldoen, hoeveelheden binnen range blijven, of aantal rijen aan verwachting voldoet. Deze test je als onderdeel van je CI/CD-pijplijn voor instant feedback als de extractiekwaliteit afneemt.

Voor puur Python pipelines biedt Pandera een lichte manier om types, ranges en nullability direct op Pandas dataframes te checken en afdwingen. Met een paar regels code verwerp je ongeldig data of geef je waarschuwingen af.

Automatisering werkt alleen als de resultaten zichtbaar zijn. Stuur testresultaten naar dashboards of alerting tools zodat teamleden weten hoeveel rijen faalden, pass/fail-tellingen en foutdetails. Zo kun je direct prioriteren waar gefixt moet worden.

Data kwaliteit continu meetbaar en zichtbaar maken zorgt dat elke opgeschoonde dataset accuraat, consistent en productie-klaar blijft.

Performance- en Opslagtips (Zorg dat Data Cleaning geen Bottleneck wordt)

Data schoonmaken is essentieel, maar mag je pijplijnen niet vertragen. Zeker bij grote aantallen facturen, bonnen of transacties kunnen slecht geoptimaliseerde processen voor vertraging, hogere kosten en gefrustreerde teams zorgen. Het doel: kwaliteit zonder snelheid te verliezen.

Uit onderzoek van MDPI blijkt dat data cleaning tot wel 80% van de tijd van een data professional kan opslokken, wat het belang onderstreept om deze processen zo efficiënt mogelijk te houden. Dit benadrukt hoe belangrijk het is om data cleaning optimaal in te richten om je pipeline snel en efficiënt te houden.

Zo houd je de performance onder controle:

- Gebruik kolomgeoriënteerde opslagformaten — Apache Arrow en Parquet maken datacleaning sneller door vectoroperaties en lager geheugengebruik. Ze integreren soepel met analytics en Python tools.

- Batch en paralleliseer workloads — In plaats van records één voor één verwerken, doe je batch-jobs of async taken vanaf de extractor. Zo verwerk je meerdere bestanden tegelijk.

- Maak gebruik van warehouse-native tools — Voor hele grote CSV's of complexe joins kun je parsing in DuckDB of direct in je warehouse afhandelen. Dit haalt werk weg uit je lokale pijplijn en versnelt conversies.

- Cache tussenresultaten — Als bepaalde checks of normalisaties vaker voorkomen, voorkom je herhaalwerk door resultaten te cachen.

- Monitor systeembelasting — Houd CPU, geheugen en I/O in de gaten om bottlenecks vroeg te signaleren.

Een efficiënte pipeline combineert accuraatheid en schaalbaarheid—dus met kolomformaten, batching en slim gebruik van resources hou je validatie en schoonmaak snel genoeg voor real-time analytics.

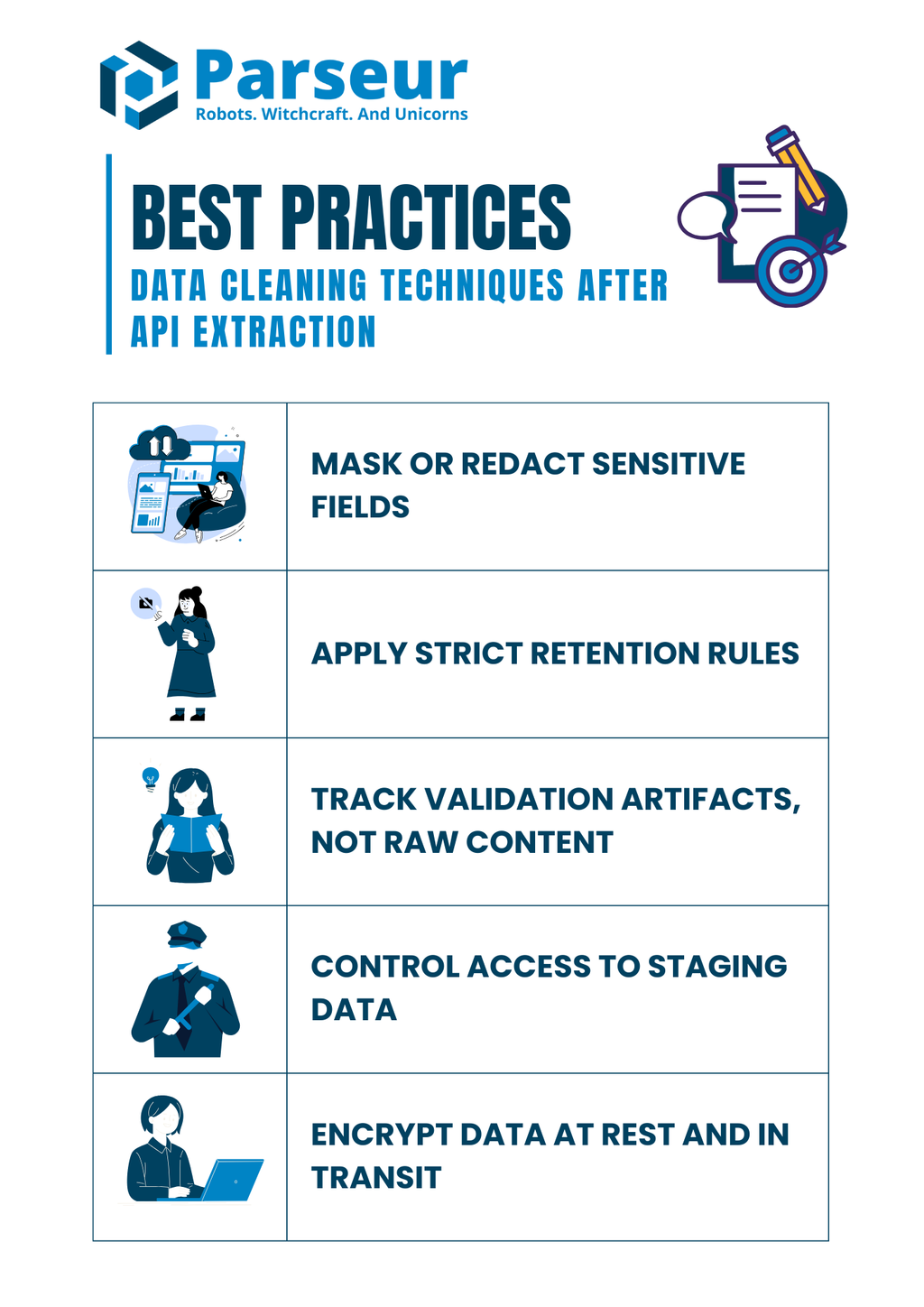

Security- en Compliance Notities (Houd Controleregels Intact bij Cleaning)

Data schoonmaken betekent meer dan alleen fouten fixen; het draait óók om compliance. Veel geëxtraheerde documenten bevatten gevoelige info als banknummers, fiscaal IDs of personeelsinfo. Onzorgvuldig omgaan met deze velden tijdens het nabewerken kan risico’s geven nog voordat de data op het warehouse belandt.

Uit onderzoek van Mitratech blijkt dat 61% van organisaties datalekken, inefficiënties en compliance-issues ondervindt vanwege slechte datagovernance. Dit maakt het belang van sterke data cleaning praktijken voor kwaliteit én regelgeving overduidelijk.

De beste compliance practices tijdens cleaning:

- Maskeer of redacteer gevoelige velden — Sla geen volledige nummers van bijvoorbeeld sofi- of creditcards op in logs. Gebruik altijd gemaskeerde of gehashte varianten.

- Strikte bewaartermijnen — Houd ruwe extracties niet langer dan noodzakelijk. Definieer bewaartermijnen volgens de regels.

- Log validatie-uitkomsten, géén ruwe inhoud — Leg vast wat en waarom iets misging (bv. ontbrekende velden, ongeldige datums) maar bewaar geen gevoelige documenten.

- Beperk toegang tot stagingdata — Rolgebaseerde permissions: alleen bevoegden mogen gevoelige records op staging zien of wijzigen.

- Versleutel data, zowel bij opslag als transport — Alles, tijdelijk of permanent: staging databases, bestanden, logs. Altijd encryptie gebruiken.

Sterke compliance-maatregelen lopen parallel aan technische cleaning. Controle houden door de hele pijplijn bespaart boetes en houdt klantvertrouwen op peil.

Praktisch Voorbeeld (Alles Samenbrengen)

We maken het concreet met een voorbeeld waarin validatie, normalisatie, reconciliatie en testen in één pijplijn samenkomen. Stel: je gebruikt Parseur API om factuurdata uit een PDF of e-mail te trekken. Parseur levert gestructureerde JSON direct uit ongestructureerde documenten, en dat is een topstartpunt voor cleanen.

Voorbeeld van geëxtraheerde JSON (input):

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

Stap 1: Valideer het schema met Pydantic:

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# Define line item model

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Define invoice model

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# Example raw JSON string

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# Parse JSON into Invoice model

invoice = Invoice.model_validate_json(raw_json)

# Normalize line items into Pandas DataFrame

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# Check totals

if round(df["amount"].sum(), 2) != invoice.total:

print("Mismatch: line items do not add up to invoice total")

else:

print("Totals match ✅")

print(df)

Stap 3: Draai data quality tests met Great Expectations:

import great_expectations as gx

# Initialize Great Expectations context

context = gx.get_context()

# Load the Pandas DataFrame into a batch

batch = context.sources.pandas_default.read_dataframe(df)

# Get a validator to run expectations

validator = batch.get_validator()

# Set expectations

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# Run validation and capture results

results = validator.validate()

print(results)

Output (schoongemaakt):

- Factuurdata is gevalideerd tegen een schema.

- Datums en bedragen zijn correct getypeerd.

- Totalen gecontroleerd met een tolerantiecheck.

- Kwaliteitstests bevestigen ranges en structuur.

Deze end-to-end aanpak laat zien hoe je van rommelige API-output tot vroegtijdig gevalideerde en deterministisch opgeschoonde data komt voordat het je productie in gaat.

Data cleaning is slechts één deel van een robuuste datapijplijn; het begint allemaal bij het krijgen van gestructureerde, accurate data uit je documenten. Daar komt Parseur om de hoek kijken. Met een intuïtief platform en een flexibele Parseur API kun je volledig automatisch data uit PDF’s, e-mails, spreadsheets en bijlagen halen, waardoor je het handwerk dat teams vertraagt sterk beperkt. Is je data eenmaal binnen, dan pas je de schoonmaaktechnieken uit deze gids toe om te zorgen dat alles accuraat, consistent en analyse-klaar is.

Kijkend naar de toekomst verwacht Gartner dat tegen 2026 70% van nieuwe cloud-implementaties gebruik maken van samenhangende cloud data ecosystemen in plaats van handmatig geïntegreerde point solutions. Deze trend benadrukt de groeiende nood aan schone, gestructureerde data en naadloze, API-gedreven extractieworkflows.

Wil je het hele plaatje snappen? We hebben een uitgebreide gids samengesteld over hoe API's documentverwerking transformeren, hoe je de juiste tool kiest en je workflows optimaliseert. Bekijk onze volledige uitleg over Data Extraction API's voor Documenten en ontdek hoe je van rommelige ruwe bestanden tot schone, bruikbare data komt waarmee je echt verder kunt.

Veelgestelde Vragen

Voordat we afsluiten, hier zijn wat veelgestelde vragen over data cleaning na API-extractie. Deze korte antwoorden pakken veelgemaakte valkuilen en praktische zorgen aan waar teams vaak mee te maken krijgen.

-

Moet ik rijen met ontbrekende totalen verwijderen?

-

Ik geef de voorkeur aan in quarantaine plaatsen en onderzoeken in plaats van ze direct te verwijderen. Totalen zijn kritische financiële velden, en ze zonder melding verwijderen kan rapportages vertekenen. Door ze in een review bucket te houden, is er transparantie en een correcte afhandeling.

-

Hoe garandeer ik geldige JSON vóór het schoonmaken?

-

Valideer met JSON Schema of Pydantic om te bevestigen dat binnenkomende data machineleesbaar is en overeenkomt met de verwachte velden. Door foutieve JSON vroeg te onderscheppen, voorkom je verspilling van tijd aan latere reparaties.

-

Kan ik kwaliteit testen zonder warehouse?

-

Ja. Tools zoals Great Expectations of Pandera laten je regels afdwingen direct in Python-pijplijnen of CI/CD-workflows. Op deze manier kun je kwaliteit bewaken, zelfs voordat data je warehouse bereikt.

-

Wat als tabellen niet optellen tot het factuurtotaal?

-

Stel een reconciliatieregel in om de som van de regels te vergelijken met het factuurtotaal binnen een tolerantie. Elke afwijking moet worden gemarkeerd en ter beoordeling worden gestuurd in plaats van te worden overschreven.

-

Zijn DBT-tests nodig als ik upstream test?

-

Ja. DBT-tests bieden een extra vangnet door beperkingen aan de modellayer te codificeren. Ook als er upstream-controles zijn, voorkomt deze defense-in-depth benadering dat onvoldoende data in je productie-analyses sluipt.

-

Hoe ga ik om met encoding-issues uit CSV-export?

-

Definieer altijd delimiter, encoding en aanhalingstekens expliciet tijdens het parsen. DuckDB en vergelijkbare tools kunnen lastige bestanden diagnosticeren en zorgen voor consistentie bij het normaliseren van data uit verschillende bronnen.

Laatst bijgewerkt op