Points clés à retenir

- L’extraction des données peut produire des résultats désordonnés qui nécessitent validation et post-traitement si le processus n’est pas maîtrisé.

- Un pipeline fiable doit inclure la validation du schéma, la normalisation, le nettoyage du texte, la correction des tableaux, la déduplication et des contrôles QA continus.

- Des outils comme JSON Schema, Pydantic, Pandas et Great Expectations renforcent et automatisent le post-traitement.

- L’API Parseur permet de capturer et structurer les données rapidement, afin que les équipes puissent se concentrer sur la qualité et l’analytique.

Les techniques de nettoyage des données englobent les méthodes visant à corriger, standardiser et valider les données brutes issues d’API. Même si les outils d’extraction convertissent des fichiers non structurés, comme des PDF, images ou emails, en formats structurés tels que JSON ou CSV, les résultats comportent souvent des incohérences, valeurs nulles, erreurs de type, doublons ou problèmes de formatage. Le nettoyage garantit que le jeu de données respecte le schéma attendu et devient fiable pour le reporting, l’analytique et les workflows en aval.

Une étude récente de DataXcel a montré que 14,45% des fiches de téléphonie extraites étaient invalides ou inactives, soulignant l’importance de bonnes pratiques de nettoyage pour limiter ces erreurs et garantir la qualité des données extraites.

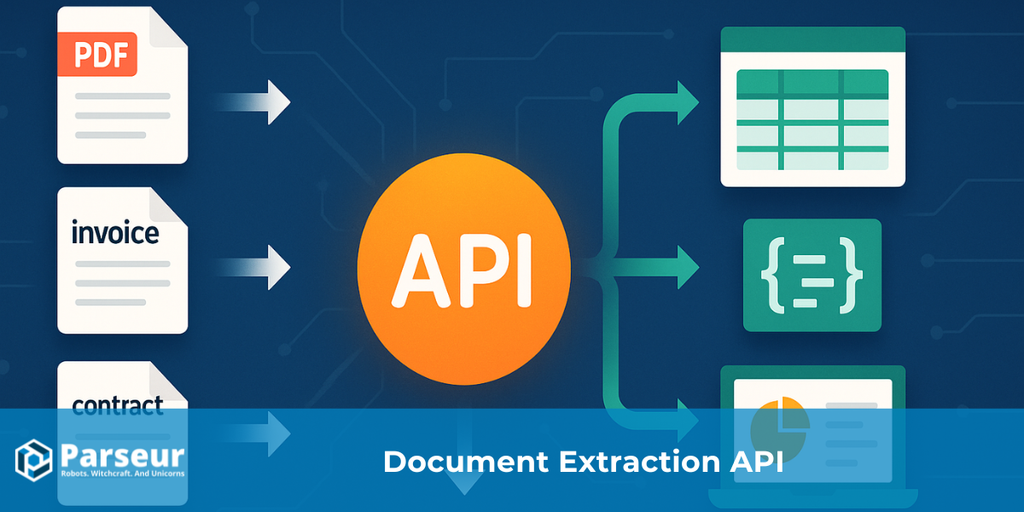

Les API permettant d’extraire des données de PDF, images ou emails retournent majoritairement des structures comme JSON ou CSV. Bien que cela rende l’information brute plus accessible, la sortie demeure rarement sans défaut : valeurs omises, entêtes incohérentes, typages mixtes, doublons ou dates incorrectes sont fréquents. En l’absence de nettoyage, ces défauts faussent rapports, analyses et décisions.

Ce guide vous livre une feuille de route pratique pour passer d’extractions désordonnées à des jeux de données fiables : valider, standardiser, enrichir, tester et journaliser. Pour les équipes manipulant des emails ou PDF joints, des solutions comme Parseur automatisent la capture et vous permettent de vous concentrer sur la qualité et le nettoyage.

Pour explorer tous les aspects des API d’extraction de données, consultez notre guide détaillé : Qu'est-ce qu'une API d'extraction de données pour les documents ?

Types de techniques de nettoyage des données

Après extraction via une API d'extraction de données, la sortie nécessairement brute renferme fréquemment des incohérences, valeurs manquantes, erreurs de format ou doublons. Même si les API facilitent la conversion de fichiers non structurés comme les PDF, images ou e-mails en formats structurés type JSON ou CSV, les données doivent être rigoureusement nettoyées avant d’être fiables.

D’après Harvard Business Review, seuls 3% des jeux de données d'entreprise atteignent le niveau de qualité minimal, et 47% des nouveaux enregistrements comportent au moins une erreur critique. De telles anomalies coûtent cher : Gartner estime leur impact à 15 millions de dollars par an pour l’entreprise moyenne.

Mettre en place des techniques efficaces de nettoyage des données est essentiel pour garantir leur exactitude, cohérence et exploitabilité. Voici les méthodes les plus répandues :

Validation et contrôle d’erreurs

Contrôlez que les formats extraits (dates, emails, numéros) sont conformes à l’attendu. Cette étape évite les erreurs dans l’analytique ou le reporting, et sécurise la fiabilité des sorties d’API d’extraction de données.

Standardisation

Unifiez la présentation : numéros de téléphone, adresses ou dates sont normalisés pour faciliter l’intégration et l’utilisation.

Gestion des valeurs manquantes

Selon l’usage prévu, traitez les nulls ou valeurs manquantes via complétion, interpolation ou suppression des lignes incomplètes.

Déduplication

Détectez et éliminez les doublons causés par des appels API répétés ou des recoupements de sources, afin d’augmenter la fiabilité des jeux de données.

Enrichissement de données

Pour améliorer l’utilité des données extraites, complétez-les avec du contexte ou des informations supplémentaires (détails géo, catégories...).

Correction de format et de type

Assurez l’homogénéité : corrigez les erreurs de format, transformez chaînes en numériques, rectifiez les coquilles ou standardisez les devises.

Journalisation et auditabilité

Consignez toutes les opérations de nettoyage afin de surveiller la qualité de vos extractions API et garantir l’intégrité sur la durée.

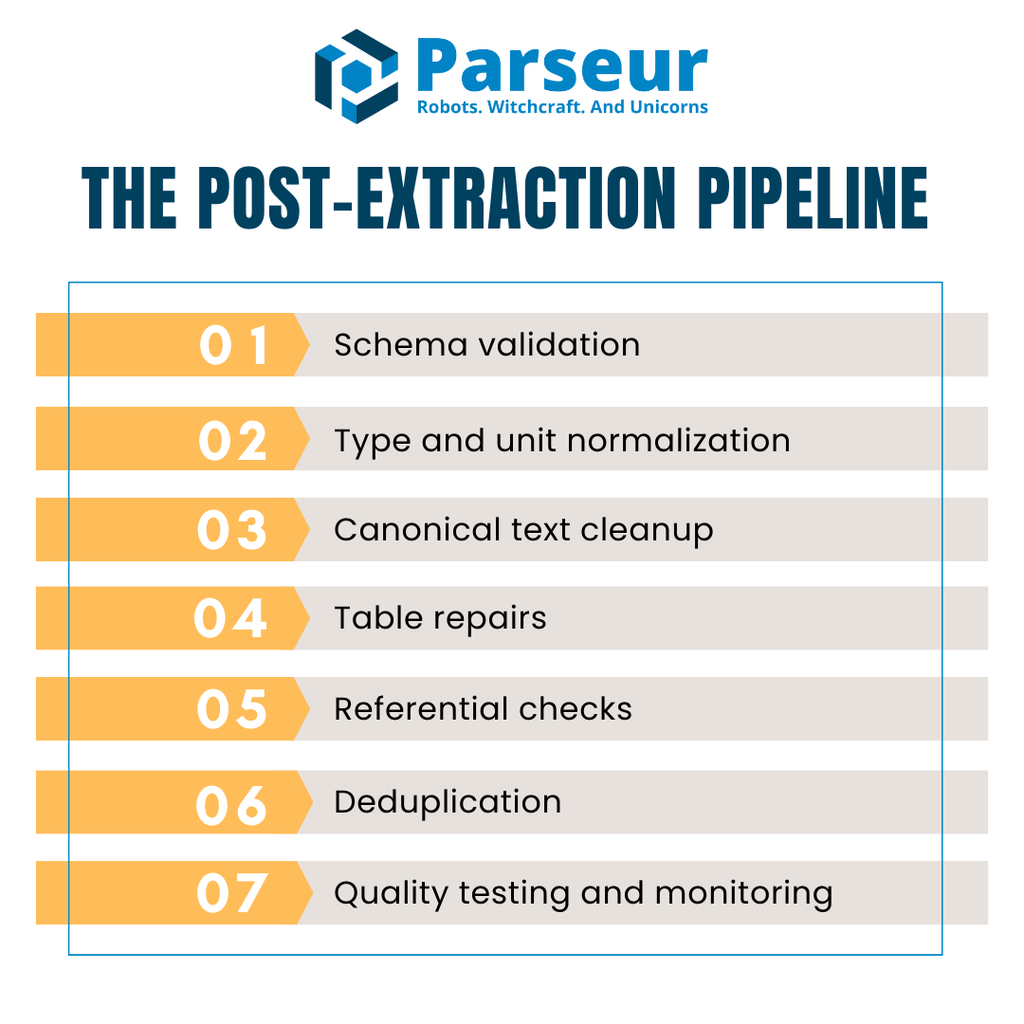

Le pipeline post-extraction (Vue d’ensemble)

Après extraction API, les données sont rarement prêtes à être exploitées directement dans l’analytique ou le reporting. Les sorties brutes révèlent souvent champs vides, types inadaptés, tableaux incohérents ou valeurs en doublon. Pour éviter la propagation de ces défauts, il faut un pipeline organisé et réutilisable à chaque lot extrait.

Un pipeline post-extraction robuste comporte généralement cinq étapes principales :

- Validation du schéma – Vérifiez que le JSON/CSV entrant suit la structure attendue avant tout autre traitement.

- Normalisation des types et unités – Corrigez les types, traitez les manques, harmonisez unités ou formats.

- Nettoyage canonique du texte – Uniformisez chaînes de caractères, casse, traitements Unicode.

- Réparation des tableaux – Unifiez les entêtes, réalignez les lignes, rapprochez les totaux pour les factures multi-lignes.

- Contrôles référentiels – Validez la cohérence entre ensembles de données (fournisseurs, devises, fiscalité).

- Déduplication – Identifiez et supprimez les doublons, sans écarter les entrées légitimes.

- Tests qualité & supervision – Automatisez les contrôles pour signaler les erreurs au plus tôt et protéger la donnée de production.

Côté performance, stockez les données dans un format colonnaire (Apache Arrow ou Parquet) durant le nettoyage : gain de mémoire, rapidité et fluidité pour traiter de gros volumes (factures, transactions...).

Visualisez ce flux comme une ligne de nage : API → Validation → Nettoyage → QA → Entrepôt. Cette organisation assure cohérence, limitation des coûts et suppression des mauvaises surprises de qualité.

Étape 1 : Validez par rapport à un schéma (Stoppez les erreurs dès le départ)

La première étape du nettoyage après extraction API, c’est la validation du schéma. Elle garantit que l’information est lisible par machine et structurellement conforme. En l’absence de ce garde-fou, des données dégradées peuvent polluer tout le pipeline en aval.

Le standard le plus largement adopté est le JSON Schema (Draft 2020-12). Universel, il définit le schéma valide (types, champs obligatoires, formats). Exemple : invoiceDate au format ISO 8601 ou un total toujours positif.

En Python, Pydantic v2 permet une validation dynamique tout en générant le schéma JSON. Définissez vos modèles (factures, lignes : vendorName = chaîne, invoiceNumber = regex, devise codée USD/EUR/GBP…).

Les règles ne doivent pas se limiter aux types : ajoutez des énumérations, regex (ex : SIREN, TVA), bornes numériques... Cela offre une barrière contre les erreurs subtiles.

Enfin, définissez comment traiter les entrées invalides : rejet immédiat ou file d’attente d'erreurs pour revue ultérieure. Cette approche fail-fast élimine les risques dès le début.

Étape 2 : Corrigez types, valeurs nulles et unités

Après la validation du schéma, la priorité est de corriger les types, traiter les valeurs manquantes et normaliser les unités. Même avec une API de parsing produisant JSON ou CSV structuré, on retrouve des nombres chaînes, dates irrégulières, ou champs nuls disséminés. Sans correction, l’analytique et le reporting deviennent peu fiables.

Avec l’API Parseur, vous extrayez automatiquement données de factures, reçus et emails vers un JSON propre avec un paramétrage minimal. Les webhooks en temps réel injectent la donnée structurée dans vos ERP, CRM ou bases, limitant le nettoyage manuel à venir avant les règles de validation : pipeline accéléré et beaucoup d’erreurs courantes éliminées en amont.

Commencez par convertir chaque valeur dans le bon type : quantité, prix unitaire en numérique ; dates au format ISO, booléens normalisés (true/false).

Puis, décidez comment traiter les valeurs manquantes. Trois stratégies principales :

- Suppression : retirez les lignes incomplètes si elles sont non critiques.

- Complétion : imputez des valeurs (par défaut, moyenne ou placeholder).

- Signalement : marquez explicitement les champs manquants pour revue.

La règle doit être documentée champ par champ afin d’assurer cohérence et traçabilité.

Avec Pandas, cette normalisation est rapide : to_numeric(errors="coerce"), to_datetime(), fillna(), dropna() standardisent efficacement chaque colonne. Vous vous assurez ainsi que tout est correctement formaté et que la gestion du null est prédictible.

Corriger types, nulls et unités d'emblée offre une base solide pour la normalisation du texte, la réparation des tableaux et des contrôles référentiels.

Étape 3 : Canonicalisez le texte (noms, casse, Unicode)

Une fois les champs numériques/dates corrigés, le nettoyage se concentre sur les valeurs textuelles. Les textes sont la principale source de variabilité : casse, espaces, encodage rendent difficile la comparaison, le regroupement et la détection de doublons.

Commencez par le nettoyage d’espaces et de ponctuation : supprimez les blancs en début/fin, collapsez les multiples espaces, éliminez les caractères parasites. Appliquez ensuite des règles de casse systématiques (noms en title case, statuts en majuscule...).

La normalisation Unicode revêt une importance particulière. Des encodages différents rendent deux chaînes identiques impossibles à reconnaitre comme égales. La normalisation NFKC évite les doublons ("Café"/"Cafe"). Pour des jeux multi-pays, supprimez à la volée les accents lors des comparaisons internes si besoin.

Enfin, bâtissez une liste de canonisation pour les champs critiques (ex : fournisseurs). Cela démarre par quelques règles de correspondance simple ("Inc." / "Incorporated"), et évolue, si besoin, vers de la résolution d’entités par apprentissage machine.

Une canonisation rigoureuse du texte réduit les fragments ou doublons dans la suite des traitements.

Étape 4 : Réparation des tableaux (lignes qui s’additionnent)

Après extraction API, les tableaux de lignes requièrent souvent le plus de corrections. Entêtes éclatées sur plusieurs lignes, cellules pivotées depuis un PDF scanné, valeurs fusionnées rendant l’analyse difficile. La réparation commence par une entête unique et fiable qui mappe chaque colonne à votre schéma.

Une fois la structure posée, normalisez les unités pour que les calculs restent fiables d’un document à l’autre (ex : KG/LBS). Recâblez aussi les devises avant tout rapprochement de total. Le recalcul amount = quantity × unitPrice est indispensable pour vérifier l’intégrité, et contrôlez systémiquement que la somme des lignes égale le total de la facture (tolérance faible acceptée). Cela permet de détecter des erreurs de lignes manquantes ou doublonnées.

L’export en CSV ajoute une complexité supplémentaire : délimiteurs cachés, caractères de citation parasites, encodages incohérents cassent les colonnes. Chargez les fichiers à l’aide d’outils souples comme DuckDB : fixez explicitement délimiteurs, quotes, encodages ; le mode all_varchar sécurise le chargement puis permet un typage métier par la suite.

Ces étapes transforment vos tableaux extraits « bruts » en jeux fiables que vos équipes d’analyse et de finance peuvent exploiter. La cible : garantir non seulement le bon total, mais l’absence d’erreurs occultes dans vos rapports.

Étape 5 : Règles référentielles et métier

Des défauts surgissent souvent à la croisée de tableaux, même si chaque ligne paraît correcte isolément. Les contrôles référentiels assurent cohérence et conformité métiers avant le chargement final.

Par exemple, chaque vendorId de la table factures doit exister dans la table référentielle fournisseurs. Les devises doivent être autorisées, les taux de taxe correspondre à la bonne législation... Détecter en avance ces écueils évite ruptures de jointures, erreurs dans les rapports, ou problèmes réglementaires.

Les data teams modernes codent désormais ces règles dans les couches de transformation. Les tests DBT facilitent la formalisation de contraintes telles que :

- unique (pas de numéro de facture en doublon),

- not_null (champ critique obligatoire),

- accepted_values (devise autorisée),

- relationships (clé étrangère présente dans la table cible).

Intégrer ces règles au pipeline offre une défense en profondeur : vos contrôles sont immédiats, plutôt que rétroactifs après analyse financière.

Étape 6 : Déduplication et rapprochement d’enregistrements

Le risque des doublons existe à chaque extraction. Ils faussent totaux, génèrent doubles paiements, brouillent les audits. Nettoyer après une extraction requiert une méthode sans risque de perte d’entrées légitimes.

Commencez par définir des clés déterministes (ex : supplierName, invoiceNumber, invoiceDate, montant, devise). Si deux lignes partagent tout cela, ce sont probablement des doublons.

Mais certains doublons sont subtils : appliquez une fenêtre floue (ex : factures du même fournisseur dans les 7 jours, montant similaire à 1 % près...) pour repérer les faux positifs, tout en protégeant les vraies entrées.

Faites aussi la différence entre matching syntaxique (texte exact) et matching sémantique ("Acme Corp." vs "ACME Corporation"). Des outils comme OpenRefine regroupent automatiquement les entrées proches pour validation humaine.

L’association de règles déterministes et de matching flou/sémantique permet une purification maximale du jeu de données, en minimisant le risque de perte.

Étape 7 : Automatisation des tests qualité

La data quality n’est jamais statique : même après un nettoyage soigné, chaque extraction peut réintroduire des défauts. L’automatisation des tests garantit la détection continue avant que le défaut n’impacte le reporting ou la décision.

Un standard reconnu : Great Expectations (GX). Déclarez vos Expectations (attendus de qualité/exhaustivité) : regex sur numéros de factures, bornes sur quantités/prix, seuils de lignes... Ces contrôles s’intègrent à votre CI/CD, et préviennent toute dérive en extraction.

Pour les pipelines Python natifs, Pandera impose types, bornes et nullabilité sur dataframe Pandas. Avec peu de code, rejetez les lignes invalides ou délivrez une alerte aux variations anormales.

Pour rendre ce contrôle efficace, rendez les résultats visibles : poussez-les dans un dashboard ou système d’alerte, partagez taux d’erreur et détails. Cela boucle la boucle et permet la priorisation immédiate des corrections.

Rendre la qualité mesurable et continue, c’est garantir sur le long terme des données propres, exploitables et prêtes pour la production.

Performance et stockage : Ne laissez pas le nettoyage devenir le goulot

Nettoyer la donnée après extraction est indispensable, mais ne doit pas freiner l’ensemble de la chaîne. À gros volume (factures, logs, transactions), un process mal optimisé génère latence, surcoûts et frustration ; l’enjeu est d’assurer qualité et rapidité.

Des études de MDPI montrent que le nettoyage peut consommer jusqu’à 80% du temps d’un professionnel des données, signalant son rôle critique dans la performance du process global.

Pour maintenir la performance :

- Adoptez les formats colonnaires — Apache Arrow, Parquet : nettoyage rapide, vectorisé, économe en RAM. Parfait pour Python et l’analytique moderne.

- Traitez en batch et parallélisez — Préférez les jobs de traitement par lots ou asynchrones (plusieurs fichiers traités en simultané) : plus d’attente ni de goulets.

- Exploitez vos outils warehouse — Pour les CSV massifs ou les jointures complexes, décalez les calculs lourds vers DuckDB ou l’entrepôt de données : accélération majeure du process.

- Mettez en cache les résultats intermédiaires — Si certains contrôles sont réitérés, le cache évite de retraiter inutilement !

- Monitorer l’usage système — Suivez la charge CPU/mémoire/I/O pour anticiper toute saturation potentielle.

Des pipelines de nettoyage efficaces conjuguent précision et scalabilité. Adopter les bons formats, le batch et des ressources bien utilisées garantit l’agilité de la donnée – jusqu'au temps réel !

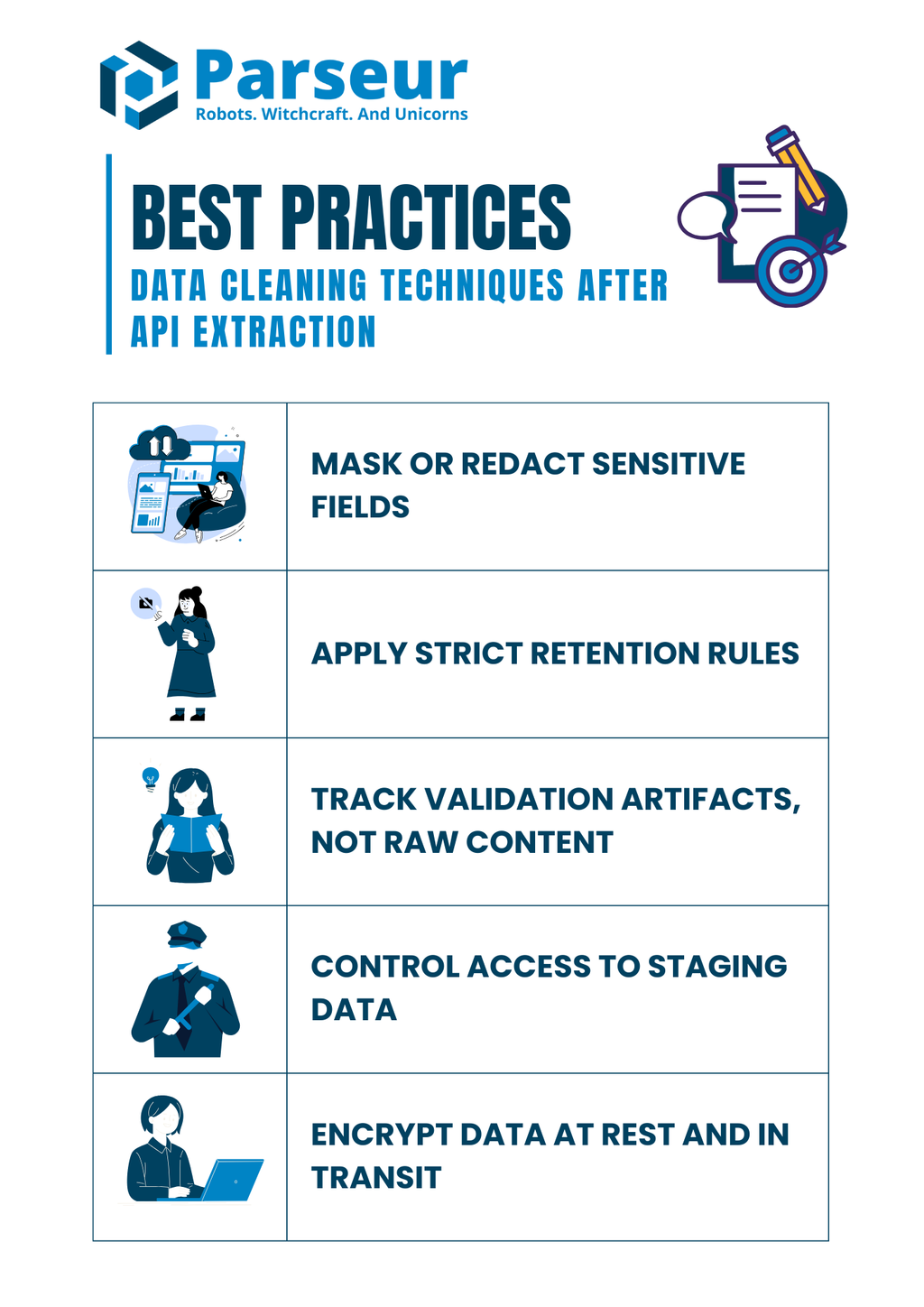

Sécurité et conformité (Ne supprimez pas les contrôles en nettoyant)

Le nettoyage de données n’a pas qu'une finalité technique : il implique la conformité. Les documents extraits contiennent souvent des champs sensibles (bancaire, fiscal, RH). Une mauvaise gestion lors du post-traitement vous expose avant même l’arrivée en entrepôt.

Des études de Mitratech révèlent que 61% des organisations subissent fuites, inefficacités et incidents de conformité à cause d’une gouvernance défaillante, d’où l’absolue nécessité de sécuriser le nettoyage pour garantir à la fois la qualité des données et la conformité réglementaire.

Quelques pratiques pour garantir la conformité pendant le nettoyage :

- Masquez ou censurez les champs sensibles — Interdisez tout identifiant brut (NIR, CB...) dans vos logs ; optez pour le masquage ou le hashage.

- Appliquez une rétention stricte — Ne stockez jamais un fichier d’extraction brute plus que nécessaire : ajustez votre fenêtre de retention selon le RGPD ou vos obligations internes.

- Tracez sur l’erreur, pas sur le contenu — Conservez l’information sur la cause de rejet (champ manquant...) mais jamais le document source.

- Contrôlez les accès sur la zone de staging — Segmentez sur le rôle : seuls les utilisateurs légitimes accèdent/peuvent modifier les intermédiaires sensibles.

- Chiffrez au repos comme en transit — Tout ce qui circule ou dort (bases, fichiers, logs) est crypté, pour limiter l’exposition des données.

Le respect strict des contrôles de sécurité protège l’organisation d’amendes réglementaires et préserve la confiance client.

Exemple pratique (Assembler toutes les étapes)

Pour rendre le process concret, parcourons un exemple simple combinant validation, normalisation, rapprochement et tests dans une chaîne unique. Imaginons que vous utilisiez l’API Parseur pour extraire des données de facture depuis un PDF ou un email. Parseur délivre un JSON structuré à partir de documents non structurés, parfait pour initier votre nettoyage.

Exemple de JSON extrait (entrée) :

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

Étape 1 : Validation du schéma avec Pydantic :

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# Définir le modèle de ligne

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Définir le modèle de facture

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# Exemple de chaîne JSON brute

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# Parser le JSON dans le modèle Invoice

invoice = Invoice.model_validate_json(raw_json)

# Normaliser les lignes en DataFrame Pandas

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# Vérifier les totaux

if round(df["amount"].sum(), 2) != invoice.total:

print("Erreur : la somme des lignes ne correspond pas au total de la facture")

else:

print("Totaux cohérents ✅")

print(df)

Étape 3 : Tests qualité avec Great Expectations :

import great_expectations as gx

# Initialiser le contexte Great Expectations

context = gx.get_context()

# Charger le DataFrame Pandas dans un batch

batch = context.sources.pandas_default.read_dataframe(df)

# Obtenir un validateur pour lancer les expectations

validator = batch.get_validator()

# Définir les expectations

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# Exécuter la validation et récupérer les résultats

results = validator.validate()

print(results)

Sortie (nettoyée) :

- Les données de facture sont validées contre un schéma.

- Dates et numériques sont correctement typés.

- Les totaux sont rapprochés avec contrôle de tolérance.

- Les tests qualité confirment la structure et les valeurs.

Ce pipeline de bout en bout démontre comment transformer une sortie d’API brute en dataset propre, fiable et prêt pour la production grâce à une validation rapide et un nettoyage déterministe.

Le nettoyage des données n’est qu’une étape dans la création d’un pipeline de données fiable : tout commence par une extraction structurée et précise depuis vos documents. C’est là que Parseur fait la différence. Grâce à sa plateforme intuitive et à son API flexible, vous extrayez automatiquement les données de PDF, emails, tableurs ou pièces jointes, allégeant la charge manuelle. Une fois capturées, appliquez les techniques détaillées dans ce guide pour garantir structuration, exactitude et exploitabilité.

Enfin, Gartner prédit qu’à l’horizon 2026, 70 % des nouveaux déploiements cloud s’appuieront sur des écosystèmes de données intégrés au lieu de solutions composites manuelles. Cette évolution souligne l’importance stratégique des données propres, structurées, et des workflows d’extraction pilotés par API.

Pour une vision d’ensemble, nous avons rassemblé une ressource complète sur la transformation du traitement documentaire par les API : comment choisir son outil et bâtir l’automatisation optimale. Plongez dans notre guide complet sur les API d'extraction de données pour les documents pour maîtriser la chaîne complète, du fichier brut à la donnée exploitable.

Foire aux questions

Avant de conclure, voici quelques questions fréquemment posées sur le nettoyage des données après extraction par API. Ces réponses rapides traitent des pièges courants et des préoccupations pratiques auxquels les équipes sont souvent confrontées.

-

Dois-je supprimer les lignes avec des totaux manquants ?

-

Je privilégie la mise en quarantaine et l'investigation plutôt que leur suppression pure et simple. Les totaux sont des champs financiers critiques, et les supprimer silencieusement peut fausser les rapports. Les garder dans un espace de revue assure transparence et résolution appropriée.

-

Comment garantir un JSON valide avant le nettoyage ?

-

Validez avec JSON Schema ou Pydantic pour confirmer que les données entrantes sont lisibles par machine et correspondent aux champs attendus. Détecter un JSON malformé tôt évite de perdre du temps sur des corrections ultérieures.

-

Puis-je tester la qualité sans entrepôt de données ?

-

Oui. Des outils comme Great Expectations ou Pandera vous permettent d'appliquer des règles directement dans vos pipelines Python ou workflows CI/CD. Ainsi, vous pouvez maintenir la qualité même avant que les données n'atterrissent dans votre entrepôt.

-

Que faire si les tableaux ne correspondent pas au total de la facture ?

-

Mettez en place une règle de rapprochement pour comparer la somme des éléments aux totaux de la facture dans une plage de tolérance. Toute divergence doit être signalée et envoyée pour révision plutôt qu'écrasée.

-

Les tests DBT sont-ils nécessaires si je teste en amont ?

-

Oui. Les tests DBT apportent un filet de sécurité supplémentaire en codifiant les contraintes au niveau du modèle. Même si des contrôles amont existent, cette approche de défense en profondeur prévient l'entrée de données insuffisantes dans l'analytique de production.

-

Comment gérer les problèmes d'encodage venant d’exports CSV ?

-

Définissez toujours explicitement le délimiteur, l’encodage et les caractères de citation durant le parsing. DuckDB et d'autres outils similaires peuvent vous aider à diagnostiquer des fichiers compliqués et garantir la cohérence lors de la normalisation de données provenant de différentes sources.

Dernière mise à jour le