Wichtigste Erkenntnisse

- Die Datenextraktion kann unübersichtliche Resultate liefern, die eine sorgfältig geplante Validierung und Nachbearbeitung erfordern.

- Eine verlässliche Pipeline umfasst Schema-Validierung, Normalisierung, Textbereinigung, Tabellenabstimmung, Duplikaterkennung und kontinuierliche Qualitätssicherung.

- Tools wie JSON Schema, Pydantic, Pandas und Great Expectations automatisieren und stärken die Nachbearbeitung.

- Die Parseur API ermöglicht die schnelle Erfassung und Strukturierung von Daten, sodass Teams sich auf Qualität und Analyse fokussieren können.

Datenbereinigungstechniken beschreiben den Prozess zur Korrektur, Standardisierung und Validierung von Rohdaten, die mittels APIs bereitgestellt werden. Auch wenn Extraktionstools unstrukturierte Quellen wie PDFs, Bilder oder E-Mails in strukturierte Formate (z. B. JSON oder CSV) umwandeln, enthalten die Ergebnisse häufig Inkonsistenzen, Nullwerte, falsche Typen, Duplikate oder Formatierungsfehler. Eine konsequente Bereinigung stellt sicher, dass Ihre Datensätze dem benötigten Schema entsprechen und zuverlässig für Reporting, Analysen und Downstream-Prozesse eingesetzt werden können.

Eine aktuelle Fallstudie von DataXcel ergab, dass 14,45 % der extrahierten Telefonaufzeichnungen ungültig oder inaktiv waren – ein klares Signal, wie wichtig nachhaltige Datenbereinigungstechniken zur Fehlervermeidung und Sicherung der Datenqualität sind.

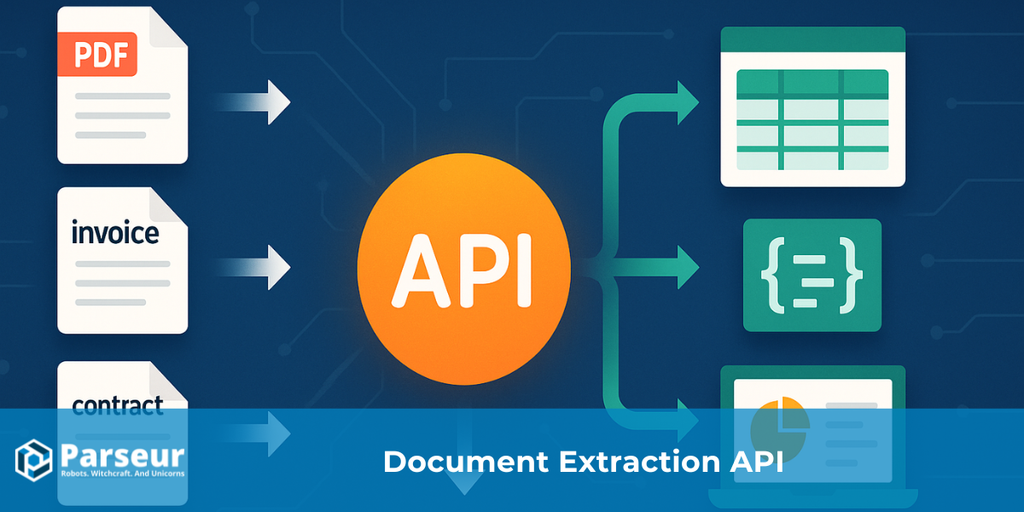

APIs, die Daten aus PDFs, Bildern oder E-Mails extrahieren, liefern üblicherweise strukturierte Formate wie JSON oder CSV. Dadurch werden Rohinformationen effizienter nutzbar – aber das Resultat ist selten fehlerfrei. Teams begegnen häufig fehlenden Werten, inkonsistenten Feldnamen, gemischten Datentypen, Duplikaten oder Notationsproblemen bei Datumsangaben. Unbereinigte Fehler beeinträchtigen Analysen, Reportings und finanzielle Entscheidungen.

Dieser Leitfaden liefert Ihnen einen praxisnahen Ansatz, wie Sie aus chaotischen Extraktionen zuverlässige Datensätze erzeugen: validieren, standardisieren, anreichern, testen und lückenlos protokollieren. Für alle, die mit E-Mail- oder PDF-Anhängen arbeiten, vereinfacht Parseur die Datenerfassung und schafft Freiraum für die eigentliche Datenqualitätssicherung.

Möchten Sie erfahren, wie Datenextraktions-APIs von Grund auf funktionieren? Lesen Sie unseren umfassenden Leitfaden: Was ist eine Datenextraktions-API für Dokumente?

Arten von Datenbereinigungstechniken

Nach der Extraktion durch eine Datenextraktions-API weisen Rohdaten oft Inkonsistenzen, fehlende Werte, Formatierungsfehler oder Duplikate auf. APIs, die unstrukturierte Dateien wie PDFs, Bilder oder E-Mails in strukturierte Formate wie JSON oder CSV umwandeln, liefern Daten, die dennoch gezielt bereinigt werden müssen, um Verlässlichkeit zu erreichen.

Eine Studie der Harvard Business Review ergab, dass nur 3 % der Unternehmensdaten grundlegende Qualitätsstandards erfüllen, während 47 % neuer Datensätze mindestens einen kritischen Fehler aufweisen. Die Folgen sind real: Nach Gartner verursachen Datenqualitätsprobleme durchschnittliche Kosten von 15 Millionen US-Dollar pro Jahr.

Eine gezielte Anwendung effektiver Datenbereinigungstechniken ist daher entscheidend, damit Ihre Daten korrekt, konsistent und für Analysen nutzbar sind. Zu den gängigsten Methoden gehören:

Validierung und Fehlerüberprüfung

Prüfen Sie, ob die extrahierten Daten erwarteten Formaten wie Datums-, Zahlen- oder E-Mail-Feldern entsprechen. Das verhindert Fehler bei Analyse und Reporting und sorgt für verlässliche Ausgaben nach der Datenextraktion.

Standardisierung

Bringen Sie Daten in einheitliche Formate – etwa für Telefonnummern, Anschriften oder Datumsschreibweisen. So werden Datensätze leichter kombinier- und vergleichbar.

Umgang mit fehlenden Werten

Behandeln Sie Null- und Fehlwerte je nach Verwendungszweck: durch Auffüllen, Interpolation oder Entfernen fehlerhafter Einträge.

Duplikaterkennung

Eliminieren Sie doppelte Datensätze, die durch mehrfache API-Abfragen oder überlappende Datenquellen entstehen können. Das verbessert die Korrektheit und Verlässlichkeit des Gesamtbestands.

Datenanreicherung

Ergänzen Sie die extrahierten Daten um Kontext – etwa durch Hinzufügen von Geoinformationen, Klassifikationen oder zusätzlichen Attributen.

Format- und Typkorrektur

Sichern Sie Konsistenz durch Korrektur falsch formatierter Werte, Umwandlung von Strings zu Zahlen, Korrekturen bei der Rechtschreibung oder Vereinheitlichung von Währungen.

Protokollierung und Audit

Dokumentieren Sie jeden Bereinigungsschritt, um Qualität und Integrität Ihrer API-Extraktionen nachvollziehbar zu halten.

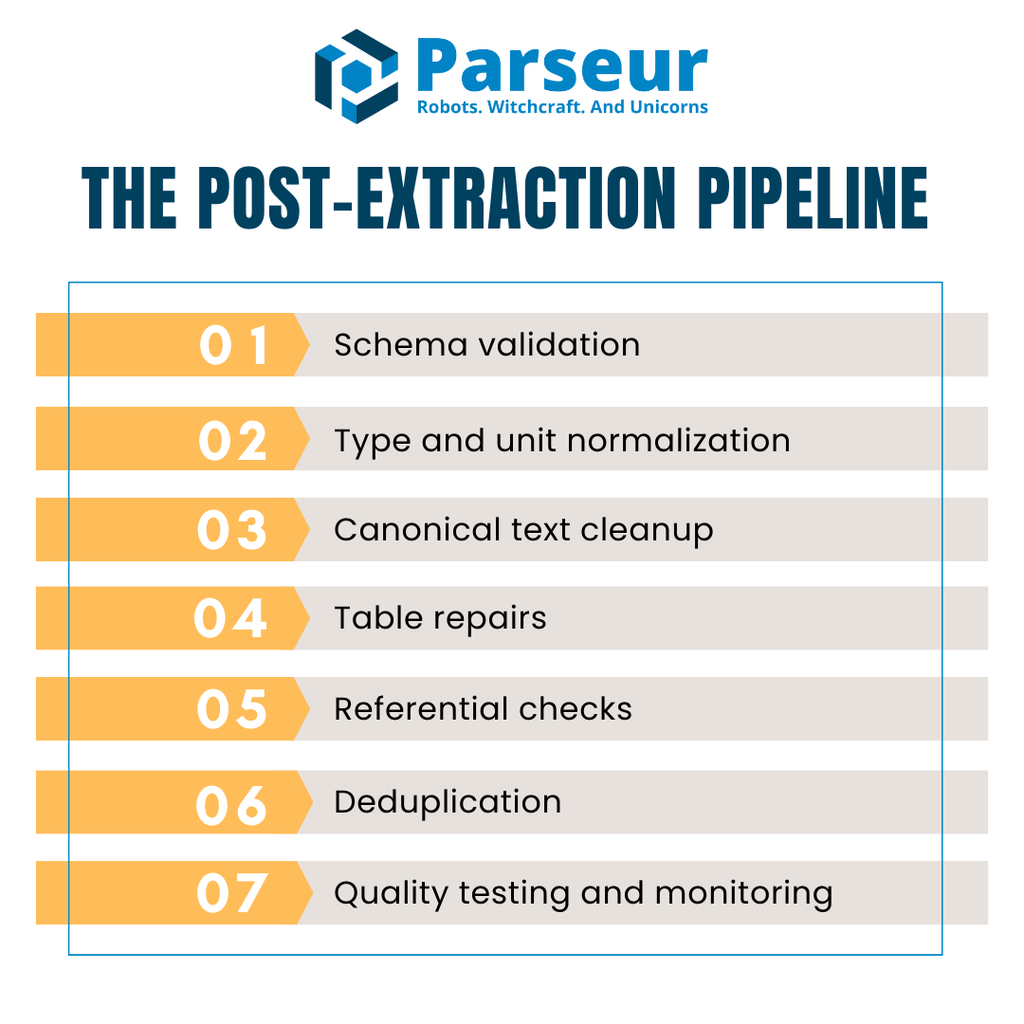

Die Pipeline nach der Extraktion (Überblick)

API-Extraktionen liefern selten Rohdaten, die direkt für Reporting oder Analysen einsetzbar sind. Es gibt oft fehlende Felder, abweichende Datentypen, Inkonsistenzen, Tabellenprobleme oder Duplikate. Eine strukturierte Pipeline, die in jeder Runde gleich angewendet wird, schützt vor der Weitergabe von Fehlern und steigert die Qualität.

Eine praxiserprobte Pipeline nach der Extraktion gliedert sich üblicherweise in diese Hauptphasen:

- Schema-Validierung: Sicherstellen, dass eingehendes JSON oder CSV der erwarteten Struktur entspricht – noch vor weiteren Schritten.

- Typ- und Einheits-Normalisierung: Datentypen durchsetzen, fehlende Werte gezielt behandeln, einheitliche Einheiten und Formate verwenden.

- Kanonische Textbereinigung: Strings vereinheitlichen, Groß-/Kleinschreibung anpassen und Unicode-Probleme lösen.

- Tabellenreparatur: Konsistente Kopfzeilen, strukturierte Zeilen und Abgleich von Summen in Rechnungen und Quittungen.

- Referenzielle Prüfungen: Überprüfung der Beziehungen zwischen Tabellen – z. B. Lieferanten, Währungen oder Steuersätzen.

- Duplikaterkennung: Erkennen und Entfernen doppelter Einträge bei gleichzeitiger Vermeidung unerwünschter Löschungen.

- Qualitätstests und Monitoring: Automatisierte Prüfungen, um Fehler frühzeitig zu erkennen und produktive Systeme zu schützen.

Viele Teams nutzen effiziente spaltenorientierte Speicherformate wie Apache Arrow oder Parquet in der Bereinigungsphase. Das erlaubt schnellere Analysen und besseren Speicherverbrauch, besonders bei großen Rechnungs- und Transaktionsdatenbeständen.

Stellen Sie sich Ihre Pipeline als gestaffelte Schwimmbahnen vor: API → Validierung → Bereinigung → QA → Warehouse. So sichern Sie Konsistenz und vermeiden unerwartete Datenprobleme oder Kosten.

Schritt 1: Schema-Validierung (Müll früh aussortieren)

Am Ausgangspunkt der Datenbereinigungstechniken steht die Schema-Validierung. Sie stellt sicher, dass angelieferte Daten maschinenlesbar und strukturell passend sind. Werden ungültige Datenarten nicht sofort abgefangen, schleichen sich später schwer auffindbare Fehler ein.

Ein bewährter Standard ist **JSON Schema (Draft 2020-12)**. Das Framework ist portabel, anbieterunabhängig und in vielen Ökosystemen etabliert. Mit JSON Schema beschreiben Sie gewünschte Felder, Datentypen und Pflichtwerte: z. B. dass invoiceDate ISO 8601 entsprechen und total stets ≥ 0 sein muss.

Bei Python-Projekten übernimmt Pydantic v2 die Validierung zur Laufzeit – samt automatischer Generierung von JSON-Schema-Strukturen. Eigene Datenmodelle sorgen dafür, dass Fehler bei Rechnungen oder Einzelposten sofort aufgedeckt werden: vendorName als String, invoiceNumber nach Regex, currency nach Codesatz (USD, EUR, GBP).

Gute Validierungsregeln gehen über reine Typprüfung hinaus: Definieren Sie erlaubte Werte (Enumerationen), Formatregeln per Regex (z. B. Steuernummern) und Zahlenbereiche (Summen, Mengen). So blocken Sie auch subtile Datenfehler effektiv ab.

Planen Sie den Umgang mit fehlerhaften Datensätzen: Manche Teams lehnen sie unmittelbar ab, andere verschieben sie zur späteren Überprüfung in eine Dead-Letter-Queue. Eine Fail-fast-Strategie garantiert, dass nur zuverlässige Daten die nachfolgende Bereinigung erreichen.

Schritt 2: Typen, Nullwerte und Einheiten bereinigen

Ist das Schema validiert, folgt die Korrektur von Datentypen, die Behandlung von Nullwerten und die Normalisierung von Einheiten. APIs liefern Felder oft nicht getypt aus (z. B. Zahlen als Text, uneinheitliche Datumsformate) oder lassen Nullfelder stehen. Werden diese Abweichungen nicht früh bereinigt, werden Analysen und Reportings unzuverlässig.

Mit der Parseur API lassen sich Rechnungs-, Quittungs- und E-Mail-Daten direkt als sauber strukturiertes JSON extrahieren. Die natürlichen Webhooks liefern strukturierte Daten direkt an ERP-, CRM- oder Datenbanken und reduzieren so manuelle Vorverarbeitung – die Pipeline wird robuster gegen Fehler.

Zunächst werden Felder dem richtigen Datentyp zugewiesen. Mengen- und Preisfelder (quantity, unitPrice) werden zu Zahlen, Datumsangaben (invoiceDate, dueDate) korrekt geparst. Auch boolesche Felder wie paid oder approved werden auf true/false normalisiert.

Wählen Sie eine konsistente Strategie für fehlende Werte:

- Löschen: Entfernen nicht-kritischer, unvollständiger Zeilen.

- Füllen: Fehlende Werte mit Defaults, Mittelwerten oder Platzhaltern ergänzen.

- Markieren: Fehlende Felder zum späteren Review kennzeichnen statt sie unbemerkt zu überschreiben.

Dokumentieren Sie die Vorgehensweise für jedes relevante Feld und bleiben Sie konsistent.

Mit Pandas gelingt die Umsetzung rasch: Methoden wie to_numeric(errors="coerce"), to_datetime(), fillna() oder dropna() standardisieren jede Spalte und behandeln Nullwerte systematisch.

Die konsequente Bereinigung bei Typen, Nullwerten und Einheiten ist die Basis für alle weiteren Schritte der Datenbereinigungstechniken, etwa bei Textbereinigung, Tabellenabgleich und referenziellen Prüfungen.

Schritt 3: Kanonisierung von Text (Namen, Groß-/Kleinschreibung, Unicode)

Nach Typ- und Einheitsbereinigung steht die Standardisierung von Textfeldern an. Uneinheitliche Schreibweisen, Abstände, Groß-/Kleinschreibung oder Codierungen erschweren Gruppierungen und Vergleiche: Ein Lieferant kann unter zig Varianten auftreten.

Entfernen Sie überflüssige Leerzeichen und Ausreißerzeichen und standardisieren Sie Satzzeichen. Normalisieren Sie die Groß-/Kleinschreibung – z. B. Firmennamen auf Title Case, Status-Werte auf Großbuchstaben.

Mit Unicode-Normalisierung (z. B. NFKC) beseitigen Sie Unterschiede in der hinterlegten Zeichenkodierung, selbst wenn die Darstellung ähnlich aussieht. Für internationale Listen sollten Sie Akzente bei Vergleichen entfernen, um "Café" und "Cafe" als gleich zu erkennen.

Für wichtige Felder bietet sich eine Kanonisierungsliste an – einfache Regeln wie das Ersetzen von "Inc." durch "Incorporated", bis hin zu ML-basierten Methoden für komplexe Entitäten.

Systematisches Kanonisieren verhindert Dubletten und sorgt für konsistente, vergleichbare Daten – ein Schlüsselschritt in Ihrer Bereinigungspipeline.

Schritt 4: Tabellen reparieren (Positionen müssen aufgehen)

Tabellen mit Einzelpositionen benötigen häufig das meiste Feintuning nach der API-Extraktion. Kopfzeilen sind vielleicht auf mehrere Zeilen verteilt, Zellen aus gescannten PDFs verkeilt oder Werte zusammengeführt.

Statten Sie jede Tabelle mit eindeutigen, konsistenten Kopfzeilen aus, die klar auf Ihr Schema passen. Danach harmonisieren Sie Einheiten (z. B. Gewicht, Währungen) und rechnen alles auf Standardcodes um. Die Zeilenberechnung amount = quantity × unitPrice ist bei Rechnungsdaten essenziell, um korrekte Beträge abzusichern. Überprüfen Sie zudem, dass die Endsummen der Zeilen mit dem Gesamtrechnungswert übereinstimmen und Differenzen sofort auffallen.

Beim Export nach CSV können versteckte Trennzeichen, Anführungsstriche oder Codierungsprobleme die Spaltenstruktur gefährden. Nutzen Sie flexible Tools wie DuckDB und geben Sie Trennzeichen, Anführungszeichen oder Zeichencodierung explizit an. Mit Modi wie all_varchar laden Sie selbst problematische Dateien sicher und machen die Typisierung danach.

So verwandeln Sie auch semichaotische Extraktionen in vertrauenswürdige Tabellen, denen Finanz- und Analyseteams wirklich vertrauen können.

Schritt 5: Referenzielle und betriebliche Regeln

Nicht selten treten Fehler erst beim Blick auf Beziehungen zwischen Tabellen auf, auch wenn einzelne Zeilen formal gültig erscheinen. Referenzielle Prüfungen stellen sicher, dass Werte konsistent sind und betriebliche Vorschriften berücksichtigt werden, bevor die Aufbereitung finalisiert wird.

Damit etwa keine phantomhaften Lieferanten entstehen, muss jede vendorId aus einer Rechnungstabelle im Lieferantenstamm existieren, zulässige Währungscodes geprüft und Steuersätze mit Anforderungen der Jurisdiktion abgestimmt werden. Solche Prüfungen verhindern inkonsistente Berichte, Compliance-Verletzungen und technische Fehler in Joins.

Moderne Data-Teams setzen diese Regeln zunehmend direkt in Transformationsebenen um. DBT-Tests machen es leicht, Constraints wie folgende zu kodifizieren:

- unique (keine doppelten Rechnungsnummern),

- not_null (Pflichtfelder wie vendorId müssen befüllt sein),

- accepted_values (z. B. Währungen: USD, EUR usw.),

- relationships (Fremdschlüssel wie vendorId müssen als gültig hinterlegt sein).

Das Einbinden referenzieller Integrität in automatisierte Tests bietet Teams Defense-in-Depth: Probleme tauchen sofort auf – nicht erst Wochen später im Finanzreview. Manual Checks werden so zu wiederholbaren, skalierbaren Prozessen, die die Berichtssicherheit und Compliance stärken.

Schritt 6: Duplikaterkennung und Record Linkage

Duplikate untergraben die Glaubwürdigkeit Ihrer Daten, führen zu doppelten Zahlungen, Fehlern in Summen und erschweren Audits. Ziel ist, echte Dubletten zu entfernen und legitime Wiederholen nicht versehentlich zu löschen.

Definieren Sie deterministische Schlüssel – für Rechnungen etwa Kombinationen wie supplierName, invoiceNumber, invoiceDate, amount, currency. Bei exakter Übereinstimmung aller Felder ist der Fall klar.

Doch oft ähneln sich Duplikate nur: Mit Fuzzy-Matching (z. B. Rechnungen desselben Lieferanten innerhalb von sieben Tagen mit kleiner Betragsabweichung) markieren Sie verdächtige Fälle ohne echte Rechnungen zu verlieren.

Grenzen Sie zwischen syntaktischem Matching (Vergleich der Zeichenketten) und semantischem Matching ("Acme Corp." = "ACME Corporation") ab. OpenRefine nutzt Clustering, um ähnliche Datensätze zu gruppieren und Duplikatvorschläge bereitzustellen.

Durch die Kombination aus festen, Fuzzy- und semantischen Regeln erzielen Sie höchste Präzision bei geringstmöglichem Risiko versehentlicher Löschungen.

Schritt 7: Datenqualitätsprüfungen automatisieren

Datenqualität ist eine Daueraufgabe. Trotz gründlicher Bereinigungen werden laufend neue Extraktionen mit frischen Fehlern eingespeist. Die Automation von Qualitätsprüfungen garantiert, dass Probleme erkannt werden, bevor sie den Bericht oder operative Ketten beeinflussen.

Eine verlässliche Option ist Great Expectations (GX). GX erlaubt Teams, präzise Regeln (Expectations) zu definieren: z. B. ob Rechnungsnummern Mustern entsprechen, Mengen und Beträge im zulässigen Bereich liegen oder Tabellen die richtige Zeilenzahl aufweisen. Die Checks können Teil der CI/CD-Pipeline werden und liefern sofortiges Extraktions-Feedback.

Für Python-native Pipelines bietet Pandera eine leichte Möglichkeit, Datentypen, Wertebereiche und Nullbarkeit direkt auf Pandas DataFrames zu prüfen. Mit wenigen Zeilen Code lassen sich ungültige Zeilen ablehnen oder Warnungen bei Abweichungen ausgeben.

Automatisierung ist nur so gut wie ihre Sichtbarkeit. Leiten Sie Testergebnisse an Dashboards oder Alarmsysteme weiter, damit Stakeholder den Prozentsatz ungültiger Zeilen, Pass/Fail-Ergebnisse und Fehler schnell erkennen. So werden Korrekturen priorisiert.

Messbare und kontinuierliche Datenqualitätsprüfungen sorgen dafür, dass Ihre bereinigten Datensätze immer korrekt, konsistent und produktionsreif bleiben.

Performance- und Speichertipps (damit die Datenbereinigung nicht zum Engpass wird)

Auch die besten Datenbereinigungstechniken dürfen nicht zum Performance-Problem werden. Bei großen Mengen an Rechnungen, Quittungen oder Transaktionsdaten drohen ansonsten Verzögerungen, Mehrkosten und Frust. Ziel bleibt: Qualitätssicherung, ohne die Geschwindigkeit auszubremsen.

Studien von MDPI zeigen, dass Datenbereinigung bis zu 80 % der Zeit eines Datenprofis beanspruchen kann, was ihren großen Einfluss auf die Effizienz der gesamten Datenverarbeitung verdeutlicht. Das zeigt, wie wichtig eine Optimierung der Bereinigungsprozesse für die Pipeline-Performance ist.

Hier sind einige praktische Wege, um die Performance Ihrer Pipeline im Griff zu behalten:

- Spaltenorientierte Speicherformate verwenden – Formate wie Apache Arrow oder Parquet erlauben schnelle Vektorberechnung und sparen Speicher. Die Integration mit Analyseengines und Python-Bibliotheken funktioniert reibungslos.

- Batch- & Parallelverarbeitung – Statt einzelne Zeilen nacheinander zu verarbeiten, arbeiten Sie mit Batch-Jobs oder asynchronen Tasks direkt aus dem Extraktor, um viele Dateien parallel einzulesen und Wartezeiten zu vermeiden.

- Warehouse-native Tools nutzen – Großvolumige CSVs und komplexe Joins erledigen Sie idealerweise mit DuckDB oder direkt im Data Warehouse – die lokale Pipeline wird entlastet.

- Cachen von Zwischenergebnissen – Falls bestimmte Checks oder Normalisierungen wiederholt ausgeführt werden müssen, sparen Caches erneute Verarbeitung und machen die Pipeline effizient.

- Systemressourcen überwachen – Prüfen Sie regelmäßig CPU-, Speicher- und I/O-Auslastung zur schnellen Engpassidentifikation.

Eine effiziente Bereinigungspipeline balanciert Genauigkeit mit Skalierbarkeit. Der Einsatz spaltenorientierter Formate, Batching und clevere Ressourcennutzung hält Ihre Validierungs- und Bereinigungsschritte schnell genug für Echtzeit-Analysen und Reporting.

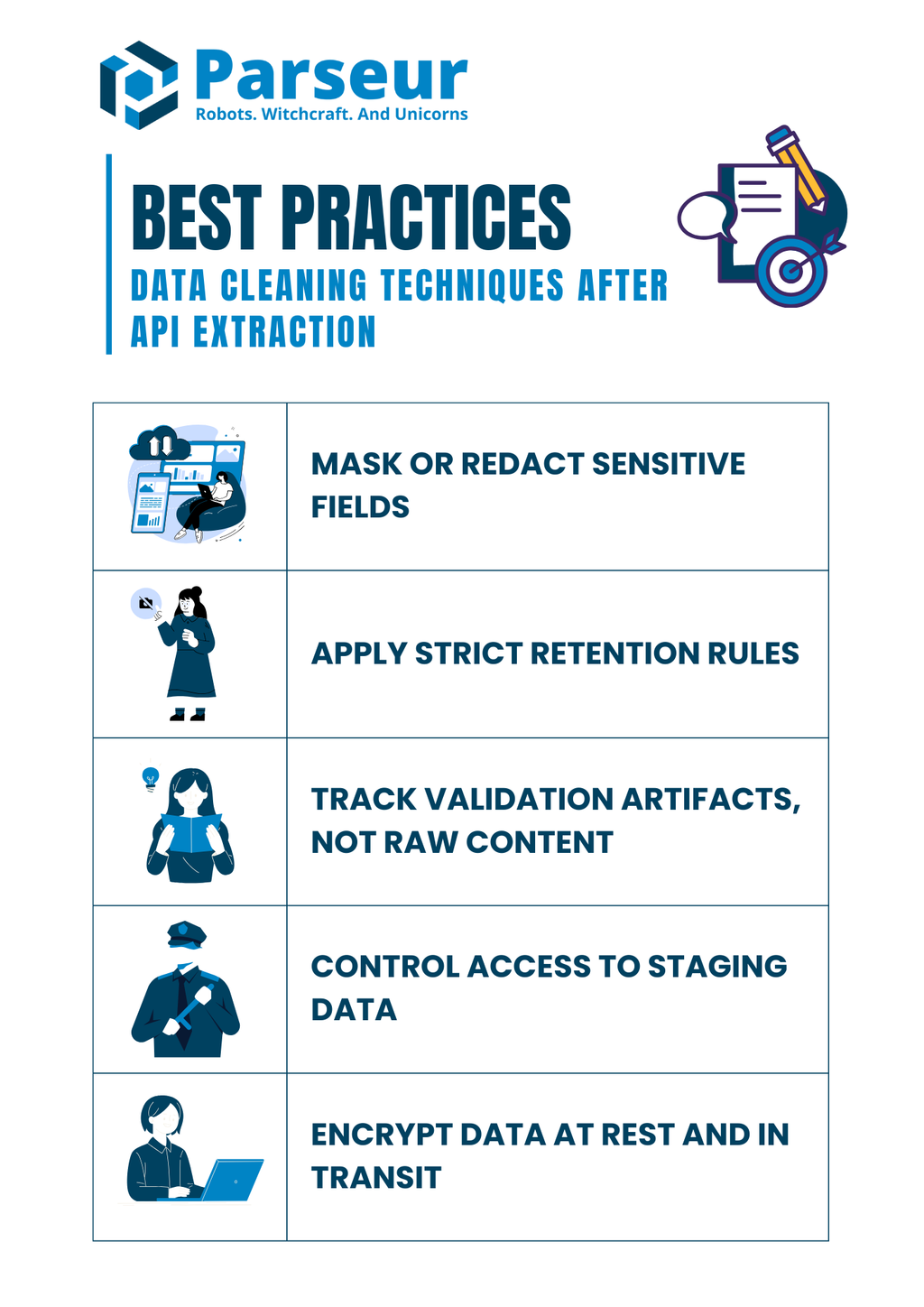

Sicherheits- und Compliance-Hinweise (keine Kontrollen wegbereinigen)

Datenbereinigung geht weit über Fehlerbeseitigung hinaus – auch Datenschutz und Compliance sind entscheidend. Extrahierte Dokumente enthalten oft sensible Inhalte wie Kontodaten, Steuer-IDs oder persönliche Informationen. Fehlerhafte Behandlung kann vor dem Laden ins Warehouse schon rechtliche Risiken erzeugen.

Forschung von Mitratech zeigt, dass 61 % der Unternehmen Datenpannen, Ineffizienzen und Compliance-Verstöße durch schlechte Governance erleben. Das unterstreicht, wie wichtig solide Datenbereinigungspraktiken für Datenqualität und regulatorische Anforderungen sind.

Best Practices für einen compliant-gerechten Bereinigungs-Workflow:

- Sensible Felder maskieren/schwärzen – Keine Klartext-IDs, Kreditkartennummern oder Kontodetails loggen. Stattdessen maskieren/hashen – auch im Audit.

- Strikte Aufbewahrungsfristen umsetzen – Halten Sie Rohdaten nur so kurz wie nötig und entsprechend der Regulierungsvorgaben.

- Validierungsartefakte statt Rohdaten speichern – Dokumentieren Sie, was fehlgeschlagen ist (Grund, Typ), verzichten Sie aber möglichst auf Speicherung sensibler Dokumente.

- Zugriff auf Zwischendaten klar regeln – Rollenbasierte Rechte gewährleisten, dass nur autorisierte Nutzer Einblick oder Änderungsrechte haben.

- Daten verschlüsseln, lokal und bei der Übertragung – Verschlüsseln Sie alle temporären wie permanenten Datenbanken, Dateien und Protokolle.

Starke Compliance-Praktiken laufen parallel zu den technischen Bereinigungsschritten. So schützen Sie sich vor Bußgeldern und bewahren das Vertrauen Ihrer Kunden.

Beispiel aus der Praxis (alle Teile zusammenführen)

Zur Veranschaulichung ein kompaktes Beispiel für eine End-to-End-Bereinigungspipeline: inklusive Validierung, Normalisierung, Summenabgleich und Qualitätstest. Angenommen, Sie extrahieren mit der Parseur API Rechnungsdaten aus PDF oder E-Mail. Parseur liefert Ihnen dabei strukturiertes JSON direkt aus unstrukturierten Dokumenten und bietet den idealen Startpunkt für Ihre Bereinigungspipeline.

Beispiel extrahiertes JSON (Input):

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

Schritt 1: Schema mit Pydantic validieren:

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# Line-Item-Modell definieren

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Rechnungsmodell definieren

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# Beispiel-Roh-JSON-String

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# JSON ins Invoice-Modell einlesen

invoice = Invoice.model_validate_json(raw_json)

# Line-Items zu einem Pandas DataFrame normalisieren

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# Summen prüfen

if round(df["amount"].sum(), 2) != invoice.total:

print("Abweichung: Positionen summieren sich nicht auf die Rechnungsendsumme")

else:

print("Summen stimmen überein ✅")

print(df)

Schritt 3: Qualitätstests mit Great Expectations:

import great_expectations as gx

# Great Expectations-Kontext initialisieren

context = gx.get_context()

# DataFrame als Batch laden

batch = context.sources.pandas_default.read_dataframe(df)

# Validator holen

validator = batch.get_validator()

# Erwartungen setzen

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# Validierung ausführen und Resultate erfassen

results = validator.validate()

print(results)

Resultat (bereinigt):

- Rechnungsdaten werden am Schema geprüft.

- Datumsangaben und Zahlen korrekt typisiert.

- Summen stimmen mit Rechnungsendsumme überein.

- Qualitätstests sichern Wertebereiche und Struktur.

Das Beispiel zeigt, wie Teams innerhalb der Pipeline API-Ausgaben frühzeitig validieren, systematisch bereinigen und das Resultat zuverlässig weiterverwenden – bereit für produktive Analytics.

Die Datenbereinigung ist nur ein Teil einer verlässlichen Pipeline – den Anfang macht eine korrekte, strukturierte Datenerfassung Ihrer Dokumente. Genau dort kommt Parseur ins Spiel. Mit seiner intuitiven Plattform und der flexiblen Parseur API extrahieren Sie automatisch Daten aus PDFs, E-Mails, Tabellen und Anhängen. Nach erfolgreicher Erfassung können die in diesem Leitfaden beschriebenen Bereinigungstechniken angewendet werden, damit Ihre Daten sauber, konsistent und analysierbar sind.

Ein Blick nach vorn: Gartner prognostiziert, dass bis 2026 70 % neuer Cloud-Deployments auf ganzheitliche Datenökosysteme statt auf isolierte Einzellösungen setzen werden. Die Nachfrage nach bereinigten, strukturierten Daten und reibungslosem, API-gesteuertem Datenimport steigt damit weiter.

Sie wollen das große Ganze verstehen? Unser umfassender Guide zeigt, wie APIs die Dokumentenverarbeitung transformieren, welches Tool zu Ihrem Workflow passt und wie Sie Ihre Pipeline optimieren. Entdecken Sie unseren Datenextraktions-API-Guide für Dokumente – und lernen Sie, wie Sie von chaotischen Rohdateien zu sauberer, verwertbarer Information gelangen.

Häufig gestellte Fragen

Bevor wir abschließen, hier einige häufig gestellte Fragen zur Datenbereinigung nach der API-Extraktion. Diese kurzen Antworten behandeln typische Fallstricke und praktische Herausforderungen, denen Teams oft begegnen.

-

Sollte ich Zeilen mit fehlenden Summen entfernen?

-

Ich bevorzuge Quarantäne und Untersuchung statt ein sofortiges Löschen. Summen sind kritische Finanzfelder, und das unbemerkte Entfernen kann Berichte verzerren. Die Aufnahme in einen Review-Bereich gewährleistet Transparenz und eine ordnungsgemäße Klärung.

-

Wie garantiere ich gültiges JSON vor der Bereinigung?

-

Validieren Sie mit JSON Schema oder Pydantic, um sicherzustellen, dass eingehende Daten maschinenlesbar sind und den erwarteten Feldern entsprechen. Das frühzeitige Erkennen von fehlerhaftem JSON verhindert zeitraubende spätere Korrekturen.

-

Kann ich Qualität auch ohne Data Warehouse testen?

-

Ja. Tools wie Great Expectations oder Pandera ermöglichen Ihnen, Regeln direkt in Python-Pipelines oder CI/CD-Workflows durchzusetzen. So bleibt die Qualität auch gewahrt, bevor Daten im Data Warehouse landen.

-

Was tun, wenn Tabellensummen nicht mit der Rechnungsendsumme übereinstimmen?

-

Richten Sie eine Abgleichsregel ein, die die Summen der Einzelpositionen innerhalb eines Toleranzbereichs mit der Gesamtsumme der Rechnung vergleicht. Jegliche Abweichung sollte markiert und zur Überprüfung weitergeleitet werden, anstatt überschrieben zu werden.

-

Sind DBT-Tests notwendig, wenn ich bereits aufwärts teste?

-

Ja. DBT-Tests bieten eine zusätzliche Sicherheitsstufe, indem sie Constraints auf Modellebene kodifizieren. Auch wenn es aufwärts Prüfungen gibt, verhindert dieses Defense-in-Depth-Prinzip, dass unzureichende Daten in die Produktionsanalytik gelangen.

-

Wie gehe ich mit Codierungsproblemen bei CSV-Exporten um?

-

Definieren Sie immer Trennzeichen, Codierung und Quellzeichen explizit beim Parsen. DuckDB und ähnliche Tools helfen, schwierige Dateien zu diagnostizieren und Konsistenz bei der Normalisierung von Daten aus mehreren Quellen zu schaffen.

Zuletzt aktualisiert am