Large Language Models (LLM’s) bieden ongeëvenaarde flexibiliteit in het begrijpen van ongestructureerde tekst, waardoor ze ideaal zijn voor redenatie, samenvatting en taken met een laag documentenvolume. Door hun probabilistische karakter, latentie en gebrek aan deterministische precisie zijn ze echter niet geschikt als enige aanpak voor grootschalige, gereguleerde documentautomatisering.

Belangrijkste Inzichten

- Strategische flexibiliteit: LLM’s excelleren in het vertalen van ongestructureerde, nieuwe of sterk variabele documenten, waardoor snellere onboarding en redeneergedreven taken mogelijk zijn.

- Operationele beperkingen: Voor gestructureerde, grootschalige workflows kunnen LLM’s alleen leiden tot fouten, trage verwerking en compliance-risico’s. Deterministische systemen blijven essentieel.

- Hybride voordeel: De meest effectieve documentautomatiseringsstrategieën combineren LLM's met gespecialiseerde platforms zoals Parseur, waarbij AI wordt ingezet voor contextueel begrip en deterministische extractie zorgt voor nauwkeurigheid, schaalbaarheid en compliance.

De Automatiseringsparadox

Large Language Models (LLM’s) hebben natuurlijke taalverwerking fundamenteel vooruit geholpen. Hun vermogen om ongestructureerde tekst te interpreteren, betekenis af te leiden en te generaliseren over verschillende domeinen heeft het speelveld van documentautomatisering vergroot. Taken die voorheen afhankelijk waren van rigide regels of veel handmatige configuratie, worden nu veel flexibeler benaderd.

Beperkingen van LLM’s

Deze flexibiliteit brengt echter een paradox met zich mee voor bedrijven. Terwijl LLM’s uitstekend presteren bij redeneergedreven of kleinschalige taken, tonen standaarden van Hyperscience aan dat ze vaak maar 66-77% exacte match-nauwkeurigheid behalen op belangrijke documenttaken zoals facturen en vrachtbrieven, terwijl gespecialiseerde IDP-systemen 93-98% halen.

Hierdoor is hun flexibiliteit tegelijkertijd een beperking: LLM’s zijn niet ontworpen als system-of-record, waar deterministische precisie, vaste schema’s en voorspelbare prestaties vereist zijn.

Niet-deterministische uitkomsten, variabele latentie door API-rate-limieten en snel oplopende inference-kosten door tokenvolume en GPU-verbruik, maken het moeilijk om LLM-systemen betrouwbaar op te schalen voor productieomgevingen met behoefte aan snelheid, consistentie en voorspelbaarheid.

Groei van Hybride IDP

Documentautomatisering op ondernemingsniveau vereist daarom steeds vaker een hybride benadering. Hybride Intelligent Document Processing (IDP)-architecturen combineren de flexibiliteit van LLM's met de precisie van gespecialiseerde extractie-engines en deterministische logica, wat zorgt voor een optimale balans tussen kwaliteit en efficiëntie.

Dit weerspiegelt het besef dat technologie niet gelijktijdig kan optimaliseren voor flexibiliteit, nauwkeurigheid, kosten en governance. Architecturen waarin reasoning en uitvoering gescheiden zijn, zorgen ervoor dat elk systeemonderdeel op zijn sterkte wordt benut, in plaats van LLM’s te belasten met taken waarvoor ze niet ontworpen zijn.

Volgens Fortune Business Insights zal de wereldwijde IDP-markt groeien van $14,16 miljard in 2026 naar $91,02 miljard in 2034 met een CAGR van 26,20%. Dit illustreert de grote behoefte aan betrouwbare systemen bij ondernemingen met hoge documentvolumes. In deze architecturen worden LLM’s selectief ingezet voor contextueel begrip, terwijl grootschalige extractie, validatie en workflowautomatisering wordt overgelaten aan purpose-built-systemen, gericht op betrouwbaarheid, kosten en compliance.

Het strategisch inzicht is helder: LLM’s zijn een krachtig onderdeel van moderne documentautomatisering, maar geen vervanger van gespecialiseerde engines. Door technologie toe te passen op operationele sterktes, kunnen organisaties efficiënt opschalen zonder concessies te doen aan nauwkeurigheid, compliance of snelheid.

Wat zijn Large Language Models (LLM’s)?

Large Language Models (LLM’s) zijn een type machine learning model dat is ontworpen om natuurlijke taal op grote schaal te begrijpen, genereren en beredeneren. Ze zijn getraind op enorme tekstcorpora met diepe neurale netwerken (voornamelijk transformer-architecturen) die leren om statistische verbanden tussen woorden, zinnen en concepten te herkennen.

LLM’s werken op basis van het voorspellen van het meest waarschijnlijke volgende token (woord of symbool) op basis van een sequentie van voorgaande tokens. Door deze aanpak op miljarden teksten toe te passen, ontwikkelen ze vaardigheden op het gebied van samenvatting, classificatie, vraag-en-antwoord, vertaling en contextuele analyse. Voor documentverwerking betekent dit dat LLM’s vrije tekst kunnen duiden, betekenis over verschillende passages heen kunnen ontdekken en flexibel zijn in het omgaan met variatie in opmaak en stijl.

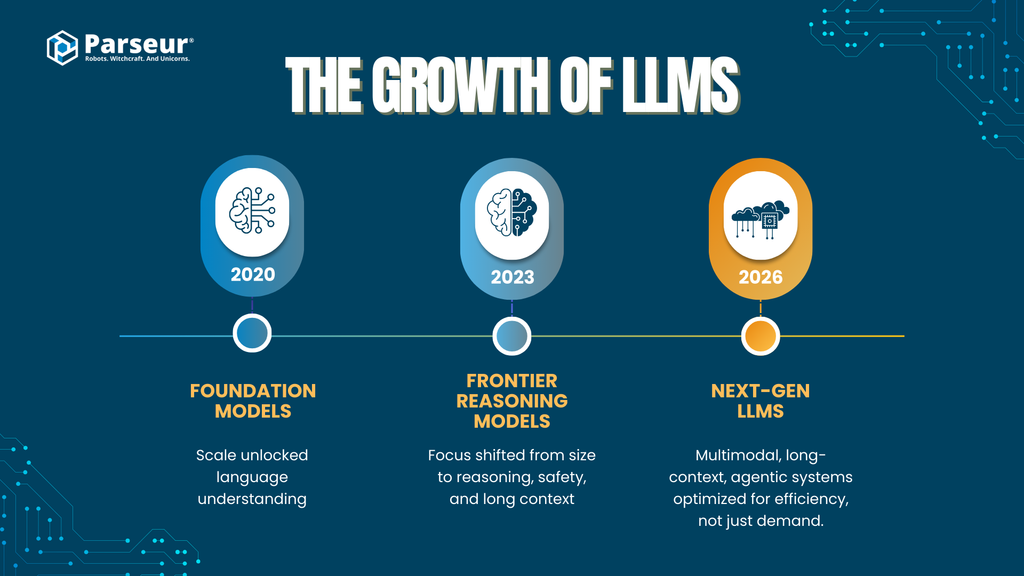

Schaal en Ontwikkeling van LLM’s

De mogelijkheden van LLM’s zijn snel toegenomen door de groei in modelgrootte en verbeterde trainingstechnieken bij de grote AI-ontwikkelaars:

Vroege foundation-modellen (2020–2021)

Modellen als GPT-3 introduceerden grootschalige transformer-netwerken (ca. 175 miljard parameters) en bewezen dat schaal routinematig sterke taalvaardigheden kan opleveren.

Tweede generatie frontline-modellen (2023–2024)

GPT-4, Claude 2/3 (Anthropic), Gemini 1.x (Google) en DeepSeek-LLM leggen meer nadruk op redeneervermogen, veiligheidstuning en langere contextvensters. Terwijl exacte parameter-aantallen zelden worden vermeld, wordt aangenomen dat deze modellen werken op triljoen-parameter-schaal (waarbij mixture-of-experts-architecturen een rol spelen).

Zoek- en retrieval-gebaseerde modellen

Platforms zoals Perplexity AI combineren LLM-redenering met realtime zoek- en citatiemechanismen (retrieval-augmented generation, RAG) voor verbeterde feitelijke nauwkeurigheid en minder hallucinaties in kennisgedreven taken.

Next-generation LLM’s (2025–2026)

De focus verschuift bij alle aanbieders naar:

- Multimodaliteit (tekst, afbeeldingen, tabellen, documenten, audio)

- Verwerking van zeer lange contexten (honderdduizenden tot miljoenen tokens)

- Agentic capabilities (toolgebruik, meerstapsreasoning, taakcoördinatie)

- Efficiëntie en domeinspecialisatie i.p.v. louter grotere schaal

Deze evolutie laat zien dat prestatieverbetering steeds vaker voortkomt uit architectuur, tooling en systeemontwerp — niet alleen uit meer parameters. Dit is een cruciaal punt bij zakelijke documentautomatisering.

Adoptietrends in ondernemingen

- LLM’s bewegen van pilot naar productie

- 78% van de organisaties zet generatieve AI in voor ten minste één bedrijfsfunctie, zoals operations, analytics en automatisering.

- Versnelde enterprise-lanceringen

- Volgens Gartner heeft naar verwachting tegen 2026 meer dan 80% van de grote ondernemingen generatieve AI-API’s of GenAI-enabled apps in productie, vergeleken met minder dan 5% in 2023.

- Documentverwerking als primaire use case

- Documentautomatisering is een topgebruik van GenAI vanwege de wens om handmatig werk te reduceren, sneller te verwerken en operationele efficiëntie te vergroten (McKinsey, Gartner).

Relevant voor documentautomatisering

Voor documentworkflows worden LLM’s vooral toegepast bij:

- Ongestructureerde of semi-gestructureerde tekst

- Classificatie op type of intentie

- Extractie van velden uit lastig definieerbare input, waar statische regels tekortschieten

- Omgaan met taal- en opmaakverschillen tussen leveranciers, regio's of formats

Hoewel LLM’s sterk zijn in interpretatie en redenering, zijn ze probabilistisch: hun output is kansgebaseerd, niet gegarandeerd. Dit beïnvloedt nauwkeurigheid, herhaalbaarheid, kosten en governance voor organisaties met veel documenten.

Dit onderscheid is de kern van de strategische vraag voor ondernemingen: waar voegen LLM’s daadwerkelijk waarde toe, en wanneer zijn specialistische documentverwerkers onmisbaar?

Kerncapaciteiten: Waar LLM’s uitblinken (De Strategische Laag)

LLM’s bieden de meeste toegevoegde waarde op het strategische niveau van documentautomatisering, waar flexibiliteit en semantisch begrip zwaarder wegen dan deterministische precisie. De kracht van LLM’s ligt vooral bij initiële automatisering, kennisintensieve processen en uitzonderingssituaties.

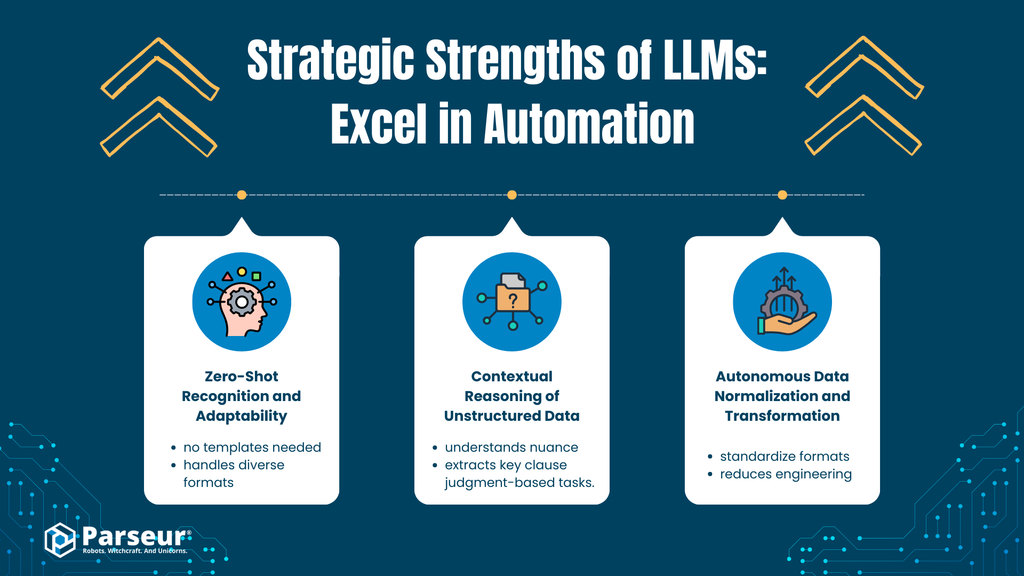

A. Zero-Shot Herkenning en Aanpassingsvermogen

LLM’s beschikken over hoog semantisch inzicht, waardoor ze relevante data herkennen en extraheren uit documenttypes en layouts die ze niet eerder zagen. Denk aan een LLM die een factuurnummer of totaalbedrag oppikt van een ongewone factuur, ook wanneer labels of volgorde sterk afwijken.

Deze vaardigheid komt voort uit generieke taalkundige modellering, niet uit documentspecifieke training.

Zakelijk effect

- Snellere onboarding van nieuwe leveranciers en documenten

- Minder afhankelijkheid van uitgebreide trainingsdatasets

- Initieel sneller automatiseren met lagere configuratiedrempel

B. Contextuele redenering bij ongestructureerde data

Anders dan regelsystemen kunnen LLM’s nuance, intentie en onderliggende betekenissen in ongestructureerde teksten analyseren, zoals lange e-mails, contracten of klantcorrespondentie.

Ze leggen verbanden tussen passages, begrijpen relaties en redeneren over meerdere alinea’s heen.

Zakelijk effect

- Automatisering van workflows met subjectieve beoordeling

- Gebruik bij klantintentieclassificatie, clausuleherkenning, datum- of risico-extractie

- Minder handmatige review in kennisintensieve processen

C. Autonome datanormalisatie en transformatie

LLM’s standaardiseren data al tijdens genereren, bijvoorbeeld:

- Datums, valuta’s en numerieke formaten aanpassen

- Velden harmoniseren vanuit inconsistente bronnen

Zakelijk effect

- Betere compatibiliteit met downstream-systemen (ERP, CRM)

- Minder technische overhead voor datacleansing

- Versnelt time-to-value bij proof-of-concept-trajecten

Strategische Sterktes in een Notendop

LLM’s brengen bedrijven:

- Natuurlijke taalverwerking op schaal

- Semantische flexibiliteit – betekenis ondanks variatie in lay-out of formulering

- Redeneren zonder expliciete regels

- Snel inzetbaar over meerdere domeinen

- Basis voor geavanceerde AI-workflows en contextualisatie

Een SaaS-klant van ons verwerkte jaarlijks circa 4.000 facturen. Met LLM’s werd 40% bespaard op handmatig werk voor standaardfacturen. Voor afwijkende en gescande facturen faalden LLM’s echter bij het extraheren van totalen en datums. Pas door regelgebaseerde checks en OCR toe te voegen, werd het proces betrouwbaar. LLM’s zijn waardevolle assistenten, maar mogen niet leidend zijn bij documentbeslissingen. - Nick Mikhalenkov, SEO Manager, Nine Peaks Media

Kritische beperkingen: Waar LLM’s tekortschieten (Operationele Laag)

Hoewel LLM’s strategisch veel te bieden hebben, worden bij grootschalige, productieklare documentautomatisering hun grenzen duidelijk. Waar nauwkeurigheid, consistentie, snelheid en kostenbeheersing prioriteit hebben, brengt een pure LLM-aanpak operationeel risico.

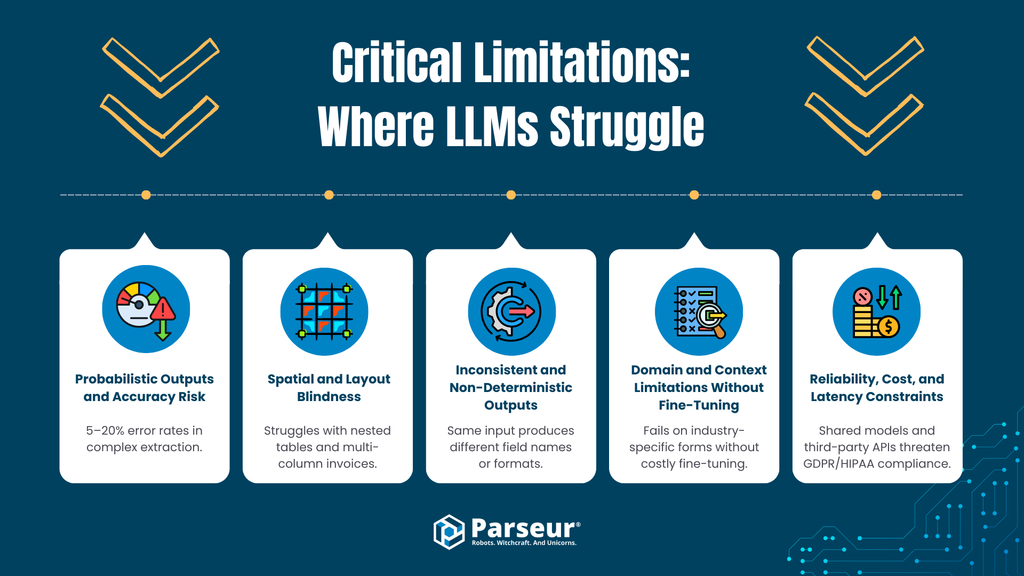

A. Probabilistische output en nauwkeurigheidsrisico

LLM’s zijn probabilistisch en geven bij hetzelfde document soms verschillende antwoorden. Meest geavanceerde modellen produceren volgens Master of code nog altijd in 5–20% van de gevallen fouten of hallucinaties bij complexe extractie.

Operationeel risico

In financiële processen, waar foutenpercentages van 1–3% (zie Ramp’s data) grote gevolgen hebben, is deze onzekerheid niet acceptabel en vereisen workflows deterministische resultaten.

B. Blindheid voor layout en ruimtelijke logica

De meeste LLM’s negeren visuele indeling. Ze kunnen tekst "lezen" maar missen het begrip van ruimtelijke relaties waarop facturen, tabellen en formulierstructuren drijven.

Operationeel risico

Een fout in het herkennen van rijen, kolommen of headers veroorzaakt:

- Onjuiste waardekoppeling (prijzen bij verkeerde regels)

- Foutieve toekenning van totalen en velden

Deze fouten zijn moeilijk te traceren en zeer kostbaar.

C. Inconsistente en niet-deterministische output

LLM’s garanderen geen vaste velden, naamgeving of formatering. Output kan variëren per prompt of documentversie.

Operationeel risico

Voorspelbare JSON-structuren, consistente veldnamen en vaste datatypes zijn essentieel. Variatie dwingt tot:

- Uitgebreide validatielagen

- Handmatige controles

- Minder gestroomlijnde bulkverwerking

D. Domein- en contextbeperkingen zonder fine-tuning

Algemene LLM’s kunnen moeite hebben met branche- en document-specifieke data, tenzij ze gelabeld en (vaak handmatig) gefinetuned zijn.

Operationeel risico

Fine-tuning kost tijd, vraagt beheersing van data privacy en verhoogt onderhoudsdruk.

E. Betrouwbaarheid, kosten en latentie

Inference met LLM’s is zwaar. Documentextractie kost vaak 8–40 seconden per document, terwijl gespecialiseerde engines dit in milliseconden doen.

Operationeel risico

- 10–100× hogere kosten per document op schaal

- Trage batch- en realtimeverwerking

- Beperkte doorvoercapaciteit voor bulkprocessen

F. Privacy en Compliance

Veel publieke LLM-diensten gebruiken gedeelde infrastructuur en bewaren mogelijk klantdata.

Operationeel risico

- GDPR-risico’s rond verwerking, retentie en recht op verwijdering

- Onzekerheid bij audits en branchespecifieke regelgeving

In het onderwijs zie ik dat LLM’s prima samenvatten en uitleggen, maar vaak tekortschieten bij het correct extraheren van gestructureerde informatie uit cijferlijsten of examenresultaten. Een verkeerde datum of score kan het hele eindresultaat onderuit halen, zeker omdat LLM’s zelfverzekerd verkeerd antwoorden als context ontbreekt. Regelgebaseerde systemen met menselijke controle blijven daarin beter presteren. - Joern Meissner, Founder & Chairman, Manhattan Review

Samenvatting: Strategische Intelligentie vs. Operationele Betrouwbaarheid

LLM’s bieden krachtige mogelijkheden voor NLU en reasoning, maar in operationele documentworkflows zijn hun probabilistische output, fouten, inconsistenties en lage snelheid beperkend. Voor bedrijfsautomatisering van facturen, accounting of complianceprocessen zijn gespecialiseerde systemen noodzakelijk.

Opkomst van “Agentic AI” in documentverwerking

Bedrijven zoeken naar manieren om de beperkingen van pure LLM-extractie te omzeilen. Zo is het architectuurpatroon Agentic AI ontstaan, waarbij LLM’s werken als orkestrator: ze roepen externe tools aan, voeren meerstapsredenering uit en valideren hun eigen output.

Wat is Agentic AI?

Agentic AI-systemen laten een LLM:

- Taken opdelen in deelstappen

- Externe tools (OCR, validatiescripts) inschakelen

- Output controleren en aanpassen voor consistentie

Bij documentverwerking betekent dit vaak volle validatielussen tot de output voldoet aan een bepaalde zekerheid.

Het voordeel: Minder hallucinaties

Door validatie en tool-gebruik worden fouten over numerieke data, ontbrekende velden en logica verminderd. Zo transformeert de LLM van gokmachine naar autonoom, zelfcorrigerend systeem.

Het compromis: Latentie, kosten en systeemcomplexiteit

Latentie

Elke redeneerstap en tool-interactie kost tijd. Extractie duurt vaak 8–40 seconden per document — te traag voor veel zakelijke toepassingen.

Kosten

Meerdere LLM-calls verhogen direct de API-kosten (en tokengebruik) per document, vooral bij hoge volumes.

Engineering-complexiteit

- Noodzakelijke orkestratieframeworks

- Uitgebreide monitoring en foutafhandeling

- Aanhoudend onderhoud aan prompts en workflows

Operationele realiteit

Voor bedrijven met duizenden documenten per maand zijn deze nadelen moeilijk te rechtvaardigen waar voorspelbaarheid, kosten en snelheid essentieel zijn.

Conclusie: Nuttig, maar selectief toepasbaar

Agentic AI verbetert de reasoning van LLM’s, maar is vooral waardevol voor uitzonderlijke of kennisintensieve documenten — niet als basis voor grootschalige, transactionele workflows.

Waarom gespecialiseerde tools belangrijk blijven (Parseur en gespecialiseerde engines)

Ondanks de hype rondom LLM’s, zijn gespecialiseerde documenttools (zoals Parseur) onmisbaar waar precisie, voorspelbaarheid en efficiëntie centraal staan. Succesvolle automatisering op schaal combineert LLM’s met deze engines en gebruikt elke technologie waar deze het meeste toevoegt.

Precisie op schaal

Gespecialiseerde systemen baseren zich op:

- Regelassisted extractie

- Layout-bewuste logica

- Specifieke classificatiemodellen

Resultaat: deterministische extractie en herhaalbare, nauwkeurige output per documenttype.

Instelbare regels en AI-learning

Moderne documentverwerkingstools combineren:

- Templates en validatieregels

- Lichtgewicht AI-classificatie

- Eventueel AI-ondersteunde herkenning

Deze aanpak levert 95%+ veld-nauwkeurigheid en structureel lagere foutpercentages bij grote volumes dan LLM’s alleen.

Het verschil? Bedrijven behouden volledige controle over formaten, validaties en foutenafhandeling.

Integratie en workflowvolwassenheid

Rijpe documenttools bieden:

- Stabiele API's en webhooks

- Integraties met ERP, CRM en boekhoudsoftware

- Automatiseringscompatibiliteit (Zapier, Make, Power Automate)

- Betrouwbare monitoring, retries en logging

Hierdoor worden ze een robuust onderdeel van bedrijfsprocessen — niet slechts een experimentele workflow.

Security en compliance als kern

Beveiliging en naleving zijn architectonisch geborgd:

- Data-isolatie per klant

- Versleuteling in rust en transport

- Configureerbaar bewaarbeleid

- Verwerking volgens GDPR en sectorregels

Omdat deze platforms geen documenten gebruiken om generieke modellen te trainen, vermijden ze veel dataprivacy- en auditproblemen van algemene AI-API's.

De kruising: LLM’s binnen documenttools

Bedrijven stappen af van “LLM-vervanging” en kiezen voor hybride modellen waarin LLM's ingebed worden als verrijkingslaag bovenop deterministische extractie.

LLM’s versterken hiermee de flexibiliteit en intelligentie, maar de kern van betrouwbare verwerking blijft bij gespecialiseerde engines.

Prompt-gedreven correctie- en verrijking

Best practice: post-extractie-verrijking.

- Deterministisch systeem haalt de hoofdvelden op

- LLM voegt optional: normalisatie, uitleg, categorisatie toe

Zo behoud je betrouwbaarheid én profiteer je van context en intelligentie voor verrijking zonder het workflowproces in gevaar te brengen.

Human-in-the-loop validatie met LLM-samenvattingen

LLM’s kunnen reviewers ondersteunen:

- Lange documenten samenvatten

- Belangrijke afwijkingen en velden automatiseren markeren

- Reviewnotities genereren in natuurlijke taal

De menselijke controle blijft leidend, waarmee compliance en consistentie gewaarborgd blijven.

Agentic AI Workflows: LLM’s als orkestrator

Geavanceerde platformen experimenteren met agentic workflows waarin LLM’s deterministische engines aansturen en validatie combineren met menselijk ingrijpen op uitzondering.

Voor omvangrijke processen blijven deze workflows aanvullend — niet vervangend — vanwege hun operationele belasting.

Waarom hybride architecturen standaard worden

Het toenemende gebruik van LLM-integraties laat een volwassen strategische houding zien: elk systeem wordt benut waar het het beste werkt. Een hybride structuur levert:

- Nauwkeurige extractie daar waar vereist

- Flexibiliteit en intelligentie op lastige of variabele documenten

- Voorspelbare kosten en prestaties

- Beter audit- en compliance-beheer

Strategisch advies

De toekomst is niet LLM-only, maar LLM-bewust. Succesvolle organisaties gebruiken LLM’s voor reasoning en flexibiliteit, gespecialiseerde engines voor uitvoering, en ontwerpen hun systemen zodanig dat intelligentie in dienst staat van betrouwbaarheid.

Wanneer LLM’s versus gespecialiseerde documenttools gebruiken

| Beslissingscriterium | Gebruik Large Language Models (LLM’s) | Gebruik Gespecialiseerde Documenttools (zoals Parseur) |

|---|---|---|

| Variatie in documenttypen | Sterk variabel, onbekend of ongestructureerd (e-mails, vrije tekst, contracten) | Consistente of semi-gestructureerde documenten (facturen, bonnen, forms) |

| Nauwkeurigheidseisen | Advies of assistentie met ruimte voor menselijke review | Systeem-van-record automatisering met deterministische nauwkeurigheid |

| Foutentolerantie | Af en toe een foutje is acceptabel | Vrijwel nul foutentolerantie vereist |

| Reguleringsrisico | Lage gevoeligheid of niet gereguleerde data | Gereguleerde data (GDPR, CCPA, financieel, zorg) |

| Dataprivacy & soevereiniteit | Data wordt gebruikt voor verrijking/reasoning, beperkte retentie vereist | Strikte isolatie, auditability, recht op verwijdering |

| Verwerkingsvolume | Laag tot gemiddeld | Groot volume (duizenden tot miljoenen documenten per maand) |

| Latentiegevoeligheid | Seconden per document is prima | Milliseconden of realtime vereist |

| Kostenefficiëntie op schaal | Prima voor laag volume, kosten stijgen snel bij schaalvergroting | Voorspelbare, lage kosten per document op grote schaal |

| Integratiecomplexiteit | Flexibele output, losse koppeling | Vaste schema’s, ERP/RPA/Accounting-integraties |

| Best-fit use cases | Classificatie, samenvatting, intentieherkenning, verrijking | Factuurverwerking, AP/AR, vormextractie, compliance-workflows |

Toekomstperspectief: LLM’s, Agentic systemen & automatisering

Het landschap voor documentautomatisering met AI ontwikkelt zich snel. Organisaties moeten niet alleen de huidige LLM-mogelijkheden snappen, maar ook de opkomende trends voor de komende jaren.

1. Nieuwe generatie LLM-architecturen

- Multimodale modellen: LLM’s verwerken tekst, afbeeldingen, tabellen en documenten tegelijk, wat automatisering van complexe facturen of formulieren ondersteunt.

- Retrieval-Augmented Models (RAG): Koppeling met externe kennisbronnen zorgt voor betere nauwkeurigheid en context zonder klantdata opnieuw te trainen.

- Agentic AI-workflows: LLM’s voeren meerstapsredeneringen en tool-integraties uit — zoals validatie, samenvatten en uitzonderingen voorstellen.

2. Enterprise-adoptietrends

- Toekomstvoorspellingen voor adoptie: AI is naar verwachting universeel in grote ondernemingen tegen 2027, met generatieve AI als kern van automatisering en contentverwerking. Hybride automatisatiestacks worden de standaard.

- De focus ligt op minder handmatig werk, snellere processen en strategische inzichten uit ongestructureerde gegevens.

3. Verklaarbaarheid, vertrouwen en toezicht

- Met bredere LLM-adoptie groeit de behoefte aan verklaarbare AI voor audits en compliance.

- Human-in-the-loop (HITL) blijft nodig bij belangrijke documenten en beslissingen.

- Succes vereist een balans tussen LLM-flexibiliteit en deterministische nauwkeurigheid door gespecialiseerde systemen.

Balans tussen AI-intelligentie en operationele controle

Large Language Models (LLM’s) bieden krachtige analyse en semantische interpretatie van ongestructureerde documenten, maar zijn geen losstaande oplossing voor grootschalige data-extractie in bedrijven. Zet LLM’s slim in waar flexibiliteit en context nodig zijn, en vertrouw voor nauwkeurigheid, compliance en schaalbaarheid op gespecialiseerde platforms zoals Parseur. Door cognitieve AI te combineren met deterministische engines, profiteren bedrijven van strategisch inzicht en operationele zekerheid — noodzakelijk om documentautomatisering succesvol, snel en betrouwbaar te maken.

Veelgestelde Vragen

Om besluitvormers in ondernemingen te helpen de praktische toepassingen en beperkingen van Large Language Models in documentworkflows te begrijpen, hebben we antwoorden verzameld op de meest gestelde vragen over hun gebruik, beveiliging en integratie met gespecialiseerde tools zoals Parseur.

-

Waar zijn LLM's goed in bij documentverwerking?

-

LLM’s blinken uit in het vertalen van ongestructureerde tekst, het herkennen van patronen, het classificeren van inhoud en het extraheren van contextgevoelige informatie. Ze zijn ideaal voor flexibele, redeneergedreven workflows, maar zijn probabilistisch in plaats van deterministisch.

-

Waarom kunnen LLM's geen gespecialiseerde extraction tools vervangen?

-

LLM’s kunnen inconsistente outputs produceren, hebben moeite met layout-afhankelijke data en zijn duur op grote schaal. Tools zoals Parseur bieden deterministische nauwkeurigheid, compliance en schaalbaarheid voor grote aantallen gestructureerde documenten.

-

Zijn LLM’s veilig voor bedrijfsgegevens?

-

Beveiliging hangt af van de implementatie. Veel LLM’s gebruiken gedeelde API’s die data kunnen bewaren. Parseur zorgt voor geïsoleerde verwerking, configureerbare retentie en naleving van GDPR en andere regelgeving.

-

Hoe kunnen bedrijven LLM's en gespecialiseerde tools combineren?

-

Gebruik LLM’s voor redeneren en ongestructureerde data, en gespecialiseerde engines voor grote aantallen gestructureerde of gereguleerde documenten om flexibiliteit en betrouwbaarheid te waarborgen.

Laatst bijgewerkt op