Large Language Models (LLMs) bieten unvergleichliche Flexibilität beim Verstehen unstrukturierter Texte und sind ideal für Reasoning, Zusammenfassungen und Aufgaben mit geringer Dokumentenanzahl. Aufgrund ihrer probabilistischen Natur, Latenz und fehlender deterministischer Präzision sind sie jedoch als alleinige Lösung für automatisierte Verarbeitung großer Mengen regulierter Dokumente nicht ausreichend.

Wichtige Erkenntnisse:

- Strategische Flexibilität: LLMs glänzen beim Übersetzen unstrukturierter, neuartiger oder hochvariabler Dokumente, ermöglichen schnelleres Onboarding und Reasoning-basierte Aufgaben.

- Betriebliche Einschränkungen: Bei strukturierten, hochvolumigen Workflows führen LLMs allein oft zu Fehlern, langsamer Verarbeitung und Compliance-Risiken. Deterministische Systeme bleiben unverzichtbar.

- Hybrider Vorteil: Die wirkungsvollsten Strategien zur Dokumentenautomatisierung kombinieren LLMs mit spezialisierten Plattformen wie Parseur. KI wird für kontextuelles Verständnis, deterministische Extraktion für Genauigkeit, Skalierbarkeit und Compliance genutzt.

Das Automatisierungs-Paradoxon

Large Language Models (LLMs) haben das Verständnis natürlicher Sprache grundlegend verbessert. Ihre Fähigkeit, unstrukturierten Text zu erklären, Bedeutungen abzuleiten und domänenübergreifend zu generalisieren, hat die technischen Möglichkeiten in der Dokumentenautomatisierung erweitert und vormals regelbasierte oder manuell konfigurierte Aufgaben flexibler gemacht.

Grenzen von LLMs

Diese Flexibilität offenbart im Unternehmenskontext jedoch ein Paradoxon: Während LLMs bei Reasoning-orientierten oder geringvolumigen Prozessen effektiv sind, erreichen sie laut Hyperscience Standards bei Kernaufgaben wie Rechnungen und Frachtbriefen oft nur 66–77 % „Exact Match Accuracy“. Spezialisierte IDP-Systeme erreichen hingegen 93–98 %.

Das verdeutlicht: LLMs sind nicht als System of Record gedacht, bei denen deterministische Genauigkeit, feste Schemata und Vorhersehbarkeit erforderlich sind.

Nicht-deterministische Resultate, variable Antwortzeiten aufgrund API-Limits und steigende Inferenzkosten (bedingt durch Token-Volumen und GPU-Bedarf) erschweren die Einführung reiner LLMs in produktiven Unternehmensworkflows, in denen es auf Geschwindigkeit, Konsistenz und Skalierbarkeit ankommt.

Wachstum hybrider IDP-Systeme

Deshalb setzt sich in der dokumentenzentrierten Unternehmensautomatisierung zunehmend ein hybrider Ansatz durch. Hybridarchitekturen im Intelligent Document Processing (IDP) kombinieren die Anpassungsfähigkeit von LLMs mit der Präzision spezialisierter Extraktions-Engines und deterministischer Logik – für optimale Qualität und Wirtschaftlichkeit.

Das ist die Erkenntnis, dass keine Einzeltechnologie gleichzeitig maximale Flexibilität, Genauigkeit, Kostenkontrolle und Governance bieten kann. Unternehmen trennen Reasoning und Ausführung explizit nach Schichten, um jede Technologie optimal einzusetzen.

Laut Fortune Business Insights soll der globale IDP-Markt von 14,16 Mrd. $ (2026) auf 91,02 Mrd. $ (2034) wachsen (26,20 % CAGR). Das demonstriert die steigende Nachfrage nach skalierbaren, verlässlichen Extraktionssystemen großer Unternehmen. LLMs werden gezielt dort angewendet, wo es auf Kontextverständnis ankommt, während Speziallösungen die massenhafte Extraktion, Validierung und Verarbeitung übernehmen.

Strategisch gilt: LLMs sind ein bedeutender Baustein der modernen Dokumentenautomatisierung, ersetzen jedoch keine spezialisierten Engines. Wer die jeweiligen Technologien an ihren Stärken einsetzt, erreicht Skalierbarkeit ohne Einbußen bei Genauigkeit, Governance oder Performance.

Was sind Large Language Models (LLMs)?

Large Language Models (LLMs) sind fortschrittliche Machine-Learning-Modelle, die entwickelt wurden, um natürliche Sprache zu verstehen, zu generieren und Reasoning anzuwenden. Sie werden mit riesigen Textkorpora und tiefen neuronalen Netzen trainiert—fast immer auf Basis von Transformer-Architekturen—um Zusammenhänge zwischen Wörtern, Phrasen und Konzepten zu erfassen.

Vereinfacht gesagt: LLMs sagen das wahrscheinlichste nächste Token (Wort oder Symbol) basierend auf einer vorhandenen Textsequenz vorher. Durch diesen Mechanismus und umfangreiche Trainingsdaten entstehen Fähigkeiten wie Zusammenfassen, Klassifizieren, Beantworten von Fragen, Übersetzen und kontextbezogenes Reasoning. In der Dokumentenverarbeitung erklärt das LLM Freitext, erschließt Bedeutungen und passt sich flexibel an unterschiedliche Layouts oder Formulierungen an.

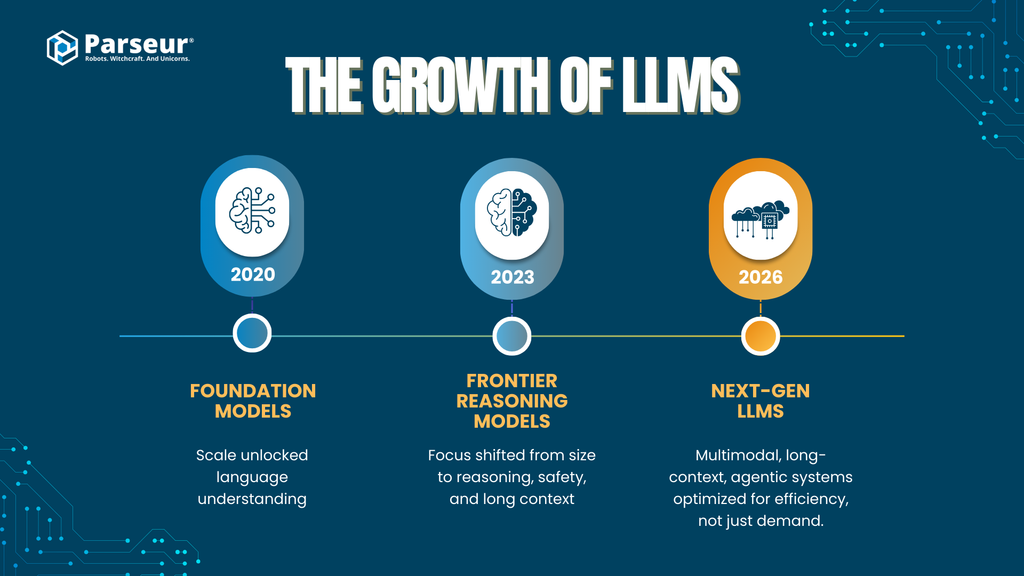

Skalierung und Entwicklung von LLMs

Die Leistungsfähigkeit von Large Language Models ist mit zunehmender Modellgröße und optimierten Trainingsmethoden rapide gestiegen:

- Frühe Foundation-Modelle (2020–2021)

Beispielsweise führte GPT-3 Transformer-Architekturen mit rund 175 Mrd. Parametern ein und zeigte, dass „Größe“ direkt zu beachtlichem Sprachverständnis führen kann.

- Frontier-Modelle der zweiten Generation (2023–2024)

Modelle wie GPT-4, Claude 2/3 (Anthropic), Gemini 1.x (Google) oder DeepSeek-LLM legen den Fokus weniger auf reine Parameterzahl, sondern vermehrt auf Reasoning, Sicherheit und längere Kontexte. Exakte Parametergrößen werden zunehmend geheim gehalten, werden jedoch auf Multi-Billionen-Niveau eingeschätzt (z. B. durch Mixture-of-Experts-Architektur).

- Search- und Retrieval-augmented Modelle

Plattformen wie Perplexity AI setzen auf Retrieval-Augmented Generation (RAG): Das LLM nutzt dabei externe Suchmaschinen und Zitate, um Fakten zu verifizieren und Halluzinationen zu reduzieren.

- Künftige LLMs (2025–2026)

Im Fokus stehen:

- Multimodalität (Text, Bild, Tabelle, Audio)

- Lang-Kontext-Verarbeitung (hunderttausende bis Millionen Tokens)

- Agentenfähigkeiten (Tool-Nutzung, Reasoning in mehreren Schritten)

- Effizienz & Spezialisierung statt ausschließlich größerer Modelle

Architektur, Tooling und Systemdesign rücken immer mehr ins Zentrum und bestimmen entscheidend die Praxistauglichkeit für die Dokumentenautomatisierung.

Trends bei der Unternehmensadoption

- LLMs gehen von Pilot in Produktion

- 78 % der Unternehmen setzen Generative AI mindestens in einer Geschäftsbereich ein, etwa Operations, Analytics oder Automatisierung.

- Rasantes Wachstum der Produkteinführungen

- Bis 2026 sollen über 80 % der Unternehmen Generative-AI-APIs oder GenAI-basierte Lösungen produktiv einsetzen (Gartner), nach weniger als 5 % in 2023.

- Dokumentenverarbeitung bleibt ein Top-Use-Case

- Automatisierung und Datenauszug zählen zu den wichtigsten Anwendungsfällen für GenAI, gefordert sind höhere Effizienz, kürzere Durchlaufzeiten und weniger manuelle Prozesse (McKinsey, Gartner).

Relevanz für die Dokumentenautomatisierung

Im Dokumentenworkflow liefern LLMs Nutzen bei:

- Verarbeitung unstrukturierter oder semistrukturierter Texte

- Klassifikation von Dokumenten nach Typ oder Absicht

- Extraktion flexibler Felder, die sich nicht starr beschreiben lassen

- Umgang mit Sprach- und Formatvielfalt

Auch wenn LLMs in Interpretation und Reasoning stark sind, bleiben sie probabilistische Systeme. Ihre Ergebnisse sind nicht festregelbasiert, was Genauigkeit, Wiederholbarkeit, Kosten und Governance bei Massendatenverarbeitung beeinflusst.

Für Unternehmen ist es daher zentral: Wo bringen LLMs strategischen Mehrwert und wo bleiben spezialisierte Systeme alternativlos?

Kernkompetenzen: Wo LLMs glänzen (die strategische Ebene)

Large Language Models liefern besonders auf der strategischen Ebene der Dokumentenautomatisierung Mehrwert, wenn Flexibilität, semantisches Verständnis und Reasoning wichtiger sind als deterministische Präzision. Ihre Stärken sind qualitativ—etwa beim Start neuer Automatisierungsvorhaben, bei Ausnahmen und wissensintensiven Prozessen.

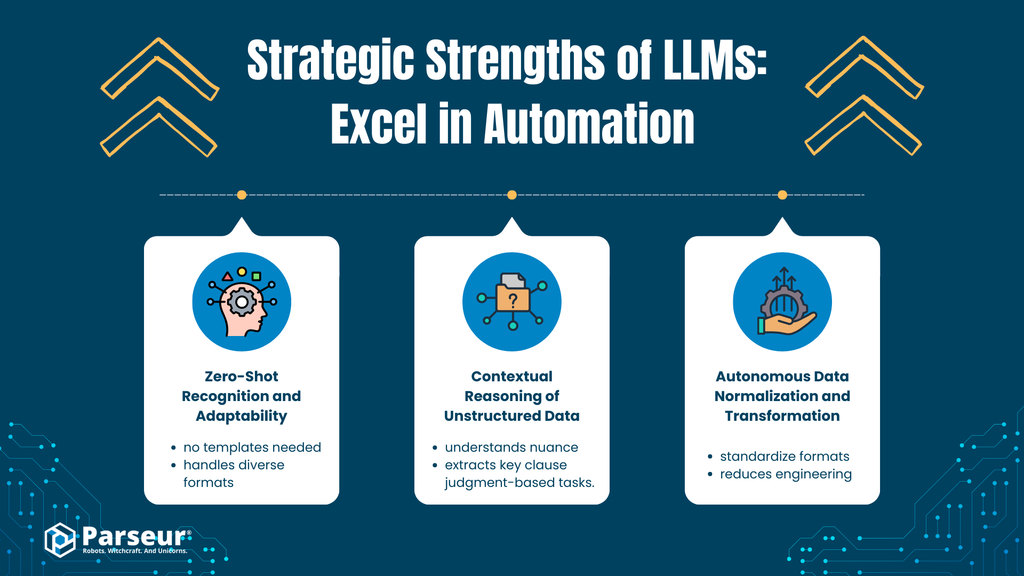

A. Zero-Shot-Erkennung und Anpassungsfähigkeit

Analyse

LLMs interpretieren Bedeutung kontextabhängig und extrahieren selbst bei unbekannten Dokumenttypen relevante Informationen. So kann ein LLM etwa Rechnungsnummern, Fälligkeitsdaten oder Beträge aus Rechnungen extrahieren, die es nie zuvor gesehen hat – Position, Label oder Format sind zweitrangig.

Das funktioniert durch generelles Sprachverständnis, nicht durch templatespezifisches Training. Bedeutung wird im Zusammenhang erschlossen, nicht durch feste Regeln.

Geschäftlicher Nutzen

- Schneller Mehrwert: Weniger Initialkonfiguration und Training nötig

- Reduzierter Datenbedarf: Geringere Abhängigkeit von gelabelten Trainingsdaten

- Rasches Onboarding: Neue Lieferanten, Formate und Dokumenttypen können schneller automatisiert werden

Gerade in dynamischen, heterogenen Umgebungen senkt das die Einstiegshürden für Automatisierungsprojekte.

B. Kontextuelles Reasoning bei unstrukturierten Daten

Analyse

LLMs analysieren Nuancen, Intentionen und Kontext in unstrukturierten oder semistrukturierten Texten—etwa Freitext in E-Mails, Verträgen, Richtlinien oder Kundenanfragen. Sie erkennen narrative Bedeutung und Zusammenhänge über mehrere Absätze, was deterministische Systeme häufig nicht können.

Geschäftlicher Nutzen

- Automatisierung von Workflows, die Beurteilungsvermögen benötigen

- Beispiele:

- Klassifikation von Kundenanliegen

- Auffinden von Klauseln in Rechtstexten

- Extraktion von Terminen, Verpflichtungen oder Risiken in Narrativdokumenten

Vor allem Bereiche mit uneinheitlicher Struktur und hohem Kontextbedarf profitieren.

C. Autonome Normalisierung und Transformation von Daten

Analyse

LLMs können bereits im Extraktionsprozess Daten normalisieren, beispielsweise:

- Datums- oder Währungsformate vereinheitlichen

- Feldbezeichner aus unterschiedlichen Quellen harmonisieren

So wird zusätzlicher Nachbearbeitungsaufwand auf technischer Ebene minimiert.

Geschäftlicher Nutzen

- Vereinfachte Integration mit ERP, CRM & Analytics

- Weniger Aufwand für Datenbereinigung und Formatierung

- Schneller Start für Proof-of-Concepts

Strategische Stärken von LLMs in der Automatisierung

LLMs bringen für Unternehmensautomatisierung summarisch folgende strategischen Vorteile:

- Skalierbares Sprachverständnis: große Mengen unstrukturierter Texte extrahieren, kategorisieren oder zusammenfassen

- Semantische Flexibilität: Bedeutung unabhängig von Formulierung, Layout oder Intention verstehen

- Reasoning- und Klassifikationsfähigkeit: Muster und Zusammenhänge ohne explizite Regeln erkennen

- Rasche Anwendbarkeit: von Kundensupport bis juristischer Prüfung und interner Kollaboration

- Basis für Agenten-Workflows: Prompt-Ketten, Aufgabenzerlegung, automatische Prüfung

Beispiel: Ein SaaS-Kunde, der jährlich rund 4.000 Rechnungen verarbeitete, automatisierte mit LLMs den Rechnungseingang und senkte den manuellen Aufwand bei Standardlieferanten um 40 %. Doch bei schlecht strukturierten, gescannten Rechnungen lieferten LLMs keine korrekten Beträge– erst die Ergänzung durch regelbasierte Validierung und OCR brachte die nötige Zuverlässigkeit. LLMs können Automatisierung unterstützen, sollten aber nicht allein das finale Ergebnis bestimmen. – Nick Mikhalenkov, SEO Manager, Nine Peaks Media

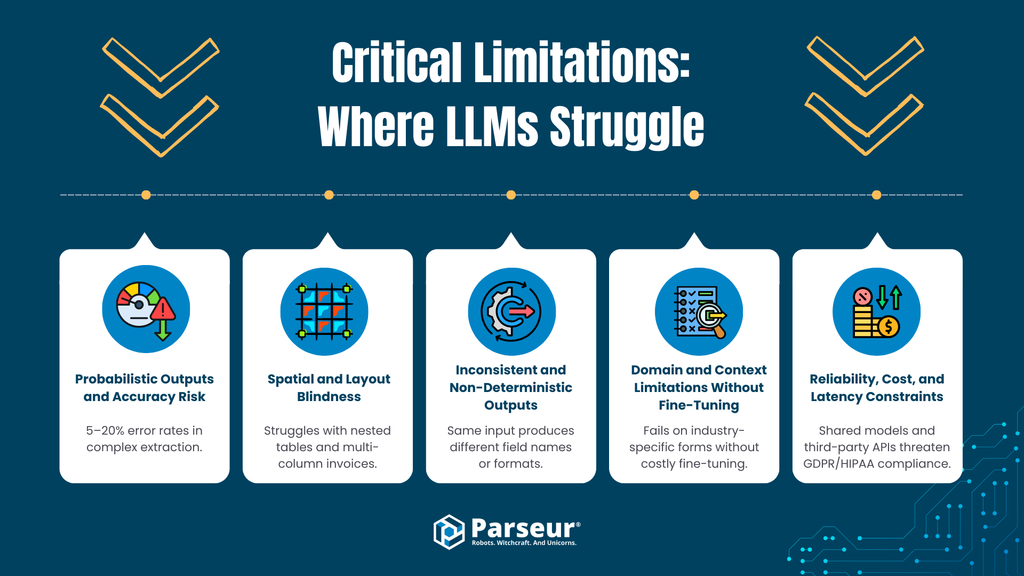

Entscheidende Grenzen: Wo LLMs an ihre Grenzen stoßen (die operative Ebene)

Obwohl Large Language Models auf strategischer Ebene hohe Flexibilität bieten, werden ihre Schwächen beim hochvolumigen, operativen Einsatz klar sichtbar. Genauigkeit, Konsistenz, Geschwindigkeit und Kosteneffizienz sind geschäftskritisch – reine LLM-Workflows bergen hier echte Risiken.

A. Probabilistische Ergebnisse und Genauigkeitsrisiko

Grenze

LLMs treffen Ausgaben probabilistisch, nicht regelgebunden. Selbst fortschrittliche Modelle generieren mitunter Fehler oder halluzinierte Inhalte. Master of code gibt Fehlerraten im Reasoning und der Extraktion zwischen 5–20 % an.

Risiko

In Buchhaltung, Einkauf oder Compliance sind Fehler nicht tolerierbar. Ramp-Daten zeigen bereits bei manueller Erfassung 1–3 % Fehlerquote (~10–30 von 1.000 Rechnungen)—die Automatisierung darf das nicht weiter erhöhen. LLM-Ergebnisse sind nicht zuverlässig wiederholbar, ohne intensive manuelle Kontrolle drohen neue → Ausnahme- und Korrekturaufwände.

B. Blindheit für Layout und Position

Grenze

LLMs verarbeiten Textsequenzen, aber kein native Dokumentenlayout. Informationen:

- aus mehrspaltigen Rechnungen,

- komplexen Tabellen,

- strukturierten Zeilen- oder Spaltenbezügen

werden schlechter erkannt.

Risiko

Fehlerhafte Positionszuordnung kann zu falschen Beträgen oder falscher Feldbelegung führen, insbesondere bei strukturierten Dokumenten mit Layout-Logik. Das erhöht Prüf- und Korrekturaufwand.

C. Inkonsistente und nicht-deterministische Ausgaben

Grenze

LLM-Outputs sind nicht schemafest. Feldnamen, Reihenfolge oder Formate variieren—bereits kleine Promptabweichungen führen zu unterschiedlichen Ergebnissen.

Risiko

Betriebliche Systeme erwarten konsistente Strukturen (z. B. gleichbleibendes JSON). Abweichungen bedeuten:

- mehr Validierungsschichten und Fehlerupdates

- manuelle Überprüfungen

- Langfristig: Rückbau der Automatisierung

D. Fachspezifika und Kontext ohne Feintuning eingeschränkt

Grenze

LLMs glänzen beim Allgemeinwissen, doch Spezialfälle (z. B. Transportdokumente, Steuerformulare) werden ohne Feintuning und spezifische Prompts oft falsch erkannt.

Risiko

Feintuning ist aufwändig:

- Datenaufbereitung/-anonymisierung

- Mehr Integration und Support

- zusätzlicher Pflegeaufwand

- Datenschutz & Aufbewahrungsfragen

Das erschwert die geplante Plug-and-Play-Implementierung vieler Unternehmen.

E. Zuverlässigkeit, Kosten und Latenz

Grenze

LLM-basierte Inferenz braucht hohe Rechenleistung; Extraktion dauert oft 8–40 Sekunden je Dokument, Spezial-Engines liefern Ergebnisse in Millisekunden.

Risiko

Bei größerer Last:

- API-Kosten steigen auf das 10–100-fache gegenüber klassischen IDP-Systemen

- Latenz bremst kritische Workflows aus

- Durchsatzprobleme bei Batchverarbeitung

Für tausende Dokumente pro Monat wird der LLM-Ansatz meist wirtschaftlich unattraktiv.

F. Datenschutz- und Compliance-Risko

Grenze

Viele LLM-APIs nutzen geteilte Modelle, nicht immer transparente Datenhaltung oder Logs. Risiken entstehen beim:

- Erfüllen der DSGVO-Zweckbindung/Löschung

- Branchenvorgaben (HIPAA, GLBA)

- Recht auf Datenhoheit

Risiko

Fehlt die isolierte Kundenverarbeitung und Datennutzung zu Trainingszwecken, sind Compliance-Verstöße möglich. Vertragsklauseln allein bieten oft keine ausreichende Sicherheit.

„Eine der größten Schwächen von Large Language Models in der Dokumentenverarbeitung ist die fehlende Präzision, wenn sie wirklich notwendig ist. LLMs fassen Inhalte zusammen und erfassen den Kern, aber beim strukturierten Auslesen, wo schon kleine Fehler riesige Auswirkungen haben, enttäuschen sie. Sie präsentieren fehlerhafte Daten oft sehr überzeugend, was das Problem verschärft.

Beispielsweise klappt Zusammenfassen in der Bildung, aber das korrekte Auslesen standardisierter Prüfungsdaten misslingt regelmäßig. Klassische Extraktionssysteme liefern zusammen mit menschlicher Kontrolle deutlich bessere Ergebnisse.“ – Joern Meissner, Gründer & Vorsitzender, Manhattan Review

Fazit: Strategische Intelligenz vs. operative Zuverlässigkeit

Large Language Models (LLMs) liefern neuartige Möglichkeiten für Sprachverständnis, Interpretation und Reasoning. Doch für Enterprise-Dokumentenautomatisierung gibt es Defizite bei Präzision, deterministischem Datenextrakt, Layout-Interpretation, Wirtschaftlichkeit und Compliance. Probabilistische Ausgaben machen reine LLM-Workflows bei Massenverarbeitung (z. B. Rechnungen) zur riskanten Strategie.

Der Aufstieg von „Agentic AI“ in der Dokumentenverarbeitung

Zur Überwindung dieser Grenzen etabliert sich ein neuer Architekturtrend: Agentic AI. Hier agiert das LLM nicht mehr nur als Textgenerator, sondern orchestriert externe Tools, setzt mehrstufiges Reasoning ein und prüft eigene Ausgaben laufend.

Was ist Agentic AI?

Agentic AI meint Systeme, bei denen ein LLM:

- Aufgaben in Einzelschritte zerlegt

- Tools wie OCR, Rechner, Datenbanken ansteuert

- Ergebnisse validiert und gegebenenfalls erneut überprüft

- Den Prozess bis zur Zielerfüllung mehrfach durchläuft

In der Dokumentenverarbeitung resultiert das etwa in mehrfacher Dokumentenabfrage, Validierung von Summen und Werten, ständigem Nachjustieren und erst danach im finalen Auszug.

Reduktion von Halluzinationen

Durch Validierungsschleifen und Tool-Unterstützung werden typische LLM-Schwächen wie:

- numerische Fehler,

- fehlende Felder,

- logische Brüche

deutlich verringert. Das LLM agiert so als „selbstoptimierendes System“ und verbessert Präzision bei schwierigen Anwendungsfällen.

Verbleibende Trade-Offs: Latenz, Kosten und Komplexität

Agentic-Architekturen steigern zwar das Reasoning, bringen aber spürbare operative Kosten:

Latenz

Jeder Validierungsschritt verlängert die Verarbeitungsdauer, häufig auf 8–40 Sekunden pro Vorgang – für Echtzeitprozesse oder Massendaten ungeeignet.

Kosten

Mehrere LLM-Aufrufe treiben den Token- und Ressourcenverbrauch pro Dokument stark in die Höhe – Kosten liegen oft deutlich über klassischen Extraktionssystemen.

Komplexität

Nötig werden:

- komplexe Orchestrations-Frameworks,

- aufwändige Fehlerbehandlung,

- regelmäßiges Monitoring,

- fortlaufendes Prompt- und Logik-Tuning

Das steigert Integrations- und Wartungsaufwand erheblich.

Betriebsrealität

Für Unternehmen mit hohen Dokumentenmengen sind diese Nachteile schwer tragbar. Gefordert sind Vorhersagbarkeit, planbare Kosten, deterministische Ergebnisse und transparente Fehlerbehandlung. Agentic AI eignet sich vor allem für Ausnahmefälle und komplexe Varianten, nicht für die Massenautomatisierung.

Fazit: Wertvoll, aber begrenzt einsetzbar

Agentic AI ist ein Fortschritt für den LLM-Einsatz bei kniffligen Aufgaben mit wenigen Fällen. Für Massendaten oder Standard-Workflows ist der Aufwand aber oftmals zu hoch, und specialistische Engines bleiben unverzichtbar.

Warum spezialisierte Tools weiterhin essenziell sind (Parseur und der Wert maßgeschneiderter Engines)

Angesichts der Popularität von LLM-Automatisierung nehmen viele Unternehmen an, generische Modelle könnten klassische Dokumentenverarbeitung ersetzen—doch das Gegenteil ist richtig: Maximale Qualität, Sicherheit und Skalierbarkeit erzielt man weiterhin nur durch die Kombination von LLMs und maßgeschneiderten Engines.

Parseur und ähnliche Plattformen existieren nicht, weil LLMs „unintelligent“ wären, sondern weil operative Automatisierung Präzision und Zuverlässigkeit über reine Intelligenz stellt.

Präzision bei Skalierung

Automatisierung strukturierter Dokumente (Rechnungen, Aufträgen, Finanzbelegen) verlangt feldgenaue Extraktion. Spezial-Engines liefern:

- regelbasierte Feldauslese,

- layouterkennung,

- präzise Klassifikation

und damit deterministische Ergebnisse—das gleiche Dokument ergibt immer dasselbe Resultat.

Beim LLM-Ansatz summiert sich schon geringe Fehlerquote bei größeren Datenmengen rasch zu nennenswerten Nachbesserungen—das gefährdet die Automatisierungsvorteile.

Regel-Editing & gezieltes Lernen

Moderne Plattformen verschmelzen:

- Templates & Validierungsregeln,

- ML-Klassifikatoren,

- KI-gestützte Datenfelder

und erreichen laut Branchenstudien über 95 % Feldgenauigkeit bei der Extraction—auch bei Formatvariabilität.

Reine LLM-Workflows erzielen bei Rechnungen/Belegen meist niedrigere Werte. Spezial-IDP-Systeme senken Fehlerquoten um mehr als 52 %, reduzieren so Korrekturschleifen und Nacharbeit.

Wichtig ist Kontrolle: Unternehmen geben Schemata, Prüflogik und Notfallbehandlungen explizit vor—Promptbasierte Systeme allein ermöglichen das kaum.

Integration und Workflow-Reife

Maßgeschneiderte Plattformen sind für produktiven Betrieb konzipiert:

- stabile REST APIs & Webhooks,

- native ERP-/Finance-/CRM-Konnektoren,

- Automatisierungs-Integrationen (Zapier, Make, Power Automate),

- Monitoring und Fehlerbehandlung

sorgen für kontinuierliche, zuverlässige Verarbeitung und präzisen Datenaustausch. LLMs bleiben ergänzend als Reasoning-Layer; das operationelle Rückgrat liefern spezialisierte Systeme.

Sicherheit und Compliance

In der Unternehmensdokumentenverarbeitung stehen Datenschutz und Compliance an oberster Stelle.

Parseur und vergleichbare Lösungen bieten:

- Mandantengetrennte Datenhaltung,

- Verschlüsselung im Speicher/transit,

- konfigurierbare Löschfristen,

- datenschutzkonforme Verarbeitung (DSGVO usw.)

und verzichten auf eine Modellnachschulung mit Kundendaten—so bleibt Daten- und Prüftreue gewahrt. Für regulierte Branchen ist das entscheidend, da Compliance sowohl Speicherung als auch Datenfluss berücksichtigt.

Das Zusammenspiel: LLMs in Dokumentenverarbeitungstools

Mit fortgeschrittener Adaption zeigt sich ein klarer Trend: LLMs werden in spezialisierte Dokumentenverarbeitungstools eingebettet—sie ersetzen keine klassischen Engines, sondern ergänzen sie.

Hybride Systeme kombinieren LLM-Flexibilität mit der Zuverlässigkeit deterministischer Methoden.

Das grundlegende Prinzip: LLMs wirken als unterstützende Schicht für Fehlerbehandlung, Kontext und Anreicherung, während der Kernauszug strukturiert und kontrolliert bleibt.

Prompt-basierte Korrektur- und Anreicherungs-Schichten

Ein effektives Muster: LLM-Anreicherung nach strukturierter Extraktion:

- Template-/Layout-Engine extrahiert Kerndaten (z. B. Rechnungsnummern, Beträge).

- LLM ergänzt/normalisiert spezifische Felder oder Metadaten, klärt Mehrdeutigkeiten, klassifiziert Details.

Da das LLM nur im Nachgang zum Einsatz kommt, bleibt sein probabilistisches Verhalten kontrollierbar und nachvollziehbar.

Man-in-the-Loop-Validierung mit LLM-Zusammenfassungen

Ein weiteres Muster: LLMs unterstützen menschliche Prüfer—sie

- fassen lange Texte/Dokumente zusammen,

- erklären, warum Felder Validierungen nicht bestehen,

- generieren natürliche Audit-Kommentare.

So sinkt der manuelle Aufwand bei Ausnahmefällen, die finale Kontrolle bleibt beim Menschen—entscheidend für regulierte Workflows.

Agentic-AI-Workflows: LLMs als Orchestrierungsschicht

Fortschrittliche Plattformen experimentieren mit agentischen KI-Workflows, in denen LLMs die Steuerung übernehmen:

- LLM orchestriert Pipelines,

- OCR/Klassifikation/Feldauslese erfolgt durch spezialisierte Engines,

- Validierungsregeln definieren Grenzwerte,

- Mensch greift nur bei schwerwiegenden Ausreißern ein.

Agentic-Ansätze erhöhen jedoch Latenz, Kosten und Komplexität und sind besonders für niedrige Stückzahlen/hohe Varianz oder Ausnahmefälle geeignet.

Warum hybride Architekturen sich durchsetzen

Die LLM-Integration in spezialisierte Dokumentenverarbeitungstools zeigt: Unternehmen erkennen Stärken und Grenzen von KI realistisch an.

Hybride Architekturen bieten:

- deterministische Genauigkeit für Routine,

- semantische Flexibilität für Spezialfälle,

- planbare Kosten und Performance

- bessere Prüfbarkeit und Compliance

Strategische Empfehlung

Die Zukunft ist nicht „LLM-first“, sondern LLM-bewusst. Erfolgreiche Unternehmen werden:

- LLMs für Flexibilität & Entscheidungsunterstützung einsetzen,

- Spezialengines für exakte Extraktion und Massenverarbeitung nutzen,

- Architekturen mit klarer Trennung von Intelligenz und Zuverlässigkeit bauen.

Wann nutzt man LLMs und wann Spezialtools zur Dokumentenverarbeitung?

| Entscheidungskriterium | Large Language Models (LLMs) einsetzen | Spezialisierte Dokumentenverarbeitungstools (z. B. Parseur) nutzen |

|---|---|---|

| Dokumentenvariabilität | Hohe Varianz, neue/unstrukturierte Dokumente (E-Mails, Freitext, Verträge) | Gleichförmige oder semistrukturierte Dokumente (Rechnungen, Belege, Formulare) |

| Genauigkeitsanspruch | Beratende/Ausgabe mit menschlicher Prüfung ausreichend | System-of-Record-Automatisierung mit deterministischer Genauigkeit |

| Fehlertoleranz | Einzelne Fehler akzeptabel | Streng niedrige Fehlerquote gefordert |

| Regulatorisches Risiko | Unregulierte oder wenig kritische Daten | Gewährleistung regulatorischer Vorgaben (DSGVO, Finanzen etc.) |

| Datenschutz & Souveränität | Anreicherung/Support, keine vollständige Speicherung | Isolation, Prüfbarkeit, Löschmaschinen |

| Verarbeitungsmenge | Kleine bis mittlere Mengen | Große Mengen (tausende bis Mio. Dokumente/Monat) |

| Latenzempfindlichkeit | Sekundentakt akzeptabel | Fast-Echtzeit (Millisekunden) gefordert |

| Kosteneffizienz bei Skalierung | Bei geringen Mengen tragbar; Kosten steigen mit Volumen | Stabil niedrige Kosten bei Massendaten |

| Integrationskomplexität | Flexible Ausgaben, lose gekoppelt | Präzise Schemata, tiefe ERP/RPA-Integration |

| Best-Fit-Anwendungen | Klassifikation, Zusammenfassung, Intenterkennung, Anreicherung | Rechnungsbearbeitung, AP/AR, Formularauslese, Compliance |

Ausblick: LLMs, agentische Systeme und Automatisierung

Der Markt für KI-gestützte Dokumentenautomatisierung wandelt sich rasant. Für Unternehmen ist es entscheidend, heutige und künftige Trends zu kennen, um Automatisierungsstrategien nachhaltig zu gestalten.

1. Künftige LLM-Architekturen

- Multimodale Modelle: LLMs können gleichzeitig Text, Bild, Tabellen und Dokumente verarbeiten—neue Anwendungsfälle für Rechnungs-, Formular- und PDF-Prozesse.

- Retrieval-Augmented-Modelle (RAG): Einbindung von externem Wissen steigert Genauigkeit und Datenschutz, da sensible Kundendaten im Unternehmen verbleiben.

- Agentic-AI-Workflows: Mehrstufiges Reasoning und Integration spezialisierter Tools ermöglichen Feldabgleiche, Vertragssummenbildung oder Ausnahmenerkennung.

2. Unternehmensadoption – Entwicklungstrends

- Prognosen: Bis 2027 wird KI praktisch jede Großorganisation durchdringen. Kombination aus Generative AI, Content Processing und hybriden Architekturen wird zur Norm.

- Ziel bleibt, menschlichen Aufwand zu reduzieren, Durchlaufzeiten zu senken und aus unstrukturierten Daten strategische Erkenntnisse zu ziehen.

3. Erklärbarkeit, Vertrauen und Governance

- Mit wachsendem LLM-Einsatz wird Erklärbarkeit wichtiger. Unternehmen müssen Ergebnisse nachvollziehen, plausibilisieren und dokumentieren können.

- Human-in-the-Loop bleibt für kritische Dokumente (Verträge, Rechnungen, Finanzberichte) wesentlich.

- Die Unternehmensautomation wird hybrid aufgebaut, sodass LLM-Flexibilität durch deteministische Engines abgesichert bleibt.

Das Gleichgewicht von KI-Intelligenz und operativer Kontrolle

Large Language Models (LLMs) bringen enorme Fähigkeiten im Verstehen unstrukturierter Texte und im Reasoning über komplexe Inhalte. Für die Extraktion von Enterprise-Daten sind sie jedoch keine Standalone-Lösung. Unternehmen sollten LLMs gezielt für flexible, kontextgetriebene Aufgaben nutzen und für Präzision, Compliance und Skalierbarkeit weiterhin auf spezialisierte Plattformen wie Parseur setzen. Die intelligente Verbindung von KI und spezialisierter Extraktionsengine hebt Dokumentenautomatisierung auf ein neues Level—schneller, präziser und kontrollierbar.

Häufig gestellte Fragen

Um Entscheidern in Unternehmen ein besseres Verständnis der praktischen Anwendungen und Einschränkungen von Large Language Models in Dokumenten-Workflows zu vermitteln, haben wir Antworten auf die häufigsten Fragen zu deren Einsatz, Sicherheit und Integration mit Spezialtools wie Parseur zusammengestellt.

-

Wofür eignen sich LLMs bei der Dokumentenverarbeitung?

-

LLMs sind hervorragend geeignet, um unstrukturierten Text zu übersetzen, Muster zu erkennen, Inhalte zu klassifizieren sowie kontextabhängige Informationen zu extrahieren. Sie sind ideal für flexible, anspruchsvolle Workflows, funktionieren aber probabilistisch und nicht deterministisch.

-

Warum können LLMs spezialisierte Extraktionstools nicht ersetzen?

-

LLMs liefern mitunter inkonsistente Ergebnisse, tun sich mit layoutsensitiven Daten schwer und sind in großer Skalierung kostenintensiv. Tools wie Parseur bieten deterministische Genauigkeit, Compliance und Skalierbarkeit für große Mengen strukturierter Dokumente.

-

Sind LLMs für Unternehmensdaten sicher?

-

Die Sicherheit hängt von der Implementierung ab. Viele LLMs nutzen geteilte APIs, die Daten behalten könnten. Parseur gewährleistet isolierte Verarbeitung, konfigurierbare Aufbewahrung und Compliance gemäß DSGVO und anderen Vorschriften.

-

Wie sollten Unternehmen LLMs und Spezialtools kombinieren?

-

LLMs für Reasoning und unstrukturierte Daten einsetzen, spezialisierte Engines für große Mengen, strukturierte oder regulierte Dokumente verwenden – für maximale Flexibilität und Zuverlässigkeit.

Zuletzt aktualisiert am