I Large Language Models (LLM) offrono una flessibilità impareggiabile nella comprensione del testo non strutturato, rendendoli ideali per compiti di ragionamento, riepilogo e automazione documentale a basso volume. Tuttavia, la loro natura probabilistica, la latenza e la mancanza di precisione deterministica li rendono insufficienti come unica soluzione per l'automazione di documenti regolamentati e ad alto volume.

Punti Chiave:

- Flessibilità Strategica: I LLM eccellono nell'interpretazione di documenti non strutturati, nuovi o molto variabili, consentendo una più rapida attivazione di processi guidati dal ragionamento.

- Limitazioni Operative: Nei flussi strutturati e ad alto volume, i soli LLM possono portare a errori, lentezza e rischi di compliance. I sistemi deterministici restano essenziali.

- Vantaggio dell’Ibrido: Le strategie più efficaci per l’automazione documentale combinano LLM con piattaforme specializzate come Parseur, sfruttando l’AI per la comprensione contestuale e affidandosi all’estrazione deterministica per accuratezza, scalabilità e conformità.

Il Paradosso dell’Automazione

I Large Language Models hanno rivoluzionato la comprensione del linguaggio naturale, estendendo ciò che è tecnicamente possibile nell’automazione dei documenti. Attività che richiedevano regole rigide o configurazioni manuali ora possono essere gestite con molta più flessibilità.

Limiti dei LLM

Tuttavia, questa flessibilità introduce un paradosso per l’automazione enterprise. Mentre i LLM funzionano bene nei casi guidati dal ragionamento o a basso volume, gli standard di Hyperscience dimostrano che raggiungono spesso solo il 66-77% di accuratezza nell’estrazione esatta su documenti critici come fatture e bill of lading, rispetto a oltre il 93-98% di sistemi IDP specializzati.

Quindi, pur eccellendo in casi di ragionamento e basso volume, i LLM non sono progettati per agire come sistemi di record, dove accuratezza deterministica, schemi fissi e prestazioni prevedibili sono obbligatori.

Output non deterministici, latenza variabile per limiti di API e costi crescenti di inferenza rendono difficile distribuire sistemi puramente basati su LLM in ambienti produttivi che richiedono velocità, coerenza e prevedibilità.

Sviluppo dell’IDP ibrido

Di conseguenza, l’automazione documentale aziendale richiede sempre più un approccio ibrido. Le architetture IDP (Intelligent Document Processing) ibride combinano l’adattabilità dei LLM con la precisione di motori di estrazione specializzati e logiche deterministiche, offrendo un livello superiore di qualità ed efficienza.

Nessuna tecnologia, infatti, può ottimizzare contemporaneamente flessibilità, accuratezza, costi e governance. Le aziende stanno adottando modelli che separano ragionamento da esecuzione, ottimizzando ogni layer per il ruolo operativo anziché forzare i LLM a gestire compiti deterministici per cui non sono stati progettati.

Secondo Fortune Business Insights, il mercato globale dell’IDP crescerà dai 14,16 miliardi di dollari del 2026 a 91,02 miliardi di dollari entro il 2034, con un CAGR del 26,20%, riflettendo la forte domanda di sistemi affidabili tra le grandi imprese che gestiscono alti volumi di documenti. In tale modello, i LLM sono impiegati selettivamente dove la comprensione contestuale porta valore. Al contempo, l’estrazione ad alto volume e l’automazione downstream sono affidate a sistemi progettati per affidabilità, controllo dei costi e conformità.

La conclusione strategica è chiara: i LLM sono una componente potente dell’automazione documentale moderna, ma non sostituiscono i motori di elaborazione specializzati. Le organizzazioni che allineano ogni tecnologia ai propri punti di forza sono quelle meglio posizionate per scalare senza sacrificare accuratezza, governance e prestazioni.

Cosa sono i Large Language Models (LLM)?

I Large Language Models (LLM) sono una classe di modelli di machine learning progettati per comprendere, generare e ragionare sul linguaggio naturale su larga scala. Addestrati su enormi corpora testuali tramite reti neurali profonde, tipicamente architetture transformer, apprendono relazioni statistiche tra parole, frasi e concetti.

A grandi linee, i LLM prevedono il token successivo più probabile (parola o simbolo) dato un contesto di token precedenti. Questo semplice meccanismo, esposto a dataset massivi e variegati, permette comportamenti complessi tra cui riassunto, classificazione, risposta a domande, traduzione e ragionamento contestuale. In ambito documentale, i LLM consentono di spiegare testo libero, inferire significato in più paragrafi e rispondere a layout o stili linguistici differenti.

Scala e sviluppo dei LLM

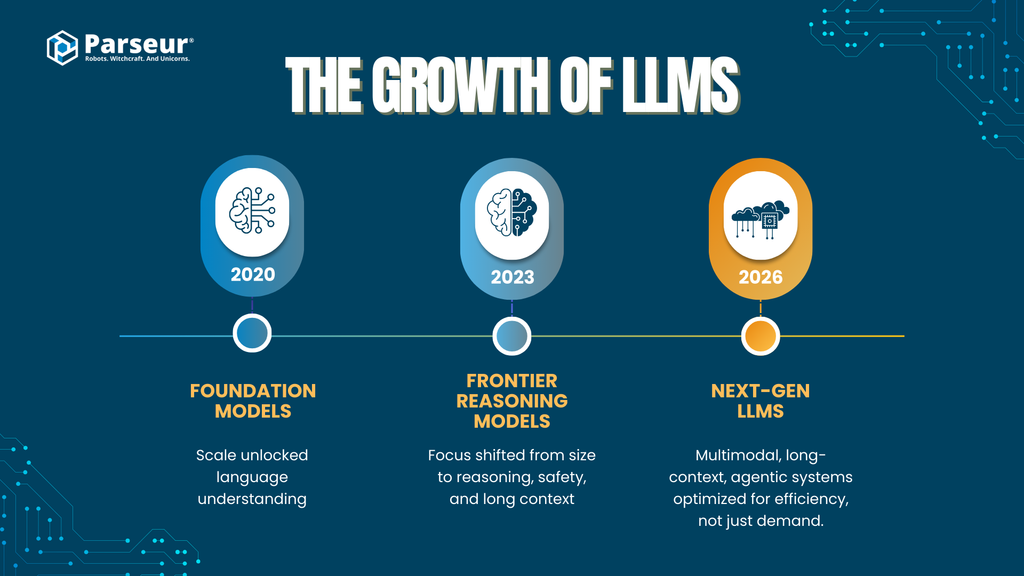

Le capacità dei LLM sono cresciute rapidamente grazie a evoluzioni nella scala dei modelli e nelle tecniche di training:

- Modelli fondazionali iniziali (2020–2021)

Modelli come GPT-3 hanno introdotto architetture transformer di grande scala (~175 miliardi di parametri), dimostrando che la sola scala poteva sbloccare una comprensione del linguaggio molto efficace.

- Modelli di seconda generazione (2023–2024)

Modelli come GPT-4, Claude 2/3 (Anthropic), Gemini 1.x (Google) e DeepSeek-LLM si sono focalizzati su miglioramenti nel ragionamento, tuning sulla sicurezza e finestre di contesto più lunghe. Anche se i vendor non rivelano più i parametri precisi, si ritiene che operino a livello o oltre il trilione di parametri, considerando mixture-of-experts e ottimizzazioni architetturali.

- Modelli potenziati dalla ricerca e dal recupero

Piattaforme come Perplexity AI puntano sulla generazione aumentata dalla ricerca (RAG), combinando ragionamento LLM con ricerca in tempo reale e meccanismi di citazione, per migliorare accuratezza e ridurre le allucinazioni in compiti knowledge-intensive.

- LLM di prossima generazione (2025–2026)

L'accento degli sviluppatori si sposta verso:

- Multimodalità (testi, immagini, tabelle, documenti, audio)

- Elaborazione di lunghissimo contesto (da centinaia di migliaia a milioni di token)

- Capacità agentiche (uso di strumenti, ragionamento multi-step, orchestrazione)

- Efficienza e specializzazione invece dell'aumento lineare della dimensione del modello

Questo trend segnala che i guadagni di prestazione derivano sempre di più da architetture, strumenti e design di sistema, anziché dal semplice numero di parametri, una distinzione importante per l'automazione documentale enterprise.

Trend di adozione aziendale

- I LLM passano dai progetti pilota alla produzione

- Il 78% delle aziende dichiara di utilizzare la generative AI in almeno una funzione, incluse operation, analytics e automazione.

- Rapidissima crescita dei lanci enterprise

- Entro il 2026, oltre l’80% delle aziende utilizzerà API di generative AI o applicazioni GenAI in produzione (contro meno del 5% nel 2023) secondo Gartner.

- L’elaborazione documentale è un caso d’uso chiave enterprise

- L'automazione dei documenti e l'estrazione dati sono tra le applicazioni GenAI principali, trainate dalla richiesta di ridurre il lavoro manuale, velocizzare i processi e migliorare l’efficienza (McKinsey, Gartner).

Rilevanza per l’automazione documentale

Nei workflow documentali, i LLM sono utilizzati soprattutto per:

- Trattare testo non strutturato o semi-strutturato

- Classificare documenti per tipo o intento

- Estrarre campi poco definiti dove le regole fisse falliscono

- Gestire variabilità linguistica tra fornitori, regioni e formati

Tuttavia, pur eccellendo nell’interpretazione e nel ragionamento, i LLM sono sistemi intrinsecamente probabilistici: i loro output sono generati in base alla probabilità, non tramite regole deterministiche. Questo implica conseguenze importanti per accuratezza, ripetibilità, costi e governance, specialmente nell’elaborazione documentale massiva.

Questa distinzione porta a una domanda centrale: dove i LLM aggiungono valore strategico e dove restano fondamentali i sistemi documentali specializzati.

Capacità Fondamentali: Dove eccellono i LLM (Lo strato strategico)

I Large Language Models eccellono nello strato strategico dell’automazione documentale: dove contano flessibilità, comprensione semantica e ragionamento più della precisione deterministica. I loro punti di forza sono qualitativi, ideali nella fase iniziale dell’automazione, nei casi limite e nei workflow knowledge-intensive.

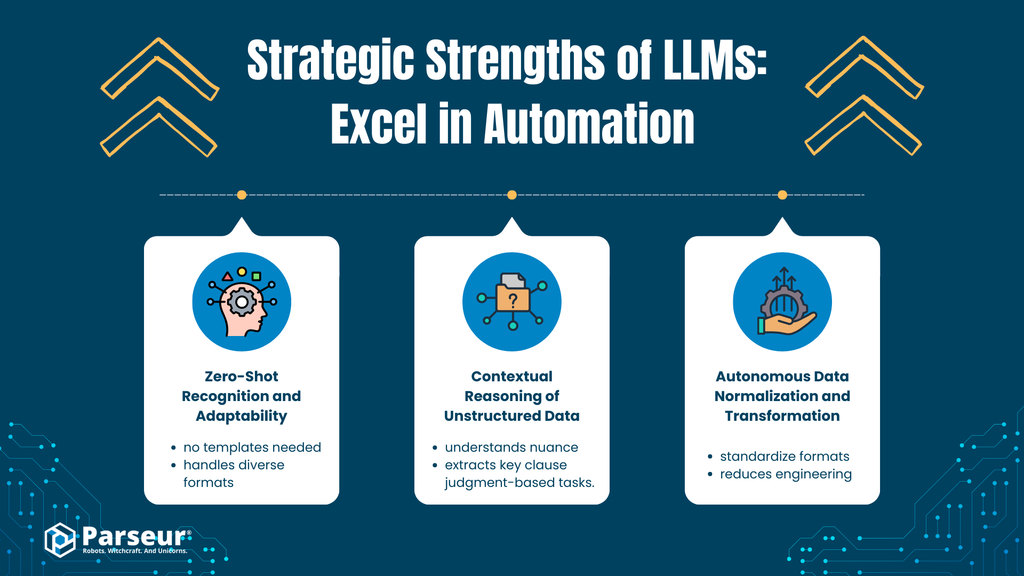

A. Riconoscimento Zero-Shot e Adattabilità

Analisi

I LLM possiedono una forte comprensione semantica che consente di riconoscere ed estrarre informazioni da documenti e layout mai visti. Ad esempio, un LLM può individuare numero di fattura, data di scadenza o importo totale da una fattura non standard di un nuovo fornitore, anche se le etichette o la formattazione sono diverse.

Questa capacità deriva dall’apprendimento linguistico generalizzato, non da training specifici sul documento. Il modello deduce il significato dal contesto, non da template o regole fisse.

Impatto aziendale

- Accelera il time-to-value riducendo la configurazione iniziale

- Riduce la dipendenza da grandi dataset etichettati

- Consente un onboarding più rapido per nuovi fornitori e formati

Per aziende attive in ambienti dinamici o eterogenei, questa adattabilità abbassa le barriere iniziali all’automazione.

B. Ragionamento contestuale su dati non strutturati

Analisi

A differenza dei sistemi tradizionali basati su regole (es. regex, logiche posizionali), i LLM analizzano sfumature, intenzioni e significati impliciti in testi strutturati e non. Questo comprende email, clausole di contratti, policy e corrispondenza con i clienti.

Possono estrarre significato da linguaggio narrativo, capire relazioni tra concetti e ragionare su più paragrafi, capacità molto difficili da codificare con regole deterministiche.

Impatto aziendale

- Automatizza processi che richiedono ragionamento e giudizio

- Supporta casi d'uso come:

- Classificazione degli intenti del cliente

- Identificazione di clausole in testi legali

- Estrazione di date chiave, obblighi e rischi in testi narrativi

- Riduce le revisioni manuali in processi knowledge-heavy

Risulta quindi particolarmente efficace dove la struttura è incoerente e il contesto conta tanto quanto il contenuto.

C. Normalizzazione e trasformazione autonoma dei dati

Analisi

I LLM possono normalizzare i dati durante l’estrazione, ad esempio:

- Convertire formati di data diversi in rappresentazioni standard (es. ISO 8601)

- Standardizzare valute e numeri

- Uniformare i nomi dei campi tra fonti incoerenti

Questo riduce la necessità di logiche downstream o pipeline di post-processing.

Impatto aziendale

- Semplifica l'integrazione con sistemi a valle (ERP, CRM, analytics)

- Riduce il lavoro di pulizia dei dati per lo sviluppo

- Velocizza il roll-out di progetti PoC o pilota

Punti di Forza Strategici dei LLM nell'Automazione

Più in generale, i LLM portano all’automazione d’impresa:

Comprensione del linguaggio su scala enterprise

Estrazione, riepilogo e categorizzazione di testo non strutturato su grandi volumi documentali.

Flessibilità semantica

Individuazione del significato malgrado variazioni di frase, layout e intenzioni.

Ragionamento non vincolato da regole

Classificazione, inferenza e riconoscimento di pattern senza logiche esplicite.

Applicazione rapida cross-settore

Utili in customer support, revisione legale, knowledge management e tooling interno.

Base per workflow agentici

Consentono catene di prompt, scomposizione di task e orchestrazione di decisioni nei sistemi AI.

Ad esempio, un nostro cliente SaaS che gestiva annualmente circa 4.000 fatture, ha avviato un progetto per automatizzare l’acquisizione delle fatture. Grazie ai LLM, il cliente ha ridotto del 40% l’onere manuale sui fornitori standard. Tuttavia, con fatture da vecchi fornitori, con formati non standard e PDF scansionati, i LLM non riuscivano a estrarre correttamente importi totali o date. La soluzione è stata integrare controlli basati su regole e verifica OCR per i LLM. È fondamentale comprendere che i LLM sono più adatti a supportare l'automazione documentale, ma non dovrebbero essere l'unico strumento a guidare il processo decisionale. - Nick Mikhalenkov, SEO Manager, Nine Peaks Media

Limiti Critici: Dove i LLM si fermano (Lo strato operativo)

Sebbene i Large Language Models offrano un enorme valore strategico, i loro limiti emergono chiaramente se usati per l’automazione documentale enterprise ad alto volume. Dove servono accuratezza, costanza, velocità e controllo dei costi, l’approccio puramente basato su LLM introduce rischi reali.

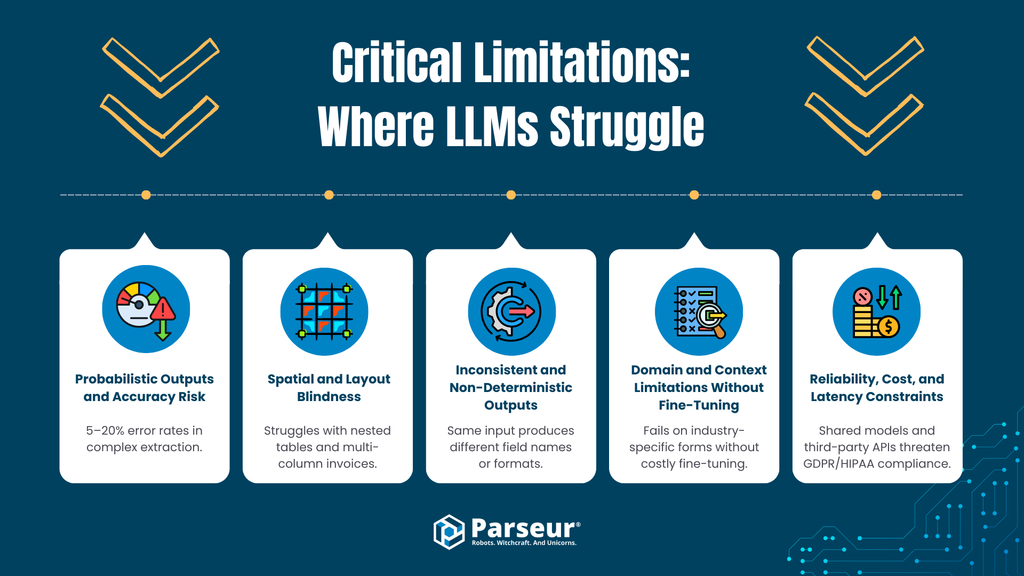

A. Output probabilistici e rischio di errore

Limite

I LLM sono sistemi probabilistici: generano output in base alla probabilità, non tramite regole certe. Anche i modelli più avanzati producono risultati errati o inventati. Secondo Master of code, i tassi di errore/allucinazione possono variare dal 5 al 20% nei casi di ragionamento o estrazione complessi.

Rischio Operativo

In contabilità e nei workflow finanziari (conti fornitori/clienti, procurement, report di compliance), gli errori probabilistici sono inaccettabili. Ramp mostra che la gestione manuale delle fatture ha tassi di errore tra l'1 e il 3%, ovvero 10–30 transazioni problematiche ogni 1.000, che vanno corrette o investigate. L’uso puro di LLM non garantisce mai output identici a input identici, senza ulteriori layer di verifica o revisione umana, erodendo i benefici stessi dell’automazione.

B. Ciechi alla disposizione e al layout

Limite

La maggior parte dei LLM processa testo sequenziale, senza comprensione nativa dei rapporti spaziali. Sanno leggere testo estratto, ma faticano a interpretare il significato derivante dalla disposizione spaziale, ad esempio:

- Fatture con più colonne

- Tabelle annidate o multilinea

- Intestazioni che coprono più colonne

- Valori definiti dalla posizione, non da etichette

Tuttavia, nuovi modelli stanno lentamente colmando questo gap.

Rischio Operativo

Nei documenti strutturati, il layout è la logica. Errori su righe o colonne portano a:

- Voci abbinate a prezzi o quantità sbagliati

- Totali inseriti nei campi errati

- Intestazioni propagate male

Sono errori sottili, difficili da rilevare e dannosi per i workflow automatizzati.

C. Output incoerenti e non deterministici

Limite

I LLM di default non impongono schemi rigidi: presenza di campi, nomi, formati e ordine possono variare tra le esecuzioni, specie se cambiano i prompt o la struttura dei documenti.

Rischio Operativo

I sistemi aziendali richiedono output prevedibili (es. JSON fisso, nomi di campo costanti, tipi di dati normalizzati). La variabilità forza le aziende a:

- Costruire layer di validazione e correzione

- Gestire infiniti casi limite

- Reintrodurre processi di revisione manuale

Così si perde l’affidabilità necessaria per l’automazione E2E.

D. Limiti di dominio/contesto senza fine-tuning

Limite

Nonostante l'ampia conoscenza, senza fine-tuning o prompt accurati i LLM mostrano difficoltà su schemi molto specializzati (es. documenti logistici, moduli fiscali, fatture di settore).

Rischio Operativo

Il fine-tuning introduce complessità:

- Richiede dataset curati

- Allunga i tempi di sviluppo

- Complica la privacy dei dati e la loro conservazione

- Va mantenuto nel tempo

Per molte imprese, il vantaggio plug-and-play svanisce.

E. Vincoli su affidabilità, costi e latenza

Limite

L’inferenza LLM, specie nel ragionamento multi-step, è costosa. I workflow reali richiedono 8-40 secondi per documento usando LLM, contro i millisecondi delle soluzioni OCR/estrazione specializzate.

Rischio Operativo

Su larga scala questo porta a:

- Costi API anche 10-100 volte maggiori rispetto a sistemi IDP specializzati

- Latenza che blocca i processi urgenti

- Limiti su throughput e carichi simultanei

Se si processano migliaia di documenti al mese, i costi unitari diventano insostenibili.

F. Esposizione a rischi di privacy e compliance

Limite

Molte integrazioni LLM implicano API di terze parti, architetture condivise o politiche di conservazione dei dati non chiare. In ambienti regolamentati questo comporta rischi verso:

- Limiti del GDPR su finalità e minimizzazione dei dati

- Diritto alla cancellazione e auditabilità

- Compliance HIPAA, GLBA e di settore

Rischio Operativo

Se i documenti transitano su modelli che possono registrare, trattenere o riusare i dati per il training, le aziende perdono il controllo sulle informazioni sensibili. Non sempre contratti e DPA sono sufficienti a ridurre il rischio.

Dal mio punto di vista, uno dei maggiori limiti dei Large Language Models nell’automazione documentale resta l’impossibilità di garantire risultati precisi quando è davvero richiesto. I LLM sono ottimi nel riassumere e capire il testo, ma falliscono nell’estrazione strutturata: errori anche minimi su cifre o date possono compromettere l’intero processo. Inoltre, i LLM comunicano un alto grado di sicurezza nelle risposte anche quando i dati non ci sono o sono ambigui.

Nei casi educativi, ho visto i LLM funzionare bene nel riassumere materiale o spiegare concetti, ma fallire sistematicamente nell’estrazione standardizzata da record accademici o risultati di test. I sistemi tradizionali a regole, con supervisione umana, superano ampiamente l’automazione pura LLM in questi scenari. - Joern Meissner, Founder & Chairman, Manhattan Review

Sintesi: Intelligenza strategica vs. affidabilità operativa

I Large Language Models offrono capacità di comprensione semantica e ragionamento senza pari, ma nei workflow documentali enterprise presentano limiti in termini di precisione, estrazione deterministica, interpretazione del layout, costi ed esigenze regolatorie. Output probabilistici e tempi più lunghi rendono rischioso usare solo LLM per l'elaborazione massiva di fatture, l'automazione AP e altri flussi strutturati.

L’ascesa dell’“Agentic AI” nell’elaborazione documentale

Per superare i limiti dell’estrazione basata solo su LLM, emerge il modello Agentic AI: i LLM non sono più generatori a passo singolo ma orchestratori che invocano strumenti esterni, ragionano a passaggi multipli e validano iterativamente i propri output.

Cos’è l’Agentic AI?

Agentic AI indica sistemi in cui un LLM:

- Suddivide i compiti in step multipli

- Chiama strumenti esterni (OCR, calcolatrici, DB, script di validazione)

- Revisiona e corregge i propri output

- Ripete il ciclo fino a raggiungere una soglia di confidenza

Per i documenti: il LLM estrae dati, controlla totali, re-interroga, corregge inconsistenze e infine restituisce il risultato.

Obiettivo: meno hallucinations

Con la validazione iterativa e l'uso di strumenti, i workflow agentici riducono gli errori comuni dei LLM:

- Incoerenze numeriche

- Campi mancanti

- Errori logici evidenti (es. totale ≠ somma delle righe)

Il LLM passa da un “tentativo unico” a un sistema auto-correttivo, migliorando le performance dove i documenti sono complessi o ambigui.

Compromessi: latenza, costi, complessità

Tuttavia questa architettura impone significativi compromessi:

Latenza

Ogni step e ogni strumento aggiunge secondi. In pratica, un workflow agentico può impiegare 8–40 secondi per documento: troppo per il processing in tempo reale o per grandi batch.

Costi

Chiamate multiple al LLM aumentano l’uso di token e i costi API; su larga scala si può arrivare a costi per documento anche dieci volte superiori rispetto alle pipeline deterministiche.

Complessità tecnica

Servono:

- Framework di orchestrazione

- Gestione degli errori multi-tool

- Livelli di monitoraggio

- Tuning continuo di prompt e logica

Aumentano così i tempi e il carico di mantenimento.

In pratica: non per l’automazione ad alto volume

Se si elaborano migliaia di documenti al mese, questi compromessi sono spesso insostenibili. L’automazione ad alto volume richiede:

- Latenza prevedibile

- Costi stabili

- Output deterministici

- Modalità di fallimento semplici

L’Agentic AI aumenta la profondità di ragionamento, non l’efficienza operativa.

Verdetto: Potente, ma con ambiti ristretti

L’Agentic AI rappresenta un progresso importante, ma i suoi punti di forza sono:

- Ricerca a basso volume e alta complessità

- Gestione di eccezioni e casi limite

- Revisione di documenti knowledge-intensive

Non è adatto per pipeline produttive o di data entry su larga scala.

L’Agentic AI potenzia il ragionamento dei LLM, ma non elimina i trade-off fondamentali dei modelli probabilistici. Nell’automazione documentale high-throughput, resta un complemento dei sistemi specializzati deterministici.

Perché gli strumenti specializzati restano fondamentali (Parseur e il valore dei motori dedicati)

L’interesse verso l’automazione spinta da LLM porta molte aziende a supporre che i modelli generalisti possano sostituire i sistemi documentali tradizionali. In realtà, sta emergendo l’opposto: chi raggiunge un'automazione affidabile su grande scala combina i LLM con motori specializzati, usando ciascuno dove rende di più.

Strumenti come Parseur esistono non perché ai LLM manchi intelligenza, ma perché l’automazione enterprise richiede precisione, prevedibilità ed efficienza operativa prima del ragionamento generalizzato.

Precisione su larga scala

Le soluzioni documentali lavorano con vincoli profondamente diversi dalla AI conversazionale. Fatture, ordini e formulari finanziari richiedono accuratezza a livello di campo, non una comprensione approssimativa.

I motori specializzati si basano su:

- Estrazione rafforzata da regole

- Riconoscimento di pattern sensibile al layout

- Modelli di classificazione ottimizzati per documenti strutturati

Questo garantisce output deterministici: lo stesso documento dà sempre lo stesso risultato.

Nei LLM, invece, anche tassi di errore minimi si amplificano su larga scala, con costi di riconciliazione e gestione delle eccezioni che azzerano i vantaggi dell’automazione.

Regole configurabili con apprendimento mirato

Le piattaforme moderne non si basano più solo su regole: uniscono:

- Template e regole di validazione configurabili

- Modelli leggeri di classificazione

- Rilevamento di campi assistito da AI (opzionale)

Così si ottiene oltre il 95% di accuratezza sui campi su formati anche variabili.

Spesso, invece, i workflow basati solo su LLM riportano errori di campo maggiori su documenti finanziari strutturati, mentre le soluzioni IDP dedicate riducono gli errori di estrazione e inserimento dati di oltre il 52%, riducendo notevolmente la revisione manuale.

La differenza chiave è il controllo: le aziende specificano:

- Formati ammessi

- Logica di validazione

- Modalità di fallback

Un livello di determinismo impossibile in sistemi basati solo su prompt.

Integrazione e maturità del workflow

Le piattaforme specializzate sono nate per l’operatività enterprise, non per i prototipi.

Offrono:

- REST API stabili e webhook

- Integrazione nativa con ERP, contabilità e CRM

- Compatibilità con strumenti di automazione (Zapier, Make, Power Automate)

- Monitoraggio, retry e gestione degli errori integrata

Così l’automazione documentale diventa una componente affidabile, non una fragilità orchestrata via prompt e script.

I LLM si integrano bene nel layer logico di ragionamento, ma gli strumenti specializzati gestiscono la parte operativa richiesta per la scala enterprise.

Sicurezza e compliance innate

Per i documenti enterprise, sicurezza e compliance sono requisiti architetturali.

Piattaforme come Parseur prevedono:

- Isolamento dei dati a livello di tenant

- Crittografia at-rest e in-transito

- Politiche di conservazione configurabili

- Controlli di cancellazione e processing allineati al GDPR

Siccome questi sistemi non usano i documenti per il re-training dei modelli globali, evitano problemi di data sovereignty e auditability presenti nelle piattaforme AI condivise.

Nelle industrie regolamentate questa distinzione è vitale: la compliance dipende non solo da come i dati sono conservati ma anche se vengono riusati.

Il punto d’incontro: LLM all'interno degli strumenti di elaborazione documenti

Superata la fase sperimentale, ora i LLM vengono integrati dentro gli strumenti documentali, non usati come motori di estrazione isolati. Questo approccio ibrido unisce l’adattabilità dei modelli linguistici AI all’affidabilità dei sistemi deterministici.

Non sostituiscono l’automazione tradizionale, ma operano come strati di supporto: aumentano flessibilità, gestione degli errori e intelligenza downstream, mentre l'estrazione core resta strutturata e controllata.

Questo riflette un principio architetturale più ampio: i LLM sono più efficaci quando sono vincolati da sistemi che impongono accuratezza, performance e compliance.

Layer di correzione e arricchimento guidati da prompt

Un uso estremamente efficace dei LLM è l’arricchimento post-estrazione.

Tipicamente:

- Un motore deterministico o sensibile al layout estrae i campi base (numero, totale, scadenza…).

- Il LLM interviene selettivamente per:

- Normalizzare descrizioni

- Risolvere etichette ambigue

- Aggiungere metadati contestuali (es. categorizzazione del fornitore, identificazione dei termini di pagamento)

Il LLM agisce dopo l’estrazione core, così la sua natura probabilistica non mina l’integrità dei dati. Gli errori possono essere verificati o ignorati, senza impattare il workflow.

Così si ottiene flessibilità senza rischio sistemico.

Validazione human-in-the-loop tramite LLM di sintesi

Un altro pattern emergente è usare i LLM per aiutare i revisori umani, non per sostituirli.

Ad esempio:

- Riassumere lunghi documenti per evidenziare campi o anomalie

- Spiegare il motivo per cui un campo non è valido

- Generare note di revisione in linguaggio naturale per gli audit trail

Nelle piattaforme documentali, ciò riduce il carico cognitivo nella gestione delle eccezioni, pur mantenendo il controllo finale in mano all’operatore umano.

Operativamente, migliora la velocità e la coerenza senza affidare ai LLM l'input dei dati ufficiale, una distinzione importante nei workflow regolamentati.

Workflows AI agentici: LLM che orchestrano sistemi deterministici

Le piattaforme più avanzate sperimentano workflow agentici con i LLM che coordinano strumenti lungo la pipeline documentale.

In queste architetture:

- Il LLM fa da orchestratore

- I sistemi deterministici gestiscono OCR, classificazione ed estrazione dei campi

- Le regole di validazione impongono vincoli

- L’intervento umano scatta solo al superamento di certe soglie

Il loro utilizzo va comunque ben delimitato: come detto, i workflow agentici aumentano latenza, costi e complessità operativa, quindi sono ideali per:

- Documenti a basso volume e alta variabilità

- Task di riconciliazione intersistema

- Workflow guidati dalle eccezioni

Per l’estrazione ad alto volume, l’AI agentica complementa (non sostituisce) i motori documentali.

Perché l’ibrido è lo standard enterprise

L’adozione di massa dei LLM nelle piattaforme documentali nasce dalla consapevolezza dei limiti e dei benefici dell'AI.

I sistemi ibridi offrono:

- Accuratezza deterministica per dati strutturati

- Flessibilità semantica per i casi limite

- Costi e performance prevedibili anche su larga scala

- Compliance e auditabilità solide

Parola d’ordine strategica

Il futuro dell’automazione documentale NON è LLM-first, ma LLM-aware:

Le organizzazioni di successo nel 2026 e oltre saranno quelle che:

- Usano i LLM per le decisioni e la flessibilità

- Affidano l’esecuzione a motori specializzati

- Progettano architetture dove l’intelligenza è vincolata dall’affidabilità

Quando usare LLM e quando strumenti di elaborazione documentale specializzati

| Criterio di Decisione | Usa Large Language Models (LLM) | Usa strumenti di elaborazione documentale specializzati (es. Parseur) |

|---|---|---|

| Variabilità documentale | Documenti molto variabili, nuovi o non strutturati (email, testo libero, contratti) | Documenti coerenti o semi-strutturati (fatture, scontrini, moduli) |

| Requisito d’accuratezza | Output consultivi o assistivi dove è ammessa la revisione umana | Automazione sistemica con accuratezza deterministica e ripetibile |

| Tolleranza all'errore | Qualche imprecisione è accettabile | Tolleranza all'errore quasi zero |

| Rischio regolatorio | Dati non sensibili o non regolamentati | Dati regolamentati (GDPR, CCPA, finanza, sanità) |

| Privacy e sovranità dei dati | Dati usati per ragionamento/arricchimento con scarsa necessità di conservazione | Isolamento rigoroso, auditabilità e diritto all’oblio richiesti |

| Volume di processamento | Basso o medio volume | Alto volume (migliaia/milioni di documenti al mese) |

| Sensibilità alla latenza | Latenza di alcuni secondi per documento accettabile | Elaborazione in millisecondi/on-demand richiesta |

| Efficienza dei costi su scala | Accettabile a basso volume; costi crescenti con la scala | Costo unitario prevedibile su grandi volumi |

| Complessità di integrazione | Output flessibili, workflow "loosely coupled" | Schemi fissi, integrazione ERP/RPA/Accounting |

| Casi d’uso ideali | Classificazione, riepilogo, intent detection, arricchimento | Fatturazione, AP/AR, estrazione da moduli, compliance |

Sguardo al futuro: LLM, sistemi agentici e automazione

L’automazione documentale basata su AI evolve rapidamente. Le aziende devono comprendere le tecnologie attuali e i trend emergenti che plasmeranno le strategie future.

1. Architetture LLM di nuova generazione

- Modelli multimodali: i LLM processeranno non solo testo ma anche immagini, tabelle e PDF, ampliando le possibilità per l'automazione di fatture e moduli.

- Modelli potenziati dal recupero (RAG): Integrando fonti esterne, migliorano accuratezza e comprensione senza dover riaddestrare i modelli sui dati del cliente.

- Workflow agentici: Loop di ragionamento e strumenti consentono ai LLM di eseguire compiti autonomi, tra cui controlli incrociati, sintesi di contratti e suggerimenti per la gestione delle eccezioni.

2. Trend d’adozione enterprise

- Proiezioni future: L’adozione dell'AI raggiungerà livelli universali nei grandi gruppi entro il 2027, con la GenAI che diventerà centrale nei workflow. Lo scenario suggerisce un futuro di stack di automazione ibrida.

- Il focus sarà sulla riduzione dell’intervento umano, sulla velocizzazione operativa e sugli insight strategici ottenuti dai dati non strutturati aziendali.

3. Spiegabilità, fiducia e oversight

- L'adozione crescente dei LLM porterà maggior pressione sull'AI spiegabile: serviranno meccanismi per audit, verifica delle decisioni e compliance.

- L’human-in-the-loop resterà cruciale, specie per contratti, fatture o bilanci.

- Le strategie prediligeranno architetture ibride che uniscono la flessibilità dei LLM all’affidabilità deterministica dei motori specializzati, garantendo fiducia e compliance.

Equilibrare intelligenza AI e controllo operativo

I Large Language Models (LLM) offrono grandi capacità cognitive nella comprensione del testo non strutturato e nel ragionamento documentale complesso, ma non sono la soluzione unica per l’estrazione dati aziendale. Il loro valore emerge quando vengono adottati selettivamente per task strategici che necessitano flessibilità e comprensione contestuale, affidandosi parallelamente a piattaforme come Parseur per garantire accuratezza deterministica, compliance, scalabilità e auditabilità. Così, unendo l'intelligenza artificiale e i motori di estrazione dedicati, le aziende possono ottenere affidabilità operativa e insight strategico, ottimizzando l’automazione documentale per velocità, precisione e controllo.

Domande Frequenti

Per aiutare i decision maker aziendali a comprendere le applicazioni pratiche e i limiti dei Large Language Models nei flussi di lavoro documentali, abbiamo raccolto le risposte alle domande più comuni sul loro utilizzo, sicurezza e integrazione con strumenti specializzati come Parseur.

-

Per cosa sono utili i LLM nell’elaborazione dei documenti?

-

I LLM eccellono nell'interpretare testo non strutturato, riconoscere pattern, classificare contenuti ed estrarre informazioni contestuali. Sono ideali per flussi di lavoro flessibili che richiedono ragionamento, ma sono probabilistici e non deterministici.

-

Perché i LLM non possono sostituire gli strumenti di estrazione specializzati?

-

I LLM possono produrre output incoerenti, avere difficoltà con dati dipendenti dalla disposizione e sono costosi su larga scala. Strumenti come Parseur offrono accuratezza deterministica, conformità e scalabilità per grandi volumi e documenti strutturati.

-

I LLM sono sicuri per i dati aziendali?

-

La sicurezza dipende dall’implementazione. Molti LLM usano API condivise che possono conservare i dati. Parseur garantisce elaborazione isolata, conservazione configurabile e conformità a GDPR e altre normative.

-

Come dovrebbero le aziende combinare LLM e strumenti specializzati?

-

Utilizza i LLM per ragionamento e dati non strutturati, e motori specializzati per documenti regolamentati, strutturati o ad alto volume, per garantire flessibilità e affidabilità.

Ultimo aggiornamento il