Les grands modèles de langage (GML) offrent une flexibilité inégalée pour comprendre le texte non structuré, ce qui les rend idéaux pour le raisonnement, la synthèse d’informations et les tâches documentaires à faible volume. Pourtant, leur nature probabiliste, leur latence et l'absence de précision déterministe les rendent insuffisants en tant qu’approche unique pour l’automatisation de documents à fort volume et soumis à la réglementation.

À retenir :

- Flexibilité stratégique : Les GML excellent dans le traitement de documents non structurés, nouveaux ou très variables, accélérant l’intégration et les tâches nécessitant du raisonnement.

- Limites opérationnelles : Pour des flux de travail structurés et volumineux, les seuls GML peuvent générer des erreurs, ralentir le traitement et exposer à des risques de conformité. Les systèmes déterministes restent essentiels.

- Avantage hybride : Les stratégies d’automatisation documentaire les plus performantes combinent GML et plateformes spécialisées comme Parseur, exploitant l’IA pour la compréhension contextuelle tout en s’appuyant sur l’extraction déterministe pour la précision, l'échelle et la conformité.

Le paradoxe de l’automatisation

Les grands modèles de langage (GML) ont radicalement fait avancer la compréhension du langage naturel. Leur capacité à interpréter le texte non structuré, à inférer le sens et à généraliser à travers plusieurs domaines élargit considérablement le champ du possible dans l’automatisation documentaire. Des tâches qui nécessitaient autrefois des règles rigides ou une configuration manuelle poussée peuvent désormais être abordées beaucoup plus souplement.

Limites des GML

Cependant, cette flexibilité introduit un paradoxe pour l’automatisation d’entreprise. Si les GML excellent dans les scénarios orientés raisonnement ou à faible volume, les standards établis par Hyperscience montrent qu’ils n’atteignent souvent que 66-77 % de précision d’extraction exacte sur des tâches documentaires critiques comme les factures ou les connaissements, contre 93-98 % avec les systèmes d’IDP spécialisés.

Bien que cette flexibilité soit précieuse dans certains cas, les GML ne sont donc pas conçus pour servir de système de référence, là où la précision déterministe, les schémas fixes et des performances prévisibles sont impératifs.

Leur sortie non déterministe, une latence variable due à la limitation des API et la montée des coûts d’inférence (liés au volume de tokens et à la demande GPU) rendent les systèmes entièrement basés sur des GML difficiles à déployer en production dans des environnements nécessitant rapidité, cohérence et prévisibilité.

L’essor de l’IDP hybride

De plus en plus, l’automatisation documentaire d’entreprise requiert donc une approche hybride. Les architectures hybrides de Traitement Intelligent de Documents (IDP) conjuguent l’adaptabilité des GML à la précision des moteurs d’extraction spécialisés et à la logique déterministe, offrant un meilleur compromis qualité/efficacité.

Cette évolution traduit une reconnaissance croissante : aucune technologie seule n’optimise simultanément flexibilité, précision, coût et conformité. Les entreprises adoptent des architectures séparant explicitement le raisonnement de l’exécution, afin que chaque couche soit optimisée pour son rôle opérationnel, sans surcharger les GML de tâches déterministes pour lesquelles ils ne sont pas conçus.

Selon Fortune Business Insights, le marché mondial de l’IDP devrait passer de 14,16 milliards de dollars en 2026 à 91,02 milliards d'ici 2034 (TCAC : 26,20 %), traduisant la demande croissante pour ces systèmes fiables auprès des grandes entreprises gérant de gros volumes documentaires. Dans ce modèle, les GML sont utilisés avec discernement là où la compréhension contextuelle est à forte valeur ajoutée, tandis que l’extraction de masse, la validation et l’automatisation aval sont confiées à des systèmes spécialisés, optimisés pour la fiabilité, la maîtrise des coûts et la conformité.

La conclusion stratégique est sans appel : les GML sont un puissant élément de l’automatisation documentaire moderne, mais ne constituent pas un substitut aux moteurs de traitement spécialisés. Les organisations qui appuient chaque technologie sur ses atouts opérationnels sont les mieux positionnées pour faire évoluer l’automatisation sans sacrifier précision, conformité ou performance.

Qu’est-ce qu’un grand modèle de langage (GML) ?

Un grand modèle de langage (GML) est une catégorie de modèles d’apprentissage automatique conçus pour comprendre, générer et raisonner en langage naturel à grande échelle. Ces modèles sont entraînés sur d’immenses corpus de textes par des réseaux neuronaux profonds, utilisant principalement des architectures de type transformeur qui apprennent les relations statistiques entre les mots, phrases et concepts.

Globalement, les GML fonctionnent en prédisant le token (mot ou symbole) suivant le plus probable dans une séquence donnée. Exposés à des jeux de données massifs et variés, ils permettent des comportements complexes : synthèse, classification, questions-réponses, traduction, raisonnement contextuel… En traitement documentaire, cela permet aux GML d'interpréter du texte libre, d'inférer le sens d'un paragraphe à l’autre et de s’adapter à des mises en page et styles rédactionnels variés.

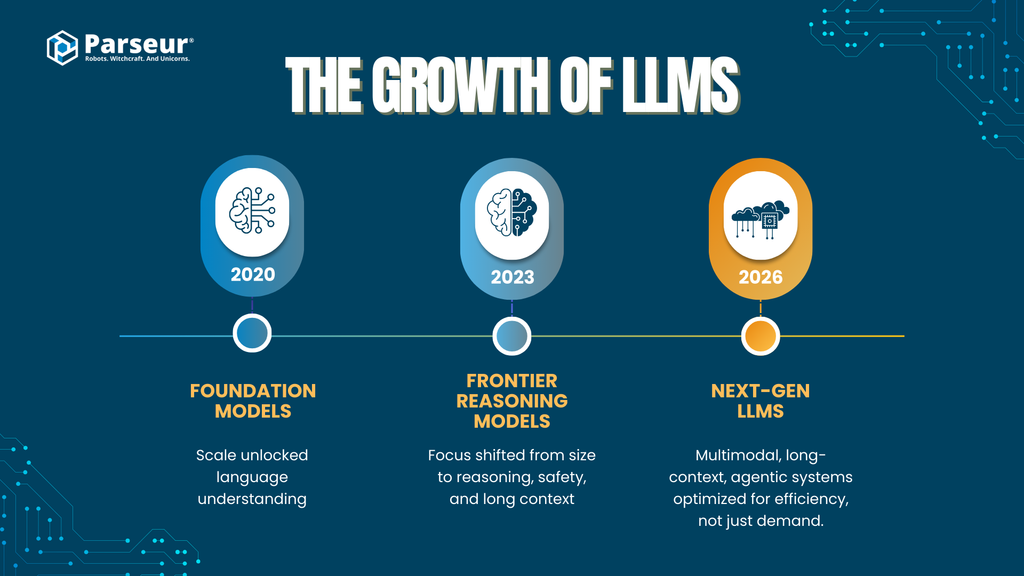

Évolution et développement des GML

Les capacités des grands modèles de langage ont rapidement progressé avec l’augmentation de la taille des modèles et l’évolution des techniques chez les grands acteurs de l’IA :

Premiers modèles de fondation (2020-2021)

Des modèles comme GPT-3 ont introduit des architectures transformeurs massives (~175 milliards de paramètres), montrant que le passage à l’échelle pouvait à lui seul débloquer une forte compréhension polyvalente du langage.

Modèles de seconde génération (2023-2024)

Avec GPT-4, Claude 2/3 (Anthropic), Gemini 1.x (Google) ou DeepSeek-LLM, l’accent a dépassé la seule taille pour intégrer un meilleur raisonnement, des ajustements de sécurité et de longues fenêtres de contexte. Quoique la taille exacte des modèles ne soit plus divulguée, ils atteignent ou dépassent le trillion de paramètres (modèles mixtes, optimisations d’architecture…).

Modèles enrichis par la recherche et la récupération d’information

Des plateformes comme Perplexity AI mettent l’accent sur la génération augmentée par la recherche (RAG), alliant le raisonnement du GML à des méthodes de recherche en temps réel et de citation, pour mieux garantir la véracité et réduire les hallucinations dans les tâches exigeant des connaissances.

GML nouvelle génération (2025–2026)

Les avancées majeures se portent sur :

- La multimodalité (texte, images, tableaux, documents, audio)

- Le traitement de longs contextes (centaines de milliers à millions de tokens)

- Des capacités agentiques (utilisation d’outils, raisonnement multi-étapes, orchestration)

- L’efficacité et la spécialisation, non un simple accroissement de taille

Cette évolution signale une tendance sectorielle : les gains de performance dépendent de plus en plus de l’architecture, des outils et du design des systèmes, non seulement du nombre de paramètres – un enjeu crucial pour l’automatisation documentaire en entreprise.

Tendances d’adoption en entreprise

- Les GML passent du pilote à la production

- 78 % des organisations déclarent utiliser l’IA générative dans au moins une fonction métier, dont l’opérationnel, l’analytique et l’automatisation.

- La mise en production s’accélère

- D’ici 2026, plus de 80 % des entreprises auront utilisé une API d’IA générative ou lancé des applications GenAI en production, contre moins de 5 % en 2023 (Gartner).

- Le traitement de documents est un cas d’usage phare

- L’automatisation documentaire et l’extraction de données comptent parmi les principales applications de la GenAI, portée par la demande de réduction d’effort manuel, de raccourcissement des cycles de traitement et de gains opérationnels (McKinsey, Gartner).

Intérêt pour l'automatisation documentaire

Dans les flux documentaires, les GML servent principalement à :

- Traiter des textes non structurés ou semi-structurés

- Classer les documents par type ou intention

- Extraire des champs vaguement définis, là où les règles fixes échouent

- Gérer les variations linguistiques selon fournisseurs, régions et formats

Néanmoins, si les GML excellent en interprétation et raisonnement, ils demeurent fondamentalement probabilistes. Leurs résultats se fondent sur la vraisemblance, non des règles fixes : cela implique des enjeux pour la précision, la répétabilité, les coûts et la conformité dans les environnements à fort volume.

Cette distinction prépare la question centrale à traiter par les entreprises : où les GML sont-ils générateurs de valeur stratégique, et où les systèmes spécialisés sont-ils irremplaçables ?

Capacités principales : là où les GML excellent (la couche stratégique)

Les grands modèles de langage apportent leur valeur maximale à la couche stratégique de l’automatisation documentaire, là où la flexibilité, la compréhension sémantique et le raisonnement comptent plus que la seule précision déterministe. Leur force est qualitative, non mécanique : ils sont particulièrement efficaces pour l’automatisation de premiers niveaux, les cas extrêmes et les flux à forte intensité de connaissances.

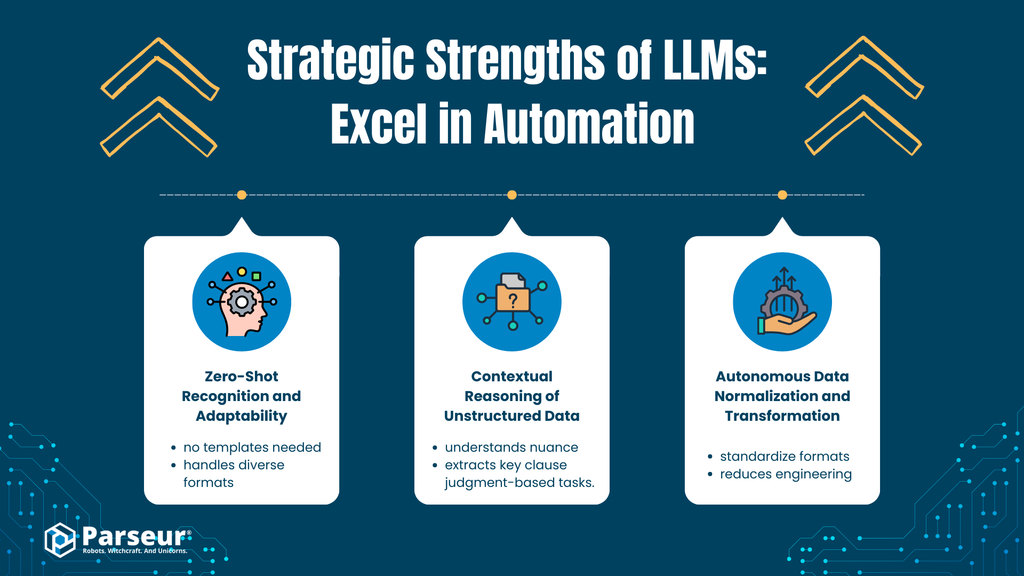

A. Reconnaissance zéro-shot et adaptabilité

Analyse

Les GML présentent une forte compréhension sémantique : ils peuvent reconnaître et extraire des informations pertinentes de types et mises en page de documents jamais rencontrés auparavant. Par exemple, un GML saura localiser les numéros de facture, dates d’échéance ou montants totaux sur une facture atypique, même si l’étiquetage, la position ou la mise en forme diffèrent radicalement des exemples vus lors de son entraînement.

Cette capacité découle d’une modélisation généralisée du langage, non d’un entraînement spécifique par modèle de document. Le sens est inféré du contexte, sans règles fixes ou modèles prédéfinis.

Bénéfices pour l’entreprise

- Accélère la mise en production en réduisant la configuration initiale

- Limite la dépendance à des jeux de données annotés importants

- Permet l’intégration rapide de nouveaux fournisseurs, formats ou types de documents

Pour les entreprises évoluant dans des contextes dynamiques, cette adaptabilité réduit sensiblement les freins initiaux à l’automatisation.

B. Raisonnement contextuel sur données non structurées

Analyse

Contrairement aux systèmes reposant sur des règles (expressions régulières, positions fixes…), les GML analysent la nuance, l’intention et le non-dit dans le texte semi-structuré ou non structuré : emails, clauses de contrat, politiques, correspondance client…

Ils savent extraire la signification de discours narratif, comprendre les relations conceptuelles et raisonner sur des paragraphes, compétences difficilement codables par des règles déterministes.

Bénéfices pour l’entreprise

- Automatise des workflows relevant du jugement humain

- Cas couverts :

- Classification d’intentions client

- Identification de clauses juridiques

- Extraction de dates, obligations, risques à partir de documents narratifs

- Réduit la relecture manuelle dans les processus intensifs en connaissances

Cela rend les GML particulièrement pertinents pour les domaines où la structure fluctue et le contexte importe autant que le contenu.

C. Normalisation et transformation autonome des données

Analyse

Les GML peuvent normaliser des données extraites au moment même de la génération. Par exemple, ils peuvent :

- Convertir différents formats de date vers une notation standard (ISO 8601)

- Uniformiser les devises et formats numériques

- Harmoniser le nommage des champs à partir de sources hétérogènes

Cela allège le besoin de logique de transformation ultérieure ou de scripts de nettoyage complexes.

Bénéfices pour l’entreprise

- Facilite l’intégration aux systèmes ERP, CRM, BI…

- Réduit l’effort d’ingénierie pour le formatage

- Accélère le lancement d’expérimentations ou de pilotes

Les atouts stratégiques des GML pour l’automatisation

Plus globalement, ils apportent :

Compréhension du langage naturel à grande échelle

Extraire, synthétiser et catégoriser du texte non structuré sur de gros volumes de documents.

Flexibilité sémantique

Décoder le sens malgré les variantes de formulation, disposition ou intention.

Raisonnement généralisé sans règles fixes

Classifier, inférer, reconnaître des patterns sans arbres de décision explicites.

Applicabilité immédiate multi-domaines

Utilisable en support client, revue juridique, gestion documentaire, outils internes.

Base pour les workflows agentiques

Activer la composition de prompts, la décomposition des tâches, l’orchestration des décisions dans des systèmes pilotés par IA.

Par exemple, un de nos clients SaaS, qui traitait environ 4 000 factures annuellement, a lancé un projet d’automatisation de la réception des factures. En s’appuyant sur les GML, il a pu réaliser 40 % d’économies sur la charge manuelle liée aux factures fournisseurs standardisées. Cependant, pour les factures de fournisseurs plus anciens (utilisant des formats non standards ou des PDF scannés), les GML ne parvenaient pas à extraire correctement les totaux et les dates. Il a donc été nécessaire de compléter le processus avec des contrôles basés sur des règles et une vérification OCR supplémentaire. Il est donc crucial de garder à l'esprit que les GML sont de précieux assistants pour l'automatisation documentaire, mais qu'ils ne doivent pas piloter seuls le processus décisionnel. – Nick Mikhalenkov, SEO Manager, Nine Peaks Media

Limites critiques : là où les GML peinent (la couche opérationnelle)

Si les grands modèles de langage (GML) présentent une forte valeur stratégique, leurs limites s’accentuent dès lors qu’on vise une automatisation documentaire de production, à large échelle. À ce niveau opérationnel, où la précision, la cohérence, la rapidité et le contrôle des coûts sont impératifs, une approche purement GML introduit des risques tangibles.

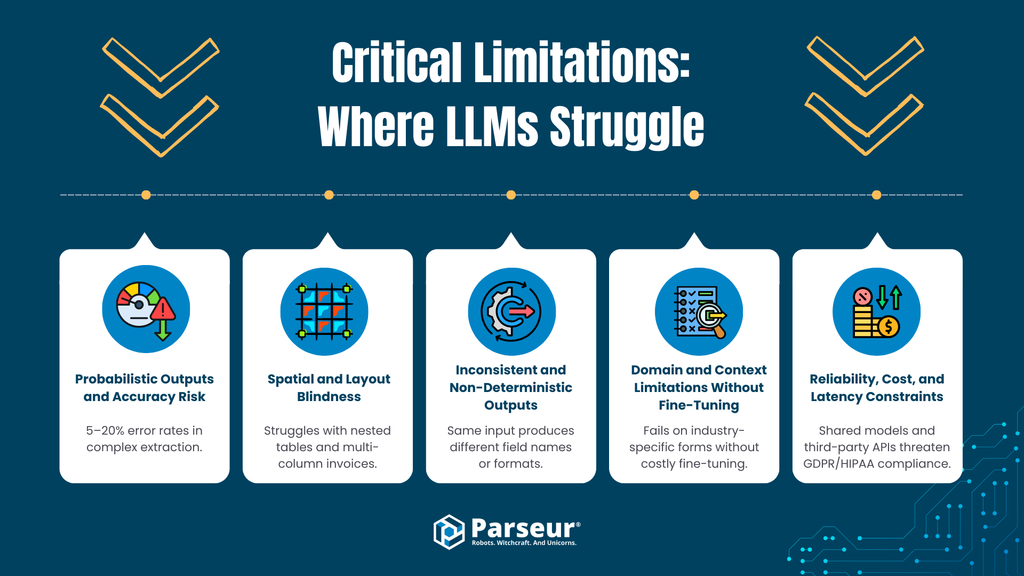

A. Résultats probabilistes & risques sur la précision

Limitation

Les GML sont probabilistes : ils produisent leurs résultats selon la probabilité, pas selon des règles invariables. Même les derniers modèles génèrent un taux non négligeable d’erreurs ou d’informations fictives. Selon les standards du secteur, des modèles de pointe comme GPT-4o continuent à présenter des taux d’erreur/hallucination de 5 à 20 % sur des scénarios complexes (Master of code).

Risques opérationnels

Dans la comptabilité fournisseurs/clients, les achats ou la conformité, de telles erreurs sont inacceptables. Les données du blog Ramp montrent que le traitement manuel des factures génère 1 à 3 % d’erreurs : soit 10 à 30 transactions problématiques pour 1 000 factures à corriger ou revérifier. Cela occasionne pertes de remises, paiements en retard, corrections coûteuses… Contrairement aux systèmes à base de règles, les GML ne garantissent pas de résultat identique à chaque entrée sans couches de vérification et relecture humaine, réduisant sensiblement le gain d’efficacité attendu.

B. Cécité spatiale et à la mise en page

Limitation

La plupart des GML traitent le texte séquentiellement, sans compréhension native des relations spatiales. Bien que la lecture du texte extrait soit possible, l’interprétation fiable de la mise en page fait défaut :

- Factures à plusieurs colonnes

- Tableaux imbriqués ou à lignes multiples

- En-têtes sur plusieurs colonnes

- Champs dont le sens dépend de la position (non du libellé)

Des progrès émergent, mais des lacunes demeurent.

Risques opérationnels

Dans un document structuré, la mise en page, c’est la logique. Se tromper d’alignement ou d’association colonne/ligne engendre :

- Désynchronisation des lignes/quantités/prix

- Totaux affectés au mauvais champ

- En-têtes propagés de façon erronée

Des erreurs subtiles, difficiles à détecter automatiquement, mais lourdes de conséquences en production.

C. Résultats inconsistants et non déterministes

Limitation

Les GML n’imposent aucune rigueur de schéma. Présence/noms/format/ordre des champs peuvent varier d’un passage à l’autre, surtout si le prompt ou le document change légèrement.

Risques opérationnels

Or, les systèmes d’entreprise exigent des sorties prédictibles, normalisées (JSON structuré, nomenclature stable…). Ce qui entraîne :

- Besoin d’étages de validation/correction complexes

- Multiplication des cas particuliers

- Maintien d’une supervision manuelle

Une fiabilité fragilisée pour l’automatisation de bout en bout.

D. Limites de contexte et de domaine sans affinement

Limitation

Les GML, bien que polyvalents, peinent sur les schémas documentaires très spécialisés (logistique, fiscalité, industries) sans adaptation spécifique (fine-tuning) ou prompt avancé.

Risques opérationnels

L’affinement exige :

- Jeux de données annotés

- Temps d’implémentation allongé

- Problématiques de confidentialité et de gestion des données

- Charges de maintenance accrues

Ce qui remet en question l'argument du « plug-and-play » souvent avancé.

E. Fiabilité, coût et latence

Limitation

L’inférence GML, en particulier raisonnement multiple ou agentique, est coûteuse en ressources. En pratique, le traitement d’un document unique peut prendre 8 à 40 secondes avec un GML, contre quelques millisecondes pour un moteur OCR/extraction dédié.

Risques opérationnels

À grande échelle :

- Les coûts API sont 10 à 100 fois plus élevés par document

- La latence complique les workflows en temps réel

- Le débit limite les charges en lot et pics de trafic

Pour les volumes mensuels de milliers à dizaines de milliers de documents, la rentabilité s’effondre vite.

F. Exposition à la confidentialité des données et conformité

Limitation

De nombreuses solutions GML reposent sur des API tierces, des architectures mutualisées ou des politiques de rétention floues. En environnement réglementé, cela soulève des préoccupations sur :

- Limitation de finalité et minimisation (RGPD)

- Droit à l’effacement et auditabilité

- HIPAA, GLBA et conformité sectorielle

Risques opérationnels

Si les documents transitent par des modèles susceptibles de conserver, logger ou recycler les données pour leur entraînement, le contrôle de l’information sensible est perdu. Les contrats ne suffisent pas toujours à couvrir le risque réglementaire.

De mon point de vue, la principale limite des grands modèles de langage en traitement documentaire est leur incapacité à garantir un résultat précis quand l’exactitude est essentielle. Les GML excellent pour synthétiser et comprendre le texte, mais échouent dans l’extraction structurée de données où la moindre erreur de note ou de date est préjudiciable. En outre, les GML répondent souvent avec assurance même lorsque les données sont absentes ou incertaines.

Pour les usages éducatifs, je constate que les GML sont efficaces pour résumer des cours ou expliquer un concept, mais peinent systématiquement à extraire correctement des informations standardisées à partir de dossiers scolaires ou résultats d’examens. Dans ces applications, les systèmes à règles avec supervision humaine sont plus performants que l’automatisation purement GML. – Joern Meissner, Fondateur & Président, Manhattan Review

Résumé : Intelligence stratégique vs fiabilité opérationnelle en automatisation documentaire

Les grands modèles de langage (GML) offrent des capacités uniques en compréhension, interprétation sémantique et raisonnement contextuel. Cependant, dans les workflows d’automatisation documentaire en entreprise, ils peinent sur la précision, l’extraction déterministe, l’interprétation spatiale, la maîtrise des coûts et la conformité. Leur caractère probabiliste et leur lenteur rendent les approches 100 % GML risquées pour les opérations structurées à fort volume comme le traitement de factures ou la gestion comptable automatisée.

L’essor de l’“Agentic AI” dans le traitement documentaire

Pour dépasser les limites du traitement basé simplement sur les GML, un nouveau schéma émerge : l’IA agentique. Ici, les GML ne servent plus seulement de générateurs de texte, mais orchestrent un éventail d’outils, appliquent du raisonnement multi-étapes et valident itérativement leurs sorties.

Qu’est-ce que l’IA Agentique ?

L’IA Agentique désigne tout système où un GML :

- Décompose une tâche en étapes

- Invoque des outils externes (moteur OCR, calculatrices, bases, scripts de validation)

- Vérifie et corrige ses propres résultats

- Répète ces cycles jusqu’à atteindre un seuil de confiance

Concrètement dans le traitement documentaire, le GML extrait des données, contrôle les totaux, relit le document, corrige et ne génère le résultat final qu’après correction d’incohérences.

Objectif : Réduction des hallucinations

Grâce à la validation itérative et au raisonnement outillé, ces workflows réduisent certains écueils majeurs des GML :

- Incohérences numériques

- Champs manquants

- Erreurs logiques évidentes (ex : totaux ≠ somme des lignes)

Le GML passe ainsi d’une simple prédiction probabiliste à un mode auto-correctif, augmentant de fait la précision sur des documents complexes ou ambigus.

Contreparties : Latence, coût, complexité

Mais ces architectures ont un coût opérationnel :

Latence

Chaque étape de raisonnement ou d’appel d’outil allonge le temps de traitement. En pratique, ces workflows prennent 8 à 40 secondes par document, incompatible avec le temps réel ou les gros volumes.

Coût

Appeler le GML de multiples fois fait flamber la consommation de tokens et les coûts API – souvent une magnitude supérieure à un pipeline d’extraction déterministe.

Complexité d’ingénierie

Ce modèle exige :

- Orchestrateurs spécialisés

- Gestion des erreurs inter-outils

- Couches d’observabilité et de monitoring

- Ajustement continu des prompts et règles

=> Du temps d’intégration et des coûts de maintenance en hausse.

Réalité opérationnelle : inefficace à grande échelle

Pour les entreprises traitant des milliers de documents/mois, le jeu n’en vaut généralement pas la chandelle. Les priorités de l’automatisation documentaire à fort volume sont :

- Latence prédictible

- Coûts maîtrisés

- Résultats déterministes

- Gestion d’erreur maîtrisée

L’IA agentique mise tout sur la profondeur de raisonnement, pas sur l’efficacité opérationnelle.

En résumé : Puissant, mais d’usage spécifique

L’IA agentique représente un vrai bond en usage des GML sur les tâches complexes, mais convient surtout à :

- Petits volumes complexes

- Traitement des exceptions, cas limites

- Lecture intensive de documents à forte valeur ajoutée

Elle n’est pas adaptée au traitement industriel ou à la saisie de masse.

L’IA agentique renforce le raisonnement des GML, sans pour autant effacer la nature probabiliste de ces modèles. Pour l’automatisation de masse, elle complète les moteurs spécialisés sans les supplanter.

Pourquoi les outils spécialisés restent indispensables (Parseur et la valeur de l’ingénierie dédiée)

Avec la montée de l’automatisation via GML, beaucoup pensent que les modèles généralistes vont supplanter les systèmes dédiés. En réalité, la tendance inverse se dessine : les entreprises les plus performantes combinent GML et moteurs documentaires spécialisés, chacun allant là où il apporte le plus de valeur.

Les plateformes dédiées comme Parseur existent non parce que les GML manqueraient d’intelligence, mais parce que l’automatisation d’entreprise requiert précision, prévisibilité et performance avant le raisonnement généralisé.

La précision à l’échelle

L’automatisation documentaire relève d’autres contraintes que l’IA conversationnelle. Factures, bons de commande et formulaires financiers réclament une précision champ par champ, non une compréhension approximative.

Les moteurs spécialisés s’appuient sur :

- Extraction enrichie de règles

- Reconnaissance de motifs tenant compte de la mise en page

- Modèles de classification calibrés pour chaque type document structuré

D’où des sorties déterministes : un même document donne toujours le même résultat.

Les GML, eux, restent probabilistes : même de faibles taux d'erreur s'accumulent rapidement, accroissant les exceptions à traiter manuellement.

Règles configurables et apprentissage ciblé

Les plateformes modernes mêlent :

- Modèles/configurations sur mesure et règles de validation

- Mini-modèles de classification

- Aide AI optionnelle pour repérer des champs

Cette hybridation garantit une précision d’extraction supérieure à 95 % dans les standards industriels, sur une diversité de formats.

À l’inverse, les workflows purement GML restent moins fiables sur documents structurés financiers. Les systèmes intelligents spécialisés montrent une réduction de plus de 52 % des erreurs d’extraction et de saisie, réduisant d’autant la charge humaine de supervision.

L’avantage majeur est le contrôle : la possibilité de définir explicitement :

- Formats admis

- Règles de validation

- Comportements en cas d’erreur

Une assurance difficile à tenir uniquement par un système à prompt.

Intégration et workflow éprouvés

Les plateformes spécialisées sont conçues pour opérer en production, et non seulement à la marge.

Elles offrent :

- APIs REST stables & webhooks

- Intégrations natives ERP, comptabilité, CRM

- Compatibilité Zapier, Make, Power Automate

- Monitoring, relance automatique, gestion d’erreurs intégrés

De quoi fiabiliser l’automatisation documentaire comme un composant solide du SI (et non un orchestre fragile de prompts/scripts).

Les GML interviennent idéalement en couche logique ou raisonnement, les outils spécialisés portent la plomberie opérationnelle.

Sécurité et conformité intégrées

En entreprise, la sécurité et la conformité sont des prérequis d’architecture.

Des plateformes comme Parseur offrent :

- Isolation des données par locataire

- Chiffrement au repos et en transit

- Retention configurable

- Suppression/conformité RGPD native

Étant donné qu’elles ne réutilisent pas les documents clients pour entraîner leurs modèles globaux, elles évitent les risques de souveraineté et de traçabilité propres aux plateformes IA mutualisées.

En secteur réglementé, cela fait toute la différence.

La convergence : GML intégrés dans les outils d’extraction documentaire

Après l’expérimentation, le modèle gagnant s’impose : les GML s’intègrent à l’intérieur des outils de traitement documentaire, et non comme moteurs de parsing indépendants. Ce modèle hybride combine adaptabilité du GML et fiabilité du déterminisme.

Au lieu de remplacer l’automatisation documentaire classique, les GML fonctionnent de plus en plus comme couches d’accompagnement, apportant souplesse, gestion d’erreurs ou intelligence supplémentaire tandis que l’extraction cœur demeure structurée.

Ce choix illustre un principe d’architecture : un GML donne le meilleur de lui-même combiné à un moteur qui garantit précision, performance, conformité.

Correction et enrichissement post-extraction via prompts

L’un des usages les plus efficaces : enrichir et corriger le résultat de l’extraction, une fois les champs principaux extraits par un moteur.

Ici :

- Le moteur déterministe extrait les champs de base (n° de facture, total, échéance…)

- Le GML intervient pour :

- Normaliser les intitulés

- Lever des ambiguïtés

- Ajouter du contexte (catégorisation fournisseur, identification des conditions de paiement…)

Son intervention après l’extraction rend son caractère probabiliste sans danger pour l’intégrité des données. Les erreurs sont circonscrites, vérifiables ou ignorables.

Une flexibilité sans les risques systémiques.

Validation humaine assistée par synthèse GML

Autre exemple : l’usage des GML pour assister le reviewer humain, non pour le remplacer.

Ainsi :

- Résumer un document long, mettre l’accent sur des champs/anomalies clés

- Expliquer pourquoi un champ a échoué à la validation

- Générer une note d’audit ou commentaire naturel

Le reviewer gagne en rapidité et homogénéité, mais conserve le dernier mot : distinction cruciale en environnement réglementé.

Workflows agentiques : le GML orchestre le déterminisme

Certaines plateformes testent des logiques agentiques, où le GML pilote toute la chaîne :

- Le GML orchestre l’OCR, la classification, l’extraction

- Les règles de validation garantissent la cohérence

- L’humain n’intervient qu’en cas de doute

Mais attention, ce type de workflow introduit latence, coût, complexité, et ne sied qu’à :

- Des documents atypiques, à faible volume

- Les conciliations inter-systèmes

- Le traitement guidé par l’exception

Pour l’extraction de masse, l’IA agentique complète les moteurs spécialisés, sans les remplacer.

Pourquoi les architectures hybrides s’imposent-elles dans l’entreprise ?

La généralisation de l’intégration GML dans les outils d’extraction reflète une vision plus mature des atouts/limites de l’IA.

Le système hybride offre :

- Précision déterministe sur le structuré

- Flexibilité sémantique sur les marges

- Coût/performance prévisibles à l’échelle

- Meilleure conformité/traçabilité

À retenir stratégiquement

L’avenir de l’automatisation documentaire n’est pas “GML first”, mais GML-aware.

Les entreprises qui réussiront en 2026 et au-delà :

- Mobilisent les GML pour l’aide à la décision et la flexibilité

- Comptent sur les moteurs spécialisés pour l’exécution opérationnelle

- Architecturent des systèmes où l’intelligence est bornée par la fiabilité

Quand utiliser un GML vs un outil spécialisé (comme Parseur) ?

| Critère de décision | Utiliser un grand modèle de langage (GML) | Utiliser un outil spécialisé (ex : Parseur) |

|---|---|---|

| Variabilité documentaire | Documents très variés, nouveaux, non structurés (emails, textes libres…) | Documents cohérents ou semi-structurés (factures, reçus, formulaires) |

| Exigence de précision | Sorties à titre consultatif ou d'assistance, où une révision humaine est acceptable | Automatisation de référence exigeant une exactitude reproductible |

| Tolérance à l’erreur | Erreurs occasionnelles acceptées | Tolérance quasi-zéro à l’erreur |

| Risque réglementaire | Données peu sensibles ou non réglementées | Données réglementées (RGPD, CCPA, finance, santé) |

| Confidentialité/souveraineté | Raisonner/enrichir, faible besoin de rétention | Isolement strict, audit, droit à l’effacement requis |

| Volume de traitement | Faible à modéré | Volumes élevés (milliers à millions par mois) |

| Sensibilité à la latence | Latence de quelques secondes tolérée | Traitement en ms ou quasi temps réel exigé |

| Efficacité-coût à l’échelle | Correct à faible volume, mais coûts explosifs à grande échelle | Coût unitaire bas, prévisible en masse |

| Complexité d’intégration | Sorties souples, workflows faiblement couplés | Schémas fixes, intégration ERP/RPA/comptabilité |

| Cas d’usage optimal | Classification, synthèse, détection d'intention, enrichissement | Analyse (parsing) de factures, comptabilité fournisseurs/clients (AP/AR), extraction de formulaires, conformité |

Perspectives : GML, systèmes agentiques & automatisation

Le paysage de l’automatisation documentaire IA évolue vite. Il est crucial de connaître non seulement les capacités actuelles des GML, mais aussi les tendances qui façonneront vos stratégies.

1. Architectures GML nouvelle génération

- Modèles multi-modaux : Les GML combinent désormais texte, images, tableaux et documents structurés – ouvrant la voie à la gestion automatique de factures, formulaires, PDF, etc.

- Modèles enrichis par récupération d’information (RAG) : L’intégration de sources externes améliore la compréhension contextuelle sans réentraîner sur des données clients sensibles.

- Workflows agentiques : Le raisonnement multi-étapes et la connexion d’outils autorisent le GML à référencer des champs, synthétiser des contrats complexes ou cerner les exceptions.

2. Tendances de l’adoption en entreprise

- Projections à venir : L’adoption IA devrait devenir la norme chez les grandes entreprises d’ici 2027, la GenAI s’intégrant au cœur de l’automatisation, du traitement documentaire et des workflows de connaissance (projection extrapolée des tendances globales).

- Les déploiements viseront surtout la réduction de la charge humaine, l’accélération des cycles et la valorisation stratégique des données non structurées.

3. Explicabilité, confiance et supervision

- Avec la progression des GML, les exigences d’IA explicable vont croître : auditabilité, validation humaine, conformité seront incontournables.

- Le contrôle humain des points critiques (contrats, factures, documents financiers…) restera clé.

- La stratégie d’automatisation en entreprise favorisera de plus en plus les architectures hybrides, alliant la souplesse GML à la fiabilité déterministe pour garantir robustesse et conformité.

Savoir équilibrer intelligence IA et contrôle opérationnel

Les grands modèles de langage (GML) apportent de puissantes capacités cognitives pour comprendre le texte non structuré et raisonner sur des documents complexes, mais ne sont pas suffisants à eux seuls pour l'extraction de données à l'échelle de l'entreprise. Il faut mobiliser les GML sur des tâches stratégiques où règnent flexibilité et interprétation contextuelle, mais s’appuyer sur des plateformes spécialisées comme Parseur pour garantir exactitude, conformité, évolutivité et auditabilité. En combinant intelligence IA et moteurs d’extraction dédiés, les entreprises allient fiabilité opérationnelle ET valeur stratégique, optimisant leur automatisation documentaire pour la rapidité, la précision et le contrôle.

Foire aux questions

Pour aider les décideurs d'entreprise à comprendre les applications concrètes et les limites des grands modèles de langage dans les flux de travail documentaires, nous avons compilé les réponses aux questions les plus fréquentes sur leur utilisation, leur sécurité et leur intégration avec des outils spécialisés comme Parseur.

-

En quoi les GML sont-ils efficaces pour le traitement documentaire ?

-

Les GML excellent dans l'interprétation de texte non structuré, la reconnaissance de schémas, la classification de contenu et l'extraction d'informations sensibles au contexte. Ils conviennent parfaitement aux flux de travail flexibles et complexes, mais restent des systèmes probabilistes plutôt que déterministes.

-

Pourquoi les GML ne peuvent-ils pas remplacer les outils d’extraction spécialisés ?

-

Les GML peuvent produire des résultats incohérents, rencontrent des difficultés avec les données dépendantes de la mise en page et sont coûteux à grande échelle. Des outils comme Parseur offrent une précision déterministe, la conformité et l’évolutivité pour les documents structurés à fort volume.

-

Les GML sont-ils sécurisés pour les données d'entreprise ?

-

La sécurité dépend de la mise en œuvre. De nombreux GML utilisent des API mutualisées pouvant conserver les données. Parseur garantit un traitement isolé, une rétention configurable et la conformité avec le RGPD et autres réglementations.

-

Comment les entreprises doivent-elles combiner GML et outils spécialisés ?

-

Utilisez les GML pour le raisonnement et les données non structurées, et des moteurs spécialisés pour les documents structurés, à fort volume ou réglementés afin d’assurer flexibilité et fiabilité.

Dernière mise à jour le