Os Grandes Modelos de Linguagem (LLMs) proporcionam uma flexibilidade incomparável na compreensão de texto não estruturado, tornando-os ideais para raciocínio, sumarização e tarefas documentais de baixo volume. No entanto, a sua natureza probabilística, a latência e a ausência de precisão determinística tornam-nos insuficientes como solução autónoma para a automação de documentos em ambientes regulados e de grande volume.

Principais Pontos:

- Flexibilidade Estratégica: Os LLMs destacam-se na interpretação de documentos não estruturados, inéditos ou altamente variáveis, permitindo uma integração e automação mais rápidas em tarefas baseadas em raciocínio.

- Limitações Operacionais: Para fluxos de trabalho estruturados e de grande volume, a utilização exclusiva de LLMs pode levar a erros, processamento lento e exposição a problemas de conformidade. Os sistemas determinísticos continuam a ser essenciais.

- Vantagem Híbrida: As estratégias mais eficazes de automação de documentos combinam LLMs com plataformas especializadas como o Parseur, aproveitando a IA para a compreensão do contexto e a extração determinística para garantir precisão, escalabilidade e conformidade.

O Paradoxo da Automação

Os Grandes Modelos de Linguagem (LLMs) revolucionaram a compreensão da linguagem natural. A sua capacidade de interpretar texto não estruturado, inferir significado e generalizar em múltiplos domínios expandiu o que é tecnicamente possível na automação de documentos. Tarefas que exigiam regras rígidas ou uma extensa configuração manual podem agora ser abordadas com muito mais flexibilidade.

Limitações dos LLMs

Entretanto, essa flexibilidade traz um paradoxo para a automação empresarial. Enquanto os LLMs têm um bom desempenho em fluxos orientados por raciocínio ou cenários de baixo volume, padrões da Hyperscience mostram que eles frequentemente atingem apenas 66–77% de precisão de correspondência exata em tarefas cruciais como faturas e conhecimentos de embarque, em comparação com mais de 93–98% dos sistemas especializados de IDP.

Embora os LLMs brilhem no raciocínio e em casos de uso de baixo volume, eles não foram projetados para operar como sistemas de registro, onde precisão determinística, esquemas fixos e desempenho previsível são mandatórios.

Resultados não determinísticos, latência variável devido a limites de API e custos de inferência crescentes, impulsionados pelo volume de tokens e pela procura de GPUs, tornam difícil a implementação fiável de sistemas puramente baseados em LLMs em ambientes que exigem velocidade, consistência e previsibilidade.

Crescimento do IDP Híbrido

Como resultado, a automação de documentos de nível empresarial exige cada vez mais uma abordagem híbrida. As arquiteturas de Processamento Inteligente de Documentos (IDP) híbridas combinam a adaptabilidade dos LLMs com a precisão de motores de extração especializados e lógica determinística, alcançando melhores resultados em qualidade e eficiência.

Essa mudança reflete o reconhecimento crescente de que nenhuma tecnologia, por si só, consegue otimizar simultaneamente flexibilidade, precisão, custo e governança. As empresas estão a priorizar arquiteturas que separam explicitamente o raciocínio da execução, permitindo que cada camada seja otimizada para o seu papel operacional, em vez de forçar os LLMs a cumprir tarefas determinísticas para as quais não foram projetados.

Segundo a Fortune Business Insights, o mercado global de IDP deverá crescer de 14,16 mil milhões de dólares em 2026 para 91,02 mil milhões de dólares até 2034, com uma CAGR de 26,20%, refletindo a crescente procura por estas soluções fiáveis entre grandes empresas que lidam com enormes volumes de documentos. Neste modelo, os LLMs são usados seletivamente onde a compreensão contextual agrega valor. Ao mesmo tempo, a extração de grande volume, a validação e a automação subsequente são realizadas por sistemas desenvolvidos para garantir fiabilidade, controlo de custos e conformidade.

A implicação estratégica é clara: os LLMs são um componente poderoso na automação moderna de documentos, mas não substituem os motores de processamento especializados. As organizações que alinham cada tecnologia aos seus pontos fortes operacionais estarão mais bem posicionadas para expandir a automação sem sacrificar a precisão, a governança ou o desempenho.

O Que São Grandes Modelos de Linguagem (LLMs)?

Grandes Modelos de Linguagem (LLMs) são uma classe de modelos de machine learning projetados para compreender, gerar e raciocinar sobre a linguagem natural em grande escala. São treinados em vastos volumes de texto utilizando redes neuronais profundas, geralmente arquiteturas do tipo transformer capazes de aprender relações estatísticas entre palavras, frases e conceitos.

Em termos gerais, os LLMs funcionam prevendo o token (palavra ou símbolo) mais provável a seguir numa sequência. Expostos a conjuntos de dados massivos e diversos, são capazes de desenvolver comportamentos complexos, incluindo sumarização, classificação, resposta a perguntas, tradução e raciocínio contextual. No processamento de documentos, isto permite que os LLMs interpretem texto livre, infiram significados ao longo de parágrafos e respondam de forma flexível a diferentes layouts e estilos de linguagem.

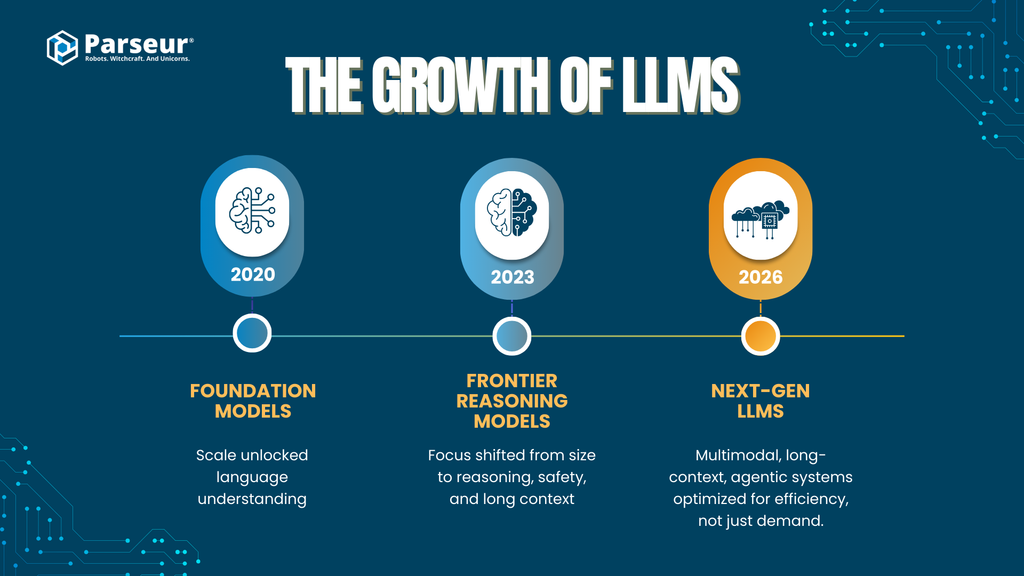

Escala e desenvolvimento dos LLMs

As capacidades dos grandes modelos de linguagem evoluíram rapidamente à medida que tanto a escala como as técnicas de treino avançaram nos principais fornecedores de IA:

- Modelos de fundação iniciais (2020–2021)

Modelos como o GPT-3 introduziram arquiteturas transformer de larga escala (~175 mil milhões de parâmetros), demonstrando que apenas o aumento da escala já possibilita uma compreensão robusta da linguagem.

- Modelos de fronteira de segunda geração (2023–2024)

Modelos como o GPT-4, Claude 2/3 (Anthropic), Gemini 1.x (Google) e DeepSeek-LLM evoluíram para além da contagem bruta de parâmetros, priorizando o raciocínio aprimorado, o ajuste de segurança e janelas de contexto maiores. Embora a maioria não divulgue o número exato de parâmetros, acredita-se que operem com uma equivalência a biliões de parâmetros, utilizando mixture-of-experts e otimizações arquitetónicas.

- Modelos com busca e recuperação aumentadas

Plataformas como a Perplexity AI enfatizam a geração com recuperação aumentada (RAG), combinando o raciocínio do LLM com mecanismos de busca e citação em tempo real para melhorar a precisão factual e reduzir alucinações em tarefas complexas.

- Próxima geração de LLMs (2025–2026)

Entre os fornecedores, o foco está a mudar para:

- Multimodalidade (texto, imagens, tabelas, documentos, áudio)

- Processamento de contextos longos (centenas de milhares a milhões de tokens)

- Capacidades agentivas (uso de ferramentas, raciocínio multinível, orquestração)

- Eficiência e especialização, em vez de um aumento linear do tamanho do modelo

Esta evolução indica uma tendência do setor mais ampla: os ganhos de desempenho vêm cada vez mais da arquitetura, das ferramentas e do design de sistemas, em vez de apenas do número de parâmetros, um ponto crucial para a automação de documentos corporativos.

Tendências de adoção empresarial

- Os LLMs passam do piloto à produção

- 78% das organizações usam IA generativa em pelo menos uma função de negócio, incluindo operações, análise de dados e automação.

- A adoção empresarial acelera rapidamente

- Até 2026, mais de 80% das empresas deverão ter utilizado APIs de IA generativa ou lançado aplicações GenAI em produção, em comparação com menos de 5% em 2023, segundo o Gartner.

- O processamento de documentos é um dos principais casos de uso

- A automação de documentos e a extração de dados estão entre as principais aplicações de GenAI graças à procura pela redução do trabalho manual, ciclos de processamento mais rápidos e eficiência operacional (McKinsey, Gartner).

Relevância para automação de documentos

Nos fluxos de trabalho com documentos, os LLMs são utilizados primariamente para:

- Processamento de texto não estruturado ou semiestruturado

- Classificação por tipo ou intenção

- Extração de campos pouco definidos, onde as regras rígidas falham

- Lidar com variações linguísticas entre fornecedores, regiões e formatos

Contudo, embora os LLMs sejam excelentes para interpretação e raciocínio, são sistemas inerentemente probabilísticos. Os seus resultados são gerados com base em probabilidades, e não em regras determinísticas — uma característica que impacta a precisão, a repetibilidade, o custo e a governança na automação de documentos de grande volume.

Esta distinção leva à questão central que as empresas precisam resolver: onde é que os LLMs agregam valor estratégico e onde é que os sistemas especializados continuam a ser essenciais.

Capacidades-Centrais: Onde os LLMs se Destacam (Camada Estratégica)

Os Grandes Modelos de Linguagem oferecem o seu maior valor na camada estratégica da automação de documentos, onde a flexibilidade, a compreensão semântica e o raciocínio são mais importantes do que a precisão determinística. Estas forças são qualitativas e não mecânicas, tornando os LLMs particularmente eficazes na automação inicial, no tratamento de exceções e em fluxos de trabalho com uma elevada carga de conhecimento.

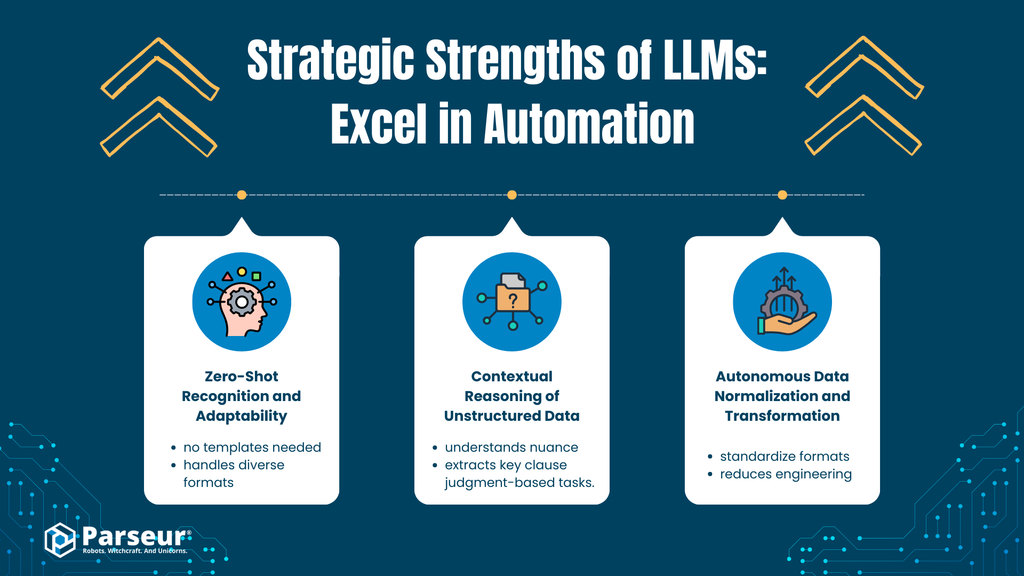

A. Reconhecimento Zero-Shot e Adaptabilidade

Análise

Os LLMs apresentam uma compreensão semântica elevada, o que lhes permite identificar e extrair informações relevantes de tipos e layouts de documentos que nunca viram antes. Por exemplo, um LLM pode extrair o número de uma fatura, a data de vencimento ou o valor total de um documento fora do padrão, mesmo que os rótulos, as posições ou a formatação sejam diferentes.

Esta capacidade deve-se à modelagem geral da linguagem, e não a um treino específico por documento: o modelo infere o significado pelo contexto, e não por regras ou modelos fixos.

Impacto no Negócio

- Acelera o tempo de obtenção de valor, com menos configuração prévia

- Reduz a dependência de grandes conjuntos de dados de treino rotulados

- Permite uma integração mais rápida de novos fornecedores, formatos e tipos de documentos

Para equipas que atuam em ambientes dinâmicos ou heterogéneos, tal adaptabilidade reduz significativamente o atrito inicial da automação.

B. Raciocínio Contextual de Dados Não Estruturados

Análise

Ao contrário dos sistemas tradicionais baseados em regras — como regex ou lógica de posição fixa — os LLMs analisam nuances, intenção e significado implícito em texto não estruturado ou semiestruturado, incluindo e-mails, cláusulas contratuais, políticas e correspondência.

Os LLMs conseguem extrair sentido da linguagem narrativa, compreender relações entre conceitos e raciocinar entre parágrafos — capacidades virtualmente impossíveis de codificar com regras determinísticas.

Impacto no Negócio

- Permite a automação de fluxos de trabalho que exigem raciocínio baseado em julgamento

- Ajuda na:

- Classificação da intenção do cliente

- Identificação de cláusulas jurídicas

- Extração de datas, obrigações ou riscos em documentos narrativos

- Reduz a revisão manual em processos com muito conhecimento envolvido

Assim, os LLMs tornam-se particularmente valiosos em áreas de baixa estrutura e onde o contexto importa tanto quanto o conteúdo.

C. Normalização e Transformação Autónoma de Dados

Análise

Os LLMs podem normalizar dados já no momento da geração, por exemplo:

- Converter diferentes formatos de data para padrões (ex: ISO 8601)

- Padronizar moedas e valores

- Harmonizar nomes de campos em fontes variadas

Isto diminui a dependência de lógica de transformação posterior, scripts personalizados ou pipelines frágeis.

Impacto no Negócio

- Facilita a integração com sistemas (ERP, CRM, análise de dados)

- Reduz os custos de engenharia para limpeza/formatação de dados

- Acelera a fase de prova de conceito (POC) e projetos-piloto

Forças Estratégicas dos LLMs na Automação

No contexto empresarial mais amplo, os LLMs trazem vantagens fundamentais para as iniciativas de automação:

Compreensão em larga escala da linguagem natural

Extraem, resumem e categorizam texto não estruturado em grandes volumes.

Flexibilidade Semântica

Identificam o significado apesar das variações de formulação, layout e intenção.

Raciocínio generalista e não limitado a regras

Classificam, inferem e reconhecem padrões sem lógica explícita ou árvores de decisão.

Aplicabilidade cruzada rápida entre domínios

Aplicável ao suporte ao cliente, revisão legal, gestão de conhecimento e ferramentas internas.

Base para fluxos de trabalho agentivos

Permitem o encadeamento de prompts, a decomposição de tarefas e a orquestração de decisões.

Por exemplo, um cliente nosso de SaaS, que processava cerca de 4.000 faturas por ano, iniciou um projeto para automatizar a entrada dessas faturas. Usando LLMs, conseguiu uma economia de 40% no trabalho manual referente às faturas padrão de fornecedores. Já para as faturas de fornecedores antigos, com formatos não padronizados e PDFs digitalizados, os LLMs não conseguiram extrair corretamente o valor total ou as datas. A solução foi fornecer verificações baseadas em regras e validação via reconhecimento ótico de caracteres (OCR) para complementar os LLMs. É fundamental entender que os LLMs são mais úteis ao auxiliar na automação, mas não devem ser os decisores finais. - Nick Mikhalenkov, SEO Manager, Nine Peaks Media

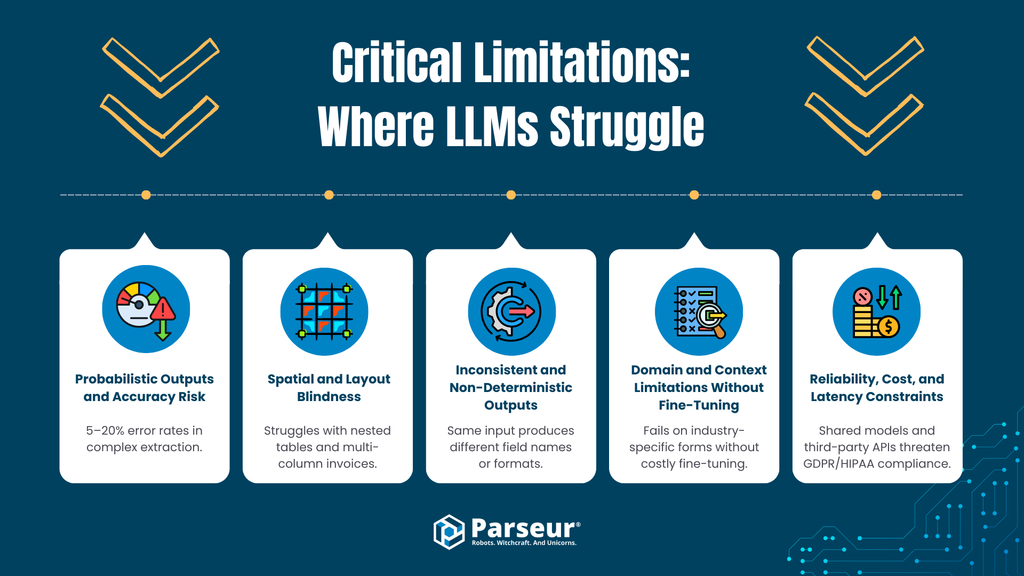

Limitações Críticas: Onde os LLMs Enfrentam Desafios (Camada Operacional)

Apesar do seu valor estratégico, as limitações dos Grandes Modelos de Linguagem tornam-se evidentes ao aplicá-los à automação de documentos em ambiente de produção e de grande volume. No nível operacional, onde precisão, consistência, velocidade e controlo de custos são inegociáveis, as abordagens 100% baseadas em LLMs introduzem riscos mensuráveis.

A. Resultados Probabilísticos e Risco de Precisão

A Limitação

Os LLMs são inerentemente probabilísticos; geram respostas com base em probabilidades estatísticas, e não em regras fixas. Mesmo os modelos avançados apresentam taxas mensuráveis de informação incorreta ou “fabricada”. De acordo com os padrões do setor, modelos de ponta como o GPT-4o e outros modelos modernos ainda apresentam taxas de erro/alucinação entre 5–20% em cenários complexos.

Risco Operacional

Em fluxos de trabalho financeiros e operacionais como contas a pagar, a receber, compras ou conformidade, os erros probabilísticos são inaceitáveis. Dados da Ramp mostram que o processamento manual já gera entre 1–3% de erros, ou seja, de 10 a 30 transações problemáticas a cada 1.000 faturas. Estes erros geram perdas de descontos, atrasos e retrabalho dispendioso. Ao contrário dos sistemas baseados em regras, os LLMs não garantem resultados idênticos para entradas idênticas sem camadas de verificação extensas, o que reduz consideravelmente os ganhos esperados da automação.

B. Cegueira ao Layout e às Relações Espaciais

A Limitação

A maioria dos LLMs processa o texto sequencialmente e não compreende as relações espaciais. Eles leem o texto extraído de documentos, mas têm dificuldade em reconhecer o significado que depende da formatação, como:

- Faturas com múltiplas colunas

- Tabelas aninhadas ou de múltiplas linhas

- Cabeçalhos que abrangem diversas colunas

- Valores cujo significado deriva da posição, e não do rótulo

Apesar disso, os modelos mais recentes estão a evoluir neste aspeto.

Risco Operacional

Em documentos estruturados, o layout é a lógica. Erros de alinhamento podem resultar em:

- Itens de linha desligados dos seus preços/quantidades

- Totais atribuídos a campos errados

- Cabeçalhos replicados incorretamente entre linhas

Estes erros são subtis, difíceis de detetar automaticamente e altamente prejudiciais.

C. Resultados Inconsistentes e Não Determinísticos

A Limitação

Os LLMs não impõem esquemas restritos por padrão. A existência/nome dos campos, a formatação e a ordenação podem variar entre execuções, especialmente se o prompt ou a estrutura do documento tiver pequenas variações.

Risco Operacional

Os sistemas empresariais exigem previsibilidade (p. ex., estrutura JSON fixa, nomes padronizados, tipos de dados normalizados). Esta variabilidade força a implementação de:

- Camadas complexas de validação e correção

- Gestão frequente de exceções

- Retorno a revisões manuais

Isto compromete a fiabilidade necessária para a automação de ponta a ponta.

D. Limitações de Domínio e Contexto Sem Ajuste Fino (Fine-Tuning)

A Limitação

Os LLMs possuem conhecimento geral, mas enfrentam dificuldades com esquemas altamente especializados (ex: documentos logísticos, formulários fiscais, faturas de nicho) sem um ajuste fino e engenharia de prompts.

Risco Operacional

O ajuste fino (fine-tuning) traz desafios:

- Exige conjuntos de dados curados

- Aumenta o tempo de desenvolvimento

- Levanta questões de privacidade e retenção de dados

- Amplia o esforço de manutenção

Para muitos, isto elimina a vantagem "plug and play" prometida pelos LLMs.

E. Fiabilidade, Custo e Latência

A Limitação

A inferência com LLMs, especialmente o raciocínio agentivo/multietapas, é dispendiosa. Os fluxos de extração reais com LLMs podem demorar de 8 a 40 segundos por documento, em comparação com os milissegundos dos motores especializados de OCR e extração.

Risco Operacional

Em grande escala, isto implica:

- Custos de API 10 a 100 vezes maiores por documento em relação aos sistemas IDP

- A latência torna-se um gargalo em fluxos de trabalho sensíveis ao tempo

- Restrições de débito (throughput) limitam o processamento em lote e em picos de procura

Para volumes de milhares de documentos por mês, a economia por unidade torna-se inviável.

F. Exposição a Riscos de Privacidade e Conformidade (Compliance)

A Limitação

Muitas integrações de LLMs utilizam APIs de terceiros, arquiteturas partilhadas ou políticas de retenção pouco claras. Em ambientes regulados, isto levanta preocupações sobre:

- Limitação de finalidade e minimização de dados (RGPD)

- Direito ao esquecimento e auditabilidade

- HIPAA, GLBA e outras normas setoriais

Risco Operacional

Se os documentos são processados em modelos que podem registar, reter ou reutilizar dados para treino, a empresa perde o controlo sobre informações sensíveis — um risco de conformidade que não pode ser mitigado apenas contratualmente.

Do meu ponto de vista, uma das maiores limitações dos Grandes Modelos de Linguagem no Processamento de Documentos é a falta de precisão quando ela é mais importante. Os LLMs são bons para resumir e compreender textos, mas falham na extração estruturada, onde pequenos erros, como ler uma nota ou uma data errada, são críticos. Além disso, os LLMs tendem a parecer muito confiantes, mesmo quando os dados estão ausentes ou pouco claros.

Em aplicações educacionais, observei que os LLMs funcionam bem ao resumir materiais ou explicar conceitos, mas falham ao extrair dados padronizados de históricos escolares ou provas. Os sistemas tradicionais baseados em regras, supervisionados por humanos, ainda superam a automação 100% baseada em LLMs nestes cenários. - Joern Meissner, Fundador & Presidente, Manhattan Review

Resumo: Inteligência Estratégica vs. Fiabilidade Operacional na Automação de Documentos

Os Grandes Modelos de Linguagem (LLMs) destacam-se na compreensão da linguagem natural, interpretação semântica e raciocínio contextual. Contudo, na automação de documentos, enfrentam limites quanto à precisão, extração determinística, interpretação de layout, eficiência de custo e conformidade. Resultados probabilísticos e processamento mais lento tornam arriscado o uso exclusivo de LLMs em tarefas estruturadas como processamento de faturas, automação de contas a pagar e outras semelhantes.

A Ascensão da “IA Agentiva” no Processamento de Documentos

Para superar as limitações da extração puramente via LLM, surge um novo padrão arquitetónico: a IA agentiva. Neste modelo, os LLMs não se limitam a gerar texto numa única etapa; eles orquestram ferramentas externas, aplicam raciocínio multinível e validam os seus próprios resultados de forma iterativa.

O que é a IA Agentiva?

A IA agentiva designa sistemas onde um LLM:

- Divide tarefas em múltiplos passos

- Aciona ferramentas externas (OCR, calculadoras, validações)

- Revisa e ajusta os seus próprios resultados

- Repete o ciclo até atingir o nível de confiança desejado

No processamento de documentos, isto significa que o LLM extrai dados, verifica totais, consulta novamente o ficheiro e corrige inconsistências antes de apresentar o resultado final.

O Benefício Procurado: Redução das Alucinações

Ao implementar ciclos de validação e raciocínio com ferramentas, os fluxos agentivos reduzem falhas comuns dos LLMs, como:

- Inconsistências numéricas

- Campos em falta

- Erros lógicos óbvios (ex: o total não corresponde à soma dos itens)

Isto eleva o LLM de uma "suposição" probabilística a um sistema autocorretivo, aumentando a precisão em documentos complexos.

O Contraponto: Latência, Custo e Complexidade

Apesar do ganho em fiabilidade de raciocínio, a abordagem agentiva traz contrapartidas substanciais:

Latência

Cada etapa e chamada de ferramenta adiciona tempo ao processamento. Na prática, os fluxos agentivos podem levar de 8 a 40 segundos por documento — o que é impraticável para operações em tempo real ou grandes lotes.

Custo

Várias execuções do LLM elevam drasticamente o consumo de tokens e os custos de API. Em escala, o custo por documento pode ser dez vezes ou mais superior ao dos pipelines determinísticos.

Complexidade de Engenharia

Os sistemas agentivos requerem:

- Frameworks de orquestração

- Tratamento de erros entre ferramentas

- Camadas para monitorização

- Afinação contínua de prompts e lógicas

Isto aumenta o tempo de integração e manutenção.

Realidade Operacional: Não Adequado para Grande Volume

Para quem processa milhares de documentos por mês, estas contrapartidas são difíceis de justificar. A automação de grande volume prioriza:

- Latência previsível

- Custos estáveis

- Resultados determinísticos

- Falhas simples e conhecidas

A IA agentiva aprimora a profundidade do raciocínio, não a eficiência operacional.

Veredito: Poderoso, porém de Uso Restrito

A IA agentiva representa uma evolução importante na aplicação dos LLMs a tarefas complexas. Mas as suas vantagens encaixam melhor em:

- Pesquisa de baixo volume и alta complexidade

- Regras de exceção e análise de outliers

- Revisões de documentos subordinadas ao conhecimento

Ela não é adequada para extração padronizada e de grande volume, nem para pipelines industriais de processamento.

A IA agentiva amplia o raciocínio dos LLMs, mas não elimina as contrapartidas fundamentais dos modelos probabilísticos. Para a automação de alto débito (throughput), ela complementa — mas não substitui — os motores determinísticos e especializados.

Por Que as Ferramentas Especializadas Ainda São Essenciais (Parseur e o Valor dos Motores Específicos)

Com o interesse crescente na automação baseada em LLMs, muitos acreditam que os modelos genéricos podem substituir as soluções tradicionais. Na prática, ocorre o oposto: as empresas de sucesso combinam LLMs com motores especializados, aplicando cada um onde entrega o maior valor.

Plataformas como o Parseur existem não pela falta de inteligência dos LLMs, mas porque a automação empresarial exige precisão, previsibilidade e eficiência operacional — prioridades que estão acima do raciocínio generalista.

Precisão em Escala

A automação de documentos enfrenta restrições muito diferentes das da IA conversacional. Faturas, ordens de compra e formulários financeiros requerem precisão campo a campo, e não apenas uma compreensão aproximada.

Os motores especializados baseiam-se em:

- Extração com regras avançadas

- Reconhecimento de padrões sensível ao layout

- Modelos de classificação calibrados para documentos estruturados

Isto gera resultados determinísticos, garantindo uma repetibilidade total.

Já a extração baseada em LLMs mantém-se probabilística. Pequenas taxas de erro tornam-se problemáticas em grandes volumes, exigindo ações corretivas que comprometem o ROI da automação.

Regras Configuráveis com Aprendizagem Direcionada

As plataformas modernas combinam:

- Modelos e regras de validação personalizáveis

- Modelos leves de classificação

- Deteção de campos assistida por IA (opcional)

Esta abordagem híbrida proporciona +95% de precisão na extração de campos, mesmo com formatos variados, segundo os padrões do setor.

A extração baseada apenas em LLMs costuma ter taxas de erro mais altas em documentos financeiros, enquanto os sistemas de IDP especializados reduzem os erros de campo e de entrada em mais de 52%, diminuindo os esforços de intervenção e revisão.

O ponto-chave é o controlo: as empresas podem definir explicitamente:

- Formatos suportados

- Lógicas de validação

- Comportamentos de fallback

Este nível de determinismo é difícil de garantir apenas com prompts.

Integração e Maturidade do Fluxo de Trabalho

Os motores especializados são criados para operar dentro de fluxos de trabalho produtivos, não apenas como provas de conceito (POC).

As ferramentas maduras oferecem:

- APIs REST e webhooks estáveis

- Integrações com sistemas ERP, de contabilidade e CRM

- Compatibilidade com plataformas de automação (Zapier, Make, Power Automate)

- Monitorização, novas tentativas (retries) e tratamento de erros integrados

Assim, a automação de documentos torna-se um componente robusto do sistema e não um arranjo frágil de prompts e scripts.

Os LLMs integram-se bem na lógica e no raciocínio, mas as ferramentas especializadas garantem a infraestrutura operacional necessária em escala.

Segurança e Conformidade Integradas

Na automação de documentos corporativos, a segurança e a conformidade são requisitos de arquitetura.

Plataformas como o Parseur são projetadas com:

- Isolamento de dados por cliente (tenant)

- Criptografia em trânsito e em repouso

- Políticas configuráveis de retenção de dados

- Processamento e exclusão alinhados com o RGPD

Por não dependerem de documentos de clientes para treinar novamente os modelos globais, evitam os principais desafios de soberania e auditabilidade de dados dos grandes serviços de IA.

Em setores regulados, isto é crucial. A conformidade depende não apenas de como os dados são armazenados, mas também de se são reutilizados.

O Cruzamento: LLMs Dentro de Ferramentas de Processamento de Documentos

Ao sair da fase de experimentação, surge um novo modelo: os LLMs são integrados em ferramentas de processamento, em vez de serem usados isoladamente como motores de extração. Esta abordagem equilibra a adaptabilidade dos LLMs com a fiabilidade do determinismo.

Em vez de substituir a automação tradicional, o papel dos LLMs torna-se de suporte, aumentando a flexibilidade, o tratamento de erros e a inteligência, enquanto a extração principal permanece estruturada e controlada.

Isto reflete um princípio arquitetónico-chave: os LLMs têm maior eficácia quando são restringidos por sistemas que garantem precisão, desempenho e conformidade.

Camadas de Correção e Enriquecimento Baseadas em Prompt

Uma das integrações mais vantajosas é o enriquecimento pós-extração.

Neste modelo:

- Um motor determinístico extrai campos essenciais (ex: número da fatura, total, data de vencimento)

- Um LLM é aplicado de modo seletivo para:

- Normalizar descrições

- Resolver rótulos ambíguos

- Adicionar metadados (categorias, identificação de termos de pagamento)

O LLM é ativado após a extração principal — a sua natureza probabilística não compromete a integridade dos dados já extraídos. Possíveis erros podem ser verificados, ignorados ou compensados, sem afetar o fluxo principal.

Assim, ganha-se flexibilidade sem risco sistémico.

Validação com Humano no Loop Usando Sumarização por LLM

Outro padrão emergente é usar LLMs para auxiliar os revisores, nunca para os substituir.

Exemplos:

- Resumir documentos extensos, destacando campos-chave ou anomalias

- Explicar a causa de falhas nos campos extraídos

- Gerar notas de revisão em linguagem natural para auditoria

Nas plataformas de processamento, isto reduz o esforço cognitivo na gestão de exceções, mantendo o controlo final no operador humano.

Operacionalmente, isto eleva a produtividade e a consistência, sem delegar a entrada de dados críticos a um LLM, o que é fundamental em fluxos de trabalho regulados.

Workflows Agentivos: LLMs Orquestrando Sistemas Determinísticos

As plataformas avançadas estão a testar fluxos de trabalho agentivos, nos quais os LLMs coordenam múltiplas ferramentas na cadeia de processamento.

Nestas arquiteturas:

- O LLM é a camada de orquestração

- Os sistemas determinísticos lidam com o OCR, a classificação e a extração

- As regras de validação impõem restrições

- A revisão humana ocorre apenas quando os limites de confiança são excedidos

Porém, isto deve ser bem delimitado. Como vimos, tais fluxos de trabalho trazem latência, custo e complexidade, sendo indicados para:

- Documentos de baixo volume e alta variedade

- Tarefas de reconciliação cruzada

- Fluxos de trabalho orientados por exceções

Na extração massiva, a IA agentiva complementa, mas não substitui, os motores especializados.

Por que Arquiteturas Híbridas se Tornam o Padrão

A integração de LLMs em ferramentas de extração reflete uma visão madura sobre as capacidades e os limites da IA.

Os sistemas híbridos permitem:

- Precisão determinística em dados estruturados

- Flexibilidade semântica para exceções

- Custos e desempenho previsíveis em escala

- Conformidade e auditabilidade aprimoradas

Resumo Estratégico

O futuro da automação de documentos não é LLM-first, mas sim LLM-aware.

As empresas que se vão destacar em 2026 e além serão aquelas que:

- Usam LLMs para ampliar a tomada de decisão e a flexibilidade

- Confiam em motores especializados para a execução operacional

- Projetam arquiteturas onde a inteligência é regulada pela fiabilidade

Quando Usar LLMs vs. Ferramentas Especializadas de Processamento de Documentos

| Critério de Decisão | Use Grandes Modelos de Linguagem (LLMs) | Use Ferramentas Especializadas (ex: Parseur) |

|---|---|---|

| Variabilidade do Documento | Documentos altamente variáveis, inéditos ou não estruturados (e-mails, texto livre, contratos) | Documentos consistentes/semiestruturados (faturas, recibos, formulários) |

| Requisitos de Precisão | Resultados de natureza consultiva, com revisão humana aceitável | Automação como sistema de registro, precisão determinística necessária |

| Tolerância a Erros | Alguma incerteza pontual é aceitável | Margem de erro mínima exigida |

| Risco Regulatório | Baixa sensibilidade/regulação | Dados regulados (RGPD, CCPA, finanças, saúde) |

| Privacidade & Soberania | Dados usados para enriquecimento, retenção limitada | Isolamento completo, auditabilidade, direito ao esquecimento |

| Volume de Processamento | Baixo a moderado | Alto volume (milhares a milhões/mês) |

| Sensibilidade à Latência | Segundos por documento é aceitável | Milissegundos ou tempo quase real exigido |

| Eficiência de Custo em Larga Escala | Viável em baixo volume; custos crescem rapidamente | Custo previsível e baixo, mesmo em larga escala |

| Complexidade da Integração | Resultados flexíveis, fluxos de trabalho desacoplados | Esquemas fixos, integrações com ERP/RPA/Sistemas de Contabilidade |

| Principais Casos de Uso | Classificação, sumarização, deteção de intenção, enriquecimento | Processamento de faturas, AP/AR, extração de formulários, conformidade |

Perspectiva Futura: LLMs, Sistemas Agentivos e Automação

A automação de documentos guiada por IA evolui rapidamente. As empresas precisam de compreender as capacidades atuais dos LLMs e as tendências que ditarão a estratégia nos próximos anos.

1. Próxima Geração de Arquiteturas LLM

- Modelos Multimodais: LLMs capazes de processar texto, imagens, tabelas e documentos simultaneamente, abrindo novas fronteiras para a automação de PDFs, formulários e faturas.

- Modelos com Recuperação (RAG): Ao integrarem fontes externas, elevam a precisão contextual sem necessidade de retreino com dados sensíveis.

- Workflows Agentivos: O raciocínio multinível e a integração de ferramentas permitem tarefas autónomas como o cruzamento de campos, a sumarização de contratos e a sugestão de tratamento de exceções.

2. Tendências de Adoção Empresarial

- Projeções: Espera-se que a adoção em grandes empresas seja universal até 2027, com a IA generativa como núcleo da automação, do processamento de conteúdo e da gestão de conhecimento, tornando as arquiteturas híbridas o padrão. (Inferência de tendências gerais)

- O foco será a redução do esforço humano, a velocidade operacional e os insights estratégicos extraídos de dados não estruturados.

3. Explicabilidade, Confiança e Supervisão

- Com o aumento do uso dos LLMs, a pressão normativa e operacional para uma IA explicável cresce. Mecanismos de auditoria, confirmação de decisões e conformidade serão obrigatórios.

- A supervisão humana (HITL) mantém-se crítica, especialmente para documentos-chave.

- As estratégias automatizadas favorecerão arquiteturas híbridas, que combinam a flexibilidade dos LLMs com a fiabilidade determinística de motores especializados.

Equilíbrio: Inteligência de IA com Controlo Operacional

Os Grandes Modelos de Linguagem oferecem um poder cognitivo na interpretação de texto livre e no raciocínio sobre documentos complexos, mas não são uma solução única para a extração de dados em escala empresarial. É recomendável selecionar LLMs para tarefas estratégicas que exigem flexibilidade e contexto, enquanto plataformas como o Parseur garantem precisão determinística, conformidade regulatória, escalabilidade e auditabilidade. Ao unir a inteligência da IA com motores especializados, as empresas conquistam fiabilidade operacional e insights estratégicos, otimizando a automação de documentos com velocidade, precisão e controlo.

Perguntas Frequentes

Para ajudar os decisores empresariais a compreender as aplicações práticas e as limitações dos Grandes Modelos de Linguagem nos fluxos de trabalho com documentos, compilámos respostas às perguntas mais comuns sobre a sua utilização, segurança e integração com ferramentas especializadas como o Parseur.

-

Para que servem os LLMs no processamento de documentos?

-

Os LLMs são excelentes para interpretar texto não estruturado, reconhecer padrões, classificar conteúdo e extrair informações sensíveis ao contexto. São ideais para fluxos de trabalho flexíveis e que exigem raciocínio, mas a sua natureza é probabilística e não determinística.

-

Porque é que os LLMs não podem substituir ferramentas especializadas de extração de dados?

-

Os LLMs podem gerar resultados inconsistentes, têm dificuldade com dados dependentes da formatação e são dispendiosos em grande escala. Ferramentas como o Parseur proporcionam precisão determinística, conformidade e escalabilidade para documentos estruturados de grande volume.

-

Os LLMs são seguros para dados empresariais?

-

A segurança depende da implementação. Muitos LLMs utilizam APIs partilhadas que podem reter dados. O Parseur garante o processamento isolado, retenção configurável e conformidade com o RGPD e outras regulamentações.

-

Como devem as empresas combinar LLMs e ferramentas especializadas?

-

Utilize LLMs para raciocínio e dados não estruturados, e motores especializados para documentos de grande volume, estruturados ou regulados, garantindo assim flexibilidade e fiabilidade.

Última atualização em