大規模言語モデル(LLM)は、非構造化テキストの理解において比類なき柔軟性を持ち、推論、要約、小規模なドキュメント関連タスクに最適です。しかし、その確率的な出力、遅延、そして決定論的な精度の欠如により、高度な規制下での大量のドキュメント自動化業務に単独で利用するには不十分です。

要点まとめ:

- 戦略的柔軟性:LLMは、構造化されていない新規の、または大きく変動するドキュメントの解釈に優れ、迅速な導入や高度な推論を必要とするタスクに最適です。

- 運用上の限界:LLMのみの運用では、構造化された大量処理ワークフローにおいて、ミスや遅延、規制上のリスクを引き起こす可能性があります。決定論的なシステムが依然として不可欠です。

- ハイブリッドの強み:最適なドキュメント自動化戦略は、Parseurのような専門プラットフォームとLLMを組み合わせることです。AIで文脈理解を強化しつつ、正確性、拡張性、法令遵守は決定論的な抽出に依存します。

自動化パラドックス

大規模言語モデル(LLM)は、自然言語理解の分野を大きく前進させました。非構造化テキストの解釈、意味の推論、そして分野を横断して一般化する能力により、以前は厳格なルールや大量の手作業による設定を要した処理も、はるかに柔軟なアプローチが可能になりました。

LLMの限界

しかし、この柔軟性は企業の自動化に一つのパラドックスをもたらします。LLMは推論を重視するシナリオや小規模な運用で優れた性能を示す一方で、Hyperscienceの基準によれば、請求書や船荷証券といった重要なドキュメント業務における厳密一致精度は66~77%にとどまり、専門のIDPシステムは93~98%を記録しています。

LLMは推論や低ボリュームの用途には強いものの、決定論的な精度、固定スキーマ、一貫したパフォーマンスが求められる基幹業務(System of Record)には不向きです。

非決定論的な出力、APIのレート制限による遅延、トークン量およびGPU需要によるコスト高騰といった現実的な課題も、スピード、一貫性、予測可能性が要求される本番環境での運用には、純粋なLLMの適用を困難にしています。

ハイブリッドIDPの台頭

そのため、エンタープライズグレードのドキュメント自動化はハイブリッド型へと進化しています。ハイブリッド知的文書処理(IDP)アーキテクチャは、LLMの柔軟性と、高精度な専門抽出エンジンおよび決定論的ロジックを組み合わせることで、品質と効率の両面で優れたパフォーマンスを実現します。

この変化の背景には、単一の技術では柔軟性、精度、コスト、ガバナンスのすべてを同時に最適化できないという認識が広がっていることがあります。企業の自動化戦略は、各レイヤーの役割を明確に分離し、「推論」と「実行」を最適に配分する設計思想へと移行しています。

Fortune Business Insightsによると、世界のIDP市場は2026年の1,416億ドルから2034年には9,102億ドルへと成長し、年平均成長率26.20%を記録する見通しです。特にドキュメント量の多い大企業を中心に、信頼性が求められています。 このモデルでは、LLMは文脈理解で価値を付加する場面で選択的に用いられ、大量の抽出、検証、自動化は、信頼性、コスト管理、法令遵守に特化したシステムによって担われます。

ここから得られる戦略的な示唆は明確です。LLMは現代のドキュメント自動化における強力な要素ですが、専門的な処理エンジンの代替とはなりません。各技術を最適な目的で使い分ける組織こそが、大規模な自動化を精度、ガバナンス、性能を損なうことなく拡大できるのです。

LLM(大規模言語モデル)とは?

大規模言語モデル(LLM)は、大量のテキストコーパスを深層ニューラルネットワーク(主にトランスフォーマー・アーキテクチャ)で学習し、自然言語を理解、生成、推論できる機械学習モデルです。

端的に言えば、LLMは直前の単語や記号列(トークン)から、最も確率的に尤もらしい次のトークンを予測します。これを巨大で多様なデータセットに適用することで、要約、分類、Q&A、翻訳、文脈からの推論といった複雑なタスクが可能になります。ドキュメント処理においては、自由記述文の解釈、段落をまたいだ意味の推論、多様なレイアウトや言い回しへの柔軟な対応が実現されます。

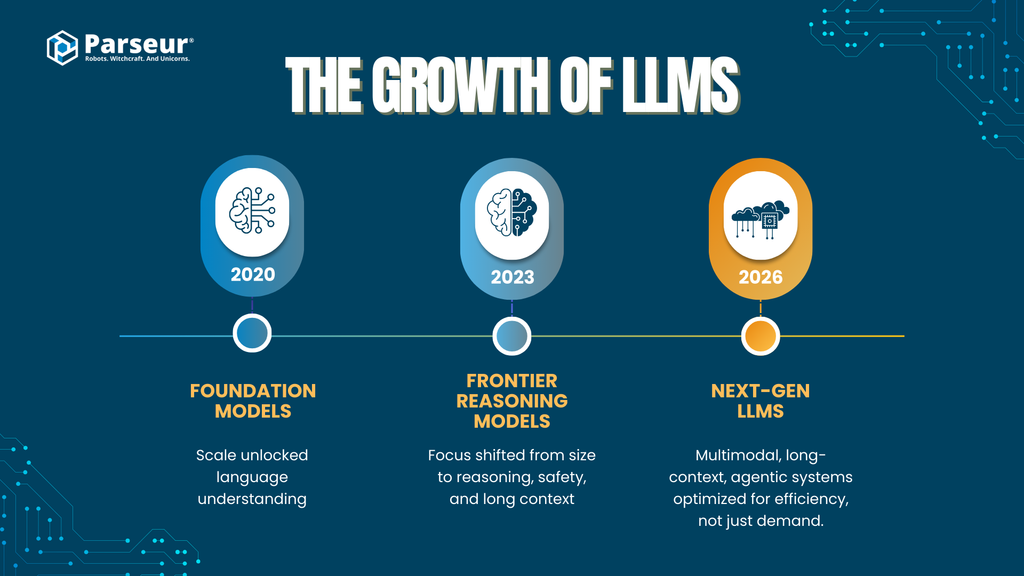

LLMの規模と進化

大規模言語モデルの能力は、主要なAIプロバイダーによるモデル規模の拡大と学習技術の進化を背景に、急速に向上しています。

- 初期基盤モデル(2020–2021)

GPT-3などのモデルは、1750億パラメータという大規模なトランスフォーマーを導入し、規模の拡大そのものが優れた汎用言語理解能力を引き出すことを示しました。

- 第2世代フロンティアモデル(2023–2024)

GPT-4、Claude 2/3(Anthropic)、Gemini 1.x(Google)、DeepSeek-LLMなどは、単なるパラメータ数の競争から、推論力、安全性の調整、長い文脈ウィンドウの重視へとシフトしました。多くのベンダーは具体的なパラメータ数を非公開としていますが、MoE(専門家の混合)やアーキテクチャの工夫により、「1兆パラメータ相当」以上に到達していると考えられています。

- 検索・検索連動型モデル

Perplexity AIのようなプラットフォームは、検索拡張生成(RAG)を前面に押し出し、リアルタイム検索と引用を組み合わせて事実性を高め、ハルシネーション(幻覚)を低減しています。

- 次世代LLM(2025–2026)

各社が注力するポイントは、以下のように移行しています:

- マルチモーダル対応(テキスト、画像、表、文書、音声)

- 長文対応(数十万~数百万トークン)

- エージェント的能力(ツールの活用、多段階推論、オーケストレーション)

- モデルサイズよりも効率と専門性

この進化は、「純粋なパラメータ数ではなく、設計、ツール、システム全体での性能最適化」が文書自動化において重要であることを示唆しています。

企業での採用トレンド

- LLMはパイロット段階から本番運用へ

- 78%の企業が、業務運営、分析、自動化などで生成系AIをすでに活用しています。

- 導入スピードは急加速

- Gartnerによると、2026年には8割以上の企業が生成AI APIを使用するか、生成AIを搭載したアプリケーションを本番環境に導入する予定です(2023年時点では5%未満)。

- ドキュメント処理は有力な企業用途

- McKinseyやGartnerによれば、ドキュメント自動化とデータ抽出は、「手作業の軽減、処理の高速化、業務効率化」という強い需要に後押しされた、優先的な利用ケースです。

ドキュメント自動化との関係性

ドキュメントワークフローでLLMが主に利用される場面は以下の通りです:

- 非構造化または半構造化テキストの処理

- 書類の種類や意図に基づく分類

- 厳格なルールが適用しにくい、緩やかなフィールドの抽出

- ベンダー、地域、書式などのバリエーションへの対応

一方、LLMは「解釈・推論」に強い反面、その性質上確率的であり、出力は決定論的ルールに基づかず、尤もらしさによって生成されます。これは、精度、再現性、コスト、ガバナンスといった大量の文書自動化に求められる要件に大きな影響を及ぼします。

この特徴から、企業が検討すべき中心的な問い、すなわち「どこでLLMが戦略的価値を発揮し、どこで専門的な処理システムが不可欠か」という問題に繋がります。

主な能力:LLMが得意とする領域(戦略レイヤー)

大規模言語モデルの真価は、「柔軟性、意味理解、推論重視」の戦略レイヤーで最も発揮されます。特に、初期の自動化、例外処理、知識集約型の業務では、定量的な精度よりも定性的な価値が重要となるため、LLMはその本領を発揮します。

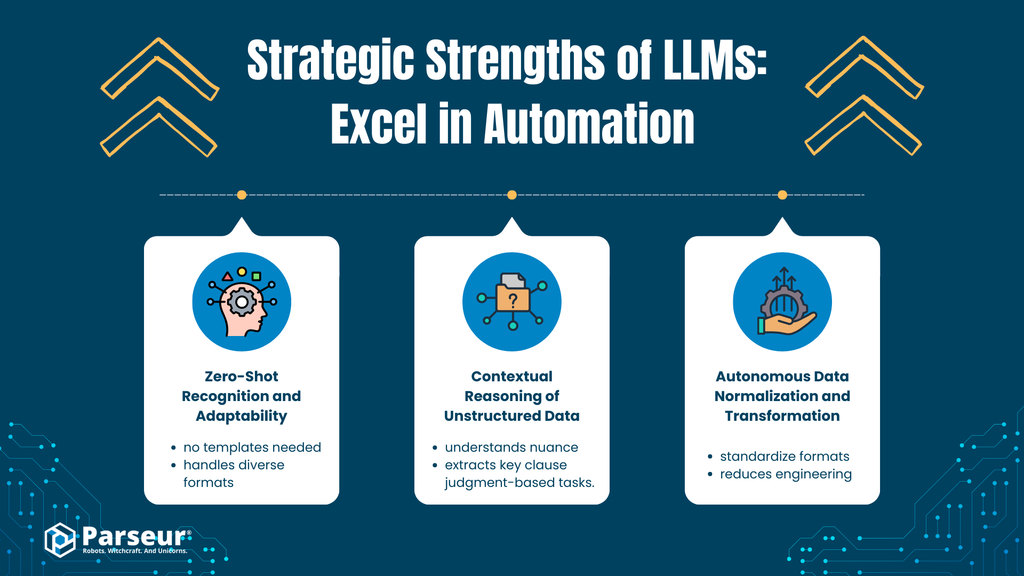

A. ゼロショット認識と適応性

分析

LLMは高い意味理解力を持ち、初めて見る書類の形式やレイアウトであっても、文脈から必要な情報(請求書番号、支払期限、合計金額など)を抽出できます。例えば、新しい仕入先から非標準的なレイアウトの請求書を受け取った場合でも、過去の事例の有無に関わらず識別が可能です。

これは、テンプレート化やルールベースではなく、汎用的な言語モデリングに基づく能力です。

ビジネスへの影響

- 立ち上げ期間の短縮:初期設定の負荷を削減

- 大量のラベル付き学習データが不要

- 新たな供給元や書式、書類種別への対応を高速化

動的で多様な環境において、初期の自動化における障壁を大幅に下げることができます。

B. 非構造データの文脈的推論

分析

伝統的なルールベース(正規表現や座標指定など)のアプローチとは異なり、LLMは複雑な言い回し、意図、暗示された内容などを文脈的に解釈できます。このため、長文のメール、契約書の条項、方針文書、顧客との応対記録などにも有効です。

言語的なストーリー性から意味、関係、推論を導き出す能力は、決定論的なルールでは捉えにくいものです。

ビジネスへの影響

- 判断や推論に基づくワークフローの自動化

- 例えば:

- 顧客の意図の分類

- 契約文書における特定条項の識別

- 記述形式の文書からの重要日時やリスクの抽出

- 知識集約型業務における手作業でのレビュー負担を軽減

構造が一定しない領域や、コンテンツそのもの以上に文脈が鍵を握る領域で、その価値は大きくなります。

C. 自律的なデータ正規化・変換

分析

LLMは生成時に抽出データを正規化できます。例えば:

- 多様な日付書式を統一(ISO 8601など)

- 通貨や数値フォーマットの標準化

- フィールド名のばらつきを解消

これにより、下流システムでの変換ロジックやカスタムスクリプト、脆弱な事後処理パイプラインへの依存が減少します。

ビジネスへの影響

- ダウンストリームシステム(ERP、CRM、分析基盤など)との連携が容易に

- データクリーニングや整形工程におけるエンジニアの負担を低減

- PoCやパイロットプロジェクトの立ち上げが迅速に

自動化におけるLLMの戦略的強み

より広義には、LLMは企業の自動化に以下の基盤的な利点を提供します:

大規模な自然言語理解

膨大な文書群から非構造化テキストを抽出し、要約、分類する能力。

意味的な柔軟性

言い回し、レイアウト、意図の多様なバリエーションから意味を見出す能力。

規則に依存しない汎用的な推論

ロジックツリーなしで分類、推論、パターン発見を可能にする能力。

迅速な分野横断的な適用

顧客サポート、法務審査、ナレッジ管理、社内ツールなど、多岐にわたる応用可能性。

エージェント的なワークフロー基盤

プロンプトの連鎖、タスクの分解、AIベースの意思決定のオーケストレーションが可能。

例:当社のあるSaaS顧客は、年間約4,000件の請求書処理を自動化したいと考えていました。LLMを活用したところ、標準的なベンダーからの請求書処理にかかる手作業の40%を削減できました。一方で、旧来のベンダーが発行する非標準フォーマットやスキャンされたPDFの請求書では、LLMが合計金額や日付を正しく抽出できないことがありました。そこで、ルールベースのチェックとOCR検証をLLMのプロセスに付加しました。この経験から、LLMは自動化の補助には適していますが、意思決定全体を委ねるべきではないことが分かりました。 - Nick Mikhalenkov, SEO Manager, Nine Peaks Media

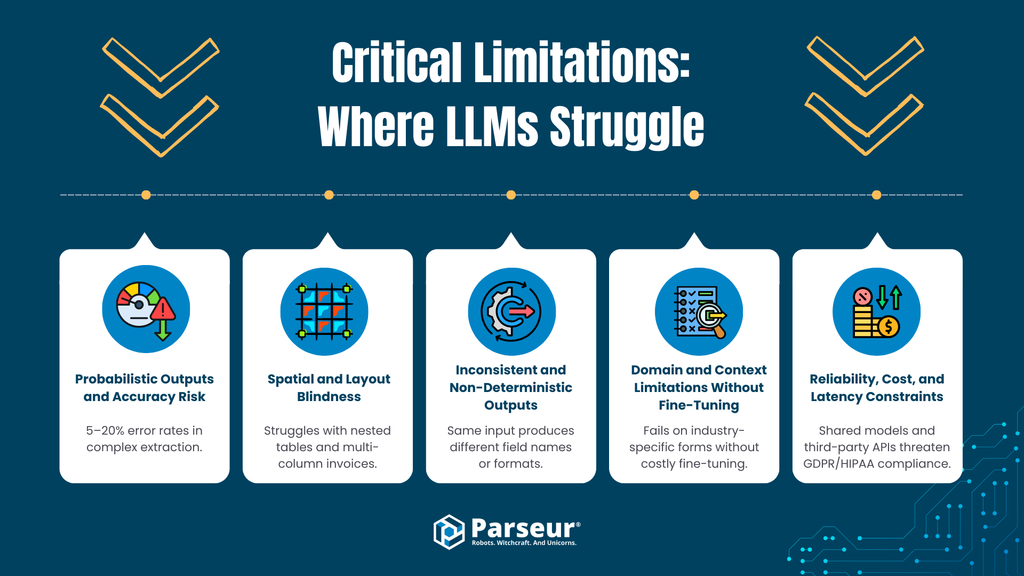

重要な限界:LLMが苦手な領域(運用レイヤー)

LLMは戦略的な用途では多大な価値を発揮する一方、大量かつ本番レベルのドキュメント自動化では限界が目立ちます。精度、一貫性、速度、コスト管理が必須となる運用層において、純粋なLLMアプローチは実務上のリスクを生み出す可能性があります。

A. 確率的出力と精度リスク

限界

LLMは確率的なシステムであり、決定論的なルールではなく統計的な尤もらしさに基づいて出力を生成します。先進的なモデルであっても、誤りや虚偽(ハルシネーション)はゼロにはなりません。Master of codeによると、高度な推論や抽出タスクでは、5〜20%のエラーまたはハルシネーション率が記録されています。

運用リスク

経理、調達、法令報告など、ミスが許されないワークフローにおいて、確率的な誤出力は致命的です。Rampのデータでは、手作業による請求書処理のエラー率は1~3%(1,000件中10~30件の問題)とされています。自動化の目的を考えると、これは許容できません。決定論的なシステムとは異なり、LLMは同じ入力に対しても出力が毎回同じとは限らないため、追加の検証層や人手によるレビューが必須となり、効率化が頭打ちになります。

B. 空間・レイアウト把握の弱さ

限界

多くのLLMはテキストを逐次的に処理するため、空間的な関係性、すなわちレイアウトに依存する情報の把握を苦手とします。例えば:

- 複数カラムの請求書

- 入れ子構造や複数行にわたるテーブル

- 複数列にまたがるヘッダー

- ラベルではなく位置関係によって意味が変わる値

ただし、最新のモデルではこの分野でも進歩が続いています。

運用リスク

構造化されたドキュメントでは、「レイアウト=論理」です。行や列の誤解釈は、以下のような機械での判別が難しい致命的なミスを招きます:

- 明細、価格、数量のずれ

- 合計金額の誤ったフィールドへの割り当て

- ヘッダー値の全行への誤った拡張

C. 入出力の一貫性・決定論性欠如

限界

LLMは、デフォルトでは厳密なスキーマを保証しません。出力される項目の有無、名称、フォーマット、順序が、プロンプトや書式の違いによって変わる可能性があります。

運用リスク

エンタープライズシステムでは、決まったスキーマ(JSON構造やフィールド名、データ型)の一貫性が絶対条件です。ばらつきを抑えるためには、以下の対応が必要となり、エンドツーエンドの自動化の信頼性が揺らぎます:

- バリデーションや修正を行う層の構築

- 頻繁な例外ケースの処理

- 人手によるレビューの再導入

D. 特殊分野知識・文脈解像度の弱さ(ファインチューニングなし)

限界

LLMは広範な一般知識を持つ一方、業界特有のドキュメント(物流関連、税務申告、業界仕様の書式など)は、ファインチューニングやプロンプト設計なしには苦手とします。

運用リスク

ファインチューニングは、以下のような追加の負荷を招き、「プラグアンドプレイ」としての利便性を損ないます:

- 特化したデータセットの準備

- 開発期間の増加

- データプライバシーや保持に関するリスク

- 継続的な運用負荷

E. 信頼性・コスト・遅延の課題

限界

LLMによる推論、特にエージェント的な多段階推論は高コストです。実際、LLMを用いた抽出は1件あたり8~40秒かかる例もあり、専門の抽出エンジンではミリ秒単位で処理が完了します。

運用リスク

大規模な処理では、以下の課題が生じます:

- LLM APIは1件あたり10倍から100倍以上のコスト(専門IDP比)

- レイテンシー(遅延)がリアルタイム処理の要件の障害に

- スループット制限により、バッチ処理や負荷の変動に対応が困難

大量の処理(月間数千~数万件)では、単位あたりのコストが現実的でなくなります。

F. データプライバシー・規制遵守リスク

限界

多くのLLM連携は、第三者のAPIや共有モデル、曖昧なデータ保持ポリシーで実装されがちです。これにより、以下の規制対応に支障が生じる可能性があります:

- GDPRにおける目的の限定や最小化

- 消去権や監査証跡の確保

- HIPAA、GLBAなどの業界規制

運用リスク

モデルがデータを記録、保持、再学習に利用する場合、企業は機密情報の管理権を損なうことになります。契約だけでは十分なリスク低減はできません。

私の見解では、LLMの最大の制約は「本当に精度が求められる場面で、正確な結果を保証できない」という点です。LLMはテキストの要約や内容理解では優秀ですが、スコアや日付などのわずかな読み間違いが致命的となる構造化データの抽出には向いていません。また、データが不明確な場合でも、LLMは自信満々に回答してしまう性質があります。

教育分野の用途を例に挙げると、LLMは授業の要約や概念の説明は得意ですが、学業成績やテスト結果から標準化されたデータを正確に抽出する点では一貫して失敗します。こうした用途では、従来のルールベースと人手による監督を組み合わせた方が、純粋なLLMによる自動化よりも高性能です。 - Joern Meissner, Founder & Chairman, Manhattan Review

まとめ:ドキュメント自動化における戦略的知能 vs. オペレーショナル信頼性

LLMは自然言語の理解、意味の推論、文脈の解釈において比類なき能力を持つ一方で、企業向けのドキュメント自動化では、精度、決定論的な抽出、レイアウトの解釈、コスト効率、法令遵守といった点で課題があります。その確率的な出力と遅い処理速度ゆえ、純粋なLLM方式は、大量の請求書処理やAP(買掛金)自動化、構造的なドキュメント業務では大きなリスクを伴います。

ドキュメント処理における“エージェントAI”の台頭

純粋なLLMによる抽出の限界を回避する策として、エージェントAI(agentic AI)という新しいアーキテクチャが台頭しています。このモデルでは、LLMが単なる一次的な生成エンジンとしてではなく、ツールの連携、多段階の推論、自己検証を実行する“オーケストレーター”として機能します。

エージェントAIとは何か

エージェントAIは、LLMが以下のようなサイクルを回す仕組みです:

- タスクを複数のステップに分割

- 外部ツール(OCR、計算機、データベース、検証スクリプトなど)を呼び出し

- 自己の出力を見直し、再修正

- 信頼度の閾値に到達するまで繰り返し実行

ドキュメント処理においては、「まず抽出→合計をチェック→再確認→不整合があれば修正→最終的な出力を生成」といった作業を自律的に実行します。

狙い:ハルシネーション抑制

検証ループやツールを併用した推論により、以下のようなLLMの失敗パターンを抑制できます:

- 数値の整合性の欠如

- 抽出漏れ

- 論理エラー(例:明細の合計が一致しないなど)

これにより、“確率的な当てずっぽう”から“自己修正ループ”へと進化させ、複雑で曖昧な書類の精度向上を狙います。

トレードオフ:レイテンシ・コスト・複雑性

しかし、この方式は運用レベルで大きな犠牲ももたらします:

レイテンシ

各推論ステップやツールの呼び出しごとに処理時間がかさみ、実際には1件あたり8〜40秒もかかることがあります。これは、リアルタイム処理や大規模なバッチ処理には不向きです。

コスト

複数のLLM呼び出しにより、トークン消費量とAPIコストが急増します。処理件数が増えれば、従来方式の数倍から数十倍のコストがかかる可能性があります。

エンジニアリング複雑性

- オーケストレーション基盤の構築

- 異なるツール間のエラーハンドリング

- 監視・ログの整備

- プロンプトとロジックの継続的な手入れ

などが必要になり、統合と保守のコストが高く付きます。

本質:大量自動化には不向き

このアプローチは、大量のドキュメント業務に求められる要件(低遅延、安定したコスト、決定論的な出力、失敗理由の単純化)とは真逆の方向性を持っています。

エージェントAIは“推論の深度”を高めるのには有効ですが、“運用効率”の向上には繋がりません。

結論:限定領域で強力

エージェントAIは、LLM応用の重要な進化ですが、その真価は以下の領域で発揮されます:

- 低ボリュームで高複雑性のリサーチ

- 例外やエッジケースの処理

- 知識集約型のドキュメント審査

一方で、大量の実務データ入力や書類処理パイプラインには(現時点では)不向きです。

エージェントAIはLLMの推論力を向上させることができますが、本質的な「確率的な不確実性とのトレードオフ」までは排除できません。大量の自動化においては、補助的な役割にとどまります。

なぜ専門的ツールがこれからも不可欠か(Parseurと特化型エンジンの価値)

LLMによる自動化の話題が高まるにつれて、「汎用モデルが従来のドキュメント処理を置き換える」と考えられがちですが、実態はその逆です。高い信頼性で大量の自動化を実現している企業ほど、LLMと専門エンジンを明確に組み合わせ、それぞれの強みを生かしています。

Parseurのような専門プラットフォームが不可欠である理由は、LLMに知能が不足しているからではなく、「精度、予測可能性、運用効率が本質的に重視される」業務領域が存在するためです。

スケールする精度

ドキュメント自動化の現場は、チャットボットとは異なり、「フィールド単位での絶対的な精度」が求められます。請求書、発注書、財務書類などでは、“近似値”は許されません。

専門エンジンは、

- ルールを拡張した抽出

- レイアウト認識パターン

- 構造化された書類向けの分類モデル

などを組み合わせて、決定論的なアウトプットを保証します。すなわち、同じ書類は必ず同じ抽出結果になります。

LLMベースの抽出は確率的であり、わずかな誤差でも大量に処理すると、例外処理や修正の負担が雪だるま式に拡大します。

設定可能なルールと機械学習の融合

現代の専門プラットフォームは、完全なルールベースではなく、

- テンプレートやバリデーションルールの設定

- 軽量な分類モデル

- 必要に応じたAIベースの識別

といったハイブリッド方式を採用しており、業界標準として95%を超えるフィールド精度が記録されています。

構造化された財務書類へのLLMベースの抽出はエラーが多発しがちですが、専門のIDPは抽出や入力のミスを52%以上低減し、手作業による介入を大幅に削減しています。

要はコントロール性です。企業は、

- 許容するフォーマット

- バリデーションロジック

- フォールバックの動作

などを明示的に定めることができます。プロンプト頼りのシステムだけでは、この決定論性を実質的に達成するのは困難です。

統合性と運用成熟度

特化型ツールは、「本番業務の一部」として設計されています。

- 安定したREST APIやWebhook

- ERP、会計システム、CRMなどとのネイティブ統合

- Zapier、Make、Power Automateなどとの連携

- ビルトインの監視、リトライ、エラーハンドリング機能

これらを備え、実用的な“業務インフラ”として運用できます。

LLMはロジック層で補助的に利用できますが、業務基盤の部分は専門ツールに頼る必要があります。

組込型セキュリティ・コンプライアンス

企業用途のドキュメント自動化において、セキュリティと法令遵守は「追加要件」ではなく「アーキテクチャ上の必須要件」です。

Parseurなどの専門プラットフォームは、

- テナント単位でのデータ分離

- 保存時および転送時の暗号化

- 保持期間ポリシーの設定

- GDPRに準拠した処理と削除の制御

などを標準で装備しています。データが学習に転用されることもなく、「データ主権や監査性の課題」からも自由です。

規制の厳しい業界では、この一点が決定的な要因となります。コンプライアンスとは、「データの保存方法」だけでなく、「データが再利用されるか否か」も問われるのです。

交差点:ドキュメント処理ツール内へのLLM統合

企業の実運用フェーズでは、「LLMを補助的なレイヤーとして文書処理ツール内部に埋め込む」というハイブリッド設計へと成熟しつつあります。これは、LLMの柔軟性と決定論的システムの信頼性を両立させるためです。

従来方式の置き換えではなく、LLMは補助層として位置づけられ、本質的な抽出は専門エンジンが担うことで、柔軟性、例外処理、インテリジェンスの向上と、データの一貫性や統制を両立しています。

この設計方針は、「LLMは“信頼性、性能、コンプライアンス”を課すシステムによって制約されてこそ真価を発揮する」というITアーキテクチャ上の原則にも合致します。

プロンプト駆動型の修正・付加レイヤー

LLM統合で最も効果的なユースケースの一つは、“抽出後の補正や付加情報の生成”です。

このモデルでは、

- 決定論的またはレイアウト認識エンジンで主要なフィールド(請求書番号、合計金額、期日など)を抽出

- LLMをピンポイントで活用し:

- 説明文の標準化

- 曖昧なラベルの判別

- 文脈に基づくメタデータ(仕入先カテゴリ、支払条件など)を付加

という手順を踏みます。

LLMを「主抽出の後」に使うため、その確率的な性質が根幹データの整合性を損なうことはありません。誤りは範囲が限定され、必要に応じて無視したり修正したりすることも容易です。

LLM要約でヒューマン検証を支援

もう一つの新しいパターンが、「LLMによる人間レビュワーの補助」です。

例:

- 長文の書類を要約し、重要項目や異常を指摘

- バリデーションが失敗した理由を説明

- 自然なレビューコメントを自動生成(監査ログ用)

これにより、例外対応時の認知負荷を下げつつ、「最終的なコントロールは人間が握る」という体制を維持できます。

運用上、LLMを“主要なデータエントリ”に用いない限り、信頼性や監査性を保つことが可能です。

エージェントAIワークフロー:LLMによる決定論的システムのオーケストレーション

さらに進んだプラットフォームでは、エージェントAIワークフロー(LLMが複数のツールを連携・統括する仕組み)が登場しています。

この設計では、

- LLMがオーケストレーション層として機能

- OCR、分類、フィールド抽出は決定論的な方式で実行

- バリデーションルールで制約を保持

- 誤差が生じた場合は人間が介入

という運用が取られます。

ただし、前述の通りエージェントAIの導入はレイテンシ、コスト、複雑化の課題を伴うため、

- 低ボリュームでバリエーションが豊富な書類

- クロスシステムでの照合

- 例外駆動型のワークフロー

などに限定して活用されます。

高ボリュームの抽出業務は、あくまで「専門エンジンが主役、エージェントAIが補完」という形が推奨されます。

ハイブリッドアーキテクチャが企業標準化の理由

LLMを組み込んだ抽出ツールの普及は、AIの長所と短所を現実的に理解した企業の成熟した路線を反映しています。

ハイブリッド型であれば、

- 構造化データには決定論的な精度を確保

- イレギュラーなケースには意味理解による柔軟性で対応

- コストと性能は大規模運用でも予測可能

- ガバナンスも強化

といった利点が得られます。

戦略的まとめ

ドキュメント自動化の未来は「LLMファースト」ではなく、LLMアウェアです。

2026年以降に成功する組織は、

- LLMで意思決定と柔軟性を強化

- 実行は特化エンジンへ任せ

- 「知能は信頼性によって制約される」という設計

を選ぶ企業です。

LLMと専門ドキュメント処理ツールはどう使い分けるべきか

| 判断基準 | 大規模言語モデル(LLM)を使う場合 | 専門ドキュメント処理ツール(Parseur等)を使う場合 |

|---|---|---|

| 書類フォーマットの多様性 | 非常にバラバラ/未知/非構造の書類(メール、自由記述、契約書など) | 一定以上統一された半構造の書類(請求書、領収書、帳票など) |

| 精度要件 | 人による最終レビューが可能な助言/補助的な出力 | 決定論的で再現可能な、基幹システムの自動化が必要な場合 |

| 誤差許容度 | 多少のミスが許容される場面 | 原則として誤差ゼロが要求される場合 |

| 規制リスク | 機密性が低く、規制対象外のデータ | 規制対象の書類(GDPR、CCPA、金融、医療など) |

| データプライバシー・主権 | 推論や付加目的で短期的に保持するだけでよい場合 | 厳格なデータ分離、監査性、削除権が要求される場合 |

| 処理ボリューム | 低~中規模のボリューム | 高ボリューム(毎月数千~数百万件) |

| 遅延感度 | 1件あたり数秒の遅延が許容できる場合 | ミリ秒単位やほぼリアルタイムの処理が求められる場合 |

| 大量化時のコスト効率 | 小規模では問題ないが、規模拡大でコストが急増する可能性がある | 大規模でもユニットコストが安定している |

| 統合複雑度 | 柔軟な出力、緩やかな連携のワークフロー | 固定スキーマ、ERP/RPA/会計システムなどとの厳密な統合 |

| おすすめ用途 | 分類、要約、意図検出、付加情報の生成 | 請求書処理、AP/AR、帳票抽出、法令遵守ワークフローなど |

今後の展望:LLM・エージェントAI・自動化の未来

AIによるドキュメント自動化分野は急速に進化しています。現在のLLMの能力だけでなく、今後数年で自動化戦略を規定するであろう新しいトレンドも踏まえた設計が必要です。

1. 次世代LLMアーキテクチャ

- マルチモーダル対応:テキスト、画像、表、ドキュメントを並行して処理することで、「請求書、フォーム、PDF」の自動化が新たな常識へ。

- 検索拡張生成モデル(RAG):外部の知識と連携することで、高精度と文脈解像度を向上させ、かつ顧客データの再学習を不要に。

- エージェントAIワークフロー:多段階の推論とツールの統合により、フィールドの照合、契約書の要約、例外の提案などを自律化。

2. 企業導入の今後

- 今後の採用率:2027年には大手企業のほぼ全社でAIの活用が普及し、生成系AIは自動化、コンテンツ処理、知識集約型業務の中核になる見込みです(AI全体のトレンドより)。

- 「人の作業削減」「業務の高速化」「非構造化データからの戦略的示唆の抽出」を主要な目的に、採用が加速するでしょう。

3. 説明可能性・信頼・監督要件

- LLMの普及拡大に伴い、「説明可能なAI(XAI)」への要請が高まります。出力の監査、意思決定プロセスの確認、法令監査への対応が重要になります。

- 人による監督(Human-in-the-Loop, HITL)は、契約書、請求書、財務書類などのクリティカルな業務で不可欠であり続けます。

- LLMの柔軟性と特化エンジンの信頼性を両立させる「ハイブリッド設計」が、今後の主流となるでしょう。

AIの知能と運用コントロールのバランスを

LLMは、非構造化テキストの理解や複雑な書類の推論において、圧倒的な知的能力を発揮します。しかし、エンタープライズ規模のデータ抽出において、LLM単独のアプローチは最適解ではありません。柔軟性や文脈理解が必要な戦略的な業務ではLLMを選択的に活用し、Parseurなどの専門プラットフォームで決定論的な精度、法令準拠、スケーラビリティ、監査性を担保するべきです。AIの知能と特化型抽出エンジンを組み合わせることで、運用の信頼性と戦略的な洞察の両立、すなわちドキュメント自動化におけるスピード、精度、コントロールの最適化を実現できます。

よくある質問と回答

本記事では、企業の意思決定者向けに、文書ワークフローにおける大規模言語モデル(LLM)の実用的な用途と限界、セキュリティ、そしてParseurのような専門ツールとの統合に関する主要な質問への回答をまとめています。

-

ドキュメント処理でLLMが得意なことは何ですか?

-

LLMは構造化されていないテキストの翻訳、パターン認識、コンテンツ分類、文脈依存情報の抽出に優れています。柔軟かつ推論を要するワークフローに最適ですが、結果は決定論的ではなく確率的です。

-

なぜLLMだけでは専門的な抽出ツールの代わりにならないのですか?

-

LLMは出力の一貫性に欠け、レイアウト依存のデータを苦手とし、大規模な運用ではコストが高くなります。Parseurのような専門ツールは、大量かつ構造化されたドキュメント向けに、高精度、法令準拠、スケーラビリティを確保します。

-

LLMはビジネスデータの取り扱いにおいて安全ですか?

-

セキュリティは実装に依存します。多くのLLMはデータが保持される可能性のある共有APIを利用していますが、Parseurはデータの個別処理、保持期間の設定、GDPRなどの規制準拠を保証します。

-

企業はLLMと専門的ツールをどう組み合わせるべきですか?

-

LLMは推論や構造が不明瞭なデータ向けに、専門エンジンは大量・構造化・規制対象ドキュメントの処理に、というように使い分けることで、柔軟性と信頼性の両立を図るべきです。

最終更新日