Los Grandes Modelos de Lenguaje (LLM) ofrecen una flexibilidad incomparable para comprender texto no estructurado, lo que los convierte en una herramienta ideal para tareas de razonamiento, resumen y gestión documental de bajo volumen. Sin embargo, su naturaleza probabilística, la latencia y la falta de precisión determinista limitan su eficacia como solución única para la automatización de documentos regulados y de gran volumen.

Puntos clave:

- Flexibilidad estratégica: Los LLM sobresalen en la interpretación de documentos no estructurados, novedosos o muy variables, facilitando una incorporación más rápida y la ejecución de tareas basadas en el razonamiento.

- Limitaciones operativas: Para flujos de trabajo estructurados y de gran volumen, los LLM por sí solos pueden provocar errores, un procesamiento lento y una exposición al incumplimiento normativo. Los sistemas deterministas siguen siendo esenciales.

- Ventaja híbrida: Las estrategias más efectivas de automatización de documentos combinan los LLM con plataformas especializadas como Parseur, aprovechando la IA para la comprensión contextual y confiando en la extracción determinista para garantizar la precisión, la escalabilidad y el cumplimiento.

La paradoja de la automatización

Los Grandes Modelos de Lenguaje (LLM) han supuesto un avance fundamental en la comprensión del lenguaje natural. Su capacidad para interpretar texto no estructurado, inferir significados y generalizar entre dominios ha expandido lo que es técnicamente posible en la automatización de documentos. Tareas que antes requerían reglas rígidas o una extensa configuración manual ahora pueden abordarse con una flexibilidad mucho mayor.

Limitaciones de los LLM

Sin embargo, esta flexibilidad introduce una paradoja para la automatización empresarial. Aunque los LLM se desempeñan bien en escenarios orientados al razonamiento o de bajo volumen, estudios de Hyperscience demuestran que a menudo solo alcanzan una coincidencia exacta del 66-77 % en tareas documentales críticas como facturas y conocimientos de embarque, frente al 93-98 % de los sistemas IDP especializados.

De hecho, si bien los LLM destacan en el razonamiento y los casos de bajo volumen, no están diseñados para funcionar como sistemas de registro, donde la precisión determinista, los esquemas fijos y el rendimiento predecible son obligatorios.

Los resultados no deterministas, la latencia variable debida a los límites de las API y los crecientes costes de inferencia impulsados por el volumen de tokens y la demanda de GPU hacen que los sistemas basados puramente en LLM sean difíciles de desplegar de forma fiable en entornos de producción que exigen velocidad, consistencia y previsibilidad.

Crecimiento híbrido de IDP

Como resultado, la automatización de documentos a nivel empresarial requiere cada vez más un enfoque híbrido. Las arquitecturas híbridas de Procesamiento Inteligente de Documentos (IDP) combinan la adaptabilidad de los LLM con la precisión de los motores de extracción especializados y la lógica determinista, ofreciendo un equilibrio superior entre calidad y eficiencia.

Este cambio refleja el creciente reconocimiento de que ninguna tecnología por sí sola puede optimizar simultáneamente la flexibilidad, la precisión, el coste y la gobernanza. Las empresas priorizan arquitecturas que separan explícitamente el razonamiento de la ejecución, permitiendo que cada capa se optimice para su función operativa en lugar de forzar a los LLM a realizar tareas deterministas para las que no fueron diseñados.

Según Fortune Business Insights, se proyecta que el mercado global de IDP crecerá de 14.160 millones de dólares en 2026 a 91.020 millones para 2034, con una TCAC del 26,20 %, lo que refleja la alta demanda de estos sistemas fiables por parte de grandes empresas que gestionan un elevado volumen de documentos. En este modelo, los LLM se utilizan de forma selectiva donde la comprensión contextual agrega valor, mientras que la extracción de gran volumen, la validación y la automatización posterior quedan en manos de sistemas diseñados para la fiabilidad, el control de costes y el cumplimiento.

La implicación estratégica es clara: los LLM son un componente poderoso de la automatización de documentos moderna, pero no sustituyen a los motores de procesamiento dedicados. Las organizaciones que alinean cada tecnología con sus fortalezas operativas están mejor posicionadas para escalar la automatización sin sacrificar la precisión, el cumplimiento ni el rendimiento.

¿Qué son los Grandes Modelos de Lenguaje (LLM)?

Los Grandes Modelos de Lenguaje (LLM) son una clase de modelos de aprendizaje automático diseñados para comprender, generar y razonar sobre el lenguaje natural a gran escala. Se entrenan en vastos corpus de texto utilizando redes neuronales profundas, generalmente mediante arquitecturas transformer que aprenden relaciones estadísticas entre palabras, frases y conceptos.

A grandes rasgos, los LLM funcionan prediciendo el siguiente token (palabra o símbolo) más probable dada una secuencia de tokens previos. Al exponer este mecanismo simple a conjuntos de datos masivos y diversos, se obtienen comportamientos complejos que incluyen el resumen, la clasificación, la respuesta a preguntas, la traducción y el razonamiento contextual. En el procesamiento de documentos, esto les permite interpretar texto libre, inferir el significado entre párrafos y responder con flexibilidad a diferentes formatos o estilos de lenguaje.

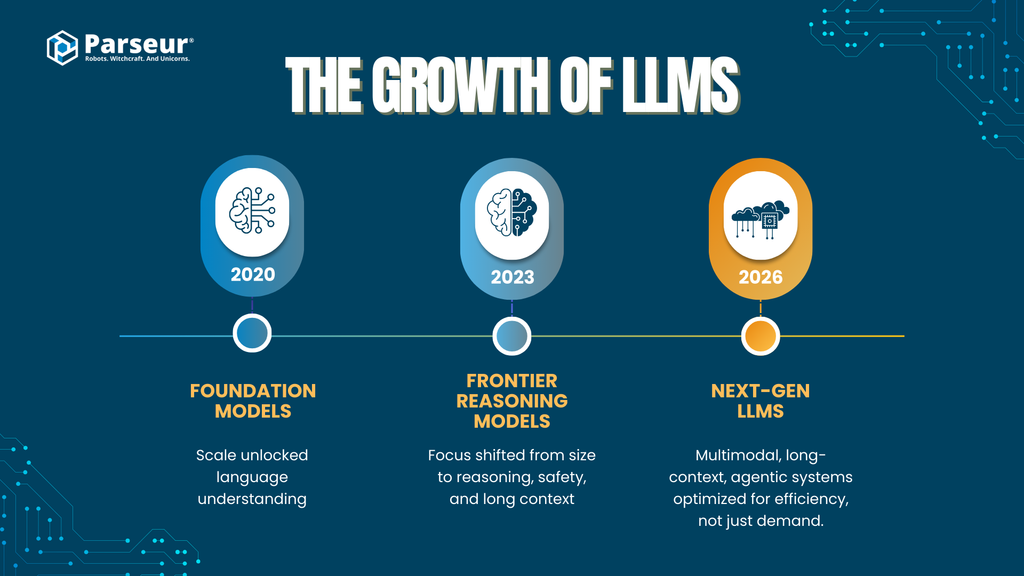

Escala y desarrollo de los LLM

Las capacidades de los grandes modelos de lenguaje han crecido rápidamente a medida que los modelos escalan y las técnicas de entrenamiento evolucionan entre los principales proveedores de IA:

- Primeros modelos fundacionales (2020-2021)

Modelos como GPT-3 introdujeron arquitecturas transformer a gran escala (~175 mil millones de parámetros), demostrando que la escala por sí sola podía desbloquear una sólida comprensión general del lenguaje.

- Modelos de vanguardia de segunda generación (2023-2024)

Modelos como GPT-4, Claude 2/3 (Anthropic), Gemini 1.x (Google) y DeepSeek-LLM desplazaron el foco del simple número de parámetros hacia un mejor razonamiento, un ajuste de seguridad y ventanas de contexto más largas. Aunque la mayoría de los proveedores ya no comunican el tamaño exacto de los modelos, se estima que operan a nivel de billones de parámetros o superior si se consideran arquitecturas mixtas y optimizaciones.

- Modelos potenciados con búsqueda y recuperación

Plataformas como Perplexity AI dan protagonismo a la generación aumentada por recuperación (RAG), que combina el razonamiento de los LLM con la búsqueda y la citación en tiempo real para mejorar la precisión factual y reducir las alucinaciones en tareas intensivas en conocimiento.

- Próxima generación de LLM (2025-2026)

Entre los proveedores, la tendencia se centra en:

- Multimodalidad (texto, imágenes, tablas, documentos, audio)

- Procesamiento de contexto largo (de cientos de miles a millones de tokens)

- Capacidades agénticas (uso de herramientas, razonamiento en varias etapas, orquestación)

- Eficiencia y especialización, en lugar de solo aumentar el tamaño del modelo

Esta evolución señala una tendencia: los avances son impulsados cada vez más por la arquitectura, las herramientas y el diseño de sistemas, no solo por la escala de parámetros, una distinción importante para los casos de uso empresariales en la automatización de documentos.

Tendencias de adopción en empresas

- Los LLM pasan de proyectos piloto a producción

- El 78 % de las organizaciones informan de que utilizan la IA generativa en al menos una función empresarial, incluidas las operaciones, el análisis y la automatización.

- La adopción en empresas se acelera rápidamente

- Para 2026, se espera que más del 80 % de las empresas hayan utilizado API de IA generativa o hayan lanzado aplicaciones GenAI en producción, un gran salto desde menos del 5 % en 2023, según Gartner.

- El procesamiento de documentos es un caso de uso líder en las empresas

- La automatización de documentos y la extracción de datos se encuentran entre las principales aplicaciones de la GenAI, impulsadas por la demanda de reducir el esfuerzo manual, acelerar los ciclos de procesamiento y mejorar la eficiencia operativa (McKinsey, Gartner).

Relevancia para la automatización de documentos

En los flujos de trabajo con documentos, los LLM se utilizan principalmente para:

- Procesar texto no estructurado o semiestructurado

- Clasificar documentos por tipo o intención

- Extraer campos poco definidos donde las reglas rígidas son deficientes

- Gestionar la variabilidad lingüística entre proveedores, regiones y formatos

Pero aunque los LLM destacan en la interpretación y el razonamiento, son sistemas inherentemente probabilísticos. Sus resultados se generan en función de la probabilidad, no de reglas deterministas, lo que tiene importantes repercusiones en la precisión, la repetibilidad, los costes y la gobernanza en la automatización de documentos a gran escala.

Esta diferencia plantea la cuestión central que las empresas deben abordar: dónde los LLM aportan valor estratégico y dónde los sistemas de procesamiento de documentos especializados siguen siendo esenciales.

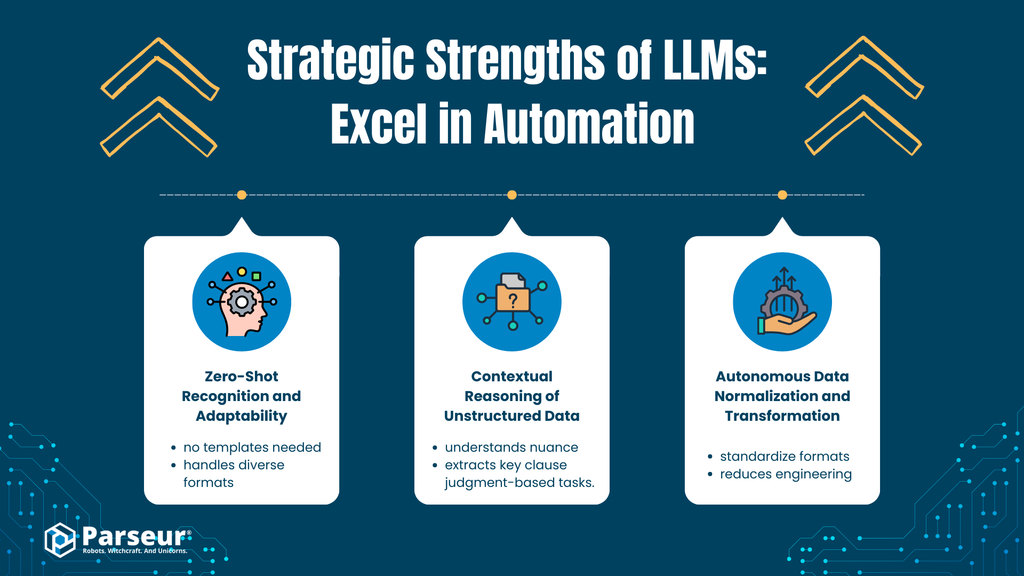

Capacidades principales: Dónde destacan los LLM (la capa estratégica)

Los Grandes Modelos de Lenguaje aportan el mayor valor en la capa estratégica de la automatización de documentos, donde la flexibilidad, la comprensión semántica и el razonamiento tienen más peso que la precisión determinista. Sus puntos fuertes son cualitativos y no mecánicos, lo que los hace particularmente efectivos en la fase inicial de la automatización, en los casos límite y en los flujos de trabajo intensivos en conocimiento.

A. Reconocimiento zero-shot y adaptabilidad

Análisis

Los LLM poseen una sólida comprensión semántica que les permite reconocer y extraer información relevante de tipos y diseños de documentos que nunca antes han visto. Por ejemplo, un LLM puede identificar el número de factura, la fecha de vencimiento o el importe total en una factura nueva, aunque las etiquetas, la posición o el formato difieran considerablemente de ejemplos previos.

Esta capacidad proviene de la modelización generalizada del lenguaje, no de un entrenamiento específico en documentos. El modelo infiere el significado a partir del contexto, no de reglas fijas o plantillas predefinidas.

Impacto empresarial

- Acelera el time-to-value al reducir la configuración inicial

- Minimiza la dependencia de grandes conjuntos de entrenamiento etiquetados

- Permite la rápida incorporación de nuevos proveedores, formatos o tipos de documentos

En entornos dinámicos o heterogéneos, esta adaptabilidad puede reducir significativamente la fricción en la automatización inicial.

B. Razonamiento contextual en datos no estructurados

Análisis

A diferencia de los sistemas tradicionales basados en reglas (como las expresiones regulares o la lógica posicional fija), los LLM pueden analizar matices, intenciones y significados implícitos en texto no estructurado o semiestructurado. Esto incluye contenido extenso como correos electrónicos, cláusulas contractuales, documentos normativos y correspondencia con clientes.

Los LLM pueden extraer significado del lenguaje narrativo, comprender relaciones conceptuales y razonar entre párrafos, capacidades muy difíciles de programar mediante reglas deterministas.

Impacto empresarial

- Permite la automatización de flujos que requieren un razonamiento basado en el juicio

- Admite casos como:

- Clasificación de la intención del cliente

- Identificación de cláusulas legales

- Extracción de fechas clave, obligaciones o riesgos en documentos narrativos

- Disminuye la revisión manual en procesos intensivos en conocimiento

Esto vuelve a los LLM especialmente valiosos donde la estructura es inconsistente y el contexto es tan importante como el contenido.

C. Normalización y transformación autónoma de datos

Análisis

Los LLM pueden normalizar los datos extraídos durante el proceso de generación. Por ejemplo:

- Convertir formatos de fecha variados a uno estándar (p. ej., ISO 8601)

- Estandarizar monedas y formatos numéricos

- Unificar nombres de campos entre fuentes incoherentes

Esto reduce la dependencia de la lógica de posprocesamiento, los scripts personalizados o los frágiles flujos de procesamiento.

Impacto empresarial

- Facilita la integración con sistemas posteriores (ERP, CRM, análisis)

- Reduce el trabajo de ingeniería en la limpieza y el formateo de datos

- Mejora la velocidad para lanzamientos piloto y pruebas de concepto

Fortalezas estratégicas de los LLM en automatización

A un nivel superior, los LLM aportan varias ventajas fundamentales a la automatización empresarial:

Comprensión del lenguaje natural a escala

Extraer, resumir y categorizar texto no estructurado a través de grandes volúmenes de documentos.

Flexibilidad semántica

Identificación del significado a pesar de las variaciones en la redacción, el formato y la intención.

Razonamiento generalizado, no atado a reglas

Realizan tareas de clasificación, inferencia y reconocimiento de patrones sin lógicas explícitas.

Aplicabilidad rápida entre dominios

Útiles para soporte al cliente, revisión legal, gestión del conocimiento y herramientas internas.

Fundamento para flujos agénticos

Habilitan cadenas de prompts, descomposición de tareas y orquestación de decisiones en sistemas basados en IA.

Por ejemplo, uno de nuestros clientes de SaaS, que procesaba unas 4000 facturas al año, inició un proyecto para automatizar la introducción de facturas. Usando un LLM, lograron generar un ahorro del 40 % en la carga de trabajo manual asociada a las facturas estándar de los proveedores. Sin embargo, al intentar procesar facturas de proveedores antiguos con formatos no estándar y PDF escaneados, los LLM no lograban extraer correctamente el importe o la fecha. La solución fue proporcionar verificaciones basadas en reglas y OCR a los LLM. Es clave entender que los LLM son excelentes asistentes para automatizar documentos, pero no deberían liderar el proceso de toma de decisiones. - Nick Mikhalenkov, SEO Manager, Nine Peaks Media

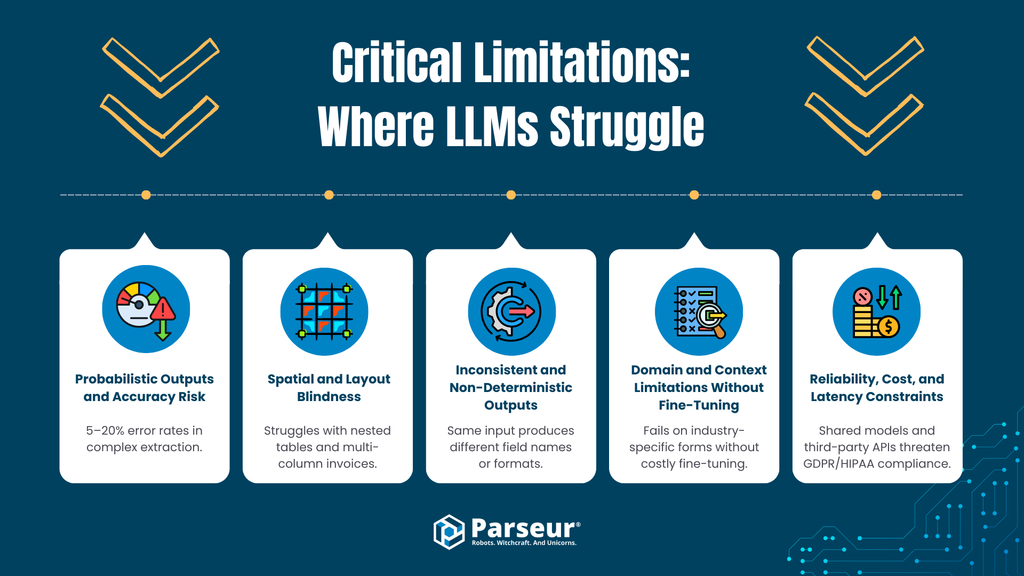

Limitaciones críticas: Dónde tienen dificultades los LLM (la capa operativa)

Aunque los LLM ofrecen un gran valor estratégico, sus limitaciones se magnifican al aplicarlos a la automatización de documentos de producción y de gran volumen. En la capa operativa, donde la precisión, la consistencia, la velocidad y el control de costes son primordiales, los enfoques puramente basados en LLM introducen riesgos medibles.

A. Resultados probabilísticos y riesgo de precisión

La limitación

Los LLM son sistemas inherentemente probabilísticos; generan resultados basados en la probabilidad estadística, no en reglas deterministas. Incluso los modelos avanzados siguen produciendo un porcentaje de información incorrecta o inventada (alucinaciones). Según los estándares de la industria, modelos líderes como GPT-4o y otros modelos modernos aún presentan tasas de alucinación o error en tareas estructuradas, donde Master of code informa de tasas de error/alucinación del 5–20 % en escenarios de extracción y razonamiento complejo.

Riesgo operacional

En finanzas y operaciones, como en cuentas por pagar, cuentas por cobrar, adquisiciones o informes de cumplimiento, los errores probabilísticos no son aceptables. Los datos de Ramp muestran que el procesamiento manual de facturas produce tasas de error de entre el 1 y el 3 %, es decir, entre 10 y 30 transacciones problemáticas por cada 1000 facturas que requieren corrección o investigación. Estos errores suelen generar descuentos perdidos, pagos atrasados y reprocesamientos costosos. A diferencia de los sistemas basados en reglas, los LLM no pueden garantizar resultados idénticos con entradas iguales sin múltiples capas de verificación y revisión humana, lo que anula gran parte de la eficiencia de la automatización**.**

B. Ceguera espacial y de diseño (layout)

La limitación

La mayoría de los LLM procesan texto de forma secuencial y carecen de una comprensión nativa de las relaciones espaciales. Si bien pueden leer texto extraído, tienen problemas para interpretar el significado que depende del diseño, como:

- Facturas de varias columnas

- Tablas anidadas o de líneas múltiples

- Encabezados que abarcan varias columnas

- Valores cuyo significado depende de la posición y no de la etiqueta

Esto, sin embargo, está evolucionando con modelos más modernos.

Riesgo operacional

En documentos estructurados, el diseño es lógica. Una mala interpretación de la alineación de filas o la asociación de columnas puede causar:

- Líneas de pedido asignadas a precios o cantidades incorrectas

- Totales en campos erróneos

- Valores de encabezado propagados de modo incorrecto entre filas

Estos errores son sutiles, difíciles de detectar automáticamente y perjudiciales en flujos automatizados.

C. Salidas inconsistentes y no deterministas

La limitación

Los LLM no imponen esquemas fijos de forma predeterminada. La presencia, el nombre, el formato y el orden de los campos pueden variar entre ejecuciones, especialmente ante pequeños cambios en el prompt o el diseño.

Riesgo operacional

Los sistemas empresariales requieren resultados predecibles y con un esquema estable (p. ej., estructuras JSON fijas, nombres de campo consistentes, tipos de datos normalizados). La variabilidad obliga a:

- Construir complejas capas de validación y corrección

- Gestionar casos límite frecuentes

- Reintroducir la revisión manual

Esto socava la fiabilidad necesaria para la automatización de extremo a extremo.

D. Limites de dominio y contexto sin fine-tuning

La limitación

Aunque los LLM demuestran un conocimiento general, suelen fallar con esquemas muy especializados (p. ej., documentos logísticos, formularios fiscales, facturas de sectores concretos) sin un ajuste fino (fine-tuning) o una ingeniería de prompts detallada.

Riesgo operacional

El ajuste fino (fine-tuning) añade complejidad:

- Requiere conjuntos de datos curados

- Aumenta los tiempos de desarrollo

- Aporta retos de privacidad y retención de datos

- Supone un mantenimiento continuo

Para muchas empresas, esto anula la supuesta “implementación plug-and-play” de los LLM.

E. Fiabilidad, costos y restricciones de latencia

La limitación

La inferencia de los LLM, en particular cuando hay un razonamiento agéntico en varias etapas, tiene un alto coste computacional. Los flujos de extracción de documentos suelen tardar de 8 a 40 segundos por documento, frente a los milisegundos que tardan los motores especializados (OCR y extracción).

Riesgo operacional

A escala, esto genera problemas de coste y rendimiento:

- El coste de la API puede ser de 10 a 100 veces mayor por documento en comparación con los sistemas IDP especializados.

- La latencia es un cuello de botella en flujos sensibles al tiempo.

- Se limita el procesamiento masivo y las cargas pico.

En entornos con miles o decenas de miles de documentos al mes, la economía unitaria se vuelve insostenible.

F. Exposición de privacidad y cumplimiento de datos

La limitación

Muchas integraciones con LLM involucran API externas, arquitecturas compartidas o políticas de retención de datos poco claras. En entornos regulados, surgen preocupaciones como:

- Limitación de propósito y minimización de datos (RGPD)

- Derecho de supresión y auditabilidad

- HIPAA, GLBA y cumplimiento sectorial

Riesgo operacional

Cuando los documentos se procesan en modelos que pueden registrar, retener o reutilizar datos para su entrenamiento, las empresas pierden el control sobre la información sensible. Esto añade riesgos de cumplimiento que no siempre se solventan con simples contratos.

En mi opinión, una de las mayores limitaciones de los Grandes Modelos de Lenguaje en el procesamiento de documentos es su incapacidad para ofrecer resultados precisos cuando la precisión realmente importa. Los LLM resumen y comprenden bien, pero fallan en la extracción de datos estructurados, donde errores mínimos, como leer mal una puntuación o una fecha, pueden ser críticos. Además, los LLM tienden a sonar seguros incluso con datos incompletos o dudosos.

En casos educativos, he notado que los LLM son efectivos resumiendo materiales o explicando conceptos, pero no son fiables para extraer información estandarizada de expedientes académicos o resultados de exámenes. Los sistemas basados en reglas, con supervisión humana, siguen superando a la automatización basada solo en LLM en estos casos. - Joern Meissner, Fundador y Presidente, Manhattan Review

Resumen: Inteligencia estratégica frente a fiabilidad operativa

Los LLM ofrecen capacidades inigualables en la comprensión del lenguaje natural, la interpretación semántica y el razonamiento contextual. Sin embargo, en los flujos de automatización de documentos empresariales, se enfrentan a limitaciones en la precisión, la extracción determinista, la interpretación del diseño, la eficiencia de costes y el cumplimiento normativo. Sus resultados probabilísticos y sus tiempos de procesamiento más lentos hacen que un enfoque puramente basado en LLM sea arriesgado para el procesamiento de facturas, la automatización de cuentas por pagar y otros flujos de trabajo estructurados de gran volumen.

El auge de la “IA agéntica” en el procesamiento documental

A medida que las empresas intentan superar las limitaciones de la extracción puramente basada en LLM, surge un nuevo patrón arquitectónico: la IA agéntica. En este enfoque, los LLM no son generadores de texto de un solo paso, sino orquestadores que invocan herramientas externas, aplican un razonamiento en varias etapas y validan iterativamente sus resultados.

¿Qué es la IA agéntica?

La IA agéntica se refiere a sistemas donde un LLM:

- Descompone una tarea en varios pasos

- Llama a herramientas externas (motores de OCR, calculadoras, bases de datos, scripts de validación)

- Revisa y corrige sus propios resultados

- Repite este ciclo hasta alcanzar un umbral de confianza

En el procesamiento de documentos, esto significa que el LLM extrae datos, verifica totales, vuelve a consultar el documento y corrige incoherencias antes de entregar el resultado final.

Beneficio buscado: menos alucinaciones

Al introducir bucles de validación y un razonamiento asistido por herramientas, los flujos agénticos reducen los fallos habituales de los LLM:

- Incoherencias numéricas

- Campos faltantes

- Errores lógicos claros (p. ej., totales que no coinciden con las líneas de detalle)

Esto transforma al LLM de ser un sistema de “adivinación probabilística” a un sistema autocorrector, mejorando la precisión en documentos complejos o ambiguos.

La contrapartida: latencia, coste y complejidad

Aunque las arquitecturas agénticas mejoran la fiabilidad del razonamiento, introducen importantes compromisos operativos:

Latencia

Cada paso y llamada a herramientas añade tiempo. Los flujos agénticos pueden tardar de 8 a 40 segundos por documento, lo que impide su uso en tiempo real o en el procesamiento de grandes lotes.

Coste

Las múltiples invocaciones a los LLM incrementan el consumo de tokens y, por ende, los costes de la API. A escala, el coste por documento es muy superior al de los pipelines deterministas.

Complejidad técnica

Los sistemas agénticos requieren:

- Frameworks de orquestación

- Manejo de errores multiherramienta

- Capas de monitorización y observabilidad

- Calibración constante de prompts y lógica

Esto incrementa el tiempo de integración y el mantenimiento a largo plazo.

Realidad operativa: No para automatización de alto rendimiento

Para las organizaciones que procesan miles de documentos al mes, estos compromisos resultan difíciles de justificar. La automatización de documentos de gran volumen prioriza:

- Latencia predecible

- Costes estables

- Resultados deterministas

- Modos de fallo sencillos

La IA agéntica gana en profundidad de razonamiento, no en eficiencia operativa.

Veredicto: Potente, pero de aplicación limitada

La IA agéntica representa un avance importante en el uso de LLM para tareas complejas, pero sus puntos fuertes se alinean mejor con:

- Investigación de bajo volumen y alta complejidad

- Gestión de excepciones y análisis de casos límite

- Revisión de documentos intensiva en conocimiento

No es adecuada para pipelines de procesamiento de documentos o de introducción de datos a gran escala y en producción.

La IA agéntica potencia el razonamiento de los LLM, pero no elimina los compromisos clave de los modelos probabilísticos. En la automatización intensiva de documentos, complementa, pero no reemplaza, a los motores dedicados y deterministas.

Por qué todavía importan las herramientas especializadas (Parseur y el valor de motores dedicados)

Mientras crece el interés por la automatización impulsada por LLM, muchas organizaciones asumen que los modelos generalistas pueden sustituir a los sistemas tradicionales de procesamiento de documentos. En la práctica, ocurre lo contrario. Las empresas que logran una automatización fiable y de gran volumen combinan cada vez más los LLM con motores especializados, empleando cada uno donde aporta más valor.

Plataformas dedicadas como Parseur existen no porque los LLM carezcan de inteligencia, sino porque la automatización empresarial prioriza la precisión, la previsibilidad y la eficiencia operativa sobre el razonamiento general.

Precisión a escala

La automatización de documentos opera bajo restricciones muy distintas a las de la IA conversacional. Las facturas, las órdenes de compra y los formularios financieros exigen precisión a nivel de campo, no una comprensión aproximada.

Los motores especializados se basan en:

- Extracción basada en reglas

- Reconocimiento de patrones sensible al diseño

- Modelos de clasificación ajustados para documentos estructurados

Este enfoque genera resultados deterministas, garantizando que el mismo documento produzca siempre el mismo resultado.

En cambio, la extracción basada en LLM sigue siendo probabilística, y los pequeños errores se multiplican a gran escala, creando esfuerzos de conciliación y manejo de excepciones que anulan el beneficio esperado.

Reglas configurables combinadas con aprendizaje selectivo

Las plataformas modernas de procesamiento de documentos ya no se basan únicamente en reglas. Combinan:

- Plantillas y reglas de validación configurables

- Modelos ligeros de clasificación

- Detección de campos asistida por IA (opcional)

Este enfoque híbrido logra de forma consistente más del 95 % de precisión en la extracción de campos incluso con formatos variables.

Los flujos basados únicamente en LLM informan de tasas de error más altas en documentos financieros estructurados, mientras que los IDP especializados han demostrado reducir los errores de extracción y de introducción de datos en más del 52 %, lo que se traduce en menos revisión y esfuerzo manual.

La distinción clave aquí es el control. Las empresas pueden definir explícitamente:

- Formatos aceptados

- Lógica de validación

- Comportamientos de respaldo

Este nivel de determinismo es difícil de garantizar en sistemas basados solo en prompts.

Integración y madurez de workflow

Las plataformas especializadas están diseñadas para operar dentro del flujo de trabajo de producción, no en entornos de prueba de concepto.

Las herramientas consolidadas ofrecen:

- API REST y webhooks estables

- Integraciones nativas con sistemas ERP, de contabilidad y CRM

- Compatibilidad con plataformas de automatización (Zapier, Make, Power Automate)

- Monitorización, reintentos y gestión de errores incorporados

Esto permite a las empresas implementar la automatización de documentos como un componente fiable, no como una frágil orquestación de prompts y scripts.

Los LLM encajan bien en la capa de razonamiento, pero las herramientas especializadas gestionan la operativa necesaria para la automatización a escala empresarial.

Seguridad y cumplimiento desde la base

La seguridad y el cumplimiento no son un añadido en la automatización de documentos, sino requisitos arquitectónicos.

Plataformas como Parseur se diseñan con:

- Aislamiento de datos por cliente (multi-tenant)

- Cifrado en reposo y en tránsito

- Retención de datos configurable

- Controles de procesamiento y eliminación de datos conformes al RGPD

Al no depender de los documentos del cliente para reentrenar modelos globales, evitan muchos de los desafíos de soberanía y auditabilidad presentes en las plataformas de IA compartidas.

En sectores regulados, esta distinción es crítica. El cumplimiento depende no solo de cómo se almacenan los datos, sino de si se reutilizan para otros fines.

La intersección: LLMs dentro de herramientas de procesamiento documental

A medida que las empresas avanzan más allá de la experimentación, surge un modelo más pragmático: los LLM se integran dentro de las herramientas de procesamiento de documentos, no como motores de extracción independientes. Esta estrategia híbrida combina la adaptabilidad de los grandes modelos con la fiabilidad de los sistemas deterministas.

En lugar de sustituir la automatización de documentos tradicional, los LLM operan cada vez más como capas de soporte, mejorando la flexibilidad, el tratamiento de errores y la inteligencia posterior, mientras que la extracción principal continúa siendo estructurada y controlada.

Este cambio responde a un principio arquitectónico central: los LLM rinden mejor cuando están acotados por sistemas que imponen calidad, rendimiento y cumplimiento.

Capas de corrección y enriquecimiento mediante prompts

Uno de los usos más eficaces de los LLM en la extracción de documentos es el enriquecimiento post-extracción.

En este caso:

- Un motor determinista o sensible al diseño extrae los campos principales (p. ej., número de factura, total, vencimiento).

- Un LLM se aplica solo para:

- Normalizar descripciones

- Resolver etiquetas ambiguas

- Añadir metadatos contextuales (p. ej., categorización de proveedores, identificación de condiciones de pago)

El LLM opera después de la extracción principal, de modo que su naturaleza probabilística no afecta a la integridad de los datos. Los errores pueden acotarse, verificarse o ignorarse sin alterar el flujo principal.

Así se obtiene flexibilidad sin riesgo sistémico.

Validación humana asistida por LLM (resumen y explicaciones)

Otro patrón emergente es usar los LLM para asistir a los revisores humanos, no para sustituirlos.

Ejemplos:

- Resumir documentos largos resaltando campos o anomalías clave

- Explicar por qué un campo no superó la validación

- Generar notas en lenguaje natural para auditorías

Esto reduce la carga cognitiva frente a las excepciones sin delegar la entrada de datos definitiva en el LLM, una distinción capital en procesos regulados.

Desde el punto de vista operativo, mejora el flujo de trabajo y la coherencia, sin depender de los LLM para obtener el dato "oficial".

Flujos agénticos: el LLM como orquestador de sistemas deterministas

Las plataformas más avanzadas experimentan con flujos agénticos, donde el LLM coordina múltiples herramientas en el pipeline de documentos.

Aquí:

- El LLM actúa como capa de orquestación

- Los sistemas deterministas se encargan del OCR, la clasificación y la extracción

- Las reglas de validación imponen restricciones

- La intervención humana solo es necesaria cuando se superan ciertos umbrales

Estos sistemas deben ser cuidadosamente acotados, pues, como ya se vio, los flujos de trabajo agénticos añaden latencia, coste y complejidad, por lo que encajan mejor en:

- Documentos de bajo volumen y alta variabilidad

- Tareas de conciliación entre sistemas

- Flujos de trabajo impulsados por excepciones

Para la extracción masiva, la IA agéntica complementa, pero no sustituye, a los motores de procesamiento de documentos.

Por qué la arquitectura híbrida es el estándar en empresas

El avance de la integración de LLM en herramientas de extracción de documentos demuestra una comprensión madura de las capacidades y los límites de la IA.

Un sistema híbrido ofrece:

- Precisión determinista para datos estructurados

- Flexibilidad semántica en casos límite

- Coste y rendimiento predecibles a escala

- Mayor cumplimiento y capacidad de auditoría

Resumen estratégico

El futuro de la automatización de documentos no es “LLM-first”, sino LLM-aware.

Las organizaciones que triunfen en 2026 y más allá serán aquellas que:

- Usen los LLM para mejorar la toma de decisiones y la flexibilidad

- Confíen en motores dedicados para la ejecución operativa

- Diseñen arquitecturas donde la inteligencia esté al servicio de la fiabilidad

Cuándo usar LLM y cuándo herramientas especializadas

| Criterio de decisión | Usar Grandes Modelos de Lenguaje (LLM) | Usar herramientas especializadas (ej: Parseur) |

|---|---|---|

| Variabilidad documental | Documentos muy variables, novedosos o no estructurados (correos, texto libre, contratos) | Documentos consistentes o semiestructurados (facturas, recibos, formularios) |

| Requisitos de precisión | Resultados orientativos o asistidos que admiten revisión humana | Automatización como sistema de registro (system of record) que exige precisión determinista |

| Tolerancia al error | Se admiten inexactitudes ocasionales | Tolerancia al error prácticamente nula |

| Riesgo regulatorio | Datos no sensibles o no regulados | Datos regulados (RGPD, CCPA, finanzas, salud) |

| Privacidad y soberanía | Datos para razonamiento/enriquecimiento con poca retención | Aislamiento de datos, auditoría y derecho al olvido estrictos |

| Volumen de procesamiento | Volumen bajo a moderado | Alto volumen (de miles a millones/mes) |

| Sensibilidad a la latencia | Tiempos de procesamiento de varios segundos por documento son aceptables | Procesamiento en milisegundos o casi en tiempo real |

| Eficiencia de coste a escala | Aceptable para volúmenes bajos; costoso a gran escala | Coste bajo y predecible para grandes volúmenes |

| Complejidad de integración | Resultados flexibles, flujos de trabajo poco acoplados | Esquemas fijos, integración con sistemas ERP/RPA/contabilidad |

| Casos ideales de uso | Clasificación, resumen, detección de intención, enriquecimiento | Procesamiento de facturas, cuentas por pagar/cobrar, extracción de formularios, cumplimiento |

Perspectivas de futuro: LLM, sistemas agénticos y automatización

El panorama de la automatización de documentos impulsado por la IA evoluciona con rapidez. Las empresas deben mirar no solo las capacidades actuales de los LLM, sino también las tendencias emergentes que influirán en la automatización en los próximos años.

1. Arquitecturas LLM de próxima generación

- Modelos multimodales: LLM que procesan texto, imágenes, tablas y documentos de forma nativa, abriendo nuevas posibilidades para facturas, formularios y PDF.

- Modelos aumentados por recuperación (RAG): Al integrar fuentes externas de conocimiento, mejoran la precisión y el contexto sin necesidad de reentrenar con datos sensibles.

- Flujos agénticos: El razonamiento en varias etapas y las herramientas integradas permiten tareas autónomas (verificación cruzada de campos, resúmenes complejos, sugerencia de excepciones).

2. Tendencias de adopción empresarial

- Perspectivas de adopción: Se espera que la IA alcance niveles universales en las grandes empresas para 2027, con la IA generativa como núcleo en la automatización, la gestión de contenido y los flujos de conocimiento, lo que sugiere la proliferación de arquitecturas híbridas (inferencia basada en tendencias generales en lugar de en un único pronóstico explícito).

- El foco estará en reducir el esfuerzo humano, incrementar la velocidad y extraer insights estratégicos de los datos empresariales no estructurados.

3. Explicabilidad, confianza y supervisión

- El auge de los LLM traerá más presión regulatoria y operativa para la explicabilidad. Las organizaciones necesitarán mecanismos para auditar los resultados, justificar las decisiones y garantizar el cumplimiento.

- La supervisión humana (HITL, Human-in-the-Loop) seguirá siendo clave, especialmente en contratos, facturas o documentos financieros.

- Las estrategias preferirán arquitecturas híbridas que combinen la flexibilidad de los LLM con la fiabilidad determinista de los motores especializados para asegurar la confianza y el cumplimiento.

Equilibrando inteligencia IA y control operativo

Los Grandes Modelos de Lenguaje (LLM) ofrecen potentes capacidades cognitivas para comprender texto no estructurado y razonar sobre documentos complejos, pero no son una solución autónoma para la extracción de datos empresariales. Las organizaciones deben utilizar los LLM de forma selectiva en tareas estratégicas que requieran flexibilidad y razonamiento contextual, mientras confían en plataformas especializadas como Parseur para asegurar una precisión determinista, el cumplimiento normativo, la escalabilidad y la auditabilidad. Combinando la inteligencia de la IA con motores de extracción dedicados, las empresas logran fiabilidad operativa e insights estratégicos, optimizando la automatización de documentos en velocidad, precisión y control.

Preguntas Frecuentes

Para ayudar a los responsables de la toma de decisiones empresariales a comprender las aplicaciones prácticas y las limitaciones de los Grandes Modelos de Lenguaje en los flujos de trabajo con documentos, hemos recopilado respuestas a las preguntas más comunes sobre su uso, seguridad e integración con herramientas especializadas como Parseur.

-

¿Para qué son buenos los LLM en el procesamiento de documentos?

-

Los LLM destacan en la interpretación de texto no estructurado, el reconocimiento de patrones, la clasificación de contenido y la extracción de información sensible al contexto. Son ideales para flujos de trabajo flexibles y con un alto componente de razonamiento, pero son probabilísticos y no deterministas.

-

¿Por qué los LLM no pueden reemplazar a las herramientas de extracción especializadas?

-

Los LLM pueden producir resultados inconsistentes, tienen dificultades con datos cuyo significado depende del diseño y son costosos a gran escala. Herramientas como Parseur ofrecen precisión determinista, cumplimiento normativo y escalabilidad para documentos estructurados y de gran volumen.

-

¿Son seguros los LLM para los datos empresariales?

-

La seguridad depende de la implementación. Muchos LLM utilizan API compartidas que pueden retener datos. Parseur garantiza un procesamiento aislado, una retención configurable y el cumplimiento con el RGPD y otras normativas.

-

¿Cómo deben las empresas combinar LLM y herramientas especializadas?

-

Utilice los LLM para el razonamiento y los datos no estructurados, y los motores especializados para documentos estructurados, de gran volumen o regulados, para garantizar tanto la flexibilidad como la fiabilidad.

Última actualización el