Duże modele językowe (LLM) zapewniają niespotykaną elastyczność w rozumieniu nieustrukturyzowanego tekstu, przez co doskonale sprawdzają się w zadaniach wymagających rozumowania, podsumowywania i obsłudze niewielkich wolumenów dokumentów. Jednak ich probabilistyczny charakter, opóźnienia oraz brak deterministycznej precyzji sprawiają, że nie są wystarczające jako samodzielne rozwiązanie do automatyzacji dokumentów o dużej skali i objętych regulacjami.

Najważniejsze informacje:

- Strategiczna elastyczność: LLM-y świetnie radzą sobie z tłumaczeniem nieustrukturyzowanych, nowych lub bardzo zmiennych dokumentów, umożliwiając szybszy onboarding i pracę tam, gdzie kluczowe jest rozumowanie.

- Ograniczenia operacyjne: W wysoce ustrukturyzowanych procesach o dużym wolumenie, same LLM-y mogą powodować zwiększoną liczbę błędów, opóźnienia i ryzyko utraty zgodności. Systemy deterministyczne są niezbędne do zapewnienia niezawodności.

- Zaleta hybrydy: Najskuteczniejsze strategie automatyzacji dokumentów łączą LLM-y ze specjalistycznymi platformami takimi jak Parseur, korzystając z AI do rozumienia kontekstu, ale opierając ekstrakcję na mechanizmach deterministycznych — gwarantując precyzję, skalowalność i zgodność.

Paradoks automatyzacji

Duże modele językowe (LLM) zmieniły sposób, w jaki technologia rozumie język naturalny. Ich umiejętność tłumaczenia tekstów nieustrukturyzowanych i dokonywania uogólnionych wniosków technicznie zwiększyła możliwości automatyzacji dokumentów. Zadania, które wcześniej wymagały sztywnych reguł czy czasochłonnej konfiguracji, dziś stają się dostępne z większą elastycznością.

Ograniczenia LLM

Jednak ta elastyczność wprowadza paradoks w automatyzacji przedsiębiorstw. Chociaż LLM-y sprawdzają się przy zadaniach wymagających rozumowania lub w przypadku niskiego wolumenu dokumentów, testy Hyperscience pokazują, że ich skuteczność w krytycznych zadaniach (faktury, listy przewozowe) wynosi 66–77%, podczas gdy wyspecjalizowane systemy IDP osiągają 93–98%.

W związku z tym LLM-y nie są projektowane jako systemy referencyjne wszędzie tam, gdzie wymagana jest deterministyczna precyzja, sztywne schematy i powtarzalność działania.

Niedeterministyczne wyniki, zmieniające się opóźnienia spowodowane limitami API oraz rosnące koszty inferencji, zależne od wielkości wejścia i wydajności GPU, sprawiają, że czyste rozwiązania oparte o LLM są trudne do niezawodnego wdrożenia tam, gdzie wymagane są szybkość i przewidywalność.

Rozwój hybrydowych IDP

W efekcie rośnie zapotrzebowanie na hybrydowe podejście w automatyzacji dokumentów przedsiębiorstw. Hybrydowe architektury Inteligentnego Przetwarzania Dokumentów (IDP) łączą adaptacyjność LLM-ów z precyzją dedykowanych silników ekstrakcji i deterministycznej logiki, osiągając najlepszy kompromis między jakością a wydajnością.

Ten trend odzwierciedla fakt, że pojedyncze rozwiązanie nie daje maksymalnej elastyczności, dokładności, kontroli kosztów i zgodności. Coraz częściej przedsiębiorstwa dzielą warstwę rozumowania od realizacji, pozwalając każdej działać optymalnie według swojego przeznaczenia, zamiast wymuszać na LLM-ach całość przetwarzania.

Zgodnie z Fortune Business Insights, rynek IDP wzrośnie z 14,16 mld USD w 2026 roku do 91,02 mld USD w 2034 (CAGR 26,20%), co jasno pokazuje rosnące wymagania dużych firm operujących na olbrzymich wolumenach dokumentów. W tym modelu LLM-y są wykorzystywane punktowo, gdy kluczowy jest kontekst, a ekstrakcja na dużą skalę, walidacja i automatyzacja downstream realizowana jest przez systemy zaprojektowane pod niezawodność, kontrolę kosztów i zgodność.

Wniosek strategiczny: LLM-y są kluczowym elementem nowoczesnej automatyzacji dokumentów, lecz nie zastąpią silników dedykowanych stricte pod ekstrakcję. Firmy, które najlepiej dopasują narzędzie do zadania, zyskują szansę efektywnie zautomatyzować procesy bez kompromisu na precyzji, kontroli i wydajności.

Czym są duże modele językowe (LLM)?

Duże modele językowe (LLM) to zaawansowane modele machine learning, które rozumieją, generują i rozwiązują zadania związane z językiem naturalnym w szerokiej skali. Są trenowane na ogromnych zbiorach tekstowych przy użyciu głębokich sieci neuronowych (najczęściej architektury transformer), ucząc się statystycznych powiązań między słowami, frazami oraz pojęciami.

LLM-y przewidują najbardziej prawdopodobny kolejny token (słowo lub znak) bazując na wcześniejszych tokenach. Dzięki trenowaniu na olbrzymich, zróżnicowanych danych osiągają zdolności takie jak podsumowywanie, klasyfikacja, odpowiadanie na pytania, tłumaczenie oraz rozumowanie kontekstowe. W wykorzystaniu do dokumentów umożliwia to m.in. tłumaczenie swobodnych tekstów, wyciąganie sensu z akapitów oraz radzenie sobie ze zróżnicowaniem układu i stylistyki dokumentów.

Skala i rozwój LLM-ów

Rozwój możliwości dużych modeli językowych napędzany jest zarówno przez wzrost skali modeli, jak i innowacje w technikach treningowych:

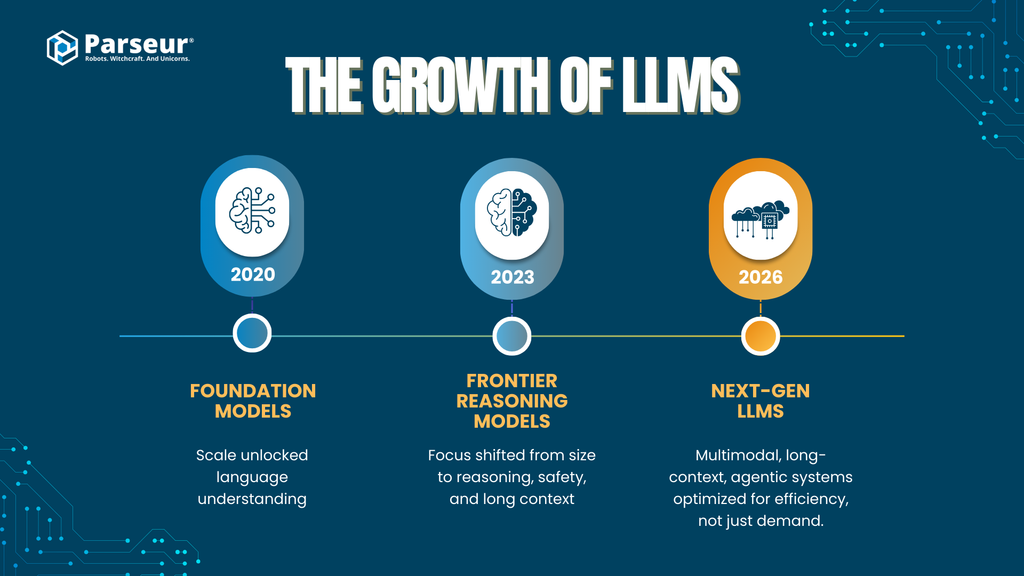

Wczesne modele bazowe (2020–2021)

Modele pokroju GPT-3 wprowadziły architekturę transformer na nieznaną wcześniej skalę (~175 mld parametrów), udowadniając, że sama wielkość modelu daje potencjał do uniwersalnego rozumienia języka.

Modele drugiej generacji (2023–2024)

Obejmuje m.in. GPT-4, Claude 2/3 (Anthropic), Gemini 1.x (Google) oraz DeepSeek-LLM. Oprócz większej liczby parametrów skupiają się na rozumowaniu, bezpieczeństwie i dłuższym kontekście. Spekuluje się, że modele te przekraczają bilion parametrów dzięki technikom mixture-of-experts i optymalizacjom architektury.

Modele z funkcją wyszukiwania i pobierania informacji

Platformy jak Perplexity AI wdrażają generowanie wspierane pobieraniem danych (RAG), łącząc wnioskowanie LLM z wiedzą wyszukiwaną w czasie rzeczywistym – poprawiając faktograficzność i ograniczając halucynacje.

Nowa fala LLM-ów (2025–2026)

Przewidywane kierunki rozwoju to:

- Multimodalność (obsługa tekstu, obrazów, tabel, audio)

- Obsługa długiego kontekstu (setki tysięcy, a nawet miliony tokenów)

- Możliwości agentowe (korzystanie z narzędzi, wieloetapowe rozumowanie, orkiestracja procesów)

- Nastawienie na efektywność i specjalizację zamiast prostego zwiększania rozmiaru modelu

Ten postęp pokazuje, że wydajność nie zależy już wyłącznie od wielkości modelu, lecz coraz częściej od architektury, wykorzystania narzędzi oraz integracji systemowej — kluczowe w automatyzacji dokumentów w przedsiębiorstwach.

LLM-y w przedsiębiorstwach: trendy wdrożeniowe

- LLM-y wychodzą poza testy i pierwsze pilotaże

- 78% przedsiębiorstw używa generatywnej AI przynajmniej w jednej funkcji biznesowej (operacje, analityka, automatyzacja).

- Wzrost wdrożeń korporacyjnych

- Do 2026 ponad 80% dużych firm będzie używać generatywnej AI lub API GenAI w środowiskach produkcyjnych (wzrost z poniżej 5% w 2023; Gartner).

- Automatyzacja dokumentów kluczowym przypadkiem użycia

- Ekstrakcja danych i automatyzacja przetwarzania dokumentów to jedne z najbardziej popularnych wdrożeń GenAI (McKinsey, Gartner).

Znaczenie dla automatyzacji dokumentów

W automatyzacji dokumentów LLM-y są najczęściej stosowane do:

- Przetwarzania nieustrukturyzowanego lub półustrukturyzowanego tekstu

- Klasyfikowania dokumentów według typu lub intencji

- Ekstrakcji rozmytych pól tam, gdzie klasyczne reguły zawodzą

- Radzenia sobie z nieregularnością języka, formatów i układów

Jednak chociaż LLM-y świetnie sprawdzają się w interpretacji i rozumowaniu, są modelami probabilistycznymi — ich wynik nie jest deterministyczny. Ma to poważne implikacje dla dokładności, powtarzalności, kosztów i bezpieczeństwa przy automatyzacji na dużą skalę.

Prowadzi to do kluczowego pytania: gdzie LLM-y przynoszą strategiczną wartość, a gdzie potrzebne są narzędzia specjalistyczne?

Kluczowe możliwości: gdzie LLM-y się sprawdzają (warstwa strategiczna)

Modele LLM oferują najwięcej wartości na strategicznym poziomie automatyzacji dokumentów, tam, gdzie kluczowa jest elastyczność, rozumienie kontekstu i semantyka, a nie bezwzględna precyzja. Ich atuty są jakościowe — idealnie nadają się do automatyzacji początkowej, obsługi przypadków granicznych i wiedzochłonnych procesów.

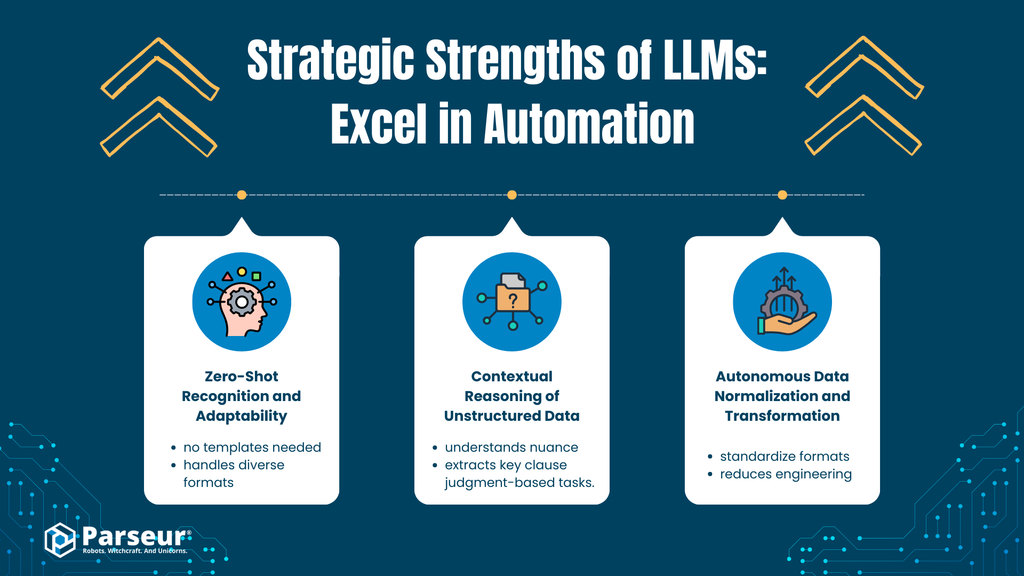

A. Zero-shot recognition i adaptacyjność

Analiza

LLM-y wykazują zdolność do semantycznego rozumienia, pozwalając im wydobywać informacje z dokumentów nowych typów i układów, nawet jeśli nigdy wcześniej nie były ich uczone. Przykładem jest rozpoznanie numeru faktury, terminu płatności czy całkowitej kwoty w niestandardowej fakturze od nowego dostawcy, mimo nietypowych etykiet i układu.

Zdolność ta wynika nie z trenowania na konkretnych layoutach, ale z szeroko zakrojonego modelu językowego. Model wydobywa znaczenie z kontekstu, a nie ze zdefiniowanych szablonów.

Korzyści biznesowe

- Skrócenie czasu wdrożenia i ograniczenie konieczności konfiguracji

- Mniejsza zależność od dużych, oznakowanych zbiorów treningowych

- Ułatwienie szybkiego onboardingu nowych dostawców i formatów

W środowiskach o dużej zmienności taka adaptacyjność błyskawicznie upraszcza i przyspiesza wdrożenia automatyzacji.

B. Rozumowanie kontekstowe na danych nieustrukturyzowanych

Analiza

W przeciwieństwie do reguł i klasycznych systemów bazujących na pozycjach (regex, logika pozycji), LLM-y potrafią analizować niuanse językowe oraz intencje i relacje w tekstach pół- lub nieustrukturyzowanych, takich jak e-maile, zapisy korespondencji czy teksty umów.

Model z tego poziomu potrafi zrozumieć relację między pojęciami i wydobyć sens z narracyjnego języka. To wyzwanie, które trudno rozwiązać wyłącznie przez klasyczne reguły.

Korzyści biznesowe

- Automatyzacja zadań wymagających rozumowania i oceny

- Obsługa takich przypadków jak:

- Klasyfikacja intencji

- Identyfikacja specyficznych klauzul umownych

- Wydobycie dat, ryzyk lub zobowiązań z tekstu

- Redukcja pracy ręcznej w wiedzochłonnych procesach

LLM-y są nieocenione tam, gdzie struktura dokumentów jest nieregularna, a kontekst równie istotny jak treść.

C. Autonomiczna normalizacja i transformacja danych

Analiza

LLM-y mogą samodzielnie normalizować lub standaryzować dane:

- Przekształcanie różnorodnych formatów dat na standardy (np. ISO 8601)

- Ujednolicanie walut i liczb

- Konsolidowanie rozbieżnych nazw pól

Ogranicza to zależność od skryptów czyszczących, złożonych konwersji czy poprawek downstream.

Korzyści biznesowe

- Ułatwienie integracji z systemami downstream (ERP, CRM)

- Mniej pracy inżynieryjnej dla czyszczenia i normalizacji danych

- Szybsze wdrożenia pilotażowe i POC

Strategicznym atutem LLM w automatyzacji jest:

- Masowe rozumienie języka naturalnego — automatyczne wydobycie, podsumowanie, klasyfikacja nieustrukturyzowanych informacji w dużych wolumenach

- Semantyczna elastyczność — zrozumienie znaczenia, niezależnie od słownictwa czy układu

- Abstrakcyjne, nienaznaczone regułami rozumowanie

- Szybka adaptacja do różnych przypadków

- Podstawa do workflow agentowych — agentowe podejście, łańcuchowanie promptów, dekompozycja zadań

Przykład: SaaS-owy klient obsługujący ~4000 faktur rocznie rozpoczął automatyzację ich przetwarzania. Dzięki LLM uzyskano 40% oszczędności manualnej pracy przy standardowych dokumentach od aktualnych dostawców. Jednak przy niestandardowych, starszych fakturach – szczególnie zeskanowanych PDF — LLM nie był w stanie poprawnie wydobyć sumy lub dat. Kluczem okazało się połączenie OCR z warstwą walidacji i reguł wspierających LLM. LLM doskonale wspiera automatyzację, ale nie powinien być główną warstwą decyzyjną. – Nick Mikhalenkov, SEO Manager, Nine Peaks Media

Krytyczne ograniczenia: gdzie LLM-y zawodzą (warstwa operacyjna)

Duże modele językowe mają imponującą wartość strategiczną, jednak podczas wdrożeń na dużą skalę pojawiają się realne ograniczenia operacyjne. W systemach, gdzie liczą się precyzja, spójność, szybkość oraz koszty, czyste podejście LLM niesie ze sobą istotne ryzyka.

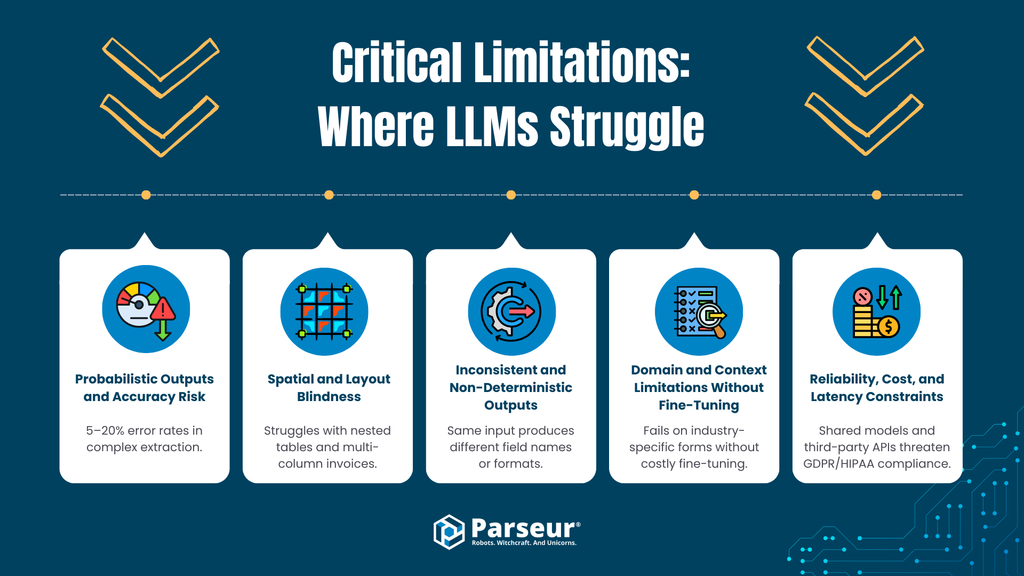

A. Probabilistyczność wyników i brak gwarancji precyzji

LLM-y z natury generują odpowiedzi na podstawie prawdopodobieństw. Nawet najnowsze modele wykazują mierzalny odsetek błędów i halucynacji. Według Master of code nawet w GPT-4o odsetek halucynacji przy zadaniach ekstrakcji i złożonego rozumowania wynosi 5–20%.

Ryzyko

W procesach finansowych i zgodnych z przepisami (AP, AR, zakupy, compliance), błędy probabilistyczne są niedopuszczalne. Ramp podaje, że ręczne przetwarzanie powoduje 1–3% błędów — czyli nawet 10–30 źle obsłużonych dokumentów na 1000. LLM nie gwarantuje powtarzalnego wyniku, co wymusza kosztowne warstwy walidacyjne i korekcyjne.

B. Niewrażliwość na układ graficzny (layout blindness)

Większość LLM przetwarza tekst sekwencyjnie — nie widzi natywnie położeń ani relacji przestrzennych. Stąd ma problemy z analizą informacji zależnych od układu, jak:

- Wielokolumnowe faktury

- Zagnieżdżone tabele

- Nagłówki zajmujące wiele kolumn

- Wartości zależne od pozycji

To pole, w którym skuteczność LLM dopiero powoli rośnie.

Ryzyko

Błędne przyporządkowanie pozycji czy pól, źle odczytane sumy — to subtelne, lecz kosztowne błędy, trudne do wykrycia na etapie operacyjnym.

C. Niestabilność i zmienność struktury wyników

LLM-y nie wymuszają sztywnych schematów danych. Nazwy pól, formaty i kolejność mogą się różnić, nawet jeśli przetwarzany jest ten sam dokument lub lekko zmodyfikowany prompt.

Ryzyko

Systemy operacyjne wymagają przewidywalności (stałe struktury JSON, typy danych). Zmienność wyników wymusza rozbudowane mechanizmy walidacji i obsługi wyjątków.

D. Ograniczenia domenowe bez fine-tuningu

LLM-y lepiej radzą sobie z tekstem ogólnym niż z bardzo specyficznymi branżowymi dokumentami (logistycznymi, podatkowymi, specyficznymi fakturami), jeśli nie zostaną dodatkowo wytrenowane.

Ryzyko

Fine-tuning wymaga dedykowanych zestawów danych, wydłuża wdrożenie, może generować wątpliwości dotyczące prywatności i utrzymania modelu.

E. Wydajność, koszty i opóźnienia

Ekstrakcja przy użyciu LLM, a zwłaszcza w trybie agentowym lub krok-po-kroku, jest znacząco bardziej zasobożerna. Przetworzenie dokumentu zajmuje od 8 do nawet 40 sekund, podczas gdy silniki deterministyczne działają w milisekundy.

Ryzyko

Koszt obsługi rośnie nawet 10–100× w porównaniu do IDP. Przy dużym wolumenie LLM-y nie są opłacalne, a opóźnienia stanowią wąskie gardło procesu.

F. Ryzyka prywatności i zgodności

Wiele integracji LLM korzysta z API modeli zewnętrznych, nie zawsze dając jasność co do przechowywania i wykorzystywania danych. Problem ten dotyczy:

- Ochrony danych osobowych (RODO)

- Regulacji branżowych (HIPAA, GLBA)

Ryzyko

Brak kontroli nad przetwarzaniem i przechowywaniem danych oznacza zagrożenie utraty suwerenności nad informacjami firmowymi. To ryzyko nie do obejścia samą umową SLA.

Moim zdaniem największym wyzwaniem przy użyciu dużych modeli językowych w automatyzacji dokumentów jest brak gwarancji precyzji. LLM-y doskonale rozumieją tekst, ale w ekstrakcji danych strukturalnych (np. data, kwota) regularnie się mylą — i ten jeden błąd potrafi zachwiać całą automatyzacją. Do zadań, gdzie liczy się bezbłędność i powtarzalność, lepiej sprawdzają się tradycyjne rozwiązania regułowe. — Joern Meissner, Founder & Chairman, Manhattan Review

Podsumowanie: strategiczna inteligencja vs operacyjna niezawodność

LLM-y zapewniają wyjątkowy poziom rozumienia tekstu i kontekstu. Jednak w automatyzacji na poziomie korporacyjnym ich ograniczenia w precyzji, deterministycznym wydobyciu pól, interpretacji layoutów, kosztach i zgodności sprawiają, że nie są wystarczające do przetwarzania dużych wolumenów czy obsługi faktur i dokumentów regulowanych.

Wzrost znaczenia agentowego AI w przetwarzaniu dokumentów

Aby przełamać ograniczenia klasycznego podejścia LLM, pojawił się nowy wzorzec architekturalny: agentowe AI. Tutaj LLM nie tylko generuje tekst, ale także krok po kroku zarządza procesem i wywołuje narzędzia pomocnicze.

Czym jest agentowe AI?

To system, w którym LLM:

- Dzieli zadanie na etapy

- Wywołuje narzędzia zewnętrzne (OCR, bazy, walidatory)

- Skorygowuje i przegląda swoje odpowiedzi

- Iteruje aż do osiągnięcia zadowalającego wyniku

W praktyce dokumentowej: LLM wydobywa dane, sprawdza sumy, analizuje ponownie, koryguje i dopiero końcowy wynik trafia do downstream.

Cel: ograniczenie halucynacji

Dzięki walidacji i wsparciu narzędzi agentowe workflow ogranicza typowe błędy LLM, takie jak:

- Błędne lub niespójne liczby

- Braki pól

- Proste błędy logiczne (np. suma niezgodna z pozycjami)

LLM zamiast raz generować odpowiedź, przechodzi pełną pętlę sprawdzania własnych rezultatów.

Skutki uboczne: wydajność, koszty i złożoność

Architektury agentowe poprawiają rozumowanie, lecz kosztują:

Opóźnienia

Każdy krok to dodatkowy czas. Realne workflow trwają do 40 sekund na dokument, co uniemożliwia pracę w trybie real-time lub batchowym na dużą skalę.

Wyższe koszty

Wielokrotna inferencja LLM to wielokrotnie wyższe zużycie tokenów i opłat za API — koszty na dokument potrafią być o rząd wielkości większe niż w deterministycznych IDP.

Komplikacja workflow

Potrzebna jest złożona orkiestracja, monitorowanie, automatyzacja obsługi błędów i tuning promptów — to wszystko wymaga więcej zasobów inżynierskich.

Praktyka: ograniczone zastosowania masowe

Przy tysiącach dokumentów miesięcznie kompromis agentowy jest nieakceptowalny. Dla przedsiębiorstw liczy się przewidywalność kosztów, deterministyczność, szybkość i proste zarządzanie wyjątkami.

Werdykt: silne uzupełnienie, nie alternatywa masowa

Agentowe AI to przełom dla złożonych lub nietypowych przypadków, lecz w automatyzacji masowej jest tylko opcją komplementarną — nie zastąpi specjalistycznych systemów.

Dlaczego specjalistyczne narzędzia są niezbędne (Parseur i przewaga silników dedykowanych)

Popularność LLM-ów rodzi przekonanie, że mogą one zastąpić systemy dedykowane. Tymczasem praktyka pokazuje: firmy stawiające na niezawodność stawiają na synergię — hybrydę LLM + silniki specjalistyczne, wykorzystując moc każdej z technologii do jej naturalnych zadań.

Platformy takie jak Parseur są niezbędne, nie dlatego że LLM-y są zbyt „mało inteligentne”, ale ponieważ automatyzacja biznesowa na dużą skalę wymaga precyzji, powtarzalności i wydajności, które musi zapewniać silnik deterministyczny.

Precyzja w skalowalnej ekstrakcji

Systemy przetwarzania dokumentów muszą zapewniać „bezwzględną” dokładność. Przykłady jak faktury czy zamówienia wymagają poprawności na poziomie każdego pola.

Specjalistyczne silniki korzystają z reguł, rozpoznawania layoutu oraz dedykowanych klasyfikatorów — dając deterministyczne wyniki, zawsze takie same dla tych samych danych.

U LLM nawet minimalna ilość błędów, przy dużych wolumenach, szybko eskaluje do wielu kosztownych poprawek i eskalacji.

Konfigurowalne reguły + uczenie ukierunkowane

Nowoczesne platformy IDP łączą szablony, walidacje, lekkie modele AI i okazyjne wsparcie LLM dla identyfikacji pól. Takie hybrydy osiągają ponad 95% dokładności na poziomie pól, a redukują błędy ekstrakcji o 52% względem klasycznych LLM bez wsparcia deterministycznego.

Tym, co daje przewagę specjalistycznym narzędziom, jest kontrola — przedsiębiorstwo może zdefiniować akceptowane formaty, logikę walidacji i ścieżki alternatywne.

Dojrzałość integracji workflow

Specjalistyczne systemy projektowane są do wdrożeń produkcyjnych:

- Stabilne API, webhooki

- Integracje z ERP, księgowością, CRM

- Współpraca z narzędziami RPA (Zapier, Make, Power Automate)

- Obsługa błędów, monitoring i retry

To umożliwia wdrożenia dokumentów jako stabilnych usług, nie eksperymentalnych procesów.

LLM-y mogą być użyteczne jako „warstwa rozumowania”, lecz rdzeń workflow wymaga niezawodności silników deterministycznych.

Zintegrowane bezpieczeństwo i zgodność

W organizacjach korporacyjnych zgodność prawna i bezpieczeństwo są podstawą, nie dodatkiem.

Parseur zapewnia:

- Izolowanie klientów („tenancy”)

- Szyfrowanie "at-rest" i "in-transit"

- Konfigurowalną politykę przechowywania oraz kasowania danych

- Rozliczalność pod kątem RODO i prawa do zapomnienia

System nie wykorzystuje dokumentów klientów do trenowania modeli, ograniczając ryzyka związane z suwerennością danych.

Punkt styku: LLM-y wewnątrz narzędzi do przetwarzania dokumentów

Dojrzałe firmy wdrażają model, w którym LLM-y są częścią narzędzi ekstrakcyjnych, lecz nie silnikiem rdzenia procesu. To podejście hybrydowe daje efektywną adaptacyjność (LLM) i niezawodność (silniki deterministyczne).

Zamiast wypierać klasyczną automatyzację, LLM-y działają jako warstwa wspierająca: zwiększają elastyczność, inteligencję i efektywność, lecz sama ekstrakcja bazuje na precyzyjnych metodach specjalistycznych.

Warstwa wzbogacenia i korekty

Sprawdzony model to post-extraction enrichment:

- Główne pola wydobywa silnik deterministyczny lub layoutowy

- LLM normalizuje opisy, rozstrzyga niejasne etykiety, dodaje kontekst (np. identyfikuje warunki płatności lub klasyfikuje kategorię dostawcy)

LLM działa po ekstrakcji — jego ewentualna probabilistyczność nie wpływa na kluczowe dane.

LLM jako wsparcie Human-in-the-Loop

Kolejny sprawdzony pattern: LLM-y wspierają pracę osób przeglądających dokumenty, np.:

- Streszczają długie dokumenty, wyciągając anomalia i kluczowe pola

- Wyjaśniają powody odrzucenia rekordu czy pola

- Tworzą notatki audytowe

To obniża koszty poznawcze, zapewniając pełną kontrolę człowieka nad akceptacją danych wejściowych.

Agentowy workflow: LLM jako orkiestrator

Zaawansowane platformy eksperymentują z przepływami, w których LLM zarządza zadaniami między narzędziami:

- LLM — koordynator

- Silniki deterministyczne — ekstrakcja pól, OCR, klasyfikacja

- Reguły walidacji — enforcement ograniczeń

- Interwencja człowieka — tylko przy nadmiarze błędów

Taka architektura sprawdza się w niskich wolumenach, wysokiej złożoności lub w reconciliacji danych.

Hybrydowe architektury nowym standardem

Coraz częściej narzędzia ekstrakcyjne budowane są wokół hybrydy, bo:

- Zapewniają deterministyczną precyzję dla danych strukturalnych

- Dają semantyczną elastyczność na nietypowe, trudne przypadki

- Gwarantują przewidywalne koszty i wydajność

- Podnoszą zgodność i możliwość audytu

Podsumowanie strategiczne

Przyszłość automatyzacji dokumentów to nie podejście „LLM-first”, lecz LLM-aware — mądre stosowanie LLM do zadań wymagających rozumowania i elastyczności, przy jednoczesnym poleganiu na silnikach specjalistycznych wszędzie tam, gdzie kluczowa jest deterministyczność, powtarzalność i zgodność.

Kiedy używać LLM-ów, a kiedy narzędzi specjalistycznych (np. Parseur)?

| Kryterium decyzyjne | Gdy stosować Duże Modele Językowe (LLM) | Gdy stosować Specjalistyczne Narzędzia do Przetwarzania Dokumentów (np. Parseur) |

|---|---|---|

| Zmienność typów dokumentów | Bardzo zmienne, nowe lub nieustrukturyzowane (e-maile, teksty swobodne, umowy) | Dokumenty powtarzalne lub półstrukturalne (faktury, paragony, formularze) |

| Wymagana dokładność | Wyniki doradcze lub wsparcie – akceptowalna kontrola człowieka | Automatyzacja systemów referencyjnych – wymagana powtarzalność i precyzja |

| Tolerancja błędów | Dopuszczalne sporadyczne niedokładności | Tolerancja błędów bliska zeru |

| Ryzyko regulacyjne | Dane niespecjalnie wrażliwe, nieobjęte ścisłymi normami | Dane regulowane (RODO, CCPA, finanse, zdrowie) |

| Prywatność i suwerenność | Dane do rozumowania/enrichment, brak wysokich wymagań retencyjnych | Wysoka izolacja i audytowalność, prawo do bycia zapomnianym |

| Wolumen przetwarzania | Mały do średniego | Duży (tysiące/miliony dokumentów miesięcznie) |

| Wrażliwość na opóźnienia | Sekundy na dokument dopuszczalne | Milisekundy lub czas zbliżony do rzeczywistego wymagane |

| Efektywność kosztowa w skali | Dobre przy małym wolumenie, koszty rosną szybko przy dużej skali | Przewidywalny niski koszt jednostkowy dla dużych wolumenów |

| Złożoność integracji | Elastyczne wyniki, luźno powiązane workflow | Stałe schematy, integracje ERP/RPA/Księgowość |

| Idealne przypadki użycia | Klasyfikacja, podsumowania, wykrywanie intencji, enrichment | Przetwarzanie faktur, AP/AR, ekstrakcja formularzy, workflow zgodności |

Perspektywy rozwoju: LLM-y, systemy agentowe i automatyzacja

Ekosystem dokumentowej automatyzacji AI dynamicznie się rozwija. Firmy powinny planować zarówno pod kątem dzisiejszych możliwości LLM, jak i nadchodzących trendów.

1. LLM-y nowej generacji

- Multimodalne modele: Przetwarzają tekst, obrazy, tabele czy skany PDF, co otwiera automatyzację dokumentów o nietypowych formatach.

- Modele z RAG: Integracja z zewnętrznymi bazami wiedzy zwiększa zgodność faktograficzną, bez potrzeby trenowania na poufnych danych.

- Agentowe workflow: LLM organizuje wieloetapowe zadania, np. cross-checking pól, streszczenie umów, wyjaśnianie wyjątków.

2. Trendy wdrożeniowe w przedsiębiorstwach

- Projekcje adopcji AI: Do 2027 niemal wszystkie większe firmy mają korzystać z AI, a generatywna AI stanie się główną częścią procesów automatyzacji, przetwarzania treści i zarządzania wiedzą. Stos hybrydowy zostanie standardem.

- Wygrywają strategie łączące redukcję pracy manualnej, przyspieszenie procesów i nowoczesną analizę danych nieustrukturyzowanych.

3. Wyjaśnialność, zaufanie, nadzór

- Wraz z upowszechnieniem LLM-ów, rośnie presja na ich wyjaśnialność oraz zgodność z regulacjami — konieczne będą mechanizmy audytu i kontroli.

- Efektywne workflow utrzymają człowieka w pętli (Human-in-the-Loop), zwłaszcza przy dokumentach krytycznych.

- Najwyższą wydajność zapewni hybryda: elastyczność LLM i niezawodność narzędzi specjalistycznych.

Równowaga między inteligencją AI a kontrolą operacyjną

Duże modele językowe dostarczają ogromnych możliwości w rozumieniu nieustrukturyzowanych danych i złożonym rozumowaniu, jednak nie zastąpią wyspecjalizowanych narzędzi ekstrakcyjnych w środowiskach korporacyjnych. Organizacje powinny korzystać z LLM-ów wybiórczo — do strategicznych zadań opartych na elastyczności i kontekście, zapewniając deterministyczność ekstrakcji, zgodność prawną i wydajność dzięki dedykowanym systemom, jak Parseur. Połączenie tych technologii daje niezawodność i przewagę strategiczną, optymalizując automatyzację dokumentów pod kątem prędkości, dokładności i pełnej kontroli.

Najczęściej Zadawane Pytania

Aby pomóc osobom decyzyjnym w przedsiębiorstwach zrozumieć praktyczne zastosowania i ograniczenia dużych modeli językowych w przepływach pracy opartych na dokumentach, przygotowaliśmy odpowiedzi na najczęściej zadawane pytania dotyczące ich zastosowania, bezpieczeństwa i integracji ze specjalistycznymi narzędziami, takimi jak Parseur.

-

W czym LLM-y sprawdzają się w przetwarzaniu dokumentów?

-

LLM-y doskonale radzą sobie z tłumaczeniem tekstu nieustrukturyzowanego, rozpoznawaniem wzorców, klasyfikacją treści i wydobywaniem informacji zależnych od kontekstu. Idealnie nadają się do elastycznych procesów wymagających rozumowania, jednak ich działanie opiera się na prawdopodobieństwie, nie na deterministycznych zasadach.

-

Dlaczego LLM-y nie mogą zastąpić wyspecjalizowanych narzędzi ekstrakcyjnych?

-

LLM-y mogą generować niespójne wyniki, mają trudności z danymi zależnymi od układu dokumentu i są kosztowne przy dużej skali. Narzędzia takie jak Parseur zapewniają deterministyczną dokładność, zgodność z przepisami oraz skalowalność przy dużej liczbie i złożonej strukturze dokumentów.

-

Czy LLM-y są bezpieczne dla danych firmowych?

-

Bezpieczeństwo zależy od wdrożenia. Wiele LLM-ów korzysta ze współdzielonych API, które mogą przechowywać dane. Parseur zapewnia izolowane przetwarzanie, konfigurowalne okresy przechowywania oraz zgodność z RODO i innymi rozporządzeniami.

-

Jak przedsiębiorstwa powinny łączyć LLM-y i wyspecjalizowane narzędzia?

-

Wykorzystuj LLM-y do rozumowania i przetwarzania danych nieustrukturyzowanych, a wyspecjalizowane silniki do dokumentów o dużej objętości, sformalizowanych lub podlegających regulacjom, by zapewnić elastyczność i niezawodność.

Ostatnia aktualizacja