Wat Betekent “Geen Training Op Jouw Data”?

In de kern verwijst “geen training op jouw data” naar een toezegging van AI-leveranciers dat de informatie die jij met hun systemen deelt nooit wordt gebruikt om hun machine learning modellen te verbeteren of bij te trainen.

Belangrijkste Punten

- “Geen training op jouw data” houdt in dat informatie uitsluitend wordt verwerkt en niet opnieuw wordt ingezet voor AI-training.

- Het is voor bedrijven essentieel om dit beleid te hanteren ter bescherming van vertrouwen, compliance en eigendomsrechten.

- Parseur levert standaard encryptie, bewaarbeleid, compliance en een strikt geen-trainingsbeleid.

Zodra bedrijven AI-tools inzetten, willen ze de garantie dat hun gevoelige data niet wordt hergebruikt, gelekt of ingezet voor andere doeleinden zonder hun toestemming.

Ook consumenten maken zich zorgen: ongeveer 70% van de volwassenen vertrouwt bedrijven niet om AI op verantwoorde wijze te gebruiken, en meer dan 80% verwacht enig misbruik van hun data, blijkt uit Protecto. Reputatieschade door verkeerd gebruik van data kan zelfs zwaarder wegen dan sancties van toezichthouders.

Grote AI-leveranciers zoals OpenAI, Anthropic en Microsoft liggen onder een vergrootglas met betrekking tot hun omgang met klantdata. De centrale vraag: wordt de gedeelde data alleen verwerkt voor het beoogde doel, of wordt deze ook gebruikt om het model verder te trainen?

Daarom groeit het beleid “geen training op jouw data” snel uit tot de nieuwe norm voor vertrouwen in AI. Het waarborgt dat klantdata alleen wordt gebruikt om verzoeken uit te voeren, en nooit terechtkomt in bredere trainingsmodellen. Voor bedrijven vormt deze garantie het fundament voor vertrouwen en langdurige adoptie van AI-oplossingen.

In dit artikel ontdek je wat “geen training op jouw data” in de praktijk betekent, waarom het cruciaal is voor compliance en governance, hoe grote spelers er mee omgaan, en hoe Parseur dit beleid toepast om zowel AI-vertrouwen als dataveiligheid te borgen.

Wat Betekent “Geen Training Op Jouw Data” Nu Echt?

Jouw data wordt uitsluitend gebruikt voor het uitvoeren van jouw verzoek – of dat nu het samenvatten van een document, het extraheren van gegevens, het opstellen van tekst of het uitvoeren van een analyse betreft. Vervolgens wordt de data verwijderd of veilig opgeslagen onder duidelijke afspraken.

Het essentiële verschil:

- Verwerken: Jouw data wordt in realtime benut voor een taak, zoals rapportages genereren of het extraheren van factuurinformatie. Na afronding wordt deze data niet meer gebruikt om het systeem te trainen of te verbeteren.

- Training: Data wordt ingezet om het AI-model te verbeteren, waardoor onderdelen van jouw gevoelige input deel kunnen uitmaken van het kennisbestand, met risico op het opnieuw verschijnen ervan.

Bij veel grootschalige AI-systemen werd dit onderscheid lange tijd niet gemaakt, en werd klantinput zowel verwerkt als gebruikt voor training. Hoewel dit technologische groei stimuleerde, bracht het ook serieuze risico’s:

- Bezwaren rond vertrouwelijkheid: Gevoelige bedrijfs-, financiële of klantgegevens konden onbedoeld gedeeld of gereconstrueerd worden.

- Eigendomsdiscussies: Vervagen de rechten als jouw input gebruikt wordt om een model te trainen?

- Compliance-dilemma’s: Sectoren als zorg, financiën en juridische sectoren mogen geen risico lopen op het hergebruiken van klantdata zonder toestemming.

Een strikt geen-trainingsbeleid neemt dit twijfel weg. Data wordt slechts verwerkt voor de afgenomen dienst: niet gerecycled voor modeltraining, niet gedeeld, en niet op verborgen wijze gebruikt. Dit versterkt databeveiliging, ondersteunt compliance en bevordert het vertrouwen tussen bedrijven en AI-leveranciers.

Kortom, “geen training op jouw data” betekent dat jouw data beschermd, privé en volledig onder jouw regie blijft.

Waarom Trainingsbeleid van Data Belangrijk Is Voor Bedrijven

Een effectief AI-privacybeleid is onmisbaar. Voor bedrijven betekent het de garantie dat gevoelige informatie beschermd blijft zonder verborgen risico’s. Zonder heldere richtlijnen riskeren organisaties verlies van controle over data, boetes, reputatieschade en concurrentienadelen.

Risico’s van data gebruiken voor training

- Intellectueel eigendom kan lekken: Interne processen, contracten of onderzoek kunnen onbedoeld in trainingsdata terechtkomen, met mogelijke gevolgen voor eigendomsrechten of concurrentievoordeel.

- Compliance-overtredingen: Wetgeving als GDPR en CCPA stelt strenge eisen aan data. Hergebruik voor modeltraining zonder toestemming kan tot hoge boetes leiden.

- Concurrentiegevoeligheid: Als jouw data een gedeeld model verbetert, krijgen concurrenten mogelijk voordeel uit wat van jou is.

Waarom bedrijven dit belangrijk vinden

Organisaties kijken niet alleen naar de prestaties van AI-tools, maar ook kritisch naar het AI privacybeleid. Uit onderzoek van The Futurum Group uit 2025 blijkt dat 52% van de organisaties technische expertise het belangrijkst vindt, met data- en privacybeleid direct daarachter met 51%. Robuust beleid rondom privacy is dus cruciaal bij leverancierselectie. Leveranciers met een geen-trainingsbeleid tonen:

- Respect voor eigendom: Klanten behouden controle over hun data.

- Compliance: Juridisch risico neemt af, audits worden eenvoudiger.

- Vertrouwen en openheid: Geen verborgen databewerking, maar duurzame klantrelaties.

Samengevat: het beleid rond datatraining bepaalt of bedrijven met een AI-leverancier in zee gaan. Een leverancier met een strikt geen-trainingsbeleid stimuleert innovatie met behoud van controle, compliance en vertrouwen.

Compliance- en Governance Perspectief

AI-adoptie draait bij veel organisaties om meer dan alleen efficiency – vooral compliance en governance zijn doorslaggevend. Regelgeving als ISO 27001, GDPR en sectorspecifieke normen (zoals in zorg en financiën) verplichten bedrijven tot uiterst zorgvuldige omgang met data. Uit de 2025 Investment Management Compliance Testing Survey blijkt dat 57% van de compliance officers AI als hun grootste compliance-zorg ziet. Afstemmen op de strengste regels is dus essentieel.

Een geen-trainingsbeleid voldoet direct aan compliance-eisen:

- Dataminimalisatie: Alleen essentiële data wordt verwerkt, wat risico’s minimaliseert.

- Toestemming en controle: Jouw data wordt nooit zonder voorafgaande toestemming opnieuw gebruikt.

- Doelbeperking: Gegevens dienen enkel het oorspronkelijke doel en niet toekomstige training.

Deze aanpak maakt het bedrijven eenvoudiger om aan audits te voldoen en boetes te voorkomen.

Goed governance draait om vertrouwen door transparantie en standaardisatie. Branchestandaarden, zoals van de Electronic Commerce Code Management Association (ECCMA), benadrukken de waarde van hoogwaardige datakwaliteit en betrouwbare processen. Geen-trainingsbeleid weerspiegelt deze waarden door openheid te bieden over het gebruik van data.

Organisaties die AI-leveranciers kiezen met solide governance nemen een voorsprong in veiligheid en ethisch gebruik van AI.

Voorbeelden uit de Praktijk: Hoe Big Tech Omgaat Met Datatraining

Steeds meer Big Tech-bedrijven geven gehoor aan de vraag naar privacy en controle over data.

- OpenAI: Bij ChatGPT mag data in de gratis versie gebruikt worden voor modelverbetering, maar bedrijven kunnen via opt-out instellingen hun data afschermen en zijn ervan verzekerd dat hun input niet aan training wordt toegevoegd.

- Microsoft: Microsoft benadrukt in Copilot voor Microsoft 365 en Azure OpenAI Service het isoleren van bedrijfsdata. Zakelijke klantinformatie wordt daar nooit gebruikt voor modeltraining.

- Anthropic: Anthropic belooft met Claude expliciet geen bedrijfsdata te gebruiken voor modeltraining, en positioneert zich als betrouwbare AI-partner gericht op veiligheid en klantcontrole.

Deze voorbeelden illustreren dat bedrijven steeds vaker garanties eisen voor duidelijke AI privacy policies. AI-leveranciers die geen helder beleid bieden, verliezen terrein aan concurrenten die transparantie en vertrouwen centraal stellen.

Waarom ‘Geen Training op Jouw Data’ Vertrouwen in AI Opbouwt

De sleutel tot succesvolle AI-adoptie is vertrouwen. Bedrijven implementeren AI pas grootschalig als zij zeker weten dat hun data zorgvuldig wordt behandeld. Uit het PwC AI-agent onderzoek 2025 blijkt dat 28% van de zakelijke leiders een gebrek aan vertrouwen in AI als grootste belemmering voor implementatie ziet. Zonder duidelijke afspraken, zoals een geen-trainingsbeleid, blijven bedrijven terughoudend. Een geen-trainingsbeleid is dus cruciaal voor het bouwen van vertrouwen, met heldere grenzen tussen klantdata en modelontwikkeling.

- Klanten geruststellen: Klanten krijgen de zekerheid dat hun data nooit wordt gebruikt voor modeltraining waarvan concurrenten kunnen profiteren.

- Transparantie bieden: Transparantie over datagebruik vormt de basis van vertrouwen, maakt compliance eenvoudiger en versterkt samenwerking.

- Adoptie versnellen: Als het beleid helder en strikt is, durven bedrijven AI toe te passen in kernprocessen.

Geen training op jouw data is niet alleen beleid, maar een concurrentievoordeel. Met een dergelijk beleid tonen bedrijven hun betrouwbaarheid en stimuleren zij veilige opschaling van AI-integraties.

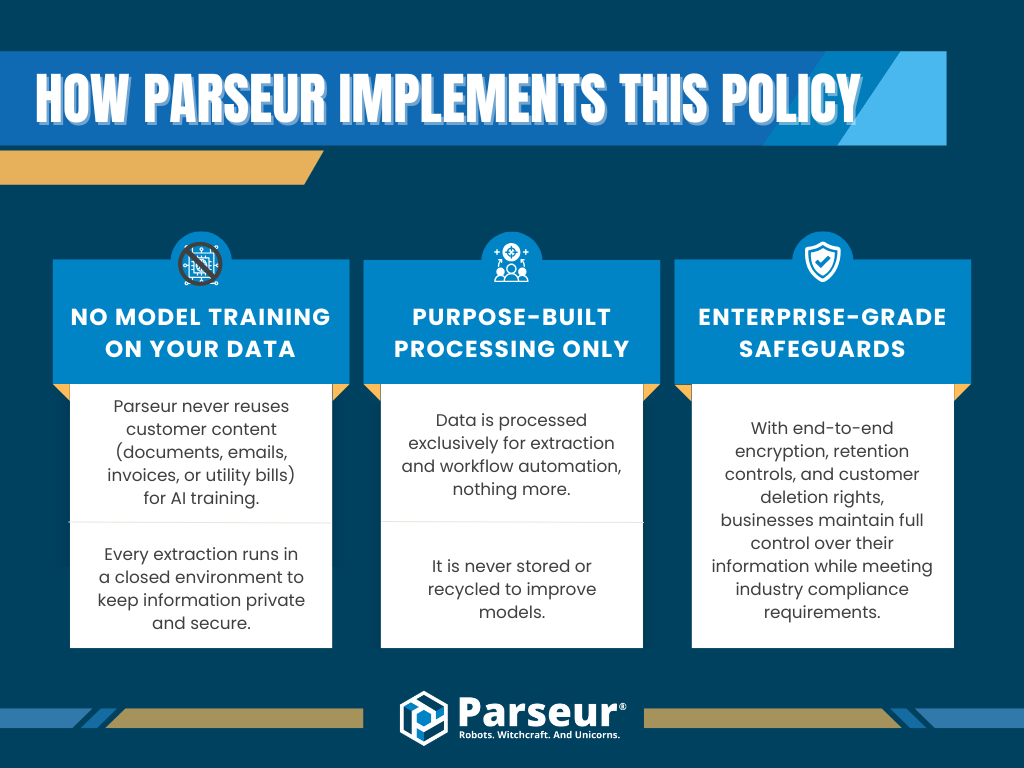

Hoe Parseur Dit Beleid Implementeert

Bij Parseur staan privacy en compliance centraal. Wij begrijpen dat bedrijven aarzelen over AI-tools wanneer onduidelijk is wat er met data gebeurt. Parseur hanteert daarom: jouw data blijft van jou, en wordt nooit gebruikt voor het trainen van AI-modellen.

In de praktijk betekent dit:

- Nooit modeltraining op jouw data: Parseur gebruikt klantinhoud (zoals documenten, e-mails, facturen of rekeninggegevens) niet om AI-modellen te trainen. Elke extractie gebeurt in een gesloten, beveiligde omgeving.

- Doelgerichte verwerking: Data wordt alleen benut voor extractie en workflowautomatisering, niet bewaard of gebruikt om modellen te verbeteren.

- Enterprise-zekerheid: End-to-end encryptie, bewaarbeleid en een verwijderrecht garanderen volledige controle en compliance.

Met een strikt geen-trainingsbeleid blijft klantdata écht beschermd en groeit het vertrouwen in AI-automatisering. Organisaties kunnen zonder zorgen opschalen, zonder risico op datalekken, verlies van eigendom of compliance-problemen.

Dankzij transparantie, governance en sterke beveiliging kunnen bedrijven met Parseur automatiseren, met privacy als topprioriteit.

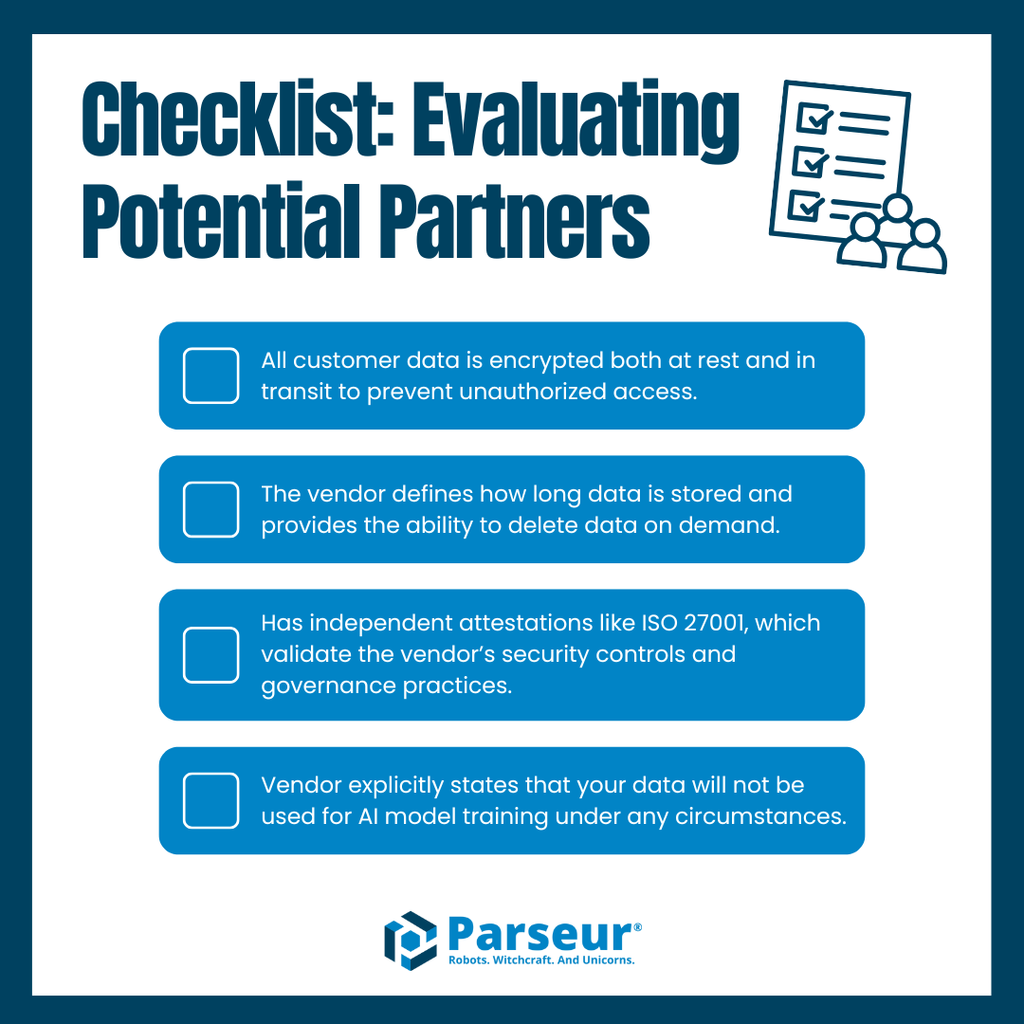

Best Practices Voor het Evalueren van Leveranciers

Het kiezen van een AI- of automatiseringsleverancier vraagt om meer dan functievergelijking. Essentieel is dat de datapraktijk van de leverancier aansluit op security, compliance en governance-eisen. Zonder heldere afspraken lopen bedrijven risico op datalekken of overtredingen.

Gebruik onderstaande checklist voor de keuze van een partner:

- Data-encryptie: Zorg dat data altijd versleuteld is, zowel in opslag als tijdens verzending.

- Retentiebeleid: Kijk of bewaartermijnen duidelijk zijn en data direct verwijderd kan worden.

- Compliance-certificaten: Zoek naar onafhankelijke bewijzen zoals ISO 27001.

- Geen-trainingsbelofte: Eis bevestiging dat jouw data niet voor AI-training wordt gebruikt.

Als er onduidelijkheden zijn over deze punten, vergroot dat het risico op compliance-problemen en privacyschending. Leveranciers die dit wel waarmaken, vormen een solide basis voor samenwerking.

Parseur blinkt hierin uit: met standaard encryptie, transparant bewaarbeleid, erkende compliance en een strikt geen-trainingsbeleid weten bedrijven zeker dat hun data veilig is. Parseur zet op alle vlakken de juiste standaarden.

Waarom Vertrouwen De Toekomst van Automatisering Bepaalt

Vertrouwen is cruciaal bij het selecteren van automatiserings- en datadiensten. Bedrijven verwerken steeds gevoeligere informatie en willen maximale zekerheid over de bescherming daarvan. Dit vertrouwen draait om één heldere afspraak: geen training op jouw data.

In de toekomst zal de nadruk op transparantie en verantwoordelijkheid rondom data alleen maar toenemen. Branche-experts verwachten dat leveranciers binnenkort standaard eisen tegenkomen op het gebied van bewaarbeleid, encryptie, compliance-certificaten en uitgesproken beloftes dat klantdata niet voor modeltraining wordt hergebruikt. Bedrijven die hierin nalaten, verliezen aan geloofwaardigheid op een markt waar governance en databeveiliging essentieel zijn.

Parseur is klaar voor deze toekomst. Met encryptie op enterpriseniveau, strikt bewaarbeleid, erkende compliance-processen en een uitgesproken geen-trainingsbeleid kunnen bedrijven grootschalig automatiseren zonder concessies op security of privacy.

Ontdek hoe Parseur jouw data beschermt met beveiliging op enterpriseniveau en een strikt geen-trainingsbeleid, zodat jouw bedrijf veilig en transparant kan automatiseren.

Veelgestelde Vragen

Terwijl bedrijven automatisering en data-extractie tools verkennen, ontstaan er vaak vragen over databeveiliging, compliance en werkwijzen van leveranciers. Hier vind jij de meest gestelde vragen van ondernemingen over het geen-trainingsbeleid en hoe dit bijdraagt aan vertrouwen in automatisering.

-

Wat betekent “geen training op jouw data”?

-

Dit beleid zorgt ervoor dat jouw data nooit opnieuw wordt gebruikt om machine learning modellen of AI-systemen te trainen. Leveranciers met dit beleid verwerken jouw informatie alleen voor het beoogde doel, zodat het privé en veilig blijft.

-

Waarom is een geen-trainingsbeleid belangrijk voor bedrijven?

-

Een strikt geen-trainingsbeleid vermindert het risico op datalekken, niet-naleving en misbruik van intellectueel eigendom. Dit maakt het een topvereiste voor bedrijven die automatiseringsleveranciers evalueren.

-

Hoe beschermt Parseur mijn data?

-

Parseur hanteert beveiliging op enterpriseniveau met encryptie, bewaarbeleid, compliance en een strikt geen-trainingsbeleid, zodat jouw informatie nooit hergebruikt wordt.

-

Zijn geen-trainingsbeleid gekoppeld aan compliance-regels?

-

Ja. Standaarden zoals GDPR en ISO 27001 leggen nadruk op dataminimalisatie en doelbeperking. Een geen-trainingsbeleid sluit hier direct bij aan en helpt organisaties compliant te blijven.

-

Zullen meer leveranciers in de toekomst geen-trainingsbeleid overnemen?

-

Branche-experts voorspellen dat geen-trainingsbeleid de norm zal worden, omdat bedrijven steeds meer transparantie, compliance en sterkere data governance eisen.

Laatst bijgewerkt op