Co Oznacza „Brak Trenowania Na Twoich Danych”?

W swojej istocie, fraza „brak trenowania na twoich danych” oznacza zobowiązanie dostawcy AI, że informacje przekazane przez użytkownika nie będą używane w celu ulepszania ani ponownego trenowania modeli uczenia maszynowego.

Kluczowe Wnioski

- „Brak trenowania na twoich danych” to gwarancja, że Twoje dane są tylko przetwarzane, a nie wykorzystywane do trenowania sztucznej inteligencji.

- Polityka ta chroni zaufanie, zgodność i własność intelektualną przedsiębiorstw.

- Parseur oferuje szyfrowanie, kontrolę retencji, zgodność oraz ścisłe domyślne przestrzeganie tej polityki.

Firmy wdrażające narzędzia AI oczekują, że ich wrażliwe dane biznesowe nie zostaną nadużyte, ujawnione ani użyte w sposób, na który nie wyraziły zgody.

Te obawy podzielają także konsumenci: około 70% dorosłych nie ufa firmom w zakresie odpowiedzialnego korzystania z AI, a ponad 80% spodziewa się, że ich dane mogą zostać nadużyte, według Protecto – co oznacza, że utrata reputacji w przypadku nieprawidłowego zarządzania danymi może być równie dotkliwa jak kary regulacyjne.

W ostatnich latach czołowi dostawcy AI, tacy jak OpenAI, Anthropic i Microsoft, byli pod lupą pod kątem tego, jak wykorzystują dane swoich klientów. Kluczowe pytanie brzmi: czy dane przekazywane tym platformom służą tylko do wykonania zadania — czy także do budowania bazy dla dalszego trenowania modeli?

Z tego powodu „brak trenowania na twoich danych” stał się nowym standardem transparentności i zaufania. To zobowiązanie, że dane klienta wykorzystywane są wyłącznie do realizacji zamówionych operacji i nigdy nie wchodzą w skład zbiorów treningowych modeli AI. Dla przedsiębiorstw taka gwarancja to fundament zaufania, zgodności i długofalowej adopcji rozwiązań AI.

W tym artykule wyjaśniamy, czym w praktyce jest polityka braku trenowania, jakie niesie korzyści w zakresie zgodności i zarządzania danymi firmowymi, jak interpretują ją główni dostawcy oraz w jaki sposób Parseur wdraża tę politykę, budując zaufanie i bezpieczeństwo AI.

Co Oznacza „Brak Trenowania Na Twoich Danych”?

Twoje dane są wykorzystywane wyłącznie do realizacji Twojego zlecenia — niezależnie, czy chodzi o podsumowanie dokumentu, ekstrakcję pól, generowanie treści czy analizę wzorców. Po zakończonym zadaniu dane są usuwane lub bezpiecznie przechowywane zgodnie z polityką firmy.

Oto kluczowa różnica:

- Przetwarzanie: Twoje dane są używane w czasie rzeczywistym wyłącznie do realizacji konkretnego zadania, np. generowania raportu lub wydobycia danych z dokumentu. Po wykonaniu usługi nie wracają do algorytmów AI w celu dalszego trenowania.

- Trenowanie: Dane są wykorzystywane do ulepszania lub rozwijania modelu. Informacje użytkownika mogą wtedy trwale wchłonąć się do wiedzy modelu, niosąc podwyższone ryzyko ponownej ekspozycji poufnych treści.

Wiele dużych firm wcześniej rozmywało te granice, używając danych klientów zarówno do realizacji usług, jak i uczenia modeli. Tego typu praktyki wprawdzie napędzały innowacje, ale rodziły poważne ryzyka:

- Ryzyko ujawnienia poufnych informacji: Wrażliwe dane firmowe czy informacje osobiste mogą zostać przypadkowo odtworzone lub wycieknięte.

- Zagadnienia dotyczące własności danych: Jeśli dane klienta trenują model AI, pojawia się pytanie o naruszenie praw własności intelektualnej.

- Wyzwania zgodności: W sektorach regulowanych brak wyraźnej zgody na ponowne użycie danych klientów jest niedopuszczalny.

Polityka braku trenowania eliminuje te wątpliwości. Dane są wykorzystywane tylko do ustalonego zadania; nie są używane przy trenowaniu modeli, nie są przekazywane podmiotom trzecim ani wplątywane w zakulisowe procesy. W ten sposób wzmacnia się bezpieczeństwo, spełniane są normy zgodności, a relacje na linii firma-dostawca AI oparte są na zaufaniu.

Podsumowując, „brak trenowania na twoich danych” oznacza, że dane pozostają pod Twoją kontrolą – prywatne, dobrze chronione i przetwarzane dokładnie na Twoich zasadach.

Dlaczego Polityka Trenowania Danych Ma Znaczenie Dla Firm

Polityka prywatności danych AI to nie kolejny dodatek, lecz fundament, który decyduje o tym, czy cenne informacje pozostają bezpieczne, czy staną się ukrytym ryzykiem. Bez niej firmy mogą utracić kontrolę nad własnymi danymi, narażając się na wysokie kary, utratę przewagi i reputacji.

Ryzyka związane z wykorzystaniem danych do trenowania

- Ryzyko utraty własności intelektualnej: Dokumenty wewnętrzne, poufne umowy czy wyniki badań mogą trafić do zbiorów treningowych modelu i osłabić unikalność przewagi firmy.

- Ryzyko naruszeń zgodności: Normy takie jak RODO czy CCPA jednoznacznie limitują powtórne przetwarzanie danych osobowych. Ponowne wykorzystanie tych informacji bez zgody grozi poważnymi sankcjami.

- Utrata przewagi konkurencyjnej: Jeżeli dane klienta trenują ogólnodostępny model, konkurencja może pośrednio zyskać dostęp do know-how, które pierwotnie było zastrzeżone.

Czego szukają przedsiębiorstwa wdrażające AI

Kupujący narzędzia AI zwracają uwagę nie tylko na wydajność, ale przede wszystkim na politykę prywatności danych. Według badania The Futurum Group z 2025 roku, 52% firm najbardziej ceni wiedzę techniczną dostawców AI, a tuż za nią (51%) plasuje się polityka dotycząca danych i prywatności. Jasna polityka braku trenowania pozwala:

- Zachować kontrolę nad własnością danych: Pewność, że know-how, wrażliwe procesy i dane nie trafią poza firmę.

- Wzmacniać zgodność z normami: Ułatwia audyty, redukuje ryzyko naruszeń i wspiera branże regulowane.

- Budować zaufanie i przejrzystość: Otwarte deklaracje eliminują wątpliwości dotyczące zarządzania danymi i wzmacniają współpracę.

Firmy coraz częściej traktują restrykcyjne zasady dotyczące trenowania danych jako warunek niezbędny do wdrażania automatyzacji i AI. Dostawcy oferujący politykę braku trenowania dają firmom przestrzeń do innowacji bez kompromisów.

Perspektywa Zgodności i Zarządzania

W rozwoju AI decydujące znaczenie mają dziś nie tylko koszty i efektywność, lecz także zgodność z rygorystycznymi normami bezpieczeństwa oraz zarządzania danymi — zwłaszcza w sektorach o wysokiej wrażliwości informacji. Standardy branżowe takie jak ISO 27001, RODO, czy normy sektora finansowego i medycznego wymagają najwyższej ochrony. Zgodnie z 2025 Investment Management Compliance Testing Survey, 57% przedstawicieli compliance uznaje wdrażanie AI za główny obszar ryzyka, podkreślając potrzebę dopasowania się do standardów, takich jak ISO 27001, RODO i norm sektorowych.

Polityka braku trenowania umożliwia osiągnięcie zgodności poprzez:

- Minimalizację gromadzonych danych: Przetwarzanie wyłącznie tego, co niezbędne.

- Wyraźną zgodę i kontrolę: Brak ponownego użycia danych bez zgody właściciela.

- Ograniczenie celu: Dane są wykorzystywane wyłącznie w celu realizacji zleconej usługi.

Takie postępowanie upraszcza audyty i pozwala lepiej zabezpieczać się przed karami za możliwe naruszenia przepisów.

Ponadto, zgodność to także standardyzacja i transparentność. Organizacje pokroju Electronic Commerce Code Management Association (ECCMA) promują zaufanie do danych poprzez dobre praktyki – polityka braku trenowania pokrywa się z tymi oczekiwaniami, wzmacniając etyczne podejście do automatyzacji.

Decydując się na współpracę z dostawcami, którzy wdrażają zaawansowane zasady zarządzania danymi i ochrony prywatności, organizacje podnoszą swoją odporność, bezpieczeństwo i wiarygodność.

Przykłady Branżowe: Jak Big Tech Podchodzi Do Trenowania Danych

Rosnące oczekiwania rynku wymuszają na gigantach technologicznych standaryzację podejścia do trenowania danych:

- OpenAI: W ChatGPT dane z wersji darmowych i konsumenckich mogą zasilać rozwój modeli, ale użytkownicy korporacyjni mogą wyraźnie z tego zrezygnować – ich dane i konwersacje nie są wykorzystywane do trenowania. To pokazuje wyraźne rozgraniczenie pomiędzy ofertą konsumencką a biznesową.

- Microsoft: W Copilot for Microsoft 365 oraz Azure OpenAI Service firma zapewnia ścisłą izolację danych – informacje klientów przedsiębiorstw nie są w ogóle używane do rozwoju modeli, więc dokumenty i komunikacja są bezpieczne.

- Anthropic: Claude od Anthropica zobowiązuje się do braku trenowania na danych przedsiębiorstw, dzięki czemu klienci mogą polegać na bezpieczeństwie, transparentności i ochronie informacji.

Przykłady te wyraźnie potwierdzają, że rynek wymusza coraz bardziej rygorystyczną politykę ochrony danych w AI. Dostawcy, którzy nie są w stanie jej zapewnić, tracą zaufanie i klientów na rzecz bardziej transparentnych konkurentów.

Dlaczego „Brak Trenowania na Twoich Danych” Buduje Zaufanie Do AI

Zaufanie jest fundamentem skutecznego wdrożenia AI. Przedsiębiorstwa uruchomią automatyzację i podejmą decyzje transformujące działalność tylko wtedy, gdy mają pewność, że ich dane są przetwarzane odpowiedzialnie. Ankieta PwC 2025 dotycząca agentów AI wykazała, że 28% liderów biznesu wskazuje brak zaufania do AI jako główną barierę adopcji. Bez jasnej, restrykcyjnej polityki – jak brak trenowania – przedsiębiorstwa postrzegają korzystanie z AI jako ryzykowne. Polityka ta daje:

- Gwarancję bezpieczeństwa danych: Firmy wiedzą, że strategiczne informacje i własność intelektualna nie trafią do modeli, które potencjalnie mogliby wykorzystywać konkurenci. Brak trenowania to fundament ochrony przed niekontrolowanym wyciekiem wiedzy.

- Pełną przejrzystość: Otwarta polityka oddzielająca dane klienta od zbioru treningowego modelu eliminuje niejasności, ułatwia kontrolę i audytowanie.

- Wzmacnia wdrożenia AI: Jasne deklaracje zaufania powodują, że firmy chętniej wdrażają automatyzację nawet w obszarach krytycznych — zwyczajnie nie obawiają się już, jak ich dane zostaną wykorzystane.

Brak trenowania na twoich danych to przewaga konkurencyjna, nie tylko deklaracja. Firmy wdrażające taką politykę dają wyraźny sygnał: szanujemy Twoje dane, możesz innowować bez obaw o bezpieczeństwo.

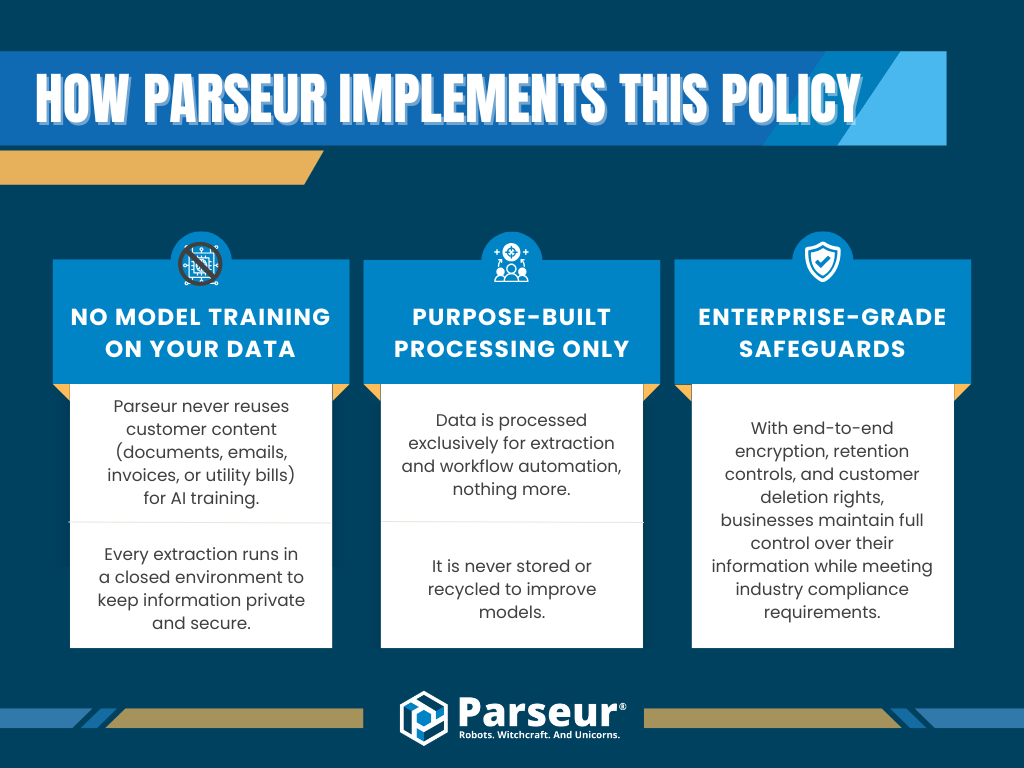

Jak Parseur Wdraża Tę Politykę

W Parseur ochrona prywatności i zgodność to podstawy. Rozumiemy, że przed wdrożeniem AI wiele firm obawia się o los swoich danych. Parseur przyjmuje jasne zobowiązanie: Twoje dane są Twoje i nigdy nie będą użyte do trenowania AI.

To oznacza:

- Zero trenowania modeli na danych klientów: Parseur nie używa treści przesyłanych przez klientów – e-maili, dokumentów, faktur – do trenowania swoich modeli AI. Ekstrakcja odbywa się w zamkniętym, bezpiecznym systemie.

- Wyłącznie przetwarzanie pod wyraźne zlecenie: Dane są przetwarzane wyłącznie w celu wykonywania żądanych operacji – nigdy nie są ponownie wykorzystywane poza wyznaczonym kontekstem i nie trafiają do repozytoriów modele.

- Najwyższy poziom zabezpieczeń: Szyfrowanie, kontrola retencji oraz możliwość usunięcia danych zapewniają pełną kontrolę nad informacjami, spełniając najnowsze standardy compliance.

Taka polityka minimalizuje ryzyko wycieków, utraty własności intelektualnej i naruszenia zasad ochrony danych. Przez przejrzystość, silne zarządzanie i nowoczesne zabezpieczenia Parseur pozwala organizacjom rozwijać automatyzację bez obawy o swoje informacje.

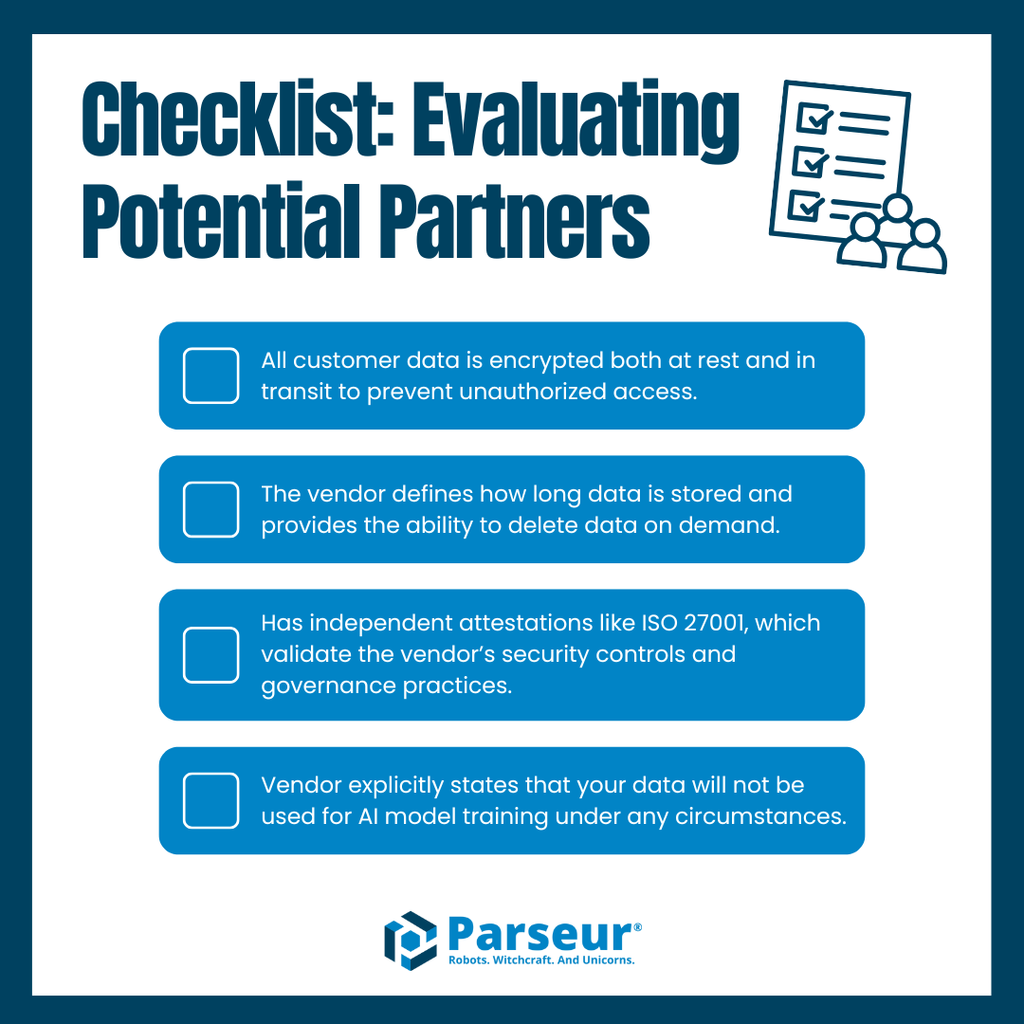

Najlepsze Praktyki Weryfikacji Dostawców

Wybierając dostawcę narzędzi AI, firmy muszą priorytetowo traktować jego praktyki dotyczące bezpieczeństwa, zgodności i zarządzania danymi. Brak przejrzystych reguł grozi utratą kontroli, kompromitacją lub łamaniem przepisów.

Co sprawdzić przed wyborem partnera:

- Szyfrowanie danych: Wszystkie dane przesyłane i przechowywane powinny być zawsze szyfrowane, aby zapobiegać nieautoryzowanemu dostępowi.

- Polityka retencji: Jasno opisana retencja — jak długo dane są przechowywane i jak można je usunąć na żądanie użytkownika.

- Certyfikacje zgodności: Warto szukać uznanych atestacji, jak ISO 27001, potwierdzających wysokie standardy zarządzania informacjami.

- Wyraźna polityka braku trenowania: Upewnij się, że dostawca deklaruje brak użycia danych klientów do trenowania modeli AI – i to we wszystkich okolicznościach.

Dostawcy niejasno podchodzący do tych zagadnień mogą narazić firmę na luki zgodności i ryzyka prywatności. Pełna transparentność oraz zgodność z najlepszymi praktykami budują pewność i partnerskie zaufanie.

To odróżnia Parseur na rynku. Domyślne szyfrowanie, jasne zasady retencji, znane certyfikaty oraz ścisła polityka braku trenowania danych — rozwiązanie, które umożliwia bezpieczną automatyzację dla nowoczesnych przedsiębiorstw.

Dlaczego Zaufanie Definiuje Przyszłość Automatyzacji

Zaufanie jest kluczowe dla rozwoju automatyzacji i zaawansowanego przetwarzania danych. Przy obsłudze coraz bardziej poufnych informacji firmy muszą mieć pewność, że dostawcy dbają o nie na najwyższym poziomie. Fundamentalną zasadą, która to umożliwia, jest brak trenowania na twoich danych.

W kolejnych latach firmy będą jeszcze bardziej przykładać wagę do transparentności i odpowiedzialnego zarządzania danymi. Eksperci przewidują, że standardem staną się wymagania dotyczące jasnych zasad retencji, szyfrowania domyślnego, certyfikatów zgodności i pisemnych deklaracji braku użycia danych do trenowania modeli. Dostawcy, którzy nie spełnią tych oczekiwań, szybko stracą zaufanie na rynku, gdzie bezpieczeństwo i etyka stanowią podstawę.

Parseur jest gotowy na tę przyszłość. Dzięki wdrożonym rozwiązaniom klasy korporacyjnej, precyzyjnej polityce retencji, uznanym standardom i ścisłej polityce braku trenowania, Parseur pozwala firmom rozwijać automatyzację na dużą skalę bez kompromisów dotyczących bezpieczeństwa oraz prywatności.

Dowiedz się, jak Parseur chroni Twoje dane dzięki najwyższym standardom i jednoznacznemu zobowiązaniu do braku trenowania, zapewniając pełne bezpieczeństwo i przejrzystość w automatyzacji workflow.

Najczęściej Zadawane Pytania

W miarę jak firmy eksplorują automatyzację i narzędzia do ekstrakcji danych, często pojawiają się pytania dotyczące bezpieczeństwa danych, zgodności i praktyk dostawców. Oto najczęstsze pytania przedsiębiorstw o politykę braku trenowania i jej wpływ na zaufanie do automatyzacji.

-

Co oznacza „brak trenowania na twoich danych”?

-

Ta polityka gwarantuje, że Twoje dane nigdy nie zostaną wykorzystane do trenowania modeli uczenia maszynowego ani systemów AI. Dostawcy z tą polityką przetwarzają Twoje informacje wyłącznie w wyznaczonym celu, zapewniając ich prywatność i bezpieczeństwo.

-

Dlaczego polityka braku trenowania jest ważna dla przedsiębiorstw?

-

Ścisła polityka braku trenowania minimalizuje ryzyko wycieku danych, naruszeń zgodności i niewłaściwego wykorzystania własności intelektualnej, co czyni ją priorytetem dla firm szukających rozwiązań automatyzujących.

-

Jak Parseur chroni moje dane?

-

Parseur stosuje zabezpieczenia klasy korporacyjnej dzięki szyfrowaniu, kontroli retencji, zgodności ze standardami oraz ścisłemu zobowiązaniu do braku trenowania, dzięki czemu Twoje informacje nigdy nie będą użyte w innym celu.

-

Czy polityki braku trenowania są powiązane z regulacjami zgodności?

-

Tak. Standardy takie jak RODO czy ISO 27001 kładą nacisk na minimalizację danych i ograniczenie celów przetwarzania. Polityka braku trenowania wpisuje się w te zasady, pomagając organizacjom zachować zgodność.

-

Czy więcej dostawców wdroży polityki braku trenowania w przyszłości?

-

Eksperci branżowi przewidują, że polityka braku trenowania stanie się normą, gdyż klienci korporacyjni coraz częściej wymagają przejrzystości, zgodności i silniejszego zarządzania danymi.

Ostatnia aktualizacja