Was bedeutet „Kein Training mit Ihren Daten“?

Im Kern verspricht die Aussage „kein Training mit Ihren Daten“, dass die Informationen, die Sie mit diesen Systemen teilen, niemals für die Weiterentwicklung oder das Training maschineller Lernmodelle verwendet werden.

Das Wichtigste auf einen Blick

- Kein Training mit Ihren Daten garantiert, dass Ihre Informationen zwar verarbeitet, aber nicht für das Training von KI-Modellen genutzt werden.

- Für Vertrauen, Compliance und den Schutz geistigen Eigentums ist diese Richtlinie für Unternehmen unverzichtbar.

- Parseur setzt standardmäßig auf Verschlüsselung, Aufbewahrungskontrollen, Compliance und eine strikte No-Training-Richtlinie.

Unternehmen, die KI-Lösungen einsetzen, wollen sicherstellen, dass ihre sensiblen Geschäftsdaten nicht missbraucht, weitergegeben oder für nicht vereinbarte Zwecke verwendet werden.

Diese Sorgen betreffen auch den Endkundenbereich: Etwa 70 % der Erwachsenen vertrauen Unternehmen nicht, dass sie KI verantwortungsbewusst einsetzen, und über 80 % rechnen damit, dass ihre Daten falsch verwendet werden, wie Protecto berichtet. Ein Imageschaden durch unsachgemäßen Umgang kann daher sogar bedrohlicher sein als regulatorische Strafen.

Große KI-Anbieter wie OpenAI, Anthropic oder Microsoft stehen zunehmend unter Beobachtung bezüglich der Nutzung von Kundendaten. Die zentrale Frage: Verarbeitet die Plattform vertrauliche Daten ausschließlich zur Ergebnisgenerierung – oder fließen diese auch ins Training ein?

Daher hat sich „kein Training mit Ihren Daten“ rasant als neuer Standard und Grundvoraussetzung für KI-Vertrauen etabliert. Diese Zusicherung bedeutet, dass die Daten von Unternehmenskunden nur für den jeweiligen Auftrag zum Einsatz kommen – aber niemals zur Weiterentwicklung der Modelle. Für Unternehmen bildet diese Richtlinie den Grundstein für Vertrauen, Compliance und die nachhaltige Einführung von KI-Lösungen.

Lesen Sie hier, was „kein Training mit Ihren Daten“ im Alltag tatsächlich bedeutet, warum es für Compliance und Governance unerlässlich ist, wie große Anbieter damit umgehen und wie Parseur diese Richtlinie umsetzt – für maximalen Datenschutz und KI-Vertrauen.

Was bedeutet „Kein Training mit Ihren Daten“ konkret?

Ihre Daten werden ausschließlich verwendet, um Ihre individuelle Anfrage zu erfüllen – zum Beispiel für die Dokumentenzusammenfassung, Feldauslese, Texterstellung oder die Analyse von Mustern. Nach Abschluss der Bearbeitung werden sie – je nach Ihrer Vorgabe – gelöscht oder sicher gespeichert.

Der Unterschied zwischen Verarbeitung und Training:

- Verarbeitung: Ihre Daten dienen Ihrem Auftrag, z.B. bei der Berichterstellung oder Rechnungsprüfung. Anschließend verlassen sie den Systemkontext, ohne im Modell zu landen.

- Training: Ihre Daten werden verwendet, um das KI-Modell selbst weiterzuentwickeln. Im schlimmsten Fall werden dabei sensible Informationen Teil des Modell-Wissens und könnten in Zukunft wieder ausgegeben werden.

Viele größere KI-Dienste verwischten diese Grenze: Kundeneingaben wurden oft zur Bearbeitung und für das Training genutzt. Dies spielte der technologischen Entwicklung in die Karten, eröffnete aber gravierende Risiken:

- Verletzung der Vertraulichkeit: Geschäftsgeheimnisse, vertrauliche Finanzdaten oder Kundendaten könnten versehentlich zugänglich oder nachvollziehbar werden.

- Unklarheit beim Datenbesitz: Wer das KI-Modell trainiert, könnte an geistigem Eigentum einbüßen.

- Compliance-Problem: Besonders Branchen wie Gesundheitswesen, Finanzen und Recht dürfen keine Kundendaten ohne klare Einwilligung für Trainingszwecke weiterverwenden lassen.

Eine No-Training-Richtlinie nimmt diese Risiken vom Tisch. Ihre Informationen werden nur für den konkreten Auftrag genutzt: Kein Training, keine Weitergabe, keine versteckte Nachnutzung. So wird nicht nur der Datenschutz gestärkt – sondern auch Compliance und das Vertrauen zwischen Unternehmen und Anbietern der Künstlichen Intelligenz.

Fazit: „Kein Training mit Ihren Daten“ sichert, dass Ihre Daten privat, geschützt und vollständig unter Ihrer Kontrolle bleiben.

Warum sind Training-Richtlinien für Unternehmen so wichtig?

Eine KI-Datenschutzrichtlinie ist für Unternehmen nicht optional, sondern die Voraussetzung, damit vertrauliche Informationen kein unerwünschtes Haftungs- oder Compliance-Risiko bergen. Ohne klare Regeln besteht die Gefahr von Kontrollverlust, Bußgeldern, Imageschäden oder Wettbewerbseinbußen.

Risiken bei Training mit Ihren Daten

- Verlust geistigen Eigentums: Interne Prozesse, Verträge oder Forschungserkenntnisse könnten unbeabsichtigt Teil eines KI-Datensets werden – und somit ihren geschützten Status verlieren.

- Compliance-Verletzungen: Datenschutzgesetze wie DSGVO oder CCPA fordern ausdrücklich den Schutz von personenbezogenen sowie sensiblen Daten. Werden diese ohne Einwilligung für Trainingszwecke genutzt, drohen hohe Sanktionen.

- Wettbewerbsverluste: Profitieren andere von einem durch Ihre Daten verbesserten Modell, schwindet Ihr Vorsprung.

Warum legen Unternehmenskunden so großen Wert darauf?

Unternehmenskunden prüfen KI-Anbieter heute nicht nur auf deren Technologie, sondern zunehmend auch auf die KI-Datenrichtlinien. Eine Futurum Group-Umfrage aus 2025 zeigt: 52 % der Unternehmen wählen Anbieter nach fachlicher Kompetenz – doch 51 % fordern explizit auch Datenschutzkontrolle und Sicherheit. Anbieter, die eine No-Training-Richtlinie gewährleisten, signalisieren:

- Wahrung des Eigentums: Die Kontrolle über eigene Daten bleibt beim Kunden.

- Compliance-Sicherheit: Das Haftungsrisiko sinkt und Audits sind leichter durchführbar.

- Vertrauen & Transparenz: Durch klare Ausschlüsse in der Datenverwendung werden langfristige Beziehungen gestärkt.

Datentrainings-Richtlinien sind so zum entscheidenden Faktor für KI-Projekte geworden. Mit einem Anbieter, der konsequent auf „kein Training mit Ihren Daten“ setzt, können Unternehmen Innovationen sicher, regelkonform und mit einem guten Gefühl realisieren.

Die Compliance- und Governance-Perspektive

Für Unternehmen ist KI nicht allein ein Effizienzprojekt, sondern auch ein Compliance- und Governance-Thema. Standards wie ISO 27001, DSGVO oder branchenspezifische Normen in Medizin, Finanzen oder Recht verlangen höchste Sorgfalt bei der Datenverarbeitung. Laut 2025 Investment Management Compliance Testing Survey betrachten 57 % der Compliance-Verantwortlichen KI-Nutzung als größtes Regulierungsrisiko.

Eine No-Training-Richtlinie unterstützt die Einhaltung dieser Rahmenwerke direkt, indem sie sich an zentrale Prinzipien hält:

- Datenminimierung: Nur relevante Daten werden verwendet, um die Angriffsfläche zu verringern.

- Einwilligung & Kontrolle: Es findet keine Nutzung ohne ausdrückliche Zustimmung statt.

- Zweckbindung: Die Daten werden nie für andere Zwecke – etwa Training – eingesetzt.

Mit diesen Best Practices helfen moderne KI-Anbieter, Compliance-Anforderungen problemlos zu erfüllen – und Sanktionen abzuwenden.

Gleichzeitig wünschen sich Unternehmen durchgängige Standardisierung und Transparenz. Organisationen wie die Electronic Commerce Code Management Association (ECCMA) setzen sich für einheitliche Datenqualität und Vertrauen ein. Eine No-Training-Richtlinie trägt diesen Werten Rechnung – durch Nachvollziehbarkeit und Klarheit.

Unternehmen, die Anbieter nach diesen Maßstäben auswählen, sind nicht nur compliant, sondern schaffen ein Fundament für ethische und sichere KI-Nutzung.

Brancheneinblicke: Wie Big Tech mit KI-Training umgeht

Die Praxis großer Technologiekonzerne zeigt deutlich, welchen Stellenwert Datenrichtlinien heute haben:

- OpenAI: In den öffentlichen und Consumer-Versionen von ChatGPT können Nutzerdaten zur Modellverbesserung eingesetzt werden. Für Unternehmenskunden gibt es jedoch Opt-out-Optionen sowie die Zusicherung, dass Prompts und Ausgaben nicht für Trainingszwecke genutzt werden. Damit wird erstmals klar zwischen Consumer- und Enterprise-KI unterschieden.

- Microsoft: Bei Copilot for Microsoft 365 und im Azure OpenAI Service steht die Datenisolierung im Fokus. Unternehmensdaten werden niemals zur Verbesserung von Basismodellen genutzt – Vertraulichkeit bleibt gewahrt.

- Anthropic: Mit Claude garantiert Anthropic explizit No-Training bei Unternehmensdaten – für maximale Sicherheit und Kundenkontrolle.

Dies verdeutlicht: Der Markt verlangt nach verbindlichen KI-Datenrichtlinien. Wer diesen Standard nicht erfüllt, verliert im Wettbewerb gegen Anbieter, die auf Transparenz und Zuverlässigkeit setzen.

Warum „Kein Training mit Ihren Daten“ Vertrauen in KI schafft

Erfolgreiche KI-Projekte stehen und fallen mit Vertrauen. Unternehmen setzen Automatisierung und KI nur dann ein, wenn sie sicher sein können, dass ihre Daten geschützt und verantwortungsbewusst verarbeitet werden. Die PwC-Umfrage zu KI-Agenten 2025 zeigt, dass 28 % der Unternehmensleiter mangelndes Vertrauen in KI-Agenten als Haupthindernis für deren Einführung sehen. Ohne strenge Leitplanken wie eine No-Training-Richtlinie bleibt die Nutzung riskant. Eine solche Richtlinie ist die Basis für Vertrauen, weil sie eine klare Trennung zwischen Kundeninformation und Modellentwicklung garantiert.

- Sicheres Gefühl für Kunden: Unternehmenskunden können darauf vertrauen, dass ihre exklusiven Daten niemals zur Optimierung von Modellen verwendet werden, die auch anderen zur Verfügung stehen. Das Versprechen „kein Training mit Ihren Daten“ schützt somit sensible Strategien, Kundendaten oder Finanzwerte.

- Transparenz: Transparenz ist die Grundlage für Vertrauen in KI. Klare Regeln sichern Unternehmen die Kontrolle über vertrauliche Informationen und erleichtern die Compliance-Arbeit.

- Stärkere Akzeptanz: Vertrauen erhöht die Bereitschaft, KI auch in sensiblen Bereichen wie Finance, Recht oder Healthcare flächendeckend einzusetzen. Wer weiß, dass Daten ausschließlich für die eigene Nutzung verarbeitet werden, kann Automatisierung breit ausrollen.

„Kein Training mit Ihren Daten“ ist mehr als eine Richtlinie – es ist Ihr Wettbewerbsvorteil. Wer dieses Prinzip verfolgt, stellt das Kundenvertrauen in den Mittelpunkt und legt die Basis für zügige, sichere KI-Einführungen.

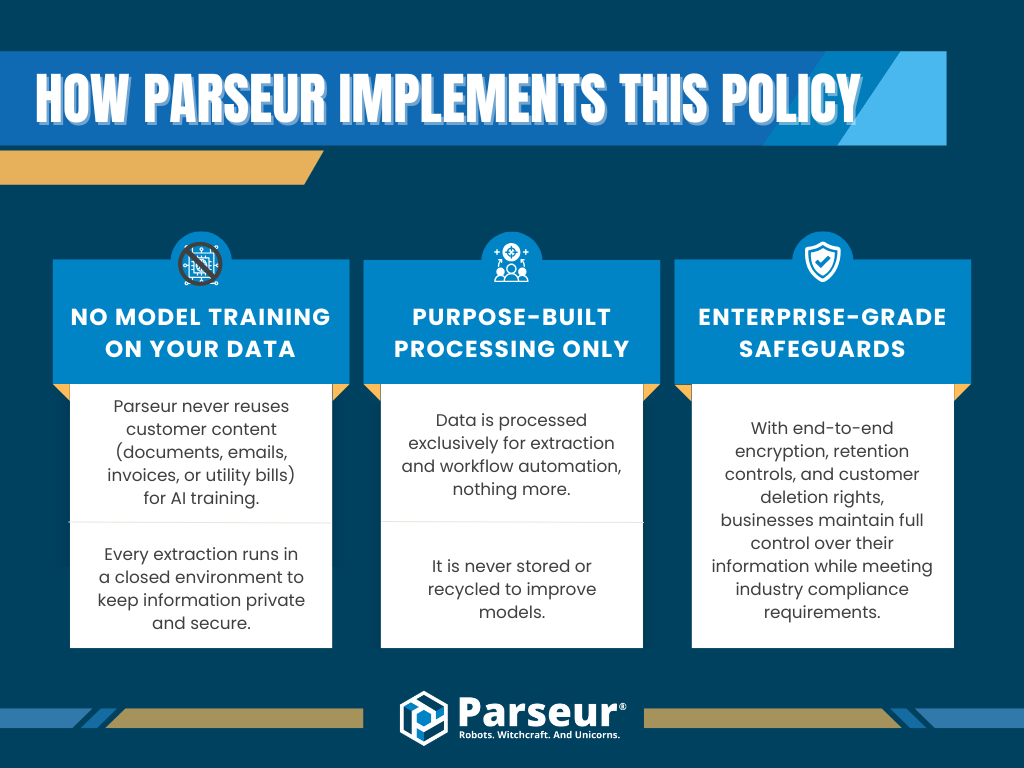

Wie Parseur diese Richtlinie konkret umsetzt

Bei Parseur steht der Datenschutz im Mittelpunkt des gesamten Plattformkonzepts. Wir wissen, dass viele Unternehmen KI-Tools skeptisch gegenüberstehen, wenn sie nicht verstehen, wie ihre Daten behandelt werden. Darum verfolgt Parseur einen klaren Ansatz: Ihre Daten gehören Ihnen – und werden niemals für das Training von KI-Modellen verwendet.

Was bedeutet das?

- Kein Training mit Ihren Daten: Parseur verwendet Ihre Dokumente, E-Mails, Rechnungen oder Abrechnungen ausschließlich für Ihren individuellen Arbeitszweck – und NIE für Modelltraining. Die Verarbeitung erfolgt in einer geschützten Umgebung, Ihre Informationen bleiben privat.

- Zweckgebundene Verarbeitung: Daten werden nur zur Extraktion oder Prozessautomatisierung genutzt. Es erfolgt weder eine Speicherung zur Trainingsnutzung noch ein "Recycling" zur Modelloptimierung.

- Unternehmenssicherer Schutz: Mit End-to-End-Verschlüsselung, klaren Aufbewahrungsregelungen und Löschrechten behalten Sie jederzeit die Kontrolle – und erfüllen alle Compliance-Anforderungen.

Dank der kompromisslosen No-Training-Richtlinie bleiben Kundendaten zu jeder Zeit geschützt. Unternehmen können die Automatisierung sicher und transparent ausbauen, ohne Risiko für Datenlecks, das geistige Eigentum oder die Regulierung.

Mit Klarheit, Governance und starken Schutzmechanismen befähigt Parseur Unternehmen, ihre Automatisierungsstrategie mit maximalem Datenschutz voranzutreiben.

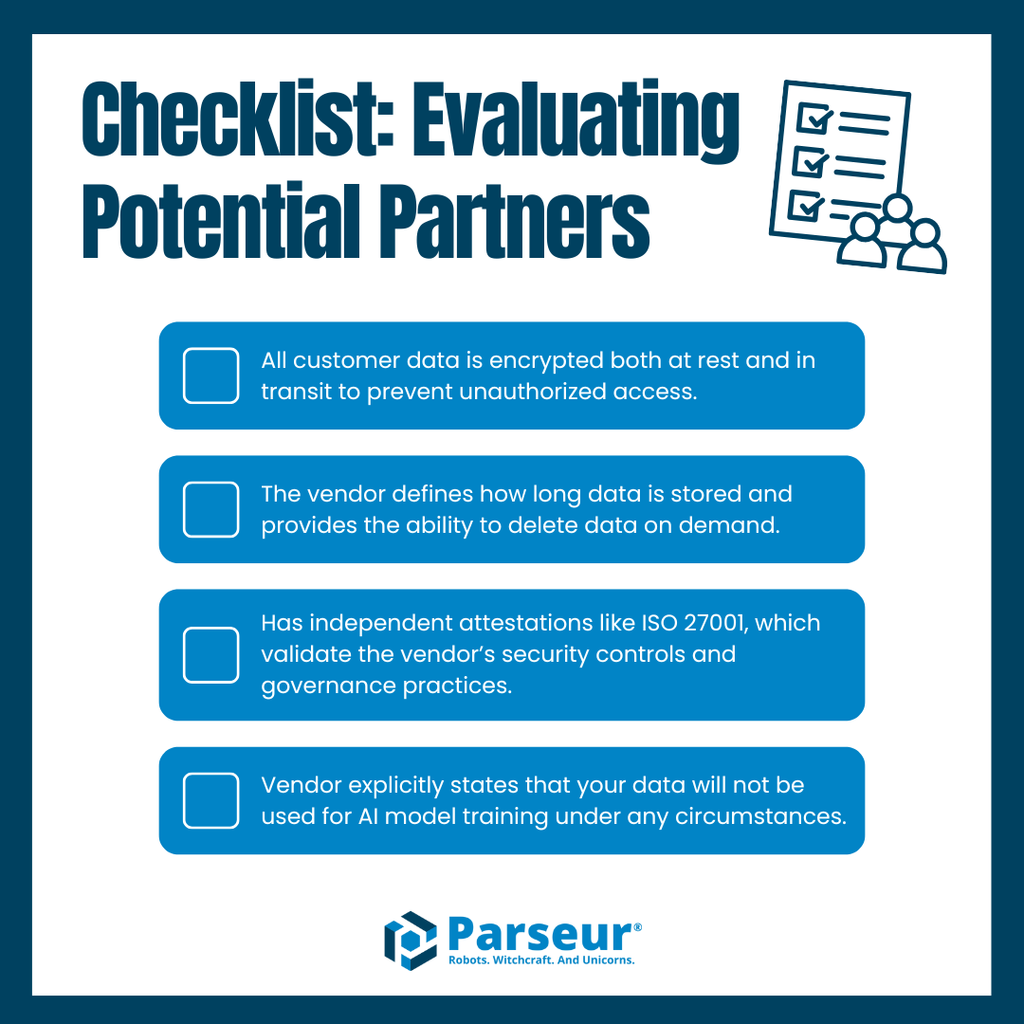

Best Practices für die Auswahl von Anbietern

Die Auswahl eines KI- oder Automatisierungsdienstleisters sollte mehr als nur auf Funktionalität oder Preis basieren. Unternehmen müssen sicherstellen, dass die Datenpraktiken des Anbieters mit eigenen Sicherheits-, Compliance- und Governance-Anforderungen übereinstimmen. Fehlen klare Vorgaben, drohen Datenverlust oder Verstöße.

Diese Checkliste hilft Ihnen bei der Anbieterauswahl:

- Verschlüsselung: Sind Ihre Daten im Ruhezustand und beim Transport wirksam geschützt?

- Aufbewahrung: Wie lange werden Ihre Daten gespeichert und besteht ein gesetzlich fundiertes Recht auf Löschung?

- Zertifizierungen: Liegen Compliance-Nachweise vor, z.B. ISO 27001?

- No-Training-Zusage: Sichert der Anbieter verbindlich zu, dass Ihre Daten nicht für KI-Modelltraining verwendet werden?

Fehlen solche Zusicherungen, riskieren Sie Compliance-Lücken und Datenschutzprobleme. Anbieter, die diese Anforderungen erfüllen, fördern nachhaltiges Vertrauen.

Parseur ist in diesem Punkt führend: Durch konsequente Verschlüsselung, transparente Datenhaltung, umfassende Compliance und eine klare No-Training-Richtlinie können Sie Automatisierung sicher und regelkonform etablieren – stets mit vollem Überblick über Ihre Daten und deren Nutzung.

Warum Vertrauen die Zukunft der Automatisierung bestimmt

Vertrauen ist der entscheidende Faktor bei der Auswahl von Automatisierungs- und Datendienstleistern. Wer mit sensiblen Daten arbeitet, benötigt die Gewissheit, dass diese verantwortungsvoll behandelt werden. Im Zentrum dieses Vertrauens steht das Prinzip „kein Training mit Ihren Daten“.

Zukünftig wird Transparenz noch wichtiger: Immer mehr Unternehmen werden ihre Anbieter gezielt nach klaren Richtlinien zu Datenspeicherung, Verschlüsselung, Compliance-Zertifikaten und vertragsbasierten Zusagen auswählen, dass Kundendaten nie für Modelltraining genutzt werden. Anbieter, die diese Anforderungen nicht erfüllen, werden an Glaubwürdigkeit verlieren – denn Governance und Datenschutz sind heute nicht verhandelbar.

Parseur ist bereit für diese Zukunft: Mit unternehmensweiter Verschlüsselung, strenger Aufbewahrungssteuerung, zertifizierter Compliance und der festen No-Training-Richtlinie nutzen Sie Automatisierung sicher und skalierbar – ohne Einbußen bei Transparenz oder Sicherheit.

Erfahren Sie jetzt, wie Parseur Ihre Daten mit unternehmenskonformen Sicherheitsmaßnahmen und einer kompromisslosen No-Training-Richtlinie schützt – für transparente, sichere und skalierbare Workflows in Ihrem Unternehmen.

Häufig gestellte Fragen

Wenn Unternehmen Automatisierungs- und Datenerfassungstools nutzen möchten, tauchen häufig Fragen zu Datensicherheit, Compliance und Anbieterpraktiken auf. Hier finden Sie die am häufigsten gestellten Fragen von Unternehmen zu No-Training-Richtlinien und deren Auswirkungen auf das Vertrauen in die Automatisierung.

-

Was bedeutet „kein Training mit Ihren Daten“?

-

Diese Richtlinie stellt sicher, dass Ihre Daten niemals wiederverwendet werden, um maschinelle Lernmodelle oder KI-Systeme zu trainieren. Anbieter mit dieser Richtlinie verarbeiten Ihre Informationen ausschließlich für den vorgesehenen Zweck und gewährleisten so deren Vertraulichkeit und Sicherheit.

-

Warum ist eine No-Training-Richtlinie für Unternehmen wichtig?

-

Eine strenge No-Training-Richtlinie verringert das Risiko von Datenlecks, Compliance-Verletzungen und dem Missbrauch von geistigem Eigentum. Sie ist damit ein entscheidendes Kriterium für Unternehmen bei der Auswahl von Automatisierungsanbietern.

-

Wie schützt Parseur meine Daten?

-

Parseur setzt Sicherheitsmaßnahmen auf Unternehmensniveau mit Verschlüsselung, Aufbewahrungsrichtlinien, Compliance und einem strikten No-Training-Versprechen um, damit Ihre Informationen niemals zweckentfremdet werden.

-

Stehen No-Training-Richtlinien im Zusammenhang mit Compliance-Vorschriften?

-

Ja. Standards wie GDPR und ISO 27001 legen Wert auf Datenminimierung und Zweckbindung. Eine No-Training-Richtlinie steht direkt im Einklang mit diesen Prinzipien und unterstützt Unternehmen bei der Einhaltung von Vorschriften.

-

Werden in Zukunft mehr Anbieter No-Training-Richtlinien einführen?

-

Branchenexperten erwarten, dass No-Training-Richtlinien zum Standard werden, da Unternehmenskunden immer mehr Transparenz, Compliance und starke Datenkontrolle verlangen.

Zuletzt aktualisiert am