「あなたのデータでトレーニングしない」とは?

「あなたのデータでトレーニングしない」というフレーズは、AIプロバイダーがあなたのシステムに預けた情報を独自のAIモデルの改善や再トレーニングに使わないという約束を意味します。

主なポイント

- 「あなたのデータでトレーニングしない」運用により、情報はAIトレーニングで再利用されず、業務目的でのみ使用されることが保証されます。

- エンタープライズにとっては、信頼、コンプライアンス、知的財産保護の観点から、この方針が必要不可欠です。

- Parseurは暗号化、データ保持管理、コンプライアンス、そして厳格なノートレーニングポリシーを標準で導入しています。

企業がAIツールを採用する際は、機密性の高いビジネスデータが無断で再利用されたり漏洩したりしないことが必須条件です。

また消費者の声も強く反映されています。約70%の大人が企業のAI利用を信頼せず、80%超がデータの不適切利用を懸念しているというProtectoの調査もあり、規制違反の罰金だけでなく、評判へのダメージが甚大となるケースが増えています。

近年、OpenAIやAnthropic、Microsoftなど主要なAIプロバイダーも、顧客データの取扱い方法に厳しい視線が注がれています。重要なのは、プラットフォームに取り込んだデータが「業務処理だけに使われるのか」「モデルのトレーニングにも使われるのか」という点です。

このため**「AIはあなたのデータでトレーニングしない」**という明確なポリシーが、AIの信頼構築における新たな業界スタンダードとなっています。顧客データが業務上の処理目的のみに利用され、モデル開発のためには使われないと保証できる体制こそが、企業の信頼とコンプライアンスの基盤になるのです。

この記事では、「あなたのデータでトレーニングしない」の具体的な意味や、エンタープライズでなぜ重要視されるのか、大手プロバイダーの現状、そしてParseurがいかにこの方針を徹底しているかを解説します。

「あなたのデータでトレーニングしない」の本当の意味

あなたのデータは、ドキュメント要約、フィールド抽出、文章生成、パターン分析など、あなたのリクエスト対応のためにのみ使用され、その後は削除または厳格なルールで安全に管理されます。

ここが大きな違いです:

- 処理(Processing): データはリアルタイムで業務処理(レポート作成、請求書データ抽出など)に利用され、処理完了後はAIの学習に使われません。

- トレーニング(Training): データがAIモデルの性能向上のために蓄積・利用されることで、将来的に機密事項が予期せず生成されるリスクがあります。

従来は多くの大型AIシステムで両者の境界が曖昧でしたが、これが次のようなリスクを生み出してきました。

- 機密保持の懸念: ビジネス文書や財務情報、顧客データが外部に漏れたり再現されたりするリスク

- データ所有権問題: トレーニング利用によって知的財産権が不明確になる恐れ

- コンプライアンス違反: 医療・金融・法務など分野では明確な同意なくトレーニング活用すればリスク発生

ノートレーニングポリシーはこの不透明さを一掃し、データが業務処理のみに限定され、学習・第三者共有・意図しない流用は一切行われません。これによりデータセキュリティ、コンプライアンス遵守、そしてベンダーへの信頼強化が実現します。

つまり、「あなたのデータでトレーニングしない」は、あなたのデータが常にあなたのものであり続け、プライバシーと法令順守のもと安全に管理されることを意味します。

なぜデータトレーニングポリシーが企業に不可欠なのか

明確なAIデータプライバシーポリシーは、企業の機密データを守り、リスクを最小限に抑えるための必須要件です。ポリシーが曖昧だと、データ管理のコントロールを失い、法的リスクや信頼失墜につながります。

学習利用のリスク

- 知的財産の漏洩: 企業独自の業務プロセスや重要資料が、知らぬ間に学習データとなり独自性や所有権喪失の恐れ

- 法令・規制違反: GDPRやCCPA等は個人データの用途限定を義務付け。無断利用で高額な罰則リスク発生

- 競争情報リスク: 学習に使われた独自情報が結果的に他社も活用できる形となり、優位性を損なう

エンタープライズが重視する理由

エンタープライズではAIツールの機能性だけでなく、AIデータプライバシーポリシーへの姿勢が重視されます。The Futurum Groupの2025年調査では、52%の企業がAIベンダーの技術力、51%がデータ運用・プライバシーへの配慮を重要視しており、堅牢なプライバシーポリシーが選定の決め手となっています。ノートレーニングを約束するベンダーの特徴は以下です。

- データ所有権の明確化: 顧客の知的財産権を厳守

- コンプライアンス対応: 法的リスクを軽減し監査も容易

- 信頼・透明性: データの不正利用を排除し長期的な関係構築

このように、データトレーニングポリシーはAI導入時の“決定的要素”です。厳格なノートレーニングポリシーを持つベンダーであれば、イノベーションと制御、法令順守、信頼を同時に実現できます。

コンプライアンスとガバナンスの視点

AI導入には業務効率化だけでなく、高度なコンプライアンス・ガバナンス対応も必須です。ISO 27001やGDPR、金融・法務・医療などの規格は、最高水準のデータ管理・説明責任を要求します。2025 Investment Management Compliance Testing Surveyによれば、57%のコンプライアンス担当者がAI利用を最重要課題と回答し、AIのISO 27001やGDPR等への適合が注目されています。

ノートレーニングポリシーは「情報を本来の目的にしか使わない」仕組みとして、以下の原理を徹底します。

- データ最小化: 処理の必要最小限のみ活用

- 明確な同意とコントロール: 許可なく別用途へ転用しない

- 目的限定: 業務目的のみで利用し、AI学習に再利用しない

これにより、ベンダーの監査対応や法的リスク最小化が容易になります。

ガバナンス上も、「標準化された信頼構築」の面でノートレーニングポリシーは不可欠です。**Electronic Commerce Code Management Association (ECCMA)**のような団体も信頼性と透明性向上を推奨しており、ノートレーニングはこうした要請に応えます。

AIベンダーの選定時は、堅実なガバナンスに沿った企業を選ぶことで、セキュアかつ倫理的なAI活用基盤を築くことができます。

業界例:主要テクノロジー企業の対応

データポリシーの重要性の高まりの実例として、大手テック企業の取り組みが挙げられます。現在、大手AIプロバイダーもエンタープライズ向けにプライバシー・データコントロールの明確化を進めています。

- OpenAI: ChatGPTは個人版ではモデル強化のためデータ利用がありえますが、エンタープライズはオプトアウトやトレーニング利用なしの保証が提供されます。

- Microsoft: Copilot for Microsoft 365やAzure OpenAI Serviceでは、エンタープライズ顧客のデータはモデル学習に使われず、情報も隔離管理されています。

- Anthropic: Claudeにおいて、エンタープライズデータは学習に用いないと公式に約束し、顧客自身のデータコントロールや透明性も担保。

このように、エンタープライズ市場では「AIデータプライバシーポリシー」で明確な保証を求める動きが主流となっています。

なぜ「あなたのデータでトレーニングしない」がAIの信頼性を高めるのか

AI導入の根底にあるのは信頼です。エンタープライズがAIや自動化を本格展開するには、業務データが確実に安全かつ適切に処理されることが大前提です。PwCの2025年AIエージェント調査でも、ビジネスリーダーの28%が「AIへの信頼不足」を最大の障壁と認識しています。ノートレーニングポリシーなしでは大半の企業がリスクを感じてAI活用に踏み込めません。「あなたのデータでトレーニングしない」を明確に打ち出すことで、信頼が生まれます。

- 顧客の安心感: 独自情報がモデル学習や競合強化に利用される懸念を払拭。機密戦略や顧客データ等の保護も確実

- 高い透明性: 業務データとAI開発を明確に分離し、内部監査やコンプライアンス証明も容易

- AI利活用の拡大: 信頼感が高まることで、金融・法務・医療・CS業務に至るまでAI活用が加速

「あなたのデータでトレーニングしない」は方針であり、競争上の強みにもなります。 この原則を守ることが、顧客信頼・業務効率化・大規模なAI統合の推進力となります。

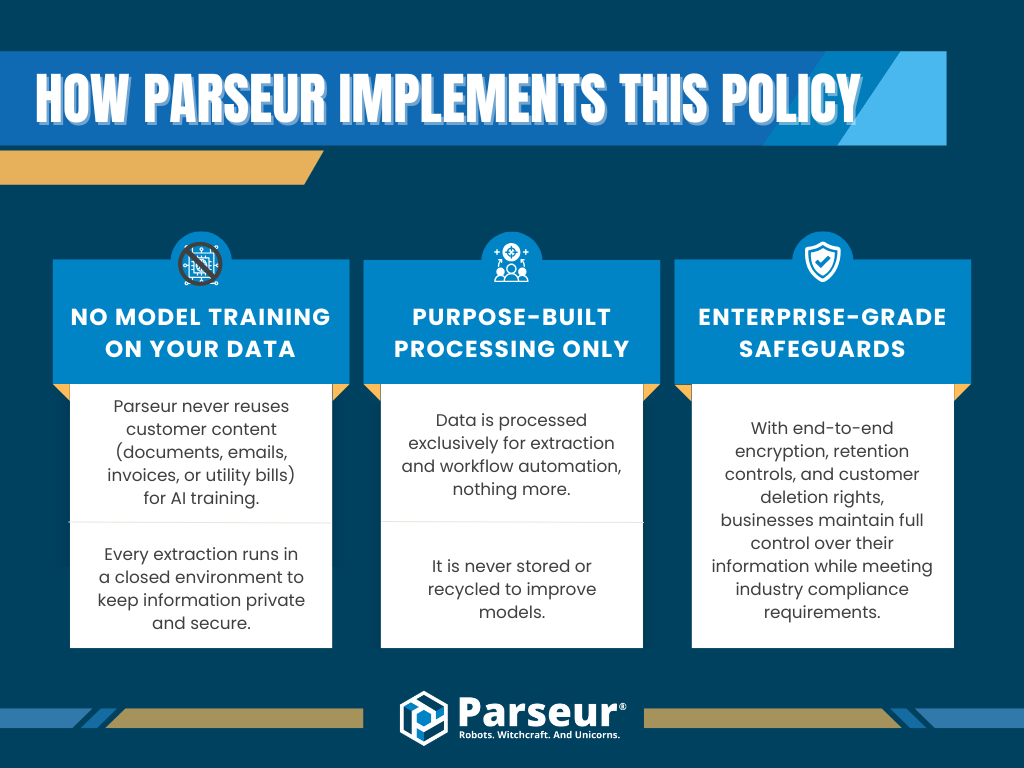

Parseurの徹底した取り組み

Parseurはプラットフォーム設計の段階からデータプライバシーとコンプライアンスを重視しており、「あなたのデータでトレーニングしない」方針を明確に掲げています。

Parseurでの具体的な対策は次の通りです。

- 顧客データは学習に一切使用しない: 全てのドキュメントやメール、請求書などの情報は学習目的で利用されず、クローズドな環境で厳格に管理

- 用途限定のデータ利用: データはフィールド抽出やワークフロー自動化など業務処理のみに使われ、モデル向上などの目的では保持・再利用されません

- エンタープライズ基準のセキュリティ対策: フル暗号化、精緻な保持コントロール、ユーザーによる削除権限など企業がコンプライアンスとガバナンスを担える仕組み

この厳格なノートレーニングポリシーで顧客データの安全を確保し、AIの長期的信頼構築を下支えします。Parseurなら、漏洩・知財流出・法令違反の不安なく自動化を推進できます。

Parseurは透明性、ガバナンス、堅牢なセキュリティの融合で、プライバシー重視の自動化ソリューションを提供します。

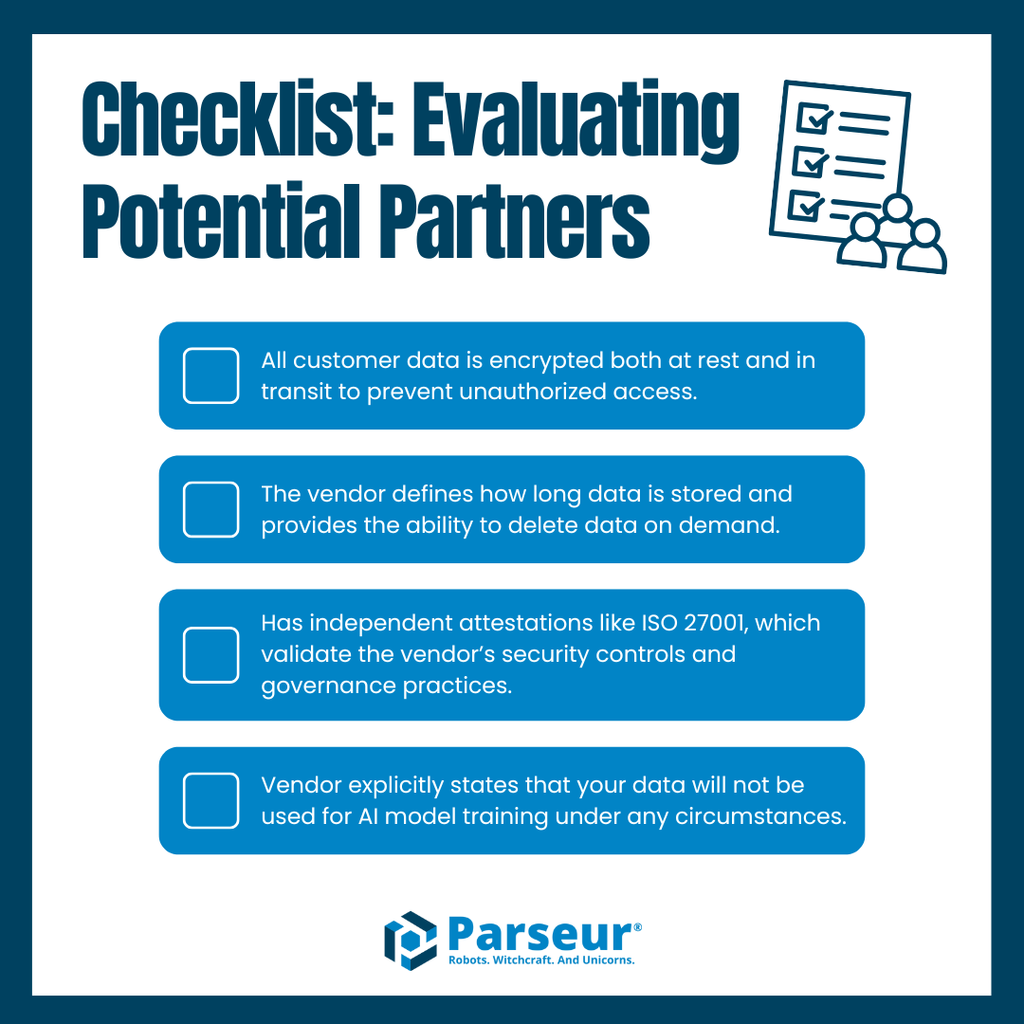

ベンダー評価のベストプラクティス

AI・自動化ベンダー選定を行う際は、単なる機能比較に留まらず、データ管理・セキュリティ・コンプライアンス・ガバナンス基準を満たしているかどうかが最大の焦点です。指針が不明確なベンダーを選ぶと、機密データの漏洩や規制違反のリスクも高まります。

比較時にチェックすべき主なポイントは:

- データ暗号化: データの保存・転送が強固に暗号化されているか

- データ保持方針: 保持期間が明確で、ユーザーが削除を管理できるか

- コンプライアンス認証: ISO 27001等、第三者認証の有無

- ノートレーニング宣言: データがAI学習に絶対使われないと公式に明言しているか

これらが不明確なベンダーは、コンプライアンスやプライバシーのリスク源となり得ます。逆にこれら全てを明記・実践するベンダーは、強い信頼を獲得できます。

Parseurはこの点で際立っています。 デフォルト暗号化、明瞭な保持管理、第三者認証、公式なノートレーニング方針を持ち、エンタープライズ企業の自動化拡大を安全に後押しします。

なぜ信頼が自動化の鍵となるのか

現代の自動化・データソリューション選択は、信頼を最優先に据える時代となりました。多様かつ膨大な機密情報を扱う中、ベンダーのデータ保護レベルが問われます。ここで「あなたのデータでトレーニングしない」という明確なポリシーが企業の信頼の要となります。

今後はさらに透明性・説明責任を重視する企業が増えるでしょう。専門家は、「明確なデータ保持指針」「標準での暗号化」「第三者認証」「書面でのノートレーニング確約」を条件とする企業が増加すると予測しています。これを満たせないベンダーはビジネスの信頼や競争力獲得が難しくなります。

Parseurはその未来に完全対応。 エンタープライズ水準の暗号化、確実な保持管理、認証取得、ノートレーニング方針の徹底で、企業の自動化推進とセキュリティ・プライバシー両立のニーズを満たします。

Parseurで、エンタープライズレベルのセキュリティとノートレーニング方針により、あなたのデータがどのように守られるかご確認ください。安全・透明・大規模な業務自動化を自信を持って推進できます。

よくある質問

企業が自動化やデータ抽出ツールの導入を検討する際、データのセキュリティ、コンプライアンス、ベンダーの運用方針に関する疑問がよく寄せられます。ここでは、「データをトレーニングに用いない」方針と、それが自動化の信頼性に与える影響についてエンタープライズでよくある質問をご紹介します。

-

「あなたのデータでトレーニングしない」とはどういう意味ですか?

-

このポリシーは、あなたのデータが機械学習モデルやAIシステムのトレーニングに決して利用されないことを約束するものです。この方針を掲げるベンダーは、あなたの情報を本来の業務目的のみで使用し、プライバシーとセキュリティの保護に努めます。

-

エンタープライズにとって「データをトレーニングに使わない」ポリシーはなぜ重要ですか?

-

厳格なノートレーニングポリシーは、データ漏洩や法令違反、知的財産の不正使用リスクを軽減するため、エンタープライズのベンダー選定において重要視されています。

-

Parseurはどのように私のデータを保護しますか?

-

Parseurはエンタープライズ水準の暗号化、保持管理、コンプライアンス対応、そして「あなたのデータでトレーニングしない」確約を通じて、情報の再利用を排除します。

-

ノートレーニングポリシーはコンプライアンス規制と関係していますか?

-

はい。GDPRやISO 27001といった国際的基準は、データの最小化や目的限定を重視します。「あなたのデータでトレーニングしない」ポリシーは、これらの要求をサポートし、企業のコンプライアンス維持に直結します。

-

今後ノートレーニングポリシーを採用するベンダーは増えますか?

-

業界の専門家は、今後この方針が標準になるとみており、エンタープライズ顧客は透明性やコンプライアンスを重視し、より強固なデータガバナンスを求める傾向が高まると予測しています。

最終更新日