O Que Significa “Nenhum Treinamento com Seus Dados”?

Em sua essência, a política de nenhum treinamento com seus dados significa que fornecedores de IA se comprometem a nunca reutilizar ou incorporar as informações dos clientes para aprimorar ou atualizar seus modelos de inteligência artificial ou machine learning.

Principais Pontos

- “Nenhum treinamento com seus dados” garante que as informações são processadas, mas nunca reutilizadas para capacitar modelos de IA.

- Essa política é fundamental para empresas que desejam preservar confiança, conformidade e propriedade intelectual.

- O Parseur aplica criptografia, retenção sob controle, conformidade e a política de nenhum treinamento como padrão.

Ao implantar ferramentas de IA, as empresas buscam a certeza de que suas informações confidenciais não serão exploradas, expostas ou reutilizadas de maneiras não autorizadas.

Essa preocupação também é amplamente compartilhada por consumidores: aproximadamente 70% dos adultos não confiam que empresas usarão IA de forma responsável, e mais de 80% acreditam que seus dados podem ser usados indevidamente, segundo Protecto. Isso torna a reputação das empresas diante do mau uso de dados ainda mais vulnerável, muitas vezes mais do que qualquer penalidade regulatória.

Nos últimos anos, empresas líderes em IA como OpenAI, Anthropic e Microsoft enfrentaram crescente pressão para clareza quanto ao uso de dados dos clientes. A principal dúvida passou a ser: os dados compartilhados são utilizados exclusivamente para operacionalizar os serviços ou também auxiliam no treinamento de modelos?

Assim, o conceito de IA sem treinamento com seus dados rapidamente se transformou em um novo padrão esperado, fundamental para a construção da confiança empresarial. É o compromisso de que informações do cliente são somente processadas, jamais utilizadas para aprimoramento de modelos. Para empresas, essa garantia sustenta confiança, conformidade e uma adoção segura de IA ao longo do tempo.

Neste artigo, você vai entender o que significa “nenhum treinamento com seus dados” na prática, sua importância para conformidade e governança, como grandes fornecedores abordam esse tema e de que forma o Parseur implementa essa política para garantir confiança e segurança de dados.

O que Envolve a Política de Nenhum Treinamento com Seus Dados?

Seus dados são utilizados apenas para atender sua solicitação específica, seja resumir um documento, extrair campos, redigir textos ou analisar padrões. Após o processamento, são descartados ou armazenados de modo seguro, conforme termos bem definidos.

A distinção central:

- Processamento: Dados utilizados em tempo real para realizar uma tarefa — por exemplo, gerar um relatório ou extrair detalhes de uma fatura. Após finalizado o serviço, não são reinseridos no sistema para aprendizado futuro.

- Treinamento: Dados alimentam o modelo de IA para que ele evolua. Com o tempo, informações inseridas podem ser absorvidas pelo sistema, aumentando o risco de dados sensíveis surgirem novamente.

Antes, muitos sistemas de IA não faziam essa distinção, misturando dados do cliente tanto em operações quanto em treinamento. Embora isso contribua para o avanço dos modelos, também gera riscos:

- Riscos à confidencialidade: Documentos confidenciais, dados financeiros ou informações de clientes podem ser expostos ou reconstruídos inadvertidamente.

- Dúvidas sobre propriedade de dados: Se seus dados ajudam a treinar um modelo, seus direitos de propriedade intelectual podem ser comprometidos.

- Desafios de conformidade: Setores como saúde, jurídico e financeiro não podem permitir que informações de clientes sejam reutilizadas para treinamento sem consentimento explícito.

Quando uma empresa adota a política de não treinamento, elimina qualquer ambiguidade: os dados são utilizados só para a tarefa em questão, nunca reciclados para treinamento, compartilhados com terceiros ou reaproveitados de forma oculta. Isso fortalece a proteção, simplifica requisitos regulatórios e promove confiança entre clientes e provedores de IA.

Em resumo, “nenhum treinamento com seus dados” significa que suas informações permanecem privadas, protegidas e sob seu controle.

Por Que Políticas de Treinamento de Dados São Cruciais para Empresas

Uma política de privacidade de dados em IA deixou de ser diferencial e passou a ser uma exigência imprescindível. Para empresas, trata-se de um baluarte legal e reputacional para garantir que informações sensíveis não se transformem em vulnerabilidade potencial. Sem regras claras, há o risco de perder controle sobre os dados, violar regulamentações, afetar reputação e prejudicar vantagem competitiva.

Riscos de uso de dados para treinamento

- Vazamento de propriedade intelectual: Processos internos, contratos, análises estratégicas e pesquisas podem ser absorvidos por modelos de IA, reduzindo sua exclusividade ou diluindo direitos autorais.

- Violações regulatórias e de conformidade: Legislações como GDPR e CCPA impõem limites severos sobre uso de dados pessoais e sensíveis. Se um fornecedor reutiliza essas informações para treinar IA sem consentimento explícito, está sujeito a sanções graves.

- Riscos à inteligência competitiva: Dados usados para treinar modelos podem criar vantagens indiretas para concorrentes ou enfraquecer sua posição no setor.

Por que empresas dão prioridade ao tema

Hoje, compradores corporativos analisam não apenas tecnologia e performance, mas principalmente as práticas de privacidade de dados em IA. Segundo pesquisa do The Futurum Group, realizada em 2025, 52% das organizações priorizam a competência técnica do fornecedor e logo atrás, 51% destacam controles de privacidade e manuseio dos dados, ressaltando a importância de políticas robustas para seleção. Um fornecedor com política clara de não treinamento oferece:

- Respeito à propriedade dos dados: Garante que informações estratégicas seguem sob domínio exclusivo do cliente.

- Alinhamento normativo: Reduz riscos legais e facilita auditorias em setores regulados.

- Transparência e confiança: Elimina práticas opacas e fortalece vínculos de longo prazo com os clientes.

No fim, as empresas veem políticas sobre treinamento de dados como critério decisivo para adoção de IA. Um fornecedor que assume política estrita de não treinamento permite inovar com automação, mantendo governança e segurança dos dados.

Conformidade e Governança na Prática

Para muitas organizações, adotar IA vai além da eficiência operacional: trata-se de aderir a exigências rigorosas de conformidade e governança. Normas como ISO 27001, GDPR e regulações setoriais em saúde, finanças e direito exigem um tratamento extremamente preciso das informações. Conforme a Pesquisa de Testes de Conformidade em Gestão de Investimentos 2025, 57% dos profissionais de compliance citaram o uso de IA como sua maior preocupação, reforçando a atenção sobre conformidade em ambientes controlados.

Adotar uma política de não treinamento permite cumprir pilares essenciais da conformidade:

- Minimização de dados: Processamento apenas do necessário, reduzindo exposição e riscos.

- Consentimento explícito: Informações não reutilizadas sem autorização clara do cliente.

- Limitação de propósito: Dados alocados somente à solicitação original, nunca reciclados para treinamento de futuros modelos.

Ao seguir essas diretrizes, fornecedores de IA garantem que empresas atendam exigências em auditorias e se defendam de eventuais penalidades por não conformidade.

Além de obedecer à lei, governança também envolve estabelecer padrões de confiança. Organizações como ECCMA trabalham para elevar a qualidade de dados e a credibilidade setorial, e políticas de não treinamento reforçam esse compromisso com transparência.

Ao escolher parceiros de IA que seguem tais práticas, empresas promovem inovação responsável, preservando integridade, segurança e alinhamento normativo.

Exemplos Práticos: Big Techs e Políticas de Treinamento de Dados

O modo como grandes empresas de tecnologia estão ajustando suas práticas evidencia o valor empresarial dessa política. Nos últimos anos, fornecedores de IA reforçaram controles para satisfazer requisitos de proteção e privacidade.

- OpenAI: Usuários do ChatGPT gratuitos e consumidores têm dados potencialmente usados para aprimoramento do modelo. Já clientes empresariais recebem garantias de opt-out: prompts e respostas não são usados no treinamento. Isso marca a separação de IA corporativa e de consumo.

- Microsoft: Nos serviços Copilot para Microsoft 365 e Azure OpenAI Service, a empresa isola completamente os dados dos clientes empresariais, nunca utilizando-os em treinamento. Isso assegura privacidade para arquivos, e-mails e informações sensíveis.

- Anthropic: Com o Claude, há um compromisso público de nunca treinar modelos empresariais com dados dos clientes, demonstrando foco em segurança, transparência e controle.

Esses exemplos mostram que políticas claras de privacidade de dados em IA são cada vez mais um diferencial competitivo. Fornecedores sem garantias robustas tendem a perder espaço para empresas mais alinhadas à confiança e à transparência.

Como a Política de Nenhum Treinamento Constrói Confiança em IA

Confiança é o fator determinante para adoção da IA nas empresas. Só haverá uso amplo de automação se houver a certeza de que os dados permanecerão protegidos. Segundo pesquisa da PwC sobre agentes de IA, 2025, 28% dos líderes empresariais citam a falta de confiança em IA como um dos principais desafios para a expansão. A ausência de limites claros sobre o uso dos dados cria riscos que inibem o uso de IA nas atividades críticas. Por isso, uma política de não treinamento é crucial para estabelecer confiança, pois define fronteiras rígidas entre dados dos clientes e o desenvolvimento dos modelos.

- Tranquilidade para o cliente: Empresas precisam saber que seus dados não contribuirão para modelos que beneficiem o concorrente. O compromisso de não treinamento assegura proteção para estratégias, portfólios de clientes e dados financeiros.

- Transparência comprovada: Práticas e políticas que separam dados dos clientes do sistema de treinamento eliminam dúvidas, fortalecem credibilidade e facilitam processos de auditoria interna.

- Maior adoção: Com confiança estabelecida, empresas expandem o uso da IA em áreas críticas como finanças, jurídico, saúde e atendimento, sabendo que informações sensíveis estão blindadas contra reaproveitamento em modelos futuros.

Em suma, adotar o princípio do “nenhum treinamento com seus dados” deixa de ser apenas uma política e se torna uma vantagem competitiva: fornecedores comprometidos com esta diretriz facilitam a integração e ampliação de IA com segurança e confiança no mercado corporativo.

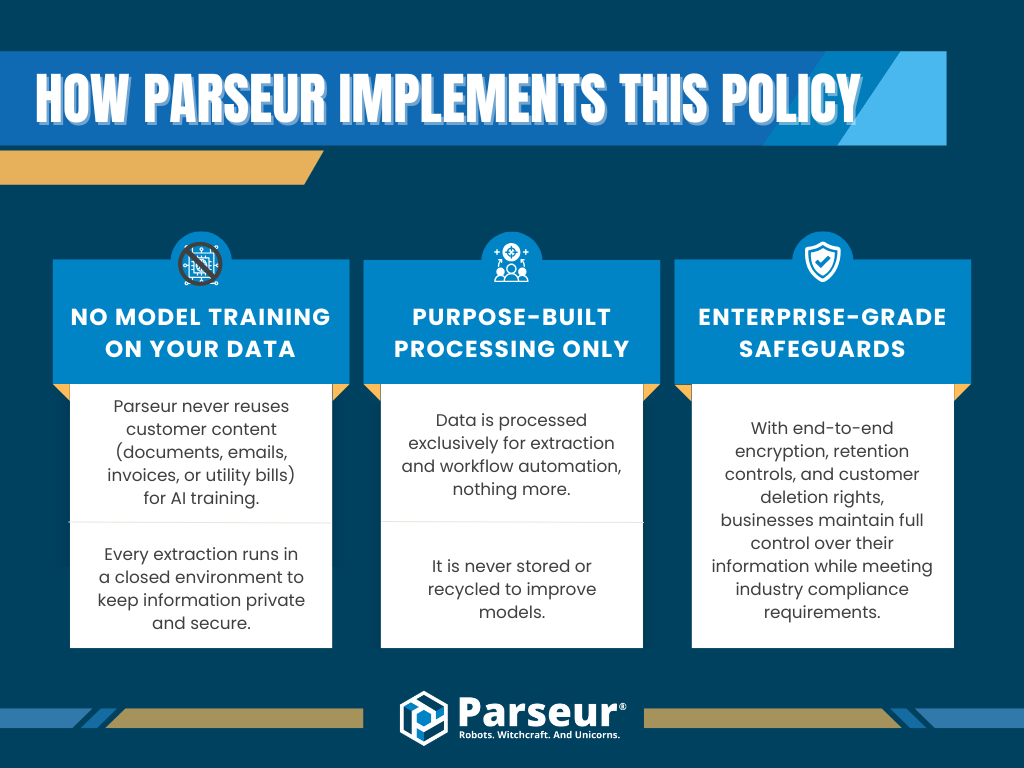

Como o Parseur Adota a Política de Nenhum Treinamento com Seus Dados

No Parseur, privacidade e conformidade de dados são pilares centrais. Reconhecemos que boa parte das empresas só considera a automação se tiver certeza absoluta sobre o uso de seus dados. Por este motivo, nunca utilizamos os dados dos clientes para treinar modelos de IA.

Na prática, o Parseur assegura:

- Zero uso de dados no treinamento de modelos: Nada que você enviar (documentos, e-mails, faturas ou contas) é usado para aprimorar sistemas internos de IA. Toda extração ocorre em ambiente isolado, sob padrões rígidos de segurança.

- Processamento exclusivo para o seu fluxo: Os dados servem apenas para extração e execução do workflow solicitado. Não são estocados ou reaproveitados para engenharias futuras.

- Segurança de nível corporativo: Com criptografia ponta a ponta, controle de retenção ajustável e direito ao apagamento, clientes mantêm pleno domínio sobre suas informações, sempre em alinhamento com conformidades do setor.

Com uma política inflexível de nenhum treinamento, o Parseur garante proteção e confiança contínua das empresas, proporcionando automação robusta sem risco de violar privacidade, propriedade intelectual ou regulamentações.

Unindo transparência, governança e segurança, o Parseur permite que organizações automatizem rotinas, sempre com a garantia de privacidade como prioridade.

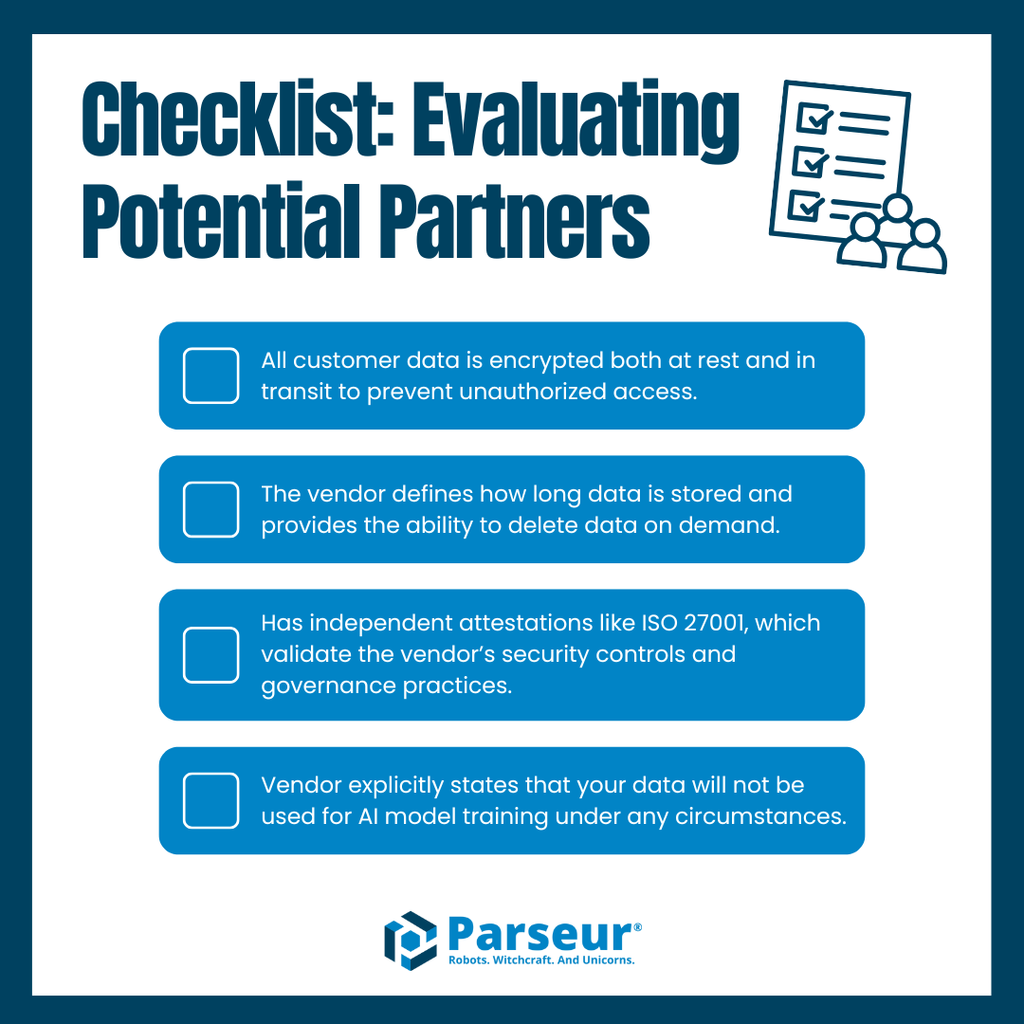

Melhores Práticas para Seleção de Fornecedores

A escolha de uma solução de automação ou IA vai muito além das funcionalidades. Nas empresas, a maior prioridade é confirmar que as práticas de dados do fornecedor seguem padrões rígidos de proteção e conformidade, pois qualquer descuido pode resultar em exposição de dados sensíveis ou violações regulatórias.

Para avaliar potenciais fornecedores, confira este checklist indispensável:

- Criptografia em todas as etapas: Exija proteção de dados tanto em repouso quanto em trânsito, evitando qualquer acesso não autorizado.

- Regras de retenção de dados: O fornecedor deve definir claramente quanto tempo os dados permanecem armazenados e possibilitar exclusão total sob solicitação.

- Certificações e compliance: Busque fornecedores com selos como ISO 27001 ou outros reconhecimentos que atestem práticas sólidas de segurança e governança.

- Declaração explícita de não treinamento: Confirme que seu fornecedor se compromete formalmente a não usar seus dados em nenhuma etapa do treinamento de IA.

Ignorar esses critérios pode deixar brechas para riscos de privacidade ou problemas regulatórios. Por outro lado, fornecedores que atendem a todos esses pontos proporcionam ambiente de confiança para escalabilidade e sustentabilidade.

Aqui, o Parseur se diferencia significativamente: oferece criptografia por padrão, retenção sob controle do cliente, certificações reconhecidas e política intransigente de nenhum treinamento — entregando automação em escala sem abrir mão da proteção de dados. Com o Parseur, sua empresa sabe exatamente como os dados serão tratados em todas as etapas do processo.

Por que a Confiança é o Pilar do Futuro da Automação

A confiança se tornou o norte das empresas ao avaliar soluções de automação e gestão de dados. Com o volume de informações sensíveis crescendo, é fundamental saber como cada fornecedor atua para proteger e gerir esses dados. E o princípio de nenhum treinamento com seus dados é central nesse novo paradigma.

O futuro aponta para uma era ainda mais focada em transparência e responsabilidade. A tendência é que as empresas passem a exigir, como regra, fornecedores que tragam políticas claras de retenção, criptografia em todos os níveis, certificações reconhecidas e compromissos formais de jamais usar dados dos clientes no treinamento de modelos. Fornecedores que não atenderem a esses requisitos verão sua credibilidade e competitividade em risco, em um mercado totalmente orientado pela governança de dados.

Parseur está preparado para esse cenário. Com criptografia de nível corporativo, controles rígidos de retenção, certificações de conformidade e política de nenhum treinamento, a plataforma assegura automação segura e escalar para empresas que não abrem mão da privacidade de suas informações.

Descubra como o Parseur protege seus dados com segurança de ponta e política de nenhum treinamento, garantindo que sua automação seja feita com confiança, transparência e em conformidade total.

Perguntas Frequentes

À medida que as empresas exploram ferramentas de automação e extração de dados, surgem dúvidas quanto à segurança dos dados, conformidade e práticas dos fornecedores. Aqui estão as perguntas mais comuns feitas pelas empresas sobre políticas de não treinamento e como elas impactam a confiança na automação.

-

O que significa “nenhum treinamento com seus dados”?

-

Esta política garante que seus dados nunca serão reutilizados para treinar modelos de machine learning ou sistemas de IA. Fornecedores que seguem essa política apenas processam suas informações para o propósito pretendido, assegurando que permaneçam privadas e seguras.

-

Por que uma política de não treinamento é importante para as empresas?

-

Uma política rigorosa de não treinamento reduz riscos de vazamento de dados, violações de conformidade e uso indevido de propriedade intelectual, tornando-se um dos principais requisitos para empresas que avaliam fornecedores de automação.

-

Como o Parseur protege meus dados?

-

O Parseur aplica segurança de nível empresarial com criptografia, controles de retenção, alinhamento à conformidade e um compromisso estrito de não utilizar seus dados para treinamento, assegurando que suas informações nunca sejam reutilizadas.

-

As políticas de não treinamento estão relacionadas a regulamentos de conformidade?

-

Sim. Normas como GDPR e ISO 27001 enfatizam minimização de dados e limitação de propósito. Uma política de não treinamento está alinhada diretamente com esses princípios, ajudando as organizações a manterem-se em conformidade.

-

Mais fornecedores adotarão políticas de não treinamento no futuro?

-

Especialistas do setor preveem que essas políticas se tornarão padrão, já que as empresas exigem cada vez mais transparência, alinhamento com a conformidade e uma governança de dados mais forte.

Última atualização em