¿Qué significa “no entrenamiento con tus datos”?

En esencia, "no entrenamiento con tus datos" es un compromiso de los proveedores de IA de que la información que compartes con sus sistemas no será utilizada para mejorar o reentrenar sus modelos de machine learning.

Puntos clave

- La política de no entrenamiento con tus datos significa que la información es procesada, pero no reutilizada para entrenar inteligencia artificial.

- Las empresas requieren esta política para proteger la confianza, cumplir regulaciones y resguardar la propiedad intelectual.

- Parseur implementa cifrado, controles de retención y cumplimiento, junto a una política de no entrenamiento como configuración predeterminada.

Al adoptar herramientas de IA, las empresas buscan la garantía de que su información sensible no será mal utilizada, expuesta o reciclada para otros fines que no han autorizado.

Esta preocupación no solo es empresarial: alrededor del 70% de los adultos no confía en que las empresas usen la IA de manera responsable y más del 80% teme un uso indebido de sus datos, según Protecto, lo que demuestra que la pérdida de reputación por un mal manejo de datos resulta incluso más dañina que las sanciones regulatorias.

En los últimos años, grandes actores de la IA como OpenAI, Anthropic y Microsoft enfrentan crecientes cuestionamientos sobre el uso de los datos de clientes. El tema central es si la información compartida con estas plataformas se utiliza solo para procesar solicitudes o también para entrenar modelos futuros.

Por eso, “no entrenamiento con tus datos en la IA” se consolida rápidamente como el nuevo estándar de confianza. Es la promesa de que los datos de los clientes se procesan exclusivamente para el servicio y jamás se incorporan a los datos de entrenamiento general. Este compromiso es la base de la confianza, el cumplimiento normativo y la adopción sostenida de soluciones de IA.

Aquí descubrirás qué implica en la práctica el no entrenamiento con tus datos, por qué es esencial en términos de cumplimiento y gobernanza, cómo lo abordan los principales proveedores, y cómo Parseur garantiza esta política para la seguridad y confianza en la IA.

¿Qué cubre exactamente la política de no entrenamiento con tus datos?

Tus datos se utilizan únicamente para resolver tu solicitud: ya sea resumir un documento, extraer campos, redactar propuestas o analizar patrones. Tras finalizar, los datos se eliminan o almacenan de forma segura bajo términos específicos.

La diferencia esencial:

- Procesamiento: Tus datos se usan en tiempo real para cumplir una tarea puntual, como generar un informe o extraer información de una factura. Luego, esa información no entra nuevamente al sistema con fines de aprendizaje.

- Entrenamiento: Tus datos alimentan el modelo de IA para mejorar su rendimiento general. Esto puede hacer que fragmentos de información sensible terminen integrándose en la base de conocimiento del modelo.

En el pasado, muchos sistemas de IA difuminaron esta línea, utilizando datos de clientes tanto para procesamiento como para entrenamiento. Aunque eso ayudó al desarrollo tecnológico, también presentó riesgos:

- Riesgo para la confidencialidad: Documentos internos, datos financieros o información de clientes pueden quedar expuestos.

- Cuestiones de propiedad intelectual: Si tus aportes entrenan el modelo, se debilita tu derecho exclusivo sobre tu información.

- Riesgos de cumplimiento: Sectores como salud, finanzas o legal no pueden permitirse que se reutilicen datos sensibles sin consentimiento.

La política de no entrenamiento con tus datos elimina toda ambigüedad: la información se procesa solo para el uso autorizado, sin reciclarse o compartirse para entrenamiento, ni usarse de manera oculta. Esta claridad fortalece la seguridad, facilita el cumplimiento normativo y fomenta la confianza entre empresas y proveedores de IA.

En conclusión, no entrenamiento con tus datos significa que tu información es privada, está protegida y siempre permanece bajo tu control.

Por qué las políticas de entrenamiento de datos importan a las empresas

La política de privacidad de datos en IA no es solo un añadido; es una barrera fundamental que asegura que la información sensible se maneja de forma segura y no se convierte en un riesgo oculto. Sin una política clara, las empresas pierden control y pueden exponerse a sanciones legales, daños reputacionales y falta de competitividad.

Riesgos de emplear los datos para entrenamiento

- Fuga de propiedad intelectual: Documentos estratégicos, contratos o investigaciones pueden incorporarse de forma involuntaria a conjuntos de datos públicos o de terceros, perdiendo exclusividad.

- Riesgo regulatorio: Leyes como GDPR y CCPA establecen estrictos límites sobre el tratamiento y almacenamiento de datos personales o sensibles. Reutilizar datos sin un consentimiento claro puede implicar graves sanciones e investigaciones.

- Ventaja competitiva debilitada: Si tus datos estratégicos entrenan un modelo de IA, tus competidores pueden aprovechar ese conocimiento, erosionando tu diferenciación.

Importancia para los compradores empresariales

Hoy, las organizaciones no solo valoran los resultados de la IA, sino también sus políticas de privacidad de datos. Según The Futurum Group, el 52% de las empresas priorizan la experiencia técnica de los proveedores de IA, y el 51% sitúa la gestión de datos y privacidad entre sus principales criterios de selección. Un proveedor que adopta una política de no entrenamiento ofrece:

- Respeto por la propiedad de los datos: Garantiza a los clientes que su información no será utilizada sin autorización.

- Alineación con el cumplimiento: Minimiza la exposición legal y simplifica auditorías en ámbitos regulados.

- Confianza y transparencia: Elimina prácticas ocultas y refuerza relaciones duraderas basadas en reglas claras.

Así, la política de entrenamiento de datos es un filtro clave en la decisión de compra de IA. Asociarse con proveedores que aplican el no entrenamiento permite innovar con seguridad, control y confianza en la gestión de datos.

Cumplimiento y gobernanza bajo una política de no entrenamiento

Para muchas organizaciones, la IA no solo es eficiencia, sino una necesidad regulatoria y de gobernanza. Estándares como ISO 27001, GDPR y los marcos sectoriales exigen máxima protección y gestión responsable de los datos. Según la Encuesta de Cumplimiento de Gestión de Inversiones 2025, el 57% de los responsables de cumplimiento identifican el uso de IA como principal desafío regulatorio en su sector.

Una política de no entrenamiento es clave para cumplir estos requisitos, ya que implica:

- Minimización de datos: Solo se procesa el dato mínimo necesario para la tarea, reduciendo la exposición.

- Consentimiento y control: La información nunca se reutiliza sin autorización explícita.

- Limitación de propósito: Los datos de clientes se usan exclusivamente para el fin acordado y jamás para entrenar futuros modelos.

Siguiendo estos principios, los proveedores ayudan a sus clientes a prepararse para auditorías exitosas y a evitar sanciones graves.

La gobernanza también implica fomentar la confianza mediante prácticas estándar. Organizaciones como la Electronic Commerce Code Management Association (ECCMA) promueven calidad y confianza en los datos, y las políticas de no entrenamiento aseguran transparencia y fiabilidad.

Al seleccionar proveedores alineados con las mejores prácticas de gobernanza, las empresas se mantienen en cumplimiento y construyen una base sólida para una IA ética y segura.

Ejemplos de la industria: Cómo los líderes tecnológicos gestionan el entrenamiento de datos

Las grandes tecnológicas han cambiado su enfoque hacia el entrenamiento de datos debido a la demanda empresarial de mayores garantías y privacidad.

- OpenAI: En ChatGPT, los datos de usuarios gratuitos pueden alimentar mejoras del modelo, pero en los servicios empresariales existen opciones para excluir los datos del entrenamiento. La diferencia marca la separación entre IA general y entornos corporativos.

- Microsoft: En Copilot para Microsoft 365 y Azure OpenAI Service, Microsoft garantiza que los datos de clientes empresariales no se usan para entrenar modelos base, lo que tranquiliza a las empresas sobre la seguridad de su información.

- Anthropic: Su plataforma Claude ofrece compromisos públicos de no entrenamiento con datos empresariales, afianzando su reputación en seguridad, control y transparencia.

Estos casos ilustran una tendencia: el mercado exige garantías concretas sobre las políticas de privacidad y uso de datos en IA. Los proveedores que priorizan la transparencia y una política clara de no entrenamiento ganan ventaja competitiva.

Por qué la política de no entrenamiento con tus datos genera confianza en la IA

La confianza es la base de cualquier adopción efectiva de IA. Solo si las empresas confían en que sus datos estarán protegidos y gestionados responsablemente, se atreverán a automatizar a gran escala. Según la encuesta de agentes de IA de PwC 2025, el 28% de los líderes empresariales identifican la falta de confianza como una de las principales barreras para el despliegue de IA. Sin políticas claras, como la de no entrenamiento, las empresas temen perder el control de su información o compartir ventajas competitivas.

- Tranquiliza a los clientes: La seguridad de que sus datos jamás formarán parte del entrenamiento de IA protege estrategias, registros sensibles y relaciones clave.

- Aumenta la transparencia: Una política explícita elimina cualquier duda sobre cómo se maneja la información.

- Facilita la adopción de IA: Saber que la información no se reutiliza acelera la implementación de flujos de trabajo automatizados en áreas críticas.

No entrenamiento con tus datos no es solo una política, es un diferencial competitivo: demuestra respeto por el usuario, fomenta la adopción y posiciona a la empresa como referente en privacidad y seguridad.

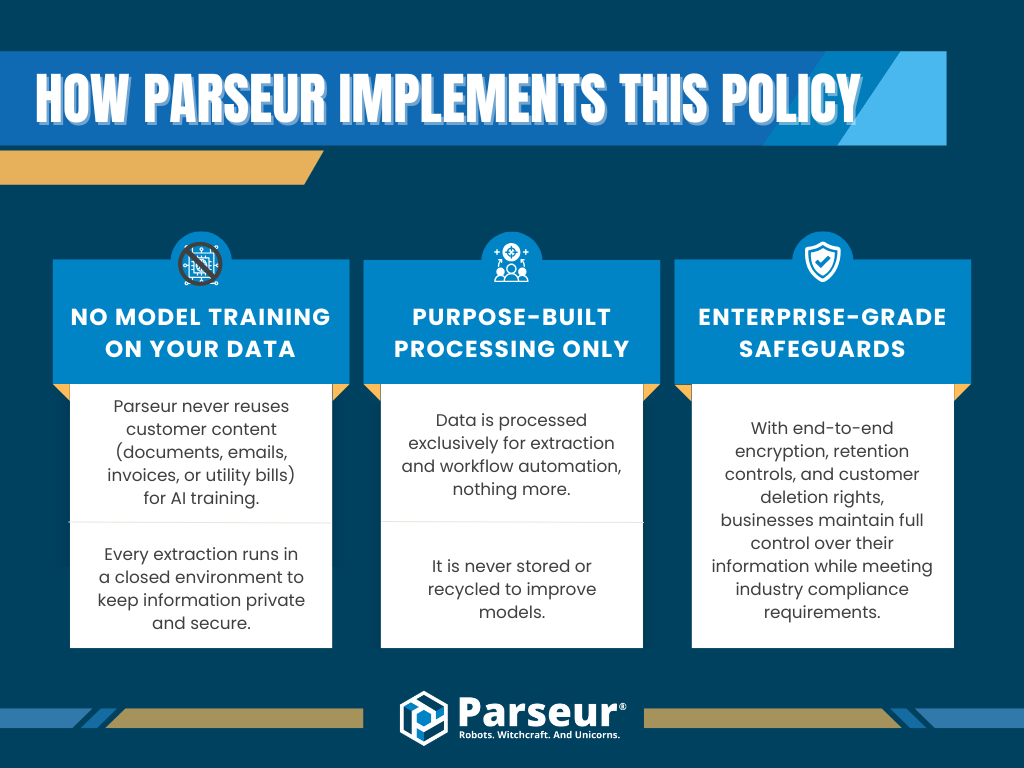

Cómo aplica Parseur la política de no entrenamiento

En Parseur, la privacidad y cumplimiento de los datos son principios fundamentales desde el diseño. Reconocemos que muchas empresas solo se plantean usar IA si tienen la certeza de que sus datos no se usarán para otros fines. Por eso, Parseur garantiza que tus datos jamás alimentarán el entrenamiento de modelos de IA.

¿Qué significa esto en la práctica?

- No entrenamiento de modelos con tus datos: Parseur nunca reutiliza contenido de cliente (correos, documentos, recibos) para desarrollo de IA. Cada dato se procesa en un entorno aislado y seguro.

- Procesamiento solo para la finalidad definida: Los datos se utilizan exclusiva y únicamente para automatización o extracción en tiempo real. Nunca se almacenan a largo plazo ni se aprovechan para entrenar modelos.

- Salvaguardas empresariales: Parseur aplica cifrado extremo a extremo, ofrece controles de retención y permite eliminar datos bajo demanda, garantizando siempre el control y la conformidad normativa.

Esta política estricta elimina riesgos y refuerza la confianza en la automatización inteligente. Las empresas pueden escalar procesos sin preocuparse por filtraciones, propiedad intelectual o cumplimiento.

Combinamos transparencia, buenas prácticas de gobernanza y seguridad robusta para que la automatización sea segura y confiable en todo momento.

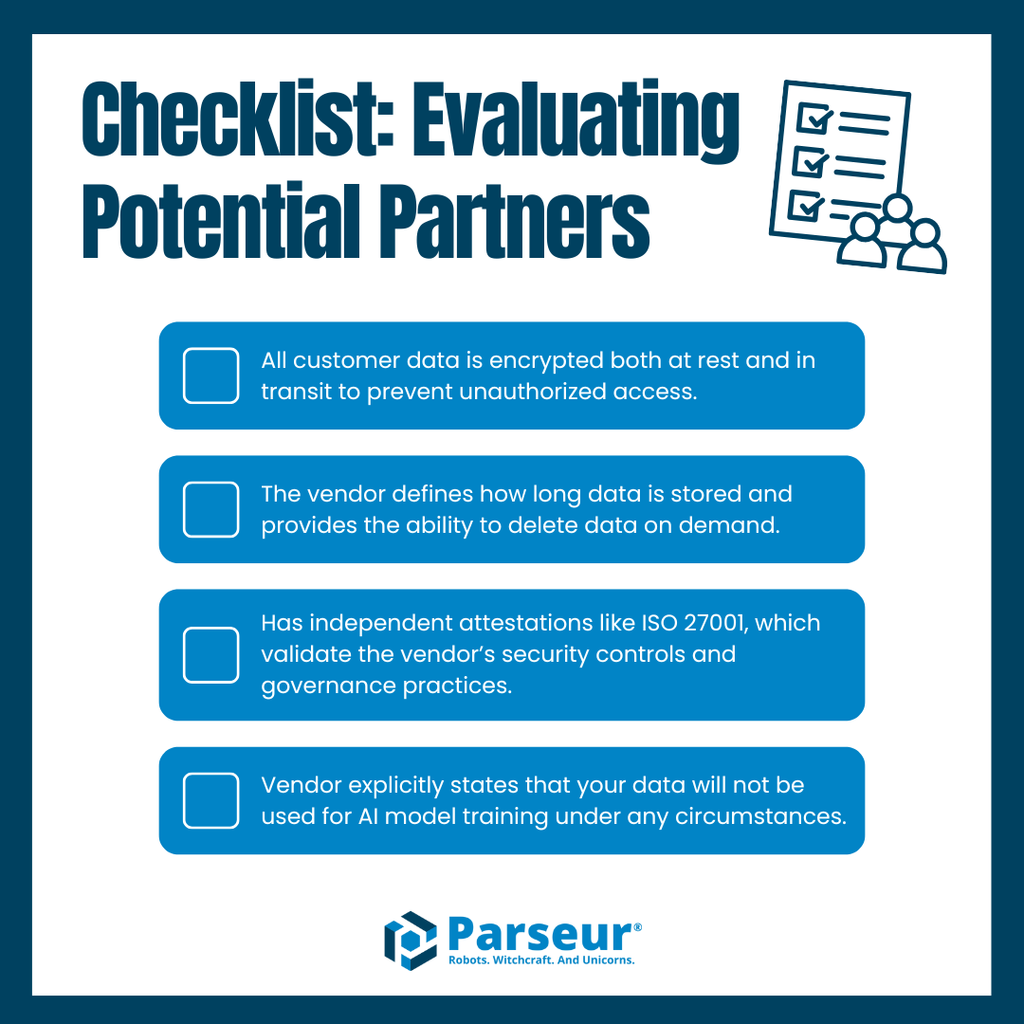

Mejores prácticas para evaluar proveedores de IA

Elegir una solución de IA o automatización requiere comparar mucho más que características técnicas. El principal criterio debe ser que la gestión de datos cumpla los más altos estándares de seguridad y privacidad.

Considera estas claves al evaluar proveedores:

- Cifrado de datos real: Asegúrate de que los datos siempre se cifran tanto en tránsito como en reposo.

- Gestión de retención: El proveedor debe definir claramente cuánto tiempo almacena datos y ofrecer herramientas de eliminación bajo demanda.

- Certificaciones independientes: Busca sellos como ISO 27001 que respalden la gobernanza y seguridad de la plataforma.

- Compromiso inequívoco de no entrenamiento: Exige declaraciones claras que los datos nunca serán utilizados para entrenar inteligencia artificial.

Los proveedores que no cumplan estos mínimos representan un riesgo operativo y legal. Los que sí, otorgarán la confianza que tu organización necesita para avanzar.

Parseur cumple con todos los requisitos: cifrado, retención clara, certificación y un compromiso firme de no entrenamiento con tus datos, permitiendo automatizar procesos con total tranquilidad.

La confianza como futuro de la automatización

La confianza es el criterio decisivo en la selección de soluciones de automatización y manejo de datos. Cuanta más información sensible gestionan las empresas, mayor importancia tiene que los proveedores ofrezcan total transparencia y responsabilidad. En el centro de esta confianza está el principio de no entrenamiento con tus datos.

El futuro exigirá a los proveedores políticas explícitas de retención, cifrado, certificaciones y garantías escritas de que los datos nunca se usarán para entrenar modelos. Las organizaciones que no cumplan estas expectativas perderán credibilidad ante competidores más alineados con la gobernanza, seguridad y privacidad.

Parseur está diseñado para este contexto. Nuestra plataforma protege los datos con cifrado empresarial, retención transparente, cumplimiento probado y una política clara de no entrenamiento. Así, ofrecemos la confianza que las empresas necesitan para automatizar procesos críticos sin comprometer privacidad ni seguridad.

Descubre cómo Parseur protege tus datos con seguridad de nivel empresarial y una estricta política de no entrenamiento, para que tu organización automatice sus flujos de trabajo de manera segura, transparente y a gran escala.

Preguntas Frecuentes

A medida que las empresas exploran herramientas de automatización y extracción de datos, surgen preguntas sobre la seguridad de los datos, el cumplimiento y las prácticas de los proveedores. Aquí tienes las preguntas más comunes que las empresas hacen sobre las políticas de no entrenamiento y cómo impactan en la confianza en la automatización.

-

¿Qué significa "no entrenamiento con tus datos"?

-

Esta política garantiza que tus datos nunca se reutilizan para entrenar modelos de machine learning o sistemas de IA. Los proveedores con esta política solo procesan tu información para el propósito previsto, asegurando que permanezca privada y segura.

-

¿Por qué es importante una política de no entrenamiento para las empresas?

-

Una política estricta de no entrenamiento reduce los riesgos de fuga de datos, incumplimientos legales y uso indebido de la propiedad intelectual, convirtiéndose en un requisito clave para las empresas que evalúan proveedores de automatización.

-

¿Cómo protege Parseur mis datos?

-

Parseur aplica seguridad de nivel empresarial con cifrado, controles de retención, cumplimiento normativo y un compromiso estricto de no entrenamiento para garantizar que tu información nunca sea reutilizada.

-

¿Están las políticas de no entrenamiento vinculadas a normativas de cumplimiento?

-

Sí. Estándares como GDPR e ISO 27001 enfatizan la minimización de datos y la limitación del propósito. Una política de no entrenamiento se alinea directamente con estos principios, ayudando a las organizaciones a cumplir con la normativa.

-

¿Adoptarán más proveedores las políticas de no entrenamiento en el futuro?

-

Expertos del sector predicen que las políticas de no entrenamiento serán la norma, ya que las empresas exigen cada vez más transparencia, alineación con el cumplimiento y una mejor gobernanza de los datos.

Última actualización el