Cosa Significa “Nessun Addestramento sui Tuoi Dati”?

Alla base, la frase “nessun addestramento sui tuoi dati” esprime l’impegno da parte dei fornitori di AI a non utilizzare le informazioni che affidi ai loro sistemi per migliorare o addestrare i loro modelli di machine learning.

Punti Chiave

- “Nessun addestramento sui tuoi dati” garantisce che le tue informazioni vengano elaborate, ma non riutilizzate per addestrare l’AI.

- Le imprese hanno necessità di questa politica per tutelare fiducia, conformità e proprietà intellettuale.

- Parseur offre crittografia, controlli di conservazione, conformità e adozione della politica di nessun addestramento come impostazione predefinita.

Quando le aziende adottano strumenti di intelligenza artificiale, desiderano la certezza che le loro informazioni sensibili non saranno usate impropriamente, esposte a rischi né riutilizzate senza il loro consenso.

Anche tra i consumatori queste preoccupazioni sono forti: circa il 70% degli adulti non si fida che le aziende usino l’AI in modo responsabile e oltre l’80% si aspetta qualche tipo di abuso dei propri dati, secondo Protecto, a dimostrazione di come la perdita di reputazione per un cattivo utilizzo dei dati possa essere più impattante delle stesse sanzioni.

Negli ultimi anni, importanti fornitori come OpenAI, Anthropic e Microsoft sono stati sottoposti a un crescente scrutinio per le modalità di utilizzo dei dati dei clienti. Il nodo centrale resta se i dati inviati vengano lavorati solo per fornire risposte o anche usati per migliorare i modelli sottostanti.

Ecco perché “AI nessun addestramento sui tuoi dati” si sta rapidamente affermando come nuovo standard di fiducia. Questo significa che i dati del cliente vengono impiegati solo per l’elaborazione e mai inseriti nei processi di addestramento generale dei modelli. Per le organizzazioni, questa promessa diventa la base della fiducia, della conformità e dell’adozione a lungo termine dell’AI.

In questo articolo scoprirai nel dettaglio che cosa vuol dire davvero “nessun addestramento sui tuoi dati”, l’impatto sulle policy di compliance e governance aziendale, come i leader del settore la stanno adottando e come Parseur applica rigorosamente questa politica per garantire sicurezza e fiducia nell’uso dell’AI.

Cosa Significa “Nessun Addestramento sui Tuoi Dati”?

I tuoi dati vengono utilizzati esclusivamente per evadere la tua richiesta, sia che si tratti di riassumere un documento, estrarre dei campi, generare testi o analizzare schemi. Successivamente, sono eliminati o conservati in modo sicuro secondo le policy definite.

Ecco la distinzione chiave:

- Trattamento: I tuoi dati sono impiegati in tempo reale per portare a termine un’attività, come redigere un report o estrarre dettagli da una fattura. Una volta completata l’operazione, non vengono reintegrati nel sistema per fini di apprendimento.

- Addestramento: I tuoi dati finiscono nel sistema AI per migliorare il modello nel tempo. In questo modo, gli input forniti possono diventare parte della memoria del modello, con il rischio che informazioni sensibili possano essere riutilizzate o riaffiorare successivamente.

Diversi grandi sistemi di AI in passato hanno confuso questo limite, usando gli input sia per eseguire task che per addestrare i modelli. Questo approccio ha accelerato l’evoluzione della tecnologia, ma non senza rischi:

- Discrezione e riservatezza compromesse: Documenti sensibili, dati finanziari o informazioni sui clienti possono venire accidentalmente ricostruiti o esposti.

- Diritti di proprietà dei dati: Se i tuoi dati vengono impiegati per addestrare un modello, possono sorgere dubbi sulla titolarità della proprietà intellettuale.

- Sfide di conformità: In settori regolamentati come sanità, finanza e legale, l’eventuale riutilizzo non autorizzato dei dati esporrebbe l’azienda a gravi rischi.

Una rigorosa politica di non-addestramento elimina del tutto questa ambiguità. I tuoi dati vengono utilizzati esclusivamente per la funzione richiesta: non vengono riciclati per addestrare modelli, né condivisi con terzi, né riutilizzati in modo nascosto. Questo garantisce maggiore sicurezza, facilita la compliance e costruisce una relazione di fiducia tra imprese e fornitori AI.

In sintesi, “nessun addestramento sui tuoi dati” significa che i tuoi dati restano di tua proprietà: privati, sicuri e sotto il tuo controllo.

Perché le Politiche di Addestramento Dati Sono Importanti per le Imprese

Una solida politica di privacy dei dati AI non è più opzionale: è una misura fondamentale per garantire che le informazioni aziendali restino protette e non si trasformino in un possibile rischio. L’assenza di linee guida chiare espone le aziende a perdita di controllo sui dati, sanzioni, danni reputazionali e svantaggi competitivi.

Rischi del riutilizzo dei dati per l’addestramento

- Perdita di proprietà intellettuale: Metodologie aziendali, contratti o ricerche possono essere inglobati nei dati di addestramento, minando la propria esclusività.

- Violazioni normative: Regolamenti come GDPR o CCPA impongono severe restrizioni sulle modalità di trattamento dei dati. La riutilizzazione per addestramento, senza preciso consenso, può risultare in gravi sanzioni.

- Rischi di intelligence competitiva: Se i tuoi dati proprietari vengono sfruttati per potenziare un modello, le aziende concorrenti possono ottenere indirettamente un vantaggio competitivo.

Perché interessa alle aziende

Oggi le imprese che valutano soluzioni aziendali attribuiscono la massima importanza anche alle policy di privacy dei dati AI. Un recente sondaggio di The Futurum Group (2025) mostra come il 52% delle organizzazioni metta le competenze tecniche dei fornitori AI al primo posto, seguite dalla capacità di gestire dati e privacy dei dati, appena dopo (51%). Un provider che si impegna pubblicamente a non usare i dati dei clienti per l’addestramento dimostra:

- Rispetto della proprietà del dato: I clienti mantengono la titolarità della proprietà intellettuale.

- Allineamento con la conformità: Diminuiscono i rischi di violazioni e si semplificano gli audit laddove la normativa lo richiede.

- Fiducia e trasparenza: Il rapporto di lungo periodo si consolida, eliminando pratiche opache.

In sostanza, la chiarezza sulla gestione dei dati è diventata essenziale per l’adozione dell’AI. Un fornitore con rigorosa politica di non-addestramento permette di innovare con sicurezza, mantenendo sempre il pieno controllo sulla propria risorsa più preziosa: i dati.

La Prospettiva della Conformità e della Governance

Per molte aziende, adottare l’AI implica anche il rispetto di rigorosi requisiti di compliance e governance. Regolamenti come ISO 27001, GDPR e vari standard settoriali in settori come sanità, finanza e legale, richiedono che i dati siano gestiti ai massimi livelli di sicurezza e responsabilità. Il Sondaggio 2025 sull’Investment Management Compliance indica che il 57% dei responsabili compliance ritiene che l’AI costituisca la principale fonte di rischio normativo, evidenziando quanto sia fondamentale che le soluzioni rispettino ISO 27001, GDPR e le best practice di settore.

Una politica di non-addestramento aiuta immediatamente le aziende a raggiungere questi requisiti, garantendo che i dati siano usati solo per lo scopo richiesto, in linea con i principi fondamentali della compliance:

- Minimizzazione dei dati: Si trattano solo i dati strettamente necessari, riducendo l’esposizione.

- Consenso e controllo: Le informazioni non sono mai riutilizzate senza esplicito consenso.

- Limitazione dello scopo: I dati vengono gestiti solo per la finalità originaria, mai riciclati per addestramenti successivi.

Queste best practice consentono ai fornitori di AI di facilitare la compliance durante gli audit e minimizzare il rischio di sanzioni.

La governance si basa anche sulla trasparenza e pratiche standardizzate. Enti come la Electronic Commerce Code Management Association (ECCMA) lavorano quotidianamente per promuovere qualità e fiducia sui dati; le policy di non-addestramento sono espressione concreta di quest’impegno.

Scegliendo partner AI che si allineano agli standard di governance, le aziende restano conformi e pongono le basi per un’adozione dell’AI più etica e sicura.

Esempi dal Settore: Come i Big Tech Gestiscono l’Addestramento Dati

Il crescente focus sulla privacy dei dati sta spingendo anche i giganti della tecnologia a rivedere le proprie policy. Negli ultimi anni, i principali fornitori di AI hanno modificato le proprie pratiche per offrire maggiori garanzie e controllo.

- OpenAI: Per ChatGPT, i dati delle versioni gratuite e consumer possono essere raccolti per potenziare i modelli, ma gli utenti business dispongono di controlli di opt-out e rassicurazioni che prompt e output non saranno usati per training. Si riconosce, così, una netta differenza tra AI consumer e AI aziendale.

- Microsoft: Su Copilot for Microsoft 365 e Azure OpenAI Service, Microsoft garantisce isolamento totale: i dati dei clienti aziendali non vengono mai utilizzati per addestrare i modelli di base, offrendo così rassicurazioni sulla riservatezza di documenti e comunicazioni.

- Anthropic: Per Claude, Anthropic ha assunto un impegno trasparente a non utilizzare i dati delle aziende clienti per l’addestramento, rafforzando il suo posizionamento quale partner affidabile che mette controllo e sicurezza al primo posto.

Questi casi evidenziano chiaramente la nuova direzione: le imprese richiedono – e ottengono – garanzie forti sulla privacy dei dati AI. Chi non adotta queste policy rischia di restare indietro rispetto ai concorrenti più trasparenti.

Perché ‘Nessun Addestramento sui Tuoi Dati’ Costruisce Fiducia nell’AI

Alla base di qualsiasi progetto AI di successo, c’è un ingrediente fondamentale: la fiducia. Le organizzazioni adotteranno soluzioni AI su larga scala solo se possono contare su gestione responsabile e sicura delle proprie informazioni. L’indagine AI agents 2025 di PwC indica che il 28% dei leader aziendali considera la mancanza di fiducia nei sistemi AI come uno dei principali ostacoli all’adozione estesa. Se non esistono regole chiare – come la politica di non-addestramento – le aziende si sentono esposte a rischi che bloccano l’innovazione.

Una politica di non-addestramento stabilisce questi confini e alimenta la fiducia su cui basare ogni relazione cliente-fornitore AI:

- Offre rassicurazione: Le imprese vogliono la certezza che i dati riservati non diventeranno strumenti per addestrare modelli a uso altrui, proteggendo così strategie, database e finanze.

- Favorisce la trasparenza: Policy esplicite sulla gestione separata dei dati danno certezza su chi accede e per cosa, aiutando anche chi si occupa di compliance a garantire responsabilità e controllo.

- Accelera l’adozione: Quando la fiducia è garantita, aumenta la propensione a introdurre l’AI nei processi strategici, dalla finanza al customer care alla sanità. Sapere che i dati non saranno riutilizzati stimola l’uso esteso e consapevole di soluzioni automatizzate.

Nessun addestramento sui tuoi dati non è solo una policy, ma un vero vantaggio competitivo: dimostra attenzione per la fiducia del cliente e apre la strada a una più rapida e sicura integrazione delle tecnologie AI.

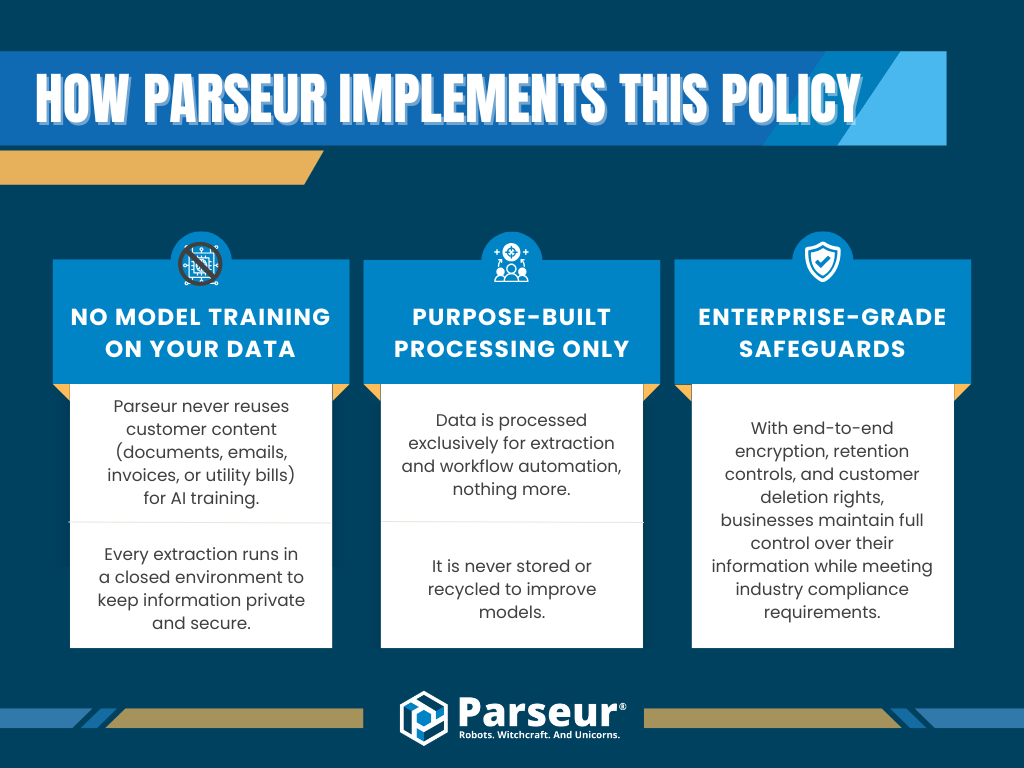

Come Parseur Applica Questa Politica

In Parseur, privacy e conformità dei dati sono valori fondamentali nella progettazione della piattaforma. Siamo consapevoli che molte aziende esitano ad adottare AI perché non è chiaro come saranno trattate le loro informazioni. Parseur adotta una posizione netta: i tuoi dati rimangono sempre tuoi, e non saranno mai impiegati per addestrare sistemi di AI.

In concreto:

- Nessun addestramento sui tuoi dati: Parseur non riutilizza mai il contenuto dei clienti (documenti, email, fatture) per addestrare i propri modelli AI. Ogni estrazione avviene in ambienti isolati, garantendo la massima riservatezza.

- Elaborazione limitata allo scopo: I dati vengono elaborati solo per estrazione e automazione del workflow, senza essere mai trattenuti o destinati a futuri miglioramenti dei modelli.

- Sicurezza di livello enterprise: Grazie a crittografia end-to-end, controlli di conservazione rigorosi e opzioni di cancellazione, le aziende mantengono il pieno controllo e sono conformi agli standard del settore.

La rigida politica di non-addestramento di Parseur protegge le informazioni e costruisce una fiducia duratura verso l’AI. Le organizzazioni possono così potenziare l’automazione senza il timore di data breach, rischi IP o infrazioni regolamentari.

Grazie a trasparenza, governance e solide misure di sicurezza, Parseur consente di adottare l’automazione mantenendo la privacy come priorità.

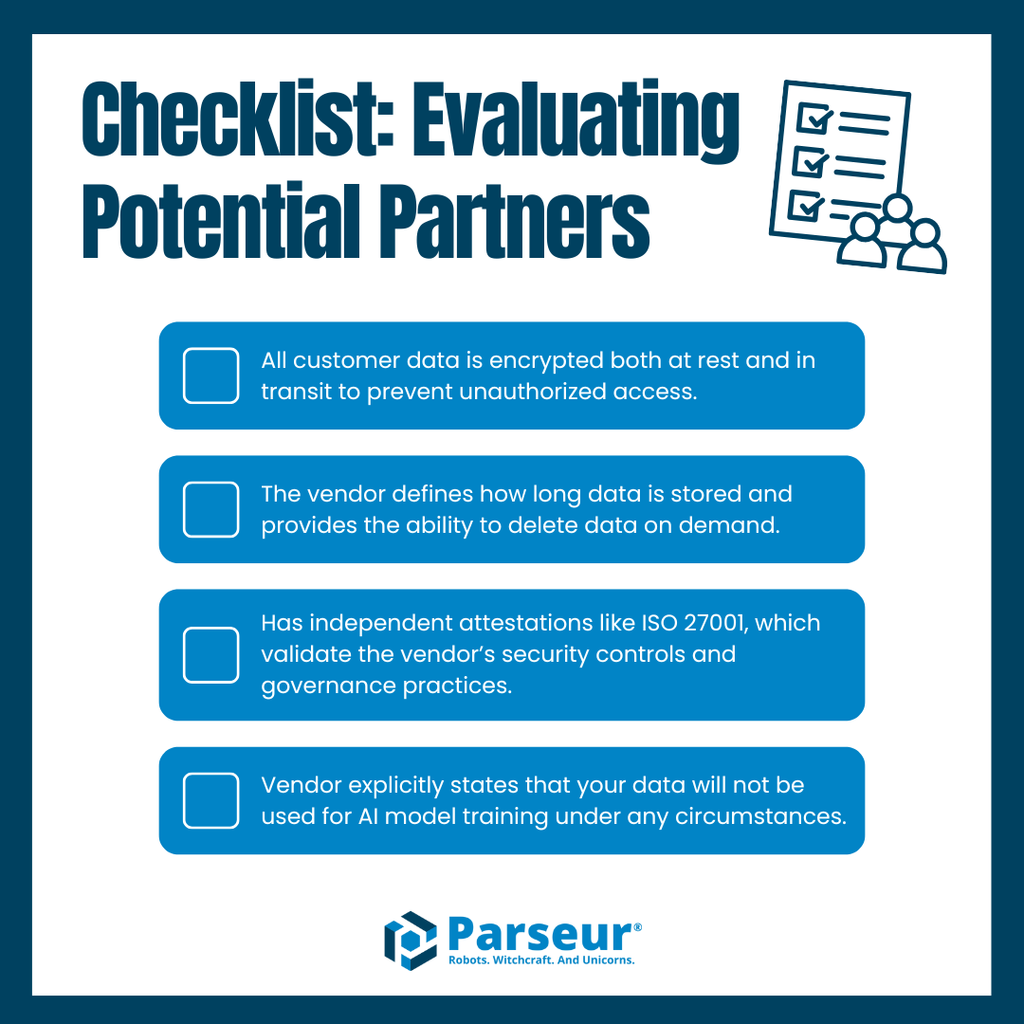

Best Practice per la Valutazione dei Fornitori

La scelta di un fornitore AI o di automazione oggi va ben oltre il confronto delle funzionalità: la priorità è assicurarsi che la gestione dei dati rispetti pienamente i requisiti di sicurezza, compliance e governance, per evitare rischi o esposizioni indesiderate.

Nella valutazione dei fornitori, segui questa checklist:

- Crittografia dei dati: Assicurati che i dati siano sempre criptati, sia a riposo che in transito, contro ogni accesso non autorizzato.

- Policy di conservazione: Pretendi chiarezza sulle tempistiche di conservazione e possibilità di cancellare i dati su richiesta.

- Certificazioni di conformità: Preferisci fornitori con attestazioni riconosciute, come ISO 27001, a conferma di controlli e governance adeguati.

- Impegno esplicito al non-addestramento: Assicurati che il fornitore dichiari che i tuoi dati non saranno mai utilizzati per addestrare modelli AI, in nessun caso.

Un fornitore che non garantisce trasparenza rischia di esporre ai rischi di conformità e privacy. Al contrario, chi rispetta queste best practice offre basi solide di fiducia e affidabilità.

Parseur si distingue nettamente. Con crittografia sempre attiva, policy di conservazione chiare, certificazioni ufficiali e una rigorosa politica di non-addestramento, Parseur offre alle aziende una piattaforma di automazione affidabile e trasparente. Ogni cliente sa sempre come vengono trattati i propri dati, rendendo Parseur un partner su cui contare.

Perché la Fiducia Definisce il Futuro dell’Automazione

La fiducia è il criterio principale nella scelta delle soluzioni di automazione e gestione dati. Gestendo informazioni sempre più sensibili, per le aziende è essenziale conoscere nel dettaglio come i fornitori gestiscono e proteggono i dati. Il principio di “nessun addestramento sui tuoi dati” ne è elemento fondamentale.

Guardando al futuro, la richiesta di trasparenza e accountability sarà sempre più diffusa. Gli esperti ritengono che, a breve, le aziende pretenderanno routine policy di conservazione trasparenti, crittografia by default, certificazioni riconosciute e rassicurazioni scritte che i dati non saranno mai impiegati per addestramento dei modelli. Chi non si adeguerà rischierà di perdere fiducia e quote di mercato dove compliance e sicurezza non possono essere negoziate.

Parseur è progettato per questo scenario. Con crittografia di livello enterprise, controlli di conservazione stringenti, conformità certificata e una precisa politica di non-addestramento, Parseur consente di automatizzare processi in modo scalabile, senza rinunciare a sicurezza o privacy.

Scopri come Parseur protegge i tuoi dati con sicurezza enterprise e una rigorosa politica di non-addestramento, fornendo alle aziende la fiducia necessaria per automatizzare i workflow in modo sicuro, trasparente e scalabile.

Domande Frequenti

Man mano che le aziende esplorano strumenti di automazione ed estrazione dati, emergono spesso domande sulla sicurezza dei dati, sulla conformità e le pratiche dei fornitori. Ecco le domande più comuni che le aziende pongono sulle politiche di non-addestramento e su come queste influenzano la fiducia nell’automazione.

-

Cosa significa “nessun addestramento sui tuoi dati”?

-

Questa politica garantisce che i tuoi dati non vengano mai riutilizzati per addestrare modelli di machine learning o sistemi di AI. I fornitori con questa politica trattano le tue informazioni solo per lo scopo previsto, assicurando che restino private e sicure.

-

Perché una politica di non-addestramento è importante per le aziende?

-

Una rigorosa politica di non-addestramento riduce i rischi di perdita di dati, violazioni di conformità e uso improprio della proprietà intellettuale, diventando un requisito fondamentale per le aziende che valutano fornitori di automazione.

-

Come protegge i miei dati Parseur?

-

Parseur applica sicurezza di livello aziendale con crittografia, controlli di conservazione, allineamento alla conformità e un forte impegno a non addestrare, garantendo che le tue informazioni non vengano mai riutilizzate.

-

Le politiche di non-addestramento sono collegate alle normative sulla conformità?

-

Sì. Standard come il GDPR e la ISO 27001 sottolineano la minimizzazione dei dati e la limitazione dello scopo. Una politica di non-addestramento si allinea direttamente a questi principi, aiutando le organizzazioni a rimanere conformi.

-

In futuro più fornitori adotteranno politiche di non-addestramento?

-

Gli esperti di settore prevedono che le politiche di non-addestramento diventeranno la norma, poiché le aziende richiedono sempre più trasparenza, allineamento normativo e una governance dei dati più solida.

Ultimo aggiornamento il