Principais Insights:

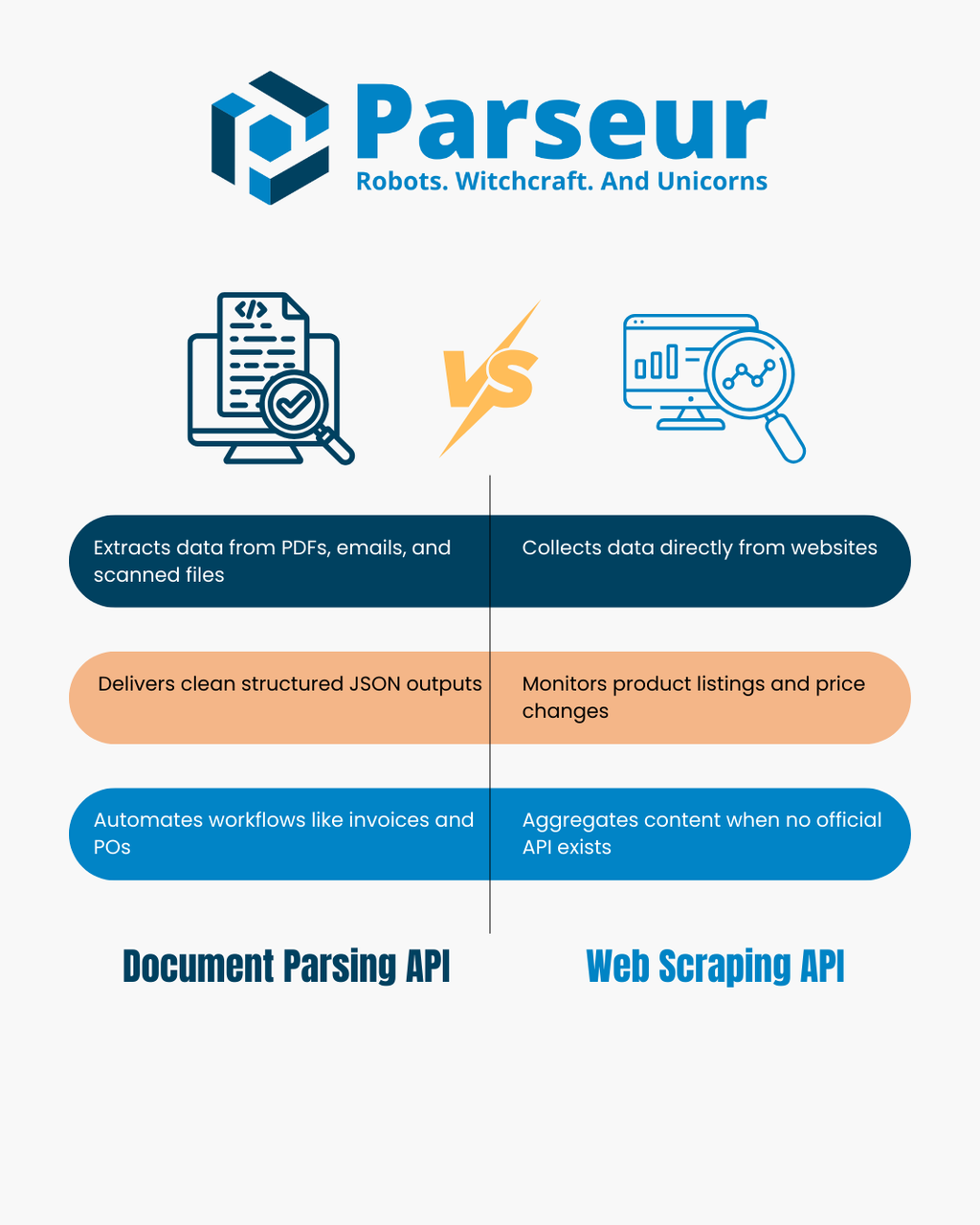

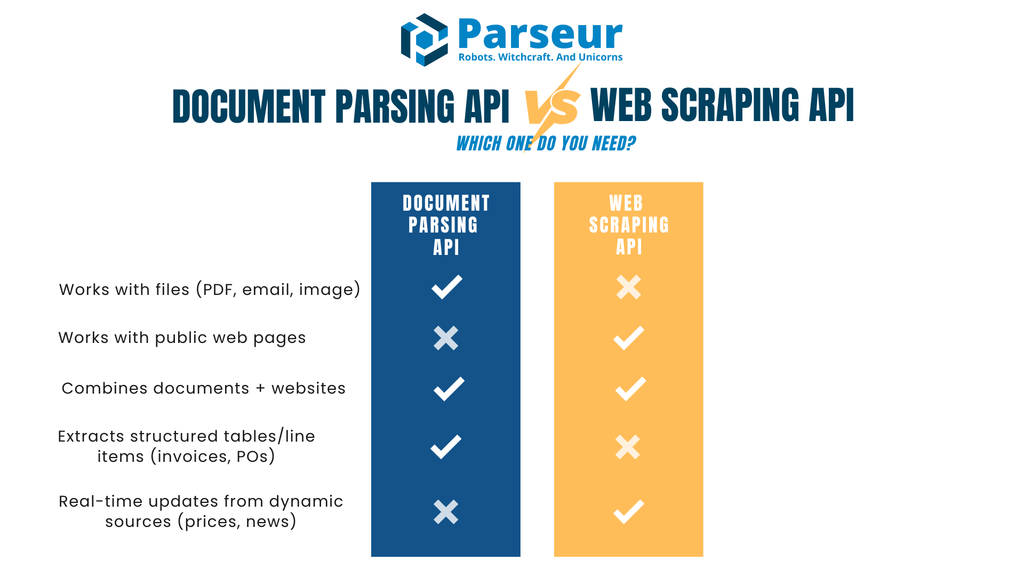

- APIs de extração de documentos extraem dados estruturados de arquivos como PDFs, imagens e e-mails que você já possui ou recebe.

- APIs de web scraping coletam informações de páginas web públicas ao analisar HTML ou conteúdo renderizado.

- Sua escolha depende da fonte dos seus dados: arquivos recebidos vs sites a monitorar.

- Muitas equipes usam fluxos de trabalho híbridos — scraping para obter documentos e extração para gerar JSON confiável.

API de Extração de Documentos vs API de Web Scraping

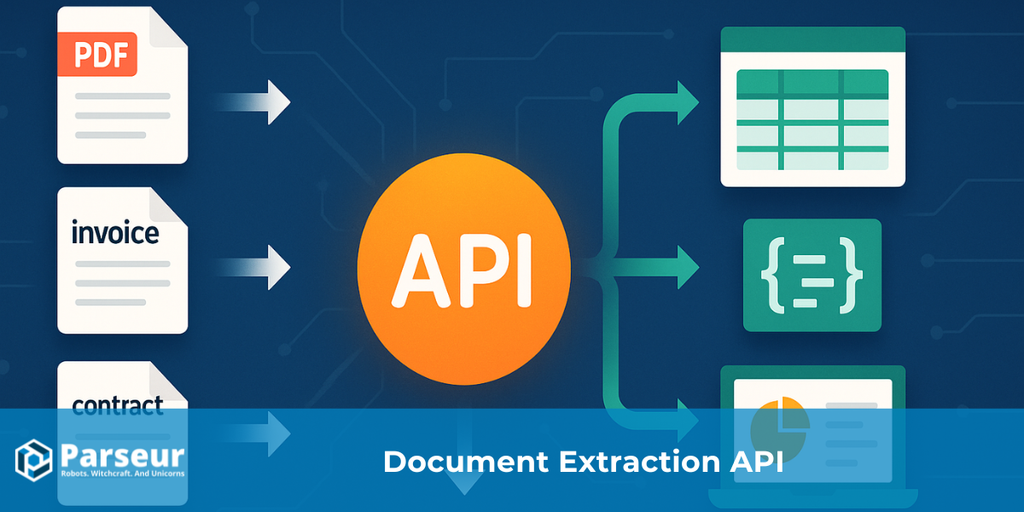

Uma API de extração de documentos converte arquivos como PDFs, imagens digitalizadas e e-mails em JSON estruturado. Analisa o layout e o texto do documento para extrair pares chave-valor e tabelas, facilitando a automação de processos como gestão de faturas, ordens de compra ou fluxo de dados de e-mails para bancos de dados.

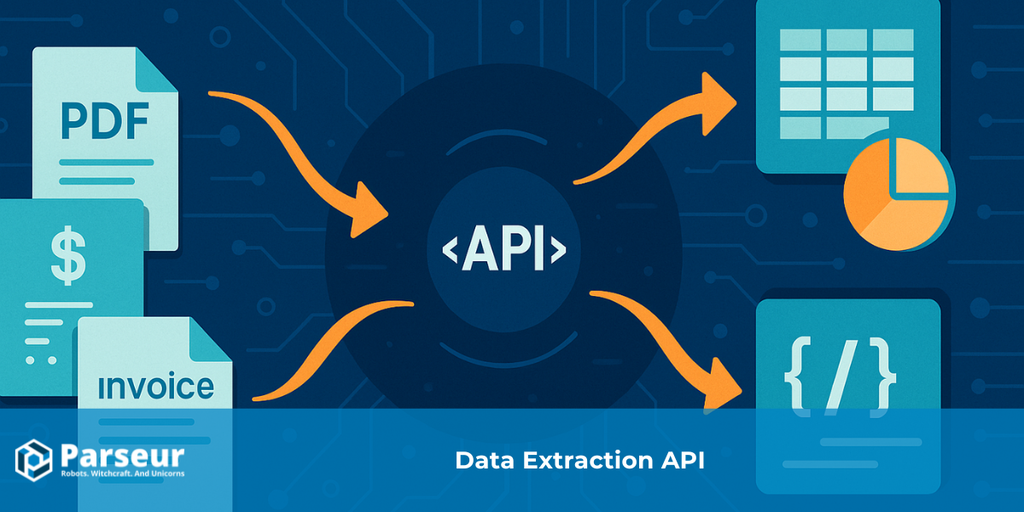

Uma API de web scraping coleta dados diretamente de sites por meio da busca programática de páginas web e análise do HTML ou DOM renderizado. Na ausência de uma API pública, web scraping costuma ser usado para monitorar listas de produtos, rastrear preços, agregar notícias ou montar conjuntos de dados robustos.

Ambas extraem dados, mas de fontes distintas: APIs de extração de documentos trabalham com arquivos que você já possui, enquanto APIs de web scraping extraem dados de páginas web que você visita. Este artigo compara seus pontos fortes, limitações, traz uma árvore de decisão, tabela de comparação e exemplos práticos. Para um panorama amplo de automação de dados, consulte nosso Guia de API de Extração de Dados.

Como Funcionam as APIs de Extração de Documentos e de Web Scraping

APIs de extração de documentos e de web scraping fazem parte do ecossistema de extração de dados, mas solucionam demandas diferentes. Entender o funcionamento prático de cada uma é fundamental para tomar decisões estratégicas.

Segundo a Scrapingdog, 34,8% dos desenvolvedores usam APIs de web scraping, evidenciando uma clara tendência à extração estruturada e pronta para uso, em detrimento à manutenção de scripts de scraping personalizados.

API de extração de documentos

APIs de extração de documentos têm foco em retirar informações de arquivos que sua empresa ou seus usuários já possuem e recebem de forma legítima: PDFs, imagens, e-mails com anexos ou documentos de escritório. Ao invés de inserir manualmente os dados, a API interpreta e entende a estrutura interna do arquivo, localizando os elementos de interesse.

- Entradas: PDFs, digitalizações, imagens, e-mails, arquivos do Office.

- Saídas: JSON organizado, com campos, pares chave-valor, tabelas e dados relevantes definidos por você.

- Como funciona: A API utiliza OCR e regras de extração que identificam blocos de texto, números, tabelas e campos relevantes. O resultado é transformado em um formato consistente para integração com sistemas downstream (como CRMs, ERPs ou bancos de dados).

- Casos de uso típicos: Processamento automático de faturas e recibos, extração de itens de ordens de compra, leitura de extratos financeiros, gestão de grandes volumes de formulários e parsing de e-mails para disparar automações no Zapier, Make ou n8n.

API de web scraping

A API de web scraping foi projetada para extrair dados da web aberta. Ao invés de arquivos, ela busca informações diretamente dos sites e transforma o conteúdo em formatos estruturados. Pode envolver análise de HTML bruto, renderização headless e aplicação de seletores CSS ou execução de scripts para captar campos específicos.

- Entradas: URLs, HTML de páginas web, endpoints JSON públicos.

- Saídas: Dados estruturados em JSON ou CSV, prontos para análise ou integração.

- Como funciona: Carrega páginas, analisa o DOM e usa seletores CSS/XPath para extrair informações como nome, preço de produtos, manchetes, listas e tabelas. Algumas ferramentas já gerenciam proxies e anti-bot para raspagem em escala.

- Casos de uso típicos: Monitoramento de preços em lojas virtuais, coleta de catálogos de produtos, agregação de notícias, rastreamento de vagas ou construção de datasets quando não existe API pública.

Essencialmente, as APIs de extração de documentos são ideais para dados em arquivos sob sua posse; APIs de web scraping brilham para dados publicados em sites.

Árvore de Decisão: Qual Você Precisa?

A decisão entre API de extração de documentos ou de web scraping depende da origem de seus dados e do que deseja fazer, e do objetivo final do que você quer alcançar. Veja o fluxograma abaixo para mapear rapidamente qual abordagem resolve melhor sua necessidade com explicações práticas para cada caminho.

!

O seu dado está em um arquivo (PDF, imagem ou anexo de e-mail) que você possui legitimamente?

→ Opte por uma API de Extração de Documentos. Ela transforma esses arquivos em JSON limpo, extrai campos-chave e detalhes de tabelas automaticamente, sem entrada de dados manual.

Sua fonte é uma página web pública ou conjunto de dados online?

→ Use uma API de Web Scraping. Ela busca HTML/renderizações de sites e permite extrair os pontos de dados específicos de que você precisa, como listas de produtos ou notícias.

Trabalha tanto com arquivos quanto com páginas de sites?

→ Em alguns casos, será necessário um fluxo híbrido. Por exemplo, talvez seja preciso raspar um portal de fornecedor para baixar PDFs e, em seguida, passar esses PDFs para uma API de extração de documentos para obter dados estruturados.

Precisa extrair tabelas ou itens detalhados (como faturas, recibos, ordens de compra)?

→ APIs de Extração de Documentos se destacam nesses cenários. Elas são projetadas para lidar com dados tabulares e financeiros, onde precisão e consistência do esquema são essenciais.

Precisa de atualizações em tempo real de fontes dinâmicas (preços, notícias)?

→ Aqui, a API de Web Scraping oferece mais agilidade para monitorar conteúdos que mudam frequentemente.

O fluxograma ajuda a alinhar o seu contexto à ferramenta indicada, ou à combinação delas.

Comparativo: API de Extração x Web Scraping

Veja lado a lado as principais características, pontos fortes e desafios de cada abordagem:

| Critério | API de Extração de Documentos | API de Web Scraping |

|---|---|---|

| Entrada Primária | Arquivos como PDFs, imagens digitalizadas e e-mails | Páginas web (HTML/JSON) ou DOM renderizado |

| Saídas Típicas | JSON com campos, tabelas e dados estruturados | HTML convertido em JSON/CSV via seletores |

| Sensibilidade a Mudanças | Estável: tipologias configuradas mantêm parsing consistente | Mudanças em layout/DOM quebram seletores facilmente |

| Casos de Uso | Faturas, ordens de compra, contratos, formulários, extratos financeiros, e-mails | Catálogos de produtos, atualização de preços, vagas, notícias |

| Aquisição | Você ou seus usuários fornecem os documentos | Dados coletados diretamente de sites de terceiros |

| Foco Legal | Privacidade, papéis de controlador/processador, políticas de retenção | Termos de Serviço, robots.txt, proteções anti-bot |

| Latência & Escala | Trabalha bem com lotes, processamento assíncrono e entrega via webhook | Limitado por crawl-rate, anti-bot, concorrência |

| Manutenção | Ajuste ocasional de template ou esquema | Seletores e anti-bot precisam manutenção frequente |

| Qualidade dos Dados | Estruturada, validada, normalização de campos | Depende de limpeza do HTML/site |

| Segurança | Criptografia total, webhooks assinados, acesso por papéis | Necessidade de proxies, rotação IP, segurança de rede |

| Adaptação a LLM | Ideal para entrada JSON estruturada em sistemas de IA/ML downstream | Ideal para enriquecimento, sumarização ou classificação de texto não estruturado |

| Quando Usar | Quando você já recebe documentos (faturas, recibos, contratos) | Quando você precisa de conteúdo web atualizado (preços, estoques, manchetes) |

Quando API de Web Scraping é a Escolha Certa (E Boas Práticas de Uso)

APIs de web scraping são recomendadas quando o dado desejado está disponível apenas em sites, sem acesso via download ou arquivo. Permitem capturar informações em larga escala, sem depender de envio de parceiros ou clientes. São ótimas para pesquisas de mercado, monitoramento de preços e projetos que exigem atualização frequente.

Dados do setor do Browsercat mostram que o mercado global de web scraping foi avaliado em cerca de US$ 1,01 bilhão em 2024 e deve chegar a US$ 2,49 bilhões até 2032, crescendo a uma taxa composta de 11,9% ao ano (CAGR).

Exemplos típicos onde web scraping faz a diferença:

- Monitoramento automatizado de preços e disponibilidade de produtos em várias lojas virtuais

- Agregação de manchetes ou comunicados de múltiplas fontes de notícias

- Construção de bancos de dados de vagas, diretórios, eventos, quando não existe API pública

Por ser baseado em sites de terceiros, o web scraping exige responsabilidade:

- Sempre confira o robots.txt e termos de uso antes de começar

- Respeite limites de acesso, evitando sobrecarregar servidores

- Implemente cache para reduzir requisições repetidas

- Identifique adequadamente seu scraper (sem mascarar user-agent)

- Prefira APIs oficiais se estiverem disponíveis

Sites mudam frequentemente. Pequenas atualizações quebram seletores e podem gerar dados incorretos. É essencial configurar monitoramento e alertas para corrigir rapidamente essas falhas.

Em muitos fluxos, scraping não é uma solução isolada. Por exemplo, você pode usar scraping para encontrar ou baixar arquivos PDF em um portal de fornecedor e, em seguida, usar uma API de extração de documentos para gerar JSON estruturado. Assim, combina-se o alcance do scraping com a precisão do parsing.

Desafios Comuns das APIs de Web Scraping

Web scraping é uma excelente estratégia para captar dados em tempo real, mas apresenta desafios importantes que exigem atenção. Conhecer essas dificuldades ajuda a definir expectativas realistas e mostra por que o scraping é mais adequado para determinados casos que para outros.

Segundo Octoparse, apenas cerca de 50% dos sites são fáceis de raspar, enquanto 30% apresentam dificuldade moderada e 20% são altamente complexos por conta de estruturas sofisticadas ou barreiras anti-scraping.

Mudanças constantes nos sites

Sites mudam frequentemente e raramente pensam em raspadores. Mesmo pequenas alterações na estrutura do HTML, como a troca de classes CSS ou o reposicionamento de elementos, podem inviabilizar scripts/API de scraping, exigindo manutenção regular.

Barreiras anti-bot

Vários sites usam CAPTCHAs, limitação de IP, validações de sessão ou algoritmos de detecção de bots. Para contornar, equipes de scraping precisam adotar proxies, alternar user-agents e limitar taxas de requisição — tudo isso aumenta a complexidade operacional.

Questões legais e éticas

Web scraping atua em uma zona cinzenta legal. Raspar dados públicos é muitas vezes permitido, mas ignorar termos de uso, diretrizes de robots.txt ou burlar paywalls pode gerar riscos legais e de compliance. É fundamental traçar diretrizes éticas e buscar suporte jurídico sempre que necessário.

Qualidade e consistência dos dados

Sites são feitos para humanos, não para máquinas. Dados extraídos exigem limpeza e validação adicionais. Estruturas HTML inconsistentes, conteúdo gerado via JavaScript ou registros duplicados resultam em dados despadronizados que podem precisar de processamento adicional antes de uso.

Escalabilidade

Ampliar operações de scraping não é apenas aumentar requisições. Para scraping em alta escala, são necessários forte infraestrutura, lógica de retry, manuseio de erros e workloads distribuídos. Os custos com proxies, servidores e monitoramento podem aumentar rapidamente.

Sustentação de longo prazo

Scraping tende a ser uma solução frágil para processos contínuos. Fluxos de scraping exigem ajustes constantes ao contrário de APIs oficiais ou arquivos estruturados. A empresa precisa destinar recursos à manutenção contínua.

Quando a API de Extração de Documentos é a Melhor Solução

APIs de extração de documentos são indicadas sempre que a informação chega até você em formato de arquivo e não está publicada como página web. PDFs, digitalizações e e-mails anexados são exemplos frequentes. Ao invés de redigitar manualmente para o banco de dados ou ERP, a API reduz o trabalho manual e entrega dados prontos para sistemas, sem erro de transcrição.

De acordo com a Sphereco, 80% dos dados empresariais são não estruturados — PDFs, e-mails, digitalizações — tornando APIs de extração essenciais para eficiência e insights.

Principais aplicações:

- Processamento de faturas e recibos: Extração de fornecedores, datas, totais e tabelas de itens para contas a pagar

- Ordens de compra e extratos: Captação de números de pedidos, valores, prazos e condições

- Formulários e contratos: Retirada de campos padronizados como dados do cliente ou datas de assinatura

- E-mails operacionais: Conversão de confirmações de pedido, avisos de envio ou solicitações em JSON para integração com sistemas downstream

Uma API de extração de documentos se destaca quando você precisa de precisão, consistência e estabilidade. Ela não só extrai texto como pode normalizar formatos, validar campos e entregar resultados via webhooks diretamente para sua aplicação ou banco de dados.

O parsing de documentos é mais estável que o web scraping porque a estrutura dos arquivos muda menos do que a do HTML dos sites. Com as instruções configuradas, as mesmas regras tratam milhares de documentos de maneira confiável.

Se sua empresa depende do processamento de documentos de fornecedores, extratos de clientes ou e-mails, a API de extração tende a ser a solução mais rápida e sustentável.

Padrões Híbridos: Sinergia no Mundo Real

Web scraping e extração de documentos são soluções complementares. Na prática, muitas empresas possuem dados vindo de fontes distintas — arquivos e sites — e combinam ambos para uma automação mais poderosa.

Exemplos de integração híbrida:

- Raspagem para baixar PDFs e extrair dados: Um portal pode hospedar faturas ou extratos como PDFs para download. Use API de web scraping para fazer login e buscar os arquivos, enquanto a API de extração de documentos extrai itens, totais e estrutura o restante dos dados.

- Enriquecimento de dados de documentos com scraping: Após extrair faturas, talvez precise de metadados adicionais como categorias de fornecedor ou benchmarks. Uma API de scraping coleta este contexto de fontes públicas enquanto a API de parsing assegura a precisão financeira.

- Parsing de e-mails validando informações em sites: Confirmações de pedido e avisos de envio chegam por e-mail. Extraia detalhes diretamente e use API de scraping para checar estoque ou preços em tempo real no site do fornecedor.

- Camadas de inteligência: Uma vez obtido o JSON estruturado dos documentos, conecte-o com dados de sites via scraping e aplique análises ou categorização. Assim, normaliza nomes de fornecedores, detecta anomalias ou associa produtos de diferentes fontes.

A abordagem híbrida potencializa o melhor de cada método. Parsing oferece saída estruturada e baseada em esquema, enquanto scraping amplia o alcance a dados da web. Usando ambos, reduz-se o trabalho manual e a automação cresce de ponta a ponta.

Parseur é API de Extração de Documentos ou de Web Scraping?

O Parseur é uma poderosa API de extração de documentos e e-mails — transforma documentos desestruturados em dados JSON estruturados. Diferente das APIs de web scraping, que extraem informações diretamente de sites, o foco do Parseur está nos documentos e e-mails que você (ou usuários) já possuem. Isso garante estabilidade e escala para automatizar rotinas sem risco de mudanças de sites, bloqueios de scraping ou problemas de renderização. Com Parseur você automatiza fluxos como faturas, recibos, ordens de compra e formulários de clientes.

Na prática, isso significa:

- O que o Parseur faz: Recebe e-mails, PDFs, imagens e arquivos do Office e retorna JSON estruturado com campos chave-valor e tabelas de itens. O envio pode ser feito via webhook ou acesso direto pela API.

- Abordagem ao tratamento de dados: O Parseur funciona estritamente na função de processador, sob seu comando. Oferece Contrato de Processamento de Dados (DPA), lista transparente de subprocessadores, políticas de retenção/deleção configuráveis, criptografia em trânsito e em repouso e entrega segura via webhooks assinados.

- Para quem é ideal: Equipes que recebem documentos principalmente por e-mail (como faturas, recibos, ordens de compra, extratos financeiros) e precisam de extração estruturada rápida, estável e com pouco código.

Por que Parseur API é Diferente

O maior diferencial do Parseur API é que combina API e aplicativo web. Desenvolvedores integram a API diretamente nos sistemas, enquanto times de Suporte ou Operações usam o app web para monitorar, revisar e otimizar extrações sem precisar de desenvolvimento extra.

Essa combinação economiza tempo dos desenvolvedores, evitando a criação de dashboards próprios — tipicamente complexos e custosos de manter. No aplicativo web, usuários definem o esquema do JSON, criam campos com poucos cliques, ajustam instruções em tempo real e validam a extração. Assim, equipes técnicas e de negócio colaboram melhor e a integração fica mais leve.

Diferente de APIs de scraping (sensíveis às mudanças dos sites), o Parseur trabalha com arquivos em sua posse, formando uma base estável para automações críticas.

Como o Parseur Trata Dados

Embora o Parseur não atue como API de scraping, ele foi projetado para processar documentos e e-mails de forma eficiente e segura. Para times que dependem de PDFs, imagens digitalizadas ou anexos, o Parseur transforma esses arquivos em JSON estruturado, pronto para automações e integração em escala.

O compromisso do Parseur com segurança, privacidade e compliance é destaque. Empresas confiam no Parseur sabendo que suas informações são tratadas com responsabilidade e alinhadas às normas globais mais rígidas.

Destaques da proteção de dados no Parseur

Feito para documentos e e-mails

O Parseur recebe PDFs, imagens e conteúdo de e-mails e, depois, entrega JSON organizado via webhooks ou chamadas de API. Assim, times automatizam desde gestão de faturas até fluxos e-mail-para-banco de dados, sem necessidade de grande desenvolvimento customizado.

Controle total sobre os dados

Você é proprietário do dado que envia ao Parseur. O Parseur só processa informações sob instrução explícita do cliente, e a retirada pode ser definida para qualquer período a partir de um dia. O recurso Processar e Deletar permite excluir documentos imediatamente após a extração.

Localização de armazenamento

Todos os dados Parseur ficam armazenados de forma segura na União Europeia (Holanda), em data center Google Cloud Platform (GCP), com certificação ISO 27001. Veja detalhes.

Criptografia e boas práticas

Todos os dados são criptografados em repouso via AES-256 e em trânsito via TLS v1.2 ou superior. Protocolos antigos (SSLv2, SSLv3, TLS 1.0, TLS 1.1) são desativados. O Parseur utiliza certificados Let's Encrypt SSL, padrão global para proteger comunicações.

Monitoramento e testes de segurança

O Parseur monitora infraestrutura e dependências continuamente, aplicando correções ao identificar vulnerabilidades. Empresas terceirizadas fazem testes de penetração regulares com base em frameworks como OWASP Top 10 e SANS 25. Clientes enterprise podem solicitar relatórios completos. Em 2025, o Parseur também recebeu o Certificado Astra Pentest como reconhecimento de sua resiliência em cibersegurança.

Segurança de senhas e proteção de conta

Senhas nunca são armazenadas em texto puro. O Parseur usa PBKDF2 com SHA-256, salt de 512 bits e 600 mil iterações — muito acima do recomendado pelo NIST.

Alta disponibilidade e SLA

A meta de uptime do Parseur é de 99,9% ou mais, com retry e backoff automáticos para prevenir perda de dados em falhas. As plataformas de coleta de e-mails fazem retry por até 24 horas, e há redundância nos envios. Planos enterprise chegam a 99,99% de uptime com garantias extras. Veja uptime histórico.

Conformidade com GDPR e privacidade

O Parseur é totalmente compatível com a GDPR e só processa sob seu controle. Você é controlador, mantém propriedade dos dados e o Parseur nunca vende nem compartilha informação. O acesso pela equipe só ocorre quando você solicita suporte, e há treinamento contínuo em proteção de dados. Saiba mais sobre Parseur e GDPR.

Resposta a incidentes e notificações

Em caso raro de violação de dados, o Parseur notifica os clientes em até 48 horas, garantindo total transparência e aderência às normas. Veja também o Panorama de Segurança e Privacidade do Parseur

Legalidade e Compliance na Extração de Dados

A dimensão legal é central ao adotar APIs de extração de documentos ou de web scraping, pois cada abordagem implica obrigações distintas conforme a origem dos dados.

É fundamental garantir base jurídica para processar documentos, normalmente por meio de acordos claros com o titular dos dados, definição de papéis conforme regulações de proteção de dados (controlador/processador), a implementação de um Contrato de Processamento de Dados e políticas de retenção. O fluxo de parsing deve também prever notificações de incidentes e práticas de minimização.

No caso do web scraping, a questão é mais complexa: algumas legislações toleram a raspagem de dados públicos, mas muitos sites proíbem explicitamente via termos de serviço ou robots.txt. Burlar paywalls, controles de acesso ou anti-bot aumenta riscos legais e de compliance — consulte sempre o jurídico para garantir aderência contratual e regulatória.

A transferência internacional de dados adiciona uma camada extra de exigência: se o fluxo envolver dados pessoais de países como União Europeia, mecanismos de transferência adequados serão necessários.

Conclusão: Quando Usar API de Extração de Documentos ou Web Scraping

Os dois tipos de API desempenham papéis estratégicos na automação, mas cada um é mais adequado a um cenário distinto. A extração de documentos é a escolha número um para arquivos próprios (faturas, extratos, e-mails etc.).

Segundo a Experlogix, a automação documental pode reduzir em até 80% o tempo de processamento, demonstrando o potencial das APIs de extração.

APIs de web scraping são ideais quando sua base de dados está em sites públicos, como catálogos, preços ou listas. Em muitos fluxos, usa-se scraping para coletar arquivos e parsing para gerar saída estruturada.

Resumindo: escolha de acordo com sua fonte. Se recebe PDFs, digitalizações ou e-mails, a API de extração poupa tempo e garante precisão. Se seus dados estão em páginas web, API de scraping é o melhor caminho. Para empresas que lidam com fontes múltiplas, combinar ambas oferece uma solução completa.

Perguntas Frequentes

Muitos leitores têm dúvidas comuns ao comparar extração de documentos e web scraping. Abaixo estão respostas para algumas das perguntas mais frequentes para ajudar a esclarecer suas diferenças e casos de uso práticos.

-

Extração de documentos é a mesma coisa que web scraping?

-

Não. A extração de documentos trabalha com arquivos como PDFs, imagens digitalizadas ou e-mails que você já possui ou recebeu, enquanto o web scraping extrai dados de sites analisando HTML ou conteúdo renderizado.

-

Parseur é uma ferramenta de API de web scraping?

-

Não. Parseur é uma API de extração de documentos e e-mails, não uma ferramenta de web scraping. Ele não rastreia ou busca páginas da web. Em vez disso, ajuda você a transformar documentos que possui, como e-mails, PDFs, imagens ou arquivos de escritório, em JSON limpo e estruturado. Isso o torna ideal para fluxos de trabalho como processamento de faturas, recibos e ordens de compra sem precisar construir ferramentas internas complexas.

-

Web scraping é legal?

-

Depende do contexto. A raspagem de dados públicos às vezes é permitida, mas muitos sites detalham restrições em seus termos de uso ou no arquivo robots.txt. Sempre revise esses documentos e consulte assessoria jurídica antes de prosseguir.

-

Quando devo evitar o scraping?

-

O scraping deve ser evitado quando os dados estão atrás de paywalls, sujeitos a controles de acesso rígidos ou explicitamente proibidos pelos termos de serviço do site. Tentar burlar restrições pode criar riscos de conformidade e legais.

Última atualização em