Puntos clave:

- Las APIs de análisis de documentos extraen datos estructurados de archivos que posees, como PDFs, imágenes y correos electrónicos.

- Las APIs de scraping web recogen información de páginas web públicas analizando HTML o contenido renderizado.

- La elección correcta depende de tu fuente de datos: archivos que recibes vs sitios web que quieres monitorear.

- Muchos equipos emplean flujos de trabajo híbridos, usando scraping para obtener documentos y análisis para extraer un JSON confiable.

API de análisis de documentos vs API de scraping web

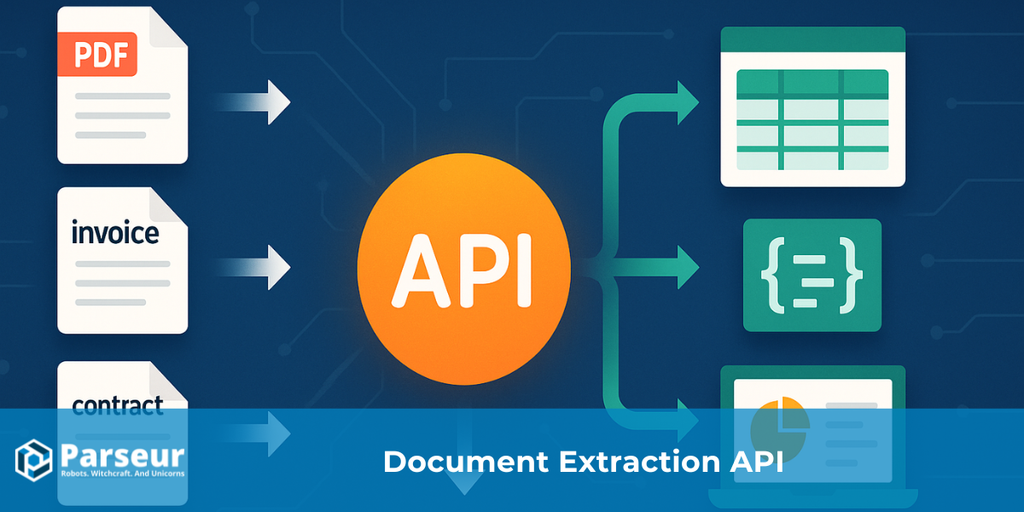

Una API de análisis de documentos convierte archivos como PDFs, imágenes escaneadas y correos electrónicos en JSON estructurado. Analiza el diseño y el texto del documento para extraer pares clave-valor y tablas, facilitando la automatización de procesos como la gestión de facturas, el seguimiento de órdenes de compra o flujos de trabajo de email a base de datos.

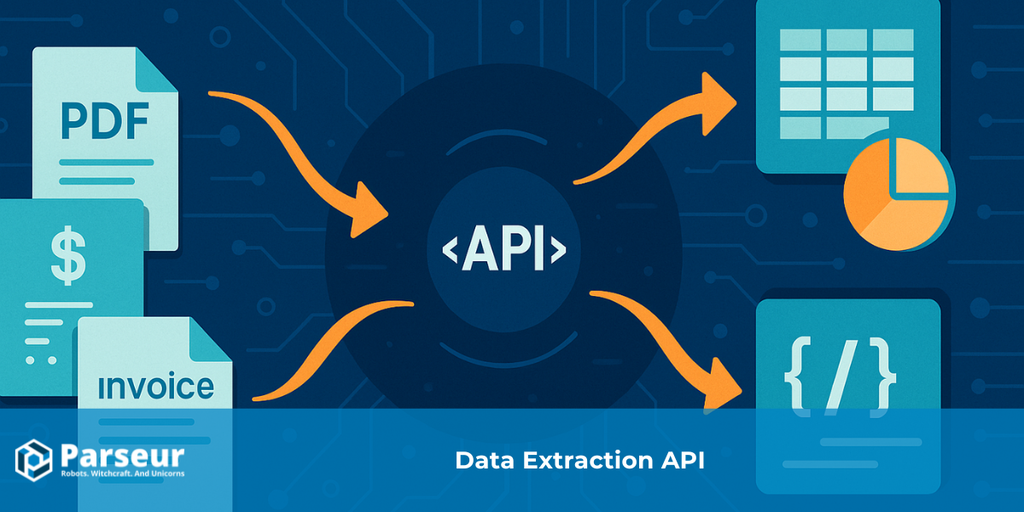

Una API de scraping web recolecta datos directamente de sitios web obteniendo las páginas de manera programática y analizando el HTML o el DOM renderizado. Cuando no existe una API oficial, el scraping web suele usarse para monitorizar productos, seguir cambios de precios, agregar noticias o construir conjuntos de datos.

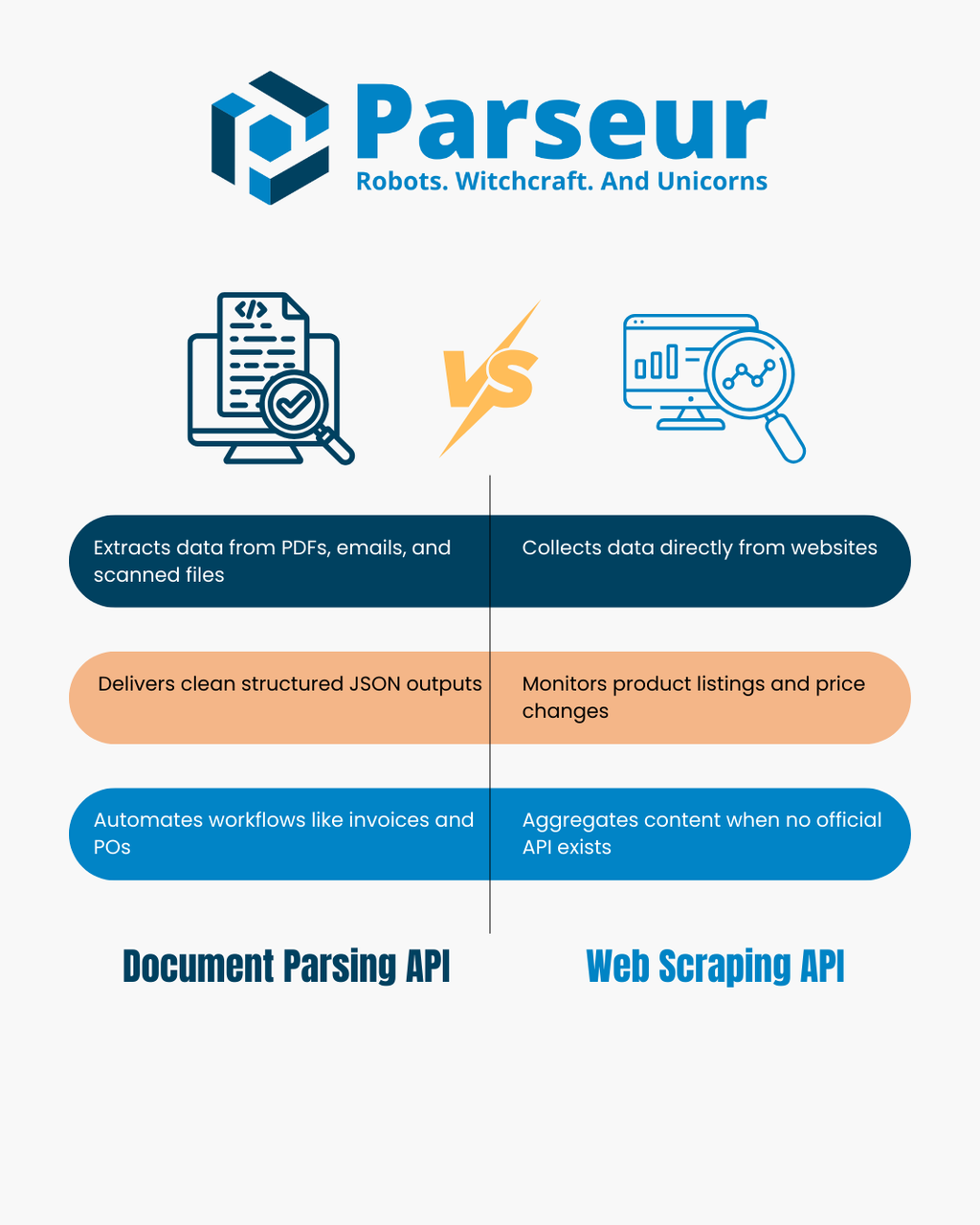

Ambos enfoques extraen datos pero trabajan sobre fuentes muy diferentes: las APIs de análisis de documentos procesan archivos que posees, mientras que las APIs de scraping web se enfocan en las páginas que visitas. Este artículo compara sus ventajas, limitaciones y te ofrece un árbol de decisión, una tabla comparativa y escenarios reales. Para una visión más amplia, revisa nuestra Guía de API de extracción de datos.

Cómo funcionan las APIs de análisis de documentos y las APIs de scraping web

Las APIs de análisis de documentos y las de scraping web están bajo el paraguas de la extracción de datos, pero su operación y los problemas que resuelven son muy diferentes. Entender cómo funciona cada una en la práctica es el primer paso para decidir cuál se adapta mejor a tu negocio.

Un estudio de Scrapingdog revela que el 34,8% de los desarrolladores ahora usan APIs de scraping web, lo que resalta la tendencia hacia flujos de extracción de datos estructurados y listos para usar sobre scripts personalizados.

API de análisis de documentos

Una API de análisis de documentos se centra en extraer información estructurada de archivos que ya tienes o recibes legalmente. Estos pueden incluir PDFs, imágenes escaneadas, correos electrónicos con adjuntos y, a veces, documentos de oficina. En vez de ingresar datos manualmente, la API analiza el diseño y el texto del documento para identificar los datos relevantes.

- Entradas: PDFs, escaneos, imágenes, correos electrónicos y archivos de oficina.

- Salidas: JSON limpio y estructurado con pares clave-valor, tablas y campos específicos que definas.

- Cómo funciona: Utilizando OCR y reglas de análisis, la API detecta bloques de texto, números y tablas. Luego, los mapea en un formato consistente para que los sistemas posteriores (como CRMs, ERPs o bases de datos) los procesen fácilmente.

- Casos de uso típicos: Automatización del procesamiento de facturas y recibos, extracción de ítems de órdenes de compra, análisis de estados financieros o manejo de grandes volúmenes de formularios de clientes. Muchos equipos también usan el análisis de documentos para transformar correos electrónicos en datos estructurados que activen flujos en herramientas como Zapier, Make o n8n.

API de scraping web

Una API de scraping web, por el contrario, está diseñada para extraer información directamente de la web abierta. En vez de trabajar con archivos, obtiene datos desde sitios y transforma el contenido en un formato utilizable. El proceso puede implicar la descarga de HTML sin procesar, el renderizado de páginas con un navegador sin interfaz y el uso de selectores o evaluaciones de JavaScript para extraer ciertos datos.

- Entradas: URLs de sitios web, contenido HTML o endpoints JSON.

- Salidas: Datos analizados y estructurados, normalmente en formato JSON o CSV, listos para análisis o integración.

- Cómo funciona: La API carga la página web, analiza el DOM (modelo de objetos del documento) y aplica reglas como selectores CSS o XPath para capturar campos como nombres de productos, precios o titulares. Algunas herramientas también gestionan proxies y eluden medidas anti-bots para acceder a sitios a escala.

- Casos de uso típicos: Monitoreo de precios en e-commerce, recopilación de catálogos de productos, agregación de artículos de noticias, seguimiento de ofertas de trabajo o creación de datasets sin APIs oficiales.

Por diseño, las APIs de análisis de documentos son ideales para archivos que posees o recibes, mientras que las de scraping web destacan para tomar información de páginas públicas.

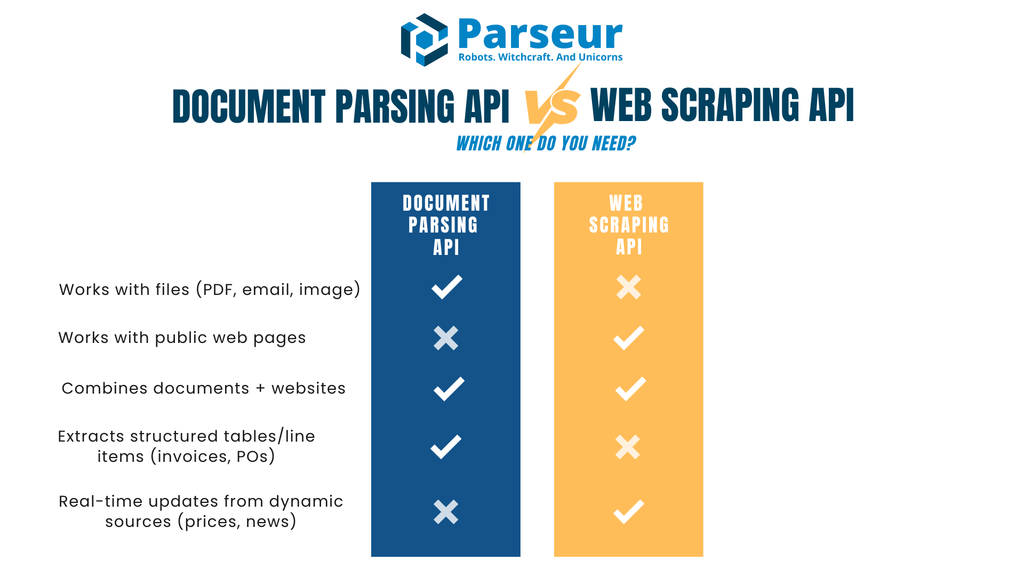

Árbol de decisión: ¿Cuál necesitas?

Elegir entre una API de análisis de documentos y una de scraping web suele depender de la fuente de tus datos y del objetivo final que buscas lograr. Para ayudarte, aquí tienes un simple flujo de decisión con explicaciones prácticas para cada camino.

!

¿Tu fuente es un archivo (PDF, imagen o adjunto de correo) que posees legalmente?

→ Usa una API de análisis de documentos. Transformará estos archivos en JSON limpio, extraerá los campos claves e incluso capturará detalles de líneas en tablas sin ingresar datos manualmente.

¿Tu fuente es una página web pública o un dataset online?

→ Usa una API de scraping web. Obtendrá HTML o páginas renderizadas y te permitirá extraer los datos específicos, como listados de productos o artículos de noticias.

¿Trabajas con documentos y sitios web?

→ A veces necesitarás un enfoque híbrido. Por ejemplo, puedes hacer scraping en un portal de proveedor para descargar PDFs y luego pasar esos PDFs a una API de análisis para su extracción estructurada.

¿Necesitas tablas estructuradas o ítems de línea (como facturas, recibos u órdenes de compra)?

→ Aquí es donde brilla una API de análisis de documentos. Está diseñada para manejar datos tabulares y financieros donde la precisión y la coherencia de esquema son cruciales.

¿Requieres actualizaciones en tiempo real de fuentes dinámicas (como cambios de precio o noticias)?

→ Una API de scraping web es la mejor opción porque puede comprobar repetidamente sitios web y obtener contenido fresco al publicarse.

Este árbol de decisión te ayuda a mapear rápidamente tu caso de uso a la herramienta adecuada, o en algunos casos, a una combinación de ambas.

API de análisis de documentos vs API de scraping web

Comparar APIs de análisis de documentos y de scraping web resulta más sencillo viendo sus fortalezas y limitaciones lado a lado. La siguiente tabla desglosa los criterios de evaluación estándar, desde entradas y salidas hasta seguridad y cumplimiento, para que identifiques cuál solución se adapta mejor a tu flujo de trabajo.

| Criterio | API de análisis de documentos | API de scraping web |

|---|---|---|

| Entrada principal | Archivos como PDFs, imágenes escaneadas y correos electrónicos con adjuntos | Páginas web (HTML/JSON) o contenido DOM renderizado |

| Salidas típicas | JSON con pares clave-valor, tablas de ítems y campos estructurados | HTML analizado convertido a JSON o CSV por selectores |

| Sensibilidad a cambios | Estable: una vez configurados los tipos de documento, el análisis es consistente | Cambios mínimos en el sitio o el DOM pueden romper los selectores |

| Casos de uso | Facturas, órdenes de compra, contratos, formularios, estados financieros, correos operativos | Catálogos de productos, actualización de precios, bolsas de empleo, agregación de noticias |

| Adquisición | Tú o tus usuarios proporcionan los documentos | Los datos se obtienen directamente de sitios web de terceros |

| Enfoque legal | Privacidad y cumplimiento (roles de controlador/procesador, políticas de retención) | Términos de servicio, robots.txt, protecciones anti-bot |

| Latencia y escalabilidad | Funciona bien con trabajos en lote, procesamiento asíncrono y entrega mediante webhooks | Limitado por tasas de rastreo, reglas anti-bot y gestión de concurrencia |

| Mantenimiento | Ajustes ocasionales de plantilla o de esquema | Actualizaciones frecuentes de selectores y medidas anti-bot |

| Calidad de los datos | Salida estructurada, reglas de validación y campos normalizados | Varía según la calidad y limpieza del HTML del sitio |

| Seguridad | Cifrado en tránsito y en reposo; webhooks firmados; acceso basado en roles | Requiere rotación de IPs, proxies seguros y buenas prácticas de red |

| Aptitud para LLM | Ideal para entrada JSON estructurada a sistemas de IA/ML | Ideal para enriquecimiento, resumen o clasificación de texto no estructurado |

| Cuándo elegir | Usa cuando ya recibes documentos (p.ej., facturas, recibos, contratos) | Usa cuando necesitas contenido web en vivo (p.ej., precios, stock, titulares) |

Cuándo la API de scraping web es la herramienta adecuada (y cómo usarla de forma responsable)

Las APIs de scraping web son a menudo la mejor opción cuando la información solo está disponible en sitios web y no en archivos. Te permiten capturar datos a escala sin depender de que un socio, proveedor o cliente te envíe un documento. El scraping funciona especialmente bien para investigación de mercado, monitoreo de precios y proyectos de agregación de conocimiento con actualizaciones frecuentes.

Datos de la industria de Browsercat indican que el mercado global del scraping web se valoró en aproximadamente 1,01 mil millones de USD en 2024 y se espera llegue a 2,49 mil millones de USD para 2032, creciendo a un CAGR del 11,9%.

Escenarios comunes donde el scraping destaca incluyen:

- Monitorizar precios o disponibilidad de productos en múltiples sitios e-commerce

- Agregar titulares o anuncios públicos desde diferentes fuentes de noticias

- Construir datasets de ofertas de trabajo, directorios o eventos cuando no hay API oficial

Dado que el scraping implica recolectar información de sitios que no posees, es importante hacerlo con responsabilidad. Buenas prácticas incluyen:

- Revisar robots.txt y los términos de servicio antes de extraer datos

- Aplicar límites de velocidad para no sobrecargar el servidor

- Usar cachés cuando sea posible para evitar peticiones repetidas e innecesarias

- Identificar claramente tu scraper, en vez de tratar de disfrazarlo

- Preferir APIs oficiales si el sitio las ofrece

Una realidad práctica del scraping web es que los sitios cambian con frecuencia. Una leve modificación en la estructura del HTML puede romper tus selectores y causar datos erróneos o faltantes. Es esencial configurar monitoreo y alertas para detectar y corregir estos problemas rápidamente.

Finalmente, en muchos flujos de trabajo, el scraping no es una solución aislada. Por ejemplo, puedes usar scraping para descubrir o descargar archivos PDF de un portal de un proveedor y luego apoyarte en una API de análisis de documentos para convertirlos en JSON estructurado. Este enfoque híbrido combina el alcance del scraping con la precisión del análisis de documentos.

Retos de las APIs de scraping web

Las APIs de scraping web pueden ser una forma poderosa de recopilar datos en tiempo real de sitios web, pero también presentan retos importantes que las empresas deben considerar cuidadosamente. Entender estos desafíos ayuda a establecer expectativas realistas y deja claro por qué el scraping es mejor para algunos casos que para otros.

Un análisis reciente de Octoparse muestra que solo alrededor del 50% de los sitios son fáciles de scrapear, mientras que el 30% son medianamente complicados y el 20% restante especialmente difíciles debido a estructuras complejas o medidas anti-scraping.

Cambios frecuentes en los sitios web

Los sitios web no están construidos pensando en el scraping. Incluso pequeños cambios en la estructura del HTML, como renombrar una clase CSS o modificar el diseño de la página, pueden romper tus scripts y APIs de scraping. Esto implica costes de mantenimiento continuos y la necesidad de monitorear activamente que los datos sigan llegando de forma fiable.

Medidas anti-bots

Muchos sitios implementan protecciones como CAPTCHA, limitación de IPs, validaciones de sesión o algoritmos de detección de bots. Para evitarlos, los equipos de scraping deben usar estrategias como rotación de proxies, gestión de user-agents y limitación de la tasa de peticiones, lo que añade complejidad técnica.

Aspectos legales y éticos

El scraping web opera en un área gris legal. Aunque extraer datos públicos a menudo está permitido, ignorar los términos de servicio, las directivas robots.txt o saltarse muros de pago puede exponer a las empresas a riesgos legales y de cumplimiento. Es fundamental establecer directrices éticas claras y, en caso de duda, consultar con expertos legales antes de desplegar scraping a gran escala.

Calidad y consistencia de los datos

Los sitios web están diseñados para humanos, no para máquinas. Los datos extraídos suelen requerir limpieza y validación extra. Estructuras HTML inconsistentes, contenido dinámico generado por JavaScript o registros duplicados pueden resultar en datasets desordenados que requieren procesamiento adicional antes de ser útiles.

Desafíos de escalabilidad

Escalar una operación de scraping no consiste simplemente en enviar más peticiones. El scraping a gran volumen requiere infraestructura sólida para gestionar concurrencia, lógica de reintentos, manejo de errores y carga distribuida. A medida que crece la operación, también lo hacen los costes de proxies, servidores y herramientas de monitoreo.

Sostenibilidad a largo plazo

El scraping puede ser una solución frágil para procesos de negocio continuos. Los pipelines de datos basados en scraping requieren ajustes constantes, a diferencia de las APIs oficiales o los archivos estructurados. Las organizaciones deben estar dispuestas a invertir tiempo y recursos en mantenimiento a largo plazo.

Cuándo es mejor optar por una API de análisis de documentos

Una API de análisis de documentos es la opción correcta cuando la información que necesitas ya te llega en forma de documentos, y no publicada en la web. Estos documentos pueden ser PDFs, imágenes escaneadas o correos electrónicos con adjuntos. En vez de reescribir manualmente los detalles en una base de datos o ERP, la API automatiza el proceso convirtiendo archivos no estructurados en datos estructurados.

Según Sphereco, el 80% de los datos empresariales son no estructurados, con formatos como emails, PDFs y documentos escaneados, haciendo que las APIs de análisis de documentos sean esenciales para desbloquear eficiencia y conocimiento.

Casos de uso típicos:

- Procesamiento de facturas y recibos: extracción de nombre del proveedor, fechas, totales y líneas de tabla para cuentas a pagar

- Órdenes de compra y estados: captura de números de pedido, importes y condiciones de pago para conciliaciones más rápidas

- Formularios y contratos: extracción de campos estandarizados como datos de cliente o fechas de firma

- Correos operativos: conversión de confirmaciones de pedido, avisos de envío o solicitudes de reserva en JSON para integración con sistemas posteriores

Una API de análisis de documentos es especialmente útil cuando requieres precisión y consistencia. No solo extrae texto: puede normalizar formatos, validar campos y entregar resultados vía webhooks directamente a tu aplicación o base de datos. Así, tus datos son estructurados, fiables y listos para la automatización sin limpieza adicional.

El análisis de documentos es más estable que el scraping porque la estructura de los archivos cambia con mucha menor frecuencia que el HTML de un sitio web. Una vez configuradas las instrucciones, las mismas reglas pueden gestionar miles de documentos de manera fiable.

Si tu empresa depende de procesar documentos de proveedores, estados de clientes o emails, una API de análisis de documentos es casi siempre la opción más rápida y sostenible.

Patrones híbridos: Solapamientos reales

En muchos flujos de trabajo, el análisis de documentos y el scraping web no son elecciones excluyentes, sino herramientas complementarias. A menudo, las fuentes de datos incluyen documentos y sitios web, por lo que combinar ambos enfoques permite una solución más completa.

Algunos patrones híbridos prácticos:

- Hacer scraping para descargar PDFs y analizarlos: Un portal de proveedor puede alojar facturas o estados como PDFs descargables. Una API de scraping puede acceder y bajar los archivos, mientras una de análisis extrae ítems, totales y otros datos estructurados.

- Analizar y enriquecer documentos con datos de scraping: Tras analizar las facturas, quizás necesites metadatos adicionales, como categorías de proveedores o referencias sectoriales. Una API de scraping puede obtener ese contexto de fuentes públicas, y la de análisis asegurar que los detalles financieros sean exactos.

- Análisis de email con verificación web: Las confirmaciones de pedidos y avisos de envío a menudo llegan por email. Puedes extraer los detalles con análisis y usar una API de scraping para verificar disponibilidad de stock o precios actuales en el sitio del proveedor.

- Agregar capas de inteligencia: Cuando tienes JSON estructurado desde documentos, puedes unir esos datos con información de la web vía scraping y luego aplicar analítica o categorización. Este enfoque permite normalizar nombres de proveedores, detectar anomalías o mapear productos entre fuentes.

Los setups híbridos son valiosos porque aprovechan la fortaleza de cada método. Las APIs de análisis destacan en salidas estructuradas y basadas en esquemas desde documentos, mientras que las de scraping amplían la cobertura a datos web. Al usar ambos, los equipos reducen trabajo manual y alcanzan mayor automatización en sus operaciones.

¿Parseur es una API de análisis de documentos o de scraping web?

Parseur es una potente API de análisis de documentos y correos electrónicos que convierte documentos no estructurados en datos JSON estructurados. A diferencia de una API de scraping web, que extrae información directamente de sitios, Parseur se enfoca en los documentos y emails que tú (o tus usuarios) ya poseéis. Esto la hace estable y escalable para automatizar flujos de trabajo sin los riesgos asociados a cambios en sitios web, restricciones de scraping o problemas de renderizado. Con Parseur puedes mejorar fácilmente procesos como automatización de facturas, seguimiento de recibos, gestión de órdenes de compra o procesamiento de formularios de cliente.

¿Qué significa esto en la práctica?

- Qué hace Parseur: Ingresa emails, PDFs, imágenes y archivos de oficina y devuelve JSON estructurado con campos clave-valor y tablas de ítems. Los datos pueden entregarse mediante webhooks o accederse por API.

- Gestión de datos: Parseur opera estrictamente como procesador bajo tu control. Soporta acuerdos de procesamiento de datos (DPA), ofrece un listado transparente de subprocesadores, permite configurar retención y borrado de datos, cifra los datos en tránsito y reposo, y asegura la entrega con webhooks firmados.

- Mejor encaje: Parseur es ideal para equipos cuyos documentos llegan principalmente por email, como facturas, recibos, órdenes de compra o estados financieros, y que necesitan extracción de datos fiable y rápida con mínimo esfuerzo de desarrollo.

Por qué destaca Parseur API

La principal ventaja de Parseur API en comparación con otras soluciones es que combina una API y una aplicación web. Los desarrolladores pueden integrar la API directamente, mientras que los equipos de soporte y operaciones pueden usar la app para monitorizar, revisar y mejorar los resultados del análisis sin desarrollo adicional.

Esta dualidad ahorra tiempo a los equipos de desarrollo en crear herramientas de monitoreo y gestión, que suelen ser costosas y complejas de mantener. En la app web los usuarios pueden definir su esquema JSON y campos en pocos clics, ajustar instrucciones al instante y validar los datos extraídos. Esta flexibilidad asegura una colaboración eficiente entre equipos técnicos y no técnicos, manteniendo ligera la integración.

A diferencia de las APIs de scraping que dependen de estructuras de sitios frágiles, Parseur trabaja con archivos que ya tienes, brindando una base más confiable para automatizaciones críticas.

Cómo gestiona los datos Parseur

Aunque Parseur no es una API de scraping web, está diseñada para procesar documentos y correos electrónicos de manera eficiente y segura. Para equipos que dependen de PDFs, imágenes escaneadas o adjuntos de email, Parseur brinda una forma fiable de transformarlos en JSON estructurado para integrarlos a gran escala.

El fuerte compromiso de Parseur con la seguridad, la privacidad y el cumplimiento la hace destacar. Puedes confiar en que tu información será gestionada responsablemente, siguiendo las mejores prácticas y normativas globales.

Aspectos clave de la gestión de datos en Parseur

Pensado para documentos y correos electrónicos

Parseur ingresa PDFs, imágenes y contenido de email, devolviendo JSON limpio y estructurado a través de webhooks o llamadas API. Así, los equipos pueden automatizar la gestión de facturas, pedidos o flujos de email a base de datos sin codificación personalizada.

Tú mantienes el control de tus datos

Tú eres dueño de los datos que envías a Parseur. Parseur solo procesa información bajo tus instrucciones explícitas, y puedes configurar la política de retención, incluso tan corta como un día. Una función Procesar y borrar permite eliminar documentos inmediatamente tras el análisis.

Dónde se almacenan los datos

Todos los datos se guardan de forma segura en la Unión Europea (Países Bajos) en un datacenter altamente seguro de Google Cloud Platform (GCP), certificado bajo ISO 27001. Ver detalles aquí.

Prácticas de seguridad y cifrado

Todos los datos se cifran en reposo usando AES-256 y en tránsito con TLS v1.2 o superior. Las capas de transporte obsoletas (SSLv2, SSLv3, TLS 1.0, TLS 1.1) están totalmente deshabilitadas. Parseur utiliza certificados SSL de Let's Encrypt, el estándar global de la industria, para asegurar las comunicaciones entre los servidores de Parseur, aplicaciones externas y tu navegador.

Supervisión de infraestructura y pruebas de penetración

Parseur monitorea continuamente su infraestructura y dependencias, aplicando parches cuando se detectan vulnerabilidades. Empresas independientes realizan también pruebas de penetración regulares para validar la seguridad frente a marcos como OWASP Top 10 y SANS 25. Los clientes Enterprise pueden solicitar informes completos de pentesting. En 2025, Parseur también recibió el Certificado Astra Pentest, demostrando aún más su solidez en ciberseguridad.

Seguridad de contraseñas y protección de cuentas

Parseur nunca almacena contraseñas en texto plano: emplea el algoritmo PBKDF2 con SHA-256, un salt de 512 bits y 600.000 iteraciones, muy por encima de las recomendaciones NIST, para proteger el acceso a la cuenta.

Fiabilidad operativa y SLA

Parseur apunta a un uptime de 99,9% o mayor, con mecanismos de reintentos y espera para asegurar que no se pierdan datos ante caídas. Las plataformas de email reintentan durante 24 horas, y la redundancia dual proporciona resiliencia. Los planes Enterprise pueden alcanzar 99,99% de disponibilidad con garantías adicionales de infraestructura. Consulta uptime histórico aquí.

Compromiso GDPR y privacidad

Parseur es totalmente compatible con GDPR y actúa como procesador bajo tu control. Tú sigues siendo el controlador de los datos, con completa propiedad sobre tus documentos. Parseur nunca vende ni comparte tus datos. El personal solo accede a los mismos si solicitas soporte explícitamente y todo el equipo recibe formación continua en GDPR y protección de datos. Más info sobre Parseur y GDPR.

Respuesta ante incidentes y notificaciones de brechas

En el improbable caso de una brecha de datos, Parseur tiene la política estricta de notificar a los clientes en menos de 48 horas, garantizando total transparencia y cumplimiento normativo. Puedes revisar también el Resumen oficial de Seguridad y Privacidad aquí.

Legalidad y cumplimiento de un vistazo

Las consideraciones legales y de cumplimiento son centrales al elegir entre APIs de análisis de documentos y de scraping web. Ambos enfoques implican el manejo de datos, pero las obligaciones difieren según la fuente y el contexto.

Las organizaciones deben asegurarse de tener una base legal para procesar documentos, lo que normalmente implica acuerdos con el propietario o proveedor de los datos. También significa definir roles bajo la normativa de protección de datos, como controlador y procesador, establecer un Acuerdo de Procesamiento de Datos e implementar políticas claras de retención. Los flujos de análisis de documentos deben incluir además obligaciones de notificación de brechas y prácticas de minimización de datos.

El panorama legal del scraping web es más complejo. Si bien puede permitirse extraer datos públicos en algunas jurisdicciones, muchos sitios web lo prohíben expresamente en sus términos de servicio o archivos robots.txt. Evadir muros de pago, controles o medidas anti-bot incrementa los riesgos legales y de cumplimiento. Las organizaciones que empleen scraping web deben consultar siempre con asesores legales para asegurar que sus prácticas cumplen con regulaciones y obligaciones contractuales.

Las transferencias internacionales de datos suman otra capa de complejidad. Si tus flujos incluyen datos personales de la Unión Europea u otras regiones reguladas, necesitarás mecanismos de transferencia compatibles que cumplan los requisitos legales.

Reflexión final: Elige la API adecuada para tus datos

Las APIs de análisis de documentos y de scraping web juegan papeles clave automatizando la recolección de datos, pero cubren necesidades distintas. El análisis es ideal cuando trabajas con documentos que posees como facturas, estados o emails.

Según Experlogix, la automatización documental puede reducir hasta en un 80% el tiempo de procesamiento de documentos, mostrando el enorme ahorro que aportan las APIs de análisis de documentos.

El scraping es la opción indicada si los datos que necesitas viven en sitios web públicos, como catálogos de productos o listas de precios. En algunos flujos, los equipos usan scraping para recolectar archivos y análisis para obtener salidas estructuradas.

La clave está en elegir según la fuente. Una API de análisis de documentos te ahorrará tiempo y mejorará la precisión si tus datos llegan como PDFs, escaneos o correos electrónicos. Si los datos viven en páginas web, entonces una API de scraping web puede ser la mejor opción. Para equipos que gestionan múltiples fuentes, combinar ambas estrategias ofrece una solución completa.

Preguntas frecuentes

Muchos lectores tienen preguntas comunes al comparar el análisis de documentos y el scraping web. A continuación encontrarás respuestas a algunas de las consultas más frecuentes para ayudarte a aclarar sus diferencias y casos prácticos de uso.

-

¿El análisis de documentos es lo mismo que el scraping web?

-

No. El análisis de documentos funciona con archivos como PDFs, imágenes escaneadas o correos electrónicos que ya posees o has recibido, mientras que el scraping web extrae datos de sitios web analizando el HTML o el contenido renderizado.

-

¿Parseur es una herramienta de scraping web API?

-

No. Parseur es una API de análisis de documentos y correos electrónicos, no una herramienta de scraping web. No rastrea ni descarga páginas web. En su lugar, te ayuda a transformar documentos que posees, como correos electrónicos, PDFs, imágenes o archivos de oficina, en JSON limpio y estructurado. Esto lo hace ideal para flujos de trabajo como la gestión de facturas, recibos y órdenes de compra sin necesidad de construir herramientas internas complejas.

-

¿Es legal el scraping web?

-

Depende del contexto. Extraer datos públicos a veces está permitido, pero los sitios web suelen establecer restricciones en sus términos de servicio o en el archivo robots.txt. Revisa siempre estos documentos y consulta con un profesional legal antes de proceder.

-

¿Cuándo debo evitar el scraping?

-

Debes evitar el scraping cuando los datos están detrás de muros de pago, sujetos a controles de acceso estrictos o prohibidos explícitamente por los términos de servicio del sitio. Intentar eludir esas restricciones puede crear riesgos de cumplimiento y legales.

Última actualización el