Punti Chiave:

- Le API di parsing documenti estraggono dati strutturati da file che possiedi, come PDF, immagini ed email.

- Le API di web scraping raccolgono informazioni da pagine web pubbliche analizzando contenuti HTML o renderizzati.

- La scelta giusta dipende dalla fonte dei tuoi dati: file ricevuti vs siti web da monitorare.

- Molti team utilizzano flussi ibridi, eseguendo scraping per recuperare documenti e parsing per estrarre JSON affidabile.

API di Parsing Documenti vs API di Web Scraping

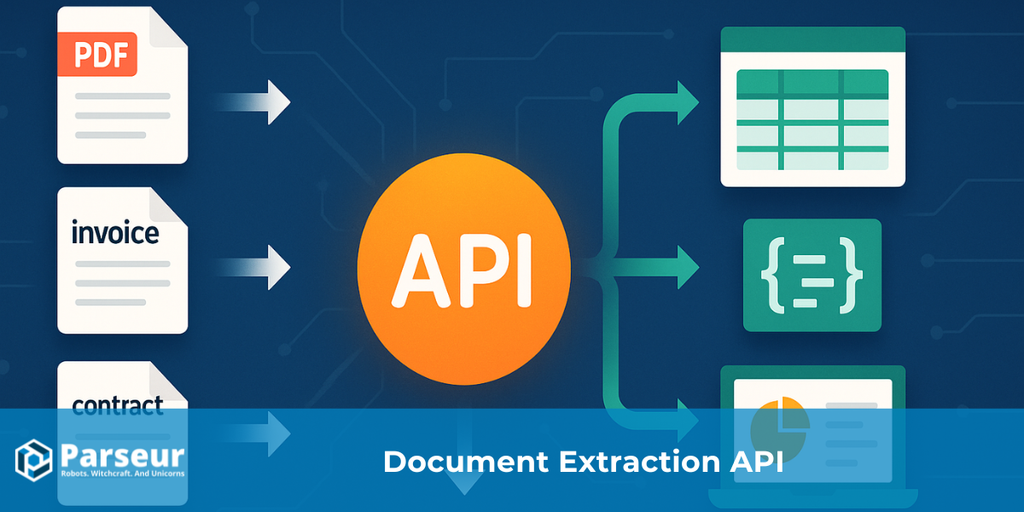

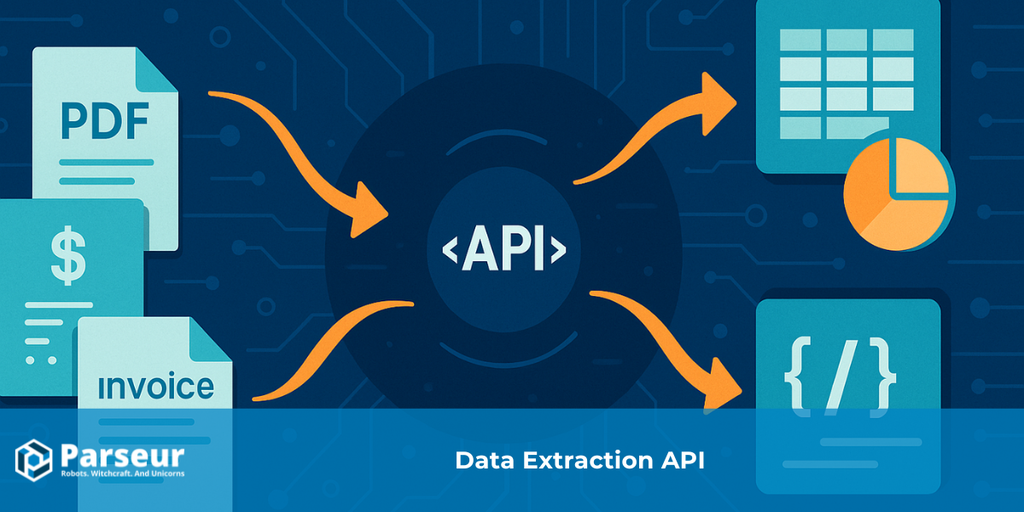

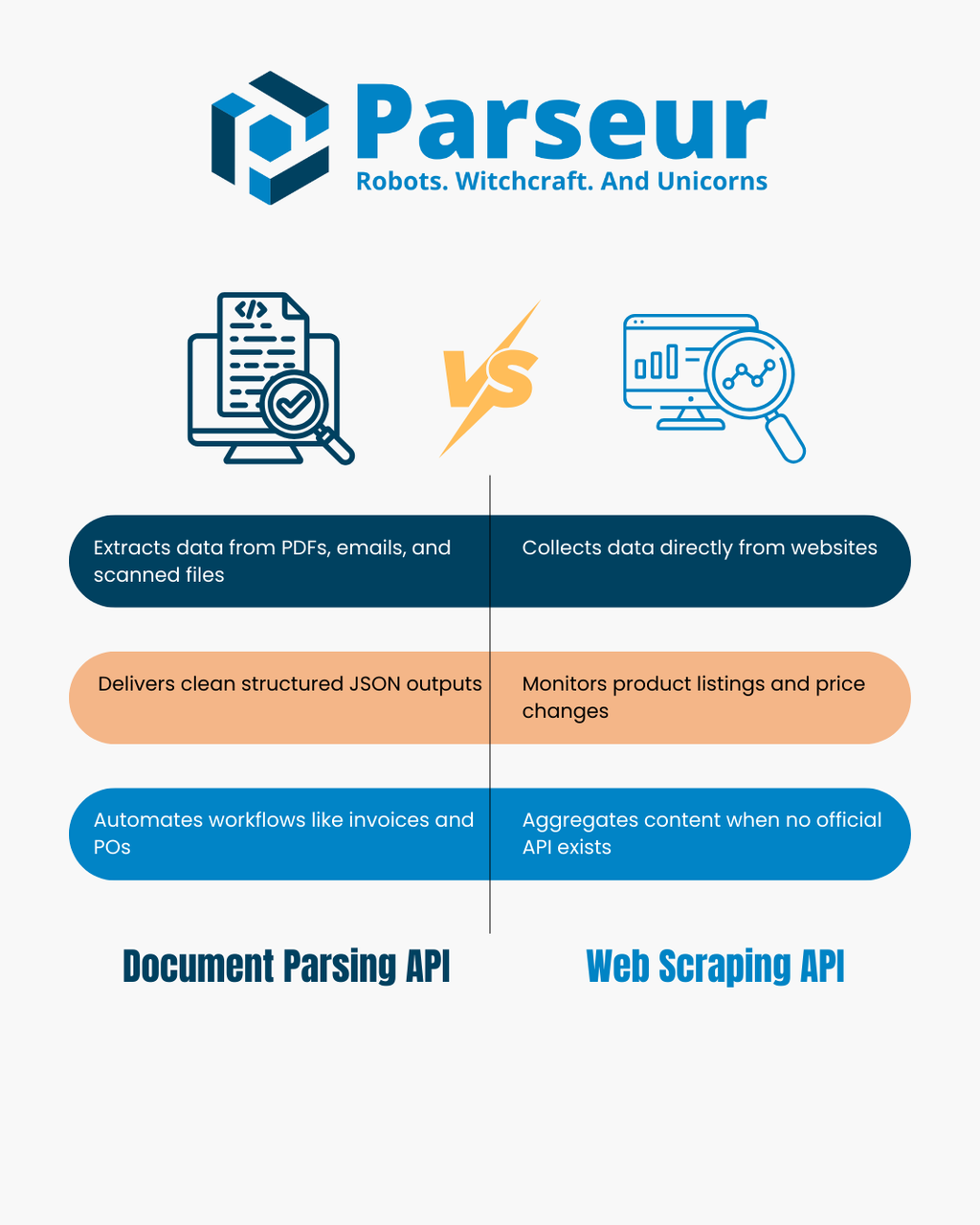

Una API di parsing documenti converte file come PDF, immagini scansionate ed email in JSON strutturato. Analizza il layout e il testo del documento per estrarre coppie chiave-valore e tabelle, semplificando l'automazione di processi come la gestione delle fatture, il monitoraggio degli ordini di acquisto o workflow email-to-database.

Una API di web scraping raccoglie dati direttamente dai siti web recuperando in modo programmato le pagine e analizzando l’HTML o il DOM renderizzato. Quando non è disponibile un'API ufficiale, il web scraping viene tipicamente utilizzato per monitorare listini prodotti, tracciare variazioni di prezzo, aggregare contenuti di notizie o costruire dataset.

Entrambi gli approcci estraggono dati ma lavorano su fonti molto diverse: le API di parsing documenti gestiscono file che possiedi, mentre le API di web scraping si concentrano sulle pagine web che visiti. Questo articolo confronterà i loro punti di forza e limiti, offrendo un diagramma decisionale, una tabella comparativa e scenari reali. Per un contesto più ampio sull’automazione dei dati, consulta la nostra guida alle API di Estrazione Dati.

Come Funzionano le API di Parsing Documenti e le API di Web Scraping

Le API di parsing documenti e le API di web scraping rientrano nell’ambito dell’estrazione dati, ma si comportano e risolvono problemi in modo molto diverso. Comprendere come operano nella pratica è il primo passo per decidere quale sia la soluzione giusta per la tua azienda.

Uno studio di Scrapingdog rivela che il 34,8% degli sviluppatori oggi utilizza API di web scraping, a conferma della tendenza verso workflow di estrazione dati strutturati e pronti all'uso invece di mantenere script custom.

API di parsing documenti

Una API di parsing documenti si concentra sull’estrazione di informazioni strutturate da file che già possiedi o ricevi legalmente. Questi possono includere PDF, immagini scansionate, email con allegati e a volte file office. Invece di richiedere l'inserimento manuale dei dati, l'API analizza layout e testo del documento per individuare informazioni significative.

- Input: PDF, scansioni, immagini, email e file Office.

- Output: JSON pulito e strutturato con coppie chiave-valore, tabelle e campi specifici definiti da te.

- Come funziona: Utilizzando OCR e regole di parsing, l’API rileva blocchi di testo, numeri e tabelle. Li mappa poi in un formato coerente che i sistemi a valle (come CRM, ERP o database) possono elaborare facilmente.

- Casi d’uso tipici: Automazione di fatture e ricevute, estrazione delle voci dagli ordini di acquisto, parsing di rendiconti finanziari o gestione di grandi volumi di moduli cliente. Molti team usano anche il parsing documenti per trasformare email in dati strutturati che possono attivare flussi di lavoro in strumenti come Zapier, Make o n8n.

API di web scraping

Una API di web scraping, invece, è progettata per estrarre informazioni direttamente dal web aperto. Invece di gestire file, estrae dati dai siti web e trasforma il contenuto in un formato utilizzabile. Il processo può prevedere il recupero di HTML grezzo, il rendering della pagina tramite browser headless e l’applicazione di selettori o valutazione JavaScript per individuare i campi specifici.

- Input: URL di siti web, contenuti HTML o endpoint JSON.

- Output: Dati strutturati (spesso JSON o CSV), pronti per analisi o integrazioni.

- Come funziona: L’API carica la pagina, analizza il DOM (Document Object Model) e applica regole come selettori CSS o XPath per catturare campi come nomi prodotti, prezzi, titoli di articoli. Alcuni strumenti gestiscono anche proxy e misure anti-bot per consentire l'accesso ai siti in modo scalabile.

- Casi d’uso tipici: Monitoraggio dei prezzi su e-commerce concorrenti, raccolta di cataloghi di prodotti, aggregazione di notizie, tracciamento di offerte di lavoro o creazione di dataset in assenza di API ufficiali.

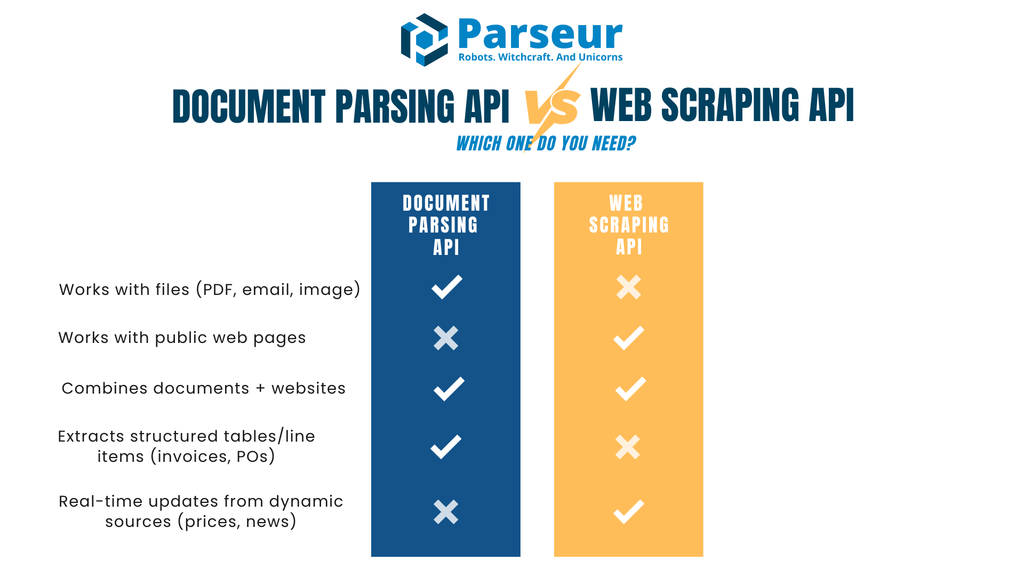

Progettualmente, le API di parsing documenti sono ideali per file posseduti o ricevuti, mentre le API di web scraping eccellono nel raccogliere informazioni da pagine web pubbliche.

Albero Decisionale: Quale Ti Serve?

La scelta tra una API di parsing documenti e una di web scraping dipende soprattutto dalla fonte dei tuoi dati e dal risultato finale che vuoi ottenere. Ecco un albero decisionale semplice con spiegazioni pratiche per ogni percorso.

!

La tua fonte è un file (PDF, immagine o allegato email) in tuo possesso legale?

→ Usa una API di Parsing Documenti. Trasformerà questi file in JSON pulito, estrarrà i campi chiave e anche i dettagli delle tabelle senza inserimento manuale.

La tua fonte è una pagina web pubblica o un dataset online?

→ Usa una API di Web Scraping. Recupererà HTML o pagine renderizzate e ti permetterà di estrarre i dati specifici di cui hai bisogno, come elenchi prodotti o articoli di notizie.

Gestisci sia documenti sia siti web?

→ A volte serve un approccio ibrido. Ad esempio, puoi eseguire scraping su un portale fornitori per scaricare PDF e poi passarli a una API di parsing documenti per l’estrazione strutturata.

Hai bisogno di tabelle strutturate o line item (come per fatture, ricevute o ordini di acquisto)?

→ Qui una API di Parsing Documenti eccelle. È progettata per gestire dati tabellari e finanziari in cui precisione e coerenza dello schema sono fondamentali.

Hai bisogno di aggiornamenti in tempo reale da fonti dinamiche (come cambi di prezzo o notizie)?

→ Una API di Web Scraping è più indicata, perché può controllare periodicamente i siti e raccogliere contenuti freschi non appena vengono pubblicati.

Questo albero decisionale ti aiuta a mappare rapidamente il tuo caso d’uso allo strumento più adatto, o in certi casi a una combinazione di entrambi.

API di Parsing Documenti vs API di Web Scraping

Per confrontare le API di parsing documenti e quelle di web scraping, è utile esaminare fianco a fianco vantaggi e limiti. La tabella seguente analizza criteri standard di valutazione, dagli input agli output, dalla sicurezza alla conformità, così da individuare velocemente quale soluzione si adatta al tuo workflow.

| Criterio | API di Parsing Documenti | API di Web Scraping |

|---|---|---|

| Input principale | File come PDF, immagini scansionate ed email con allegati | Pagine web (HTML/JSON) o contenuti DOM renderizzati |

| Output tipici | JSON con coppie chiave-valore, tabelle, campi strutturati | HTML analizzato e convertito in JSON o CSV tramite selettori |

| Sensibilità ai cambiamenti | Stabile: una volta definiti i tipi documento, la struttura resta coerente | Cambiamenti di layout o DOM possono rompere i selettori |

| Casi d’uso | Fatture, ordini di acquisto, contratti, moduli, rendiconti, email operative | Cataloghi di prodotti, aggiornamenti prezzi, job board, aggregazione news |

| Acquisizione | Tu o i tuoi utenti forniti i documenti | I dati vengono recuperati direttamente da siti di terzi |

| Focus legale | Privacy e compliance (ruoli controller/processor, politiche di conservazione) | Termini di servizio, robots.txt, protezioni anti-bot |

| Latenza & scalabilità | Ideale per batch, processi asincroni, consegna via webhook | Limitata da crawling rate, regole anti-bot, gestione della concorrenza |

| Manutenzione | Regolazioni occasionali di template o schema | Aggiornamenti frequenti dei selettori e contromisure anti-bot |

| Qualità dei dati | Output strutturato, regole di validazione, campi normalizzati | Varia a seconda della qualità e pulizia dell’HTML del sito |

| Sicurezza | Crittografia in transito e a riposo; webhook firmati; accesso basato su ruoli | Richiede rotazione IP, proxy sicuri, igiene della rete |

| Integrazione LLM | Ideale per JSON strutturato in input a sistemi AI/ML a valle | Ideale per arricchimento, sintesi o classificazione di testo non strutturato |

| Quando scegliere | Usa se già ricevi documenti (es. fatture, ricevute, contratti) | Usa se ti serve contenuto live da siti (es. prezzi, stock, notizie) |

Quando l’API di Web Scraping è lo Strumento Giusto (e Come Usarla in Modo Responsabile)

Le API di web scraping sono spesso la scelta migliore quando le informazioni di cui hai bisogno sono disponibili solo su siti web e non ti vengono consegnate come file. Permettono di catturare dati su larga scala senza aspettare l’invio da parte di partner, fornitori o clienti. Lo scraping funziona benissimo per ricerche di mercato, monitoraggio prezzi e progetti di aggregazione conoscitiva dove gli aggiornamenti sono frequenti.

Dati di settore di Browsercat mostrano che il mercato globale del web scraping valeva circa 1,01 miliardi USD nel 2024 e raggiungerà 2,49 miliardi USD entro il 2032, con una crescita annua composta dell’11,9% (CAGR).

Scenari in cui lo scraping eccelle includono:

- Monitoraggio prezzi o disponibilità prodotti su diversi e-commerce

- Aggregazione di titoli di notizie o annunci pubblici da varie fonti

- Creazione di dataset di offerte lavoro, elenchi o eventi in assenza di API ufficiali

Poiché il web scraping implica la raccolta di dati da siti che non possiedi, è importante agire responsabilmente. Le buone pratiche comprendono:

- Consultare robots.txt e i termini di servizio prima di eseguire scraping

- Applicare limiti di richiesta così da non sovraccaricare i server

- Usare sistemi di cache per evitare richieste ripetitive non necessarie

- Identificare chiaramente il proprio scraper, senza camuffarsi

- Preferire sempre le API ufficiali se disponibili

Una realtà pratica del web scraping è che i siti cambiano spesso. Modifiche minime alla struttura dell’HTML possono rompere i selettori causando dati errati o mancanti. È essenziale configurare monitoraggi e avvisi per poter risolvere velocemente questi problemi.

Infine, spesso lo scraping non è una soluzione autonoma. Ad esempio, puoi usarlo per scoprire/scaricare file PDF da un portale fornitori e poi affidare l’estrazione strutturata a una API di parsing documenti. Questo approccio ibrido combina la copertura del web scraping con la precisione del parsing documentale.

Sfide delle API di Web Scraping

Le API di web scraping sono un potente strumento per raccogliere dati in tempo reale da siti web, ma comportano anche sfide significative che le aziende devono valutare attentamente. Conoscerle aiuta a impostare aspettative realistiche e chiarisce perché lo scraping è adatto solo per certi scenari.

Un’analisi recente di Octoparse rileva che solo circa il 50% dei siti è facile da scrappare, il 30% ha difficoltà medie e il restante 20% è particolarmente complesso per struttura o misure anti-scraping.

Cambi frequenti nei siti

I siti web non sono progettati per lo scraping. Anche piccole modifiche all’HTML, come la rinomina di una classe CSS o il cambio del layout, possono rompere script/API di scraping. Ciò comporta costi di manutenzione continui e la necessità di monitoraggio attivo per la continuità della pipeline dati.

Misure anti-bot

Molti siti adottano protezioni come CAPTCHA, throttling IP, validazioni di sessione o algoritmi anti-bot. Per evitare blocchi, i team di scraping devono implementare strategie come rotazione proxy, gestione degli user-agent e limiti di richiesta, aumentando la complessità tecnica.

Questioni legali ed etiche

Il web scraping si muove in una zona grigia dal punto di vista legale. Pur essendo spesso ammesso lo scraping di dati pubblici, ignorare termini di servizio, direttive robots.txt o aggirare paywall può esporre le aziende a rischi di compliance. È fondamentale definire linee guida etiche e, in caso di dubbio, cercare consulenza legale prima di lanciare scraping su larga scala.

Qualità e coerenza dei dati

I siti sono progettati per la navigazione umana, non per il consumo da parte delle macchine. I dati estratti richiedono spesso ulteriore pulizia e validazione. Strutture HTML incoerenti, contenuti dinamici in JavaScript o duplicati producono dataset disordinati che necessitano lavorazioni successive.

Sfide di scalabilità

Scalare un’operazione di web scraping non significa soltanto aumentare le richieste. Serve infrastruttura solida per gestire concorrenza, retry, error handling e workload distribuiti. Crescendo, i costi per proxy, server e strumenti di monitoraggio aumentano rapidamente.

Sostenibilità sul lungo periodo

Lo scraping è una soluzione fragile per processi aziendali continui. Pipeline basate su scraping necessitano aggiustamenti costanti, a differenza di input strutturati da API ufficiali o documenti. Bisogna essere disposti a dedicare tempo e risorse alla manutenzione nel lungo periodo.

Quando Scegliere Una API di Parsing Documenti

Una API di parsing documenti è ideale quando le informazioni di cui hai bisogno ti arrivano già come documenti, piuttosto che essere pubblicate su siti. I documenti possono essere PDF, immagini scansionate o email con allegati. Invece di dover ricopiare manualmente i dettagli in database o ERP, un’API di parsing automatizza il processo trasformando file non strutturati in dati pronti all'uso.

Secondo Sphereco, l’80% dei dati aziendali è non strutturato, in formati come email, PDF e documenti scansionati, rendendo fondamentali le API di parsing per efficienza e insight.

Casi tipici:

- Gestione di fatture e ricevute: estrazione di anagrafica fornitore, data, totale, voci di tabella per contabilità fornitori

- Ordini di acquisto e rendiconti: acquisizione di numeri ordine, importi, condizioni di pagamento per riconciliazione rapida

- Moduli e contratti: individuazione di campi standardizzati come dati cliente o firme

- Email operative: conversione di conferme ordine, avvisi spedizione o richieste in JSON per integrazione con sistemi a valle

Una API di parsing documenti è preziosa quando servono precisione e coerenza. Non solo estrae il testo, ma può anche normalizzare i formati, validare i campi e inviare risultati via webhook all’applicazione o database. In questo modo, i dati sono strutturati, affidabili e pronti per l’automazione senza ulteriori pulizie.

Il parsing documentale è più stabile del web scraping perché la struttura dei file cambia molto meno spesso di quella dei siti. Una volta configurate le istruzioni di parsing, le stesse regole gestiscono migliaia di documenti in modo affidabile.

Se la tua azienda gestisce grandi flussi di documenti, rendiconti cliente o email, una API di parsing documenti è quasi sempre la scelta più veloce e sostenibile.

Pattern Ibridi: Sovrapposizioni Reali

Nella pratica, parsing documenti e web scraping non sono scelte in competizione ma strumenti complementari. Spesso, le fonti dati aziendali provengono sia da file che da siti web: la combinazione dei due approcci offre una soluzione più completa.

Alcuni pattern ibridi comuni:

- Scraping per scaricare PDF, poi parsing: un portale fornitori offre fatture o rendiconti in PDF scaricabili. Una API di scraping effettua login e scarica i file, mentre una API di parsing documenti estrae voci tabellari, totali e altri dati strutturati.

- Parsing e arricchimento con dati scrappati: Dopo aver elaborato le fatture puoi voler aggiungere metadati come categoria fornitore o benchmark di settore. Una API di scraping raccoglie il contesto da fonti pubbliche, mentre il parsing garantisce la precisione dei dettagli finanziari.

- Parsing email con verifica tramite scraping sito: Conferme ordine e avvisi spedizione spesso arrivano via email. Puoi estrarre subito i dettagli, poi usare una API di scraping per verificare, ad esempio, la disponibilità stock o i prezzi aggiornati sul sito del fornitore.

- Arricchimento tramite layer di intelligenza: Una volta disponibile il JSON strutturato dai documenti, puoi combinarlo con dati raccolti dal web, quindi applicare analytics o categorizzazione. L’approccio a “layer” consente di normalizzare i nomi fornitori, rilevare anomalie o mappare prodotti tra fonti diverse.

Le soluzioni ibride sono efficaci perché sfruttano i punti di forza di ogni metodo. Le API di parsing sono eccellenti per output strutturati e basati su schema estratti da documenti; le API di scraping forniscono invece visibilità su dati nativi web non disponibili in altro modo. Usare entrambi fa risparmiare lavoro manuale e permette un’automazione più ampia.

Parseur è una API di Parsing Documenti o una API di Web Scraping?

Parseur è una potente API di parsing per documenti ed email che trasforma documenti non strutturati in dati JSON strutturati. Diversamente dalle API di web scraping, che raccolgono dati direttamente dai siti, Parseur si concentra sui documenti e le email che tu o i tuoi utenti già possedete. Questo la rende una soluzione stabile e scalabile per automatizzare workflow senza i rischi di cambi di sito, restrizioni di scraping o problemi di rendering. Con Parseur puoi automatizzare con facilità processi come gestione fatture, tracciamento ricevute, gestione ordini di acquisto o elaborazione moduli cliente.

Cosa significa questo nella pratica

- Cosa fa Parseur: Riceve email, PDF, immagini o file Office e restituisce JSON strutturato con campi chiave-valore e tabelle di line-item. I dati possono essere inviati via webhook o recuperati tramite API.

- Gestione dei dati: Parseur opera esclusivamente come processore sotto il tuo controllo. Supporta Data Processing Agreement (DPA), fornisce la lista dei subprocessori, consente di configurare i tempi di retention ed eliminazione, cripta i dati in transito e a riposo, e protegge la consegna con webhook firmati.

- Ideale per: Team che ricevono principalmente documenti via email (fatture, ricevute, ordini di acquisto, rendiconti) e che vogliono estrarre dati strutturati in modo affidabile e con minimo sforzo di sviluppo.

Perché Parseur API Si Distingue

Il principale vantaggio di Parseur API rispetto ad altre soluzioni è che combina sia un’API che un’app web. Gli sviluppatori possono integrare l’API direttamente nelle loro applicazioni, mentre i team di Supporto Clienti e Operations possono utilizzare l’app web per monitorare, rivedere e migliorare i risultati senza ulteriore sviluppo.

Questo doppio approccio evita agli sviluppatori di dover creare strumenti di monitoraggio complessi e difficili da mantenere. Nell’app web puoi definire lo schema JSON e i campi dati in pochi clic, regolare le istruzioni al volo e validare i dati estratti. Questa flessibilità consente la collaborazione tra team tecnici e non, mantenendo l’integrazione leggera.

Al contrario delle API di scraping, dipendenti da strutture web fragili, Parseur lavora con file che già possiedi, offrendo una base più stabile e affidabile per l’automazione.

Come Parseur Gestisce i Dati

Sebbene Parseur non sia una API di web scraping, è progettata per processare documenti ed email in modo efficiente e sicuro. Per i team che lavorano con PDF, immagini scansionate o allegati email, Parseur offre un modo affidabile per trasformare questi file in JSON strutturato, integrabile nei flussi di lavoro su larga scala.

L’impegno di Parseur verso sicurezza dati, privacy e compliance fa la differenza. Le aziende possono usare Parseur con la certezza che le informazioni sono gestite responsabilmente e in conformità con best practice di settore e standard globali rigorosi.

Aspetti chiave della gestione dati di Parseur

Progettato per documenti ed email

Parseur riceve PDF, immagini ed email, quindi restituisce JSON pulito e strutturato tramite webhook o API. Questo abilita l’automazione di flussi come gestione fatture, ordini di acquisto o workflow email-to-database senza necessità di sviluppo custom.

Il controllo dei dati resta a te

I dati inviati a Parseur sono di tua proprietà. Parseur li elabora solo su tua istruzione esplicita; puoi configurare policy di retention a partire anche da un solo giorno. La funzione Process then Delete permette di cancellare subito i documenti dopo il parsing.

Dove sono conservati i dati

Tutti i dati Parseur sono archiviati in modo sicuro nell’Unione Europea (Paesi Bassi) in un data center altamente sicuro basato su Google Cloud Platform (GCP). GCP è conforme alle certificazioni ISO 27001. Leggi di più qui.

Sicurezza e pratiche di crittografia

Tutti i dati vengono cifrati a riposo tramite AES-256 e in transito con TLS v1.2 o superiore. Layer di trasporto obsoleti (SSLv2, SSLv3, TLS 1.0, TLS 1.1) sono completamente disabilitati. Parseur utilizza certificati SSL Let’s Encrypt, standard globale per la sicurezza delle comunicazioni tra server, app di terze parti e browser.

Monitoraggio infrastruttura e penetration test

Parseur monitora continuamente l’infrastruttura e applica patch alle vulnerabilità appena scoperte. Società esterne eseguono regolarmente penetration test secondo framework come OWASP Top 10 e SANS 25. I clienti enterprise possono richiedere i report completi. Nel 2025 Parseur ha ottenuto anche il Certificato Astra Pentest, ulteriore prova di resilienza cybersecurity.

Protezione password e account

Parseur non memorizza mai le password in chiaro. Usa l’algoritmo PBKDF2 con SHA-256, salatura di 512 bit e 600.000 iterazioni, molto oltre le raccomandazioni NIST, per la sicurezza degli accessi.

Affidabilità operativa e SLA

L’obiettivo di uptime di Parseur è 99,9% o superiore, con meccanismi di retry e backoff per assicurare assenza di perdita dati durante i disservizi. Le piattaforme di raccolta email riprovano fino a 24h e sono previsti meccanismi doppi di invio per la ridondanza. I piani enterprise arrivano a 99,99% uptime con garanzie infrastrutturali extra. Consulta lo storico uptime.

GDPR e privacy-first

Parseur è pienamente GDPR compliant e opera come processore sotto il tuo controllo. Tu resti Data Controller con piena proprietà dei documenti. Parseur non vende né condivide mai i tuoi dati; il personale vi accede solo su tua richiesta esplicita e riceve formazione continua su GDPR e data protection. Scopri di più su Parseur e GDPR.

Gestione incidenti e notifica violazioni

In caso (improbabile) di violazione dati, Parseur si impegna a notificare i clienti entro 48 ore, assicurando piena trasparenza e conformità alla privacy. Puoi anche consultare l’Overview Sicurezza e Privacy di Parseur qui

Compliance e Aspetti Legali a Colpo d’Occhio

Le considerazioni legali e di compliance sono centrali nella scelta tra parsing documenti e web scraping. Entrambi i metodi comportano gestione dati, ma obblighi e rischi variano in base a fonte e contesto.

Le organizzazioni devono assicurarsi una base legale per il trattamento dei documenti. Spesso ciò richiede accordi con il proprietario dei dati. È inoltre necessario definire i ruoli ai sensi dei regolamenti sulla privacy (controller e processore), sottoscrivere un Data Processing Agreement e attuare politiche di conservazione chiare. I workflow di parsing documentale devono prevedere obblighi di notifica violazione e principi di minimizzazione dati.

Il quadro legale del web scraping è più articolato. Lo scraping di dati pubblici può essere lecito in alcune giurisdizioni, ma molti siti lo vietano nei termini di servizio o nel robots.txt. Eludere paywall, controlli di accesso o misure anti-bot aumenta i rischi. Le aziende che intendono fare scraping devono consultare un legale per garantire pratiche conformi a normativa e contratti.

I trasferimenti di dati oltreconfine aggiungono ulteriore complessità. Se i tuoi workflow includono dati personali da UE o aree regolamentate, devi prevedere un meccanismo conforme per soddisfare le richieste legislative.

Considerazioni finali: Scegli l’API Giusta per i Tuoi Dati

Le API di parsing documenti e di web scraping giocano ruoli cruciali nell’automazione della raccolta dati, ma risolvono necessità molto diverse. Il parsing è ideale quando lavori con documenti di tua proprietà, come fatture, rendiconti o email.

Secondo Experlogix, l’automazione documentale può ridurre l’elaborazione dei documenti fino all’80%, mostrando l’enorme potenziale di efficienza sbloccabile con le API di parsing.

Lo scraping è la soluzione giusta se i dati risiedono su siti pubblici, come cataloghi prodotti o listini prezzi. In alcuni workflow, si usa lo scraping per raccogliere i file e il parsing per strutturarli.

Il concetto chiave è scegliere in base alla fonte. Se i dati arrivano in PDF, scansioni o email, una API di parsing documenti ti farà risparmiare tempo garantendo precisione. Se invece risiedono su web page, la risposta è una API di scraping. Gestendo più fonti insieme, la combinazione delle due strategie offre la soluzione più completa.

Domande Frequenti

Molti lettori hanno domande comuni quando confrontano l’analisi dei documenti e il web scraping. Di seguito trovi le risposte alle domande più frequenti per chiarire le loro differenze e i casi d’uso pratici.

-

L'analisi dei documenti è la stessa cosa del web scraping?

-

No. L’analisi dei documenti lavora con file come PDF, immagini scansionate o email che già possiedi o hai ricevuto, mentre il web scraping estrae dati dai siti web analizzando HTML o contenuti visualizzati.

-

Parseur è uno strumento API di web scraping?

-

No. Parseur è un'API per l'estrazione di dati da documenti ed email, non uno strumento di web scraping. Non esegue la scansione né il recupero di pagine web. Ti aiuta invece a trasformare i documenti che possiedi, come email, PDF, immagini o file Office, in JSON strutturato e pulito. Questo lo rende ideale per flussi di lavoro come la gestione di fatture, ricevute e ordini di acquisto senza dover costruire strumenti interni complessi.

-

Il web scraping è legale?

-

Dipende dal contesto. Lo scraping di dati pubblici a volte è consentito, ma i siti web spesso indicano restrizioni nei loro termini di servizio o nel file robots.txt. Controlla sempre questi documenti e consulta un legale prima di procedere.

-

Quando dovrei evitare lo scraping?

-

Lo scraping va evitato quando i dati sono dietro paywall, soggetti a controlli di accesso rigidi o esplicitamente proibiti dai termini di servizio del sito. Cercare di aggirare le restrizioni può comportare rischi di conformità e legali.

Ultimo aggiornamento il