What Is Data Quality?

データ品質とは、情報がその目的に対してどれだけ正確で、網羅され、一貫性を持ち、信頼できるかを指します。オートメーションでは、マシンは迷わず与えられたデータで動作するため、データ品質はさらに重要です。

Key Takeaways

- Parseurのようなツールは、クリーンでコンプライアンスに準拠した実用的なデータによるオートメーションの大規模展開を可能にします。

- VACUUM や ECCMA (Electronic Commerce Code Management Association) のようなフレームワークが、信頼できるデータ管理の構造を提供します。

- AI、検証、クリーニング技術がオートメーションの正確性と信頼性を高めます。

データ品質が損なわれると単なる不便に留まらず、企業に多大なコストをもたらします。不正確または不完全なデータはリソースの無駄遣いやコンプライアンスリスク、不適切な意思決定を招き、年間数百万ドル規模の損失にもつながります。オートメーション化が進む時代では、このリスクは一層重大です。いわゆる「ゴミを入れればゴミが出る(GIGO)」という原則がそのまま当てはまるのです。不良データをオートメーションへ流せば、結果も不良なものしか得られません。

Resolveの調査によると、手作業のデータ処理エラー率は3~5%ですが、自動化すれば0.5~1.5%まで低減し、導入から6か月でコストのかかるエラーを60~80%削減できます。オートメーション効果の大きさと同時に、データ品質の維持がいかに事業へ直接的に影響するかが分かります。数%の誤りでも大量処理時には莫大な損失となるため注意が必要です。さらにTechmentは、「品質の悪いデータは年10〜30%の売上損失原因となり、米国経済全体で3.1兆ドルもの損失を生んでいる」と報告しています。

このようにオートメーションにおけるデータ品質は、AI活用の書類処理や高度なワークフロー構築を目指す企業にとって不可欠な基盤です。高品質なデータは正確性だけでなく、一貫性や信頼性も伴います。データ品質の低下は自動化の価値を大きく損なうことになります。

本記事では、オートメーションのためのデータ品質維持のポイントを明快に解説します。VACUUMやECCMAなどのフレームワーク、GIGO原則、AIによる自動パース・バリデーション、人の介在(HITL)など、実践的なアプローチを紹介。最終的には、企業がクリーンで正確・アクション可能なデータを用いた自動化をどのように実現できるかが分かります。

What Is Data Quality?

良好なデータ品質は次の要素で構成されます:

- 正確性 – データ値が事実に即している(例:請求書の合計が実際の請求金額と一致している)。

- 完全性 – すべての重要項目が記録され抜け漏れがない(例:契約書に開始日・終了日が記載されている)。

- 一貫性 – 異なるシステム間で情報の表記や内容がバラバラになっていない(例:CRMとERPの顧客IDが一致している)。

- 信頼性 – 最新で、かつ信頼できる情報源から取得されている。

高品質なデータがオートメーションシステムで扱われることで、ワークフローはスムーズに運び、意思決定の迅速化、エラーの最小化が可能になります。一方で、品質が低ければ重複データや法令違反、誤判断といったリスクが増し、規模が大きいほど影響も甚大です。

つまりオートメーションにおけるデータ品質は、すべての自動化アクションの信頼性を保障する「土台」です。データ品質なくしてAIや機械学習の高度な成果も望めません。

Why Data Quality Matters in Document Processing Automation

データ品質は単なる技術的な要素にとどまりません。ビジネスの成否を左右する根本的なファクターです。自動化ワークフローが低品質なデータを処理すると、その悪い影響は全社へ波及します。

効率

- 不正確なデータは自動パイプラインを滞らせます。

- 手作業での修正が必要となり、生産性が大きく低下します。

コスト

- MIT Sloanによれば、品質の悪化で売上の15~25%にも相当するコストが発生します。

- ミスが自動化のプロセス内で急速に広がります。

コンプライアンス

- 契約、請求書、医療書類のミスはコンプライアンス違反や罰則、法的リスクに直結します。

顧客信頼

- 誤った請求や配送ミス、不適切な書類送付により顧客の信頼やブランドイメージが損なわれます。

これらの問題はオートメーション化によるスピードやスケールの効力を逆転させるリスクも含んでいます。悪いデータはシステム全体に波及し、「ゴミを入れればゴミが出る」という原則が現実となります。

The VACUUM Model: Framework For Data Quality

VACUUMモデルはデータ品質評価で広く認識されたフレームワークです。情報の信頼性や有用性を6つの側面から定義します。オートメーションにおけるデータ品質を担保するためには、このモデルを活用した抽出データの評価が必須です。

各側面の概要:

- 有効性(Valid) – データが定められたフォーマットやルールどおりか(例:請求書日付が正しい形式)。

- 正確性(Accurate) – データが現実を正しく反映している(例:医療フォームのIDがシステムと一致)。

- 一貫性(Consistent) – 複数データソース間で情報がぶれない(例:ベンダー名が複数書類で同一表記)。

- 均一性(Uniform) – 重複やばらつきを防ぐ(例:同じ送り状を重複処理しない)。

- 統一性(Unified) – 単位や通貨、フォーマットを統一する(例:通貨単位をUSDに揃える)。

- 有意性(Model/Meaningful) – 抽出データが目的に沿い有用である。

ドキュメント自動抽出(請求書、医療書類、配送伝票など)でVACUUMモデルを適用すれば「デジタル化しただけ」でなく「ビジネスで信頼できる」アウトプットを保証できます。

Challenges In Data Quality For Automation Workflows

自動化ツールを導入しても、データ品質維持には数多くの課題があります。Preciselyの2025年最新調査では、64%の組織がデータ品質を最大の障害に挙げ、67%が意思決定時に自社データを完全に信頼していないと回答しています。これは信頼できるデータの欠如が自動化とAIシステム全体の価値を低下させることを意味します。

このリスクは現実的です。Monte Carloのケースでは、物流のマーケットプレイスでデータエラーがAIモデルに流れ込み、誤った入札予測や市場の崩壊、1年間で400件超のインシデント・2,400時間のデータ停止・270万ドルの損失を招き、その後撤退に追い込まれました。

自動化ワークフローでの主な課題

- 非構造データ → 各種ドキュメントは形式・レイアウト・言語が多様で正確抽出が困難。

- 人為的エラー → タイポや抜け、ラベル不統一が下流に拡大。

- スケーラビリティ → 少量なら問題がなくても大規模処理になると小さな揺らぎが大きな障害に。

- 検証の欠如 → チェック体制がなければ誤った数値データやIDがそのまま流通。

Garbage In, Garbage Out (GIGO)

こうした課題は古典的な「ゴミを入れればゴミが出る(GIGO)」原則と同じです。悪データは自動修正されることなく規模の分だけ拡大されるため、上流で止めることが重要です。

特にドキュメント自動化では:

- 非構造・乱雑データ – スキャンPDFや手書きフォームなどの抽出精度は低下しがち。

- 入力時の人為ミス – IDや品番の一字違いで支払い遅延や誤配送、法令違反に発展。

- データ表記のバラつき – 日付/通貨/単位の表現不一致がシステム処理を妨げる。

- 規模の課題 – 少数のエラーなら対処できても、大規模化で収拾がつかなくなる。

典型事例:

- 請求書処理 → OCRが「$1,249.99」を「$12,499.9」と誤認し、ERPに誤データ登録。

- 医療フォーム → 不鮮明なスキャンで患者IDの誤認識、記録ミスや規制違反に。

- 配送伝票 → バーコードの読み取りミスで誤った送付先登録、遅延・クレーム発生。

教訓として、厳格な品質管理の下で検証・クリーニング・人のチェック(HITL)を運用しない限り、自動化導入はかえって負のインパクトを拡大するリスクに繋がります。

ECCMA Standards And ISO 8000 For Global Data Quality

オートメーションにおけるデータ品質では、社内フレームワークだけでなく業界全体での一貫性やコンプライアンスの確保も必要です。Electronic Commerce Code Management Association (ECCMA)はデータ品質の国際標準策定を担い、組織間のデータ一貫性・相互運用性・各種規制準拠を推進しています。

ECCMAはISO 8000(国際データ品質標準)の策定・管理を主導。あらゆる業界で高品質なマスターデータを生成・管理・流通させるためのベストプラクティスを規定します。自動化ワークフローにECCMA標準を適用することで、機械が「読める」だけでなく「正しく意味が通じ、国際的にも連携できる」状態を作れます。

ECCMAデータ品質標準が自動化・書類処理で重要な理由:

- システム連携の一貫性 → 請求書・契約書などの抽出データがERP/CRMや会計システムに適合し食い違いを防止。

- 高い正確性・信頼性 → 曖昧・不統一な情報をルール化し、コストや混乱・リスクを低減。

- 監査準拠 → 会計・医療・物流等で求められる監査証跡や法的要件にも対応。

たとえばECCMA準拠のシステムなら、金額項目を所定のタグ付き・正規フォーマットで抽出・変換し、会計ソフト等へ瞬時に連携可能です。

ParseurではAI抽出+標準化検証を組み合わせ、オートメーション流通前からデータの品質と遵法性を確保しています。

VACUUMとECCMA:データ品質の双方を担う枠組み

| 要素 | VACUUMモデル | ECCMA標準 |

|---|---|---|

| フォーカス | データ品質評価のための概念的フレームワーク | 高品質データの作成・管理・交換のための国際標準(ISO 8000) |

| 適用範囲 | 抽出データが目的に適合するかを評価 | 相互運用性や法令遵守に必要なグローバルルールを規定 |

| 強み | 業種やワークフローを問わず柔軟に適用可能 | システムや国境を越えた標準化を担保 |

| 自動化での役割 | 請求書・フォーム・契約書などから抽出したデータの品質基準適合度を測定 | 抽出データを普遍的な構造でフォーマットし、下流システムで一貫して解釈できるようにする |

AI in Data Quality Automation: Smarter Validation And Error Detection

AI(人工知能)はオートメーション時代のデータ品質確保に革新をもたらしています。従来のルールベース検証や手作業によるチェックを補完し、柔軟で進化する品質管理を実現します。

AI活用による主な品質向上ポイント:

- コンテキスト認識バリデーション → AIは情報の意味・文脈を理解し、誤った日付や通貨・IDのミスも自動検知。

- エンティティ認識 → 多様なレイアウトや非構造書類から特定フィールド(合計金額・住所など)を高精度抽出。

- 異常・エラー自動検知 → 異常値や典型的な入力ミスパターンを検出し、修正案も提示可能。

- 継続的学習 → 運用中のフィードバックを元に精度が向上し、活用すればするほど品質も改善。

- 多言語・多形式対応 → 多言語の書類や各種スクリプトに対応し、グローバルでも一貫した品質維持が可能。

つまりAIは単なる抽出ツールではなく、正確性・一貫性・信頼性向上の起爆剤となります。自動化をスケールしながら品質も担保したい企業にとって不可欠な要素です。

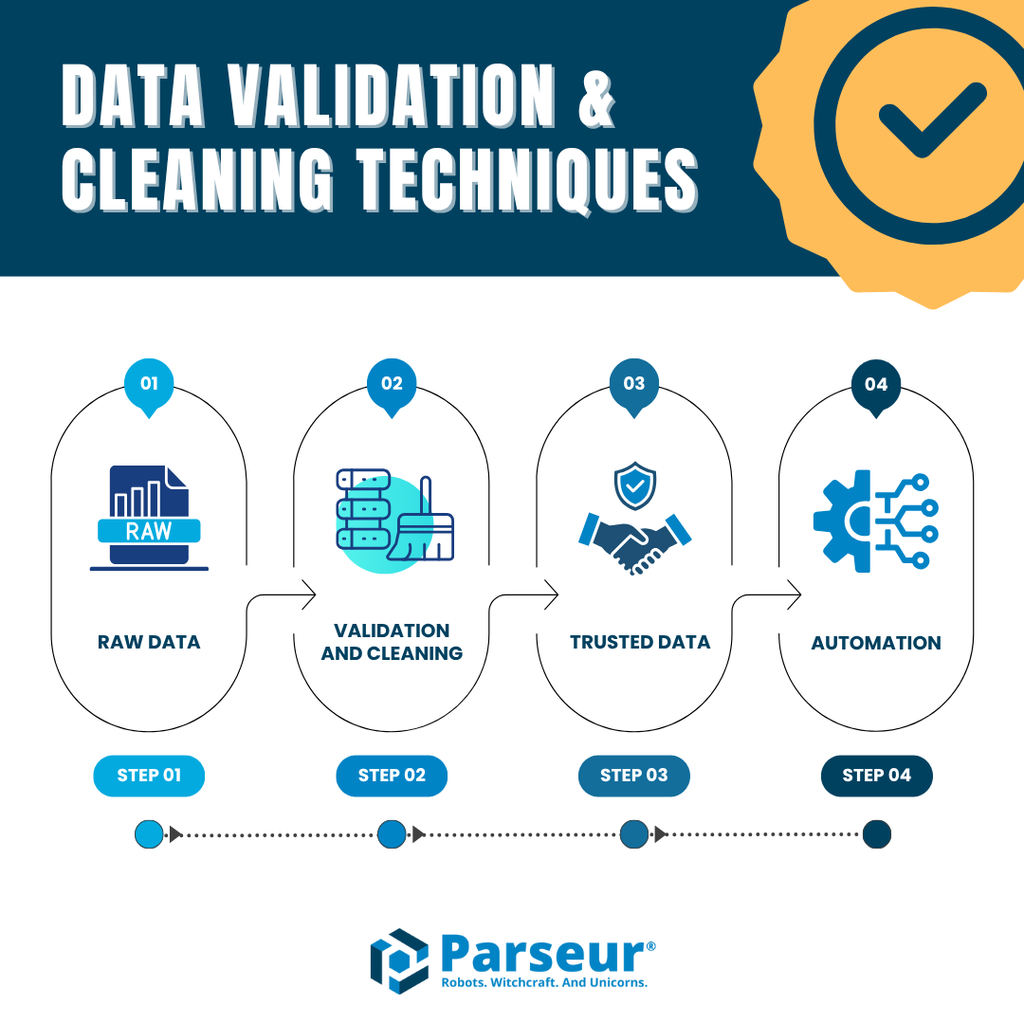

Data Validation & Cleaning Techniques

オートメーション時代のデータ品質を維持するには抽出や自動化だけでなく、バリデーションやクリーニングも不可欠です。これらの工程がなければ先端のOCRやAI導入でもエラーは排除できません。

主要な品質維持テクニック:

- 自動フィールド検証 → フィールドごとに期待フォーマット(数値・日付・ID構造など)で自動チェック。

- 重複検知 → 二重登録や誤処理を防ぎ工数・混乱を削減。

- 正規化 → 日付・通貨・住所・電話番号などを共通基準で統一。

- エラーフラグ&例外抽出 → 金額不一致やデータ抜けを下流流通前に自動発見。

- 人による品質チェック(HITL) → AIで判定困難な特例や特殊パターンは人間の目で確実に確認。

Parseurのような自動化ツールは、テンプレート不要の抽出・内蔵検証・システム連携まで備えて「高品質なスケーラブル自動化データ」を実現しています。

詳しくはデータ検証とデータクリーニング手法の解説もご覧ください。

How Parseur Ensures Data Quality

Parseurは実際の業務ユースに根差したアプローチでオートメーションにおけるデータ品質強化を図ります。OCRやテンプレートだけに頼らず、AI抽出・内蔵バリデーション・多彩なシステム連携が一体構造になっています。また、AIが出力したデータが必須要件を満たすよう品質強制の仕組みも持っています。カスタム条件付与などで企業独自のルールにも柔軟対応可能です。

Parseurの主なデータ品質強化ポイント:

- テンプレート不要抽出 → 請求書・レシート・契約・配送書など多様なレイアウトに高精度対応。

- 高水準の抽出精度 → フィールド単位で90~99%の精度。非構造・多様データにも強み。

- 自動検証・クリーニング → 重複・フォーマットミス・異常検出を自動化、下流システム流通前の信頼性確保。

- あらゆる連携 → Google SheetsやSQL、ERP/CRMなどへクリーンな構造化データを直接連携。

実務効果例:

- 金融では請求合計や税IDを正確抽出し、手動入力を約80%削減。

- 物流では出荷伝票情報を分解・抽出し、IDや住所をリアルタイムでシステム連携。

VACUUMやECCMA標準などに即した運用で、Parseurは「単なる自動化」ではなく、正確性・信頼性・法令順守一体型の自動化を実現します。

Conclusion

オートメーションの真価はクリーンで一貫し信頼できるデータの上に成り立ちます。悪いデータ品質は効率低下・コスト増・顧客信頼損失の原因となりますが、VACUUMやECCMA、AIバリデーション・人の介在といった強力な実践で自動化は真のビジネス競争力を築きます。

最終的に、オートメーションで達成できる価値はデータ品質次第です。データ品質に投資することで、あらゆる自動意思決定が正確・コンプライアンス準拠・信頼性を備えたものとなります。

Parseurなら正確・信頼性・国際標準に合致した自動化が実現できます。請求書や医療フォーム、配送伝票もParseurなら高品質データでオートメーションを実現可能です。

よくある質問

オートメーションにおけるデータ品質の確保は複雑ですが極めて重要な課題です。ビジネスでは、フレームワークや標準、ツールがどのように組み合わさってオートメーションの正確性と信頼性を保つのかがよく問われます。以下に、最も一般的な質問とその回答をまとめました。

-

オートメーションにおけるデータ品質とは何ですか?

-

オートメーションにおけるデータ品質は、自動化されたシステム内を流れるデータの正確性、一貫性、信頼性を意味します。高品質なデータはワークフローをスムーズに進めますが、低品質なデータはエラーや非効率、コンプライアンスリスクをもたらします。

-

なぜオートメーションでデータ品質が重要なのですか?

-

オートメーションは入力データに基づいて意思決定を行います。もしデータに不備があれば、そのエラーはスケールに合わせて拡大されます。強固なデータ品質はコスト削減、効率向上、自動プロセスへの信頼構築につながります。

-

データ品質におけるVACUUMモデルとは?

-

VACUUMモデルは、データ品質の6つの主要側面「有効性、正確性、一貫性、一意性、均一性、有意性」を定義します。このフレームワークは、抽出データの信頼性やオートメーションへの有用性を評価する指標です。

-

ECCMAのデータ品質標準とは何ですか?

-

ECCMAは、ISO 8000などのグローバルなデータ品質標準を策定しています。これらの標準はデータの一貫性、相互運用性、業界規制への準拠を促進し、オートメーションのアウトプットを信頼性ある監査可能なものにします。

-

企業はオートメーションでどのようにデータ品質を向上できますか?

-

検証、クリーニング、正規化、重複検知、人のチェックを交えた仕組みによりデータ品質を高められます。ParseurのようなAIドリブンツールは、正確かつ実用的なデータでオートメーションを実現する工程を簡略化します。

-

Parseurはどのようにデータ品質を担保していますか?

-

ParseurはAIによるテンプレート不要の抽出、組み込みの検証・クリーニング・連携機能を用います。VACUUMやECCMAなどのベストプラクティスに準拠し、業界横断的に精度・信頼性・スケーラビリティのあるオートメーションを提供しています。

最終更新日