¿Qué es la Calidad de los Datos?

La calidad de los datos se refiere al nivel de precisión, completitud, coherencia y fiabilidad de la información para cumplir su propósito. En los procesos de automatización, la calidad de los datos es aún más importante, ya que las máquinas dependen totalmente de los datos suministrados para tomar decisiones y ejecutar acciones.

Puntos Clave

- Herramientas como Parseur permiten escalar la automatización con datos limpios, conformes y listos para usar.

- Marcos como VACUUM y ECCMA (Electronic Commerce Code Management Association) proporcionan una base estructurada para garantizar datos confiables.

- La inteligencia artificial, la validación automatizada y la limpieza de datos refuerzan la precisión y fiabilidad de la automatización.

La mala calidad de los datos no es solo una incomodidad; representa un elevado coste empresarial. Los estudios demuestran que los datos imprecisos o incompletos le cuestan millones a las empresas cada año en recursos desperdiciados, sanciones por incumplimiento y decisiones erróneas. En el contexto de la automatización, el impacto negativo se amplifica, ya que la máxima "basura entra, basura sale" ("GIGO") sigue siendo cierta: si la automatización utiliza datos defectuosos, los resultados serán igual de erróneos.

Según Resolve, el procesamiento manual de datos genera tasas de error entre el 3% y el 5%, mientras que la automatización puede reducir ese margen al 0,5–1,5%, logrando una reducción del 60–80% en errores costosos durante los primeros seis meses. Estas cifras evidencian el vínculo directo entre automatización y eficiencia, y resaltan la necesidad de mantener datos de calidad, ya que incluso pequeños errores, cuando se escalan, pueden provocar consecuencias significativas. De hecho, la mala calidad de los datos puede representar hasta el 20–30% de las pérdidas anuales de ingresos, costando a la economía estadounidense 3,1 billones de dólares al año, según Techment.

Por este motivo, la calidad de los datos en la automatización se ha convertido en un aspecto estratégico para las organizaciones que adoptan flujos automatizados impulsados por IA. No solo se trata de precisión, sino también de coherencia, fiabilidad y confianza; sin estos elementos, la automatización no logra su máximo valor.

En este artículo, detallamos los elementos esenciales para asegurar la calidad de los datos en entornos automatizados. Analizaremos marcos como VACUUM y ECCMA, revisaremos desafíos habituales, como GIGO, y abordaremos soluciones prácticas, incluyendo validación basada en IA, limpieza de datos y revisión humana (HITL). Al concluir, verás cómo las empresas pueden mantener sus sistemas automatizados con datos limpios, precisos y confiables.

¿Qué es la Calidad de los Datos?

Una buena calidad de los datos implica:

- Precisión – los valores son correctos (por ejemplo, el importe total de una factura corresponde a la cantidad facturada).

- Completitud – no faltan campos críticos (por ejemplo, un contrato contiene tanto la fecha de inicio como la de finalización).

- Coherencia – la misma información se representa de la misma manera en todos los sistemas (por ejemplo, los IDs de clientes coinciden tanto en el CRM como en el ERP).

- Fiabilidad – los datos están actualizados y provienen de fuentes verificadas.

Cuando los sistemas automáticos procesan datos de alta calidad, los flujos de trabajo son eficientes, las decisiones se agilizan y los errores disminuyen considerablemente. Si la calidad de los datos falla, aparecen riesgos como registros duplicados, problemas con el cumplimiento normativo e interpretaciones incorrectas, aspectos todos que se agravan por la propia naturaleza de la automatización.

En definitiva, la calidad de los datos en la automatización asegura que cada proceso automatizado esté respaldado por información confiable. Si esto no es así, incluso las soluciones de IA más avanzadas ofrecerán un rendimiento por debajo de lo esperado.

Por Qué la Calidad de los Datos es Clave en la Automatización del Procesamiento de Documentos

La calidad de los datos no es solo una cuestión técnica, sino un factor de decisión crítica para toda la empresa. Los flujos automatizados que operan con información de baja calidad impactan negativamente en todas las áreas organizativas.

Eficiencia

- Los datos imprecisos ralentizan las automatizaciones y obstaculizan la operación fluida.

- El retrabajo manual para corregir errores genera costes adicionales y pérdida de tiempo.

Coste

- Según MIT Sloan, la baja calidad de los datos puede costar entre el 15% y el 25% de los ingresos de una organización, debido a recursos desaprovechados, procesos ineficientes y oportunidades perdidas.

- Los errores se escalan rápidamente en sistemas automatizados.

Cumplimiento

- Los errores en contratos, facturas o informes médicos pueden provocar incumplimientos regulatorios, sanciones legales y pérdida de reputación.

Confianza del cliente

- Datos inexactos, como facturas incorrectas o información de envío equivocada, afectan negativamente la satisfacción y confianza del cliente.

Estos riesgos adquieren mayor relevancia con la automatización. Los datos erróneos no se quedan en una base de datos: recorren todo el sistema a gran velocidad y escala. Si no se gestiona la calidad, la automatización multiplica los errores en vez de eliminar problemas, reafirmando el principio basura entra, basura sale.

El Modelo VACUUM: Marco para la Calidad de los Datos

El modelo VACUUM es uno de los referentes más empleados para evaluar la calidad de los datos. Identifica seis dimensiones fundamentales para determinar si la información es fiable y adecuada para su uso. Dentro del contexto de la calidad de los datos en la automatización, el modelo VACUUM establece un método práctico para garantizar que los datos extraídos cumplen con los requisitos necesarios.

Cada dimensión del modelo VACUUM es:

- Válido – Los datos cumplen el formato o las reglas exigidas. Por ejemplo, la fecha de una factura debe estar correctamente estructurada.

- Preciso – Los datos reflejan la realidad correctamente. Un número de identificación de paciente debe coincidir exactamente con el registro oficial.

- Coherente – La información es uniforme entre fuentes y sistemas distintos. El nombre de un proveedor debe coincidir en todos los documentos donde aparece.

- Uniforme – Se evitan registros duplicados. El flujo automatizado nunca debería procesar el mismo documento más de una vez.

- Unificado – Se estandarizan unidades de medida, monedas y formatos. Las cantidades y divisas deben conservar criterio uniforme (por ejemplo, todos los montos expresados en una misma moneda).

- Significativo – Los datos extraídos deben aportar valor para la tarea prevista; por ejemplo, extraer el número de página de un contrato puede ser válido, pero no resulta relevante para la gestión contractual.

Aplicar VACUUM a la extracción automatizada de datos — como facturas, documentos legales o formularios médicos — ayuda a garantizar que no solo se digitaliza la información, sino que además es apta para su uso directo y fiable.

Desafíos de la Calidad de los Datos en Flujos de Automatización

Asegurar datos fiables sigue siendo retador, incluso con sistemas de automatización avanzados. Una encuesta global de Precisely 2025 indicó que el 64% de las organizaciones identifica la calidad de los datos como su reto principal, y el 67% admite que no confía plenamente en sus datos a la hora de tomar decisiones. Esta brecha demuestra que la automatización solo aporta valor con datos confiables, y la IA corre el riesgo de generar recomendaciones erróneas si la calidad no está asegurada.

El riesgo es real. Según el informe de Monte Carlo, un marketplace tecnológico logístico perdió millones por alimentar sus modelos de machine learning con datos corruptos de la automatización, lo que derivó en predicciones incorrectas y transacciones fallidas. En un solo año: 400 incidentes relacionados con datos, 2.400 horas de inactividad y una pérdida de al menos 2,7 millones de dólares en eficiencia. La empresa terminó cerrando por no abordar a tiempo sus problemas de calidad de los datos.

Desafíos Comunes en Flujos Automatizados

- Datos no estructurados → Facturas, contratos, formularios y documentos llegan en diferentes formatos, idiomas y estructuras, complicando la extracción eficiente.

- Errores humanos → Tipos de errores simples, campos en blanco o etiquetas inconsistentes suman imprecisiones relevantes en los procesos automatizados.

- Problemas de escalabilidad → Lo que funciona con 100 documentos puede fallar gravemente con 100.000 si existen incoherencias o defectos pequeños.

- Falta de validación → Sin controles automáticos, errores en totales, fechas o identificadores pasan desapercibidos en los sistemas posteriores.

Basura entra, basura sale (GIGO)

Estos desafíos reflejan el clásico principio informático: basura entra, basura sale (GIGO). Si al sistema ingresan datos incorrectos, los resultados también serán defectuosos. Lejos de solucionar el problema, la automatización amplifica el daño si no existe un control de calidad sólido.

Ejemplos en la automatización documental:

- Formatos desordenados – PDFs escaneados o manuscritos, facturas sin estructura clara o baja resolución dificultan la extracción precisa.

- Errores de origen – Un dígito incorrecto en el número de cliente puede ocasionar pagos fallidos o entregas erróneas.

- Datos inconsistentes – Monedas, fechas, unidades o direcciones en formatos diversos complican la automatización.

- Escalabilidad y replicación de errores – Un error puede ser controlado manualmente, pero en procesos automáticos, ese fallo se propaga a miles de registros al instante.

Casos reales de GIGO:

- Procesamiento de facturas → Un sistema OCR interpreta “$1,249.99” erróneamente como “$12,499.9”; si no hay validación, esta cifra inflada distorsiona los registros financieros.

- Formularios médicos → Un identificador mal extraído por un escaneo deficiente puede provocar fallos en registros o infracciones regulatorias.

- Documentos de envío → Un código de barras ilegible se traduce en direcciones equivocadas y entregas perdidas.

La conclusión es clara: sin reglas de validación, limpieza de datos y revisión humana, la automatización no solo mantiene los errores, sino que los potencia. Corrigiendo la calidad de los datos se reducen costes, retrabajo y sanciones normativas.

Estándares ECCMA e ISO 8000 para Calidad Global de los Datos

Al hablar de calidad de los datos en la automatización, los marcos de referencia deben complementarse con estándares reconocidos. Muchas empresas recurren a la Electronic Commerce Code Management Association (ECCMA), que desarrolla y promueve estándares internacionales como la ISO 8000 para garantizar la consistencia, interoperabilidad y cumplimiento.

ECCMA es responsable de la ISO 8000, el estándar global sobre calidad de los datos, que recoge las mejores prácticas para crear, gestionar e intercambiar datos maestros en cualquier industria. Dentro de los flujos automatizados, estos estándares aseguran que los datos extraídos no solo sean legibles por sistemas, sino también relevantes y compatibles internacionalmente.

La relevancia de los estándares de calidad de datos ECCMA en la automatización y el procesamiento documental es indiscutible:

- Consistencia sistémica → Los estándares ECCMA garantizan que la información fluya sin fricciones entre ERPs, CRMs y plataformas contables.

- Precisión y fiabilidad → La definición de reglas claras en formato y estructura reduce errores por ambigüedad o duplicidad.

- Auditoría y cumplimiento → Facilitan adaptarse a normativas y requisitos regulatorios en sectores como finanzas, sanidad y logística.

Por ejemplo, una factura alineada con ECCMA no solo extraerá el campo "total" sino que lo etiquetará y presentará en un formato que cualquier sistema contable pueda procesar sin errores.

En Parseur, seguimos estos estándares internacionales mediante extracción inteligente por IA e integraciones con validación y normalización, asegurando que tus datos siempre sean aptos para automatización y conformes.

VACUUM vs ECCMA: Dos Enfoques Complementarios para la Calidad de los Datos

| Factor | Modelo VACUUM | Estándares ECCMA |

|---|---|---|

| Enfoque | Marco conceptual para evaluar la calidad de los datos. | Estándar internacional para crear, gestionar e intercambiar datos de alta calidad (ISO 8000). |

| Alcance | Evalúa si los datos extraídos son aptos para el uso previsto. | Proporciona reglas reconocidas a nivel global para interoperabilidad y cumplimiento. |

| Fortaleza | Flexible, fácil de aplicar a cualquier sector y workflow. | Garantiza estandarización entre sistemas y fronteras. |

| Aplicación en automatización | Se usa para medir si los datos extraídos de facturas, formularios o contratos cumplen los criterios de calidad. | Asegura que los datos extraídos tengan un formato universalmente consistente que los sistemas puedan interpretar. |

La IA en la Automatización de la Calidad de los Datos: Validación y Detección de Errores Inteligente

La inteligencia artificial (IA) está revolucionando la mejora de la calidad de los datos en la automatización. Los métodos tradicionales como revisiones manuales o validaciones basadas en reglas, aunque útiles, resultan insuficientes a gran escala. La IA añade flexibilidad, adaptabilidad y aprendizaje continuo al proceso.

¿Cómo potencia la IA la calidad de los datos?

- Validación contextual → Los modelos de IA analizan datos en contexto y detectan errores sutiles, como fechas o divisas mal asignadas.

- Reconocimiento inteligente de entidades → El aprendizaje automático identifica campos clave (como totales, IDs, direcciones) en documentos variados.

- Detección y corrección autónoma → La IA identifica anomalías (por ejemplo, un cálculo de impuestos erróneo) y sugiere modificaciones automáticamente.

- Aprendizaje continuo → Los sistemas avanzan y optimizan su precisión conforme procesan más documentos.

- Soporte multilingüe → Gestionan distintos idiomas y formatos, asegurando consistencia global.

La IA no solo recopila información; trabaja activa y continuamente para mejorar la coherencia, fiabilidad y utilidad de los datos, función decisiva a medida que crecen los procesos automatizados.

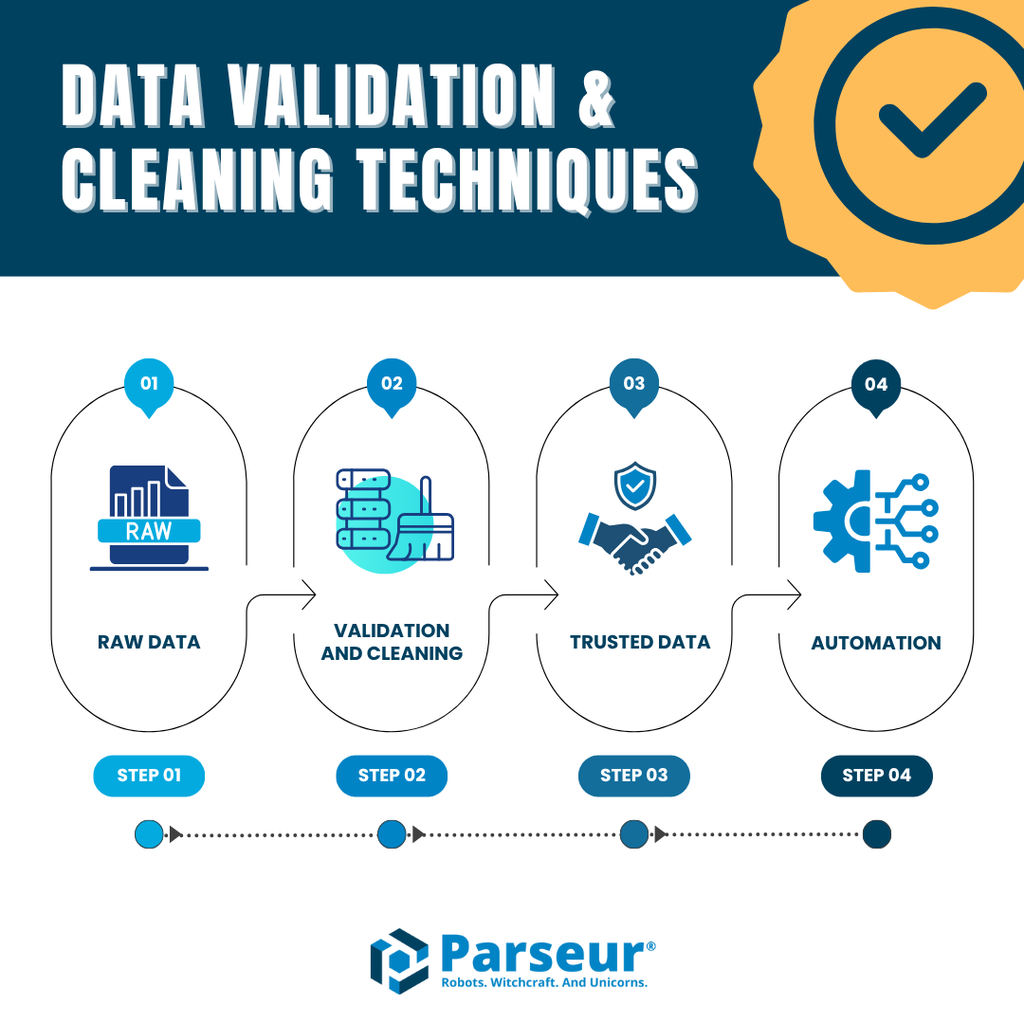

Técnicas de Validación y Limpieza de Datos

Para mantener la calidad de los datos en la automatización, la extracción debe complementarse con validación y limpieza. Omitir estos pasos permite que los errores pasen y contaminen los procesos automatizados.

Entre las principales técnicas se encuentran:

- Chequear automáticamente los campos → Validar que cada campo cumpla el formato esperado (fechas, importes, identificadores).

- Detección y gestión de duplicados → Evita que registros repetidos entren en tu sistema, reduciendo errores y cargas innecesarias.

- Normalización de datos → Uniformizar valores como fechas, monedas o direcciones para asegurar coherencia entre plataformas (por ejemplo: convertir todos los formatos de fecha a uno único).

- Marcado de errores y excepciones → Identificar anomalías antes de que la información llegue a los sistemas de destino.

- Revisión humana (HITL) → Cuando existen dudas o casos límite, la supervisión rápida humana asegura precisión sin demoras en el flujo automatizado.

Herramientas como Parseur automatizan estas tareas clave. Con extracción sin plantillas, validación avanzada e integraciones directas a ERPs, CRMs o software contable, Parseur ayuda a escalar la automatización manteniendo tus datos limpios, precisos y listos para usar.

Si quieres saber más, explora nuestras guías de validación de datos y técnicas de limpieza de datos para descubrir cómo estas estrategias fortalecen los procesos automatizados.

Cómo Parseur Garantiza la Calidad de los Datos

Al asegurar la calidad de los datos en la automatización, Parseur ofrece un enfoque integral y orientado a resultados empresariales. A diferencia de otras soluciones que dependen exclusivamente del OCR o plantillas fijas, Parseur combina IA, validación dinámica y conectores automáticos, además de funciones que verifican que la salida cumpla exactamente con los requerimientos específicos del usuario. Puedes mejorar aún más los resultados de extracción adaptando instrucciones personalizadas a tus necesidades concretas.

Funciones distintivas de Parseur para reforzar la calidad de los datos:

- Extracción sin plantillas → Se adapta a diseños variados de facturas, recibos, contratos o formularios, sin depender de plantillas rígidas.

- Alta precisión → Logra de forma consistente entre un 90% y un 99% de exactitud por campo, incluso con datos no estructurados o layouts complejos.

- Validación y limpieza automática → Identifica duplicados, errores de formato y anomalías para asegurar que la información procesada sea fiable.

- Integraciones instantáneas → Envía datos precisos y estructurados directamente a Google Sheets, SQL, ERPs, CRMs o sistemas contables, sin requerir plataformas intermedias.

Impacto en el día a día:

- En finanzas, Parseur permite extraer totales, identificadores fiscales e información de pago casi sin errores, lo que reduce hasta un 80% el tiempo dedicado a tareas manuales.

- En logística, empresas automatizan el análisis de órdenes de transporte y albaranes, asegurando que IDs de envío y direcciones sean confiables y se integren apropiadamente en los sistemas de seguimiento.

Al aplicar referentes como el modelo VACUUM y los estándares ECCMA, Parseur permite a las organizaciones automatizar el procesamiento de documentos con garantías de precisión, trazabilidad y cumplimiento normativo.

Conclusión

La automatización ofrece velocidad, escalabilidad y eficiencia, pero solo si la información que la impulsa es limpia, equilibrada y confiable. Como hemos visto, la mala calidad de los datos obstaculiza la eficiencia, aumenta los costes y erosiona la confianza. En cambio, aplicar marcos como VACUUM, estándares ECCMA e incorporar IA y validación humana convierte la automatización en una ventaja real y competitiva.

En resumen, la fuerza de la automatización depende directamente de la calidad de los datos que procesa. Invertir en mejores prácticas y tecnología asegura decisiones más precisas, cumplimiento y resultados fiables.

Con Parseur, accedes a una automatización precisa, confiable y alineada con las mejores normativas globales. Ya sea que gestiones facturas, datos de pacientes o documentos logísticos, Parseur garantiza que tu automatización funcione siempre sobre datos de alta calidad.

Preguntas Frecuentes

Garantizar la calidad de los datos en la automatización es una tarea compleja pero vital. Las empresas suelen preguntar cómo encajan los marcos, estándares y herramientas para mantener la automatización precisa y confiable. A continuación, encontrarás respuestas a algunas de las preguntas más comunes:

-

¿Qué es la calidad de los datos en la automatización?

-

La calidad de los datos en la automatización se refiere a la precisión, coherencia y fiabilidad de los datos que circulan por los sistemas automatizados. Los datos de alta calidad aseguran que los flujos de trabajo funcionen sin problemas, mientras que los datos deficientes generan errores, ineficiencias y riesgos de cumplimiento.

-

¿Por qué es importante la calidad de los datos para la automatización?

-

La automatización depende de los datos de entrada para tomar decisiones. Si los datos son defectuosos, la automatización amplificará los errores a gran escala. Una buena calidad de los datos reduce costes, aumenta la eficiencia y genera confianza en los procesos automatizados.

-

¿Qué es el modelo VACUUM en términos de calidad de los datos?

-

El modelo VACUUM define seis dimensiones clave de la calidad de los datos: Validez, Precisión, Coherencia, Unicidad, Uniformidad y Significatividad. Proporciona un marco para evaluar si los datos extraídos son confiables y utilizables en la automatización.

-

¿Cuáles son los estándares de calidad de datos de ECCMA?

-

ECCMA desarrolla estándares globales de calidad de los datos, incluyendo la norma ISO 8000. Estos estándares aseguran consistencia, interoperabilidad y cumplimiento en la industria, haciendo que los resultados de la automatización sean más confiables y listos para auditorías.

-

¿Cómo pueden las empresas mejorar la calidad de los datos en la automatización?

-

Las empresas pueden mejorar la calidad de los datos mediante validación, limpieza, normalización, detección de duplicados y revisión por humanos. Herramientas impulsadas por IA como Parseur simplifican estos pasos, asegurando que la automatización funcione con datos precisos y procesables.

-

¿Cómo garantiza Parseur la calidad de los datos?

-

Parseur utiliza extracción potenciada por IA, sin plantillas, con validación y limpieza integradas, así como integraciones automatizadas. Se alinea con las mejores prácticas como VACUUM y ECCMA para ofrecer automatización precisa, confiable y escalable para cualquier industria.

Última actualización el