Was ist Datenqualität?

Datenqualität bezeichnet, wie exakt, vollständig, konsistent und vertrauenswürdig Informationen für ihren vorgesehenen Zweck sind. Insbesondere in der Automatisierung gewinnt die Datenqualität an enormer Bedeutung, denn Maschinen treffen Entscheidungen ausschließlich auf Basis der gelieferten Daten – ohne menschliches Hinterfragen.

Wichtige Erkenntnisse

- Tools wie Parseur ermöglichen skalierbare Automatisierung mit sauberen, konformen und nutzbaren Daten.

- Frameworks wie VACUUM und ECCMA (Electronic Commerce Code Management Association) bieten strukturierte Ansätze, um Daten zuverlässig zu gestalten.

- Künstliche Intelligenz, Validierung und automatisierte Bereinigung steigern die Genauigkeit und schaffen Vertrauen in Automatisierungen.

Schlechte Datenqualität ist keineswegs nur ein Ärgernis, sondern ein teurer Risikofaktor. Studien zeigen, dass fehlerhafte oder unvollständige Daten Unternehmen jährlich Millionen kosten – durch Ressourcenverschwendung, Compliance-Verstöße und Fehlentscheidungen. Im Zeitalter der Automatisierung ist das Risiko noch größer. Das Prinzip „Garbage in, Garbage out“ (GIGO) bleibt entscheidend: Fehlerhafte Inputdaten führen auch zu fehlerhaften Ergebnissen.

Laut Resolve verursachen manuelle Datenverarbeitungen Fehlerquoten von 3–5 %, während Automatisierung diese auf 0,5–1,5 % senken kann – eine Reduktion von teuren Fehlern um 60–80 % innerhalb von sechs Monaten nach Einführung. Diese Verbesserungen belegen den Einfluss von Automatisierung auf die Effizienz, machen aber ebenso deutlich: Schon kleine Datenmängel bewirken großflächige Probleme. Wie Techment berichtet, kann schlechte Datenqualität bis zu 20–30 % des Umsatzes kosten und führt in den USA zu einem volkswirtschaftlichen Schaden von 3,1 Billionen US-Dollar jährlich.

Deshalb ist die Datenqualität in der Automatisierung ein zentrales Thema für Unternehmen, die auf KI-gestützte Dokumentenverarbeitung und smarte Workflows setzen. Hochwertige Daten sorgen nicht nur für Genauigkeit, sondern auch für Konsistenz, Zuverlässigkeit und Vertrauen. Ohne diese Basis bleibt Automatisierung unter ihrem Potenzial.

Der folgende Beitrag beleuchtet, wie Sie die Datenqualität in automatisierten Systemen sichern. Sie erhalten einen Überblick über Frameworks wie VACUUM und ECCMA, erfahren mehr über Herausforderungen wie GIGO und lernen praktische Lösungswege rund um KI-gestütztes Parsing, automatisierte Validierung und Human-in-the-Loop (HITL)-Kontrollen kennen. So sorgen Sie dafür, dass Ihre Prozesse auf genauen, sauberen und verwertbaren Daten beruhen.

Was ist Datenqualität?

Hohe Datenqualität umfasst:

- Genauigkeit – Alle Werte sind korrekt, z. B. stimmt der Rechnungsbetrag exakt mit der Forderung überein.

- Vollständigkeit – Wichtige Felder sind nicht leer, etwa sind sowohl Start- als auch Enddatum eines Vertrags vorhanden.

- Konsistenz – Informationen werden systemübergreifend gleich dargestellt, z. B. stimmen Kunden-IDs in CRM und ERP überein.

- Zuverlässigkeit – Daten stammen aus aktuellen, vertrauenswürdigen Quellen.

Automatisierungssysteme funktionieren optimal mit hochwertigen Daten: Workflows laufen störungsfrei, Entscheidungen werden rasch getroffen und Fehlerquellen minimiert. Schlechte Datenqualität führt dagegen rasch zu doppelten Datensätzen, Compliance-Risiken oder verzerrten Analysen – und all diese Schwächen verbreiten sich durch Automatisierung blitzschnell.

Kurz zusammengefasst: Datenqualität in der Automatisierung stellt sicher, dass jeder automatisierte Prozess auf verlässlichen Informationen basiert. Ohne diese solide Grundlage bringen auch die besten KI- und Machine-Learning-Modelle keine überzeugenden Ergebnisse.

Warum ist Datenqualität in der Dokumentenverarbeitungs-Automatisierung so wichtig?

Datenqualität entwickelt sich von einem technischen Aspekt zu einem erfolgskritischen Geschäftsmerkmal. Wenn automatisierte Workflows auf minderwertigen Daten gründen, spüren Unternehmen die Auswirkungen an vielen Ecken.

Effizienz

- Unpräzise Daten verlangsamen Automatisierungspipelines.

- Manuelle Nachbearbeitung wird teurer und bindet Ressourcen.

Kosten

- Nach MIT Sloan verursacht schlechte Datenqualität bei Unternehmen durchschnittlich 15–25 % Umsatzverlust durch Ressourcenverschwendung, Prozessineffizienzen und verpasste Chancen.

- Fehler potenzieren sich in der automatisierten Verarbeitung.

Compliance

- Falsche Angaben in Verträgen, Rechnungen oder Formularen führen schnell zu Compliance-Problemen, Bußgeldern oder Regressforderungen.

Kundenvertrauen

- Falschangelegte Rechnungen, fehlgeleitete Sendungen oder fehlerhafte Ansprüche untergraben das Vertrauen und schädigen das Markenimage.

Diese Risiken nehmen mit zunehmender Automatisierung zu. Fehlerhafte Daten bleiben nicht lokal, sondern durchdringen das gesamte System. Die Folge: Statt Effizienzgewinne zu sichern, erhöht sich das Fehler- und Kostenrisiko erheblich – typisch nach dem Prinzip "Garbage in, Garbage out".

Das VACUUM-Modell: Rahmen für Datenqualität

Das VACUUM-Modell gilt als bewährtes Framework zur Bewertung von Datenqualität. Es definiert sechs zentrale Dimensionen, mit denen Sie prüfen, ob Informationen vertrauenswürdig und einsatzfähig sind. Für die Datenqualität in der Automatisierung ist das VACUUM-Modell wie eine Checkliste, um sicherzustellen, dass extrahierte Daten für den angestrebten Zweck taugen.

Bedeutung der einzelnen Aspekte:

- Valid – Daten erfüllen Format- und Plausibilitätsanforderungen. Das Rechnungsdatum ist z. B. ein korrektes Datum, kein Textfeld.

- Accurate (Genau) – Erfasste Werte bilden die Realität ab, etwa stimmen Patienten-IDs exakt mit Systemdaten überein.

- Consistent (Konsistent) – Gleichförmige Darstellung über alle Systeme, etwa Schreibweise des Lieferantennamens in Rechnungen und Verträgen identisch.

- Uniform (Einheitlich) – Keine doppelten Einträge, dieselbe Lieferung taucht nicht wiederholt im System auf.

- Unified (Vereinheitlicht) – Maßeinheiten, Währungen und Formate sind standardisiert, z. B. konsequente Nutzung von EUR oder USD.

- Model (Bedeutsam) – Nur relevante Daten werden verarbeitet; beispielsweise ist die Seitenzahl eines Vertrags für die Verwaltung oft unwesentlich.

Diesen Ansatz auf die automatisierte Datenextraktion – z. B. aus Rechnungen, medizinischen Formularen oder Versandpapieren – angewendet, stellt sicher, dass die erzeugten Daten nicht nur digitalisiert, sondern auch wertvoll und nutzbar sind.

Herausforderungen bei der Datenqualität in Automatisierungs-Workflows

Trotz modernster Automatisierungslösungen bleibt die Sicherstellung von Datenqualität eine anspruchsvolle Aufgabe. Laut einer globalen Precisely-Umfrage 2025 nennen 64 % der Unternehmen Datenqualität als Haupthindernis und 67 % vertrauen den eigenen Daten nicht vollständig bei geschäftlichen Entscheidungen. Das zeigt: Ohne vertrauenswürdige Daten bleibt Automatisierung ineffektiv, und KI-Lösungen riskieren Fehlentscheidungen.

Die Folgen sind real. Einem Monte Carlo Bericht zufolge verlor ein Frachttechnologie-Marktplatz Millionen, als korrupten Automatisierungsdaten in Machine-Learning-Modelle eingespeist wurden. Das führte zu fehlerhaften Gebotsprognosen, 400 dokumentierten Datenvorfällen, 2.400 Stunden Datenausfall und einem Effizienzverlust von 2,7 Mio. Dollar – die Firma wurde später eingestellt.

Typische Herausforderungen in automatisierten Workflows

- Unstrukturierte Daten → Rechnungen, Verträge und Belege erscheinen in unterschiedlichsten Formaten, Layouts und Sprachen. Präzise Felderkennung wird ohne Parsing schwierig.

- Menschliche Fehler → Tippfehler, fehlende Angaben oder inkonsistente Bezeichnungen beeinflussen die Genauigkeit.

- Skalierungsprobleme → Was bei kleinen Volumina funktioniert, führt bei zehntausenden Dokumenten durch kleine Inkonsistenzen zu erheblichen Ausfällen.

- Fehlende Validierung → Ohne eingebaute Prüfungen gehen fehlerhafte IDs oder Summen unbemerkt ins System.

Garbage In, Garbage Out (GIGO)

Das Grundprinzip bleibt: Garbage In, Garbage Out (GIGO). Fehlerhafte Eingangsdaten führen zwangsweise zu fehlerhaften Resultaten. Automatisierung behebt diese Schwächen nicht – sie vervielfacht deren Wirkung.

Konkret in der Dokumentenverarbeitung:

- Chaotische oder unstrukturierte Formate – Gescannte PDFs, handschriftliche Formulare oder Sonderlayouts erschweren eine fehlerfreie Extraktion.

- Fehler an der Datenquelle – Ein Zahlendreher in der Kunden-ID kann Zahlungsvorgänge oder Lieferungen durcheinanderbringen.

- Inkonsistenzen bei Datenformaten – Unterschiedliche Darstellungen von Daten, Währungen oder Maßeinheiten sorgen für Verarbeitungsprobleme.

- Skalierungseffekte – Ein Fehler im kleinen Maßstab lässt sich manuell beheben, wird durch Automatisierung aber zum massiven Problem.

Praktische Beispiele:

- Rechnungsverarbeitung → Eine OCR-Engine interpretiert „$1,249.99“ als „$12,499.9“. Ohne nachträgliche Validierung landet dieser Wert ungeprüft im ERP-System.

- Medizinische Formulare → Eine fehlerhaft erkannte Patienten-ID schafft Verwechslungen und gefährdet die Compliance.

- Versanddokumente → Ein unleserlicher Barcode wandert als falsche Adresse weiter und verursacht Lieferprobleme.

Ergebnis: Nur durch konsequente Qualitätskontrollen, Validierungsregeln, Datenbereinigung und Einbindung von manuellen Prüfungen verhindern Sie, dass Automatisierung Fehler nicht nur übernimmt, sondern vervielfältigt. Unternehmen, die auf Qualitätssicherung verzichten, riskieren hohe Nacharbeitsaufwände, Umsatzverluste und Bußgelder.

ECCMA-Standards und ISO 8000 für globale Datenqualität

Für erstklassige Datenqualität in der Automatisierung benötigen Unternehmen mehr als interne Frameworks. Globale Standards wie die der **Electronic Commerce Code Management Association (ECCMA)** schaffen Konsistenz, Interoperabilität und Compliance über verschiedene Branchen und Systeme hinweg.

Die ECCMA verwaltet insbesondere ISO 8000, den internationalen Standard für Datenqualität. Dieser Standard definiert bewährte Methoden für die Erstellung, Verwaltung und den Austausch hochwertiger Stammdaten branchenübergreifend. In automatisierten Workflows gewährleisten ECCMA-Standards, dass extrahierte Daten nicht nur maschinell lesbar, sondern auch semantisch korrekt und global interoperabel sind.

Warum sind ECCMA-Datenqualitätsstandards für die Automatisierung und Dokumentenverarbeitung relevant?

- Systemübergreifende Konsistenz → ECCMA ermöglicht einen reibungslosen Datenaustausch zwischen ERP, CRM, Buchhaltung oder anderen Plattformen, ohne Inkonsistenzen.

- Genauigkeit und Zuverlässigkeit → Klare Formatierungs- und Strukturvorgaben minimieren Fehlinterpretationen durch Uneindeutigkeiten.

- Auditierbarkeit und Compliance → Globale Vorgaben erleichtern die Einhaltung regulatorischer Anforderungen, besonders im Finanz-, Gesundheits- und Logistikbereich.

Beispielsweise wird in einem ECCMA-konformen System nicht nur der Rechnungsbetrag extrahiert, sondern auch so strukturiert und verschlagwortet, dass Buchhaltungssysteme ihn direkt übernehmen können.

Parseur richtet sich nach diesen Best Practices, indem es KI-gestützte Extraktion sowie Standardisierung und Validierung kombiniert und so durchgängig hochwertige Datenflüsse in automatisierten Workflows sichert.

VACUUM vs. ECCMA: Zwei Seiten der Datenqualität

| Faktor | VACUUM-Modell | ECCMA-Standards |

|---|---|---|

| Fokus | Konzeptioneller Rahmen zur Bewertung von Datenqualität. | Internationale Standards für die Erstellung, Verwaltung und den Austausch hochwertiger Daten (ISO 8000). |

| Anwendungsbereich | Prüft, ob extrahierte Daten einsatztauglich sind. | Liefert weltweit gültige Regeln für Interoperabilität und Compliance. |

| Stärke | Flexibel, branchen- und workflowübergreifend einfach anwendbar. | Garantiert Standardisierung über Systeme und Ländergrenzen hinweg. |

| Einsatz in der Automatisierung | Misst, ob extrahierte Daten (z. B. aus Rechnungen, Formularen, Verträgen) Qualitätsstandards erfüllen. | Sorgt dafür, dass extrahierte Daten in einem weltweit konsistenten Format strukturiert sind. |

KI in der Datenqualitätsautomatisierung: Intelligentere Validierung und Fehlererkennung

Künstliche Intelligenz verändert, wie Unternehmen Datenqualität in der Automatisierung absichern. Herkömmliche Prüfungen und regelbasierte Ansätze stoßen bei wachsendem Datenvolumen schnell an ihre Grenzen. KI bringt Flexibilität, Anpassungsfähigkeit und ermöglicht kontinuierliche Optimierungen.

So verbessert KI die Datenqualität:

- Kontextuelle Validierungen → KI erkennt nicht nur grobe Fehler, sondern auch subtile Auffälligkeiten wie unpassende Rechnungsdaten oder fehlerhafte Währungscodes.

- Entitätenerkennung → Maschinelles Lernen identifiziert relevante Datenpunkte wie Beträge, IDs oder Adressen in unstrukturierten Dokumenten.

- Automatische Fehlerdiagnose und Korrekturvorschläge → KI-Algorithmen spüren Anomalien wie abweichende Steuerbeträge und bieten Korrekturen an.

- Lernen durch Feedback → KI-basierte Systeme werden durch kontinuierliche Rückmeldungen und Interaktion immer präziser.

- Mehrsprachigkeit und Formatvielfalt → KI verarbeitet globale Dokumente zuverlässig und gewährleistet Widerstandsfähigkeit über verschiedene Formate und Sprachen hinweg.

Kurzum: KI sorgt nicht nur für Datenextraktion, sondern steigert aktiv die Genauigkeit, Konsistenz und Zuverlässigkeit von Daten. Unternehmen können Automatisierung damit ausbauen, ohne die Datenqualität zu gefährden.

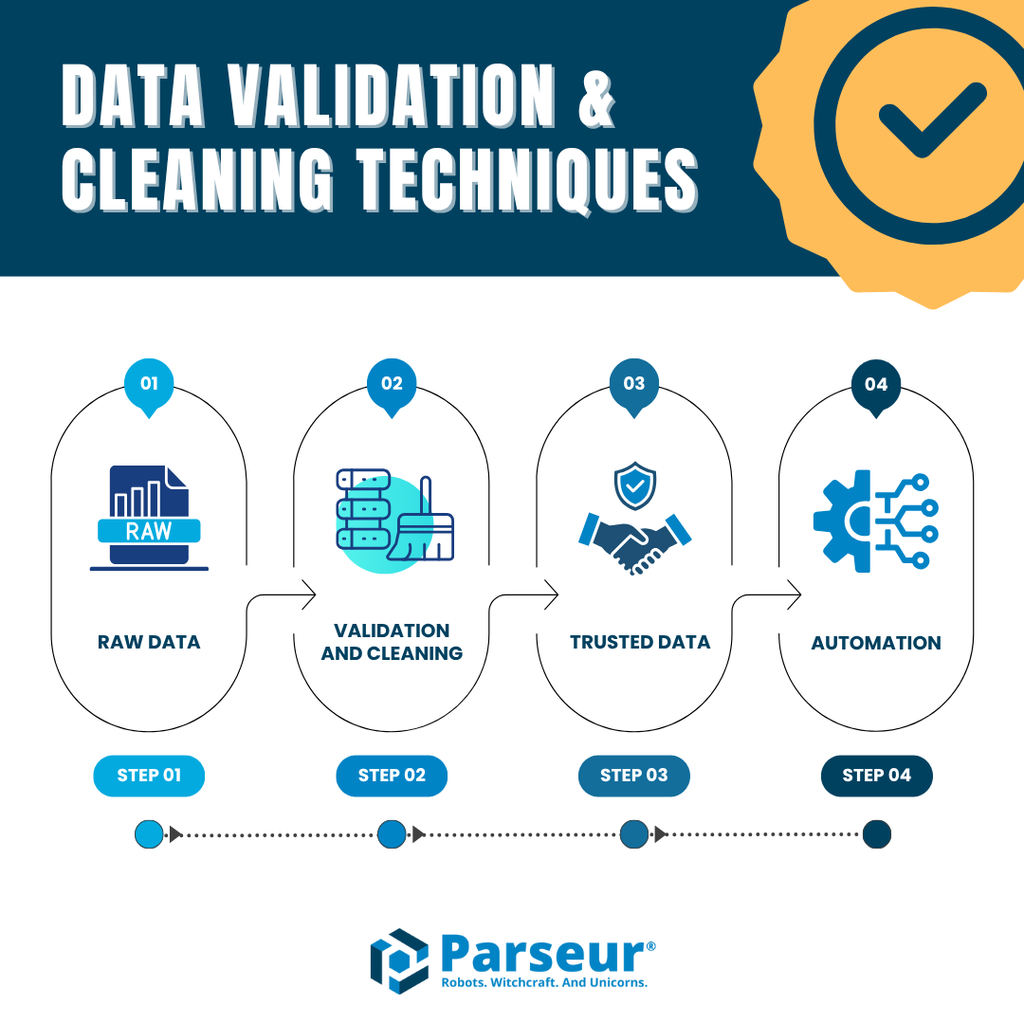

Techniken zur Datenvalidierung und -bereinigung

Für bestmögliche Datenqualität in der Automatisierung reicht reine Extraktion nicht aus – eine systematische Validierung und Bereinigung ist erforderlich. Andernfalls gelangen trotz bester OCR- und KI-Engines Fehler in Ihre Prozesse.

Zu den wichtigsten Methoden gehören:

- Automatische Feldvalidierung → Prüfung, ob extrahierte Werte Format- und Strukturvorgaben erfüllen (z. B. numerische Beträge, Datumsformate, strukturierte IDs).

- Erkennung und Entfernung von Duplikaten → Unterbindung mehrfach angelegter oder bearbeiteter Daten.

- Normalisierung → Vereinheitlichung von Datumsangaben, Währungen, Telefonnummern oder Adressen über verschiedene Systeme hinweg, z. B. Konvertierung von „12/09/25“ und „2025-09-12“ auf identische Formate.

- Fehlererkennung und Ausnahmebehandlung → Automatisches Markieren von Anomalien wie inkonsistenten Summen oder fehlenden Feldern vor Weiterverarbeitung.

- Human-in-the-Loop (HITL) → Menschliche Kontrolle für zweifelhafte oder komplexe Dokumente, ohne den Gesamtprozess zu verlangsamen.

Mit Tools wie Parseur realisieren Unternehmen diese Maßnahmen zuverlässig. Dank vorlagenfreier KI-Extraktion, integrierter Validierung und direkter Anbindung an ERPs, CRMs oder Finanzsysteme bleiben automatisierte Workflows sauber, präzise und effizient.

Weitere Details finden Sie in unseren Leitfäden zu Datenvalidierung und Datenbereinigungstechniken, die zeigen, wie diese Methoden Automatisierungsprozesse hochwertig halten.

Wie Parseur Datenqualität sicherstellt

Parseur realisiert Datenqualität in der Automatisierung mit einem nutzerorientierten Ansatz: Statt sich nur auf OCR oder starre Layouts zu stützen, verbindet Parseur KI-basierte Datenextraktion, automatische Validierung und flexible Schnittstellenintegration. Die KI-Ergebnisse entsprechen exakt den geforderten Feldern – auf Wunsch lassen sich diese Resultate durch individuelle Anweisungen weiter verfeinern.

Schlüsselfunktionen für erstklassige Datenqualität:

- Vorlagenfreie Extraktion → Flexibel für beliebige Dokumentenformate (Rechnungen, Quittungen, Verträge, Versandpapiere), ohne hohe Regelpflege.

- Hohe Genauigkeitswerte → Parseur erreicht beim Parsing typischerweise Feldgenauigkeiten von 90–99 % – selbst bei unterschiedlichen Strukturen und unstrukturierten Quellen.

- Validierung und Bereinigung → Automatische Prüfung auf Duplikate, Format- oder Strukturfehler – so gelangen nur qualitätsgesicherte Daten in nachgeordnete Systeme.

- Nahtlose Integrationen → Übergabe gereinigter, strukturierter Daten an Google Sheets, SQL-Datenbanken, ERP-, CRM- oder Buchhaltungslösungen – ohne zusätzliche Softwareebene.

Anwendungsbeispiele:

- In der Finanzbranche ermöglicht Parseur nahezu fehlerfreie Extraktion von Beträgen, Steuer-IDs und Zahlungsdetails – der Aufwand für manuelle Nachbearbeitung sinkt um bis zu 80 %.

- In der Logistik sorgt Parseur für exakte Erfassung von Versand-IDs und Adressen in Frachtpapieren und Empfangsbelegen – direkt für Trackingsysteme nutzbar.

Dank Best Practices nach VACUUM und ECCMA-Standards stellt Parseur sicher, dass Unternehmen Dokumentenautomatisierung nicht nur ausbauen, sondern auch zuverlässig, exakt und compliant realisieren.

Fazit

Automatisierung erhöht Geschwindigkeit, Skalierbarkeit und Effizienz – allerdings nur bei sauberen, konsistenten und verlässlichen Daten. Schlecht gepflegte Datenqualität gefährdet nicht nur die Produktivität, sondern auch das Kundenvertrauen und führt zu steigenden Kosten. Frameworks wie das VACUUM-Modell, internationale ECCMA-Standards, KI-basierte Validierung sowie Human-in-the-Loop-Prüfungen helfen, Automatisierung zum beständigen Wettbewerbsvorteil zu machen.

Am Ende ist Automatisierung immer nur so gut wie ihre Datengrundlage. Investitionen in Datenqualität stellen sicher, dass jede automatisierte Entscheidung korrekt, regelkonform und vertrauenswürdig bleibt.

Mit Parseur erhalten Sie Automatisierung, die genau, zuverlässig und nach globalen Standards arbeitet. Ob Rechnungen, Patientenformulare oder Versanddokumente – Parseur sorgt dafür, dass Ihre Automatisierung auf höchster Datenqualität basiert.

Häufig gestellte Fragen

Die Sicherstellung der Datenqualität in der Automatisierung ist eine komplexe, aber wesentliche Aufgabe. Unternehmen fragen oft, wie Rahmenwerke, Standards und Tools zusammenwirken, um die Genauigkeit und Zuverlässigkeit von Automatisierungen zu gewährleisten. Nachfolgend finden Sie Antworten auf einige der am häufigsten gestellten Fragen:

-

Was ist Datenqualität in der Automatisierung?

-

Datenqualität in der Automatisierung bezieht sich auf die Genauigkeit, Konsistenz und Zuverlässigkeit von Daten, die durch automatisierte Systeme fließen. Hochwertige Daten sorgen für reibungslose Workflows, während schlechte Daten zu Fehlern, Ineffizienzen und Compliance-Risiken führen.

-

Warum ist Datenqualität für die Automatisierung wichtig?

-

Automatisierung basiert auf Eingabedaten, um Entscheidungen zu treffen. Sind diese fehlerhaft, verstärkt die Automatisierung die Fehler in großem Maßstab. Starke Datenqualität reduziert Kosten, erhöht die Effizienz und schafft Vertrauen in automatisierte Abläufe.

-

Was ist das VACUUM-Modell in Bezug auf Datenqualität?

-

Das VACUUM-Modell definiert sechs wichtige Dimensionen der Datenqualität: Validität, Genauigkeit, Konsistenz, Einzigartigkeit, Einheitlichkeit und Bedeutsamkeit. Es bietet einen Rahmen zur Bewertung, ob extrahierte Daten vertrauenswürdig und für die Automatisierung nutzbar sind.

-

Was sind ECCMA-Datenqualitätsstandards?

-

Die ECCMA entwickelt globale Datenqualitätsstandards, darunter ISO 8000. Diese Standards gewährleisten Datenkonsistenz, Interoperabilität und Branchen-Compliance und machen Automatisierungsergebnisse verlässlicher und auditierbar.

-

Wie können Unternehmen die Datenqualität in der Automatisierung verbessern?

-

Unternehmen können Datenqualität durch Validierung, Bereinigung, Normalisierung, Duplikaterkennung und menschliche Kontrolle verbessern. KI-gestützte Tools wie Parseur vereinfachen diese Schritte und sorgen dafür, dass die Automatisierung auf genauen und umsetzbaren Daten basiert.

-

Wie stellt Parseur Datenqualität sicher?

-

Parseur nutzt KI-gestützte, vorlagenfreie Extraktion mit integrierter Validierung, Bereinigung und Integrationen. Es orientiert sich an Best Practices wie VACUUM und ECCMA, um präzise, verlässliche und skalierbare Automatisierung in verschiedenen Branchen zu liefern.

Zuletzt aktualisiert am