Qu'est-ce que la qualité des données ?

La qualité des données se réfère au degré de précision, de complétude, de cohérence et de fiabilité de l’information pour l’usage auquel elle est destinée. Dans le contexte de l'automatisation, elle devient essentielle car les machines exécutent sans remise en question les instructions basées sur les données reçues.

À retenir

- Des outils comme Parseur permettent de faire évoluer l’automatisation avec des données propres, fiables et exploitables.

- Des cadres comme VACUUM et ECCMA (Electronic Commerce Code Management Association) offrent une structure pour garantir la fiabilité des données.

- L’IA, la validation et les techniques de nettoyage renforcent la précision et la confiance dans l’automatisation.

Une mauvaise qualité des données n’est pas qu’un simple obstacle : elle coûte cher. Des études montrent que des données inexactes ou incomplètes entraînent des pertes de plusieurs millions chaque année, en ressources gaspillées, risques de non-conformité et mauvaises décisions. À l’ère de l’automatisation, l’impact est encore amplifié. Le principe “garbage in, garbage out” (GIGO) demeure central : si l’automatisation s’appuie sur des données erronées, les résultats s’en trouvent compromise.

Selon Resolve, le traitement manuel des données engendre un taux d’erreur de 3 à 5 %, alors que l’automatisation le réduit à 0,5 à 1,5 %, générant ainsi une réduction de 60 à 80 % des erreurs coûteuses dans les six premiers mois. Cette amélioration illustre la corrélation directe entre automatisation et efficacité. Elle rappelle que conserver des données de qualité reste impératif : une petite erreur, répétée à grande échelle, peut provoquer de lourdes pertes. En effet, la mauvaise qualité des données représente 20 à 30 % des pertes de chiffre d’affaires annuelles, coûtant à l’économie américaine 3,1 trillions de dollars par an, selon Techment.

C’est pourquoi la qualité des données dans l’automatisation est devenue une priorité pour les organisations adoptant l’IA documentaire ou des workflows intelligents. Il ne s’agit pas uniquement de précision, mais aussi de cohérence, de fiabilité et de confiance. Sans base solide, l’automatisation n’atteint pas son plein potentiel.

Dans cet article, nous allons clarifier les fondamentaux de la qualité des données dans l’automatisation. Nous explorerons les cadres VACUUM et ECCMA, passerons en revue les défis les plus fréquents – comme le GIGO – et présenterons des solutions concrètes, notamment le parsing IA, l’automatisation de la validation des données et les garde-fous humains (HITL). À l’issue, vous découvrirez comment garantir à vos processus automatisés des données propres, précises et adaptées aux enjeux métiers.

Qu'est-ce que la qualité des données ?

Une bonne qualité des données implique :

- Précision – Les valeurs sont correctes (par ex., le total d'une facture correspond réellement au montant facturé).

- Complétude – Tous les champs essentiels sont saisis (par ex., une date de début et de fin dans un contrat).

- Cohérence – L’information est homogène d’un système à l’autre (par ex., les identifiants clients sont identiques dans le CRM et l’ERP).

- Fiabilité – Les données sont à jour et issues de sources vérifiables.

Lorsque des données de qualité alimentent vos systèmes d’automatisation, les workflows sont performants et les erreurs réduites. À l’inverse, une qualité insuffisante entraîne doublons, pertes de conformité, analyses faussées – des problèmes démultipliés à grande échelle lors d’automatisation.

En résumé, la qualité des données dans l'automatisation assure que chaque action automatisée repose sur des bases solides. Sans elle, même le machine learning le plus évolué produira de mauvais résultats.

Pourquoi la qualité des données est-elle cruciale dans l’automatisation du traitement documentaire ?

La qualité des données n’est pas un détail technique : c’est un enjeu stratégique pour l’entreprise. Lorsque vos workflows automatisés tournent sur des données insuffisantes, l’impact se fait ressentir à tous les niveaux de l’organisation.

Efficacité

- Des données inexactes ralentissent les circuits automatisés et perturbent les processus.

- Les corrections manuelles deviennent coûteuses et prennent du temps.

Coût

- Selon MIT Sloan, la mauvaise qualité des données coûte en moyenne 15 à 25 % du chiffre d’affaires, en ressources gaspillées et opportunités manquées.

- Les erreurs se propagent rapidement dans tout processus automatisé.

Conformité

- Les erreurs dans les documents comme contrats ou factures peuvent déboucher sur des violations réglementaires, sanctions financières, voire des risques juridiques.

Confiance client

- Une facture erronée ou une livraison mal traitée nuisent à la réputation et à la fidélité.

Tous ces risques sont amplifiés par l’automatisation. Les données erronées circulent vite et touchent de multiples systèmes simultanément, risquant de transformer l’automatisation en facteur d’exposition – garbage in, garbage out.

Le modèle VACUUM : un cadre pour la qualité des données

Le modèle VACUUM est un cadre de référence pour évaluer et garantir la qualité des données. Il définit six dimensions clés utiles pour juger la fiabilité d’une information, particulièrement en automatisation.

Ses critères :

- Valide – Les données respectent le bon format ou des règles précises (ex. une date conforme à un format international).

- Précise (Accurate) – Les valeurs reflètent la réalité. L'identifiant d’un client est exact et vérifiable.

- Cohérente (Consistent) – Les données sont identiques entre les systèmes : aucun décalage de noms ou d’identifiants.

- Uniforme – Les doublons sont éliminés pour éviter toute répétition dans les traitements automatisés.

- Unifiée (Unified) – Les unités, les devises et les formats sont standardisés sur toute la chaîne (ex. EUR vs USD).

- Signifiante / utile (Meaningful/Model) – L’information extraite doit avoir du sens pour la tâche à accomplir.

Dans l’extraction automatisée de données, le modèle VACUUM aide à garantir que les données produites sont non seulement numérisées, mais surtout fiables, utilisables et prêtes à l’intégration.

Défis de la qualité des données dans les workflows automatisés

Même avec des outils avancés, assurer une donnée de haute qualité reste complexe. Un sondage mondial 2025 de Precisely indique que 64 % des entreprises mentionnent la qualité des données comme principal défi et 67 % déclarent manquer de confiance totale dans leurs données lors de la prise de décision. L’automatisation ne produit donc ses bénéfices que lorsque l’intégrité des données est maîtrisée.

Les risques sont tangibles. Le rapport Monte Carlo cite l’exemple d’une marketplace logistique qui a perdu des millions faute d’avoir résolu l’automatisation de données défaillantes – ce qui a corrompu leurs modèles, généré des prédictions erronées et causé des pannes importantes, jusqu’à la fermeture de l’entreprise.

Défis courants dans les workflows automatisés

- Données non structurées – Factures, contrats, formulaires arrivent sous des formats variés et non standardisés, ce qui complique leur extraction fiable.

- Erreur humaine – Saisie erronée ou omissions lors de la création initiale du document peuvent se propager à tous les niveaux.

- Scalabilité des contrôles – Un processus efficace sur 100 documents peut s’effondrer sur 100 000, car les incohérences prennent de l’ampleur.

- Manque de validation – Sans règles intégrées, des identifiants ou montants incorrects s’introduisent dans l’automatisation.

Garbage In, Garbage Out (GIGO)

Tous ces éléments illustrent le principe Garbage In, Garbage Out (GIGO). Si les données d’origine sont erronées, l’automatisation ne fait qu’accroître les problèmes.

Concrètement, cela se traduit par :

- Formats dégradés ou non standard – Scans, documents manuscrits, factures peu lisibles rendent l’extraction peu fiable.

- Erreur humaine à la source – Une simple faute sur un numéro d’ID peut provoquer rejet de paiement ou erreur de livraison.

- Manque de standardisation – Dates ou montants exprimés différemment génèrent des erreurs lors du passage à l’automation.

- Effet d’échelle – Une erreur tolérable à petite échelle devient critique à grande échelle.

Cas pratiques :

- Traitement de factures – Un OCR interprète “1 249,99 $” comme “12 499,9” : sans contrôle, la comptabilité devient inexacte.

- Formulaires médicaux – Un identifiant illisible suite à un scan flou peut créer un mauvais appariement de patient.

- Documents d’expédition – Un code-barres erroné entraîne des livraisons incorrectes et des surcoûts.

La conclusion est sans appel : sans contrôles, règles de validation, nettoyage et éventuelle revue humaine (HITL), automatiser revient à diffuser et amplifier les erreurs, au détriment de la performance et de la conformité.

Normes ECCMA et ISO 8000 pour la qualité mondiale des données

Pour garantir la qualité des données dans l’automatisation à l’échelle internationale, les cadres internes ne suffisent pas. De nombreuses organisations adoptent l’**Electronic Commerce Code Management Association (ECCMA),** qui élabore des normes mondiales comme ISO 8000 pour assurer l'intégrité, la cohérence et la traçabilité des données entre tous les systèmes.

La norme ISO 8000 formalise les meilleures pratiques pour créer, gérer et échanger des données de référence de qualité à travers tous les secteurs. Dans les workflows automatisés, les standards ECCMA garantissent que les données ne soient pas seulement lisibles par les machines, mais aussi correctes et compatibles à l’international.

Pourquoi ces normes ECCMA sont-elles fondamentales ?

- Interopérabilité – Elles assurent que les données extraites circulent sans erreurs ni pertes de sens entre ERP, CRM, outils comptables et autres systèmes.

- Précision & contrôle – Avec des formats et règles normalisées, le risque d’erreurs d’interprétation diminue considérablement.

- Auditabilité – Les données deviennent facilement traçables et conformes, ce qui est clé en finance ou logistique.

Exemple : Une facture traitée selon ECCMA n’extrait pas seulement le montant, elle fournit des métadonnées standardisées pour la gestion comptable en aval.

Parseur applique ces bonnes pratiques en associant extraction intelligente, validation et standardisation, pour que vos processus automatisés répondent aux exigences internationales.

VACUUM vs ECCMA : deux visions de la qualité des données

| Facteur | Modèle VACUUM | Normes ECCMA |

|---|---|---|

| Focus | Cadre conceptuel pour évaluer la qualité des données. | Normes internationales pour la création, gestion et échange de données de haute qualité (ISO 8000). |

| Portée | Évalue la pertinence/utilisabilité des données extraites. | Règles mondialement reconnues pour l’interopérabilité et la conformité. |

| Point fort | Souple, applicable à tous secteurs et workflows. | Assure standardisation entre systèmes et à l’international. |

| Application en automatisation | Sert à évaluer la qualité des données extraites (factures, contrats, formulaires). | Formate les données extraites pour qu’elles soient lues/interprétées par tous systèmes avals de façon uniforme. |

IA et automatisation de la qualité des données : validation intelligente et détection d’erreurs

L’intelligence artificielle transforme le contrôle de la qualité des données dans l’automatisation. Les approches traditionnelles – vérification manuelle, règles fixes – sont vite dépassées avec la montée en volume et en diversité des données. L’IA apporte adaptabilité, contexte et auto-amélioration.

Comment l’IA améliore la qualité des données :

- Validation contextuelle – Les modèles IA comprennent le sens des données et identifient des incohérences subtiles (ex. dates improbables ou monnaie non reconnue).

- Reconnaissance d’entités – Le machine learning identifie les champs essentiels même dans des documents non structurés ou atypiques.

- Détection d’anomalies – L’IA repère automatiquement les erreurs ou valeurs inattendues, et propose des corrections.

- Amélioration continue – Grâce à l’apprentissage, la précision s’accroît avec le temps et la volumétrie.

- Gestion multilingue – Les systèmes IA traitent des documents dans plusieurs langues et formats, assurant une uniformité internationale.

Ainsi, l’IA ne se limite pas à extraire la donnée : elle optimise la précision, la fiabilité et la cohérence nécessaires à une automatisation performante.

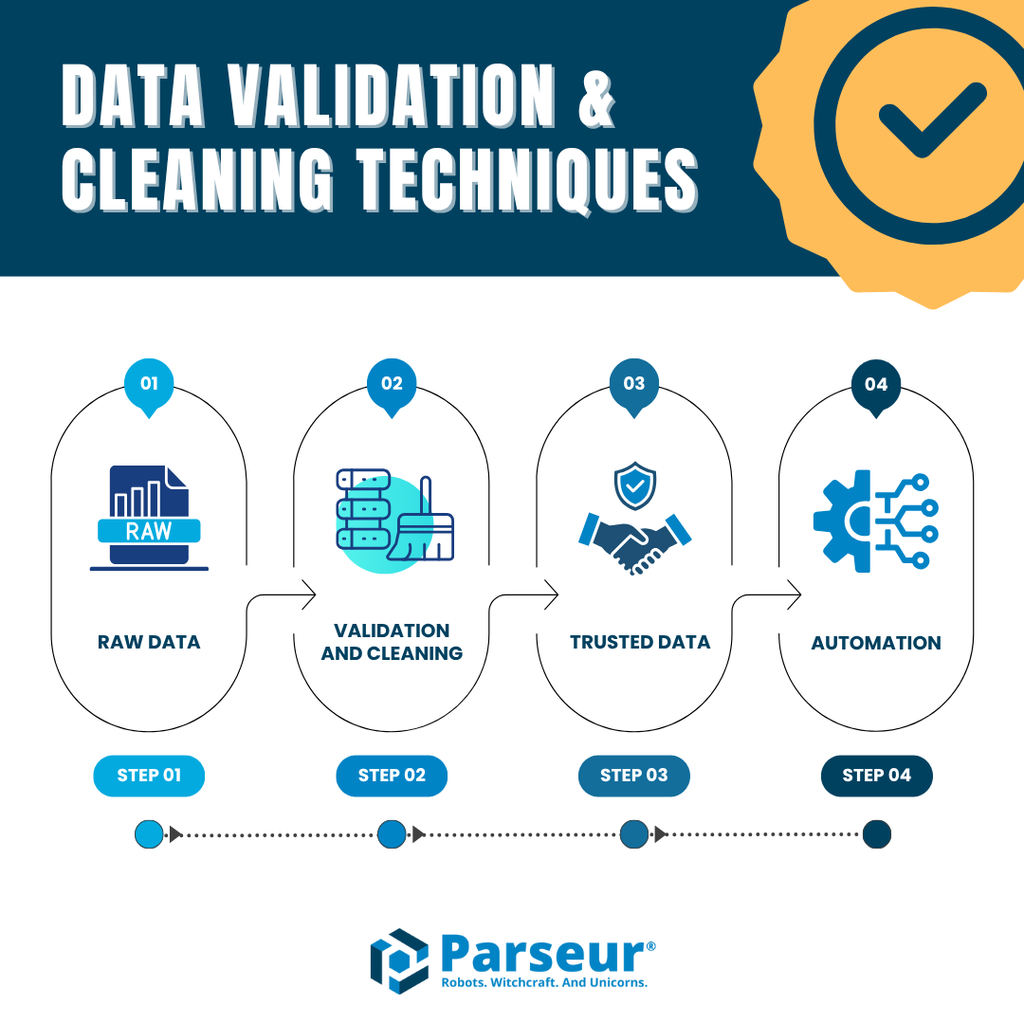

Validation et nettoyage des données

Assurer la qualité des données dans l’automatisation ne s’arrête pas à l’extraction : il faut aussi valider et nettoyer les données. Sans ces filtres, des erreurs risquent de contaminer vos process en aval, même avec la meilleure IA ou OCR.

Principales techniques :

- Contrôles automatiques de champs – Vérifier que chaque champ extrait répond au format requis (ex. totaux numériques, date valide, identifiant structuré).

- Détection des doublons – Éliminer les répétitions pour éviter la confusion et le traitement multiple des mêmes données.

- Normalisation – Uniformiser le format des dates, devises, numéros ou adresses afin de garantir la cohérence d’un système à l’autre.

- Signalement d’erreurs et exceptions – Remonter immédiatement toute anomalie pour correction avant transmission.

- Human-in-the-loop (HITL) – Sur les cas ambigus, une vérification humaine rapide garantit la fiabilité sans ralentir l’automatisation globale.

Avec Parseur, toutes ces étapes sont automatisées : extraction IA sans modèle, validations intégrées, exports directs vers vos outils (ERP, CRM, etc.). Vous bénéficiez ainsi de pipelines robustes, prêts pour l’automatisation à grande échelle.

Pour aller plus loin, lisez nos guides sur la validation des données et les techniques de nettoyage de données pour renforcer encore vos workflows.

Comment Parseur garantit la qualité des données

Pour assurer la qualité des données dans l’automatisation, Parseur privilégie une approche métier et pratico-pratique. Plutôt que reposer uniquement sur l’OCR ou des modèles statiques, Parseur combine extraction IA performante, validation automatique et intégration transparente dans vos outils. Il sécurise la fiabilité en garantissant que les sorties IA respectent strictement les champs souhaités. Les utilisateurs peuvent affiner les règles selon leurs propres exigences.

Fonctionnalités majeures pour la qualité des données :

- Extraction sans modèle – Adaptée à tous formats et types de documents, sans nécessité de créer de nouvelles règles à chaque évolution.

- Précision élevée – Parseur atteint en pratique 90 à 99 % de précision par champ, même sur des sources hétérogènes et non structurées.

- Validation et nettoyage – Repérage automatique des duplications, erreurs de format, champs anormaux pour produire des données saines.

- Intégrations transparentes – Export des données structurées directement vers Google Sheets, bases SQL, ERP, CRM, etc.

Applications concrètes :

- En finance, Parseur extrait montants, ID fiscaux ou conditions de paiement avec une fiabilité qui réduit de 80 % les tâches de saisie.

- En logistique, vos bordereaux et confirmations de livraison sont automatiquement parsés et transférés vers les systèmes de suivi, assurant traçabilité et conformité.

En adoptant les cadres VACUUM et les normes ECCMA, Parseur garantit une automatisation de traitement documentaire irréprochable en termes de précision, fiabilité et conformité.

Conclusion

L’automatisation promet efficacité, rapidité et souplesse – à la condition de disposer de données propres, cohérentes et fiables. Comme nous l’avons vu, une qualité insuffisante fragilise vos processus et augmente les coûts, alors que de bonnes pratiques – cadre VACUUM, standards ECCMA, validation IA et revue humaine – sécurisent la transformation digitale.

Au final, la valeur de l’automatisation dépend directement de la qualité des données. Investir dans des processus robustes, c’est assurer la fiabilité de chaque décision automatisée.

Avec Parseur, automatisation rime avec précision, conformité et efficacité. Que vous traitiez des factures, formulaires médicaux ou documents logistiques, Parseur assure à vos workflows une extraction et un contrôle des données au meilleur niveau.

Foire aux questions

Garantir la qualité des données dans l'automatisation est une tâche complexe mais essentielle. Les entreprises se demandent souvent comment les cadres, les normes et les outils s’associent pour maintenir la fiabilité et l’exactitude de leurs automatisations. Voici les réponses aux questions les plus courantes :

-

Qu'est-ce que la qualité des données dans l'automatisation ?

-

La qualité des données dans l'automatisation fait référence à la précision, la cohérence et la fiabilité des données circulant dans les systèmes automatisés. Des données de haute qualité garantissent le bon déroulement des workflows, tandis que des données médiocres entraînent erreurs, inefficacités et risques de non-conformité.

-

Pourquoi la qualité des données est-elle importante pour l'automatisation ?

-

L'automatisation s'appuie sur les données d'entrée pour prendre des décisions. Si les données sont erronées, l'automatisation multipliera les erreurs à grande échelle. Une bonne qualité des données réduit les coûts, augmente l'efficacité et instaure la confiance dans les processus automatisés.

-

Qu'est-ce que le modèle VACUUM en matière de qualité des données ?

-

Le modèle VACUUM définit six dimensions clés de la qualité des données : Validité, Précision (Accuracy), Cohérence (Consistency), Unicité, Uniformité et Signification. Il fournit un cadre pour évaluer si les données extraites sont fiables et utilisables dans l'automatisation.

-

Quelles sont les normes de qualité des données ECCMA ?

-

L'ECCMA développe des normes mondiales de qualité des données, incluant l'ISO 8000. Ces normes assurent la cohérence, l’interopérabilité et la conformité industrielle des données, rendant les résultats de l'automatisation plus fiables et prêts pour l’audit.

-

Comment les entreprises peuvent-elles améliorer la qualité des données dans l'automatisation ?

-

Les entreprises peuvent améliorer la qualité des données grâce à la validation, au nettoyage, à la normalisation, à la détection des doublons et à la revue humaine. Des outils basés sur l'IA comme Parseur simplifient ces étapes et garantissent une automatisation basée sur des données fiables et exploitables.

-

Comment Parseur garantit-il la qualité des données ?

-

Parseur utilise une extraction pilotée par l’IA sans modèle, dotée de validation, de nettoyage et d’intégrations intégrés. Il s’aligne sur les bonnes pratiques comme VACUUM et ECCMA pour offrir une automatisation précise, fiable et évolutive dans tous les secteurs.

Dernière mise à jour le