Cos’è la Qualità dei Dati?

La qualità dei dati rappresenta l’insieme delle caratteristiche che rendono le informazioni accurate, complete, coerenti, affidabili e adatte allo scopo per cui sono utilizzate. Nell’automazione, la qualità dei dati assume un ruolo ancora più centrale: le macchine si affidano ciecamente ai dati ricevuti e, senza verifiche, eseguono processi e prendono decisioni esclusivamente in base a questi.

Punti Chiave

- Gli strumenti come Parseur permettono di automatizzare i processi su grande scala utilizzando dati puliti, conformi e pronti all’uso.

- Framework come VACUUM ed enti come ECCMA (Electronic Commerce Code Management Association) forniscono basi solide per garantire dati di qualità.

- L’AI, le tecniche di validazione e la pulizia automatizzata rafforzano accuratezza, coerenza e affidabilità nei sistemi automatizzati.

Una scarsa qualità dei dati non è solo un fastidio tecnico, ma può diventare un costo elevato per le aziende. Diversi studi confermano che errori, dati incompleti o imprecisi causano ogni anno perdite nell’ordine di milioni di dollari, dovute a inefficienze operative, rischi di non conformità e scarsa qualità delle decisioni. Nell’era dell’automazione, un errore sui dati può essere moltiplicato per migliaia di processi.

Ad esempio, secondo Resolve, l’elaborazione manuale dei dati genera errori tra il 3% e il 5%, mentre l’automazione riduce questo tasso allo 0,5–1,5% e taglia i costi dovuti a errori fino all’80% in sei mesi. Tuttavia, questi risultati sono raggiungibili solo se si parte da dati affidabili, perché anche il più piccolo errore, replicato su larga scala, può costare caro. La bassa qualità dei dati è responsabile fino al 20–30% di perdita di ricavi annuali, un danno quantificato per l’economia USA in 3,1 trilioni di dollari ogni anno, secondo Techment.

Per questo, la qualità dei dati nell’automazione è un tema centrale per ogni azienda che implementa flussi di lavoro automatici basati su AI o automazione intelligente dei documenti. Dati affidabili significano processi precisi, conformità garantita e maggiore fiducia negli output automatizzati.

In questo articolo vedremo come assicurare una qualità ottimale dei dati nei sistemi automatizzati. Approfondiremo i framework come VACUUM ed ECCMA, illustreremo le sfide più diffuse come il fenomeno del GIGO e presenteremo soluzioni pratiche: estrazione intelligente, validazione automatica e controllo human-in-the-loop (HITL). Alla fine, scoprirai come garantire che l’automazione sia guidata solo da dati puliti, completi e affidabili.

Cos’è la Qualità dei Dati?

I dati di qualità elevata si distinguono per:

- Accuratezza – I valori sono corretti e rappresentano la realtà (es. il totale di una fattura è quello realmente dovuto).

- Completezza – Tutte le informazioni essenziali sono presenti (es. un contratto include data di inizio e di fine).

- Coerenza – Le stesse informazioni sono mantenute uniformi nei diversi sistemi aziendali.

- Affidabilità – Le informazioni sono aggiornate e certificate da fonti attendibili.

Se i sistemi di automazione ricevono dati di qualità, i workflow risultano fluidi e senza intoppi, riducendo errori e accelerando le decisioni. Al contrario, dati di scarsa qualità generano record duplicati, problemi di conformità e decisioni errate, rischi che si amplificano nei flussi automatizzati.

In sintesi, la qualità dei dati nell’automazione garantisce che ogni operazione automatica sia fatta sulla base di informazioni solide. Anche i migliori sistemi di AI falliscono se privi di una base dati affidabile.

Perché la Qualità dei Dati Conta nell’Automazione dell’Elaborazione Documentale

La qualità dei dati è molto più di un requisito tecnico: è una leva di business. Se i flussi automatizzati utilizzano dati di scarsa qualità, l’intera organizzazione ne risente.

Efficienza

- Dati errati rallentano e complicano l’elaborazione automatica.

- Le correzioni manuali post-automazione consumano tempo e risorse.

Costi

- Come rilevato da MIT Sloan, la mancata qualità dei dati costa alle aziende tra il 15% e il 25% dei ricavi annuali, a causa di sprechi, inefficienze e decisioni sbagliate.

- Errori e inefficienze si amplificano in presenza di automazione massiva.

Conformità

- Dati imprecisi su contratti, fatture o moduli possono causare violazioni, multe o cause legali.

Fiducia dei clienti

- Informazioni errate generano errori su fatture, spedizioni o servizi, minando la credibilità dell’azienda.

Questi rischi sono accentuati dall’automazione: input non verificati percorrono i sistemi velocemente, moltiplicando l’impatto di eventuali errori. Garbage in, garbage out.

Il Modello VACUUM: Framework Per la Qualità dei Dati

Il modello VACUUM è uno degli approcci più riconosciuti per misurare la qualità dei dati. Esso definisce sei dimensioni fondamentali per la valutazione dello stato delle informazioni, risultando molto utile nei processi di automazione documentale e data extraction avanzata.

Ecco le sei dimensioni del modello VACUUM:

- Validità – Il rispetto di formati o regole predefinite (es. una data deve seguire lo standard richiesto).

- Accuratezza – I valori rispecchiano la realtà (es. l’ID paziente corrisponde a quello archiviato in piattaforma).

- Coerenza – Le stesse informazioni vengono mantenute uguali fra tutti i sistemi.

- Uniformità – Eliminazione di duplicati (es. una spedizione registrata una sola volta).

- Unificazione – Uniformità nelle unità di misura e valuta fra sistemi differenti.

- Significatività – Rilevanza dei dati rispetto all’obiettivo (estrarre il numero di pagina non apporta valore se irrilevante per il processo).

Nel contesto dell’estrazione dati automatizzata, applicare il modello VACUUM significa garantire output non solo digitalizzati, ma anche realmente azionabili, affidabili e conformi.

Sfide Nella Qualità dei Dati per i Workflow Automatizzati

Anche le soluzioni di automazione documentale più evolute affrontano ostacoli nella garanzia della qualità dei dati. Il sondaggio globale 2025 di Precisely conferma infatti che il 64% delle aziende considera la qualità dei dati il più grande ostacolo all’efficacia dell’automazione, e il 67% dichiara di non fidarsi pienamente dei dati aziendali nelle decisioni strategiche.

Questa preoccupazione non è teorica: il rapporto di Monte Carlo riporta milioni di dollari di perdite causate da dati corrotti che, una volta reimessi nel sistema di machine learning di un tech marketplace, hanno portato a previsioni errate, gravi errori di mercato e in definitiva alla chiusura dell’azienda.

Sfide Comuni nei Workflow Automatizzati

- Dati non strutturati → Documenti di formati e lingue differenti complicano l’estrazione automatica di campi chiave.

- Errore umano → Refusi, campi mancanti o diciture non standard introducono errori nei processi.

- Scalabilità → Piccole incoerenze possono trasformarsi in problemi rilevanti con l’aumentare dei volumi.

- Mancata validazione → Senza controlli, dati errati o incompleti entrano nei sistemi.

Garbage In, Garbage Out (GIGO)

Il principio GIGO (“garbage in, garbage out”) vale più che mai: se l’input è difettoso, anche l’output lo sarà, spesso con impatti moltiplicati dall’automazione.

Esempi tipici di problemi nei flussi automatizzati:

- Formati irregolari – PDF scannerizzati, documenti scritti a mano o layout non standard complicano l’estrazione affidabile.

- Errori originari – ID errati o numeri di fattura sbagliati provocano mancati pagamenti o spedizioni.

- Incoerenza dei dati – Date e valute salvate in più formati creano confusioni e conciliazioni errate.

- Scalabilità dannosa – Un piccolo errore, ripetuto su migliaia di record, amplifica perdite e inefficienze.

Alcuni esempi pratici:

- Fatture → Un OCR legge “$1,249.99” come “$12,499.9” senza validazione, compromettendo i bilanci.

- Moduli sanitari → Un errore nella scansione dell’ID paziente mina la conformità.

- Documenti di spedizione → Un barcode illeggibile trasforma una spedizione in un ritardo costoso.

Senza validazioni robuste, processi di pulizia rilevanti e possibilità di revisione HITL, l’automazione rischia di propagare errori invece che risolverli, portando a costose correzioni e danni reputazionali.

Standard ECCMA e ISO 8000 per la Qualità dei Dati a Livello Globale

Framework e regole interne non bastano. La vera qualità dei dati nell’automazione richiede standard globali per interoperabilità e conformità. L’Electronic Commerce Code Management Association (ECCMA) sviluppa gli standard internazionali, tra cui la ISO 8000, punto di riferimento per la gestione della qualità dei dati a livello cross-settoriale.

Gli standard ECCMA assicurano che i dati estratti siano non solo utilizzabili dalle macchine, ma anche semanticamente corretti e pronti per l’integrazione tra sistemi e Paesi diversi.

Benefici chiave degli standard ECCMA e ISO 8000:

- Coerenza tra sistemi → Facilita lo scambio affidabile di dati tra ERPs, CRMs e piattaforme diverse.

- Accuratezza garantita → Regole chiare evitano errori dovuti ad ambiguità o inconsistenze nei dati.

- Conformità normativa → Supporto a tracciamenti e audit, fondamentale nei settori regolamentati.

Una fattura gestita secondo lo standard ECCMA sarà formattata e classificata in modo tale da poter essere subito letta ed elaborata da qualsiasi sistema contabile conforme, automatizzando anche la riconciliazione.

In Parseur, aderiamo a queste best practice unendo estrazione AI e processi di validazione e standardizzazione, per far sì che ogni workflow di automazione si basi su dati puliti, affidabili e conformi agli standard globali.

VACUUM vs ECCMA: Due Facce della Qualità dei Dati

| Fattore | Modello VACUUM | Standard ECCMA |

|---|---|---|

| Focus | Framework concettuale per valutare la qualità dei dati. | Standard internazionali per creare, gestire e scambiare dati di alta qualità (ISO 8000). |

| Ambito | Valuta se i dati estratti sono idonei all’uso. | Fornisce regole riconosciute a livello globale per interoperabilità e conformità. |

| Forza | Flessibile, facile da applicare tra settori e workflow. | Garantisce standardizzazione tra sistemi e confini internazionali. |

| Applicazione nell’automazione | Usato per misurare se i dati estratti da fatture, moduli o contratti rispettano i benchmark di qualità. | Garantisce che i dati estratti siano strutturati in un formato universalmente interpretabile dai sistemi a valle. |

AI e Automazione della Qualità dei Dati: Validazione Intelligente e Rilevamento degli Errori

L’intelligenza artificiale trasforma il controllo della qualità dei dati nell’automazione rendendolo scalabile, intelligente e continuo. Dove i controlli manuali e i sistemi a regole risultano limitati, l’AI introduce automazione adattiva e miglioramento costante nel tempo.

I vantaggi dell’AI per la qualità dei dati:

- Validazione sofisticata — I modelli AI comprendono il contesto e scovano errori sottili, come date anomale o valute errate.

- Riconoscimento automatico dei campi — Il machine learning individua correttamente i dati chiave anche se distribuiti su layout variabili.

- Rilevamento immediato delle anomalie — L’AI segnala e, in alcuni casi, corregge automaticamente errori o incoerenze numeriche.

- Apprendimento continuo — Ogni nuovo documento lavorato migliora precisione e affidabilità attraverso i feedback loop.

- Gestione multilingua — Algoritmi AI standardizzano i dati da documenti in più lingue, semplificando l’automazione cross-country.

Oggi l’AI non serve solo a “catturare”, ma a garantire e migliorare attivamente la qualità dei dati per sistemi sempre più complessi e automatizzati.

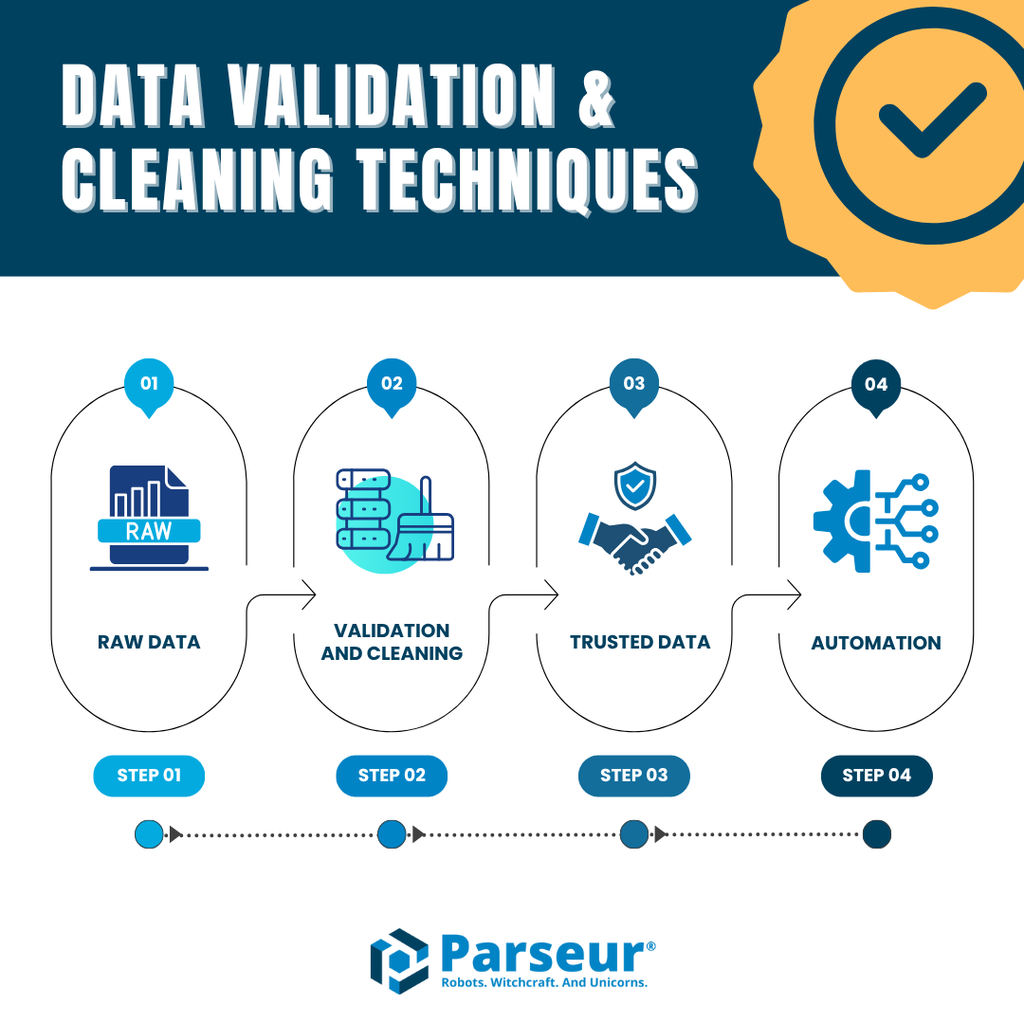

Validazione e Pulizia dei Dati

Per assicurare una qualità dei dati elevata nell’automazione documentale, l’estrazione non basta: occorrono processi strutturati di validazione e pulizia dei dati lungo tutta la pipeline.

Le strategie più efficaci includono:

- Controlli automatici sui campi — Ogni dato estratto viene validato rispetto al suo formato atteso (totali numerici, date standard, ID con pattern riconosciuti).

- Rilevamento di duplicati — Si previene l’introduzione di record doppi, mantenendo coerenza e chiarezza.

- Normalizzazione — Uniformare valori come date e valute tra i diversi sistemi semplifica la gestione dei dati (es. standard unico per formati data).

- Gestione delle eccezioni — Segnalazione e gestione immediata di incongruenze o dati incompleti.

- Revisione HITL — In casi complessi o ambigui, un controllo umano rapido evita che l’automazione si fermi o propaghi errori.

Parseur integra questi processi: dalla validazione interna all’invio diretto dei dati in ERPs, CRMs o fogli di calcolo senza passaggi manuali intermedi.

Per dettagli operativi: scopri di più sulla validazione dei dati e sulle tecniche di pulizia dati.

Come Parseur Garantisce la Qualità dei Dati

Per garantire la qualità dei dati nell’automazione, Parseur combina AI, estrazione flessibile senza template e validazione automatica continua. Ogni output AI è verificato rispetto ai campi richiesti, e gli utenti possono personalizzare le estrazioni e i filtri in base alle esigenze aziendali.

Funzionalità chiave di Parseur per la qualità dei dati:

- Estrazione AI senza template — Adattabile a qualsiasi documento (fatture, ricevute, contratti) senza creazione manuale di regole.

- Benchmark di accuratezza — Parseur raggiunge il 90–99% di precisione sui campi, anche in documenti non strutturati.

- Validazione automatica e pulizia — Duplicati, errori di formato e anomalie vengono individuati e gestiti prima dell’immissione nei database aziendali.

- Integrazioni dirette — Dati pronti e normalizzati subito disponibili in Google Sheets, SQL, ERPs, CRM e piattaforme contabili senza middleware aggiuntivo.

Impatto reale:

- In finanza, Parseur consente di estrarre con elevata precisione fatture, codici fiscali e dettagli pagamento, riducendo del 80% l’inserimento manuale dati.

- In logistica, aziende di ogni dimensione automatizzano la gestione delle polizze di carico e delle prove di consegna, assicurando dati pronti e tracciabili.

Seguendo i principi di VACUUM e gli standard ECCMA, Parseur aiuta le aziende ad automatizzare i workflow documentali mantenendo standard elevati di accuratezza, affidabilità e conformità.

Conclusione

L’automazione permette alle aziende di ottenere efficienza e scalabilità, ma la sua efficacia dipende totalmente dalla qualità dei dati di input. Come dimostrano casi ed esperienze reali, dati inaccurati non solo riducono i benefici dell’automazione, ma creano costi e rischi spesso invisibili all’inizio del processo.

Applicare modelli come VACUUM, adottare standard ECCMA e integrare AI e revisione umana sono strategie imprescindibili per trasformare l’automazione in un reale vantaggio competitivo.

Investendo nella qualità dei dati, ogni decisione automatizzata sarà corretta, conforme, scalabile e affidabile.

Con Parseur porti la qualità dei dati nell’automazione al livello più alto: più accuratezza, più affidabilità e piena conformità agli standard globali. Fatture, moduli sanitari, documenti di spedizione: la tua automazione funziona davvero solo con dati di qualità eccellente.

Domande Frequenti

Garantire la qualità dei dati nell’automazione è un compito complesso ma fondamentale. Le aziende spesso chiedono come framework, standard e strumenti si integrano per mantenere l’automazione accurata e affidabile. Di seguito sono riportate le risposte ad alcune delle domande più comuni:

-

Che cos’è la qualità dei dati nell’automazione?

-

La qualità dei dati nell’automazione si riferisce all’accuratezza, coerenza e affidabilità dei dati che scorrono nei sistemi automatici. Dati di alta qualità assicurano che i flussi di lavoro procedano senza intoppi, mentre dati scadenti portano a errori, inefficienze e rischi di conformità.

-

Perché la qualità dei dati è importante per l’automazione?

-

L’automazione si basa sui dati in ingresso per prendere decisioni. Se i dati sono difettosi, l’automazione amplificherà gli errori su larga scala. Una forte qualità dei dati riduce i costi, aumenta l’efficienza e rafforza la fiducia nei processi automatizzati.

-

Cos’è il modello VACUUM in termini di qualità dei dati?

-

Il modello VACUUM definisce sei dimensioni chiave della qualità dei dati: Validità, Accuratezza, Coerenza, Unicità, Uniformità e Significatività. Fornisce un framework per valutare se i dati estratti sono affidabili e utilizzabili nell’automazione.

-

Cosa sono gli standard di qualità dei dati ECCMA?

-

ECCMA sviluppa standard globali di qualità dei dati, tra cui la ISO 8000. Questi standard garantiscono coerenza, interoperabilità e conformità normativa, rendendo i risultati dell’automazione più affidabili e pronti per gli audit.

-

Come possono le aziende migliorare la qualità dei dati nell’automazione?

-

Le aziende possono migliorare la qualità dei dati tramite validazione, pulizia, normalizzazione, rilevamento dei duplicati e revisione umana. Strumenti basati su AI come Parseur semplificano questi passaggi, assicurando che l’automazione funzioni su dati accurati e azionabili.

-

Come Parseur garantisce la qualità dei dati?

-

Parseur utilizza un’estrazione alimentata da AI, senza modelli predefiniti, con convalida, pulizia e integrazioni incorporate. Si allinea alle best practice come VACUUM e ECCMA per offrire automazione accurata, affidabile e scalabile in diversi settori.

Ultimo aggiornamento il