マスターデータ管理(MDM)におけるデータ品質とは、生データを正確かつ一貫性のあるマスターレコードに変換するための「クレンジング」「マッチング」「エンリッチメント」などの一連のプロセスとルールを指します。

master data management(マスターデータ管理)は、高品質かつ一貫性のあるデータがあってこそ真価を発揮します。レポートや分析、機械学習にデータを活用する際、多くのケースで生データには不整合、重複、欠損が生じています。

主なポイント:

- 高品質なデータは、信頼されるMDM、正確な分析、実効性の高い機械学習を支える基盤となります。

- クレンジング、マッチング、エンリッチメントのワークフローで生データを統制し、整合性と信頼性の高いマスターレコードに変換します。

- Parseurのようなツールは抽出・正規化・統合処理を支援し、MDMのプロセス効率を大幅に向上させます。

信頼できるmaster data managementや機械学習を実現するには、まず高品質なデータが必要です。しかし、多くの生データは誤字脱字、不統一、重複、欠損フィールドなどの課題を抱え、これが分析や意思決定の正確性に影響します。質の低いデータに頼る組織では、財務・業務・顧客体験・分析等あらゆる分野でリスクや非効率が拡大します。

KeyMakrによると、低品質なデータによって世界の企業は毎年一社あたり平均1,290万ドルを失っています。さらに180 OPSの調査では、アメリカ企業ではビジネス価値の約20%(3.1兆ドル相当)が低品質データにより失われていると報告されています。これらの事実は、データ品質改善とmaster data management戦略が必須であることを示しています。クレンジング・マッチング・エンリッチメントに戦略的投資をすることで、財務コスト削減だけでなく、分析の信頼性や機械学習基盤の品質強化にもつながります。

Graphite noteによれば、AIプロジェクトで用いられるデータセットのうち、品質基準を満たすのは10~20%だけであり、プロジェクト時間の約80%はクリーニングや準備作業に費やされています。

本記事では、あなたのデータセットにも活用できる「raw → rule → cleaned」ワークフロー、Parseurの自動化活用例、即実践できるチェックリストを紹介し、MDMや機械学習の品質と効果を最大化する方法を分かりやすく解説します。

MDM・機械学習でデータ品質が重要な理由

高品質なデータは、信頼されるmaster data managementと精度の高い機械学習を実現する土台です。質の低いデータが業務やビジネスの判断・自動化に与える主な影響は以下の通りです:

- モデル精度低下: 不正確または一貫性のないデータは、機械学習モデルに悪影響を及ぼし、精度や予測力の低下を招きます。

- レポート信頼度低下: 重複や誤ったデータは、BIや業績分析の信頼性を損ないます。

- 自動処理の安定性損失: 請求や通知などの業務自動化も、クリーンなデータがなければ正常に処理できません。

- コスト増加: 低品質データに起因するエラー(例:顧客重複による二重送付等)の修正には多大なリソースがかかります。

データ品質への継続的な投資は、MDMやレポート、機械学習施策における信頼性と効率性・リスク低減を保証します。

データ品質向上の中核テクニック

master data managementのデータ品質向上は、三つの主要な技術領域を軸に進めます。それぞれが、生データを正確で一貫性あるマスターレコードへと変換する鍵となります。

主な3つの柱とその概要:

- クレンジング&標準化 ― データの誤り修正、書式統一、入力値の標準化で一貫性を確保。

- マッチング&重複排除 ― 重複や類似レコードを特定・統合し、“唯一の真実の源泉”を作る。

- エンリッチメント&拡張 ― 欠損情報を外部データや派生値で補完し、データセットの価値・実用性を高める。

これらの技術を組み合わせることで、MDMや機械学習、分析を支える高品質データを実現できます。

クレンジング&標準化

データクレンジングと標準化では、各データエントリーの一貫性と機械可読性が保証され、MDMや機械学習向けの準備が整います。主なポイントは以下の通りです。

- 正規化: 文字種、大文字・小文字、句読点、略語の統一など。

- パース(構造分解): 氏名や住所などの複合フィールドを要素ごとに分割。

- フィールド標準化: 日付・電話番号など各フィールドを統一フォーマットへ変換。

例1 – 住所:

- Raw: ACME Ltd., 1st Ave, NYC

- Rule: 略語の展開とフィールド分解

- Clean: ACME Ltd. | 1 First Avenue | New York, NY 10001

例2 – 電話番号:

- Raw: +44 20 7946 0958

- Rule: E.164フォーマットへ統一

- Clean: +442079460958

これら規則のルール化・自動適用により、エラーを減らし検索や重複判定の精度向上、MDMや分析の安全な基盤を作ります。

マッチング&重複排除

マッチングと重複排除によって、MDMシステムは各エンティティ(例:顧客・企業)ごとに唯一の正確な情報を保持できるため、不整合・重複を排除できるようになります。代表的な方法は以下の2つです。

- 決定的マッチング: 税ID・口座番号・メールアドレス等キーフィールドで完全一致による判定。精度が高い反面、些細な形式差異を見逃すこともあります。

- ファジーマッチング: 氏名や住所等、類似性をスコア化して統合またはレビューを判断。

例1 – 決定的マッチ:

- Raw: Tax ID 123-45-6789が2件存在

- Rule: 税IDの正規化・一致

- Clean: 単一の統合レコード

例2 – ファジーマッチ:

- Raw: Jon SmithとJohn S.(同じメール、類似住所)

- Rule: 類似度スコア計算(例:0–1)→ 0.9以上は自動統合、0.7–0.9は人手チェック

- Clean: レビュー結果に基づき統合

ファジースコア基準例:

| ファジースコア | アクション |

|---|---|

| > 0.95 | 自動統合 |

| 0.80–0.95 | 手動レビュー |

| < 0.80 | 統合せず |

両手法に人による確認フローを合わせることで、誤統合リスクを最小化しながら単一かつ高品質なマスターデータ管理を実現可能です。

エンリッチメント&拡張

エンリッチメントは、生データに外部情報や派生フィールドを追加し、分析や業務判断の精度を高める工程です。主な取り組み方は:

- 外部データ連携: 企業属性や住所の緯度経度、人口属性などで情報を補完。

- 派生値の算出: 顧客生涯価値(LTV)やリスクスコアなど業務判断指標を自動計算。

- ビジネスルール補完: 電話番号から自動で国/地域情報を付与等。

例 – 住所データ拡張:

- Raw: 123 Main Street, Springfield

- Rule: 緯度経度付与&地域コードの標準化

- Enriched: 123 Main Street | Springfield | IL | 62701 | Latitude: 39.7817 | Longitude: -89.6501

このようなエンリッチメント活用で、MDMレコードはさらに豊富な分析・意思決定や機械学習モデリングに直結する実用的なデータへ進化します。

自動化とワークフローパターン

データ品質維持のためには、自動化と人による監視の併用がコスト効率・精度両立のカギとなります。代表的なワークフローパターン:

- バッチクレンジング: 定期的にまとめてデータ洗浄・正規化・重複排除を実施し、全体整合性を担保。

- ストリーミング/リアルタイム検証: 新規レコードを都度、自動バリデーションし問題データ流入を防止。

- 例外/疑義レコードのステュワードキュー: ルール違反や低信頼値レコードを専門家の二次レビューへ回す。

反復処理は自動化ルール(正規化やファジーマッチ、エンリッチなど)で処理し、人員リソースは曖昧ケースや高リスク例外レビュー、改善策検討に集中。こうして高効率・高信頼なMDM運用基盤が構築できます。

指標・モニタリング(DQ KPI)

MDMおよび機械学習運用において、データ品質維持には明確なKPI追跡が不可欠です。

- 完全性: 必須フィールドがどれだけ埋まっているか。重要項目で95%以上を目指す。

- 一意性: レコード重複の発生件数。

- 適合性: 標準フォーマット(日付・電話番号等)にどれだけ準拠しているか。

- 正確性: サンプリング監査や外部ソース参照による値の正しさ。

- 適時性: データ更新の新しさ。古い情報にフラグ付与。

例:ダッシュボードには充足率のトレンド、重複件数の推移、フォーマットエラー警告、サンプリング監査結果のタイムライン等を表示。

これらKPIのモニタリングで問題の早期検知・改善優先判断・MDM/MLプロジェクトへの信頼性担保を実現します。

実践的Before/After例

以下はクレンジング・マッチング・エンリッチメントの具体的な変換例です。raw → rule適用 → clean の流れで、RPAやLLM自動化でも柔軟に活用できます。

- Raw: jon.smith@acme → Rule: ドメイン検証+小文字統一 → Clean: [email protected]

- Raw: ACME Inc., 12-34 Baker St., LDN → Rule: 書式拡張&ジオコーディング → Clean: ACME Inc. | 12-34 Baker Street | London, UK | 51.5074,-0.1278

- Raw: CUST#123 / John S. → Rule: IDと名前分離、標準化 → Clean: {customer_id: 123, name: "John Smith"}

こうした実用例を参考にすることで、データ品質向上・重複排除・エンリッチ・標準化されたマスターレコードの自動作成が効率的に行えます。「raw → rule → clean」のワークフローを徹底すれば、マスターデータ管理や分析、機械学習モデル投入の品質準備が大幅に効率化されます。

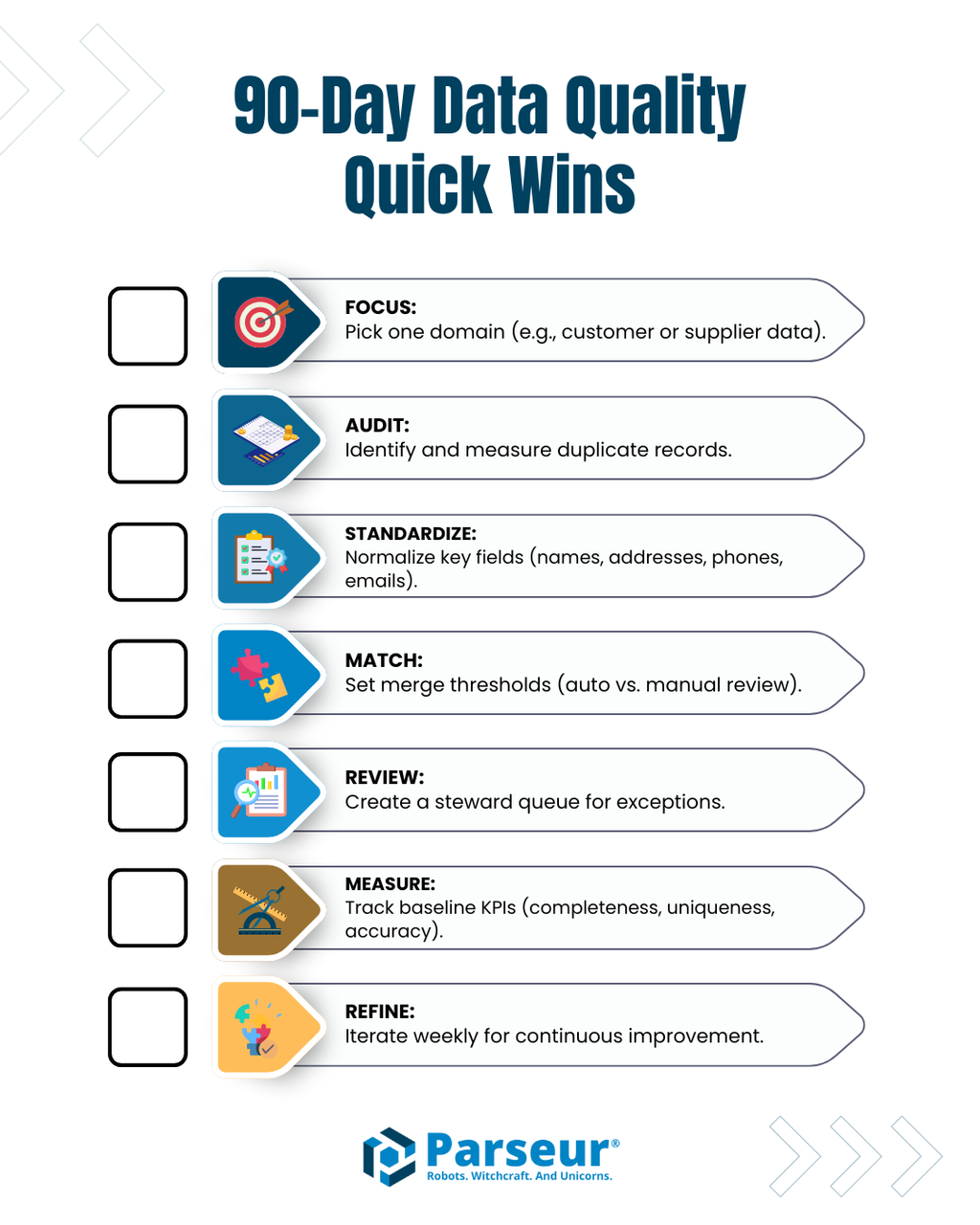

システム起動チェックリスト&90日クイックウィン

データ品質プロジェクトを開始する際は、成果が出やすい高インパクト施策に最初の90日で集中しましょう:

- 優先ドメインやデータセットを選定(例:顧客マスタや取引先データなど)

- 重複監査の実施で現状の冗長度や課題パターンを把握

- 主要フィールド(名前・住所・電話・メール等)の統一書式化

- 決定的/ファジーマッチ閾値設定による高信頼重複の自動統合

- 曖昧ケースはステュワードレビューに回す例外キュー整備

- 主要品質KPI(完全性・一意性・適合性・正確性・適時性)の現状ベースライン測定

- 毎週ルール見直しと最適化を繰り返し、正規化・マッチング・エンリッチメント規則をチューニング

このチェックリスト活用で、短期間でのデータ品質改善、業務エラー削減、信頼できるmaster data managementと機械学習基盤の確立を目指せます。

データ抽出ツールの役割

Parseurなどの文書・データ抽出ツールは、手入力作業の大幅削減とMDMワークフローの高速化に不可欠です。こうしたツールはメール、PDF、スプレッドシート、スキャンデータ等から構造化データを自動抽出し、初期正規化を施したうえでマスターデータ管理に供給します。人は主に確認・エンリッチ・例外レビューに集中でき、全体の品質維持と効率化が可能です。

抽出から始めて一元管理することで、マスターレコードが最初から一貫性ある構造・書式で各システムに投入され、後段のクレンジング・マッチング・エンリッチメントもスムーズに実行できます。

持続可能なデータ品質の確保に向けて

master data managementと機械学習を成功に導くには、クリーンで完全かつ一貫性あるデータが欠かせません。クレンジング&標準化、マッチング&重複排除、エンリッチメント&拡張の実践および自動化は、ミスや重複を減らし、データ品質を高めます。

自動化ルールと人手チェックの併用、Parseur等の抽出ツールの導入、定期的なチェックリスト実践、KPIでの継続監視、「raw → rule → clean」変換を徹底することが、高品質なデータ維持、業務効率の大幅向上、master data management/分析施策の最大化へとつながります。

よくある質問

高品質なデータはマスターデータ管理(MDM)および機械学習にとって極めて重要です。以下のFAQでは、データクレンジング、マッチング、エンリッチメント、およびParseurのような抽出ツールの役割について、よくある質問に回答しています。

-

MDMにおけるデータクレンジングとは何ですか?

-

データクレンジングは、生データの標準化と修正、フォーマットの正規化、フィールドの解析、明らかな誤りの除去を行い、一貫性のあるマスターレコードを作成します。

-

マッチングおよび重複排除はどのように機能しますか?

-

マッチングは、決定的(完全一致)またはファジー(一致度に基づく)手法で重複または同等のレコードを特定します。重複排除は、重複を統合するか、あいまいな場合は人による確認に回します。

-

データエンリッチメントとは何ですか?

-

エンリッチメントは、外部情報・派生メトリクス・推論値を追加し、レコードの欠損箇所を埋めることで、データをより完全かつ実用的にし、分析向けに整えます。

-

Parseurのような自動化ツールはMDMでどのように役立ちますか?

-

Parseurのような抽出ツールは、文書から構造化されたフィールドを自動で取得し、初期正規化を施した上でレコードをMDMパイプラインに取り込み、手作業を削減します。

-

データ品質管理で追跡すべき主要KPIは?

-

主なKPIには、完全性、一意性、適合性、正確性、そして適時性があり、高品質なマスターデータの監督と維持に役立ちます。

-

これらの手法は機械学習の成果を高められますか?

-

はい!クリーンで標準化され、エンリッチされたデータは、より精度の高いモデル・予測・分析結果につながります。

最終更新日