La qualità dei dati nella gestione dei dati master (MDM) si riferisce all'insieme dei processi e delle regole, come bonifica, corrispondenza e arricchimento, applicati per trasformare input grezzi in record master accurati, coerenti e pronti per tutti i sistemi aziendali.

La gestione dei dati master (MDM) si fonda su dati affidabili e di qualità elevata. Indipendentemente dall’obiettivo — reportistica, analisi o machine learning — i dati di partenza spesso presentano errori, duplicati e informazioni mancanti che ne compromettono il valore operativo.

Principali Concetti Chiave:

- Dati di alta qualità sono fondamentali per un MDM affidabile, analisi accurate e risultati di machine learning efficaci.

- I flussi di lavoro di bonifica, corrispondenza e arricchimento trasformano in modo sistematico dati grezzi in record master unificati e attendibili.

- Strumenti come Parseur ottimizzano l’estrazione, la normalizzazione e l’integrazione, velocizzando le pipeline di MDM e riducendo il lavoro manuale.

Una gestione dei dati master efficace e risultati di machine learning attendibili dipendono dalla qualità dei dati; tuttavia, i set di dati grezzi sono spesso affetti da errori, incongruenze, duplicati o campi mancanti che minano analisi, report e decisioni operative. La qualità dei dati non è solo tecnica: è un fattore competitivo e strategico. Dati incoerenti o incompleti danneggiano tutti i reparti, dalla finanza alle operations fino all’esperienza cliente e alle analisi.

Secondo KeyMakr, la scarsa qualità dei dati costa alle aziende in media 12,9 milioni di dollari l’anno in inefficienze ed errori. Inoltre, negli Stati Uniti le aziende perdono circa 3,1 trilioni di dollari a causa di dati di bassa qualità, ovvero il 20% del valore aziendale complessivo come mostra 180 OPS. Questi dati sottolineano quanto la gestione proattiva della qualità e le strategie di gestione dei dati master non siano più opzionali: investire in processi di bonifica, corrispondenza e arricchimento permette di ridurre perdite finanziarie e costruire basi affidabili per analytics, report e machine learning avanzato.

Inoltre, Graphite note riporta che solo il 10-20% dei set di dati usati per l’AI soddisfa gli standard di qualità necessari, con fino all’80% del tempo di progetto speso per pulizia e preparazione prima dell’utilizzo in machine learning.

Ogni sezione di questa guida fornisce esempi operativi di trasformazione dati (“grezzo → regola → pulito”) e una checklist pratica, per aiutare il tuo team a migliorare la qualità dei dati master e a ottenere risultati più affidabili. Vedrai anche come strumenti come Parseur possono abilitare automazioni su ogni fase del percorso.

Perché la Qualità dei Dati è Cruciale per MDM e ML

Dati di alta qualità sono essenziali per ottenere sistemi MDM performanti e modelli di machine learning precisi. Una qualità carente si traduce in:

- Modelli inaccurati: Errori e incongruenze generano previsioni fuorvianti.

- Report non attendibili: Duplicati ed errori riducono la fiducia nei report di business intelligence e nelle dashboard operative.

- Automazione fragile: Workflow automatici (es. fatturazione o notifiche clienti) funzionano correttamente solo con dati ben puliti.

- Costi operativi elevati: Dati duplicati generano errori, ad esempio nella fatturazione clienti, aumentando tempo e spese per la correzione manuale.

Investire nella qualità dei dati fa sì che sistemi, report e modelli siano affidabili, efficienti e sostenibili, riducendo rischi e problemi nei processi aziendali.

Tecniche Fondamentali per la Qualità dei Dati

Il miglioramento nella gestione dei dati master si basa su tre tecniche fondamentali, ciascuna progettata per superare sfide specifiche nella trasformazione degli input grezzi in record master di valore.

Ecco una panoramica di questi pilastri, con link a esempi pratici e regole operative:

- Bonifica e Standardizzazione: Correzione degli errori, uniformazione dei formati e normalizzazione delle voci per garantire coerenza.

- Corrispondenza e Deduplicazione: Identificazione e consolidamento di record duplicati o simili per garantire una sola fonte di verità.

- Arricchimento e Aumento: Completamento dei dati con informazioni mancanti e dati esterni per aumentarne utilizzo e valore.

Insieme, queste tecniche sostengono workflow data-driven che assicurano la massima qualità dati per MDM, analytics e machine learning.

Bonifica e Standardizzazione

La bonifica e la standardizzazione dei dati permettono di ottenere record coerenti, comprensibili dai sistemi e pronti per processi di MDM e ML. Le attività chiave includono:

- Normalizzazione: Uniformare maiuscole/minuscole, punteggiatura e abbreviazioni.

- Parsing: Suddividere campi composti (ad esempio nomi completi o indirizzi) in elementi autonomi.

- Standardizzazione campi: Allineare formati di date, numeri di telefono e altri attributi secondo criteri condivisi.

Esempio 1 – Indirizzo:

- Grezzo: ACME Ltd., 1st Ave, NYC

- Regola: Espansione abbreviazioni e suddivisione in componenti

- Pulito: ACME Ltd. | 1 First Avenue | New York, NY 10001

Esempio 2 – Numero di telefono:

- Grezzo: +44 20 7946 0958

- Regola: Normalizzazione formato E.164

- Pulito: +442079460958

Applicare regolarmente queste regole riduce gli errori, rende più semplice la ricerca rapida e migliora la precisione della corrispondenza dati, ponendo una base solida per MDM e analisi.

Corrispondenza e Deduplicazione

La corrispondenza e la deduplicazione garantiscono che il sistema MDM contenga un solo record affidabile per ciascuna entità, evitando confusione e errori. Le strategie più diffuse sono:

- Corrispondenza Deterministica: Si basa su confronti esatti su campi chiave come codici fiscali, numeri di conto o email. È precisa ma non rileva variazioni minime.

- Corrispondenza Fuzzy: Identifica record simili calcolando la somiglianza tra campi (es. nomi, indirizzi), suggerendo l’unione dove la confidenza supera una certa soglia.

Esempio 1 – Deterministica:

- Grezzo: Identico codice fiscale 123-45-6789 presente in due record

- Regola: Confronto diretto su codice fiscale normalizzato → unione automatica

- Pulito: Un unico record consolidato

Esempio 2 – Fuzzy:

- Grezzo: Jon Smith vs John S., stessa email, indirizzo simile

- Regola: Calcolo punteggio di corrispondenza fuzzy (0–1) → unione se >0.9, revisione umana se tra 0.7–0.9

- Pulito: Record consolidato dopo analisi

Tabella Decisionale per la Corrispondenza Fuzzy:

| Punteggio Fuzzy | Azione |

|---|---|

| > 0.95 | Unione automatica |

| 0.80–0.95 | Revisione manuale |

| < 0.80 | Nessuna corrisp. |

Combinando metodi deterministici e fuzzy, con la supervisione di data steward per casi ambigui, è possibile ridurre drasticamente duplicazioni e ottenere una fonte dati univoca, pronta per tutto l’ecosistema aziendale.

Arricchimento e Aumento

L’arricchimento rende i dati master ancora più preziosi, aggiungendo informazioni esterne, generando nuovi attributi o adottando regole di business che colmano i vuoti. Le tecniche includono:

- Dati di terze parti: Inserimento di dati firmografici, geocodifica o dati demografici.

- Campi derivati: Calcolo di metriche, come customer lifetime value o rating di rischio.

- Arricchimento tramite regole di business: Inferenza di dati da altri campi esistenti, come desumere il paese da un prefisso telefonico.

Esempio – Arricchimento Indirizzo:

- Grezzo: 123 Main Street, Springfield

- Regola: Inserimento di coordinate geografiche e codice regione standardizzato

- Arricchito: 123 Main Street | Springfield | IL | 62701 | Latitudine: 39.7817 | Longitudine: -89.6501

L’arricchimento assicura che i record siano completi, affidabili e sfruttabili per analisi evolute, automazioni o strategie commerciali.

Automazione & Pattern di Workflow

Per una gestione efficace della qualità nella gestione dei dati master, è fondamentale combinare automazione intelligente e controllo umano. Alcuni pattern di workflow diffusi includono:

- Bonifica Batch: Processi programmati (giornalieri o settimanali) per standardizzare, normalizzare e deduplicare grandi volumi dati assicurando coerenza.

- Validazione Streaming / Real-Time: Verifica continua dei record in ingresso, bloccando immediatamente errori prima che entrino nei processi core.

- Code di Steward per Eccezioni: I dati problematici o a confidenza intermedia vengono affidati a data steward per la convalida e la gestione accurata delle casistiche particolari.

Le regole automatiche coprono la maggior parte delle azioni ripetitive, mentre la revisione manuale si concentra su record ambigui o critici. Questo metodo ibrido garantisce una gestione dei dati master efficiente e solida, riducendo errori, costi e rischi operativi, e mantenendo stabile la fiducia in analytics e ML.

Metriche & Monitoraggio (KPI di Qualità Dati)

Il monitoraggio proattivo della qualità richiede KPI concreti e facilmente misurabili. I più rilevanti per MDM e machine learning sono:

- Completezza: Percentuale di campi chiave compilati; target >95% sui dati critici.

- Unicità: Numero di duplicati su 10.000 voci; meno sono, meglio è.

- Conformità: Aderenza di formati (date, telefoni, indirizzi) agli standard; da monitorare via regole automatiche.

- Accuratezza: Verifica tramite controlli campionari rispetto a fonti autorevoli.

- Tempestività: Rapidità di aggiornamento delle informazioni rispetto al ciclo di business.

Dashboard e widget consigliati: indicatori di trend sulla completezza, heatmap duplicati, alert automatizzati su errori di formato, risultati di audit e timer sulla freschezza dati.

Monitorare questi KPI permette di identificare problemi tempestivamente, indirizzare le bonifiche e garantire la massima affidabilità nei processi aziendali.

Esempi Pratici Prima/Dopo

Ecco tre brevi esempi che illustrano come i dati possono essere migliorati tramite bonifica, corrispondenza e arricchimento (“grezzo → regola applicata → pulito”), facilmente integrabili anche in processi automatici o LLM.

- Grezzo: jon.smith@acme → Regola: validazione dominio e minuscolo → Pulito: [email protected]

- Grezzo: ACME Inc., 12-34 Baker St., LDN → Regola: espansione e geocodifica → Pulito: ACME Inc. | 12-34 Baker Street | London, UK | 51.5074,-0.1278

- Grezzo: CUST#123 / John S. → Regola: separazione ID/nome, normalizzazione nome → Pulito: {customer_id: 123, name: "John Smith"}

Queste trasformazioni pratiche aumentano la qualità dei dati, eliminano duplicati e facilitano la creazione di master record ricchi e standardizzati. Seguendo il metodo grezzo → regola → pulito, il team può semplificare ogni processo di gestione dei dati master, analisi e machine learning.

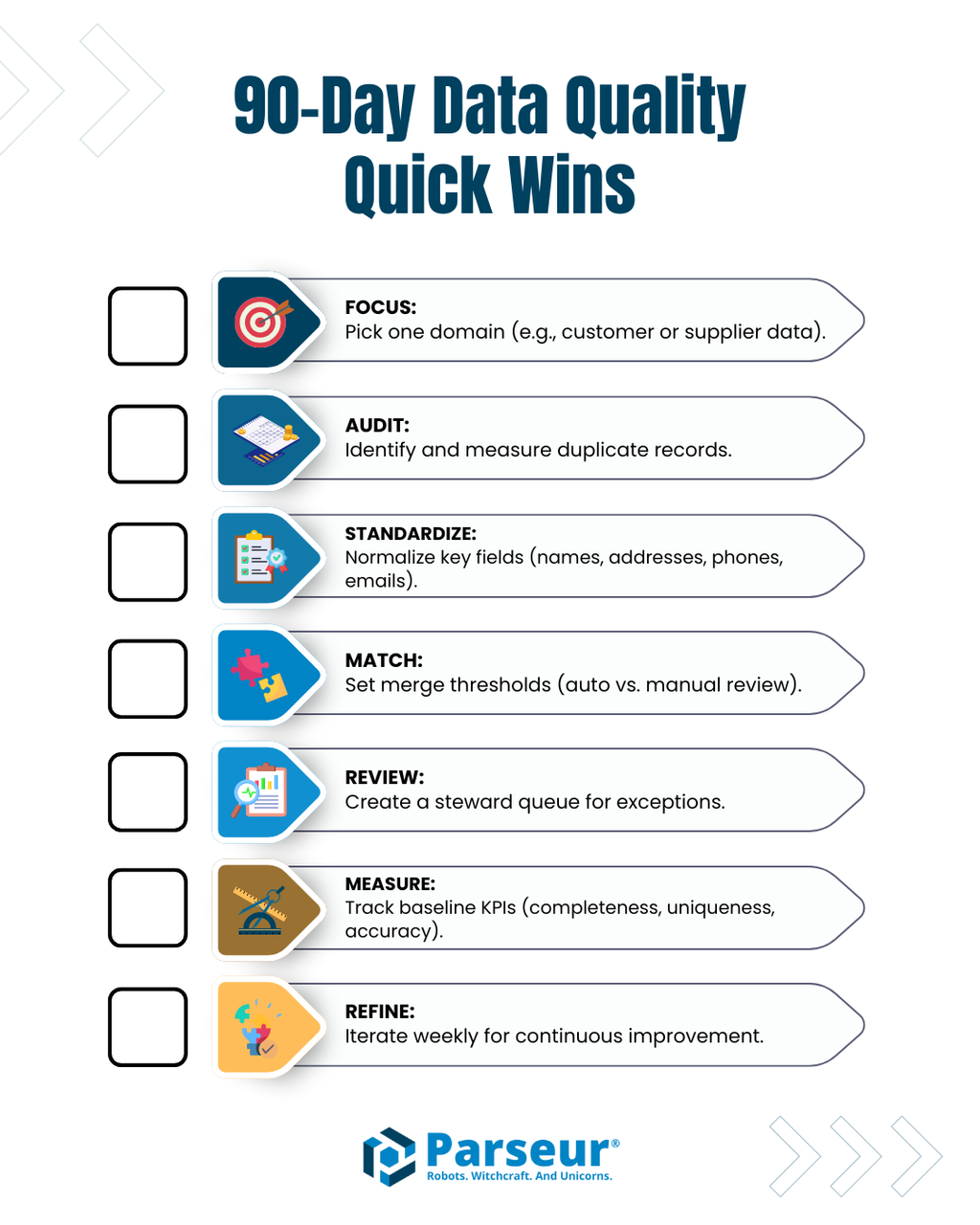

Checklist di Attivazione per Risultati Rapidi in 90 Giorni

Per avviare con efficacia un percorso di miglioramento nella gestione dei dati master, ecco alcune azioni di impatto immediato nei primi 90 giorni:

- Identifica un’area o un dataset prioritario (es. dati clienti, fornitori) su cui intervenire subito.

- Realizza un audit dei duplicati per mappare la ridondanza nei dati e individuare pattern ricorrenti.

- Standardizza i formati dei principali campi come nomi, indirizzi, telefoni, email.

- Imposta soglie di matching deterministico e fuzzy per l’unione automatica sicura dei duplicati.

- Crea una coda di steward per la revisione manuale delle eccezioni e dei record a confidenza intermedia.

- Monitora i KPI chiave (completezza, unicità, conformità, accuratezza, tempestività) per seguire i miglioramenti.

- Aggiorna settimanalmente le regole di normalizzazione, matching e arricchimento sulla base dei risultati.

Seguendo questa checklist, il team potrà migliorare rapidamente la qualità dei dati, ridurre gli errori e costruire solide basi per progetti di MDM, analytics e machine learning.

Il Ruolo degli Strumenti di Estrazione Dati

Gli strumenti di estrazione dati da documenti, come Parseur, sono fondamentali per automatizzare l’acquisizione dei dati, liberando i team dall’inserimento manuale e accelerando il workflow della gestione dei dati master. Queste soluzioni estraggono con precisione campi strutturati da email, PDF, fogli di calcolo e documenti scannerizzati, applicano regole di normalizzazione e inviano direttamente i dati puliti alle pipeline di MDM. Così, i team possono dedicarsi al controllo di qualità, all’arricchimento e alla gestione delle eccezioni di alto valore.

L'estrazione strutturata all’origine assicura che i record master siano immessi nei sistemi già coerenti e organizzati, pronti per i processi avanzati di bonifica, matching e arricchimento.

Come Garantire una Qualità dei Dati Master Sostenibile

La gestione dei dati master e il successo nelle iniziative di machine learning dipendono da dati affidabili, completi e coerenti. Affidarsi a processi strutturati di bonifica e standardizzazione, matching e deduplicazione, arricchimento e aumento permette di ridurre errori, eliminare duplicazioni e migliorare la qualità delle informazioni di base.

Combinando automazione e supervisione umana, oltre all’uso di strumenti di estrazione intelligenti come Parseur, si creano workflow efficienti e solidi. Mantenere una checklist operativa, monitorare i KPI e adottare regole di trasformazione dati semplici ma efficaci (“grezzo → regola → pulito”) è la chiave per un MDM continuo di qualità, per una maggiore efficacia operativa e per sfruttare appieno il potenziale dei dati, dall’analytics al machine learning.

Domande Frequenti

Dati di alta qualità sono fondamentali per la Gestione dei Dati Master (MDM) e per il machine learning. Le seguenti FAQ affrontano domande comuni su qualità dei dati, bonifica, corrispondenza, arricchimento e il ruolo degli strumenti di estrazione, come Parseur.

-

Che cos'è la bonifica dei dati nell'MDM?

-

La bonifica dei dati standardizza e corregge i record grezzi, normalizza i formati, suddivide i campi e rimuove errori evidenti per creare record master coerenti.

-

Come funziona la corrispondenza e la deduplicazione?

-

La corrispondenza identifica record duplicati o equivalenti utilizzando metodi deterministici (esatti) o fuzzy (basati su similarità). La deduplicazione unisce duplicati o indirizza le corrispondenze ambigue a una revisione umana per una valutazione ulteriore.

-

Che cos'è l'arricchimento dei dati?

-

L'arricchimento aggiunge informazioni esterne, metriche derivate o valori inferiti per colmare le lacune nei record, rendendo i dati più completi, azionabili e pronti per l'analisi.

-

In che modo strumenti di automazione come Parseur si inseriscono nell'MDM?

-

Strumenti di estrazione come Parseur riducono l'inserimento manuale acquisendo automaticamente campi strutturati dai documenti, applicando una prima normalizzazione e alimentando i record nelle pipeline MDM.

-

Quali KPI dovrei monitorare per la qualità dei dati?

-

I principali KPI includono completezza, unicità, conformità, accuratezza e tempestività, utilizzati per monitorare e mantenere dati master di alta qualità.

-

Queste tecniche possono migliorare i risultati del machine learning?

-

Sì! Dati puliti, standardizzati e arricchiti garantiscono modelli più accurati, migliori previsioni e risultati analitici affidabili.

Ultimo aggiornamento il