主数据管理(MDM)中的数据质量,是一套将原始数据转化为准确、一致、可系统利用的主数据记录的流程与规范,包括清洗、匹配和增强等步骤。

主数据管理的有效实施高度依赖于高质量、一致性的数据。不论应用于报表、分析还是机器学习,原始数据常常伴随不一致、重复与缺失等问题。

要点总结:

- 高质量数据是稳健主数据管理、精准分析和高效机器学习的基础。

- 借助清洗、匹配和增强工作流,可将原始数据系统性转化为一致且值得信赖的主数据。

- Parseur等自动化工具简化了数据提取、标准化和整合流程,加速主数据管理的落地,并减少人工操作。

要实现可靠的主数据管理和高质量机器学习结果,前提是基础数据须足够可靠。然而,很多原始数据集存在拼写错误、格式不统一、重复、字段缺失等问题,直接影响企业数据分析、报告和运营决策的准确性。高质量数据不仅事关技术,更关乎企业整体竞争力。当企业依赖于不完整、混乱或重复的数据,影响将波及财务、运营、客户体验乃至各类分析。

根据KeyMakr,数据质量差每年给企业平均带来约1290万美元的损失,主要由于低效和出错,说明数据管理不善,代价高昂。此外,仅在美国,据180 OPS报道,低数据质量每年导致企业损失高达3.1万亿美元,约占企业总价值的20%,反映出数据问题广泛和深远的影响。这些事实进一步证明,主动管理数据质量和推行主数据管理策略至关重要。投入于高质量数据清洗、匹配和增强,不仅能显著削减损失,更可为分析、报告和机器学习构建坚实基础。

另外, Graphite notes 指出,只有约10-20%的AI项目数据集达到可靠机器学习所需的数据质量标准,而数据清洗与准备往往耗费项目80%的时间。

下文各章节均配有**“原始→规则→清洗后”**的直接实践流程,可用于企业自身的数据集,并配套有实用清单,助力团队系统提升数据质量,让主数据管理和机器学习更加可靠高效,同时阐述Parseur等提取工具如何实现自动化处理。

为何数据质量对主数据管理和机器学习至关重要

高质量数据是主数据管理和机器学习产出可靠结果的基础。不完善的数据会影响系统、流程,甚至决策,具体表现为:

- 模型准确性下降: 错误或不一致的信息会误导机器学习模型,造成预测与洞察偏差。

- 报告可信度受损: 重复或不准的记录令BI报表和运营报告失去参考意义。

- 自动化流程失效: 自动化(如账单、通知等)依赖干净数据,否则无法高效运行。

- 运营成本上升: 数据错误(如客户重复)导致混乱,需人工校正,提高了人力成本。

对数据质量的持续投资,能确保系统、报表和模型可信、高效,显著降低企业风险与资源浪费。

数据质量的三大核心技术

要提升主数据管理中的数据质量,必须针对其三个关键挑战,采用相应技术流程:

下表概括了三大支柱及其常见场景,并配有详细操作案例和规则链接:

- 清洗与标准化 —— 修正错误、统一格式、规范数据录入,为数据一致性和可靠性打下基础。

- 匹配与去重 —— 识别并合并重复或等价记录,确保数据唯一且可追溯。

- 增强与补充 —— 填补缺失、引入外部数据,使信息更完整,有利于深入挖掘和分析。

三大技术协同支持,帮助企业建立一套可持续保障高质量数据的主数据管理工作流。

清洗与标准化

通过清洗与标准化,使数据一致、可系统处理,便于应用于主数据管理与机器学习模型。关键操作包括:

- 归一化处理: 规范大小写、标点、缩写等,实现统一格式。

- 字段拆分: 比如将姓名或地址等复合字段细分为结构化元素。

- 统一格式化: 例如将日期、电话等转化为标准结构。

案例1——地址处理:

- 原始: ACME Ltd., 1st Ave, NYC

- 规则: 展开缩写、独立组件

- 清洗后: ACME Ltd. | 1 First Avenue | New York, NY 10001

案例2——电话号码格式化:

- 原始: +44 20 7946 0958

- 规则: 标准化为E.164格式

- 清洗后: +442079460958

体系化的清洗和标准化过程可消除冗余,提升后续匹配与分析准确率,为可靠的主数据及分析提供坚实支撑。

匹配与去重

匹配和去重确保主数据管理系统为每一实体只保留一条权威记录,消除重复与混乱。常用方法:

- 确定性匹配: 如税号、账号、邮箱等关键字段精确比对,能消灭大部分完全重复,但对细微差异处理能力有限。

- 模糊匹配: 比如按姓名、地址、电话等相似度打分,结合阈值判断是否自动合并或转人工审核。

案例1——确定性匹配:

- 原始: 税号123-45-6789出现在多条记录中

- 规则: 税号格式统一后精确匹配→合并记录

- 清洗后: 合并为唯一的可靠记录

案例2——模糊匹配:

- 原始: Jon Smith 与 John S.,邮箱一致,地址接近

- 规则: 计算相似度分数(0–1);高于0.9自动合并,0.7–0.9转人工审核

- 清洗后: 保留单一,已审核的权威记录

模糊匹配决策表:

| 模糊分数 | 操作 |

|---|---|

| > 0.95 | 自动合并 |

| 0.80–0.95 | 人工审核 |

| < 0.80 | 不匹配 |

结合高效自动化与人工复核,企业可在消除重复的同时,保障主数据的准确性和唯一性,为分析和自动化构建可信的根基。

增强与补充

数据增强通过引入外部信息、业务推断、自动生成新字段等方式,让主数据更加丰富、完整。常见做法有:

- 第三方补全: 例如补充企业属性、地理信息或人口统计数据。

- 衍生字段生成: 计算如客户生命周期价值、风险等级等指标。

- 智能推断: 如根据电话区号推断国家或省份等。

案例——地址增强:

- 原始: 123 Main Street, Springfield

- 规则: 补充地理坐标、标准完整地址

- 增强后: 123 Main Street | Springfield | IL | 62701 | 纬度:39.7817 | 经度:-89.6501

增强后的数据更精确、可用,有助于提高分析结果和模型表现,使主数据管理更具增值能力。

自动化与流程模式

高效的数据质量管理需自动化与人工干预协作,从而弹性维护大型主数据集的一致性和准确性。主要情景包括:

- 批量数据清洗: 定期处理整批数据,实现快速标准化、统一和去重,适合历史和全量数据处理。

- 实时/准实时校验: 对新录入数据实施在线检查,第一时间发现和修正问题,避免缺陷进入主系统。

- 人工复核队列: 针对难以判别或不达标的数据,通过任务分配给专职数据管理员做定向纠正。

自动规则专注重复性高、可量化的处理(如归一、匹配、增强),人工则处理复杂或需业务判断的疑难数据,保障主数据管理的自动化可靠运行,减少运营成本和错误风险。

数据质量指标与监控(DQ KPI)

要科学评估和持续提升数据质量,企业应关注以下五大核心KPI:

- 完整性: 关键字段的数据填充比例,核心列建议>95%。

- 唯一性: 每万条记录中的重复数值,目标越低越好。

- 合规性: 自动检测标准格式(如日期、电话、地址),不合规处及时预警。

- 准确性: 抽检与权威来源对比,周期性人工校验。

- 时效性: 数据更新及时与否,是否有过时记录。

配套仪表盘可展示:完整性趋势、重复分布、格式合规率、样本核查和数据时效状态等,便于及时修正并持续优化主数据管理流程。

实用原始与清洗对比案例

以下为三组典型转化案例,展示如何通过规则将原始数据优化,助力主数据管理与机器学习:

- 原始:jon.smith@acme → 规则:补充分域名并小写 → 清洗后:[email protected]

- 原始:ACME Inc., 12-34 Baker St., LDN → 规则:地址扩展、补全地理信息 → 清洗后:ACME Inc. | 12-34 Baker Street | London, UK | 51.5074,-0.1278

- 原始:CUST#123 / John S. → 规则:分离ID与规范姓名 → 清洗后:{customer_id: 123, name: "John Smith"}

这些案例突显了“原始→规则→清洗后”的高效流程,不仅提升数据质量,还支持自动化应用和AI大模型调用,助力团队快速实现主数据标准化。

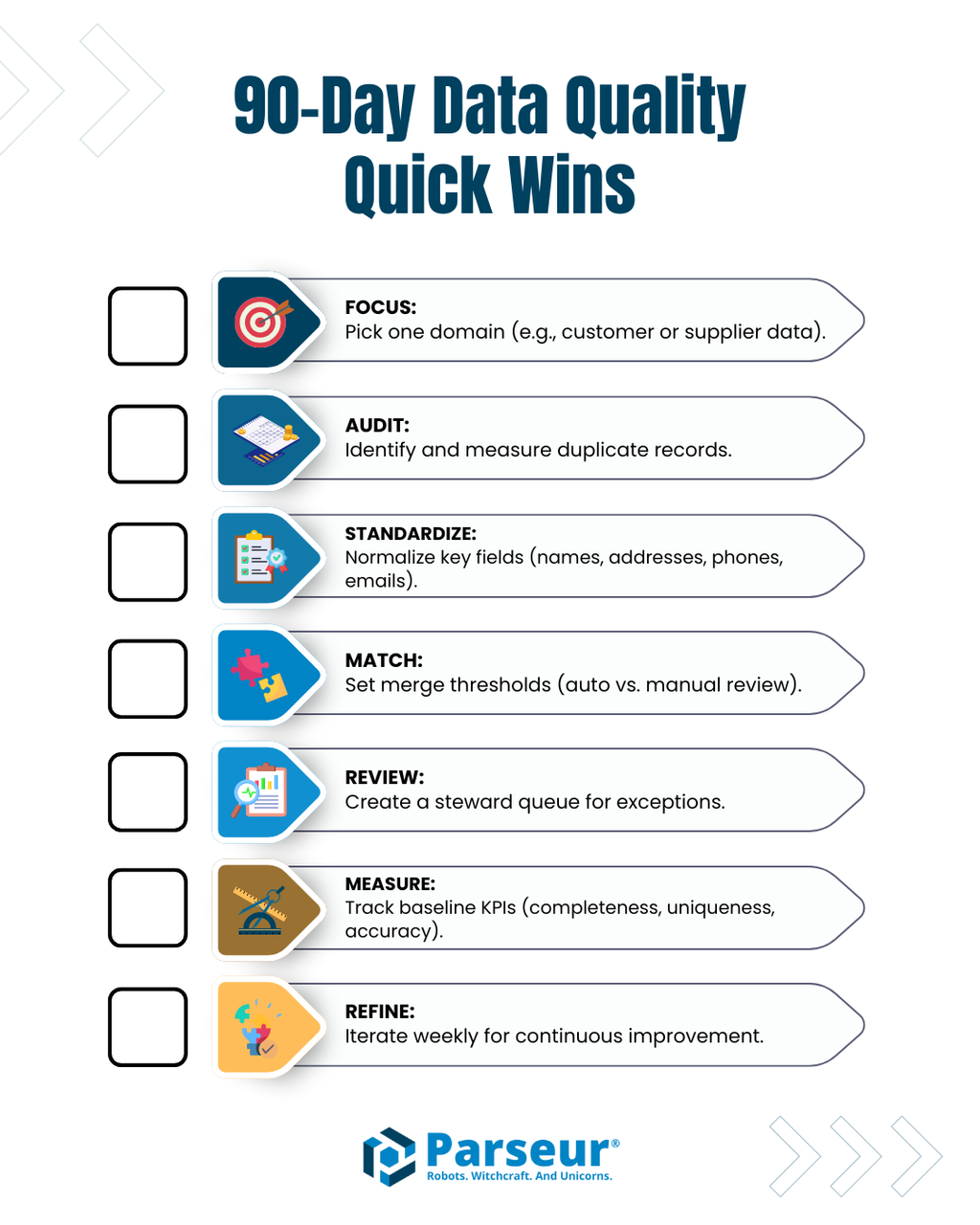

系统激活清单与90天快速提升方案

企业在启动主数据管理的数据质量提升时,建议在前90天集中精力完成以下高影响任务:

- 优先选定核心数据集(如客户或供应商记录)。

- 开展重复数据审查,识别并分析常见冗余。

- 统一关键字段(姓名、地址、电话、邮箱等)格式。

- 设定自动合并与人工审核的阈值规则。

- 针对低置信度或复杂案例,建立人工复核流程。

- 测算并跟踪数据完整性、唯一性、合规性、准确性、时效性等基线KPI。

- 每周定期优化归一化、匹配和增强规则,持续推动改进。

遵循该清单可让团队快速改进数据质量,减少运营错误,夯实主数据管理、分析和机器学习的坚实数据底座。

数据提取工具作用解析

文档及数据提取工具(如Parseur)对于简化数据录入、加速主数据管理至关重要。这些工具能够从邮件、PDF、表格等来源自动提取结构化字段,初步应用标准化,再将规范数据推入主数据管理管道。自动化处理大批量原始数据,释放团队精力专注于校验和特殊处理场景。

利用提取工具将标准结构化数据作为流程起点,为后续的清洗、匹配与增强高效运行打好基础,显著提升整体主数据管理成效。

实现可持续的数据质量

主数据管理与机器学习的价值实现,始于数据的清洁、完整和一致。综合运用清洗与标准化、匹配与去重、增强与补充等核心技术,企业能有效治理数据错误、消除重复、补足信息,实现主数据的高质、统一。

通过自动化引擎与人工流程配合,利用Parseur等智能提取工具,并严格监控关键KPI,企业能够持续保持高水准数据质量,提升运营效率和决策力,释放主数据管理与分析运算的全部价值。

常见问题解答

高质量数据对于主数据管理(MDM)和机器学习至关重要。以下FAQ解答了关于数据质量、清洗、匹配、增强以及像Parseur这样的提取工具在其中所扮演角色的常见问题。

-

MDM中的数据清洗是什么?

-

数据清洗通过标准化和校正原始记录、格式归一化、字段解析和移除明显错误,为创建一致的主数据记录奠定基础。

-

匹配和去重是如何工作的?

-

匹配通过确定性(精确匹配)或模糊(基于相似度)方法识别重复或等价记录。去重将重复数据合并,或将不明确的匹配交由人工审核进一步评估。

-

什么是数据增强?

-

增强通过添加外部信息、衍生指标或推断值来补全记录中的空白,使数据更加完整、可用并适合分析。

-

Parseur等自动化工具如何融入MDM?

-

像Parseur这样的提取工具可自动从文档中抓取结构化字段,应用初步标准化,并将记录输入MDM流程,减少人工录入。

-

应该跟踪哪些数据质量KPI?

-

主要KPI包括完整性、唯一性、合规性、准确性和时效性,这些指标用于监控并保持高质量主数据。

-

这些技术能提升机器学习的成果吗?

-

完全可以!干净、标准化和增强的数据有助于获得更精确的模型、更佳的预测和更可靠的分析结果。

最后更新于