Jakość danych dla zarządzania danymi głównymi (MDM) odnosi się do zbioru procesów i reguł: czyszczenia, dopasowywania i wzbogacania, których celem jest przekształcenie surowych informacji w precyzyjne, spójne, gotowe do wykorzystania rekordy główne w całej organizacji.

Zarządzanie danymi głównymi wymaga wysokiej jakości, ustandaryzowanych informacji. Niezależnie od tego, czy przygotowujesz dane do raportowania, analiz, czy uczenia maszynowego, nieprzetworzone dane często zawierają niespójności, duplikaty oraz luki.

Najważniejsze informacje:

- Dane wysokiej jakości stanowią podstawę rzetelnego zarządzania danymi głównymi, analityki biznesowej oraz uczenia maszynowego.

- Procesy czyszczenia, dopasowywania i wzbogacania systematycznie zmieniają surowe dane w spójne, godne zaufania rekordy główne.

- Narzędzia klasy Parseur usprawniają ekstrakcję, normalizację i integrację, przyspieszając procesy MDM oraz minimalizując ręczną pracę.

Skuteczne zarządzanie danymi głównymi i wysokiej klasy wyniki uczenia maszynowego zaczynają się od danych wysokiej jakości. Niestety, surowe zbiory informacji pełne są literówek, niejednolitych zapisów, duplikatów i nieuzupełnionych pól, które mogą negatywnie wpływać na analizy, raporty i decyzje biznesowe. Dbanie o jakość danych nie jest już tylko wymogiem technologicznym – to konieczność dla każdej nowoczesnej organizacji. Opieranie się na niekompletnych, niespójnych lub powielonych danych przekłada się na negatywne konsekwencje biznesowe we wszystkich działach – od finansów, przez operacje, po obsługę klienta i dział analityki.

Jak podaje KeyMakr, zła jakość danych kosztuje firmy średnio 12,9 mln dolarów rocznie w postaci nieefektywności i błędów. W samych Stanach Zjednoczonych straty z powodu niskiej jakości danych sięgają około 3,1 biliona dolarów rocznie – ok. 20% całkowitej wartości biznesowej (180 OPS). Dane te pokazują jasno, jak istotna jest proaktywna praca nad jakością danych i wdrażanie strategii MDM. Inwestowanie w procesy czyszczenia, dopasowywania i wzbogacania ogranicza nie tylko straty finansowe, ale także pozwala stworzyć solidne podstawy pod zaawansowaną analitykę, raportowanie oraz projekty ML.

Ponadto Graphite note zwraca uwagę, że jedynie 10–20% zestawów danych wykorzystywanych w projektach AI spełnia standardy jakości wymagane do wiarygodnego ML, a do 80% czasu projektowego pochłania przygotowanie i czyszczenie danych przed rzeczywistą analizą czy trenowaniem modeli.

Każda sekcja w tym artykule zawiera praktyczny workflow „surowe → reguła → oczyszczone” gotowy do wdrożenia oraz listę kontrolną pomagającą zespołom systematycznie podnosić jakość danych i zwiększać efektywność zarządzania danymi głównymi i uczenia maszynowego. Pokazujemy również, jak narzędzia klasy Parseur mogą zautomatyzować kluczowe elementy tego procesu.

Dlaczego jakość danych jest kluczowa w MDM i ML

Dobra jakość danych to fundament skutecznego zarządzania danymi głównymi oraz wiarygodnych wyników modeli uczenia maszynowego. Kiepskie dane mogą wywołać efekt domina, zaburzając systemy, procesy oraz decyzje biznesowe. Najważniejsze skutki to:

- Dokładność modeli – błędne lub niejednoznaczne dane obniżają trafność prognoz modeli ML i prowadzą do mylnych wniosków.

- Wiarygodność raportów – powielone lub wadliwe rekordy powodują, że raporty i dashboardy stają się mniej godne zaufania.

- Efektywność automatyzacji – zautomatyzowane procesy, jak fakturowanie czy komunikacja z klientem, działają poprawnie tylko na czystych, rzetelnych danych.

- Optymalizacja kosztów – niestaranne dane prowadzą do dublowania wpisów klientów, błędów rozliczeniowych i kosztownych poprawek.

Dbanie o jakość danych sprawia, że systemy, raporty i modele są rzetelne, efektywne i stabilne, pozwalając unikać kosztownych problemów i minimalizować straty.

Najważniejsze techniki poprawy jakości danych

Podnoszenie jakości danych w zarządzaniu danymi głównymi koncentruje się wokół trzech filarów – każdy służy rozwiązaniu innego typowego problemu podczas przekształcania surowych danych w precyzyjne rekordy główne.

Opis trzech kluczowych filarów z odnośnikami do praktycznych reguł i przykładów:

- Czyszczenie i standaryzacja – eliminowanie błędów, standaryzowanie formatów i unifikacja zapisów dla zapewnienia spójności danych.

- Dopasowywanie i deduplikacja – wykrywanie i agregowanie zduplikowanych lub równoważnych rekordów, tak by stworzyć jedno źródło prawdy.

- Wzbogacanie i augmentacja – uzupełnianie brakujących informacji oraz integracja danych zewnętrznych, by zwiększyć ich wartość i przydatność.

Zestawienie tych technik umożliwia budowanie workflow produkujących dane wysokiej jakości gotowe pod analizy i zastosowania ML.

Czyszczenie i standaryzacja

Czyszczenie i standaryzacja gwarantują, że wszystkie wpisy są spójne, gotowe do automatycznego przetwarzania i przygotowane do integracji w ramach MDM lub ML. Najczęstsze działania to:

- Normalizacja: Ujednolicanie wielkości liter, interpunkcji i skrótów.

- Parsowanie: Dekompozycja złożonych pól (np. imię i nazwisko lub adres) na osobne, jednoznaczne komponenty.

- Standaryzacja pól: Konwersja dat, numerów telefonów czy innych pól do jednego formatu.

Przykład 1 – Adres:

- Surowe: ACME Ltd., 1st Ave, NYC

- Reguła: Rozwinięcie skrótów i wydzielenie poszczególnych elementów

- Oczyszczone: ACME Ltd. | 1 First Avenue | New York, NY 10001

Przykład 2 – Numer telefonu:

- Surowe: +44 20 7946 0958

- Reguła: Normalizacja do standardu E.164

- Oczyszczone: +442079460958

Systematyczne wdrożenie powyższych reguł ogranicza liczbę pomyłek, poprawia wyszukiwanie i dopasowywanie oraz stanowi fundament efektywnego zarządzania danymi głównymi.

Dopasowywanie i deduplikacja

Dopasowywanie i deduplikacja eliminują wielokrotne wpisy tej samej jednostki i zapewniają, że w systemie MDM istnieje jeden precyzyjny rekord na każdą encję, wolny od niespójności i powtórek. Wyróżnia się dwa główne podejścia:

- Dopasowywanie deterministyczne: Wyszukiwanie identycznych wartości w kluczowych polach (np. NIP, numer konta, e-mail). Daje wysoką dokładność, ale może pominąć nieoczywiste duplikaty.

- Dopasowywanie rozmyte (fuzzy): Analiza podobieństwa wybranych pól (np. imię i nazwisko, adres, telefon), konsolidowanie rekordów na podstawie progów zaufania.

Przykład 1 – Deterministyczne:

- Surowe: Numer NIP 123-45-6789 pojawia się w dwóch rekordach

- Reguła: Dokładne dopasowanie po znormalizowanym NIP → konsolidacja

- Oczyszczone: Jeden rekord po scaleniu

Przykład 2 – Fuzzy:

- Surowe: Jon Smith vs John S., ten sam e-mail, zbliżony adres

- Reguła: Obliczenie wskaźnika podobieństwa (0–1) → połączenie przy wyniku > 0,9, przekazanie do ręcznej weryfikacji dla 0,7–0,9

- Oczyszczone: Jeden rekord po weryfikacji

Tabela decyzyjna do fuzzy matching:

| Wynik Fuzzy | Akcja |

|---|---|

| > 0.95 | Automatyczne połączenie |

| 0.80–0.95 | Ręczna weryfikacja |

| < 0.80 | Brak połączenia |

Łącząc podejścia deterministyczne i rozmyte oraz wykorzystując weryfikację człowieka w trudnych przypadkach, organizacje skutecznie eliminują duplikaty, zapewniając wysokiej jakości, niezawodne dane główne do analiz, raportowania oraz automatyzacji.

Wzbogacanie i augmentacja

Wzbogacanie danych polega na uzupełnianiu niepełnych rekordów poprzez dodawanie informacji zewnętrznych, pól wyliczanych lub wnioskowanych w oparciu o reguły biznesowe. Typowe metody obejmują:

- Dane zewnętrzne: Pozyskiwanie danych demograficznych, geolokalizacji, informacji firmowych w celu wypełnienia luk.

- Pola pochodne: Obliczanie wskaźników, takich jak LTV klienta czy scoring ryzyka.

- Reguły biznesowe: Wnioskowanie brakujących wartości (np. kraj na bazie prefiksu telefonu).

Przykład – Wzbogacenie adresu:

- Surowe: 123 Main Street, Springfield

- Reguła: Dodanie geolokalizacji i kodu regionu

- Wzbogacone: 123 Main Street | Springfield | IL | 62701 | Szerokość: 39.7817 | Długość: -89.6501

Dzięki wzbogacaniu rekordy MDM stają się kompletniejsze, dokładniejsze i gotowe do analiz, prognozowania czy decyzji operacyjnych – co dalece wykracza poza prostą deduplikację czy czyszczenie.

Automatyzacja i wzorce workflow

Nowoczesne zarządzanie danymi głównymi bazuje na automatyzacji wspieranej nadzorem człowieka, by utrzymać spójność i aktualność informacji na dużą skalę. Najpopularniejsze schematy działań:

- Batch Cleansing: Regularne (np. codzienne, tygodniowe) procesy czyszczenia, standaryzacji i deduplikacji całych zbiorów rekordów.

- Walidacja w trybie ciągłym / strumieniowym: Sprawdzanie nowych rekordów na bieżąco, zanim trafią do systemów.

- Kolejka stewardów: Przypadki niejednoznaczne lub poniżej określonego progu zaufania trafiają do ręcznej weryfikacji.

Większość rutynowych zadań realizują automatyczne reguły – np. normalizacja, fuzzy matching i enrichment – natomiast użytkownik skupia się na nietypowych wpisach. Taki model pozwala zapewnić wydajne, powtarzalne zarządzanie danymi głównymi z minimalnym ryzykiem błędu i wysokim poziomem zaufania do danych.

KPI i monitoring jakości danych (DQ KPIs)

Monitorowanie jakości danych głównych wymaga jasnych, dobrze mierzalnych wskaźników. Kluczowe KPI zarządzania danymi głównymi oraz ML to:

- Kompletność: Odsetek uzupełnionych obligatoryjnych pól (cel: ponad 95%).

- Unikalność: Liczba duplikatów na każde 10 000 rekordów – im mniej, tym lepiej.

- Zgodność: Odsetek rekordów spełniających ustalone formaty (daty, telefony, adresy); monitorowanie wspomagane walidacją automatyczną.

- Dokładność: Regularny audyt na próbach porównywanych ze źródłami wzorcowymi.

- Aktualność: Ocena świeżości informacji, tak by zmiany były natychmiast odwzorowane, a nieaktualne dane oznaczone.

Przykładowe metryki dashboardowe: trendy kompletności, heatmapy duplikatów, alerty błędnych formatów, audyty jakościowe, licznik świeżości danych.

Na bieżąco monitorując te wskaźniki, organizacje mogą proaktywnie wychwytywać problemy, priorytetyzować działania naprawcze i utrzymać najwyższą jakość danych głównych na potrzeby analityki, raportowania i uczenia maszynowego.

Praktyczne przykłady: przed i po

Oto trzy krótkie przykłady ilustrujące, jak surowe dane mogą zostać ztransformowane przy wykorzystaniu automatyzacji czyszczenia, dopasowywania i wzbogacania, wg workflow surowe → reguła → oczyszczone – idealnego do użycia manualnie lub w automatyzacji.

- Surowe: jon.smith@acme → Reguła: walidacja domeny + małe litery → Oczyszczone: [email protected]

- Surowe: ACME Inc., 12-34 Baker St., LDN → Reguła: rozwinięcie & geolokalizacja → Oczyszczone: ACME Inc. | 12-34 Baker Street | London, UK | 51.5074,-0.1278

- Surowe: CUST#123 / John S. → Reguła: rozdziel id i imię+nazwisko, normalizacja → Oczyszczone: {customer_id: 123, name: "John Smith"}

To praktyczne i uniwersalne transformacje, które pozwalają podnieść jakość informacji, wyeliminować duplikaty i tworzyć bogate, zestandaryzowane dane główne. Utrwalenie workflow typu surowe → reguła → oczyszczone skutecznie wspiera zarządzanie danymi głównymi, analizy i projekty ML.

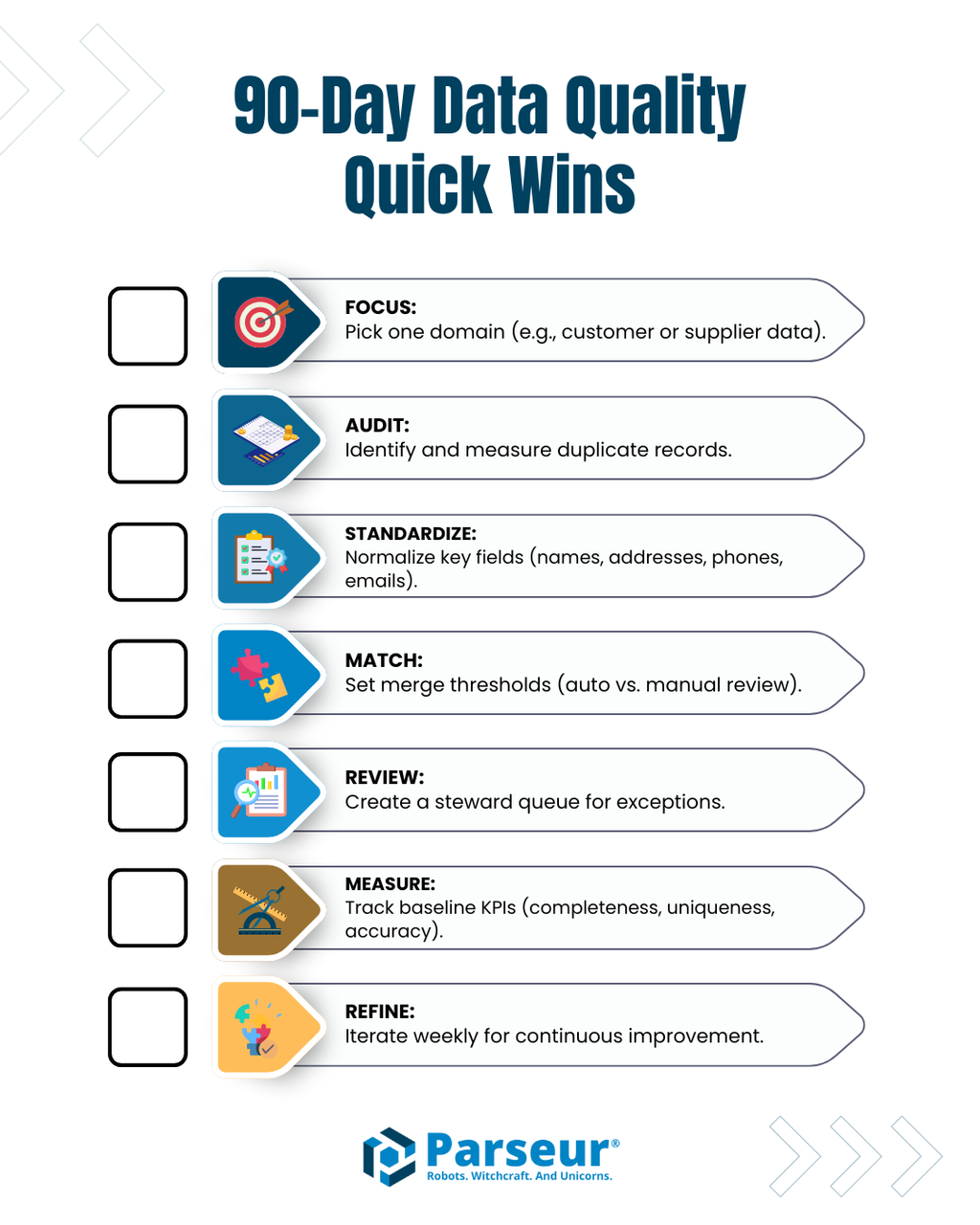

Lista kontrolna wdrożenia i rezultaty w 90 dni

Aby skutecznie wystartować z poprawą jakości danych głównych, skup się na kluczowych, mierzalnych działaniach możliwych do wdrożenia w ciągu 90 dni:

- Wybierz priorytetową domenę lub zbiór danych (np. klienci, dostawcy).

- Przeprowadź audyt duplikatów dla oceny ich skali i częstotliwości.

- Ujednolić formaty w typowych polach danych (imiona/nazwiska, adresy, telefony, e-maile).

- Określ progi dopasowania deterministycznego i rozmytego w celu automatycznej deduplikacji.

- Stwórz kolejkę stewardów do ręcznego rozstrzygania nietypowych przypadków.

- Zbierz dane bazowe KPI (kompletność, unikalność, zgodność, dokładność, aktualność) i rozpocznij monitoring na bieżąco.

- Regularnie aktualizuj reguły i workflow, ulepszając czyszczenie, dopasowywanie i wzbogacanie w odpowiedzi na wyniki.

Stosując tę listę kontrolną, szybko zauważysz wzrost jakości danych, ograniczysz liczbę pomyłek i zbudujesz solidny fundament pod zarządzanie danymi głównymi, analitykę oraz projekty ML.

Rola narzędzi do ekstrakcji danych

Narzędzia do automatycznej ekstrakcji danych, takie jak Parseur, odgrywają kluczową rolę w minimalizowaniu ręcznego wprowadzania informacji oraz przyspieszaniu workflow w zarządzaniu danymi głównymi. Pozwalają automatycznie wyciągać ustrukturyzowane dane z e-maili, dokumentów PDF, arkuszy czy skanów – stosując wstępną normalizację i automatycznie przekazując wyniki do dalszego przetwarzania w procesie MDM. Dzięki przejęciu żmudnych, powtarzalnych zadań narzędzia te pozwalają zespołom skupić się na walidacji, wzbogacaniu i rozwiązywaniu wyjątków.

Włączenie narzędzi ekstrakcyjnych w pierwszym etapie obiegu gwarantuje, że rekordy główne trafiają do systemów w spójnej, ustrukturyzowanej postaci, gotowej do dalszego czyszczenia, deduplikacji i enrichingu.

Jak utrzymać wysoką jakość danych permanentnie

Sukces zarządzania danymi głównymi oraz inicjatyw ML w firmie zależy od czystości, kompletności oraz spójności zbieranych informacji. Stosując sprawdzone techniki, takie jak czyszczenie i standaryzacja, dopasowywanie i deduplikacja oraz wzbogacanie i augmentacja, organizacje mogą ograniczyć błędy, usunąć duplikaty i konsekwentnie podnosić jakość swoich rekordów.

Łącząc automatyczne reguły z ręczną weryfikacją i wykorzystując narzędzia takie jak Parseur, możliwe jest zbudowanie optymalnych, wiarygodnych workflow. Przejrzysta lista kontrolna, monitoring KPI oraz workflow „surowe → reguła → oczyszczone” pozwalają utrzymywać najwyższy poziom jakości danych głównych, zwiększać efektywność operacyjną i w pełni wykorzystać potencjał systemów MDM oraz analityki.

Najczęściej zadawane pytania

Dane wysokiej jakości są kluczowe dla Zarządzania Danymi Głównymi (MDM) i uczenia maszynowego. Poniższe FAQ odpowiadają na najczęstsze pytania dotyczące jakości danych, czyszczenia, dopasowywania, wzbogacania oraz roli narzędzi ekstrakcyjnych, takich jak Parseur.

-

Czym jest czyszczenie danych w MDM?

-

Czyszczenie danych standaryzuje i poprawia surowe rekordy, normalizuje formaty, rozdziela pola i usuwa oczywiste błędy, tworząc spójne dane główne.

-

Na czym polega dopasowywanie i usuwanie duplikatów?

-

Dopasowywanie identyfikuje zduplikowane lub równoważne rekordy, wykorzystując metody deterministyczne (dokładne) lub rozmyte (na podstawie podobieństwa). Usuwanie duplikatów łączy je lub kieruje niejednoznaczne przypadki do ręcznej oceny przez człowieka.

-

Co to jest wzbogacanie danych?

-

Wzbogacanie polega na dodawaniu informacji zewnętrznych, metryk wyprowadzonych lub wartości wywnioskowanych, aby uzupełnić brakujące dane – czyniąc je pełniejszymi, użytecznymi i gotowymi do analityki.

-

Jak narzędzia automatyzujące, takie jak Parseur, wpisują się w MDM?

-

Narzędzia ekstrakcyjne, takie jak Parseur, ograniczają ręczne wprowadzanie danych, automatycznie wyodrębniając ustrukturyzowane pola z dokumentów, stosując wstępną normalizację i przekazując rekordy do pipeline’ów MDM.

-

Jakie KPI powinnam/powinienem śledzić dla jakości danych?

-

Kluczowe KPI to kompletność, unikalność, zgodność, dokładność i aktualność – pozwalają monitorować i utrzymać wysoką jakość danych głównych.

-

Czy te techniki mogą poprawić wyniki uczenia maszynowego?

-

Tak! Czyste, standaryzowane i wzbogacone dane zapewniają dokładniejsze modele, lepsze prognozy i wiarygodne wyniki analityczne.

Ostatnia aktualizacja