La calidad de los datos en la gestión de datos maestros (MDM) abarca los procesos y reglas necesarios—como la limpieza, el emparejamiento y el enriquecimiento—para transformar datos en bruto en registros maestros consistentes, precisos y listos para su uso en toda la organización.

La gestión de datos maestros requiere información consistente y de alta calidad para operar de forma eficiente. Ya sea para reportes, análisis o proyectos de aprendizaje automático, los datos iniciales suelen presentar duplicidades, errores e información faltante.

Puntos clave:

- La calidad de los datos es la base para implementar una gestión de datos maestros sólida, obtener análisis confiables y potenciar el aprendizaje automático.

- Limpiar, emparejar y enriquecer datos transforma de manera sistemática la información en bruto en registros fiables.

- Herramientas como Parseur simplifican la extracción, la estandarización y la integración, acelerando los procesos de MDM y reduciendo la intervención manual.

La fiabilidad en la gestión de datos maestros y en los resultados de machine learning comienza con conjuntos de datos consistentes y bien preparados; sin embargo, los datos sin tratar suelen contener errores tipográficos, duplicados e inconsistencias, lo que compromete la toma de decisiones, los informes y los análisis. Una gestión proactiva de la calidad de los datos no es solo una necesidad técnica, sino también estratégica: unos datos incompletos, duplicados o inconsistentes afectan a todos los departamentos, desde finanzas y operaciones hasta la experiencia del cliente y business intelligence.

De acuerdo con KeyMakr, la mala calidad de los datos cuesta a las empresas una media de 12,9 millones de dólares anuales en ineficiencias y errores. Además, solo en EE. UU., las empresas llegan a perder unos 3,1 billones de dólares por problemas de calidad de datos, equivalente al 20 % del valor total de negocio (180 OPS). Estas cifras demuestran el impacto financiero significativo y la urgencia de contar con buenas estrategias de gestión de datos maestros. Invertir en limpieza, emparejamiento y enriquecimiento contribuye a reducir pérdidas y consolidar una base de datos fiable para análisis, reporting y machine learning.

Por otro lado, Graphite note señala que solo entre el 10 y el 20 % de los conjuntos de datos usados en proyectos de IA cumplen los criterios de calidad necesarios para modelos fiables, y que hasta el 80 % del tiempo de proyecto se destina a preparar y limpiar datos antes de poder analizarlos de forma útil.

Cada sección contiene ejemplos sencillos de los flujos “en bruto → regla → limpio” para aplicar directamente en los datos de tu empresa, así como una lista de verificación práctica para ayudar a tu equipo a elevar la calidad de los datos y obtener mejores resultados de MDM y ML, con ejemplos de cómo herramientas como Parseur pueden automatizar el proceso de calidad.

Por qué la calidad de los datos es crucial en MDM y ML

La calidad de los datos es el cimiento para asegurar una gestión de datos maestros robusta y buenos resultados de aprendizaje automático. Una mala calidad puede provocar efectos en cadena que afectan sistemas, procesos y decisiones empresariales. Entre los impactos más importantes están:

- Precisión de los modelos: Registros inconsistentes o erróneos pueden distorsionar predicciones y análisis.

- Fiabilidad de los informes: Duplicidades o errores minan la confianza en los dashboards de business intelligence.

- Automatización robusta: Los flujos automatizados—como facturación o notificaciones—dependen de datos correctos para operar sin errores.

- Reducción de costes: Los errores por datos incorrectos, como clientes duplicados, generan problemas de facturación y mayores costes operativos.

Al invertir en la calidad de los datos, las empresas garantizan sistemas sostenibles, eficientes y confiables, además de minimizar riesgos y tareas manuales.

Técnicas esenciales para la calidad de los datos

Para lograr una gestión de datos maestros óptima, es fundamental aplicar tres técnicas principales, cada una dirigida a superar los desafíos típicos de los registros en bruto:

A continuación, una visión general de estos pilares, con enlaces a ejemplos y reglas prácticas:

- Limpieza y estandarización: Corrige errores, unifica formatos y homogeniza los datos para crear una base sólida.

- Emparejamiento y desduplicación: Detecta y fusiona registros equivalentes para mantener una sola fuente de referencia.

- Enriquecimiento y ampliación: Completa información faltante incorporando datos externos o métricas calculadas.

En conjunto, estas técnicas aseguran datos de alta calidad para iniciativas de gestión de datos maestros, análisis avanzados y machine learning.

Limpieza y estandarización

La limpieza y estandarización convierten los datos en entradas consistentes, legibles por máquinas y aptas para MDM o proyectos de ML. Estos son algunos aspectos clave:

- Normalización: Unificar mayúsculas/minúsculas, puntuación y abreviaciones.

- Parseo: Dividir datos complejos, como nombres completos o direcciones, en campos estructurados.

- Estandarización: Convertir fechas, números de teléfono y formatos en una estructura unificada.

Ejemplo 1 – Dirección:

- En bruto: ACME Ltd., 1st Ave, NYC

- Regla: Expandir abreviaturas y separar los componentes

- Limpio: ACME Ltd. | 1 First Avenue | New York, NY 10001

Ejemplo 2 – Teléfono:

- En bruto: +44 20 7946 0958

- Regla: Convertir a formato E.164 internacional

- Limpio: +442079460958

Al aplicar correctamente estas reglas, se disminuyen los errores y se preparan los datos para cualquier proceso avanzado de gestión de datos maestros o analítica.

Emparejamiento y desduplicación

El objetivo de emparejar y desduplicar es que el sistema de MDM conserve un solo registro fiable por entidad, evitando inconsistencias. Existen dos enfoques:

- Emparejamiento determinista: Utiliza coincidencias exactas en campos únicos (ID fiscal, correo, etc.). Es muy preciso, pero puede perder duplicados con mínimas diferencias.

- Emparejamiento difuso: Evalúa la similitud entre campos (ejemplo: nombres, direcciones) para unir registros que presentan ligeras variaciones, usando puntuaciones de confianza.

Ejemplo 1 – Determinista:

- En bruto: Mismo identificador fiscal 123-45-6789 en dos registros

- Regla: Coincidencia exacta → fusionar

- Limpio: Registro único consolidado

Ejemplo 2 – Difuso:

- En bruto: Jon Smith vs John S., mismo email, dirección similar

- Regla: Calcular puntuación de similitud → fusionar por encima de 0,9, revisar entre 0,7 y 0,9

- Limpio: Registro único tras revisión

Tabla de decisión para emparejamiento difuso:

| Puntuación Fuzzy | Acción |

|---|---|

| > 0.95 | Fusión automática |

| 0.80–0.95 | Revisión manual |

| < 0.80 | Sin coincidencia |

Con la combinación de ambos enfoques y una validación manual cuando es necesario, se logra un conjunto maestro de datos fiable y coherente, listo para procesos críticos, análisis y automatización.

Enriquecimiento y ampliación

Enriquecer los datos implica incorporar información adicional, derivar nuevos campos y aplicar reglas de negocio para crear registros más completos y valiosos. Algunas prácticas habituales son:

- Añadir fuentes externas: Geocodificación, información demográfica o datos firmográficos.

- Campos calculados: Ejemplo, calcular el valor estimado de vida del cliente o una puntuación de riesgo.

- Reglas de inferencia: Deducir la ubicación por el prefijo telefónico, entre otros.

Ejemplo – Enriquecimiento de dirección:

- En bruto: 123 Main Street, Springfield

- Regla: Añadir coordenadas y región estandarizada

- Enriquecido: 123 Main Street | Springfield | IL | 62701 | Latitud: 39.7817 | Longitud: -89.6501

Este proceso asegura que los registros MDM sean más completos, útiles y estén listos para análisis o automatizaciones.

Automatización y patrones de flujo de trabajo

Una gestión eficaz de la calidad de datos combina automatización y supervisión manual para conservar registros confiables a gran escala. Los enfoques más comunes incluyen:

- Procesos de limpieza por lotes: Normalización, estandarización y desduplicación programadas periódicamente para mantener la uniformidad.

- Validación en tiempo real: Comprobaciones automáticas de nuevos registros para filtrar errores antes de integrarlos al sistema.

- Colas de revisión: Los casos dudosos se remiten a revisión humana especializada para garantizar la precisión.

Las tareas repetitivas se automatizan, reservando la revisión humana para situaciones complejas o de alto impacto. De este modo, se logra una gestión de datos maestros eficiente, reduciendo errores y costes, y asegurando datos confiables para el negocio.

Métricas y monitoreo (KPIs de calidad de datos)

Para vigilar la calidad de datos en la gestión de datos maestros, se debe medir:

- Completitud: Proporción de campos clave completos; objetivo: superar el 95 % en atributos críticos.

- Unicidad: Índice de duplicados por cada 10.000 registros; cuanto menor, mejor.

- Conformidad: Registros que cumplen los formatos estándar; gestionado con validaciones automáticas.

- Exactitud: Verificado a través de auditorías y contraste con fuentes fiables.

- Actualidad: Si los registros reflejan las actualizaciones recientes y las obsolescencias se detectan.

Se recomienda monitorizar gráficos de completitud, mapas de calor de duplicados, alertas de validación y resultados de auditoría para mantener controlados estos KPIs y obtener datos maestros robustos.

Ejemplos prácticos Antes/Después

Estos tres ejemplos muestran cómo la aplicación de reglas puede transformar datos en bruto en registros listos para la gestión de datos maestros:

- En bruto: jon.smith@acme → Regla: validar dominio y convertir a minúsculas → Limpio: [email protected]

- En bruto: ACME Inc., 12-34 Baker St., LDN → Regla: expandir y geocodificar → Limpio: ACME Inc. | 12-34 Baker Street | London, UK | 51.5074,-0.1278

- En bruto: CUST#123 / John S. → Regla: separar ID y nombre, normalizar nombre → Limpio: {customer_id: 123, name: "John Smith"}

Siguiendo estos flujos de en bruto → regla → limpio, los equipos pueden sistematizar la gestión de datos maestros y asegurar datos listos para analítica y aprendizaje automático.

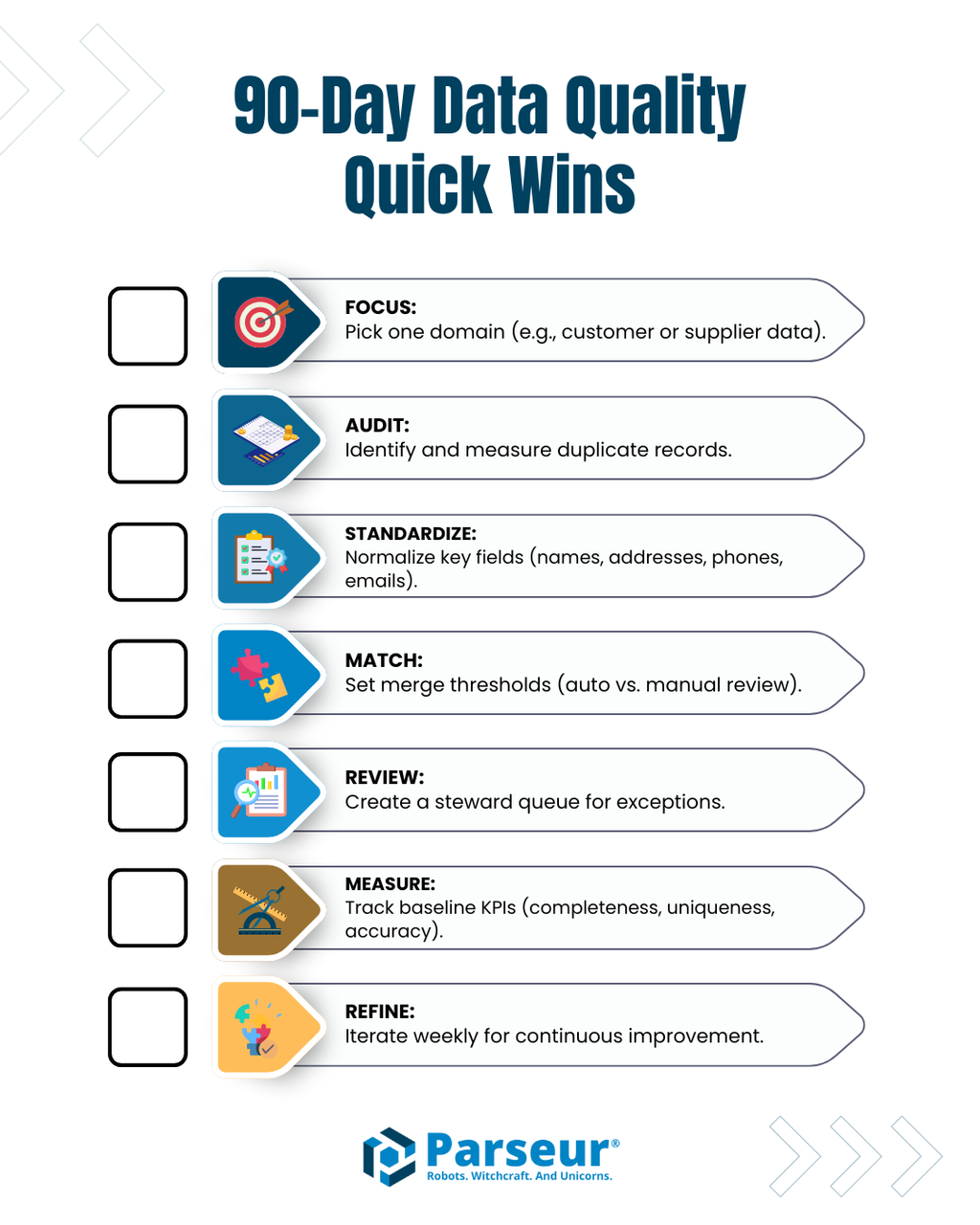

Lista de verificación para una rápida mejora en 90 días

Para impulsar la calidad de tus datos maestros en los primeros 90 días, focaliza en:

- Elige un dominio clave (clientes, proveedores, etc.).

- Audita duplicados y cuantifica su impacto real.

- Normaliza formatos en campos críticos: nombres, direcciones, teléfonos, emails.

- Fija umbrales de coincidencia para la fusión automática de duplicados de alta confianza.

- Implementa una revisión manual para casos ambiguos.

- Establece una línea base de KPIs para medir progreso.

- Refina semanalmente las reglas de normalización, emparejamiento y enriquecimiento siguiendo los resultados obtenidos.

Aplicando esta lista de verificación, prepararás el terreno para una gestión de datos maestros y una analítica fiables y escalables.

El papel de las herramientas de extracción de datos

Herramientas de extracción de datos y documentos como Parseur son clave en la automatización y aceleración de la gestión de datos maestros. Permiten extraer datos estructurados de emails, PDFs, hojas de cálculo o documentos escaneados, aplicar reglas iniciales de limpieza y alimentar tus sistemas MDM con información lista para uso inmediato. Así, los equipos pueden centrarse en las tareas de mayor valor: la validación, el enriquecimiento y el análisis de excepciones.

Iniciar el flujo de trabajo con una extracción estructurada asegura que los datos lleguen a tu sistema de gestión de datos maestros en el formato adecuado para los siguientes pasos: limpieza, emparejamiento y enriquecimiento.

Cómo mantener una calidad de datos sostenible

El éxito en la gestión de datos maestros y en la analítica avanzada depende de la calidad de la información: limpieza, completitud y consistencia son esenciales. Aplicando técnicas de limpieza, emparejamiento y enriquecimiento, combinando reglas automáticas, revisión humana y herramientas de extracción como Parseur, las organizaciones pueden crear flujos de trabajo fiables y eficientes.

Usando listas de verificación, monitorizando KPIs y adoptando el enfoque “en bruto → regla → limpio”, tu equipo logrará mantener una alta calidad de datos, agilizar operaciones y explotar todo el potencial de la gestión de datos maestros y la analítica avanzada.

Preguntas Frecuentes

Los datos de alta calidad son críticos para la Gestión de Datos Maestros (MDM) y el aprendizaje automático. Las siguientes preguntas frecuentes responden dudas comunes sobre la calidad de los datos, limpieza, emparejamiento, enriquecimiento y el papel de herramientas de extracción, como Parseur.

-

¿Qué es la limpieza de datos en MDM?

-

La limpieza de datos estandariza y corrige registros en bruto, normaliza formatos, divide campos y elimina errores obvios para crear registros maestros consistentes.

-

¿Cómo funciona el emparejamiento y la desduplicación?

-

El emparejamiento identifica registros duplicados o equivalentes utilizando métodos deterministas (exactos) o difusos (basados en similitud). La desduplicación fusiona duplicados o enruta coincidencias ambiguas a revisión humana para una evaluación adicional.

-

¿Qué es el enriquecimiento de datos?

-

El enriquecimiento agrega información externa, métricas derivadas o valores inferidos para llenar vacíos en los registros, haciendo que los datos sean más completos, útiles y listos para análisis.

-

¿Cómo encajan herramientas de automatización como Parseur en MDM?

-

Herramientas de extracción como Parseur reducen la entrada manual capturando automáticamente campos estructurados de documentos, aplicando una normalización inicial y alimentando los registros a las canalizaciones de MDM.

-

¿Qué KPIs debo rastrear para la calidad de datos?

-

Los KPIs clave incluyen completitud, unicidad, conformidad, exactitud y actualidad, que se utilizan para monitorear y mantener datos maestros de alta calidad.

-

¿Pueden estas técnicas mejorar los resultados del aprendizaje automático?

-

¡Sí! Datos limpios, estandarizados y enriquecidos garantizan modelos más precisos, mejores predicciones y resultados analíticos confiables.

Última actualización el