La qualité des données dans la gestion des données de référence (MDM) regroupe l’ensemble des processus et des règles (nettoyage, appariement, enrichissement) appliqués afin de transformer les données brutes en enregistrements maîtres fiables, cohérents et utilisables à l’échelle de l’organisation.

La gestion des données de référence dépend fortement de la qualité et de la cohérence des données pour garantir son efficacité. Que vos données alimentent le reporting, l’analytique ou le machine learning, elles sont souvent entachées d’incohérences, de doublons et de valeurs manquantes.

Points clés à retenir :

- Des données de haute qualité sont la base d'une gestion fiable des données de référence, d'analyses justes et d’un apprentissage automatique pertinent.

- Les workflows de nettoyage, d’appariement et d’enrichissement convertissent les données brutes en enregistrements de référence fiables et cohérents.

- Des outils comme Parseur automatisent l’extraction, la normalisation et l’intégration des données, accélérant les pipelines MDM tout en limitant la charge manuelle.

Disposer d’une gestion fiable des données de référence et de modèles de machine learning fiables débute par des données de qualité — or, la plupart des ensembles bruts présentent des erreurs, des incohérences, des doublons ou des champs manquants qui mettent à mal analyses, reporting et décisions métier. La qualité des données dépasse désormais le cadre technique : elle est stratégique. Lorsque l’entreprise s’appuie sur des données disparates, incomplètes ou dupliquées, toutes les fonctions sont impactées, de la finance à la relation client en passant par la BI.

Selon KeyMakr, la mauvaise qualité des données coûte en moyenne 12,9 millions de dollars par an aux entreprises en inefficacités et erreurs, soulignant l’enjeu économique considérable d’une gestion inadéquate des données. De plus, aux États-Unis, les pertes liées à une faible qualité des données atteignent environ 3 100 milliards de dollars par an, soit environ 20 % de la valeur totale de l’activité, d’après 180 OPS, preuve que ces problématiques touchent l’ensemble des organisations quelle que soit leur taille. Ces chiffres illustrent l’importance d’une gestion proactive de la qualité des données et de stratégies structurées de gestion des données de référence : y investir réduit le risque financier tout en posant les fondations de la confiance pour l’analytique et les projets d’IA.

D’ailleurs, Graphite note indique que seulement 10 à 20 % des ensembles de données IA atteignent le niveau de qualité requis pour des algorithmes performants, alors que jusqu’à 80 % du temps total d’un projet IA est consommé par le nettoyage et la préparation des données.

Chaque section ci-après fournit des workflows concrets “brut → règle → nettoyé”, des exemples pratiques et une checklist d’action pour structurer l’amélioration de la qualité, fiabiliser vos projets de gestion des données de référence et de machine learning, et découvrir comment les outils comme Parseur automatisent ces étapes clés.

Pourquoi la qualité des données est essentielle à la MDM et au Machine Learning

Des données de qualité sont fondamentales pour une gestion efficace des données de référence et des projets de machine learning performants. Une mauvaise qualité des données se répercute partout :

- Précision des modèles : Données incohérentes ou incorrectes induisent mal les modèles ML, faussant prédictions et analyses.

- Fiabilité du reporting : Doublons ou erreurs sapent la confiance dans vos rapports et tableaux de bord.

- Automatisation fiable : Les workflows automatisés, comme la gestion des factures ou des notifications, exigent des données propres pour tourner sans erreur.

- Réduction des coûts opérationnels : Des erreurs liées à la mauvaise qualité des données (ex : clients en double) génèrent de lourdes corrections manuelles.

Investir dans la qualité des données, c’est protéger la fiabilité de vos systèmes, optimiser vos rapports et modèles, réduire le risque et minimiser la perte d’effort.

Techniques clés pour garantir la qualité des données

La gestion de la qualité des données de référence mobilise trois techniques principales afin de passer de données brutes à des enregistrements fiables :

Un panorama de ces trois piliers :

- Nettoyage & Standardisation : Corriger les erreurs, unifier les formats et harmoniser les saisies pour créer une fondation commune.

- Appariement & Déduplication : Identifier puis fusionner les doublons ou équivalents pour garantir une “single source of truth”.

- Enrichissement & Augmentation : Compléter les données manquantes et ajouter des valeurs issues de sources externes pour maximiser l’exhaustivité.

Ce triptyque constitue la colonne vertébrale d’un workflow robuste de qualité pour vos projets de gestion des données de référence, d’analytique ou de machine learning.

Nettoyage & Standardisation

Nettoyer et standardiser, c’est garantir des entrées homogènes, lisibles par machine et prêtes pour une gestion des données de référence efficace. Typiquement :

- Normalisation : Harmoniser casse, ponctuation, abréviations.

- Parsing : Séparer les champs composés (par ex. : nom + prénom, ou adresse) en éléments individuels structurés.

- Standardisation : Uniformiser les formats (dates, téléphones, codes postaux…) sur des modèles choisis.

Exemple 1 – Adresse :

- Brut : ACME Ltd., 1st Ave, NYC

- Règle : Développer les abréviations & découper chaque composant

- Nettoyé : ACME Ltd. | 1 First Avenue | New York, NY 10001

Exemple 2 – Numéro de téléphone :

- Brut : +44 20 7946 0958

- Règle : Standardiser au format E.164

- Nettoyé : +442079460958

Une application systématique de ces règles limite les erreurs, facilite la recherche/l’appariement, et construit des bases fiables pour vos projets de gestion de données de référence, analyses et automatisations.

Appariement & Déduplication

L’appariement et la déduplication garantissent l’existence d’un seul enregistrement maître par entité dans votre MDM, évitant ainsi incohérences et erreurs. Deux grandes méthodes :

- Appariement déterministe : Recherche de correspondance exacte sur des champs uniques (ex : numéro fiscal, email, numéro de compte). Méthode fiable, mais ne retient que les doublons parfaits.

- Appariement flou (fuzzy matching) : Identification des quasi-doublons en score de similarité entre noms, adresses, et fusion selon des seuils configurés.

Exemple 1 – Déterministe :

- Brut : Deux fiches portent le même numéro fiscal 123-45-6789

- Règle : Fusion directe sur correspondance parfaite

- Nettoyé : Un seul enregistrement consolidé

Exemple 2 – Flou :

- Brut : Jon Smith vs John S., email identique et adresse similaire

- Règle : Calcul du score de similarité fuzzy (> 0,9 fusion automatique, entre 0,7–0,9 relecture humaine)

- Nettoyé : Un enregistrement après validation

Table décisionnelle pour l’appariement flou :

| Score fuzzy | Action |

|---|---|

| > 0,95 | Fusion automatique |

| 0,80–0,95 | Revue manuelle |

| < 0,80 | Pas de correspondance |

En combinant ces méthodes avec de la validation humaine sur les scores ambigus, vous limitez les doublons sans risque d’erreur, pour un référentiel de données fiable et exploitable pour l’analytique, les rapports et tous les processus automatisés.

Enrichissement & Augmentation

L’enrichissement consiste à ajouter des données externes, générer de nouveaux champs, ou appliquer des règles métier pour compléter vos enregistrements. Trois leviers fréquents :

- Ajout de données tierces (géolocalisation, firmographie, démographie…)

- Champs calculés (ex : segment client, scoring de risque)

- Enrichissement via règles métier (ex : inférer le pays à partir du numéro de téléphone)

Exemple – Enrichissement d’adresse :

- Brut : 123 Main Street, Springfield

- Règle : Ajouter latitude/longitude et code région officiel

- Enrichi : 123 Main Street | Springfield | IL | 62701 | Latitude: 39.7817 | Longitude: -89.6501

L’enrichissement transforme vos enregistrements de référence en données plus qualitatives, fiables, et directement prêtes pour toutes les exigences analytiques et décisionnelles.

Automatisation & organisation des workflows

Gagner en efficacité dans la gestion de la qualité des données implique de mixer automatisation intelligente et contrôle humain pour systématiser la cohérence sur de gros volumes. Exemples de workflows :

- Nettoyage par lot : Traitement planifié (jour/semaine) pour normalisation, standardisation et fusion des doublons, garantissant l’alignement entre systèmes.

- Validation en continu / temps réel : Blocage automatisé des saisies erronées dès l’entrée, avant injection en base.

- Queues de relecture manuelle : Transfert des cas ambigus ou litigieux à un référent donnée pour validation manuelle.

Les règles automatiques (normalisation, fuzzy matching, enrichissement…) absorbent les tâches répétitives ; la supervision intervient seulement sur les dossiers à risque, combinant efficacité, maîtrise des coûts et qualité continue des référentiels.

Métriques & KPIs pour la qualité des données

Garantir la réussite de votre gestion des données de référence repose sur le suivi de métriques factuelles. Les KPIs essentiels à intégrer :

- Complétude : Pourcentage de champs obligatoires renseignés (> 95% à viser sur attributs sensibles)

- Unicité : Nombre de doublons pour 10 000 enregistrements

- Conformité : Respect des règles de format (date, téléphone…), piloté par des alertes automatisées

- Précision : Vérification ponctuelle par échantillonnage/par recoupement source officielle

- Fraîcheur : Pourcentage de fiches mises à jour récemment

Tableau de bord idéal : graphiques de complétude, heatmaps de doublons, taux de conformité par champ, résultats de sampling de précision, suivi de l’âge moyen des données.

S’appuyer sur ces KPIs vous permet d’agir sur les vrais leviers, prioriser vos correctifs et garantir la fiabilité long terme de vos données pour tous vos usages.

Exemples concrets avant/après

Trois mini-cas illustrant la transformation de données brutes vers une meilleure qualité via des règles automatisables :

- Brut : jon.smith@acme → Règle : vérifier le domaine + uniformiser la casse → Nettoyé : [email protected]

- Brut : ACME Inc., 12-34 Baker St., LDN → Règle : développer les abréviations + géocoder → Nettoyé : ACME Inc. | 12-34 Baker Street | London, UK | 51.5074,-0.1278

- Brut : CUST#123 / John S. → Règle : séparer l'id et normaliser le nom → Nettoyé : {customer_id: 123, name: "John Smith"}

Ce type de séquence brut → règle → nettoyé facilite l'automatisation et accélère la montée en qualité pour préparer toutes vos données de référence à l’analytique, la BI ou le ML.

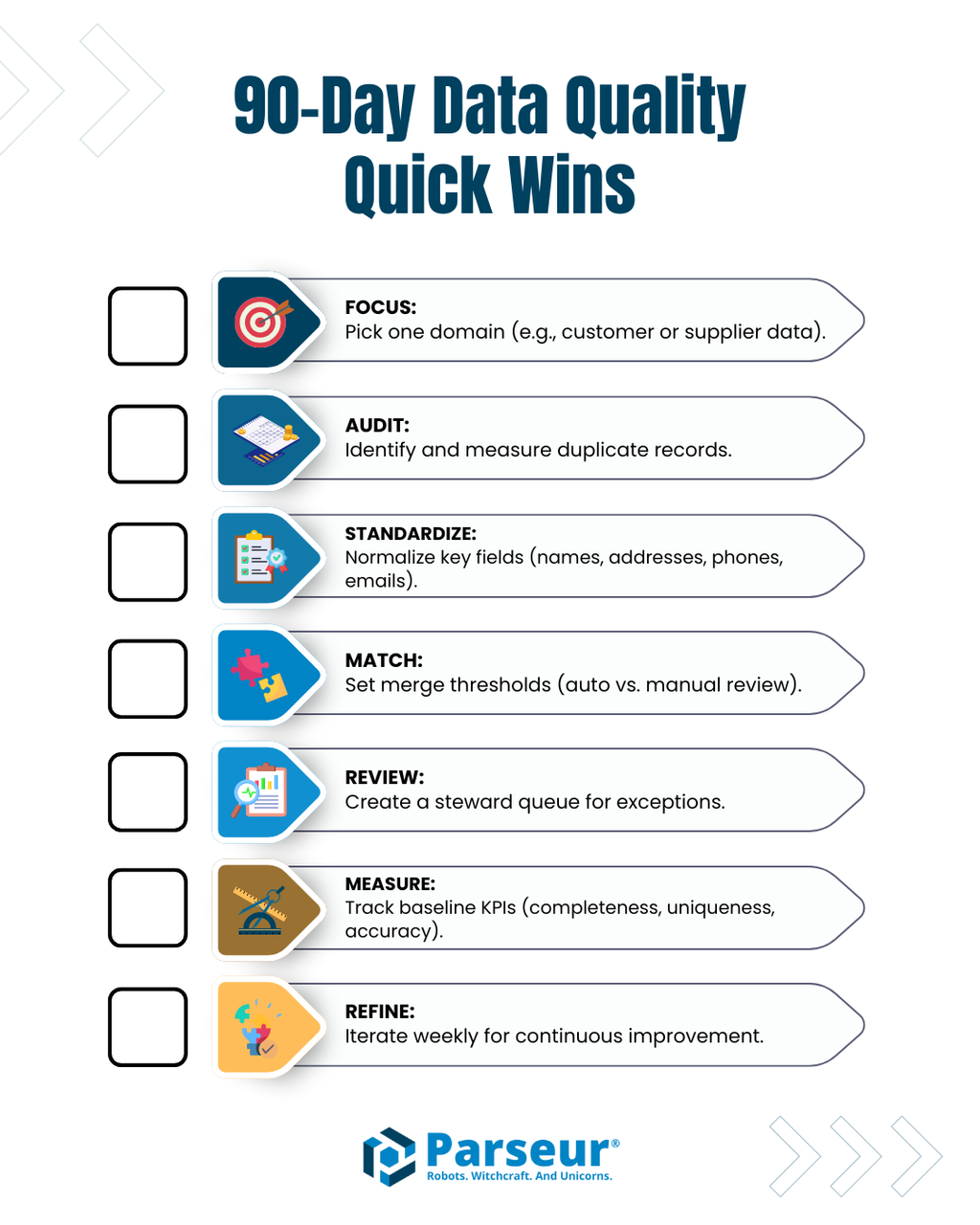

Checklist d'activation rapide (90 jours)

Pour enclencher ou structurer une démarche gestion des données de référence :

- Ciblez une priorité métier ou un jeu de données clé (clients, fournisseurs…)

- Auditez la redondance pour recenser vos doublons principaux

- Uniformisez les formats des champs stratégiques (nom, adresse, tel, mail…)

- Définissez des seuils d’appariement clair (fusion automatique si score élevé, relecture sur cas douteux)

- Mettez une file de relecture humaine sur les correspondances incertaines

- Mesurez un baseline précisé de vos KPIs (complétude, unicité, conformité, précision, fraîcheur)

- Itérez hebdomadairement les règles : ajustez normalisation, matching, enrichissement selon vos premiers résultats

Le suivi de cette checklist assure un impact rapide, mesurable et pérenne sur la qualité de vos données de référence tout en créant la base pour automatisation, analytique fiable et projets ML.

Le rôle des outils d’extraction documentaire

Les solutions d’extraction automatique comme Parseur jouent un rôle central pour diminuer la saisie manuelle et fiabiliser la gestion des données de référence à grande échelle. Ils extraient les champs structurés de emails, PDF, fichiers bureautiques ou documents scannés, appliquent une première normalisation et transfèrent les données nettoyées vers les pipelines MDM. Grâce à ces flux automatisés, vos équipes peuvent concentrer leurs efforts sur la validation, l'enrichissement et la gestion des exceptions.

Adopter l'extraction documentaire structurée dès l’entrée assure que tous les enregistrements de référence sont intégrés dans un format prêt à l’usage : fini les imports manuels et les erreurs de base.

Assurer la qualité des données de référence dans la durée

La réussite des projets de gestion des données de référence et de machine learning passe par des données propres, structurées et cohérentes. L’application systématique des bonnes pratiques — nettoyage & standardisation, appariement & déduplication, enrichissement & augmentation — permet de limiter erreurs, doublons et incomplétudes.

La combinaison d’automatisation, de validation humaine et d’outils d’extraction comme Parseur garantit la fiabilité, la robustesse et la scalabilité de vos workflows. Suivre une checklist rigoureuse, contrôler régulièrement les KPIs et encourager la culture “brut → règle → nettoyé” donne à vos équipes les moyens de renforcer la qualité, gagner en efficacité, et révéler tout le potentiel de la gestion des données de référence.

Foire aux questions

Des données de haute qualité sont essentielles pour la gestion des données de référence (MDM) et l'apprentissage automatique. Les FAQ suivantes répondent aux questions courantes concernant la qualité des données, le nettoyage, l'appariement, l'enrichissement et le rôle des outils d'extraction tels que Parseur.

-

Qu'est-ce que le nettoyage des données en MDM ?

-

Le nettoyage des données standardise et corrige les enregistrements bruts, normalise les formats, parse les champs et supprime les erreurs évidentes afin de créer des enregistrements de référence cohérents.

-

Comment fonctionnent l'appariement et la déduplication ?

-

L'appariement identifie les enregistrements dupliqués ou équivalents à l'aide de méthodes déterministes (exactes) ou floues (basées sur la similarité). La déduplication fusionne les doublons ou transmet les correspondances ambiguës à une révision manuelle pour évaluation supplémentaire.

-

Qu'est-ce que l'enrichissement des données ?

-

L'enrichissement ajoute des informations externes, des métriques dérivées ou des valeurs inférées pour combler les lacunes des enregistrements, rendant les données plus complètes, exploitables et prêtes pour l'analyse.

-

Comment les outils d'automatisation comme Parseur s’intègrent-ils dans la MDM ?

-

Les outils d'extraction comme Parseur réduisent la saisie manuelle en capturant automatiquement des champs structurés depuis des documents, en appliquant une normalisation initiale et en alimentant les enregistrements dans les pipelines MDM.

-

Quels KPIs dois-je suivre pour la qualité des données ?

-

Les KPIs clés incluent la complétude, l'unicité, la conformité, la précision et la fraîcheur, utilisés pour surveiller et maintenir une haute qualité des données de référence.

-

Ces techniques peuvent-elles améliorer les résultats en machine learning ?

-

Oui ! Des données nettoyées, standardisées et enrichies garantissent des modèles plus précis, de meilleures prédictions et des analyses fiables.

Dernière mise à jour le