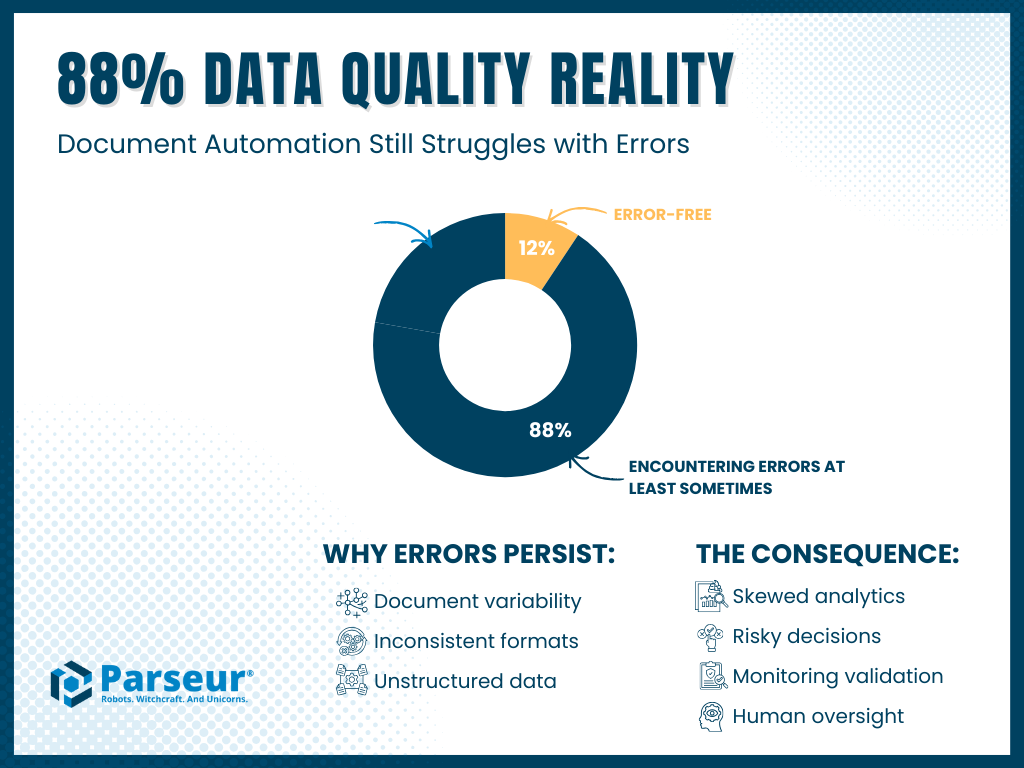

Une enquête commanditée par Parseur menée auprès de 500 professionnels américains évoluant dans des environnements à forte gestion documentaire révèle un paradoxe majeur : 88 % des décideurs expriment une grande confiance dans l’exactitude des données utilisées pour l’analyse et l’IA, alors que ces mêmes 88 % reconnaissent également relever des erreurs dans les données extraites des documents, ne serait-ce qu’occasionnellement. Ce phénomène, qualifié « d’illusion de confiance », signale que les risques liés à la qualité des données sont omniprésents et affectent durablement les analyses, prévisions et résultats fournis par l’IA.

Points clés à retenir :

- Confiance vs réalité : 88 % déclarent avoir confiance dans leurs données, mais 88 % affirment aussi repérer des erreurs dans les données extraites des documents, au moins de temps en temps.

- Fréquence : Près de 69 % observent des erreurs parfois, souvent ou très souvent.

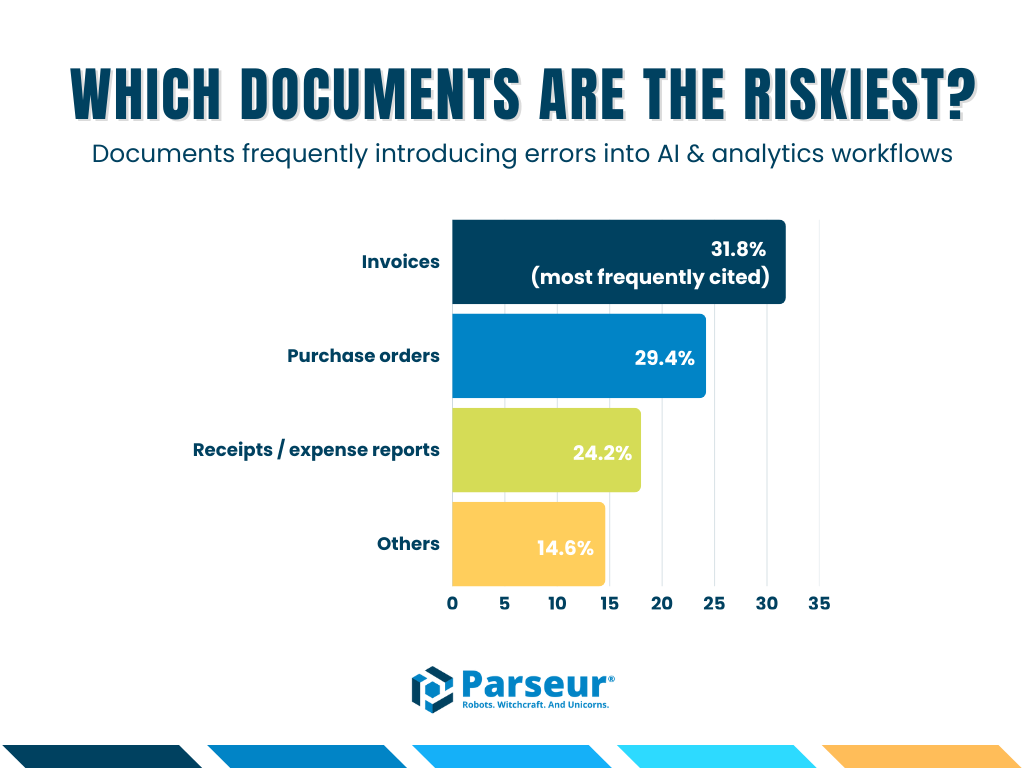

- Documents les plus concernés par les erreurs (cités en premier) : Factures (31,8 %), bons de commande (29,4 %), reçus/notes de frais (24,2 %).

- Champ de l’enquête : 500 répondants américains issus de l’exploitation, de la finance, de l’IT, du support client et fonctions associées (surtout managers, directeurs et C-level).

Au-delà des chiffres : le paradoxe des données pour l’IA

Alors que les entreprises accélèrent l’adoption de l’IA en 2026, la question n’est plus « faut-il utiliser l’IA ? », mais « dans quelle mesure peut-on s’y fier ? ». Les organisations développent des modèles de langage de grande ampleur (LLM), mettent en place des architectures RAG (Retrieval-Augmented Generation) et automatisent des flux analytiques en s’appuyant sur les documents internes comme source de données principale.

Derrière cet engouement se cache une tension fondamentale.

Selon une nouvelle étude menée par Parseur auprès de 500 professionnels américains, la confiance affichée vis-à-vis des données documentaires coexiste avec la détection régulière d’anomalies.

C’est ce décalage que nous nommons l’écart de confiance dans les données extraites de documents : une divergence croissante entre la confiance perçue et la réalité effective de la qualité des données terrain.

Le constat clé ? Un impressionnant 88 % des sondés font état d’erreurs dans les données issues de documents, données qui alimente pourtant leurs systèmes d’IA et d’automatisation.

Dans cet article, nous analysons les enseignements issus de l’enquête 2026, détaillons les facteurs à l’origine de cet écart de confiance dans les données, présentons ses impacts concrets pour les entreprises, et explorons comment certaines organisations de pointe parviennent à refermer la brèche pour asseoir leurs solutions d’IA sur des bases fiables.

Pourquoi cet enjeu est critique : impacts métier et ampleur

Les données erronées ne sont pas de simples désagréments opérationnels : elles occasionnent des conséquences financières, opérationnelles et stratégiques majeures. Une erreur apparemment mineure sur un document traité en masse peut se propager dans l’ensemble du système, générer des rapports inexacts, fausser les prévisions et induire des décisions inappropriées.

Au-delà des impacts financiers, ces erreurs créent des blocages dans les opérations : ralentissements de la supply chain, risques réglementaires, insatisfaction client et volumes accrus de retraitement, tous liés à la saisie erronée de données issues des documents.

L’enquête Parseur de 2026 met en exergue l’ampleur de ces défis. Tous secteurs confondus, les professionnels désignent les factures (31,8 %), les bons de commande (29,4 %) et les reçus/notes de frais (24,2 %) comme les documents générant le plus d’erreurs lors de l’extraction de données. Ces anomalies s’infiltrent ensuite dans les tableaux de bord, les modèles d’IA et les processus métiers, pesant sur les coûts et l’efficacité globale.

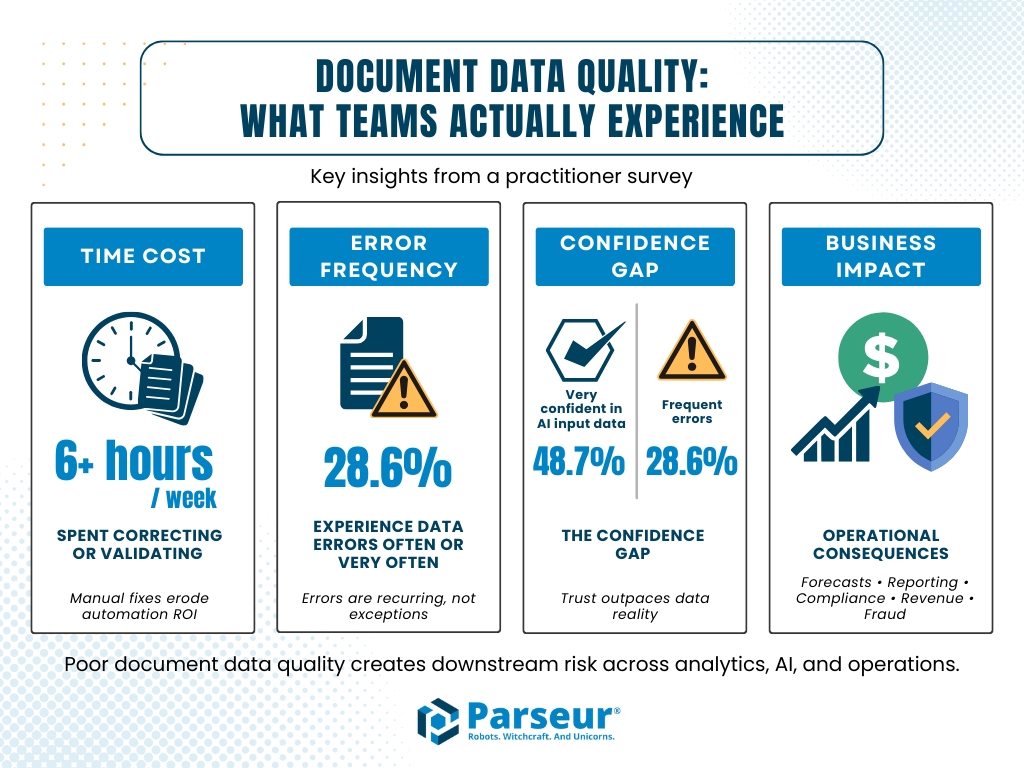

Données marquantes issues de l’enquête :

- Plus de 6 heures par semaine : De nombreuses équipes consacrent chaque semaine plus de six heures à corriger ou valider les données extraites des documents, ce qui réduit considérablement le ROI de l’automatisation.

- 28,6 % des sondés constatent souvent ou très souvent des erreurs, preuve que ce phénomène est largement répandu et non exceptionnel.

- 48,7 % des professionnels se disent « très confiants » dans la fiabilité des données utilisées pour l’IA malgré la fréquence des erreurs, signe d’un écart de confiance significatif.

- Les impacts évoqués incluent : prévisions erronées, erreurs de reporting financier, litiges avec clients ou fournisseurs, non-conformité, perte de revenus et risque accru de fraude.

Chaque document non vérifié devient une source potentielle d’incohérence et de risques systémiques. En prenant conscience de la portée des mauvaises données documentaires, les entreprises doivent miser sur l’exactitude dès la collecte, intégrer des processus de vérification et mettre en place des workflows human-in-the-loop qui sécurisent l’intégrité des résultats de l’IA ainsi que la performance métier.

Pourquoi Parseur a mené cette enquête ?

Au quotidien, Parseur accompagne les équipes cherchant à automatiser le traitement documentaire dans la finance, l’exploitation, l’IT et le support client. Si l’extraction assistée par IA progresse, la confiance s’effrite dès que des erreurs apparaissent dans les tableaux de bord analytiques, rapports d’IA, prévisions ou contrôles de conformité.

Notre enquête visait à quantifier cette problématique, cerner l’origine des erreurs et mettre en lumière la réponse des organisations. L’objectif : offrir aux responsables métiers de nouvelles pistes sur un risque devenu critique dans l’ère de l’IA pilotant les opérations : la piètre qualité des données issues des documents.

L’apprentissage clé des 88 % : l’erreur n’est plus l’exception, c’est la règle

Pour mesurer l’écart de confiance, nous avons posé aux sondés la question suivante :

« Dans vos workflows où il s’agit d’extraire, vérifier ou valider des données de documents, constatez-vous des erreurs ? »

Le verdict est sans appel.

- 88 % des répondants déclarent repérer des erreurs, au moins de temps à autre

- Seuls 12 % affirment disposer d’un pipeline documentaire totalement sans erreur

Ces chiffres prouvent que malgré le recours massif à l’OCR, aux parseurs IA et à d’autres outils d’automatisation, la diversité documentaire continue de grever la précision des données. Variations de formats, de structures, présence de manuscrits, terminologies disparates et champs libres constituent autant de facteurs de fragilité. Une simple erreur – mauvais montant lu, numéro de commande erroné, mauvaise étiquette client – peut dès lors se diffuser et affecter modèles IA, indicateurs ou prises de décision.

Cela souligne que l’automatisation ne suffit pas à elle seule. Sans validation ni supervision humaine, les pipelines IA multiplient les risques d’erreur au lieu de les résoudre. Notre enquête rappelle l’importance d’anticiper et corriger ces anomalies pour préserver la stratégie et l’efficacité opérationnelle.

Quels sont les documents présentant le plus de risques ?

Certains types de documents sont plus propices aux erreurs. L’enquête 2026 a demandé aux professionnels de désigner les catégories de documents qui injectent le plus d’anomalies dans les flux IA et analytiques.

Trois catégories se démarquent :

- Factures : 31,8 % (le document le plus souvent cité)

- Bons de commande : 29,4 %

- Reçus/notes de frais : 24,2 %

Ces documents ont en commun :

- Un volume massif : Certaines entreprises traitent des milliers à des millions de factures, bons de commande et reçus chaque année. Même un taux d’erreur faible s’y traduit par des centaines d’incidents concrets.

- Structures complexes : Mélange d’informations structurées (dates, montants, lignes) et de zones libres, pièces jointes ou notes. Cette hétérogénéité complique l’extraction et l’alignement automatique.

- Enjeux métiers cruciaux : Ils influent directement sur les rapports financiers, la reconnaissance de revenu, la chaîne logistique ou la relation client. La moindre erreur met en péril la conformité et engendre litiges ou surcoûts.

En somme, ces documents représentent des « zones critiques » pour les workflows portés par l’IA. Laisser perdurer les anomalies, c’est courir le risque de déséquilibrer toute la chaîne : des analyses jusqu’aux prises de décisions automatisées, en passant par les finances et l’opérationnel.

Effets opérationnels rapportés (qualitatif)

Les sondés relient les erreurs de données aux conséquences suivantes : prévisions faussées, anomalies de reporting financier, litiges contractuels, manquements de conformité, ralentissements d’exploitation, perte de revenus et augmentation du risque de fraude. La plupart jugent ces impacts modérés à sévères.

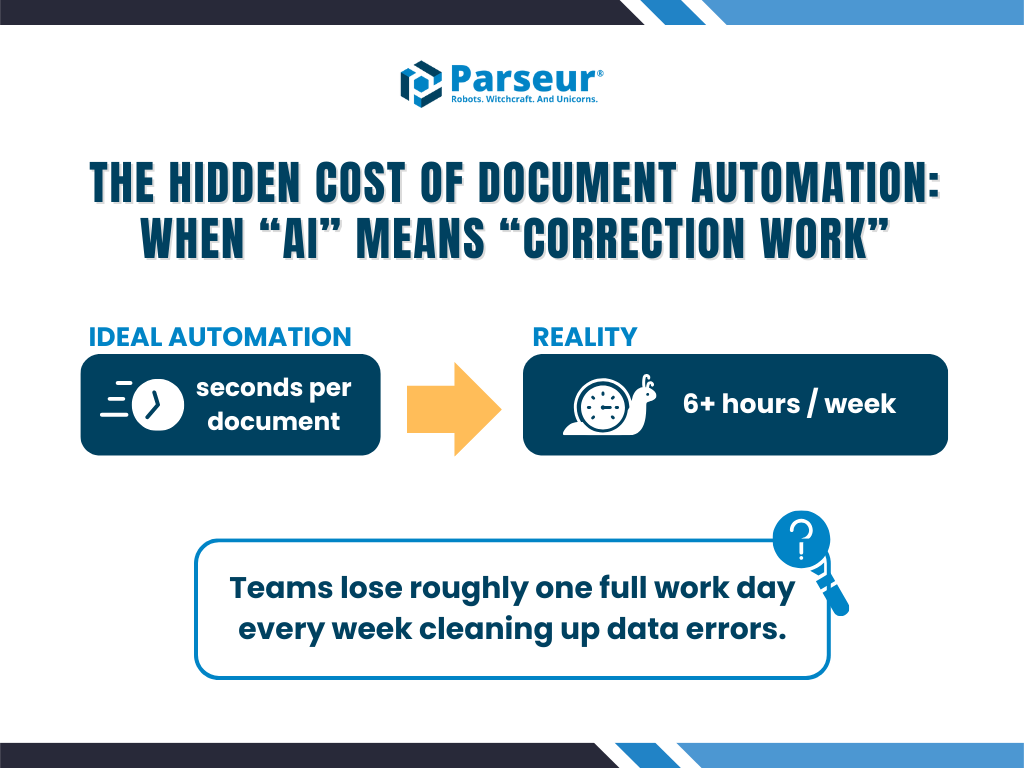

Le coût caché : heures perdues à corriger les erreurs

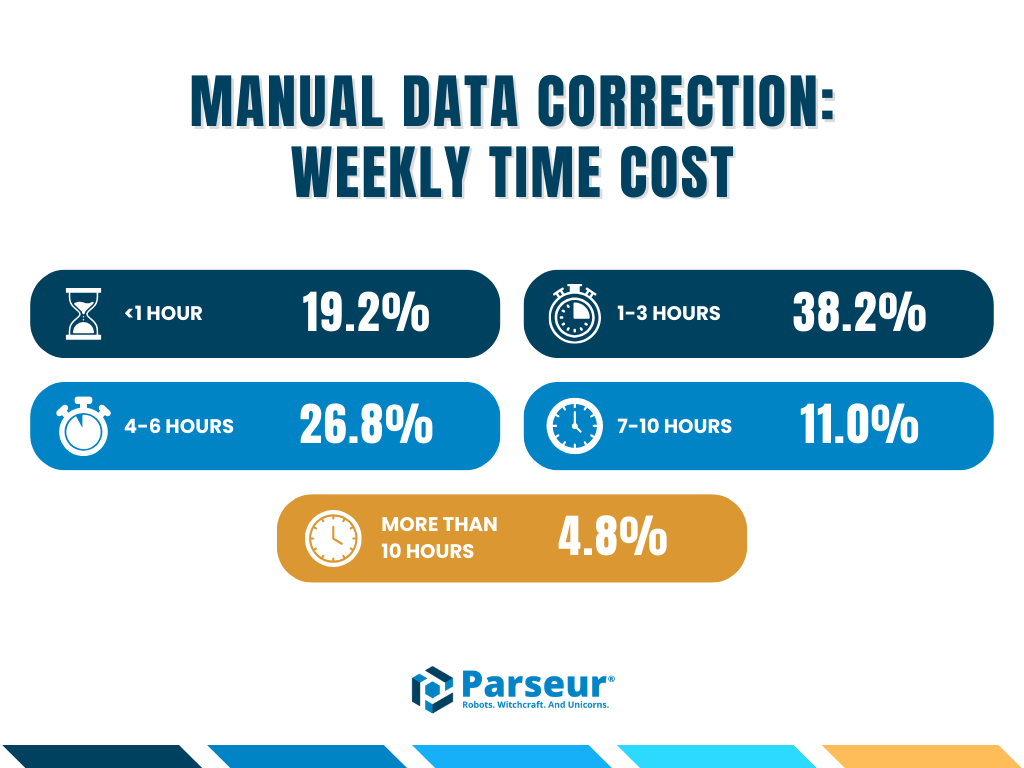

Autre enseignement fort de l’enquête : le coût humain généré par ces erreurs. Interrogés sur le volume horaire consacré chaque semaine à la correction et validation des données :

Force est de constater que l’automatisation n’a pas éliminé l’intervention humaine : elle l’a déplacée de la saisie à la correction, souvent plus ardue et chronophage.

- L’enquête révèle : Une part importante des équipes consacre plus de 6 heures par semaine à ces tâches de correction.

- La conséquence : Cette « taxe de correction » ampute le ROI escompté. Des experts qualifiés, y compris managers et C-level, sont mobilisés dans des vérifications manuelles au détriment de missions à forte valeur.

Automatisation ou correction : à quel prix ?

L’automatisation vise la suppression des tâches répétitives, mais les réponses à l’enquête tirent la sonnette d’alarme.

À la question du temps hebdomadaire passé à corriger ou revoir les données extraites :

- 38,1 % y passent 1 à 3 heures

- 26,8 % dépassent 4 à 6 heures

- Une fraction non négligeable occupe plus de 6 heures chaque semaine

C’est ainsi qu’apparaît la taxe invisible : les compétences internes sont détournées pour assurer un contrôle qualité coûteux, freinant la création de valeur promise par l’automatisation.

Plutôt que de dynamiser la prise de décision, de mauvais pipelines transforment des managers et experts IT en relecteurs, ce qui freine l’impact de l’automatisation documentaire.

Origine des erreurs : focus sur les documents-clés

Les documents qui posent problème ont trois points communs majeurs :

- Volumes importants

- Présence de champs structurés et de texte libre

- Fort enjeu opérationnel et financier

Des erreurs à ce niveau déclenchent des effets en cascade : trop-perçus, litiges, pertes de revenus, risques réglementaires, retards logistiques.

Pourquoi un écart de confiance s’est-il instauré ?

Nous avons également demandé : « Quel est votre degré de confiance dans la fiabilité des données tirées des documents ? » Malgré la fréquence des anomalies, presque la moitié (48,7 %) se déclarent très confiants dans la fiabilité des données alimentant leurs outils IA et analytiques. Ce paradoxe traduit précisément l’écart de confiance dans les données : l’écart entre l’attente vis-à-vis de l’IA et la qualité réelle au quotidien.

Plusieurs facteurs expliquent cet écart :

1. Précision statistique vs pertinence métier

Pour certains processus, une précision de 99 % n’est pas suffisante : une anomalie sur 100 peut déclencher des conséquences lourdes en finance ou compliance, là où l’exigence porte sur les résultats et non la moyenne des prédictions.

2. Foi excessive dans l’IA générique

Les extracteurs basés sur des LLM généralistes peuvent générer des erreurs (ou des données inventées) en l’absence de règles ou référentiels adaptés. Sur des formats non standards, ces limites apparaissent et les données erronées se diffusent dans tout le système.

3. Effet « boîte noire »

La traçabilité des erreurs manque. Les utilisateurs ignorent souvent où et pourquoi l’anomalie est survenue, ce qui alimente le doute et l’écart de confiance dans le pipeline.

4. Vigilance des profils à haut risque

Les équipes IT, Data et le top management, plus exposées aux conséquences métier, sont aussi les plus conscients des risques et donc les plus sceptiques.

Conséquences business identifiées

Au-delà de l’irritation opérationnelle, l’enquête met en évidence des effets tangibles :

- Pertes financières : surpaiements, pertes d’opportunité

- Risques réglementaires : erreurs de reporting dans la finance ou la santé

- Retards opérationnels : difficultés logistiques causées par des anomalies de commande

En comprenant mieux ces causes, les organisations peuvent ajuster leurs workflows de validation et renforcer les processus human-in-the-loop pour réduire l’écart de confiance dans les données et sécuriser la fiabilité de la sortie IA.

Conséquences métiers : bien plus qu’un détail

Les erreurs de données lors de l’extraction documentaire entraînent :

- Pertes de revenus et règlements erronés

- Prévisions faussées, reporting erroné

- Défis de conformité et d’audit

- Conflits avec clients/fournisseurs

- Délais opérationnels et impacts sur le chiffre d’affaires

- Augmentation du risque de fraude

Autant d’enjeux qui se transforment en risques globaux à mesure que l’IA se généralise.

Combler l’écart : miser sur l’Human-in-the-Loop

L’enquête démontre : l’IA seule n’est pas suffisante.

Les entreprises qui maîtrisent vraiment l’écart de confiance dans les données ont toutes intégré des workflows Human-in-the-Loop (HITL) combinant rapidité de l’IA et validation humaine :

- Extraction métier fiable : IA spécialisée (comme Parseur) basée sur des référentiels précis, à l’inverse des modèles LLM généralistes.

- Règles de validation strictes : Contraintes implémentées pour vérifier par exemple que les totaux correspondent bien.

- Signalement intelligent : Détection automatique des cas à faible confiance et aiguillage vers un agent pour contrôle humain rapide.

Le contrôle humain se transforme alors en filet de sécurité agile plutôt qu’en goulot d’étranglement, assurant une IA performante reposant sur des données solides.

Méthodologie

L’enquête Parseur 2026 sur les données issues des documents a été réalisée fin 2025 grâce à QuestionPro. 500 répondants américains évoluant dans des rôles à forte activité documentaire ont participé, du management au C-level.

Les secteurs représentés incluent tech, finance, retail, santé et logistique. Le questionnaire portait sur la précision des données de documents, la confiance, l’adoption de l’IA et les impacts opérationnels liés aux erreurs.

Perspectives : ne laissez plus l’IA exploiter de mauvaises données

Les systèmes d’IA sont à la merci de la qualité des données qu’on leur fournit. Si l’adoption continue de s’accélérer, les effets des données documentaires défectueuses risquent d’être décuplés.

Il ne s’agit pas de remettre en cause l’IA, mais d’intégrer la notion de fiabilité dès la base.

Parseur accompagne ses clients pour réduire l’écart de confiance dans les données issues des documents grâce à des solutions de traitement intelligent associant validation, transparence et supervision humaine, pour bâtir des IA fiables et exploitables.

Envie d’avoir à nouveau confiance dans vos données ?

Ne laissez pas votre IA fonctionner sur des données douteuses : explorez une automatisation documentaire fondée sur la fiabilité à la source.

Enseignements complémentaires de l’enquête 2026

- La détection d’erreurs reste forte : 39,4 % relèvent parfois des erreurs dans les données extraites de documents (197 sur 500). 28,6 % supplémentaires en constatent souvent ou très souvent : la non-fiabilité des données est ainsi un effet courant, non anecdotique.

- Technologie et finance dominent le panel : 43,4 % des répondants sont issus de la tech, 23,2 % de la finance : deux univers où la fiabilité des données est le pilier de la conformité et des décisions IA.

- L’intégration de l’IA est déjà avancée : 37,9 % utilisent à grande échelle l’IA dans leurs processus, 31,4 % dans certains cas précis. Plus l’IA est déployée, plus la maîtrise de la qualité des données devient critique – les problèmes non traités se multiplient.

Dernière mise à jour le