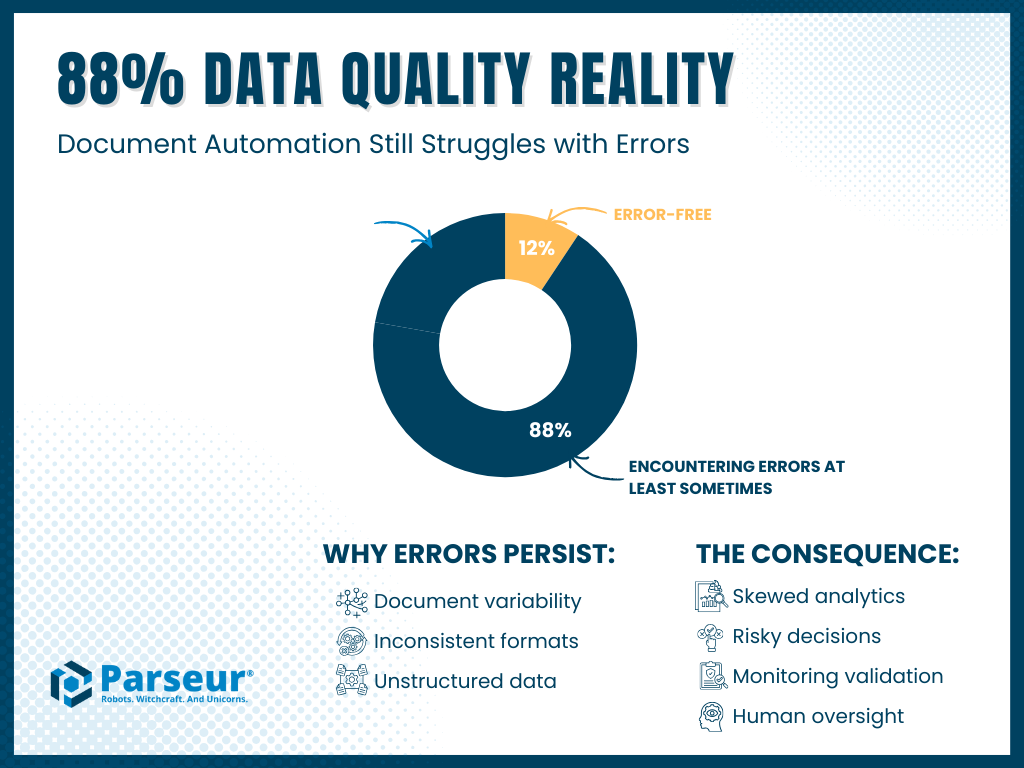

Badanie zlecone przez Parseur wśród 500 amerykańskich specjalistów pracujących w środowiskach opartych na dokumentach ujawnia wyraźny paradoks: 88% liderów biznesu deklaruje wysokie lub umiarkowane zaufanie do dokładności danych wykorzystywanych w analityce i AI, ale jednocześnie to dokładnie te same 88% przyznaje, że przynajmniej czasami napotyka błędy w danych pozyskiwanych z dokumentów. Ta „iluzja zaufania” wskazuje, że ryzyka związane z jakością danych są powszechne i stale podważają wyniki analiz, prognoz oraz systemów AI.

Kluczowe wnioski:

- Zaufanie kontra rzeczywistość: 88% deklaruje zaufanie do swoich danych, podczas gdy 88% również przyznaje, że przynajmniej czasami znajduje błędy w danych pochodzących z dokumentów.

- Częstotliwość: Prawie 69% respondentów zgłasza, że błędy pojawiają się czasami, często lub bardzo często.

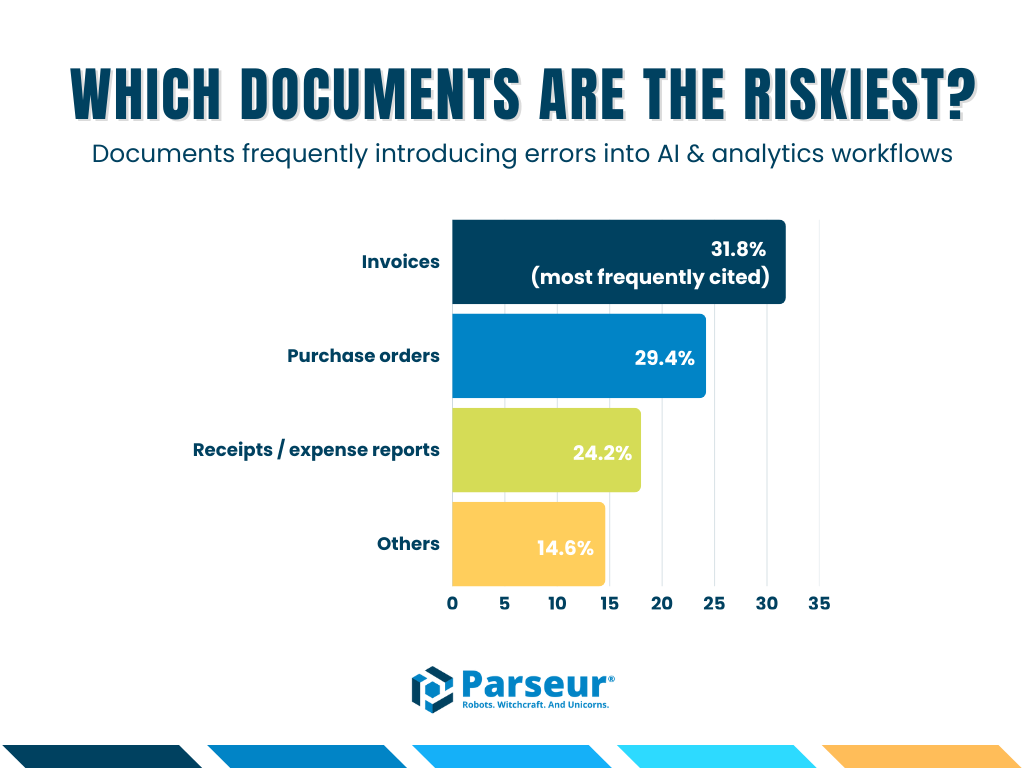

- Najczęstsze źródła błędów: Faktury (31,8%), zamówienia (29,4%), paragony/raporty wydatków (24,2%).

- Zakres badania: 500 respondentów z USA w obszarach operacji, finansów, IT, obsługi klienta i pokrewnych (głównie stanowiska menedżerskie, dyrektorzy oraz C-suite).

Poza liczbami: Paradoks Danych dla AI

Wraz z przyspieszeniem wdrożeń AI w 2026 roku debata przesunęła się z czy korzystać z AI na jak bardzo można jej ufać. Firmy szkolą duże modele językowe (LLM), wdrażają Retrieval-Augmented Generation (RAG) i automatyzują procesy analityczne, opierając się na wewnętrznych dokumentach jako głównym źródle danych.

Pod tą falą wdrożeń kryje się jednak zasadnicza sprzeczność.

Jak wskazuje najnowsze badanie Parseur, wśród 500 amerykańskich specjalistów pracujących z dokumentami, organizacje są jednocześnie pewne swoich danych i jednocześnie regularnie rejestrują w nich błędy.

To rozbieżność, którą określamy jako luka zaufania do danych z dokumentów: powiększającą się przepaść pomiędzy postrzeganą niezawodnością danych a ich realną jakością.

Najważniejsze odkrycie? Aż 88% specjalistów zgłasza napotkanie błędów w danych z dokumentów, które zasilają ich workflow AI i automatyzacje.

W artykule przedstawiamy szczegółowe wyniki badania z 2026 roku, analizujemy główne przyczyny luki zaufania, konkretne koszty biznesowe błędnych danych oraz sposoby, w jakie firmy zamykają tę lukę, by zapewnić swoim rozwiązaniom AI wiarygodne źródło informacji.

Dlaczego to ważne: wpływ na biznes i skalę

Nieprawidłowe dane to dużo więcej niż drobne niedogodności operacyjne; niosą wymierne konsekwencje finansowe, operacyjne i strategiczne. Nawet pozornie nieistotny błąd w dokumencie przetwarzanym na dużą skalę może przeniknąć przez systemy, skutkując błędnymi raportami, nietrafionymi prognozami czy nieprawidłowymi decyzjami.

Oprócz strat finansowych, błędy w danych powodują opóźnienia w łańcuchu dostaw, ryzyka zgodności, niezadowolenie klientów i zwiększają nakłady na ręczną korektę – wszystko to przez wadliwe dane z dokumentów.

Badanie Parseur 2026 ujawnia, jak szeroko rozpowszechnione są te problemy. Na przestrzeni różnych branż profesjonaliści najczęściej wskazywali na faktury (31,8%), zamówienia (29,4%) oraz paragony/raporty wydatków (24,2%) jako „strefy zagrożenia”, z których najczęściej pochodzą błędy już na etapie pozyskiwania danych. Te pomyłki rzadko zdarzają się w izolacji – propagują się do dashboardów analitycznych, modeli AI i workflow biznesowych, zwiększając wydatki i ryzyka operacyjne.

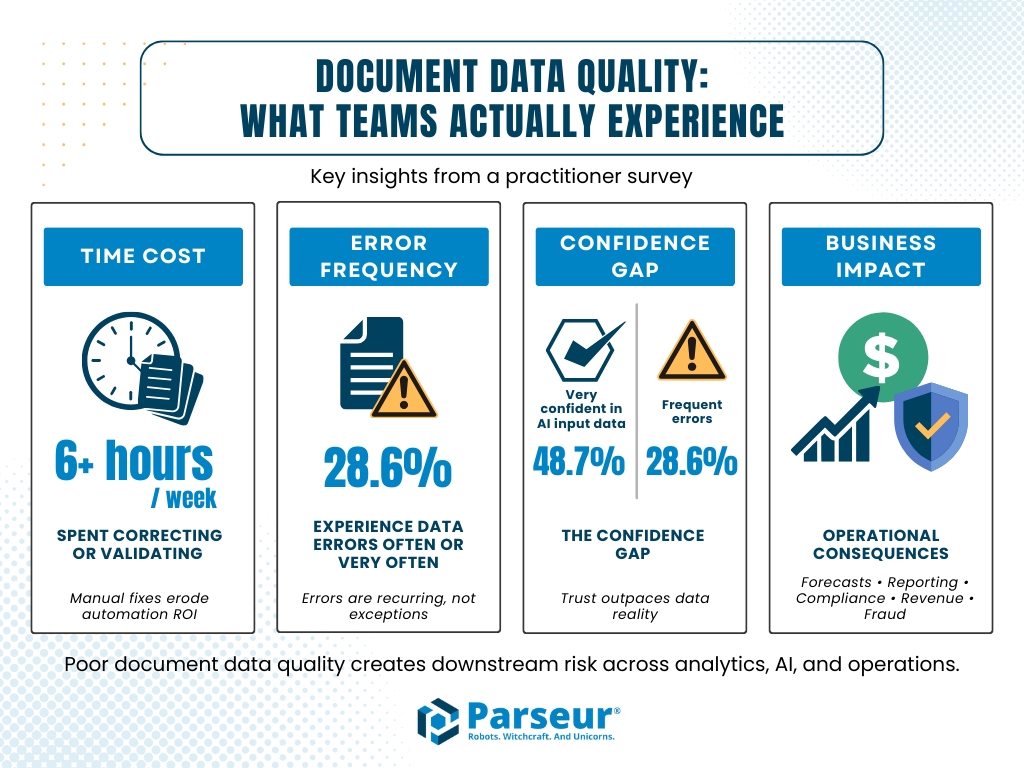

Najważniejsze dane liczbowe z badania:

- 6+ godzin tygodniowo: Wiele zespołów poświęca ponad 6 godzin tygodniowo na poprawianie lub weryfikację danych z dokumentów, co obniża realny zwrot z inwestycji w automatyzację.

- 28,6% respondentów zmaga się z błędami danych często lub bardzo często, co dowodzi, że to problem trwały, a nie marginalny.

- 48,7% specjalistów wciąż deklaruje „bardzo duże zaufanie” do danych zasilających AI, mimo tak częstych błędów – to wyraźny sygnał dla luki zaufania.

- Wskazane konsekwencje operacyjne obejmują: błędne prognozy, pomyłki w raportach finansowych, spory z klientami lub dostawcami, nietrafności wykazane podczas audytu, utratę przychodów i wyższe narażenie na oszustwa.

Każdy niezweryfikowany dokument może być źródłem systemowych nieefektywności i ryzyka. Zrozumienie skali oraz skutków złych danych pozwala organizacjom postawić na wiarygodność u źródła, wdrażać procesy walidacji i wspierać je czynnikiem ludzkim, chroniąc wyniki AI i kluczowe cele biznesowe.

Dlaczego Parseur przeprowadził to badanie?

Parseur każdego dnia wspiera zespoły automatyzujące procesy dokumentowe w finansach, operacjach, IT i obsłudze klienta. Pomimo ogromnego postępu w ekstrakcji AI, wciąż napotykamy ten sam problem: zaufanie do danych spada, gdy błędy przedostają się do kolejnych etapów – dashboardów, modeli AI, prognoz czy raportów zgodności.

Nasze badanie powstało, aby zweryfikować skalę, wskazać źródła błędów oraz pokazać, jak firmy radzą sobie z tym wyzwaniem. Chcieliśmy przekazać liderom biznesu praktyczne spostrzeżenia dotyczące jednego z często niedostrzeganych ryzyk operacji zautomatyzowanych przez AI: jakości danych z dokumentów.

88%: Zderzenie z rzeczywistością — błędy stają się normą

Aby zrozumieć rozmiar luki zaufania do danych dokumentowych, zadaliśmy pytanie:

„Czy w procesach wymagających ekstrakcji, walidacji lub przeglądu danych z dokumentów pojawiają się błędy?”

Odpowiedzi były wymowne:

- 88% respondentów przyznało, że przynajmniej od czasu do czasu napotyka błędy

- Tylko 12% deklaruje zupełnie bezbłędne pipeline’y danych

Wynik pokazuje, że pomimo szerokiego zastosowania narzędzi, takich jak OCR czy AI, różnorodność dokumentów wciąż podważa ich dokładność. Zmienność układów, formatów, odręczne notatki, niejednolita terminologia i nieustrukturyzowane pola tekstowe to główne źródła nieścisłości. Nawet drobne błędy – jak przekręcony numer zamówienia, źle odczytana kwota czy nieprawidłowy klient – mogą przedostać się dalej i zaburzać modele AI oraz decyzje.

To potwierdza, że automatyzacja bez monitoringu i walidacji nie gwarantuje wiarygodności. Bez stałej kontroli i weryfikacji przez człowieka pipeline’y AI mogą zwiększać liczbę błędów zamiast je redukować. Firmy muszą aktywnie reagować na takie zagrożenia, by zabezpieczyć zarówno operacje, jak i strategiczne decyzje.

Które dokumenty są najbardziej ryzykowne?

Nie każdy typ dokumentu niesie jednakowo wysokie ryzyko błędów. W badaniu 2026 poprosiliśmy profesjonalistów o wskazanie rodzajów dokumentów sprawiających najwięcej problemów w workflow AI i analityce.

Wyniki są jednoznaczne:

- Faktury: 31,8% (najczęstsza odpowiedź)

- Zamówienia: 29,4%

- Paragony/raporty wydatków: 24,2%

Czym te dokumenty się wyróżniają?

- Duża liczba: Przetwarzane są w tysiącach lub milionach rocznie, więc nawet mały odsetek pomyłek skutkuje poważnymi stratami.

- Złożona struktura: Łączą standardowe dane (np. daty, kwoty) oraz otwarte pola tekstowe i załączniki – to zwiększa prawdopodobieństwo błędów przy automatycznej ekstrakcji.

- Realny wpływ na biznes: Mają bezpośrednie przełożenie na raportowanie finansowe, łańcuch dostaw czy kontakt z klientem. Pomyłka oznacza nadpłatę, opóźnienie, problemy compliance lub ryzyko reputacyjne.

Te dokumenty to punkt zapalny dla workflow AI. Zaniedbanie jakości już na tym etapie wzmacnia błędy na kolejnych poziomach: od dashboardów, przez decyzje AI, po całe workflow. Skutkiem są wyższe koszty i ryzyko biznesowe.

Zgłaszane skutki operacyjne (jakościowe)

Respondenci powiązali błędy w danych z dokumentów z: błędnymi prognozami, niepoprawnymi raportami, konfliktami z klientami i dostawcami, wykryciami podczas audytów, opóźnieniami, stratą przychodów i większą ekspozycją na oszustwa. Wielu uznało te skutki za umiarkowane lub poważne.

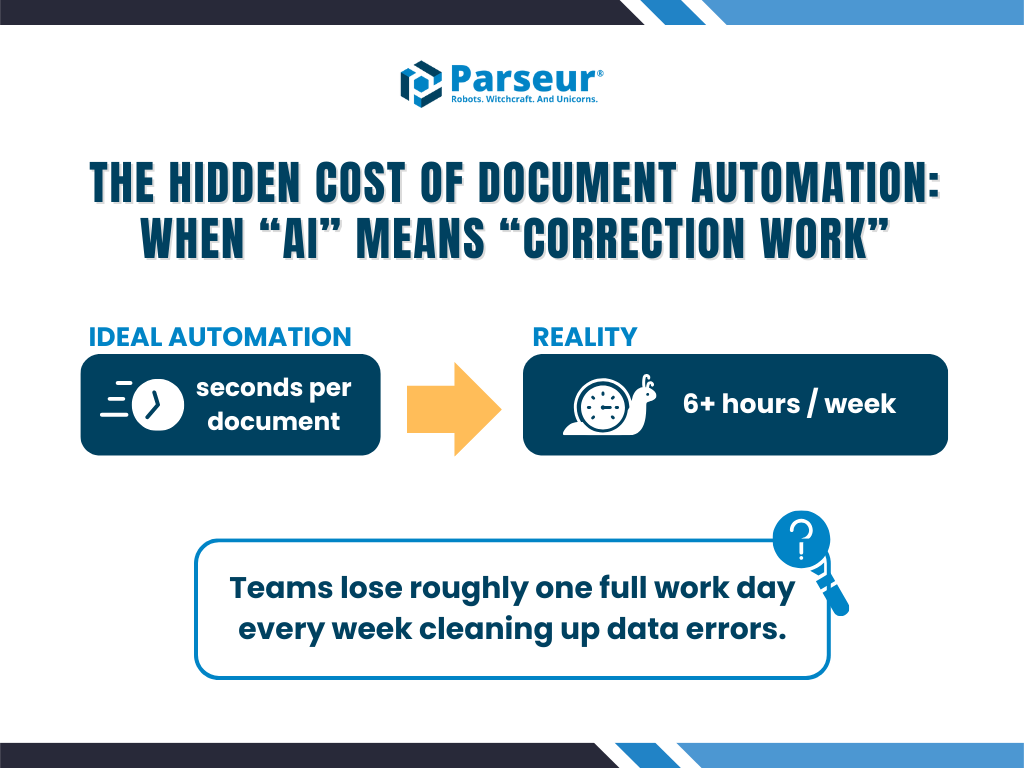

Ukryty koszt: godziny stracone na „poprawki”

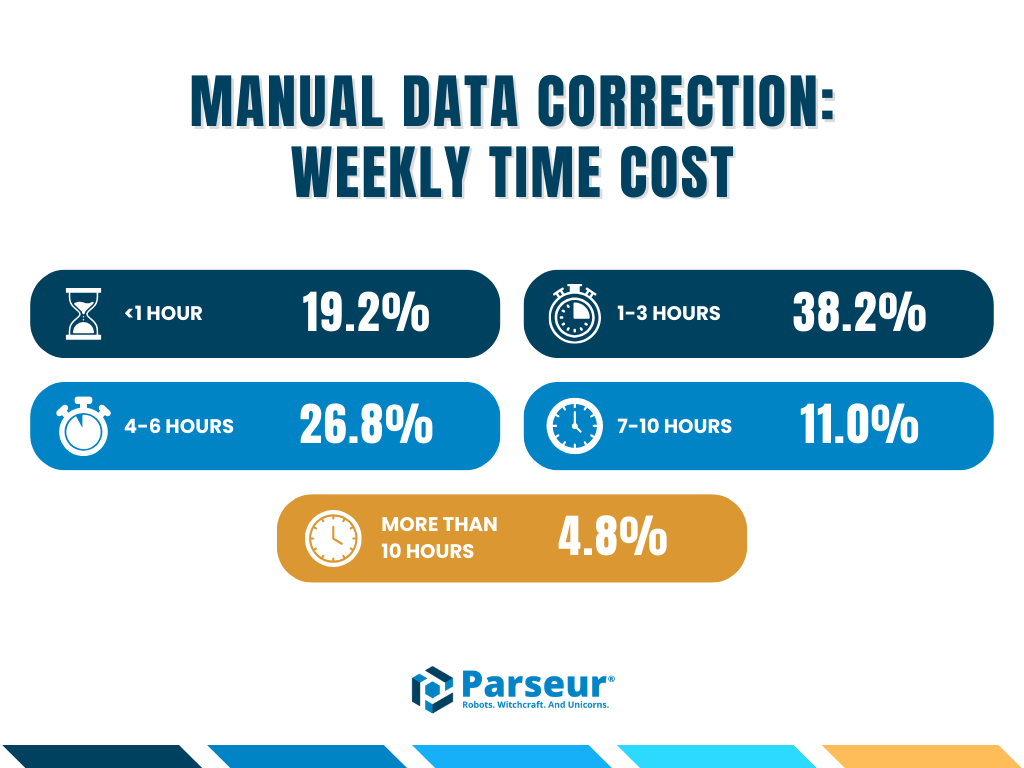

Jednym z najistotniejszych wniosków jest ludzki koszt błędów. Zapytaliśmy: "Ile godzin tygodniowo twój zespół poświęca na poprawianie lub weryfikację danych?"

Wyniki są jasne – automatyzacja nie wyeliminowała udziału człowieka, a przesunęła go z „wprowadzania” na „poprawianie”, które bywa bardziej czasochłonne i frustrujące.

- Wynik: Znacząca liczba zespołów przeznacza co tydzień ponad 6 godzin na poprawianie złych danych.

- Konsekwencje: Ten „podatek poprawkowy” zabija ROI automatyzacji – zamiast przeprowadzać analizy, doświadczeni specjaliści (C-suite, IT, data managerowie) stają się korektorami kosztowniejszymi niż sama automatyzacja.

Ukryty koszt: Gdy automatyzacja zamienia się w „pracę naprawczą”

Automatyzacja miała zredukować ręczną pracę, ale badanie pokazuje inne zjawisko.

Pytani o tygodniową ilość czasu poświęcaną na poprawianie lub przeglądanie danych:

- 38,1% wskazuje 1–3 godziny

- 26,8% — 4–6 godzin

- Spora grupa deklaruje ponad 6 godzin tygodniowo

To właśnie „podatek poprawkowy”: wykwalifikowani pracownicy zamiast wykonywać zadania strategiczne muszą przeglądać i poprawiać rezultaty AI.

Efektem jest zamiana menedżerów, IT i zespołów finansowych w kosztownych kontrolerów jakości, co znacząco zmniejsza realne korzyści z automatyzacji.

Gdzie zaczynają się błędy: dokumenty generujące problem

Nie wszystkie dokumenty wiążą się z takim samym ryzykiem, ale trzy cechy je łączą:

- Wysoki wolumen

- Pola mieszane – strukturalne i tekstowe

- Bezpośredni wpływ na finanse lub operacje

Błędy w tych dokumentach mogą szybko prowadzić do nadpłat, sporów, strat przychodów, narażenia na ryzyka zgodności oraz opóźnień operacyjnych.

Skąd się bierze luka zaufania?

Zapytaliśmy: "Jak bardzo ufasz dokładności danych pozyskiwanych z dokumentów?" Mimo tak częstych błędów, niemal połowa (48,7%) deklaruje bardzo wysokie zaufanie do danych wykorzystywanych w AI i analityce. Ta rozbieżność to właśnie luka zaufania do danych: różnica pomiędzy oczekiwaniami wobec AI a realnymi rezultatami.

Na to zjawisko składa się kilka czynników:

1. Dokładność statystyczna kontra biznesowa

W newralgicznych procesach nawet 99% dokładności nie spełnia wymagań – pojedyncza pomyłka może oznaczać poważne konsekwencje prawne lub finansowe. O tym często zapomina się, patrząc wyłącznie na ogólne wskaźniki skuteczności AI.

2. Zbyt duże zaufanie do uniwersalnych modeli AI

Standardowe modele ekstrakcji oparte na LLM mogą halucynować lub źle interpretować dane, zwłaszcza w przypadku nietypowych lub nieustrukturyzowanych dokumentów, a często działają bez odpowiednich walidacji. Błędy te przedostają się do analityki i decyzji operacyjnych.

3. Problem „czarnej skrzynki”

Użytkownicy często nie wiedzą, gdzie powstał błąd, co rodzi niepewność i zmniejsza zaufanie do całego pipeline’u danych.

4. Największa świadomość w kluczowych rolach

Najbardziej sceptyczni wobec jakości danych byli przedstawiciele IT, specjaliści ds. danych i najwyższa kadra zarządzająca – czyli osoby najlepiej znające ryzyka rozprzestrzeniania się błędów w systemach kluczowych dla biznesu.

Wpływ strategiczny – wskazane skutki

Konsekwencje sięgają znacznie dalej niż drobne błędy operacyjne. Respondenci zgłaszali między innymi:

- Straty finansowe: Nadpłaty za faktury, utracone przychody

- Ryzyko zgodności: Błędne raportowanie w regulowanych branżach (finanse, ochrona zdrowia)

- Opóźnienia operacyjne: Przestoje w łańcuchach dostaw spowodowane pomyłkami w numerach zamówień

Zrozumienie tych czynników pozwala projektować workflow, reguły walidacyjne i procesy HITL tak, by zamknąć lukę zaufania i zapewnić, że systemy AI są jednocześnie dokładne i przydatne.

Wpływ na biznes: więcej niż niedogodność

Respondenci powiązali błędy w danych dokumentowych z konkretnymi skutkami, w tym:

- Straty finansowe i nadpłaty

- Nieprawidłowe prognozy i raporty

- Ostrzeżenia w audytach i compliance

- Spory z klientami i dostawcami

- Opóźnienia oraz wyciek przychodu

- Wzrost ryzyka oszustw

Nie są to zagrożenia teoretyczne – to codzienne realia wzmocnione przez AI na szeroką skalę.

Zamykanie luki: przewaga procesu z udziałem człowieka

Wyniki badania jednoznacznie pokazują, że sama AI nie wystarczy.

Firmy rzeczywiście minimalizujące lukę zaufania wdrażają workflow Human-in-the-Loop (HITL), łącząc prędkość AI z kontrolą i weryfikacją ekspertów:

- Specjalistyczna ekstrakcja: Wykorzystanie AI stworzonych stricte pod dokumentację (jak Parseur) skonfigurowanych w oparciu o dane odniesienia, a nie generatywne LLM podatne na fantazjowanie.

- Walidacja regułami biznesowymi: Automatyczne sprawdzenia jak „suma musi równać się sumie pozycji”.

- Błyskawiczna weryfikacja: Przy niskim poziomie zaufania system automatycznie kieruje dokument do szybkiej kontroli przez człowieka, zamieniając problematyczną wartość w zweryfikowany punkt danych.

To podejście nie spowalnia procesu, a precyzyjnie zabezpiecza pipeline danych, gwarantując wiarygodność informacji wykorzystywanych przez AI.

Metodologia

Badanie Luka Zaufania do Danych w Dokumentach Parseur 2026 przeprowadzono pod koniec 2025 roku, z użyciem platformy QuestionPro. Wzięło w nim udział 500 specjalistów zaangażowanych w zarządzanie dokumentami w całych Stanach Zjednoczonych — od menedżerów po zarząd.

Badani reprezentowali sektory takie jak Technologia, Finanse, Handel detaliczny, Ochrona zdrowia, Logistyka, i odpowiadali na pytania o jakość danych dokumentowych, poziom zaufania, wdrożenia AI oraz wpływ błędów na działalność operacyjną.

Patrząc w przyszłość: Przestań karmić AI złymi danymi

Systemy AI są tak wiarygodne, jak dane, które otrzymują. Wraz z szybkim tempem wdrożeń, firmy ignorujące jakość danych dokumentowych ryzykują masowe błędy w swoich systemach.

Kluczem nie jest rezygnacja z AI, a budowa zaufanego pipeline’u danych.

Parseur wspiera zamykanie luki zaufania do danych dzięki inteligentnemu przetwarzaniu dokumentów oraz mechanizmom walidacyjnym – łącząc precyzję AI i człowieka tak, aby Twoja AI działała w oparciu o pewność, a nie wyobrażenia.

Chcesz odzyskać zaufanie do swoich danych?

Przestań dostarczać AI błędnych danych i poznaj nową generację automatyzacji dokumentów, której możesz zaufać.

Dodatkowe wnioski z badania 2026

- Błędy w danych są nadal powszechne: 39,4% respondentów twierdzi, że czasami wykrywa błędy w danych z dokumentów (197 na 500 osób). Kolejne 28,6% regularnie napotyka błędy, co potwierdza, że nieścisłości są stałym problemem.

- Branże technologiczna i finansowa przodują: 43,4% uczestników pracuje w branży technologicznej, a 23,2% w finansach – to właśnie te sektory najbardziej wymagają precyzji danych dla podejmowania decyzji, spełniania wymogów compliance i działania AI.

- AI jest szeroko wdrożona: 37,9% badanych deklaruje intensywne wykorzystanie AI w wielu workflow, a 31,4% stosuje AI w kilku kluczowych procesach. Tak wysoki poziom wdrożenia sprawia, że jakość danych dokumentowych jeszcze bardziej wpływa na efekty końcowe, jeśli nie jest skrupulatnie nadzorowana.

Ostatnia aktualizacja