主なポイント

- 2030年までに、HITLは信頼性が高く説明可能なAI設計の中核要素となる見込み

- センシティブなAI意思決定への人間の監督が規制により義務化される流れが加速

- 人間とAIが連携して倫理的・拡張可能な自動化を推進

AIと人間が共創するハイブリッドな未来

2030年が近づく今、明確になってきたのは「 AIシステムの成功は速さや自律性ではなく、いかに信頼できるか」だということです。その信頼性は、オートメーションのスピードと人間の専門性が組み合わさることで実現します。

AI導入の初期フェーズで多くの自律型システムが登場しましたが、バイアスや透明性の欠如、不可解な判断などのリスクが明らかとなり、ヒューマン・イン・ザ・ループ(HITL)や人間中心AIへの再注目が集まっています。本質的には過去への回帰ではなく、将来に向けた洗練された設計思想です。

2026年までにインターネット上のコンテンツの90%以上がAI生成となると予測されており、自動化への信頼と監督の重要性が高まっています(Oodaloop参照)。

HITLの基礎知識やビジネス活用について詳しく知りたい方は、ヒューマン・イン・ザ・ループAI:定義とメリット をご覧ください。

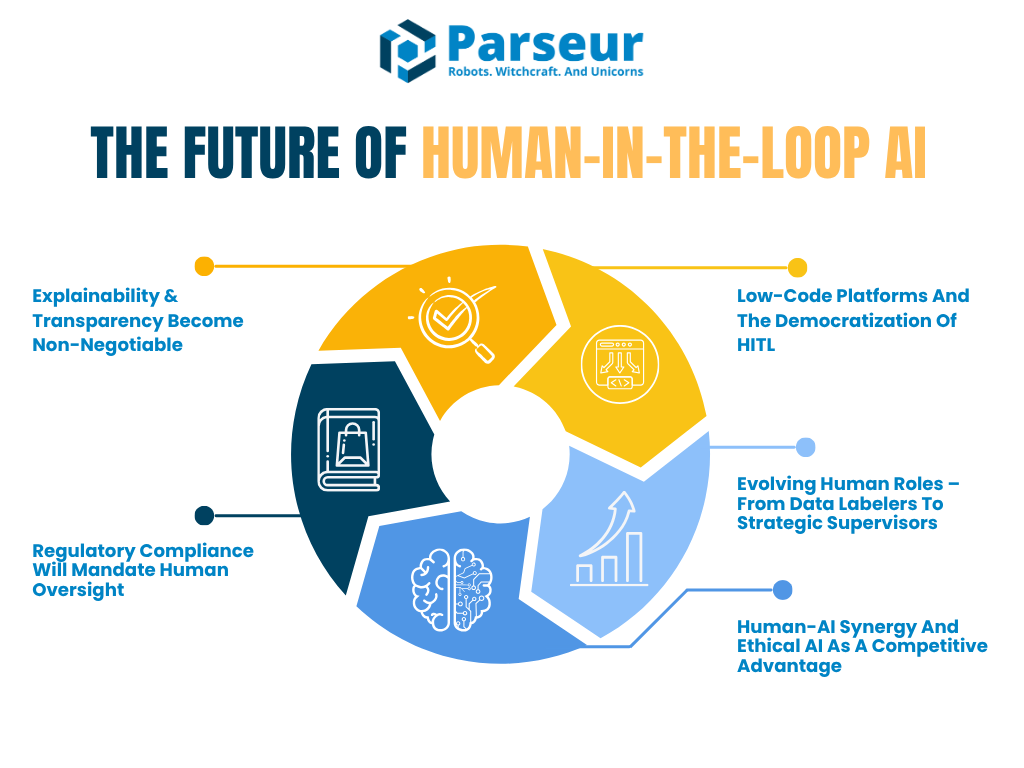

本記事では、HITLが2030年に向けどのように進化するか、また人間とAI協働の未来を形作る5つの主要トレンドにフォーカスします。

- 説明性・監査性の高いAI へのニーズ拡大

- 人間監督義務化を促す規制の増加

- ローコードプラットフォームによる手軽なHITL導入

- データラベラーからAI監督役へ進化する人間の役割

- 人間とAIの協働 が新たな競争力の源泉に

Venture Beatによれば、トップビジョナリーのリード・ホフマンもAIスーパーエージェンシーによる時代を予測し、「AIを使わない人間は、使う人間に取って代わられる」と語っています。AIは脅威ではなく生産性を飛躍的に高めるレバーになるという観点です。

また**PwCのグローバルAIジョブバロメーター(2026)では、生成AI導入後にAI活用が進む産業の生産性が2018–2022年に7%から、2018–2024年には27%と約4倍に増加**したと示されています。これは金融やソフトウェアなど多様な専門分野でAIが人間のパフォーマンスを強化している証拠です。

自動化と保証の二択に迫られる時代は終わりました。人間の判断を要所に取り入れたハイブリッドAI設計が普及し、in-the-loopやon-the-loopモデルの選択肢も拡大しています。

トレンド1: 説明性と透明性が新たな必須条件に

AIが現実世界で意思決定に影響を及ぼす中、重要なのはAIが正しいか否かだけでなく、人間が「なぜその判断に至ったのか」を説明できるかです。そのための説明可能AI(XAI)と透明性が不可欠です。

今後、説明性は単なる推奨事項ではなく必須要件となっていきます。特に金融・医療・保険・法律など高リスク分野では顕著で、HITLワークフローには人間がAI出力を検証・解釈・説明する責任が求められるようになります。これにより法規制や倫理要求にも対応可能です。

Gartnerの予測では、2026年までに企業の80%以上が生成AIアプリ/サービスを導入しているとされ、業界を問わず説明性と人間による監督の重要性がより一層高まるでしょう。

注目したい例がEU AI法です。ハイリスクAIには人間の監督・判断根拠の説明義務が既に盛り込まれています。一方NIST AI リスクマネジメントフレームワークも、曖昧なHITLの役割やブラックボックス化が重大リスクとして挙げられており、今後は監査・人間設計記録の厳格化が進む見通しです。

2030年:説明インターフェース統合型HITL

2030年には、ほぼすべてのAIツールに**「説明インターフェース」**が標準搭載されるでしょう。AIの意思決定について、人間レビュワーが「なぜその結論に至ったか」「最重要な判断根拠は何か」などを理解・検証できます。たとえばクレジット審査AIなら申込者のスコア理由トップ3を表示し、レビュー担当者が公平性や正確性チェックを行えます。

HITLは全手作業検査から、重要局面での戦略検証へと進化。AIが自動生成したアウトプットの“裏側にある根拠や論理”がビジネス価値や規制に一致しているか人間がチェックします。

業界導入事例

医療・金融がその最前線です。これらは説明性が単なる推奨ではなく法的要件であり、Deloitte Tech Trends 2026も「自動化が強大になるほど、人間従業員の重要性も高まる」と指摘しています。AIの複雑性が増すほど、専門家による監督・レビューが不可欠になるというAIの逆説を示しています。

また、**“human-on-the-loop”**の新モデルも登場。人間が常に細かな介入をせずAIの運用を監視し、必要時にのみアクションするパイロット的立ち位置です。これは自動運転や航空の運行管理などに類似しています。

なぜ重要なのか

説明性重視のトレンドは、「信頼がなければAIは大規模活用できない」という現実を裏付けます。今後は、企業が説明ログや意思決定サマリーを記録し、人間による監査やサインオフを義務化するケースも増えるでしょう。

人間の役割は単なる守りや形式的なものではなく、AI進化の鍵―欠陥や盲点の指摘、倫理軸や専門家知見の補足―として不可欠になります。

トレンド2: 規制適合が人間監督を推進

AI技術の進化とともに、法的・倫理的責任を果たす必要も高まっています。グローバル規制当局はアカウンタビリティと人間による監督に一層注力しており、2026年から2030年にかけては高インパクトAI用途にHITLプロセス義務化の波が広がると見られています。

EU、米国、NISTなど主要機関は一様に「AIはブラックボックスであってはならない」との姿勢。アルゴリズムの対象者には意思決定内容を理解・異議申立・再審査できる権利が求められます。

実際、2026年時点で米国だけでも2024年に700件以上のAI関連法案が提出され、さらに2026年初頭にも40件超の新法案が登場しており、AIの透明性・人間監督を重視する世界的潮流の速さが目立ちます(Naaia参照)。

GDPR第22条は、自動判断における人間介入の権利を明記。発効予定のEU AI法でもハイリスクAIには意味ある人間監督が必須となり、法的スタンダード化は現実のものとなりつつあります。

2030年に向けた「規制駆動型HITL」

多くの企業が2030年までに**「コンプライアンスHITL」**、すなわち規制要件を満たす明確なガバナンスワークフローを採用する見込みです。たとえば、

- AI判断を定期的に人間監査担当者が記録・レビュー

- サイバーセキュリティや航空業界のようなAI監督チームによるモニタリング体制

- 重要なリスク判定部分での人間チェックポイント

さらに、AIモデルの精度や人間レビューによる訂正回数等をダッシュボードでリアルタイム管理できる仕組みが一般化し、これらのトレーサビリティそのものが規制遵守の証明になっていきます。

業界リーダーの最新動向:ハイブリッドAIガバナンス

すでに多くの成熟企業が、人間と自動化を組み合わせたハイブリッド運用に移行しつつあります。Gartnerによると、成熟組織の67%がAI専任チームを設立し、「AI倫理責任者」「モデルマネージャー」「ナレッジエンジニア」など新たな役職を導入して責任あるAI運用を担保しています。

これはAIに対する技術的監督と倫理的責任が両輪であるとの認識の現れです。今後は「AI監査人」「AIリスク管理者」「ヒューマン・イン・ザ・ループ監督者」などの職種が2030年までに幅広く普及し、人間監督を埋め込んだAIガバナンスへの転換を示唆しています。

説明性+規制対応が当たり前に

規制側は「人間が関与している」だけでなく意思決定の説明も重視します(トレンド1とリンク)。監査記録やドキュメンテーションがスタンダードとなり、NIST AI RMFも人間によるオーバーライドやモニタリングを推奨。未対応企業への罰則や認証剥奪も視野に入っています。

今後「AI信頼認証」取得など設計段階から人間監督を内包するケースも増加し、公的な証明が競争力の源泉となるでしょう。

トレンド3: ローコードプラットフォームと民主化

これまでは、HITLワークフローの構築にはエンジニアの専門知識やカスタム開発が不可欠でした。ですが2026年以降ローコードやノーコード・プラットフォームの普及により、AI技術に詳しくないユーザーでもHITL導入が格段に容易化されています。

こうしたツールでは、プログラミング不要で人間の介入ポイントをAI自動化フローに統合可能。UiPath、Microsoft Power Automate、Amazon A2Iなどは、人間レビューをドラッグ&ドロップで簡単に挟めるサービスを展開中です。

ビジネス部門でも構築できるHITL型AIワークフローへ

HITL機能付きAIプラットフォームが業界標準に。2026年までにカスタマーサービスリーダーの70%が生成AIを顧客対応に導入予定で、品質確保・監督強化のためHITL活用が一般化するとAmplifAIも予測しています。

この民主化によって、法務・経理・現場など各部門が自らAI監督レイヤーを組み込みやすくなり、幅広い人材がAI構築+監督に参加できる体制が現実に。将来的にはLLMが信頼度やデータリスクに応じてHITLの挿入箇所を提案したり、ダッシュボードで人間が意思決定サマリーをチェックしたり、フィードバックでAI行動を改善する機能も一般化するでしょう。

クラウド型HITLでスケール&コスト最適化

またAmazon Mechanical Turkや外部BPOサービスへのアウトソースも普及。これにより大規模な内製チームがなくても、コスト効率よく高品質な人間検証と自動化を両立可能です。

例えばECサイト運営企業がAIに商品レビューを分類させ、不審な内容だけHITLチームに回す…といった仕組みも現実的になっています。

業界の流れ:カンタン&安全なHITLの普及

今後、プラットフォームはローコードUIによる自動化と、カスタムコーディング両立が当たり前になっていきます。HITL実装はメールキャンペーン作成やWebサイト制作と同程度の手軽さになるでしょう。

この流れはParseurにも重なります。Parseurはテンプレート作成の柔軟性・独自検証ワークフローなど、AIに100%依存しない責任ある自動化基盤を提供し、ハイブリッド化するAI活用現場を後押しします。

トレンド4: 人間の役割の進化—「戦略的監督」時代へ

AIが進化するとともに、人間が関与する役割も大きく変化しています。初期HITL担当はラベル付けなどルーチン作業が中心でしたが、今後は自動化やクラウドワーカーに委譲される一方、人間はより戦略的・専門的なAI監督者/意思決定補佐の位置づけに進化します。

Statisticaの2026年調査では業務の47%を人間、22%を機械、30%は両者の協働で担い、2030年にはさらにそのバランスが進化と予測されています。

HITL2.0:AI監督とリスクマネージャーの時代

これからの「ヒューマン・イン・ザ・ループ2.0」では、人間は単なるチェッカーではなく戦略的監督者やAIリスクマネジメントの使命を担います。

例えば医療AIにおける医師は、正常時はAIの判断に委ねつつリスクや異常が観測された際にのみ介入。そのレビュー内容がモデル再訓練や継続的改善に活かされ、AIの完成度も向上していきます。これが本来のAI×人間の協働モデル(拡張知能)です。

世界経済フォーラムも、2030年までに雇用主の60%がデジタル変革に向け分析力・リーダーシップ重視へシフトし、単純作業スキルは後退としています。

また「on-the-loop」型-AIを常時監視しつつ必要時だけ介入する航空管制型モデル-も多くの現場で採用が進むとみられます。

AIが人間の監督をサポートする未来像

今後、人間監督者もAIに助けられるシナリオが増えます。AIツールから「過去判断と矛盾あり要確認」等のアラートが来る時代も現実的。人間がループに「いるだけ」でなく、AIが監督効率を後押しする体制が主流となるでしょう。

新職種拡大:AI監督者・倫理担当・フィードバックスペシャリスト

2030年までには以下のような新たな職種も想定されます。

- AIフィードバックスペシャリスト

- アルゴリズム倫理オフィサー

- モデル行動コーチ

- ヒューマン・イン・ザ・ループ監督リーダー

これらは単なるチェックマンでなく、AIシステム進化・品質保証・全社ナビゲーター的役割となります。

Deloitteの2026年グローバル人材トレンドでも、組織リーダーの57%が「機械と共に考える力」を育成課題と認識し、人間の役割シフトを明言しています。

トレンド5: 人間とAI協働×倫理的AIが競争優位に

AIの未来は「人間vs機械」ではなく、人間と機械の協働でより安全・知的かつ倫理的な意思決定を行う時代。2030年に向け、最も競争力のある組織は、人間判断と自動化の最適なハイブリッド運用を確立した企業となります。

この潮流は**拡張知能(Augmented Intelligence)**とも呼ばれ、AIの強み(迅速な分析やパターン認知)+人間の強み(倫理判断・共感・専門知識)によって、賢明な判断があらゆる局面で実現されます。

組織の55%が「AIガバナンス組織」や理事会を設置し、人間の監督や倫理的統治の重視が拡大しています(Gartner参照)。

なぜ人間×AIのシナジーが勝つのか?

2026年には、「ヒューマン・イン・ザ・ループ」は単なる安全策でなく、信頼されるAI構築の中心機能へと進化します。ローン審査、採用判断、医療レコメンド等…人間レビューがあることでAI判断の正確性・信頼性が担保されます。

HITL設計自体がブランド訴求や差別化要素になり、「人間レビュー済みAI」「人間の監督で運用したAI」といったラベルが医療、金融、教育など高信頼が求められる分野で重要性を増します。

顧客や社会が「私たちのAIは人間による監督付きです」と明示する企業により信頼を寄せる時代となるでしょう。

「倫理的AI=ビジネス戦略」の現実化

自動化任せだけのAIによる失敗事例—履歴書誤判定、偏ったリスク評価、誤診断等—が広く報じられ、炎上や消費者不信の原因にもなっています。

高リスクなAIには必ず人間レビューを組み込むことで企業は規制順守+顧客責任の双方アピールが可能に。倫理的AIはもはや選択肢でなく、経営必須要件になりつつあります。

「HITL認証」や監査可能AIの到来

今後「HITL準拠認証」ラベル付きAI製品も普及する見込み。産業ISO認証のように「人間による監督・説明・訂正可能」なAIとして、公的に保証されるのが標準となります。

透明性・監査性・人間主導設計のAIを持つ企業だけが顧客・投資家・規制当局からの信頼を獲得できる社会となります。

NIST AI Risk Management FrameworkもAI設計時に「監督者」機能の内蔵を推奨し、ヒューマン・イン・ザ・ループ型・on-the-loop型役割をリスク低減の核心要素と位置付けています。数年内には一部用途で法的義務化も想定されています。

HITL by design—設計段階からの人間内包

「HITL by design」すなわち設計初期段階からHITLを組み込む思想が業界標準へ。後付けで人間レビューを追加するのではなく、フェアネス・透明性・説明責任をプロダクトの基底に置く「責任あるAI」への移行です。

業界トップもこの考え方に共感を示しています:

最終的に勝つのは人間 対 機械ではなく、“人間と機械が共存・共創する世界”です。 — Satya Nadella, Microsoft CEO

この思想がエンタープライズも一般向け製品も含めて多くの分野の設計方針に反映されています。

2030年へ:人間とAIがともに進化する社会へ

AI進化のスピードが増す今、明確な教訓が見えてきます。自動化技術と人間専門性をバランスよく組み合わせた組織が未来をリードするのです。

PWCは2030年にAIが世界経済にもたらすインパクトは最大15.7兆ドルに達すると予測しています。

HITLはAI基盤の背後に退くどころか、説明性・倫理性・信頼性を保証する戦略中枢へと進化。あらゆるAI開発・運用段階で不可欠な存在となるでしょう。

2030年には「人間による監督は一時的な補助策」ではなく、設計原理そのものに。規制基準やプラットフォーム機能もHITLとの融合を前提とし、導入の早い企業が長期でリーダーシップを発揮します。

まるでシートベルトが“車の完全標準装備”となったように、HITL機構は全ての信頼ある本格AIの基本機能になるでしょう。これは利用者保護・事故防止・責任ある技術革新のための基本条件となります。

今まさに、その準備を始めるべき時です。Amazonも「2030年欧州ではAIがほぼ普及済み」と示唆します。

ビジネスリーダーおよびIT戦略担当は、今ここから:

- 説明可能AIツール・インターフェースへの投資

- チーム横断的な人間監督役の配置

- 手軽に人間監督を組み込めるHITL対応プラットフォーム選定

- 人間×AI協働が常態となるプロセス設計

規制強化と信頼重視の流れの中、これらの取り組みが企業のレジリエンス、スピード、倫理的リーダーシップを支える礎となるでしょう。

最終更新日