Punti Chiave

- Entro il 2030, l'HITL sarà una caratteristica fondamentale della progettazione per un'IA affidabile e spiegabile.

- Le normative richiederanno la supervisione umana nelle decisioni IA sensibili.

- La sinergia tra umani e IA guiderà un'automazione etica e scalabile.

Un Futuro Ibrido per IA e Umani

Avvicinandoci al 2030, appare evidente che i sistemi di IA di maggior successo non saranno i più veloci o autonomi, ma quelli più affidabili. Questa fiducia nasce dall’equilibrio tra la rapidità dell’automazione e la competenza umana.

Le prime adozioni su larga scala ci hanno insegnato che, sebbene i sistemi autonomi siano potenti, presentano rischi rilevanti come bias, opacità e risultati imprevedibili. Queste sfide hanno riacceso l’interesse per i sistemi HITL e per l’IA centrata sull’umano—non come soluzione di ripiego, ma come strategia lungimirante di progettazione.

Si stima che entro il 2026, oltre il 90% dei contenuti online sarà generato dall’IA anziché dagli esseri umani. Questo cambiamento accentua il bisogno di fiducia e controllo nei sistemi automatizzati, come riportato da Oodaloop.

Per approfondire le basi di questo concetto, esplora la nostra guida su Intelligenza Artificiale Human-in-the-Loop: Definizione e Vantaggi, un’introduzione pratica all’uso odierno e ai benefici per il business dell’HITL.

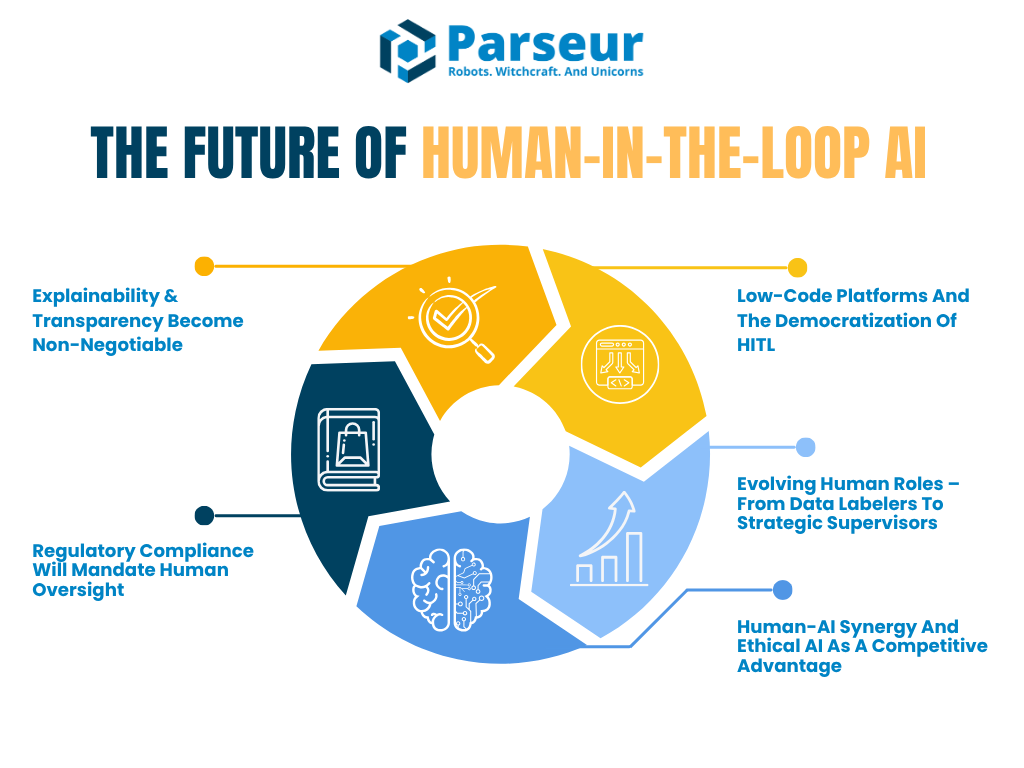

Questo articolo analizzerà come l’HITL evolverà da ora al 2030, concentrandosi su cinque trend chiave che stanno guidando il futuro della collaborazione tra uomo e IA:

- La richiesta di IA spiegabile e auditabile

- L’ascesa della conformità normativa che impone supervisione umana

- La crescita delle piattaforme low-code che facilitano l’implementazione HITL

- L’evoluzione dei ruoli umani: da labeler di dati a supervisori IA

- Come la sinergia uomo-IA diventerà un vantaggio competitivo

Secondo Venture Beat, anche i visionari tech come Reid Hoffman prevedono un futuro plasmato dalla super-agency IA: “L’umano che non usa l’IA sarà sostituito da chi usa l’IA”, posizionando così l’intelligenza artificiale come moltiplicatore di produttività più che come minaccia.

A sostegno di ciò, il Global AI Jobs Barometer di PwC 2026 rivela che, dalla proliferazione dell’IA generativa nel 2022, la produttività nei settori esposti all’IA è quasi quadruplicata dal 7% (2018-2022) al 27% (2018-2024), dimostrando come l’IA amplifichi sensibilmente la produttività umana in comparti come i servizi finanziari o il software publishing.

Le organizzazioni non sono più costrette a scegliere tra automazione e controllo. Il futuro risiede nelle architetture IA ibride, che integrano il giudizio umano nei momenti chiave, sia in modalità in-the-loop che on-the-loop.

Trend 1: Spiegabilità e Trasparenza Diventano Irrinunciabili

Man mano che l’IA influenza decisioni cruciali, la questione non è più solo la precisione della macchina. La reale preoccupazione è: gli esseri umani possono comprendere e spiegare tali decisioni? Qui entrano in gioco XAI (AI spiegabile) e trasparenza.

Nei prossimi anni, la spiegabilità passerà dall’essere best practice a requisito obbligatorio, in particolare nei settori ad alto rischio come finanza, sanità, assicurazioni e giustizia. I workflow human-in-the-loop non garantiranno solo supervisione: permetteranno alle aziende di soddisfare domande normative ed etiche, grazie a persone preposte a interpretare, validare e spiegare gli output IA.

Secondo Gartner, entro il 2026, oltre l’80% delle imprese avrà utilizzato API IA generative o implementato applicazioni abilitate da IA generativa. Questo sottolinea l’urgenza di spiegabilità e controllo umano nei sistemi IA in settori come la sanità, il legale e i servizi finanziari.

Un esempio concreto è il Regolamento Europeo sull’IA, che già prevede per le IA ad alto rischio la supervisione umana e la possibilità di spiegare gli esiti prodotti dal sistema. Nel frattempo, il NIST AI Risk Management Framework avverte che la carenza di chiarezza sui ruoli HITL e le decisioni opache restano questioni serie. Presto, framework come quello del NIST formalizzeranno la progettazione e la documentazione della revisione umana.

Prospettive future: human-in-the-loop con interfacce di spiegazione

Entro il 2030, gli strumenti IA probabilmente integreranno di serie “interfacce di spiegazione”. Queste aiuteranno i revisori umani a capire le scelte dei modelli. Immagina un sistema di valutazione del credito che assegna un punteggio e mostra le tre ragioni principali dell’output IA. Questo fornisce al revisore il contesto necessario per valutare correttezza ed equità.

L’HITL evolverà dalla revisione manuale a ogni passo verso la validazione strategica nei punti critici. Non si tratterà più di approvare ogni output, ma di confermare che la logica delle decisioni IA sia allineata con valori aziendali, obiettivi di compliance e standard di equità.

Settori dove questo è già realtà

Sanità e servizi finanziari sono pionieri: qui la spiegabilità è obbligo di legge. Ad esempio, il report Deloitte Tech Trends 2026 osserva: “Più cresce la complessità, più il ruolo umano diventa centrale.” Questo evidenzia il principale paradosso: maggiore automazione implica bisogno crescente di supervisione qualificata, non minore.

La tendenza trova riscontro anche nella crescita dei modelli “human-on-the-loop”: qui l’essere umano non interviene a ogni momento, ma supervisiona costantemente il funzionamento dell’IA ed è pronto a prendere il controllo in caso di necessità, come i piloti durante il volo automatico.

Perché conta

Il trend verso la spiegabilità rafforza una verità di fondo: un’azienda non può scalare l’IA senza fiducia. E la fiducia nasce dalla trasparenza. In futuro, potremmo persino vedere obblighi di mantenimento di “log di spiegazione” o report sulle motivazioni delle decisioni, con individuazione di umani responsabili della revisione e della firma di tali spiegazioni.

Questi ruoli umani non saranno solo passivi: plasmeranno direttamente l’evoluzione dei sistemi identificando errori, aggiungendo contesto e offrendo il fondamento etico che all’IA manca.

Trend 2: La Conformità Normativa Richiederà Supervisione Umana

Con la crescita delle capacità IA, aumentano anche le responsabilità legali ed etiche. I regolatori globali stanno ponendo crescente attenzione su accountability e controllo umano nei sistemi automatizzati. Tra il 2026 e il 2030 ci aspetta un’ondata di regolamentazioni che imporrà formalmente processi Human-in-the-Loop per molte applicazioni IA ad alto impatto.

Governi ed enti di standardizzazione come Unione Europea, Stati Uniti e NIST convergono su un punto fondamentale: l’IA non può essere una black box. Le persone soggette a decisioni algoritmiche devono poterle capire, contestare e, spesso, chiedere una revisione umana.

Di fatto, al 2026, solo negli Stati Uniti sono stati proposti oltre 700 progetti di legge sull’IA nel 2024, con più di 40 nuove proposte all’inizio del 2026, segno di un panorama regolatorio in rapida evoluzione incentrato su trasparenza e supervisione umana, secondo Naaia.

Il GDPR Articolo 22 consente ai cittadini di richiedere intervento umano di fronte a decisioni automatizzate. Il futuro Regolamento IA europeo rafforza questo principio: sarà obbligatorio per l’umano svolgere un ruolo significativo nel supervisionare e controllare i sistemi ad alto rischio. Non si tratta solo di una tendenza: sta diventando uno standard legale.

Prospettive: sistemi HITL guidati dalla conformità

Nel 2030 molte aziende implementeranno quelli che si potrebbero definire "compliance HITL", ossia flussi di governance esplicitamente progettati per la compliance. Ad esempio:

- Revisori umani registreranno e analizzaranno le decisioni IA su base programmata.

- Alcune organizzazioni istituiranno team di supervisione IA per monitorare i sistemi attivi, come i control room in aviazione o nella cybersecurity.

- Nei punti più critici della pipeline decisionale, saranno inseriti checkpoint umani dove il rischio è maggiore o l’equità è prioritaria.

Strumenti e piattaforme si adatteranno per facilitare questo processo. Le aziende utilizzeranno dashboard che tracciano la precisione dei modelli e quanto spesso i revisori umani intervengono o annullano decisioni IA. Questa tracciabilità diventerà essa stessa un parametro di compliance.

Insight dagli esperti: la crescita della governance ibrida IA

I leader di settore stanno già adottando framework ibridi che fondono automazione e supervisione umana. Secondo Gartner, il 67% delle organizzazioni mature ha creato team IA dedicati e introdotto nuovi ruoli come AI Ethicist, Model Manager e Knowledge Engineer per assicurare un’implementazione responsabile dei sistemi IA.

In comparti come dati & analytics, questi ruoli stanno diventando standard, perché le aziende riconoscono che supervisione tecnica e accountability etica sono elementi centrali per il successo dell’IA. È prevedibile che titoli come “AI Auditor”, “AI Risk Manager” o “Supervisore Human-in-the-Loop” saranno diffusi già nel 2030, segnando uno shift strategico verso l’integrazione permanente del controllo umano nella governance IA.

Spiegabilità e regolamentazione

I regolatori non si limiteranno a chiedere la presenza umana: vorranno che chi revisiona sia in grado di spiegare le decisioni. Questo si collega direttamente al primo trend. Documentazione e audit trail diventeranno prassi standard. Il NIST AI RMF raccomanda già che le organizzazioni mettano i revisori umani in grado di bloccare l’IA e di monitorare regolarmente i risultati. Futuramente, la mancata adozione potrebbe comportare sanzioni o la perdita di certificazioni.

Alcune aziende potranno cercare "certificazioni di fiducia IA" che attestino come i loro sistemi siano governati responsabilmente, con la supervisione umana integrata fin dall’inizio.

Trend 3: Piattaforme Low-Code e Democratizzazione

Tradizionalmente, realizzare un workflow HITL richiedeva risorse di sviluppo, integrazioni e competenze IA avanzate: una barriera per team piccoli o utenti non tecnici. Ora però questa barriera sta scomparendo rapidamente. Entro il 2026 e oltre, piattaforme low-code o senza conoscenze tecniche stanno rendendo l’HITL accessibile a un pubblico molto più vasto.

Queste piattaforme permettono d’inserire checkpoint umani nei flussi IA senza scrivere codice. Già oggi, strumenti come UiPath, Microsoft Power Automate e Amazon A2I offrono funzioni drag-and-drop che includono la revisione umana nell’automazione delle decisioni.

Prospettive: workflow IA creati dai business user

Nel giro di pochi anni, l’offerta di piattaforme IA con caratteristiche HITL diventerà standard. Entro il 2026, il 70% dei leader customer experience (CX) prevede di integrare IA generativa nei touchpoint, usando strumenti che spesso includono HITL per garantire qualità e controllo, come sottolinea AmplifAI.

Questa democratizzazione è una svolta. Permette a reparti come operations, legale o finance di implementare la propria governance IA. Con più persone coinvolte nella costruzione e nel monitoraggio dell’IA, le aziende possono scalare più velocemente e con maggiore sicurezza.

In futuro, persino gli LLM potranno consigliare dove inserire lo step human-in-the-loop, in base alla fiducia del modello o al rischio dei dati. Le piattaforme includeranno dashboard dove gli umani potranno vedere i riepiloghi delle decisioni, segnalare problemi e migliorare il comportamento futuro dell’IA attraverso feedback.

Revisione umana crowd-powered

Un altro aspetto di questo trend è l’avanzata della validazione umana su richiesta o crowd-sourcing. Servizi come Amazon Mechanical Turk o partner BPO possono essere integrati nei flussi IA per offrire HITL scalabile a costi più contenuti, bilanciando automazione e controllo qualità senza necessità di grandi team interni.

Immagina un’e-commerce che usa l’IA per processare recensioni prodotto ma invia tutte le anomalie a una coda di validazione umana gestita da freelance HITL. Veloce, efficiente, preciso.

Il settore si orienta all’HITL accessibile

Le piattaforme dovranno garantire automazione tramite interfacce low-code pur mantenendo la personalizzazione a livello di codice per chi lo desidera. Questo trend suggerisce che implementare un HITL sarà facile quanto una campagna email o un sito web.

Questo è in linea con l’evoluzione di Parseur. Poiché Parseur offre la creazione di template personalizzati senza bisogno di affidarsi al motore IA, man mano che l’HITL diventa pilastro dell’automazione intelligente, piattaforme come Parseur saranno centrali nello scalare workflow affidabili e verificati umanamente in tutti i settori.

Trend 4: Evoluzione dei Ruoli Umani – Da Labeler a Supervisori Strategici

Con il migliorare dei sistemi IA, anche la natura della partecipazione umana si trasforma. Nelle prime fasi di adozione, gli HITL svolgevano spesso attività ripetitive come l’etichettatura dei dati o la validazione di output basilari. Nel prossimo futuro, queste attività saranno sempre più automatizzate dall’IA o delegate a lavoratori crowd-sourced. Ma questo non significa che l’umano venga escluso: il suo ruolo diventa più strategico, specialistico e di valore.

Secondo il rapporto Statistica 2026, nel 2026 gli umani gestivano il 47% dei task lavorativi, mentre le macchine il 22%, col 30% richiedente collaborazione. Entro il 2030, le aziende si attendono una divisione ancora più bilanciata, con le macchine che cresceranno di importanza.

Prospettive: HITL 2.0 come supervisori IA e risk manager

Siamo entrati nell’epoca del “Human-in-the-Loop 2.0”: qui l’umano non è solo revisore, ma supervisor, coach e responsabile del rischio IA.

Ad esempio, un medico che supervisiona una IA clinica interviene solo se il sistema mostra incertezza o segnala anomalie. Il feedback umano servirà non solo a completare un task ma a riaddestrare il modello IA e migliorarne la precisione nelle previsioni future. È l’intelligenza aumentata in pratica, dove umani e IA apprendono insieme.

Il World Economic Forum riporta che entro il 2030, il 60% dei datori di lavoro prevede che la trasformazione digitale guiderà la domanda di skill analitiche e di leadership, mentre le competenze manuali caleranno.

Questo introduce anche il concetto di “human-on-the-loop”, dove l’umano monitora i sistemi IA costantemente e interviene solo quando è necessario. È simile al ruolo del controllo traffico aereo nelle automazioni.

Umani aumentati dall’IA

Come l’IA è integrata nei flussi, assisterà anche chi la supervisiona. Immagina uno strumento IA che segnala proattivamente a un compliance officer: "Questa decisione è incoerente con i precedenti. Si prega di revisionare." Nel futuro, l’umano non sarà solo in the loop, ma sarà supportato dall’IA nella gestione del ciclo di controllo.

Nuovi titoli e responsabilità

Entro il 2030, potrebbero vedersi titoli come:

- Specialista Feedback IA

- Responsabile Etica Algoritmica

- Coach del Comportamento del Modello

- Supervisore Human-in-the-Loop

Questi ruoli garantiranno la qualità e guideranno l’evoluzione dei sistemi IA. È uno spostamento dall’esecuzione dei task alla “governance” del sistema.

Secondo il Global Human Capital Trends 2026 di Deloitte, il 57% dei leader organizzativi afferma che occorre insegnare ai dipendenti come pensare con le macchine, non solo usarle. Una conferma del mutamento di responsabilità verso la supervisione strategica.

Trend 5: Sinergia Uomo-IA ed Etica come Vantaggio Competitivo

Il futuro dell’intelligenza artificiale non sarà uomo contro macchina, ma esseri umani e macchine insieme per risolvere problemi meglio, più eticamente, più rapidamente. Verso il 2030, le organizzazioni più competitive saranno quelle capaci di perfezionare l’equilibrio tra automazione e giudizio umano.

Questa svolta è nota come intelligenza aumentata: i punti di forza della macchina (velocità, scala, pattern recognition) si fondono con quelli degli umani (etica, empatia, esperienza di dominio), generando decisioni più intelligenti a tutti i livelli.

Il 55% delle organizzazioni ha istituito board o organismi di governance IA per supervisionare le iniziative IA, come riporta Gartner, a dimostrazione della centralità della supervisione umana ed etica.

La sinergia vincerà

Entro il 2026 la logica human-in-the-loop non sarà più una rete di sicurezza opzionale, ma una caratteristica centrale dei sistemi IA affidabili. Dai prestiti bancari alle scelte di assunzione, fino alle raccomandazioni sanitarie, la validazione umana garantirà accuratezza e fiducia.

Le aziende propenderanno sempre più a comunicare la presenza di HITL come differenziatore di brand. Proprio come le etichette “biologico” o “certificato sostenibile”, saranno sempre più utilizate diciture come “AI verificata da umani” o “AI con supervisione umana”, specialmente nei settori regolati.

Imprese che potranno dichiarare “Le nostre IA sono revisionate da persone” guadagneranno fiducia, soprattutto in un’era di potenziali errori IA amplificati dai media.

Etica IA come strategia di business

I casi di fallimento dell’IA hanno mostrato quanto possano essere disastrosi processi automatizzati senza controllo. Un CV sbagliato, uno score legale di rischio distorto, o una diagnosi clinica errata possono sfociare in cause, crisi reputazionali e perdita di fiducia.

Integrare la revisione umana nelle decisioni IA rilevanti serve sia a rispettare le norme che a dare un segnale di accountability verso i clienti. L’etica IA diventa imprescindibile per il business.

Certificazioni e sistemi auditabili

Potremmo addirittura vedere sistemi IA certificati per la conformità HITL. Come gli standard ISO garantiscono sicurezza e qualità nelle industrie, le piattaforme IA potranno presto sfoggiare “etichette” che attestano la revisione, l’esplicabilità e la reversibilità delle decisioni tramite intervento umano.

Questa tendenza crea un chiaro vantaggio competitivo. Le realtà trasparenti, auditabili e guidate da supervisione umana conquisteranno fiducia di clienti, investitori e regolatori.

Secondo il NIST AI Risk Management Framework, le organizzazioni devono progettare sistemi IA con controlli già incorporati. Il framework mette in evidenza i ruoli di human-in-the-loop e human-on-the-loop come strumenti chiave per la riduzione dei rischi. Nei prossimi anni, queste funzioni di supervisione potrebbero diventare obbligo di legge per gli use case IA di maggior impatto.

Human-in-the-loop by design

Il concetto di “HITL by design” prenderà piede: non più revisione umana come patch, ma architetture IA con HITL come mattoncino fondante. È la logica della responsible AI, dove equità, trasparenza e accountability sono ingegnerizzati già nel ciclo di sviluppo prodotto.

I leader stanno già sposando questa mentalità.

In definitiva non sarà uomo contro macchina, ma uomo con le macchine. — Satya Nadella, CEO di Microsoft

Un punto di vista che guida lo sviluppo di prodotto tra software aziendali e tecnologia di consumo.

Verso il 2030: Umani e IA Mano nella Mano

Man mano che l’IA accelera, un messaggio si fa chiaro: il futuro premia chi sa bilanciare automazione e competenza umana.

L’IA potrebbe generare fino a 15,7 trilioni di dollari di valore nell’economia globale entro il 2030, secondo PWC.

L’HITL non si dissolverà con il progresso dell’IA—si evolverà come necessità strategica, integrato nelle architetture delle IA più etiche, spiegabili e affidabili.

Nel 2030, la supervisione umana sarà un principio progettuale di base, non una toppa temporanea. L’HITL sarà atteso da framework normativi fino alle capability delle piattaforme. Chi lo adotta in anticipo si assicurerà una posizione di successo sul lungo termine.

Pensaci: proprio come la cintura di sicurezza è ormai standard in ogni auto, i meccanismi HITL saranno standard in qualsiasi IA seria, a tutela dell’utente, prevenendo errori e abilitando innovazione responsabile e inclusiva.

Il momento di prepararsi è ora: Amazon ha dichiarato infatti che l’Europa potrebbe arrivare a una diffusione quasi universale dell’IA entro il 2030.

Manager e strategist dovrebbero cominciare:

- Investendo in strumenti IA spiegabili e trasparenti

- Istituendo ruoli di supervisione umana in tutti i team chiave

- Scegliendo piattaforme che facilitano step di validazione umana

- Progettando processi dove umani e IA collaborano di default

Con normative sempre più stringenti e la fiducia pubblica cruciale, queste pratiche gettano le basi per resilienza, agilità e leadership etica nel futuro.

Ultimo aggiornamento il