À retenir

- D’ici 2030, HITL sera un pilier des IA fiables et explicables.

- La réglementation exigera une supervision humaine dans les décisions sensibles de l’IA.

- La synergie humain-IA portera l’automatisation éthique et évolutive.

Un futur hybride pour l’IA et l’humain

À l’horizon 2030, une réalité s’impose : les systèmes d’IA les plus performants ne seront pas uniquement les plus rapides ou autonomes, mais les plus dignes de confiance. Cette confiance découle de l’équilibre entre la rapidité de l’automatisation et l’expertise humaine.

Les premières vagues de l’IA ont montré que l’autonomie seule est puissante mais source de risques : biais, manque de transparence, comportement imprévisible. Ces défis ravivent l’intérêt pour les systèmes HITL et l’IA centrée sur l’humain, non comme un recours mais comme une stratégie de conception d’avenir.

On estime que d’ici 2026, plus de 90 % du contenu en ligne sera généré par l’IA plutôt que par l’humain, ce qui souligne l’importance de la confiance et de la supervision dans les systèmes automatisés, comme le souligne Oodaloop.

Pour en explorer les fondements, consultez notre guide IA Human-in-the-Loop : définition et avantages, une introduction pratique au HITL, à ses usages actuels et à sa valeur business.

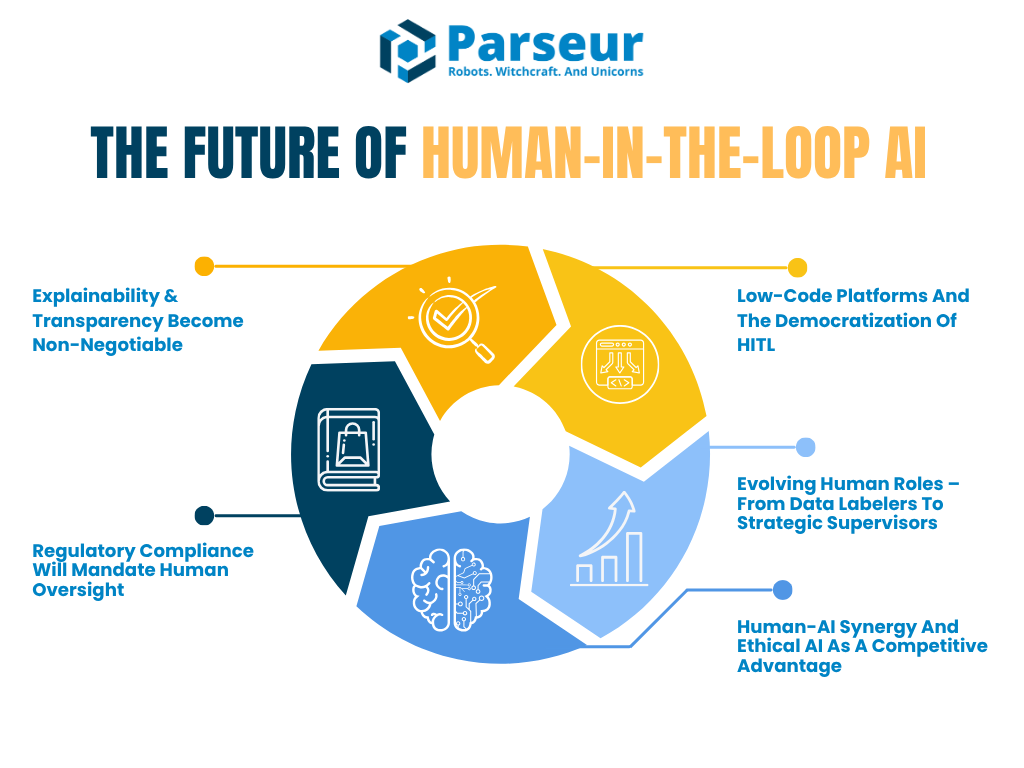

Cet article décrypte l’évolution probable du HITL à l’horizon 2030, à travers cinq tendances majeures qui façonneront la collaboration humain-IA :

- L’exigence d’IA explicables et auditables

- L’essor de la conformité réglementaire avec supervision humaine

- La montée en puissance des plateformes low-code facilitant la mise en œuvre du HITL

- L’évolution des rôles humains : de l’annotation à la supervision IA

- La synergie humain-IA comme avantage concurrentiel

Selon Venture Beat, même des visionnaires comme Reid Hoffman anticipent un futur façonné par l’AI superagency, affirmant : « L’humain qui n’utilise pas l’IA sera remplacé par celui qui l’utilise », ce qui positionne l’IA comme un multiplicateur de productivité.

Dans la même veine, le Baromètre mondial de l’emploi IA 2026 de PwC montre qu’avec la montée de l’IA générative depuis 2022, la croissance de la productivité dans les secteurs exposés à l’IA a presque quadruplé, passant de 7 % (2018-2022) à 27 % (2018-2024), démontrant la forte amplification de la productivité humaine dans des secteurs comme la finance ou l’édition logicielle.

Aujourd’hui, nul besoin de choisir entre automatisation et sécurité : l’avenir repose sur des architectures hybrides associant le jugement humain à des moments stratégiques, que ce soit via des modèles in-the-loop ou on-the-loop.

Tendance 1 : L’explicabilité & la transparence deviennent incontournables

À mesure que les systèmes IA s’immiscent dans les décisions réelles, la question n’est plus de savoir si l’IA est précise, mais si les humains peuvent comprendre et expliquer ces décisions. C’est là qu’entrent en jeu l’IA explicable (XAI) et la transparence.

Dans les années à venir, l’explicabilité deviendra une obligation réglementaire, notamment dans les secteurs critiques comme la finance, la santé, l’assurance ou le juridique. Les workflows human-in-the-loop ne serviront plus seulement la supervision : ils permettront de répondre aux exigences éthiques et réglementaires en confiant à des personnes l'interprétation, la validation et l'explication des résultats IA.

D’après Gartner, d’ici 2026, plus de 80 % des entreprises auront recours à des APIs ou applications IA génératives. C’est un appel à renforcer l’explicabilité et la supervision humaine dans des secteurs comme la santé, le juridique ou la finance.

Un exemple parlant : le EU AI Act impose déjà la supervision humaine et l’explicabilité pour les applications IA à haut risque. Le NIST AI Risk Management Framework avertit que l’absence de clarté sur les rôles HITL et l’opacité décisionnelle restent des défis majeurs. Bientôt, des cadres comme celui du NIST formaliseront la conception et la documentation de la revue humaine.

Perspectives : human-in-the-loop avec interfaces d’explication

À l’horizon 2030, les outils IA intégreront probablement des « interfaces d’explication » natives. Ces interfaces aideront les relecteurs humains à analyser la logique d’une prédiction IA. Imaginez un système de crédit affichant les trois raisons principales d’une décision : le relecteur pourra alors valider l’équité et la justesse de l’avis.

Le rôle du HITL évoluera vers une validation stratégique lors des points critiques. Il ne s’agira plus d’approuver chaque ligne de sortie, mais de vérifier que la logique de l’IA est alignée avec l’éthique, le business et la conformité voulus.

Secteurs déjà mobilisés

La santé et la finance sont précurseurs, exigeant déjà légalement l’explicabilité. Le rapport Deloitte Tech Trends 2026 rappelle : « Plus la complexité progresse, plus la supervision humaine devient centrale. » C’est le paradoxe de l’IA : plus l’automatisation est puissante, plus la supervision humaine experte est indispensable.

Ce constat se reflète dans le développement des modèles « human-on-the-loop » : l’humain supervise de façon continue et peut intervenir à tout moment, tel un pilote surveillant un pilote automatique.

Pourquoi c’est essentiel

La montée de l’explicabilité confirme un fait : les entreprises ne peuvent pas industrialiser l’IA sans confiance. Et cette confiance s’appuie sur la transparence. À l’avenir, il sera sans doute imposé de tenir des « journaux d’explication » ou rapports de décision, contrôlés ou validés par des humains.

Le rôle humain ne sera plus simplement réactif : il façonnera les IA en identifiant les failles, en apportant la contextualisation et en ancrant l’éthique.

Tendance 2 : La conformité réglementaire imposera la supervision humaine

Avec la montée en puissance de l’IA s’accompagnent des exigences juridiques et éthiques accrues. Les régulateurs du monde entier mettent davantage l’accent sur l’accountabilité et la supervision humaine dans les systèmes IA automatisés. D’ici 2026-2030, une vague de régulations imposera formellement les démarches Human-in-the-Loop sur de nombreux cas d’usage à fort impact.

Union européenne, États-Unis, NIST… tous s’accordent sur un point crucial : l’IA ne doit jamais fonctionner en boîte noire. Toute personne concernée par une décision algorithmique doit pouvoir la comprendre, la contester, et souvent demander une révision humaine.

En 2026, plus de 700 lois liées à l’IA ont été introduites aux États-Unis rien qu’en 2024, et plus de 40 nouveaux textes au début 2026, reflet d’un paysage réglementaire évoluant rapidement autour de la transparence et de la supervision IA, selon Naaia.

Le RGPD Article 22 permet à un individu de demander l’intervention humaine lors de décisions automatisées. Le futur EU AI Act renforce ces droits en imposant une implication humaine réelle dans le contrôle de certains systèmes à haut risque. Ce n’est plus une tendance, c’est un nouveau standard légal.

Perspectives : des systèmes HITL guidés par la conformité

En 2030, de nombreuses entreprises déploieront des « HITL de conformité » : des workflows spécifiquement conçus selon les obligations réglementaires :

- Des auditeurs humains journalisent et examinent périodiquement les décisions IA.

- Des équipes dédiées à la supervision IA surveillent les systèmes en direct, à l’image des centres de contrôle aérien ou cybersécurité.

- Des checkpoints humains sont ajoutés dans les chaînes décisionnelles si le risque est élevé ou si l’équité est cruciale.

Les outils et plateformes s’adapteront : dashboards de suivi de la précision des modèles, métriques de fréquence d’outrepassage humain, etc. Cette forme de traçabilité deviendra elle-même un critère réglementaire.

Avis d’expert : la gouvernance IA hybride monte en puissance

Déjà, 67 % des entreprises arrivées à maturité ont créé des équipes IA dédiées et des postes comme éthicien IA, responsable modèle, knowledge engineer, selon Gartner, pour garantir des déploiements responsables.

Dans des secteurs comme la data ou l’analytique, ces fonctions deviennent la norme, car supervision technique et responsabilité éthique sont au cœur du succès IA. On verra se généraliser les postes d’« auditeur IA », « gestionnaire des risques IA », « superviseur Human-in-the-Loop » d’ici 2030, illustrant un changement stratégique : l’humain devient socle de la gouvernance IA.

L’explicabilité rejoint la réglementation

Les régulateurs attendront non seulement une présence humaine, mais exigeront que ces humains puissent expliquer comment les décisions furent prises. Cela rejoint la première tendance. Documentation et traçabilité deviendront la norme. Le NIST AI RMF recommande déjà que les humains puissent outrepasser l’IA et contrôler les sorties de façon régulière. À l’avenir, le non respect de ces exigences pourra entraîner pénalités ou perte de certification.

Certaines entreprises chercheront même des labels de confiance IA prouvant que leur système intègre la supervision humaine dès la conception.

Tendance 3 : Plateformes low-code et démocratisation

Jadis, concevoir un workflow HITL exigeait des ressources d’ingénierie, des intégrations sur mesure et une expertise IA poussée. Cela limitait l’accès aux équipes restreintes ou non techniques. Mais cette barrière disparaît rapidement. Dès 2026 et au-delà, les plateformes low-code ou sans compétence technique requise démocratiseront le HITL auprès d’un public bien plus large.

Ces plateformes permettent d’intégrer facilement des points humains dans un workflow IA, sans écrire une ligne de code. Déjà, des outils comme UiPath, Microsoft Power Automate et Amazon A2I proposent des fonctionnalités glisser-déposer assurant la supervision humaine dans l’automatisation des décisions.

Perspectives : workflows IA créés par les métiers

On peut s’attendre à ce que dans les prochaines années, les plateformes IA intégrant le HITL deviennent la norme. D’ici 2026, 70 % des directeurs expérience client prévoient d’intégrer l’IA générative sur tous les canaux, tirant parti d’outils souvent dotés de fonctionnalités HITL pour assurer qualité et contrôle, selon AmplifAI.

Cette démocratisation change tout : les équipes métiers en opérations, juridique, finance peuvent désormais bâtir leur propre gouvernance IA. Avec plus de personnes gérant et contrôlant l’IA, l’échelle devient plus sûre et plus rapide.

Dans un futur proche, les LLM eux-mêmes pourraient proposer d’insérer des étapes humaines HITL en fonction du niveau de confiance du modèle ou du risque sur les données. Les plateformes intègrent aussi des dashboards de monitoring : les humains y résument les décisions, signalent des anomalies et peuvent améliorer l’IA via leur feedback.

Revue humaine crowd-sourcée ou à la demande

Autre phénomène : la validation humaine externalisée ou à la demande. Des services comme Amazon Mechanical Turk ou des partenaires BPO s’intègrent aisément dans les pipelines IA pour offrir du HITL à grande échelle et moindre coût. Ceci permet d’équilibrer automatisation et contrôle qualité sans équipes internes pléthoriques.

Exemple : un e-commerçant automatise le traitement des avis produits par IA mais soumet les cas suspects à une file validée par des agents HITL freelance. Rapidité, agilité, fiabilité.

Le HITL accessible à tous

Les plateformes doivent permettre l’automatisation via des interfaces low-code tout en offrant la possibilité de personnaliser via le code. C’est pourquoi le HITL sera aussi simple à déployer que la création d’une campagne e-mail ou d’un site web.

Cela rejoint l’évolution de Parseur. Parseur offre la possibilité de créer vos modèles personnalisés si vous ne souhaitez pas dépendre uniquement du moteur IA. À mesure que le HITL devient un standard de l’automatisation intelligente, des solutions comme Parseur joueront un rôle clé pour industrialiser les workflows responsables et vérifiés par l’humain dans tous les secteurs.

Tendance 4 : Nouveaux rôles – Du data labelling à la supervision stratégique

À mesure que les systèmes IA progressent, la nature de l’intervention humaine évolue. Aux débuts de l’IA, les HITL s’occupaient surtout de tâches répétitives comme le labelling ou la validation basique. Désormais, ces missions seront davantage prises en charge par l’IA ou externalisées en crowd-sourcing. L’humain ne disparaît pas, mais voit ses missions devenir plus stratégiques, spécialisées et à forte valeur ajoutée.

Le rapport 2026 de Statistica révèle qu’alors, les humains assuraient 47 % des tâches, les machines 22 % et 30 % mobilisaient les deux. En 2030, la balance s’équilibrera plus nettement, la machine prenant un rôle croissant.

Perspectives : HITL 2.0, superviseur IA et gestionnaire de risque

L’ère du Human-in-the-Loop 2.0 s’esquisse. Ici, l’humain n’est plus simple réviseur, mais superviseur, coach, gestionnaire de risque IA.

Par exemple, un médecin contrôle une IA médicale et n’intervient qu’en cas d’incertitude ou d’anomalie. Son feedback sert non seulement à statuer, mais à réentraîner le modèle et à en accroître la justesse pour l’avenir. Il s’agit d’intelligence augmentée réelle, IA et humains apprenant en tandem.

Selon le Forum Économique Mondial, d’ici 2030, 60 % des employeurs attendent de la transformation digitale une montée des compétences analytiques et de leadership, alors que les compétences manuelles déclinent.

Cela introduit la notion de « human-on-the-loop » : l’humain supervise l’IA en continu, n’intervenant que si besoin, à l’image du contrôle aérien sur les systèmes automatiques.

Humain augmenté par l’IA

L’IA s’intègre aussi aux workflows pour assister les superviseurs. Imaginez un outil IA qui signale proactivement à un compliance officer : « Cette décision diverge des précédentes, merci de la contrôler. » Demain, l’humain ne sera plus seulement dans la boucle, mais l’IA l’assistera pour piloter la boucle plus intelligemment.

Nouveaux postes et responsabilités

En 2030, on verra apparaître des intitulés comme :

- Spécialiste feedback IA

- Responsable de l’éthique algorithmique

- Coach du comportement des modèles

- Superviseur Human-in-the-Loop

Ces experts garantiront l’assurance qualité et guideront l’évolution des IA : il s’agit de passer de l’exécution à la supervision du système.

Le rapport 2026 Global Human Capital Trends de Deloitte insiste : 57 % des dirigeants affirment qu’ils doivent apprendre à leurs salariés à penser avec les machines, pas seulement à les utiliser. Cela illustre le changement de posture humaine : de l’exécution à la supervision intelligente.

Tendance 5 : Synergie humain-IA et éthique, nouveaux avantages compétitifs

L’avenir de l’IA ne sera pas homme contre machine, mais hommes et machines œuvrant ensemble, plus vite, plus éthiquement, plus intelligemment. À l’approche de 2030, les entreprises les plus compétitives seront celles qui maîtriseront l’équilibre entre automatisation et discernement humain.

On parle d’intelligence augmentée : la vitesse, l’échelle et la reconnaissance de patterns de l’IA s’articulent avec l’éthique, l’empathie et l’expertise métier de l’humain. Résultat : une prise de décision plus intelligente.

55 % des organisations ont créé un comité ou organe de gouvernance IA pour superviser les initiatives IA, preuve du poids croissant de la gouvernance humaine et de l’éthique selon Gartner.

Pourquoi la synergie prévaudra

Dès 2026, la logique du « human-in-the-loop » ne sera plus un simple filet de sécurité mais un pilier des IA de confiance. Crédits, recrutement, recommandations médicales... La validation humaine sera le garant de la justesse et la confiance.

Les organisations revendiqueront le recours au HITL comme différenciateur de marque. À l’instar des labels « bio » ou « origine contrôlée », on verra fleurir des mentions « IA vérifiée par humain » dans les messages produits, notamment dans la santé, la finance, l’éducation.

Les sociétés qui annoncent « Nos IA sont revues par des humains » gagneront la confiance, surtout à l’époque où une erreur IA peut devenir virale et nuire à la réputation.

L’éthique IA comme stratégie business

Les fiascos médiatisés l’ont montré : une IA mal contrôlée, c’est un scoring biaisé, un faux diagnostic médical ou un CV mal classé et la sanction est immédiate : litige, perte de réputation, défiance.

Intégrer la revue humaine dans les décisions critiques permet d’être conforme à la loi et de prouver sa responsabilité auprès des clients. L’IA responsable n’est plus un enjeu moral mais une nécessité business.

Certifications et IA auditable

On pourrait bientôt voir apparaître des labels HITL certifiant la conformité IA. Comme les normes ISO pour l’industrie, les plateformes IA porteront la preuve que chaque décision peut être auditée, expliquée ou renversée par l’humain.

C’est un avantage concurrentiel décisif : la transparence et la gouvernance humaine rassurent clients, investisseurs, régulateurs.

Selon le NIST AI Risk Management Framework, tout système IA doit être conçu avec la supervision intégrée. Ces guides mettent en valeur les rôles human-in-the-loop et human-on-the-loop pour limiter les risques de dérive majeure. D’ici peu, ces fonctions de supervision pourraient devenir obligatoires pour tout cas d’usage IA critique.

Human-in-the-loop dès la conception

Le concept de « HITL by design » va s’imposer. Plutôt que de plaquer une supervision humaine a posteriori, les IA seront conçues autour du HITL comme élément structurel. C’est la philosophie de l’IA responsable, où équité, traçabilité et éthique traversent tout le cycle de développement.

Les leaders sectoriels sont déjà en mouvement sur ce sujet.

Finalement, il ne s’agira pas d’un duel homme contre machine, mais d’une association homme + machine. — Satya Nadella, CEO de Microsoft

Cet état d’esprit inspire la conception de produits dans de nombreux secteurs, du logiciel d’entreprise à la tech grand public.

Cap sur 2030 : humains et IA main dans la main

Alors que l’IA progresse à grands pas, une certitude se dessine : l’avenir appartient aux organisations sachant allier automatisation et expertise humaine.

L’IA pourrait générer jusqu’à 15 700 milliards de dollars de valeur mondiale d’ici 2030, selon PWC.

Le HITL ne disparaîtra pas : il deviendra un socle de la stratégie, intégré directement dans l’architecture d’IA éthique et de confiance.

En 2030, la supervision humaine sera un principe de conception fondamental, plus une précaution temporaire. HITL s’imposera des référentiels réglementaires jusqu’aux fonctions des plateformes IA. Les pionniers seront mieux placés pour prospérer durablement.

C’est simple : comme la ceinture de sécurité est devenue incontournable en automobile, les mécanismes HITL deviendront standard dans toute IA sérieuse. Ils protégeront l’utilisateur, limiteront les erreurs et garantiront une innovation responsable et inclusive.

Le moment d’anticiper est arrivé, car Amazon prévoit une adoption quasi-totale de l’IA en Europe d’ici 2030.

Leaders et stratèges tech :

- Investissez dans des outils d’IA explicables et des interfaces de contrôle

- Créez des postes de supervision humaine dans toutes vos équipes

- Privilégiez les plateformes intégrant facilement des étapes de validation humaine

- Concevez des process où humain et IA collaborent systématiquement

À l’heure du durcissement réglementaire et de la quête de confiance publique, ces pratiques assureront résilience, agilité et positionnement éthique.

Dernière mise à jour le