Najważniejsze informacje

- Ekstrakcja danych może prowadzić do powstania zanieczyszczonych danych, które wymagają weryfikacji i obróbki końcowej, jeśli pipeline nie został właściwie zaprojektowany.

- Niezawodny pipeline powinien obejmować walidację schematu, normalizację, czyszczenie tekstu, naprawę tabel, deduplikację oraz systematyczne kontrole jakości.

- Narzędzia takie jak JSON Schema, Pydantic, Pandas czy Great Expectations pozwalają na silną i automatyczną obróbkę końcową.

- Parseur API umożliwia szybkie przechwytywanie i strukturyzację danych, dzięki czemu zespoły mogą skupić się na jakości i analizie.

Techniki czyszczenia danych to procesy poprawy, standaryzacji i weryfikacji surowych danych zwracanych przez API. Nawet jeżeli narzędzia do ekstrakcji konwertują nieustrukturyzowane pliki takie jak PDF-y, obrazy czy e-maile do formatów strukturalnych (JSON, CSV), wyniki często zawierają niespójności, puste pola, niewłaściwe typy, duplikaty lub błędy formatowania. Czyszczenie pozwala mieć pewność, że zbiór danych spełnia założony schemat i jest wiarygodny dla raportowania, analiz oraz dalszych procesów.

Ostatnie studium przypadku DataXcel ujawniło, że 14,45% wyekstrahowanych rekordów telefonicznych było nieprawidłowych lub nieaktywnych, co podkreśla znaczenie wdrożenia solidnych praktyk czyszczenia, by zapobiegać takim błędom i utrzymać wysoką jakość pozyskanych danych.

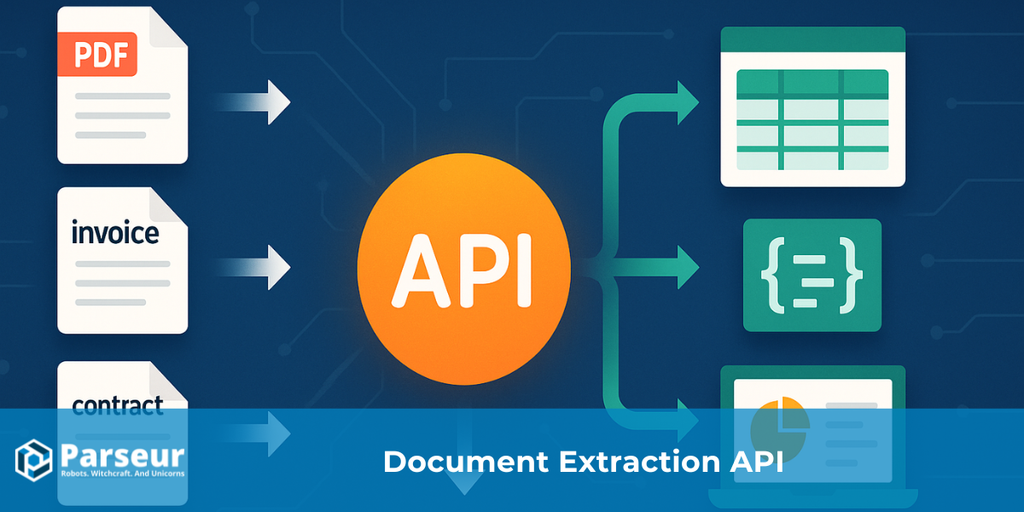

API wyciągające dane z PDF-ów, obrazów czy e-maili zwykle zwracają dane w strukturze JSON lub CSV. Choć upraszcza to dalszą obróbkę, rezultaty niemal nigdy nie są “czyste”. Zespoły często trafiają na brakujące wartości, niespójne nagłówki, mieszane typy danych, duplikaty czy nieprawidłowe daty. Bez czyszczenia, błędy te mogą przełożyć się na niewiarygodne raporty, analizy czy decyzje biznesowe.

Ten przewodnik przeprowadzi Cię przez praktyczne kroki przekształcania nieuporządkowanych ekstraktów w wiarygodne zbiory danych: walidacja, standaryzacja, wzbogacanie, testy jakości i logowanie. Dla zespołów zajmujących się przetwarzaniem załączników z e-maili oraz PDF-ów, narzędzia takie jak Parseur upraszczają pobieranie danych, pozwalając skupić się na kontroli jakości.

Chcesz wiedzieć więcej? Zobacz nasz szczegółowy poradnik: Czym jest API do ekstrakcji danych z dokumentów?

Rodzaje technik czyszczenia danych

Po ekstrakcji poprzez API, surowe dane często zawierają nieścisłości, brakujące pola, problemy z formatowaniem lub duplikaty. Nawet jeśli API umożliwia konwersję nieustrukturyzowanych plików do JSON lub CSV, dane wymagają dogłębnego czyszczenia dla zapewnienia ich jakości.

Badania Harvard Business Review pokazują, że zaledwie 3% firmowych danych spełnia podstawowe kryteria jakości, a 47% nowo utworzonych rekordów zawiera co najmniej jeden poważny błąd. Koszty tych błędów są realne – według Gartner problemy z jakością danych generują średnio 15 milionów dolarów strat rocznie w firmie.

Solidne techniki czyszczenia danych gwarantują poprawność, spójność i gotowość do analiz. Oto wybrane praktyki:

Walidacja i wykrywanie błędów

Zweryfikuj czy wyciągnięte dane mają właściwe formaty, jak daty, liczby czy e-maile. Zapobiega to problemom z raportami i analizami, gwarantując poprawność danych po ekstrakcji.

Standaryzacja

Ujednolicaj formaty danych – np. normalizuj numery telefonów, adresy, daty – dla łatwej integracji i obsługi.

Obsługa brakujących danych

W zależności od kontekstu — uzupełnij braki (wartościami domyślnymi, interpolacją) lub usuń niekompletne rekordy.

Deduplikacja

Usuń powielone rekordy, które mogły się pojawić przez wielokrotne zapytania do API lub nakładające się źródła – podnosi to jakość i wiarygodność danych.

Wzbogacanie zbioru danych

Dodaj kontekst lub dodatkowe informacje, np. położenie geograficzne, kategorie, jeśli chcesz zwiększyć użyteczność danych.

Poprawa formatowania i typów

Napraw błędne wartości, zamieniaj teksty na liczby, poprawiaj pisownię, standaryzuj waluty dla zachowania spójności.

Logowanie i audyt

Rejestruj wszystkie operacje czyszczenia, by kontrolować jakość oraz zachować integralność danych na przestrzeni czasu.

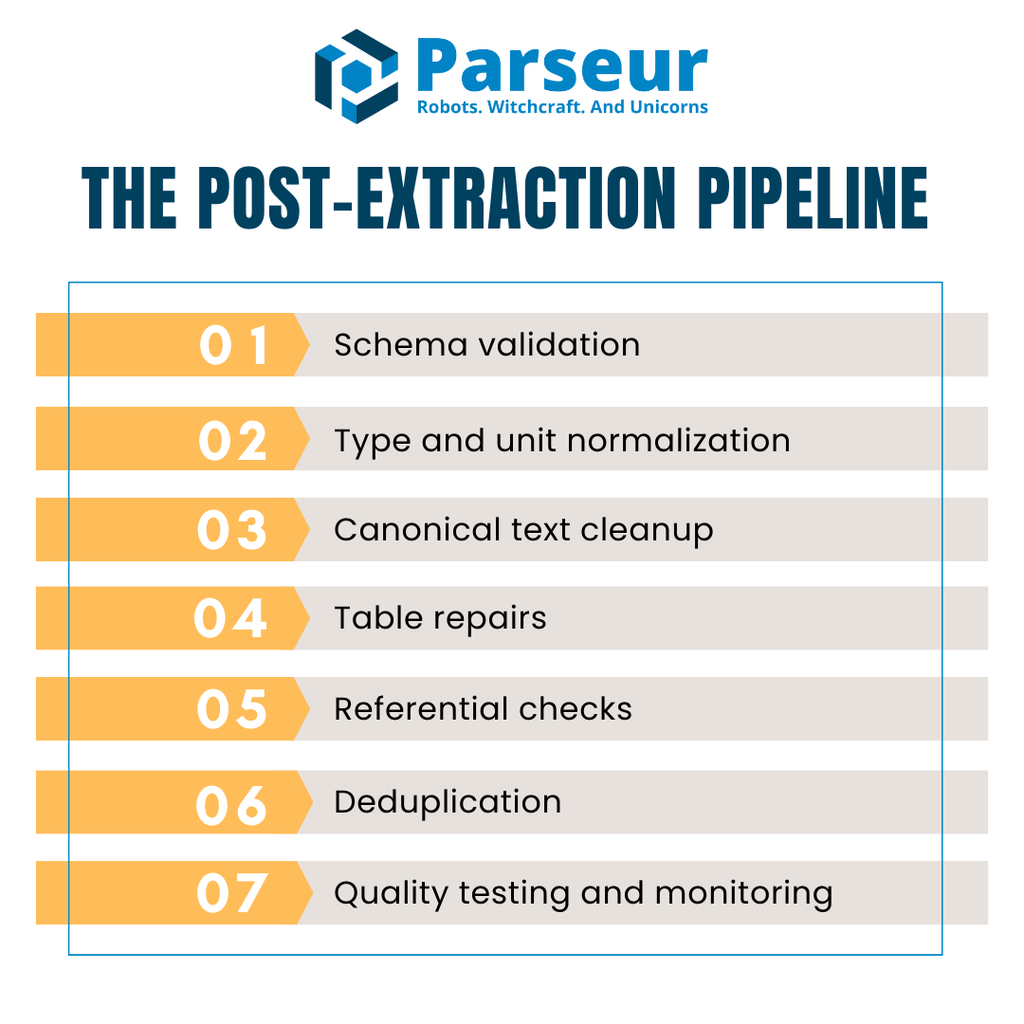

Pipeline poekstrakcyjny (przegląd)

Wyciągnięte z API dane rzadko są od razu gotowe do analiz. Zwykle wyjścia zawierają braki w polach, niewłaściwe typy, niespójne tabele lub duplikaty. By tego nie przenosić dalej, niezbędny jest powtarzalny pipeline dla kolejnych partii danych.

Typowy pipeline poekstrakcyjny składa się z tych kroków:

- Walidacja schematu – Sprawdź, czy wejściowy JSON/CSV spełnia wymaganą strukturę.

- Normalizacja typów i jednostek – Popraw typy danych, obsłuż braki oraz wymuś spójność jednostek i formatów.

- Standaryzacja tekstu – Ujednolicaj napisy, wielkość liter i kodowanie.

- Korekta tabel – Zadbaj o jednolite nagłówki, wyrównanie pozycji i uzgadnianie sum w wielowierszowych fakturach.

- Walidacje referencyjne – Sprawdzaj powiązania między zbiorami (kontrahenci, waluty, podatki).

- Deduplikacja – Wyłapuj i eliminuj duplikaty.

- Testy i monitoring jakości – Automatyczne kontrole ograniczające dalsze propagowanie błędów.

Wydajność czyszczenia zwiększa zastosowanie formatów kolumnowych (np. Apache Arrow, Parquet). Ułatwia to przetwarzanie dużych zbiorów (np. faktur, transakcji) i optymalizuje wykorzystanie zasobów.

Zobrazujmy to jako strumień: API → Walidacja → Czyszczenie → QA → Hurtownia. Daje to spójność, optymalizuje koszty oraz pozwala uniknąć niespodzianek związanych z jakością danych.

Krok 1: Walidacja zgodnie ze schematem (blokuj śmieci już na wejściu)

Pierwszym etapem jest walidacja danych względem schematu. Pozwala to wyeliminować problematyczne dane zanim trafią do kolejnych etapów — ich obecność mogłaby powodować awarie pipeline’u czy nieprawidłowe wyniki.

Standardem o szerokim zastosowaniu jest JSON Schema (Draft 2020-12) – jest uniwersalny, niezależny od narzędzi i świetnie wspierany. Pozwala określić typy pól, wymagania dotyczące ich obecności, czy formatów oczekiwanych wartości (np. wymagając ISO 8601 dla dat czy nieujemnych wartości dla sum).

W Pythonie z kolei Pydantic v2 pozwala skutecznie walidować dane w czasie rzeczywistym i automatycznie generuje definicje JSON Schema. Możesz modelować faktury, narzucać typy oraz wzorce (np. czy vendorName to string, invoiceNumber pasuje do regex, a currency pochodzi z listy kodów).

Zaleca się rozszerzyć walidację o wyliczenia akceptowanych wartości, regexy dla formatów (np. NIP), czy zakresy liczby dla sum — to ochrania przed subtelnymi błędami.

Ważne także — zdecyduj co robić z odrzuconymi rekordami: czy je wyrzucić, czy przekazać do kolejki dead-letter do późniejszego przeglądu. Takie podejście fail-fast pozwala by tylko zweryfikowane dane przechodziły dalej.

Krok 2: Popraw typy danych, braki oraz jednostki

Po wyjściowej walidacji, priorytetem jest korekta typów, obsługa pustych wartości oraz normalizacja jednostek. Nawet po przeparsowaniu do JSON/CSV przez API, możesz spotkać liczby przechowywane jako tekst, niespójne daty, czy puste kolumny. Brak naprawy tych problemów uniemożliwia rzetelną analizę i raportowanie.

Przy użyciu Parseur API możesz automatycznie pobierać dane z faktur, paragonów i maili bez żmudnej konfiguracji. Webhooki przekazują te dane w czasie rzeczywistym do Twojego ERP, CRM lub bazy — już tu oszczędzasz czas i minimalizujesz błędy przed uruchomieniem walidacji.

Najpierw zapewnij poprawność typów – ilości, ceny jednostkowe jako liczby; daty jako ISO; wartości logiczne zamień zawsze na true/false.

Podejmij decyzję jak traktować puste pola:

- Usuwanie – jeśli rekord nie jest krytyczny.

- Uzupełnianie – domyślną wartością, średnią lub placeholderem.

- Oznaczanie – flaguj braki do przeglądu, nie wypełniaj “po cichu”.

Dokumentuj zasady dla każdego pola, aby pipeline był spójny.

W Pythonie Pandas pozwala łatwo wymusić prawidłowe typy poprzez to_numeric/errors="coerce", to_datetime, fillna, itp. Pewność typów i deterministyczna obsługa braków to podstawa dalszych etapów.

Korekta typów, braków i jednostek zapewnia solidną podstawę do późniejszej normalizacji tekstu, korekt tabel i walidacji referencji.

Krok 3: Kanonizacja tekstów (nazwy, wielkość liter, Unicode)

Po naprawie pól liczbowych i dat, skup się na tekstach. Dane tekstowe bywają chaotyczne: zmienne wielkości liter, spacje, nieregularne kodowania — co komplikuje porównania oraz grupowanie.

Najpierw usuń zbędne białe znaki i interpunkcję (trim, zamiana kilku spacji na jedną, usuwanie błędnych znaków). Następnie wymuś spójną wielkość liter — np. nazwy firm w formacie tytułowym, statusy drukowanymi literami.

Normalizuj Unicode — różne kodowania mogą powodować, że podobne napisy nie zostaną przypisane do tej samej grupy. Stosując np. NFKC możesz rozwiązać kwestie akcentów i znaków specjalnych. Przy danych międzynarodowych rozważ usuwanie diakrytyków.

Stwórz również kanoniczne słowniki dla pól kluczowych jak kontrahenci – zacznij od prostych reguł (np. “Inc.” → “Incorporated”), a docelowo rozważ modele ML do zaawansowanego dopasowania.

Kanonizacja minimalizuje fragmentację rekordów i poprawia analizę.

Krok 4: Naprawa tabel (pozycje zgodne i kompletne)

Po ekstrakcji przez API, tabela z pozycjami bywa nieuporządkowana: nagłówki podzielone na kilka wierszy, przesunięcia komórek, scalone wartości utrudniają automatyczne obliczenia. Zacznij od zagwarantowania jednolitej linii nagłówków zgodnej ze schematem.

Znormalizuj jednostki (np. kg/lbs, waluty) – zawsze przelicz wielkości na ustalone jednostki, zanim policzysz sumy. Każda pozycja powinna mieć amount = quantity × unitPrice, a suma pozycji faktury powinna zgadzać się z polem total (z tolerancją na zaokrąglenia).

Przy eksporcie do CSV pojawiają się wyzwania: niestandardowe separatory, błędy cudzysłowu czy kodowania mogą psuć podział na kolumny. Najbezpieczniejsze jest ładowanie takich plików przez DuckDB, gdzie można elastycznie ustawić wszelkie parametry.

Dzięki korekcie tabel pozyskasz wiarygodne, uporządkowane dane, gotowe do raportowania finansowego.

Krok 5: Reguły referencyjne i walidacje biznesowe

Większość błędów wychodzi na jaw, gdy sprawdzamy powiązania między tabelami, nie zaś pojedyncze rekordy. Walidacja referencyjna wymusza spójność i zgodność z regułami biznesowymi przed załadowaniem danych do hurtowni.

Dla przykładu, każde vendorId w tabeli faktur powinno istnieć w katalogu kontrahentów; waluta musi być jedną z zaakceptowanych; stawki podatku zgodne z jurysdykcją. Wczesna kontrola unika późniejszych problemów z joinami lub nieprawidłowych raportów.

Najwygodniej zaimplementować to w warstwie transformacji, np. przez testy DBT tests:

- unique (brak duplikatów faktur),

- not_null (obowiązkowe pola, np. vendorId),

- accepted_values (dozwolone kody walut),

- relationships (klucze obce).

Automatyczne testy integralności dają natychmiastową informację o problemach i pozwalają trzymać jakość oraz zgodność procesów.

Krok 6: Deduplikacja i łączenie rekordów

Duplikaty danych zaniżają wiarygodność — zawyżają sumy, prowadzą do zdublowanych płatności i mieszają w audytach. Usuwanie powielonych rekordów tuż po ekstrakcji jest bardzo istotne, ale rób to z uwagą.

Najpierw opracuj deterministyczny klucz (np. supplierName + invoiceNumber + invoiceDate + amount + currency). Dokładne pokrycie sugeruje prawie na pewno duplikat.

Często jednak duplikaty są "prawie identyczne". Stosuj fuzzy matching — porównuj faktury od tego samego dostawcy w zbliżonych datach i zbliżonych kwotach, a "podejrzane" rekordy oznaczaj do ręcznej weryfikacji.

Pamiętaj o różnicy pomiędzy porównaniami syntaktycznymi (czysty tekst) a semantycznymi (np. „Acme Corp.” = „ACME Corporation”). Narzędzia jak OpenRefine pozwalają grupować i sugerować duplikaty na bazie reguł.

Łącz wskaźniki deterministyczne z fuzzym lub semantycznym dopasowaniem, by zminimalizować straty prawidłowych danych.

Krok 7: Automatyzacja kontroli jakości danych

Jakość danych to ciągły proces. Nawet po dokładnym czyszczeniu, kolejne ekstrakcje mogą wprowadzić nowe błędy. Automatyczna kontrola jakości wykrywa problemy na bieżąco, zanim pojawią się w raportach.

Niezawodnym narzędziem jest Great Expectations (GX). Umożliwia ono zdefiniowanie zbioru reguł (Expectations) dla poszczególnych danych, jak format numeru faktury, zakresy ilości czy walidację sum. Testy uruchamiane w pipeline CI/CD dają szybki feedback o jakości.

W Pythonie Pandera daje możliwość walidacji typów, zakresów i NULL-i bezpośrednio w ramach DataFrame.

Zawsze raportuj wyniki testów do dashboardu lub systemu alertowego, by było jasne jaki % danych nie przeszedł walidacji i jakie są przyczyny. Dzięki temu możesz szybko reagować na zmiany i zwiększać kontrolę.

Automatyczne testowanie zapewnia, że każda wyczyszczona paczka danych jest gotowa na produkcję.

Porady wydajnościowe i magazynowanie (czyszczenie bez hamowania pipeline’u)

Czyszczenie danych po ekstrakcji jest niezbędne, ale nie może tworzyć wąskich gardeł. Przy setkach tysięcy rekordów, źle zoptymalizowane procesy generują opóźnienia i zwiększają koszty. Celem jest zachowanie jakości oraz wydajności.

Według MDPI, procesy czyszczenia zużywają do 80% czasu pracy profesjonalisty danych, silnie wpływając na efektywność pipeline’u.

Praktyczne wskazówki:

- Korzystaj z formatów kolumnowych – Apache Arrow, Parquet – zwiększają wydajność, redukują zużycie pamięci, współpracują z analizą big data.

- Batchowanie i przetwarzanie równoległe – Dziel dane na partie, obsługuj asynchronicznie, by przyspieszyć oczyszczanie.

- Zleć ciężkie przetwarzanie hurtowniom – Duże joiny i transformacje przenoś do DuckDB czy hurtowni, odciążając pipeline.

- Cache’uj wyniki pośrednie – Powtarzające się czynności warto buforować.

- Monitoruj zasoby – Śledź CPU, RAM i I/O, by wyprzedzić powstawanie wąskich gardeł.

Równoważenie dokładności z wydajnością sprawia, że warstwa czyszczenia nie hamuje operacji, a dane są gotowe do analizy w czasie niemal rzeczywistym.

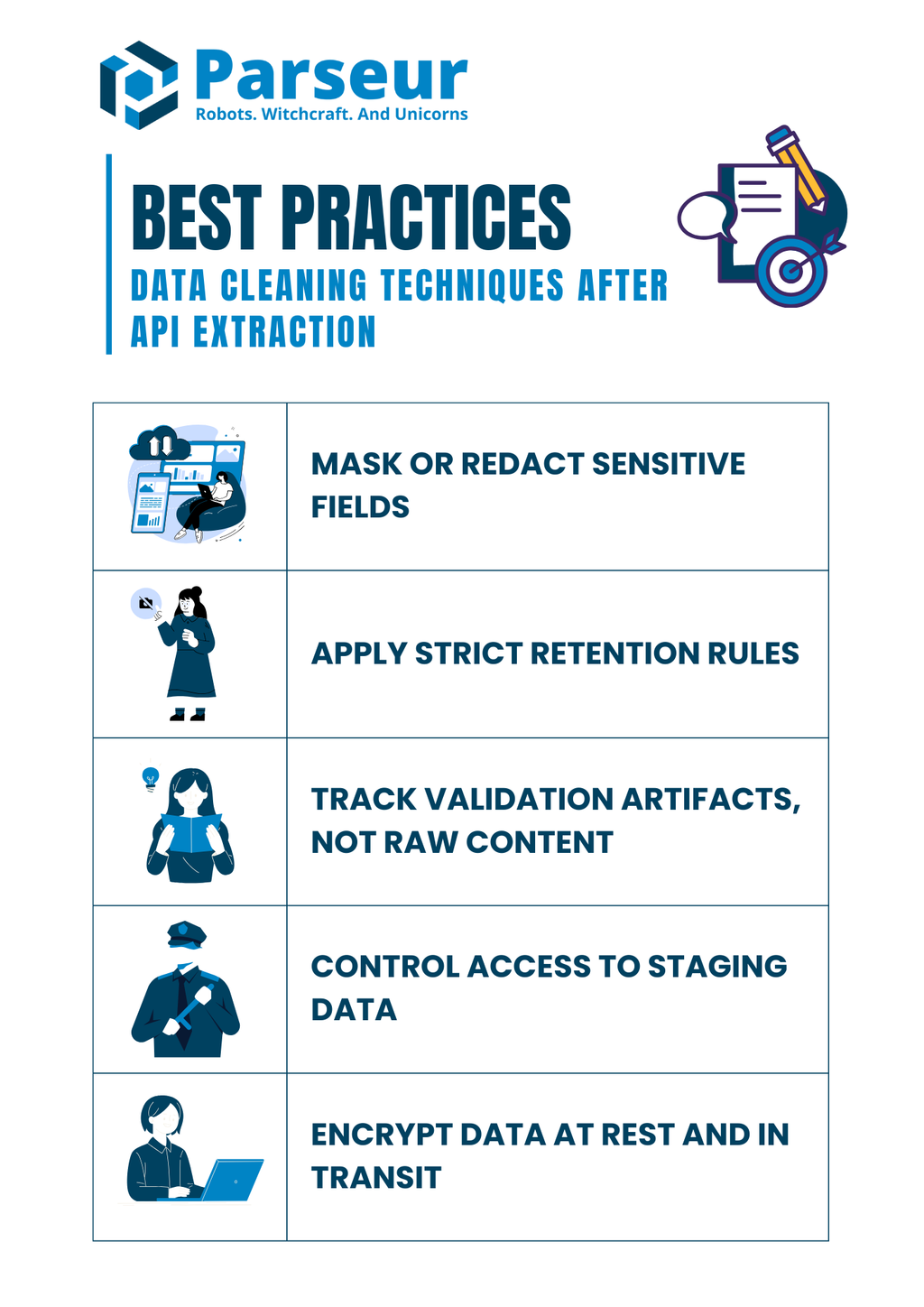

Wskazówki dotyczące bezpieczeństwa i compliance (nie trać kontroli przez błędy czyszczenia)

Czyszczenie danych to także kwestia bezpieczeństwa i zgodności z przepisami. Dokumenty po ekstrakcji mogą zawierać dane wrażliwe — numery identyfikacyjne, rachunki, dane osobowe. Błędna obróbka już na etapie czyszczenia to ryzyko dla całego przedsiębiorstwa.

Badania Mitratech dowodzą, że 61% organizacji doświadcza naruszeń danych i problemów compliance przez niedostateczne zarządzanie danymi, co podkreśla wagę solidnych praktyk od momentu czyszczenia.

Zadbaj o:

- Maskowanie lub anonimizację – Nie loguj surowych NIP-ów, numerów kont, kart – zamieniaj na wersje zamaskowane/haszowane.

- Respektowanie zasad retencji – Surowe pliki przechowuj tylko tyle, ile to naprawdę konieczne.

- Loguj artefakty walidacji, nie całe dokumenty – Archiwizuj powody odrzutów (błędy, braki), ale nie treści wrażliwe.

- Ogranicz dostęp do stagingu – Zapewnij uprawnienia tylko tym, którzy muszą widzieć/modyfikować dane wrażliwe.

- Szyfruj na każdym etapie – Pliki, staging, logi muszą być zabezpieczone (w spoczynku i w trakcie transferu).

Silne procesy compliance towarzyszą technicznym krokom czyszczenia — ochraniają firmę przed karami i budują zaufanie partnerów.

Przykład praktyczny (pipeline w działaniu)

Przyjrzyjmy się przykładowemu pipeline’owi łączącemu walidację, normalizację, uzgadnianie sum i testy jakości w jednym procesie. Wyobraź sobie, że korzystasz z Parseur API do wyciągnięcia danych z faktury PDF lub e-maila. Parseur zwraca gotowego JSON-a — to świetna baza do dalszego czyszczenia.

Przykładowy wyekstrahowany JSON (wejście):

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025/08/15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": "10", "unitPrice": "5.00" },

{ "description": "Widget B", "quantity": "3", "unitPrice": "12.50" }

],

"total": "87.50"

}

Krok 1: Walidacja schematu z Pydantic:

from pydantic import BaseModel, Field

from datetime import date

from typing import List

import pandas as pd

# Model pozycji

class LineItem(BaseModel):

description: str

quantity: int

unitPrice: float

# Model faktury

class Invoice(BaseModel):

invoiceNumber: str

invoiceDate: date

vendorName: str

lineItems: List[LineItem]

total: float

# Przykładowy surowy JSON

raw_json = """

{

"invoiceNumber": "INV-001",

"invoiceDate": "2025-08-15",

"vendorName": "Acme, Inc.",

"lineItems": [

{ "description": "Widget A", "quantity": 10, "unitPrice": 5.00 },

{ "description": "Widget B", "quantity": 3, "unitPrice": 12.50 }

],

"total": 87.50

}

"""

# Parsuj JSON do modelu Invoice

invoice = Invoice.model_validate_json(raw_json)

# Przenieś pozycje do Pandas DataFrame

df = pd.DataFrame([item.model_dump() for item in invoice.lineItems])

df["amount"] = df["quantity"] * df["unitPrice"]

# Sprawdź sumy

if round(df["amount"].sum(), 2) != invoice.total:

print("Rozbieżność: pozycje nie sumują się do sumy faktury")

else:

print("Sumy się zgadzają ✅")

print(df)

Krok 3: Testowanie jakości z Great Expectations:

import great_expectations as gx

# Inicjalizuj kontekst Great Expectations

context = gx.get_context()

# Wczytaj DataFrame Pandas do batcha

batch = context.sources.pandas_default.read_dataframe(df)

# Pobierz walidator

validator = batch.get_validator()

# Definiuj oczekiwania

validator.expect_column_values_to_be_between("quantity", min_value=1, max_value=1000)

validator.expect_column_values_to_be_between("unitPrice", min_value=0, max_value=10000)

validator.expect_column_sum_to_be_between("amount", min_value=0, max_value=100000)

# Waliduj i drukuj rezultat

results = validator.validate()

print(results)

Rezultat (po czyszczeniu):

- Dane faktury przeszły walidację według schematu.

- Daty i liczby mają odpowiednie typy.

- Sumy zostały uzgodnione.

- Testy potwierdzają poprawność zakresów i strukturę.

Ten prosty pipeline pokazuje, jak można zamienić nieuporządkowane dane API w wiarygodny, wyczyszczony i gotowy do dalszego ładowania pakiet danych.

Czyszczenie to tylko jeden element budowy stabilnego pipeline’u — fundamentem jest rzetelna ekstrakcja strukturalna danych z dokumentów. Do tego służy Parseur i Parseur API które pozwala zautomatyzować pobieranie danych z PDF-ów, e-maili, arkuszy i załączników — ograniczając liczbę błędów i eliminując pracę ręczną. Po przechwyceniu danych wdroż opisane powyżej techniki czyszczenia, by mieć je dokładne, spójne i gotowe do analizy.

Patrząc w przyszłość, Gartner prognozuje, że do 2026 roku 70% nowych wdrożeń będzie korzystać ze spójnych ekosystemów danych w chmurze, rezygnując z ręcznych integracji punkt-punkt. To jeszcze bardziej podkreśla potrzebę czystych, strukturalnych danych i zautomatyzowanych, opartych na API procesów.

Jeżeli chcesz lepiej poznać cały proces — od ekstrakcji po optymalizację workflow — przeczytaj nasz przewodnik API Ekstrakcji Danych z Dokumentów, który pokaże jak zamienić nieuporządkowane pliki w jakościowe dane gotowe do wdrożeń produkcyjnych.

Najczęściej zadawane pytania

Zanim zakończysz lekturę, zapoznaj się z najczęściej zadawanymi pytaniami na temat czyszczenia danych po ekstrakcji API. Te szybkie odpowiedzi poruszają typowe pułapki i praktyczne zagadnienia, z którymi często mierzą się zespoły.

-

Czy powinienem usuwać wiersze z brakującymi sumami?

-

Preferuję ich odizolowanie i analizę zamiast automatycznego usuwania. Suma to krytyczne pole finansowe — usuwanie wierszy po cichu może zafałszować raporty. Przechowanie ich do przeglądu zapewnia przejrzystość i właściwe rozwiązanie problemu.

-

Jak upewnić się, że JSON jest poprawny, zanim zacznę czyszczenie?

-

Waliduj za pomocą JSON Schema lub Pydantic, aby mieć pewność, że napływające dane są czytelne dla maszyny i mają oczekiwane pola. Wczesne wykrycie uszkodzonego JSON-a oszczędza czas na późniejszych poprawkach.

-

Czy mogę testować jakość bez hurtowni danych?

-

Tak. Narzędzia takie jak Great Expectations czy Pandera pozwalają narzucać reguły wprost w pipeline'ach Pythona lub workflow CI/CD. Dzięki temu zachowujesz wysoką jakość, jeszcze zanim dane trafią do hurtowni.

-

Co zrobić, jeśli tabele nie sumują się do wartości na fakturze?

-

Ustaw regułę uzgadniania, która porównuje sumy pozycji z sumą faktury w dopuszczalnym zakresie. Każda rozbieżność powinna być oznaczona i wysłana do przeglądu, a nie poprawiana automatycznie.

-

Czy testy DBT są konieczne, jeśli sprawdzam dane wcześniej?

-

Tak. Testy DBT tworzą dodatkową warstwę bezpieczeństwa, kodując ograniczenia już na etapie modelu. Nawet jeśli testy występują wcześniej, takie podejście defence-in-depth chroni przed przedostaniem się wadliwych danych do produkcyjnej analityki.

-

Jak radzić sobie z problemami kodowania z eksportów CSV?

-

Zawsze jawnie określaj separator, kodowanie i znak cudzysłowu podczas parsowania. DuckDB i podobne narzędzia pomagają diagnozować nietypowe pliki i zapewniają spójność przy normalizacji danych z różnych źródeł.

Ostatnia aktualizacja